python提取网页表格并保存为csv

0.

1.参考

表格标签

| 表格 | 描述 |

|---|---|

| <table> | 定义表格 |

| <caption> | 定义表格标题。 |

| <th> | 定义表格的表头。 |

| <tr> | 定义表格的行。 |

| <td> | 定义表格单元。 |

| <thead> | 定义表格的页眉。 |

| <tbody> | 定义表格的主体。 |

| <tfoot> | 定义表格的页脚。 |

| <col> | 定义用于表格列的属性。 |

| <colgroup> | 定义表格列的组。 |

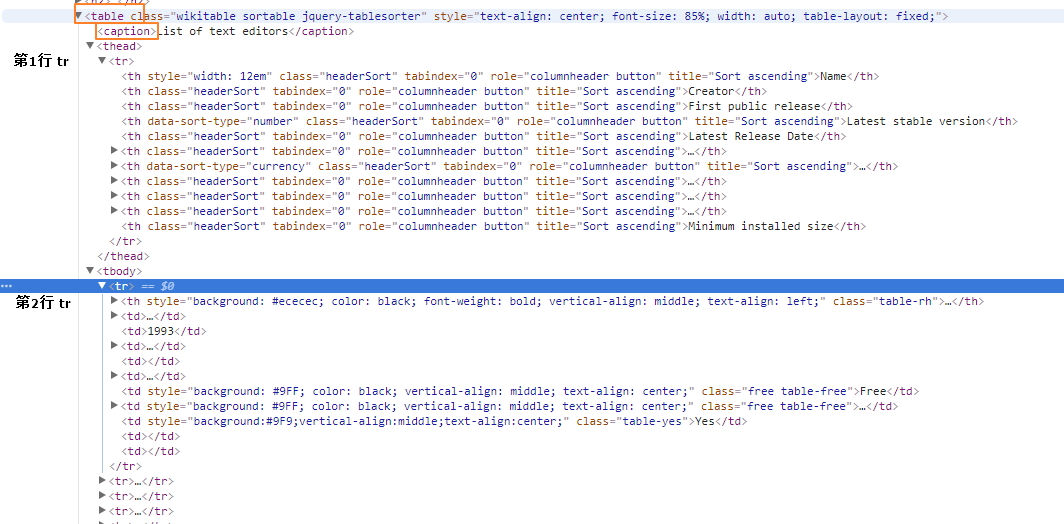

表格元素定位

参看网页源代码并没有 thead 和 tbody。。。

<table class="wikitable sortable" style="text-align: center; font-size: 85%; width: auto; table-layout: fixed;">

<caption>List of text editors</caption>

<tr>

<th style="width: 12em">Name</th>

<th>Creator</th>

<th>First public release</th>

<th data-sort-type="number">Latest stable version</th>

<th>Latest Release Date</th>

<th><a href="/wiki/Programming_language" title="Programming language">Programming language</a></th>

<th data-sort-type="currency">Cost (<a href="/wiki/United_States_dollar" title="United States dollar">US$</a>)</th>

<th><a href="/wiki/Software_license" title="Software license">Software license</a></th>

<th><a href="/wiki/Free_and_open-source_software" title="Free and open-source software">Open source</a></th>

<th><a href="/wiki/Command-line_interface" title="Command-line interface">Cli available</a></th>

<th>Minimum installed size</th>

</tr>

<tr>

<th

2.提取表格数据

表格标题可能出现超链接,导致标题被拆分,

也可能不带表格标题。。

<caption>Text editor support for remote file editing over

<a href="/wiki/Lists_of_network_protocols" title="Lists of network protocols">network protocols</a>

</caption>

表格内容换行

<td>

<a href="/wiki/Plan_9_from_Bell_Labs" title="Plan 9 from Bell Labs">Plan 9</a>

and

<a href="/wiki/Inferno_(operating_system)" title="Inferno (operating system)">Inferno</a>

</td>

tag 规律

| table | ||||

| thead tr1 | th | th | th | th |

| tbody tr2 | td/th | td | ||

| tbody tr3 | td/th | |||

| tbody tr3 | td/th | |||

2.1提取所有表格标题列表

filenames = []

for index, table in enumerate(response.xpath('//table')):

caption = table.xpath('string(./caption)').extract_first() #提取caption tag里面的所有text,包括子节点内的和文本子节点,这样也行 caption = ''.join(table.xpath('./caption//text()').extract())

filename = str(index+1)+'_'+caption if caption else str(index+1) #xpath 要用到 table 计数,从[1]开始

filenames.append(re.sub(r'[^\w\s()]','',filename)) #移除特殊符号

In [233]: filenames

Out[233]:

[u'1_List of text editors',

u'2_Text editor support for various operating systems',

u'3_Available languages for the UI',

u'4_Text editor support for common document interfaces',

u'5_Text editor support for basic editing features',

u'6_Text editor support for programming features (see source code editor)',

u'7_Text editor support for other programming features',

'',

u'9_Text editor support for key bindings',

u'10_Text editor support for remote file editing over network protocols',

u'11_Text editor support for some of the most common character encodings',

u'12_Right to left (RTL) bidirectional (bidi) support',

u'13_Support for newline characters in line endings']

2.2每个表格分别写入csv文件

for index, filename in enumerate(filenames):

print filename

with open('%s.csv'%filename,'wb') as fp:

writer = csv.writer(fp)

for tr in response.xpath('//table[%s]/tr'%(index+1)):

writer.writerow([i.xpath('string(.)').extract_first().replace(u'\xa0', u' ').strip().encode('utf-8','replace') for i in tr.xpath('./*')]) #xpath组合,限定 tag 范围,tr.xpath('./th | ./td')

代码处理 .replace(u'\xa0', u' ')

HTML转义字符&npsp;表示non-breaking space,unicode编码为u'\xa0',超出gbk编码范围?

使用 'w' 写csv文件,会出现如下问题,使用'wb' 即可解决问题

【已解决】Python中通过csv的writerow输出的内容有多余的空行 – 在路上

所有表格写入同一excel文件的不同工作表 sheet,需要使用xlwt

python ︰ 创建 excel 工作簿和倾倒 csv 文件作为工作表

python提取网页表格并保存为csv的更多相关文章

- Python读取网页表格数据

学会了从网格爬取数据,就可以告别从网站一页一页复制表格数据的时代了. 说个亲身经历的事: 以前我的本科毕业论文是关于"燃放烟花爆竹和空气质量"之间关系的,就要从环保局官网查资料. ...

- python提取分析表格数据

#/bin/python3.4# -*- coding: utf-8 -*- import xlrd def open_excel(file="file.xls"): try: d ...

- python爬取昵称并保存为csv

代码: import sys import io import re sys.stdout=io.TextIOWrapper(sys.stdout.buffer,encoding='gb18030') ...

- python爬取信息并保存至csv

import csv import requests from bs4 import BeautifulSoup res=requests.get('http://books.toscrape.com ...

- 使用python 提取网页的特定数据转

http://blog.csdn.net/nwpulei/article/details/7272832

- Python:提取网页中的电子邮箱

import requests, re #regex = r"([a-zA-Z0-9_.+-]+@[a-zA-Z0-9-]+\.[a-zA-Z0-9-.]+)"#这个正则表达式过滤 ...

- Python使用Tabula提取PDF表格数据

今天遇到一个批量读取pdf文件中表格数据的需求,样式大体是以下这样: python读取PDF无非就是三种方式(我所了解的),pdfminer.pdf2htmlEX 和 Tabula.综合考虑后,选择了 ...

- python笔记之提取网页中的超链接

python笔记之提取网页中的超链接 对于提取网页中的超链接,先把网页内容读取出来,然后用beautifulsoup来解析是比较方便的.但是我发现一个问题,如果直接提取a标签的href,就会包含jav ...

- python学习笔记——爬虫中提取网页中的信息

1 数据类型 网页中的数据类型可分为结构化数据.半结构化数据.非结构化数据三种 1.1 结构化数据 常见的是MySQL,表现为二维形式的数据 1.2 半结构化数据 是结构化数据的一种形式,并不符合关系 ...

随机推荐

- vhdl verilog

一个signal. reg 不能同时在两个always 或者 process 中,synth 8-3352

- java 中的基本数据类型

1, 变量 Java是强类型语言, 对于每一种数据都定义了类型,基本数据类型分为数值型,字符型,布尔型.数值型又分为了整型和浮点型. 整型又分为byte, int, short long. 浮点型又 ...

- Linux查看用户登录信息-last

last命令: last命令用于显示用户最近登录信息.单独执行last命令,将读取 /var/log/wtmp 文件,并将给该文件的内容记录的登入系统的用户名单全部显示出来. 语法: last (选项 ...

- scrapy之使用LinkExtractor提取链接

一.概述: 在页面含有少量链接时,使用selector来提取信息就可以,但如果链接特别多时,就需要用LinkExtractor来提取. 二.LinkExtractor构造器的各个参数: 1.allow ...

- Python import hook

转自http://blog.konghy.cn/2016/10/25/python-import-hook/,这里有好多好文章 import hook 通常被译为 探针.我们可以认为每当导入模块的时候 ...

- 计算机网络--差错检测(帧检验序列FCS计算方法)

我们知道数据链路层广泛使用循环冗余检验CRC的检验技术 现在我们知道要发送的数据M=101001(长度为k=6) 在我们每次发送数据的时候需要在M后面添加一个N位的冗余码,一共发送(k+N)位数据 ...

- linux 触摸屏驱动

目录 linux 触摸屏驱动 输入子系统怎么写? 触摸屏事件 事件分类 事件设置 硬件配置 设计思路 完整程序 测试 ts_lib 使用 问题小结 title: linux 触摸屏驱动 tags: l ...

- 实战Google深度学习框架-C3-TensorFlow入门

第三章:TensorFlow入门 TensorFlow存在计算模型,数据模型和运算模型(本文用TF代表TensorFlow) 3.1 计算模型-计算图 3.1.1 计算图的概念 TensorFlow这 ...

- Hadoop记录-metastore jmx配置

参考:http://www.lixiuliang.cn/categories/%E5%A4%A7%E6%95%B0%E6%8D%AE/ 1.修改bin/hive文件 添加jvm启动参数: if [ $ ...

- 单例模式的七种实现-Singleton(Java实现)

1. 饿汉式 实现代码: public class Singleton { private Singleton() { } private static Singleton singleton = n ...