011.Kubernetes二进制部署kube-scheduler

一 部署高可用kube-scheduler

1.1 高可用kube-scheduler介绍

- 与 kube-apiserver 的安全端口通信;

- 在安全端口(https,10251) 输出 prometheus 格式的 metrics。

1.2 创建kube-scheduler证书和私钥

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# cat > kube-scheduler-csr.json <<EOF

3 {

4 "CN": "system:kube-scheduler",

5 "hosts": [

6 "127.0.0.1",

7 "172.24.8.71",

8 "172.24.8.72",

9 "172.24.8.73"

10 ],

11 "key": {

12 "algo": "rsa",

13 "size": 2048

14 },

15 "names": [

16 {

17 "C": "CN",

18 "ST": "Shanghai",

19 "L": "Shanghai",

20 "O": "system:kube-scheduler",

21 "OU": "System"

22 }

23 ]

24 }

25 EOF

26 #创建kube-scheduler的CA证书请求文件

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# cfssl gencert -ca=/opt/k8s/work/ca.pem \

3 -ca-key=/opt/k8s/work/ca-key.pem -config=/opt/k8s/work/ca-config.json \

4 -profile=kubernetes kube-scheduler-csr.json | cfssljson -bare kube-scheduler #生成CA密钥(ca-key.pem)和证书(ca.pem)

1.3 分发证书和私钥

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

4 do

5 echo ">>> ${master_ip}"

6 scp kube-scheduler*.pem root@${master_ip}:/etc/kubernetes/cert/

7 done

1.4 创建和分发kubeconfig

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# kubectl config set-cluster kubernetes \

4 --certificate-authority=/opt/k8s/work/ca.pem \

5 --embed-certs=true \

6 --server=${KUBE_APISERVER} \

7 --kubeconfig=kube-scheduler.kubeconfig

8

9 [root@k8smaster01 work]# kubectl config set-credentials system:kube-scheduler \

10 --client-certificate=kube-scheduler.pem \

11 --client-key=kube-scheduler-key.pem \

12 --embed-certs=true \

13 --kubeconfig=kube-scheduler.kubeconfig

14

15 [root@k8smaster01 work]# kubectl config set-context system:kube-scheduler \

16 --cluster=kubernetes \

17 --user=system:kube-scheduler \

18 --kubeconfig=kube-scheduler.kubeconfig

19

20 [root@k8smaster01 work]# kubectl config use-context system:kube-scheduler --kubeconfig=kube-scheduler.kubeconfig

21

22 [root@k8smaster01 ~]# cd /opt/k8s/work

23 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

24 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

25 do

26 echo ">>> ${master_ip}"

27 scp kube-scheduler.kubeconfig root@${master_ip}:/etc/kubernetes/

28 done

1.5 创建kube-scheduler 配置文件

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# cat >kube-scheduler.yaml.template <<EOF

3 apiVersion: kubescheduler.config.k8s.io/v1alpha1

4 kind: KubeSchedulerConfiguration

5 bindTimeoutSeconds: 600

6 clientConnection:

7 burst: 200

8 kubeconfig: "/etc/kubernetes/kube-scheduler.kubeconfig"

9 qps: 100

10 enableContentionProfiling: false

11 enableProfiling: true

12 hardPodAffinitySymmetricWeight: 1

13 healthzBindAddress: ##MASTER_IP##:10251

14 leaderElection:

15 leaderElect: true

16 metricsBindAddress: ##MASTER_IP##:10251

17 EOF

1 [root@k8smaster ~]# cd /opt/k8s/work

2 [root@k8smaster work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster work]# for (( i=0; i < 3; i++ ))

4 do

5 sed -e "s/##MASTER_NAME##/${MASTER_NAMES[i]}/" -e "s/##MASTER_IP##/${MASTER_IPS[i]}/" kube-scheduler.yaml.template > kube-scheduler-${MASTER_IPS[i]}.yaml

6 done #替换模板文件中的变量

7 [root@k8smaster01 work]# ls kube-scheduler*.yaml

8 #MASTER_NAMES 和 MASTER_IPS 为相同长度的 bash 数组,分别为节点名称和对应的 IP

1.6 分发配置文件

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

4 do

5 echo ">>> ${master_ip}"

6 scp kube-scheduler-${master_ip}.yaml root@${master_ip}:/etc/kubernetes/kube-scheduler.yaml

7 done

1.7 创建kube-scheduler的systemd

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# cat > kube-scheduler.service.template <<EOF

4 [Unit]

5 Description=Kubernetes Scheduler

6 Documentation=https://github.com/GoogleCloudPlatform/kubernetes

7

8 [Service]

9 WorkingDirectory=${K8S_DIR}/kube-scheduler

10 ExecStart=/opt/k8s/bin/kube-scheduler \\

11 --config=/etc/kubernetes/kube-scheduler.yaml \\

12 --bind-address=##MASTER_IP## \\

13 --secure-port=10259 \\

14 --port=0 \\

15 --tls-cert-file=/etc/kubernetes/cert/kube-scheduler.pem \\

16 --tls-private-key-file=/etc/kubernetes/cert/kube-scheduler-key.pem \\

17 --authentication-kubeconfig=/etc/kubernetes/kube-scheduler.kubeconfig \\

18 --client-ca-file=/etc/kubernetes/cert/ca.pem \\

19 --requestheader-allowed-names="" \\

20 --requestheader-client-ca-file=/etc/kubernetes/cert/ca.pem \\

21 --requestheader-extra-headers-prefix="X-Remote-Extra-" \\

22 --requestheader-group-headers=X-Remote-Group \\

23 --requestheader-username-headers=X-Remote-User \\

24 --authorization-kubeconfig=/etc/kubernetes/kube-scheduler.kubeconfig \\

25 --logtostderr=true \\

26 --v=2

27 Restart=always

28 RestartSec=5

29 StartLimitInterval=0

30

31 [Install]

32 WantedBy=multi-user.target

33 EOF

1.8 分发systemd

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for (( i=0; i < 3; i++ ))

4 do

5 sed -e "s/##MASTER_NAME##/${MASTER_NAMES[i]}/" -e "s/##MASTER_IP##/${MASTER_IPS[i]}/" kube-scheduler.service.template > kube-scheduler-${MASTER_IPS[i]}.service

6 done #修正相应IP

7 [root@k8smaster01 work]# ls kube-scheduler*.service

8 [root@k8smaster01 ~]# cd /opt/k8s/work

9 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

10 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

11 do

12 echo ">>> ${master_ip}"

13 scp kube-scheduler-${master_ip}.service root@${master_ip}:/etc/systemd/system/kube-scheduler.service

14 done #分发system

二 启动并验证

2.1 启动kube-scheduler 服务

1 [root@k8smaster01 ~]# cd /opt/k8s/work

2 [root@k8smaster01 work]# source /opt/k8s/bin/environment.sh

3 [root@k8smaster01 work]# for master_ip in ${MASTER_IPS[@]}

4 do

5 echo ">>> ${master_ip}"

6 ssh root@${master_ip} "mkdir -p ${K8S_DIR}/kube-scheduler"

7 ssh root@${master_ip} "systemctl daemon-reload && systemctl enable kube-scheduler && systemctl restart kube-scheduler"

8 done #启动服务前必须先创建工作目录

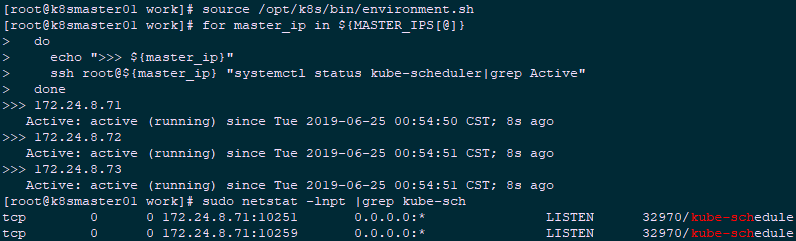

2.2 检查kube-scheduler 服务

1 [root@k8smaster01 ~]# source /opt/k8s/bin/environment.sh

2 [root@k8smaster01 ~]# for master_ip in ${MASTER_IPS[@]}

3 do

4 echo ">>> ${master_ip}"

5 ssh root@${master_ip} "systemctl status kube-scheduler|grep Active"

6 done

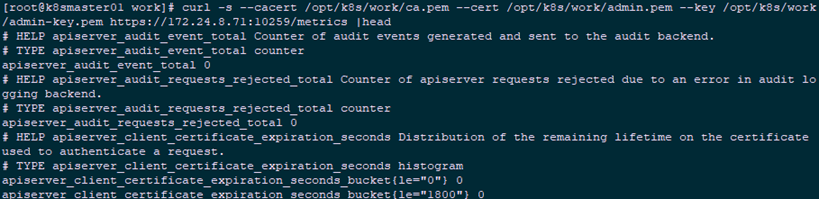

2.3 查看输出的 metrics

- 10251:接收 http 请求,非安全端口,不需要认证授权;

- 10259:接收 https 请求,安全端口,需要认证授权。

- 两个接口都对外提供 /metrics 和 /healthz 的访问。

1 [root@k8smaster01 ~]# sudo netstat -lnpt |grep kube-sch

1 [root@k8smaster01 ~]# curl -s http://127.0.0.1:10251/metrics |head

2 [root@k8smaster01 ~]# curl -s --cacert /opt/k8s/work/ca.pem --cert /opt/k8s/work/admin.pem --key /opt/k8s/work/admin-key.pem https://172.24.8.71:10259/metrics |head

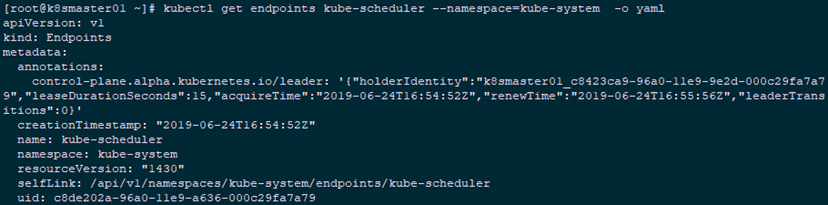

2.4 查看当前leader

1 [root@k8smaster01 ~]# kubectl get endpoints kube-scheduler --namespace=kube-system -o yaml

011.Kubernetes二进制部署kube-scheduler的更多相关文章

- Kubernetes 二进制部署(一)单节点部署(Master 与 Node 同一机器)

0. 前言 最近受“新冠肺炎”疫情影响,在家等着,入职暂时延后,在家里办公和学习 尝试通过源码编译二进制的方式在单一节点(Master 与 Node 部署在同一个机器上)上部署一个 k8s 环境,整理 ...

- kubernetes二进制部署k8s-master集群controller-manager服务unhealthy问题

一.问题现象 我们使用二进制部署k8s的高可用集群时,在部署多master时,kube-controller-manager服务提示Unhealthy [root@ceph-01 system]# k ...

- Kubernetes 二进制部署(二)集群部署(多 Master 节点通过 Nginx 负载均衡)

0. 前言 紧接上一篇,本篇文章我们尝试学习多节点部署 kubernetes 集群 并通过 haproxy+keepalived 实现 Master 节点的负载均衡 1. 实验环境 实验环境主要为 5 ...

- 003.Kubernetes二进制部署准备

一 前置准备 1.1 前置条件 相应的充足资源的Linux服务器: 设置相应的主机名,参考命令: hostnamectl set-hostname k8smaster Mac及UUID唯一: 若未关闭 ...

- 008.Kubernetes二进制部署Nginx实现高可用

一 Nginx代理实现kube-apiserver高可用 1.1 Nginx实现高可用 基于 nginx 代理的 kube-apiserver 高可用方案. 控制节点的 kube-controller ...

- 009.Kubernetes二进制部署kube-apiserver

一 部署master节点 1.1 master节点服务 kubernetes master 节点运行如下组件: kube-apiserver kube-scheduler kube-controlle ...

- 013.Kubernetes二进制部署worker节点Nginx实现高可用

一 Nginx代理实现kube-apiserver高可用 1.1 Nginx实现高可用 基于 nginx 代理的 kube-apiserver 高可用方案. 控制节点的 kube-controller ...

- 015.Kubernetes二进制部署所有节点kubelet

一 部署 kubelet kubelet 运行在每个 worker 节点上,接收 kube-apiserver 发送的请求,管理 Pod 容器,执行交互式命令,如 exec.run.logs 等. k ...

- 016.Kubernetes二进制部署所有节点kube-proxy

一 部署 kube-proxy kube-proxy 运行在所有节点上,它监听 apiserver 中 service 和 endpoint 的变化情况,创建路由规则以提供服务 IP 和负载均衡功能. ...

随机推荐

- Koa - 初体验(写个接口)

前言 不会node.js的前端不是一个好前端! 这几年node.js确实是越来越火了,好多公司对node.js都开始有要求.虽说前端不一定要会后端,但想要成为一个优秀的前端,node.js是必经之路. ...

- ARTS-S golang goroutines and channels(二)

向tcp服务端发消息 package main import ( "io" "log" "net" "os" ) fun ...

- 【JS】325- 深度理解ES6中的解构赋值

点击上方"前端自习课"关注,学习起来~ 对象和数组时 Javascript 中最常用的两种数据结构,由于 JSON 数据格式的普及,二者已经成为 Javascript 语言中特别重 ...

- yum换源,rpm包下载,源码包安装

一.yum更换源 yum自带源地址一般斗是国外的,可能下载速度略慢,我们可以自己换成国内的源,比如163等.比如配置163的yum源:1.先删除默认源文件dvd.repo # rm -f /etc/y ...

- zabbix 安装部署

环境:CentOS7 机器 两台 分别为server 和 client zabbix下载网址:http://repo.zabbix.com 本次操作使用zabbix4.0 网址:http://rep ...

- ELK 理论小知识

ELK 是现阶段众多企业单位都在使用的一种日志分析系统,它能够方便的为我们收集你想要的日志并且展示出来 ELK是Elasticsearch.Logstash.Kibana的简称,这三者都是开源软件,通 ...

- 在 ASP.NET Core 中使用 FluentValidation 进行验证

目录 从 NuGet 安装 FluentValidation 争对 Resource类 建立 FluentValidation 在Startup中对写好的验证进行注册 从 NuGet 安装 Fluen ...

- C#访问SFTP:Renci.SshNet.Async

SFTP是SSH File Transfer Protocol的缩写,安全文件传送协议.安全文件传送协议.可以为传输文件提供一种安全的网络的加密方法.sftp 与 ftp 有着几乎一样的语法和功能. ...

- Docker入门-笔记-1

Docker入门 Docker 是 Golang 编写的, 自 2013 年推出以来,受到越来越多的开发者的关注.如果你关注最新的技术发展,那么你一定听说过 Docker.不管是云服务还是微服务(Mi ...

- WinForm自定义控件之DefaultValue的误解

DefaultValue,顾名思义,默认值的意思.但这个默认值不是用来显示的,它的作用是当属性设置的值(无法代码写还是属性窗口输入)与DefaultValue相同时,会区别显示,比如其它值加粗,Def ...