069 在SparkStreaming的窗口分析

一:说明

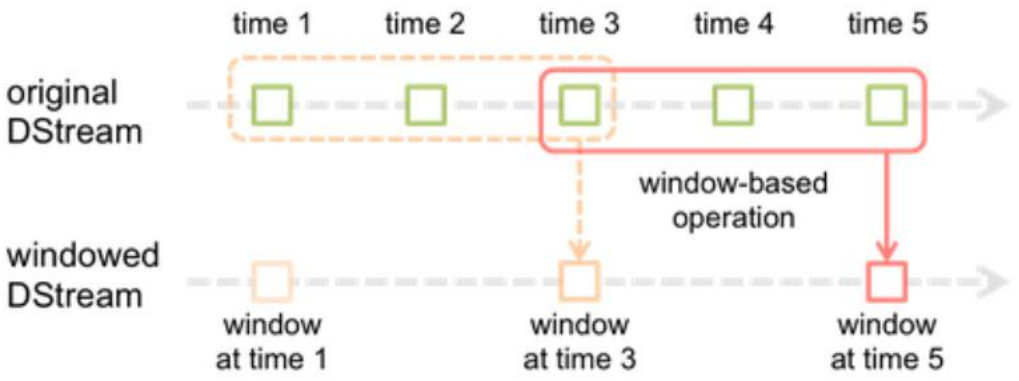

1.图例说明

-------------------------------------------------------------------------------------------------------------------------------------------------------------------------

2.对比说明

DStream:

batchInterval: 批次产生间隔时间

Window DStream:

windowInterval: 窗口间隔时间, 必须是父DStream的batchInterval的倍数(k >= 1, 整数)

slideInterval:窗口滑动间隔时间, 必须是父DStream的batchInterval的倍数(k >= 1, 整数)

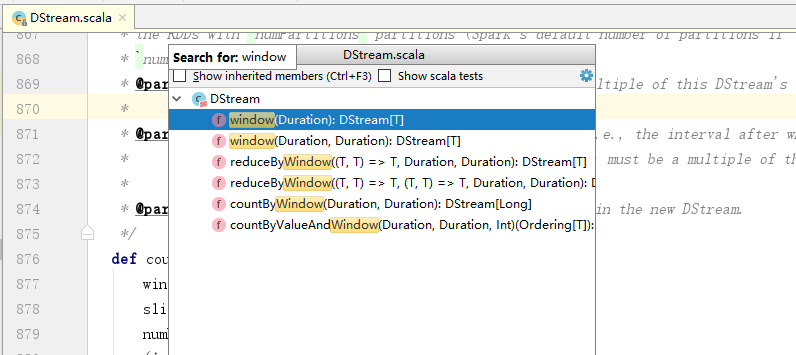

3.API

使用CTRL+F3,可以参考这篇文档的快捷键:https://blog.csdn.net/qq_36901488/article/details/80704245

二:程序

1.程序

package com.window.it

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.storage.StorageLevel

import org.apache.spark.streaming.{Seconds, State, StateSpec, StreamingContext}

import org.apache.spark.streaming.dstream.DStream

import org.apache.spark.streaming.kafka.KafkaUtils object ReduceWindow {

def main(args: Array[String]): Unit = {

val conf = new SparkConf()

.setAppName("StreamingWindowOfKafka")

.setMaster("local[*]")

val sc = SparkContext.getOrCreate(conf)

val ssc = new StreamingContext(sc, Seconds(5))

// 当调用updateStateByKey函数API的时候,必须给定checkpoint dir

// 路径对应的文件夹不能存在

ssc.checkpoint("hdfs://linux-hadoop01.ibeifeng.com:8020/beifeng/spark/streaming/452512") val kafkaParams = Map(

"group.id" -> "streaming-kafka-78912151",

"zookeeper.connect" -> "linux-hadoop01.ibeifeng.com:2181/kafka",

"auto.offset.reset" -> "smallest"

)

val topics = Map("beifeng" -> 4) // topics中value是读取数据的线程数量,所以必须大于等于1

val dstream = KafkaUtils.createStream[String, String, kafka.serializer.StringDecoder, kafka.serializer.StringDecoder](

ssc, // 给定SparkStreaming上下文

kafkaParams, // 给定连接kafka的参数信息 ===> 通过Kafka HighLevelConsumerAPI连接

topics, // 给定读取对应topic的名称以及读取数据的线程数量

StorageLevel.MEMORY_AND_DISK_2 // 指定数据接收器接收到kafka的数据后保存的存储级别

).map(_._2) val resultWordCount = dstream

.filter(line => line.nonEmpty)

.flatMap(line => line.split(" ").map((_, 1)))

.reduceByKeyAndWindow(

(a: Int, b: Int) => a + b,

Seconds(15), // 窗口大小

Seconds(10) // 滑动大小

)

resultWordCount.print() // 这个也是打印数据 // 启动开始处理

ssc.start()

ssc.awaitTermination() // 等等结束,监控一个线程的中断操作

}

}

2.效果

这里主要看的是页面的DAG。

069 在SparkStreaming的窗口分析的更多相关文章

- SparkStreaming实时日志分析--实时热搜词

Overview 整个项目的整体架构如下: 关于SparkStreaming的部分: Flume传数据到SparkStreaming:为了简单使用的是push-based的方式.这种方式可能会丢失数据 ...

- SparkStreaming 源码分析

SparkStreaming 分析 (基于1.5版本源码) SparkStreaming 介绍 SparkStreaming是一个流式批处理框架,它的核心执行引擎是Spark,适合处理实时数据与历史数 ...

- windows窗口分析,父窗口,子窗口,所有者窗口

(本文尝试通过一些简单的实验,来分析Windows的窗口机制,并对微软的设计理由进行一定的猜测,需要读者具备C++.Windows编程及MFC经验,还得有一定动手能力.文中可能出现一些术语不统一的现象 ...

- DirectStream、Stream的区别-SparkStreaming源码分析02

转http://hadoop1989.com/2016/03/15/KafkaStreaming/ 在Spark1.3之前,默认的Spark接收Kafka数据的方式是基于Receiver的,在这之后的 ...

- Flink Streaming基于滚动窗口的事件时间分析

使用flink-1.9.0进行的测试,在不同的并行度下,Flink对事件时间的处理逻辑不同.包括1.1在并行度为1的本地模式分析和1.2在多并行度的本地模式分析两部分.通过理论结合源码进行验证,得到具 ...

- LR12.53—第7课:分析场景

第7课:分析场景 在前面的课程中,您学习如何设计,控制和执行方案运行.一旦您已加载您的服务器,你要分析的运行,并确定需要被淘汰,以提高系统性能的问题. 在图表和报告中有关方案的性能您的分析会议上提出的 ...

- 小项目一---Python日志分析

日志分析 概述 分析的前提 半结构化数据 文本分析 提取数据(信息提取) 一.空格分隔 with open('xxx.log')as f: for line in f: for field in ...

- win32程序之窗口程序,以及消息机制

win32程序值窗口程序,以及消息机制 一丶简介 通过上一讲.我们了解了窗口其实是绘制出来的.而且是不断绘制的过程. 所以窗口的本质是绘制. 但是我们现在看到的窗口程序.都可以点击关闭按钮. 使用鼠标 ...

- FusionInsight大数据开发---SparkStreaming概述

SparkStreaming概述 SparkStreaming是Spark核心API的一个扩展,它对实时流式数据的处理具有可扩展性.高吞吐量.可容错性等特点. SparkStreaming原理 Spa ...

随机推荐

- 【原创】Linux基础之Shell脚本常用命令

#!/bin/sh 1 取脚本参数 $# 参数个数$0 当前脚本名$1 第1个参数$n 第n个参数$* 所有参数$@ 所有参数$? 上个命令的状态$$ 当前pid 2 日期 $ dateWed Mar ...

- 45)django-分页实现

Django提供了一个新的类来帮助你管理分页数据,.它可以接收列表.元组或其它可迭代的对象. 一:常用方法 >>> from django.core.paginator import ...

- ORACLE透明加密

--官网文档:https://www.oracle.com/technetwork/cn/tutorials/tde-096009-zhs.html#t概述Oracle 数据库 10g 第 2 版透明 ...

- ORA-00379: no free buffers available in buffer pool DEFAULT for block size 16K

SYS@orcl> select TABLESPACE_NAME ,AUTOEXTENSIBLE from dba_data_files ; ERROR: ORA-00379: no free ...

- Confluence 6 代理和 HTTPS 详细配置指南链接

详细配置指南 更多有关连接器示例,我们提供了一些按步骤配置的指南来帮助你启用 HTTPS 并正确配置你的代理. HTTPS: Running Confluence Over SSL or HTTPS ...

- Confluence 6 连接到 Jira 用户管理的建议

建议 如果下面所有的选项都为是的话: JIRA 应用程序不在高负载下运行. 你仅仅希望在一些不多的应用中跨平台管理你的用户和用户组,例如一个 JIRA 软件服务器和 Confluence 服务器,或者 ...

- 自执行匿名函数: (function() { /* code */ })();

1,常见格式:(function() { /* code */ })(); 2,解释:包围函数(function(){})的第一对括号向脚本返回未命名的函数,随后一对空括号立即执行返回的未命名函数,括 ...

- php实现备份数据库

public function dataBackup(){ $doc_root=$_SERVER['DOCUMENT_ROOT']; $file_path_name=$doc_root.'/sqlba ...

- uva11827 处理下输入

/*0.012s*/ #include<cstdio> #include<algorithm> using namespace std; ], n; int gcd(int a ...

- 性能测试四十七:jmeter性能监控工具ServerAgent

在liunx压力机进行压测的时候,可以在widows下开一个jmeter,只进行监控用,不产生压力,监控效果和dstat差不多 jmeter安装客户端插件 把工具放到服务端任意目录并解压,我这里放到了 ...