python爬虫——《瓜子网》的广州二手车市场信息

由于多线程爬取数据比单线程的效率要高,尤其对于爬取数据量大的情况,效果更好,所以这次采用多线程进行爬取。具体代码和流程如下:

import math

import re

from concurrent.futures import ThreadPoolExecutor

import requests

import lxml

import lxml.etree

# 获取网页源代码

def getHtml(url, header):

try:

response = requests.get(url, headers=header)

response.raise_for_status()

return response.content.decode('utf-8')

except:

return ''

# 获取翻页url

def getPageUrl(url, response):

mytree = lxml.etree.HTML(response)

# 页码

carNum = mytree.xpath('//*[@id="post"]/p[3]/text()')[0]

carNum = math.ceil(int(re.findall('(\d+)', carNum)[0]) / 40)

urlList = url.rsplit('/', maxsplit=1)

pageUrlList = []

if carNum != 0:

for i in range(1, carNum + 1):

pageUrl = urlList[0] + "/o" + str(i) + "/" + urlList[1]

pageUrlList.append(pageUrl)

return pageUrlList

# 获取汽车品牌

def getCarBrand(response):

mytree = lxml.etree.HTML(response)

# 汽车品牌url

carBrandUrl = mytree.xpath('//div[@class="dd-all clearfix js-brand js-option-hid-info"]/ul/li/p/a/@href')

# 汽车品牌名

carBrandName = mytree.xpath('//div[@class="dd-all clearfix js-brand js-option-hid-info"]/ul/li/p/a/text()')

carBrandDict = {}

for i in range(len(carBrandName)):

carBrandDict[carBrandName[i]] = "https://www.guazi.com" + carBrandUrl[i]

return carBrandDict

# 获取汽车信息

def getCarInfo(pageUrl, carBrandName):

response = getHtml(pageUrl, header)

mytree = lxml.etree.HTML(response)

for i in range(40):

# 汽车名称

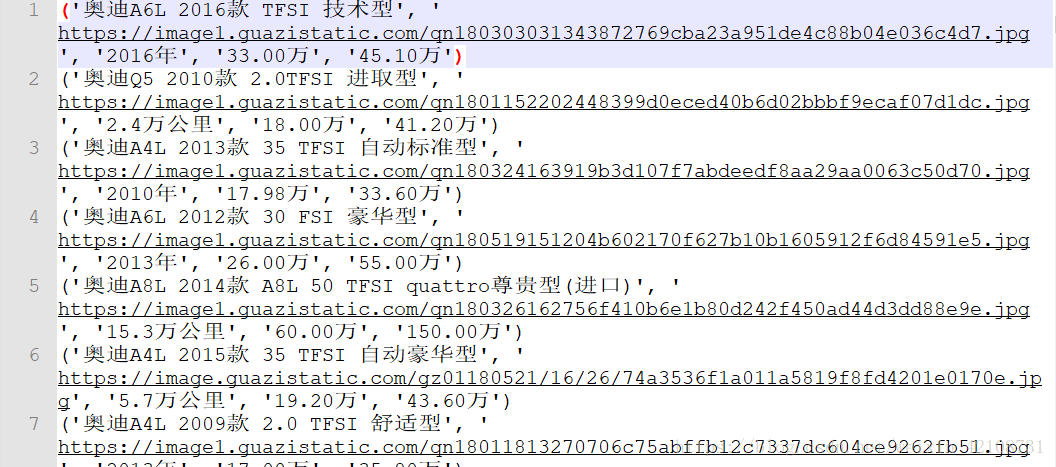

carName = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/h2/text()')[i]

# 汽车图片

carPic = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/img/@src')[i]

carPic = carPic.rsplit("jpg", maxsplit=1)[0] + 'jpg'

# 汽车出产年份、里程数

carInfo = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/div[1]/text()')[i]

# 现价

carCurrentPrice = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/div[2]/p/text()')[i] + "万"

# 原价

carOriginPrice = mytree.xpath('//ul[@class="carlist clearfix js-top"]/li/a/div[2]/em/text()')[i]

print(carName, carPic, carInfo, carCurrentPrice, carOriginPrice)

# 写入文件

path = carBrandName + '.txt'

with open(path, 'a+') as f:

f.write(str((carName, carPic, carInfo, carCurrentPrice, carOriginPrice)) + '\n')

if __name__ == '__main__':

url = 'https://www.guazi.com/gz/buy/'

header = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_5) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.85 Safari/537.36",

}

# 获得初始页源代码

html = getHtml(url, header)

# 获取汽车品牌信息字典

carBrandDict = getCarBrand(html)

# 多线程(10条的线程池)

with ThreadPoolExecutor(10) as exT:

# 程序执行流程

# 根据汽车品牌进行爬取

for carBrandName, carBrandUrl in carBrandDict.items():

# 获取不同品牌页面源代码

html = getHtml(carBrandUrl, header)

# 获取当前品牌页面的页码url

pageUrlList = getPageUrl(carBrandUrl, html)

# 翻页

for pageUrl in pageUrlList:

# 获取汽车信息并写入文件

exT.submit(getCarInfo, pageUrl, carBrandName)结果如下:

由于《瓜子网》更新过域名,所以之前有评论说网页打不开,现已做了处理,程序能正常爬取数据啦!

以上就是我的分享,如果有什么不足之处请指出,多交流,谢谢!

如果喜欢,请关注我的博客:https://www.cnblogs.com/qiuwuzhidi/

想获取更多数据或定制爬虫的请点击python爬虫专业定制

python爬虫——《瓜子网》的广州二手车市场信息的更多相关文章

- python爬虫实例--网易云音乐排行榜爬虫

网易云音乐,以前是有个api 链接的json下载的,现在没了, 只有音乐id,title , 只能看播放请求了, 但是播放请求都是加密的值,好坑... 进过各种努力, 终于找到了个大神写的博客,3.6 ...

- Python 爬虫 当当网图书 scrapy

目标站点需求分析 获取当当网每个图书名字和评论数 涉及的库 scrapy,mysql 获取解析单页源码 保存到数据库中 结果

- python爬虫 赶集网

#coding=utf-8import requestsfrom lxml import etreefrom sqlalchemy import create_enginefrom sqlalchem ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- Python爬虫开源项目代码,爬取微信、淘宝、豆瓣、知乎、新浪微博、QQ、去哪网等 代码整理

作者:SFLYQ 今天为大家整理了32个Python爬虫项目.整理的原因是,爬虫入门简单快速,也非常适合新入门的小伙伴培养信心.所有链接指向GitHub,祝大家玩的愉快 1.WechatSogou [ ...

- python链家网高并发异步爬虫asyncio+aiohttp+aiomysql异步存入数据

python链家网二手房异步IO爬虫,使用asyncio.aiohttp和aiomysql 很多小伙伴初学python时都会学习到爬虫,刚入门时会使用requests.urllib这些同步的库进行单线 ...

- python爬虫:爬取慕课网视频

前段时间安装了一个慕课网app,发现不用注册就可以在线看其中的视频,就有了想爬取其中的视频,用来在电脑上学习.决定花两天时间用学了一段时间的python做一做.(我的新书<Python爬虫开发与 ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- Python爬虫教程-15-读取cookie(人人网)和SSL(12306官网)

Python爬虫教程-15-爬虫读取cookie(人人网)和SSL(12306官网) 上一篇写道关于存储cookie文件,本篇介绍怎样读取cookie文件 cookie的读取 案例v16ssl文件:h ...

随机推荐

- VIM 编辑器操作详解

1 vim 使用介绍 1.1 vim 安装 # CentOS 安装: yum install -y vim # Ubuntu 安装: sudu apt-get install vim 安装完成后,可使 ...

- 手写无缝轮播banner

<div class="banner"> <ul class="clearfloat bannerul xin" id="xin&q ...

- [Fundamental of Power Electronics]-PART I-3.稳态等效电路建模,损耗和效率-3.5/3.6 示例:Boost变换器中包含的半导体传导损耗/要点小结

3.5 示例:Boost变换器中包含的半导体传导损耗 作为最后一个示例,让我们考虑对图3.22所示的Boost变换器中的半导体传导损耗进行建模.功率损耗的另一个主要来源是半导体器件的正向电压降引起的传 ...

- CSS3常见动画

一.是什么 CSS动画(CSS Animations)是为层叠样式表建议的允许可扩展标记语言(XML)元素使用CSS的动画的模块 即指元素从一种样式逐渐过渡为另一种样式的过程 常见的动画效果有很多,如 ...

- 开篇:ISP基本模块介绍

一般来说,ISP pipeline没有非常严格的流程,各家厂商具体实现方案或多或少都有些差异,但大致流程如下图所示.其中,又可以根据处理的数据将其分成BPS(Bayer process segment ...

- Sql Server存储过程和游标的配合操作

本段代码主要为了记录存储过程以及游标的使用,防止以后自己忘记 知识点:1.存储过程书写 2.游标书写 3.游标循环更新记录 create proc saletargetas declare @ower ...

- 最清晰易懂的 Go WaitGroup 源码剖析

hi,大家好,我是haohongfan. 本篇主要介绍 WaitGroup 的一些特性,让我们从本质上去了解 WaitGroup.关于 WaitGroup 的基本用法这里就不做过多介绍了.相对于< ...

- Go-06-数据类型、常量、运算符

数据类型转换 Go语言采用数据类型前置加括号的方式进行类型转换,格式如:T(表达式).T表示要转换的类型:表达式包括变量.数值.函数返回值等. var a int =100 b := float(a) ...

- 《C++编程思想》部分章节学习笔记整理

简介 此笔记为<C++编程思想>中部分章节的学习笔记,主要是第15章--多态性和虚函数 的学习笔记,此外还有少量其他章节的内容. 目录 文档:<C++编程思想>

- JAVAEE_Servlet_11_GetAndPost

Get请求和Post请求 * Get请求 和 Post请求各方面分析 - 什么情况下浏览器发送的是Get请求? 1. 通过浏览器的地址栏输入地址,所访问的URL都是get请求,如果以post定义,那么 ...