python 爬虫 汽车之家车辆参数反爬

水平有限,仅供参考。

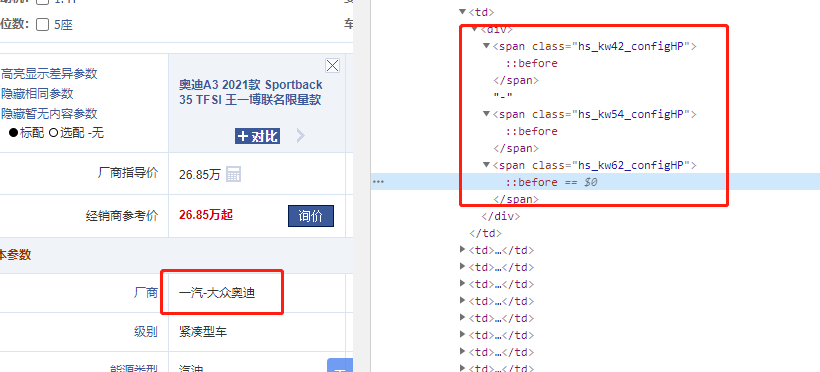

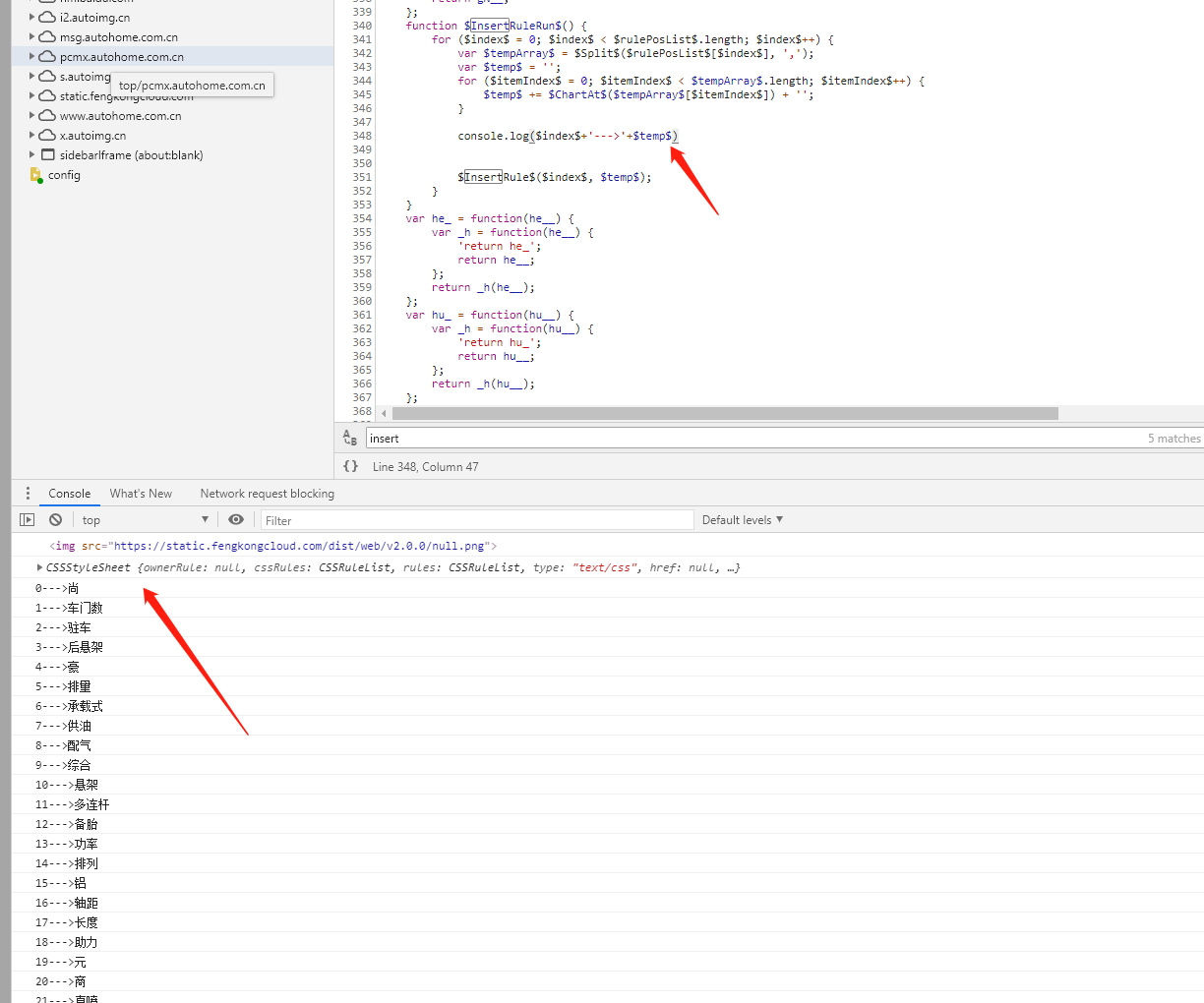

如图所示,汽车之家的车辆详情里的数据做了反爬对策,数据被CSS伪类替换。

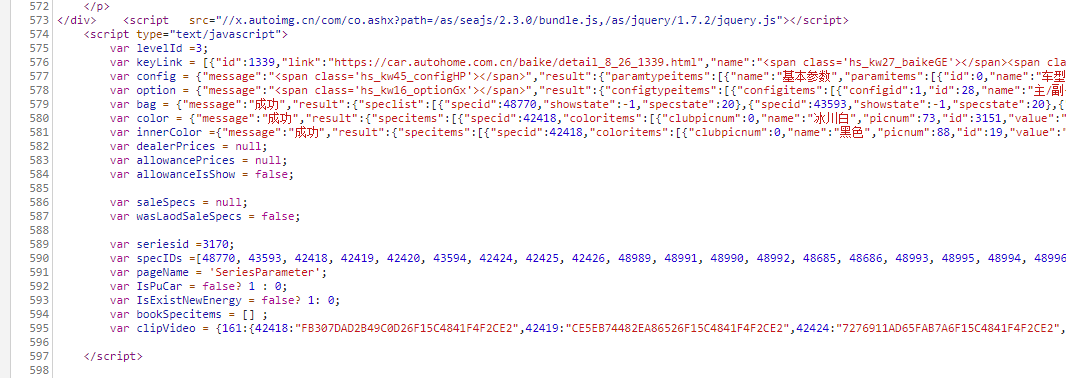

观察 Sources 发现数据就在当前页面。

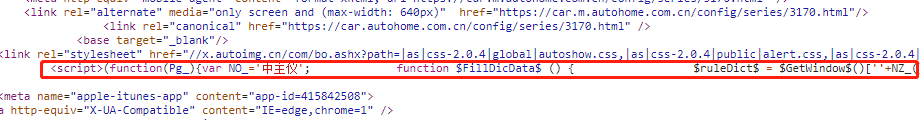

发现若干条进行CSS替换的js

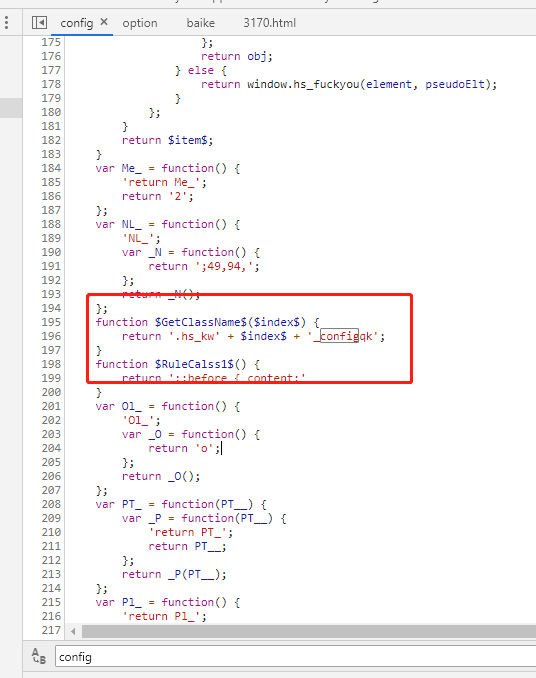

继续深入此JS

知道了数据与规则,剩下的交给PYTHON。

def repliceStr(browser,textJs,Js):

_config_pos=textJs.find("return '.")

JsSplit=textJs[_config_pos:_config_pos+70]

ClassHead=re.search("[A-Za-z]{2}_[A-Za-z]{2}",JsSplit,re.S).group(0)

ClassFoot=re.search("_[A-Za-z]+';",JsSplit,re.S).group(0)[:-2]

pos=textJs.find("$InsertRule$($index$, $temp$);")

top=textJs[0:pos]

bottom=textJs[pos:]

JsBack = browser.execute_script('''

var suc={};

'''+top+' suc[$index$]=$temp$; '+bottom+'''

return suc

''')

for cj in range(0,len(JsBack)):

cjclass=ClassHead+str(cj)+ClassFoot

Js=re.sub("<span class='"+cjclass+"'></span>",JsBack[str(cj)], Js)

return Js

#获取详情页的数据

def getDetail(base_url):

chrome_options = webdriver.ChromeOptions()

chrome_options.add_argument('--headless')

browser = webdriver.Chrome(chrome_options=chrome_options)

browser.get(base_url)

#在这里进行文件替换,反爬页面

#keyLink = re.search("var keyLink = (.*?)}];", browser.page_source, re.S)

config = re.search("var config = (.*?)};", browser.page_source, re.S)

option = re.search("var option = (.*?)};", browser.page_source, re.S)

option=option.group(0)[13:-1]

config=config.group(0)[13:-1]

script = re.findall("<script>(.*?)</script>", browser.page_source,re.S)

for i in range(0,len(script)):

if re.search("_config",script[i],re.S) :

config=repliceStr(browser,script[i],config)

if re.search("_option",script[i],re.S) :

option=repliceStr(browser,script[i],option)

option=demjson.decode(option);

config=demjson.decode(config);

carr={}

for item in config['result']['paramtypeitems'] :

bigTitle=item['name']

carr[bigTitle]={}

index=0

for ni in item['paramitems']:

cate =ni['name']

value=ni['valueitems'][0]['value']

carr[bigTitle][index]=[cate,value]

index=index+1

for item in option['result']['configtypeitems'] :

bigTitle=item['name']

carr[bigTitle]={}

index=0

for ni in item['configitems']:

cate =ni['name']

value=ni['valueitems'][0]['value']

carr[bigTitle][index]=[cate,value]

index=index+1

time.sleep(10)

return carr

刚接触PYTHON,还在学习中,找不到更好的解法。

python 爬虫 汽车之家车辆参数反爬的更多相关文章

- python爬虫的一个常见简单js反爬

python爬虫的一个常见简单js反爬 我们在写爬虫是遇到最多的应该就是js反爬了,今天分享一个比较常见的js反爬,这个我已经在多个网站上见到过了. 我把js反爬分为参数由js加密生成和js生成coo ...

- Python爬虫入门教程 64-100 反爬教科书级别的网站-汽车之家,字体反爬之二

说说这个网站 汽车之家,反爬神一般的存在,字体反爬的鼻祖网站,这个网站的开发团队,一定擅长前端吧,2019年4月19日开始写这篇博客,不保证这个代码可以存活到月底,希望后来爬虫coder,继续和汽车之 ...

- python爬虫——汽车之家数据

相信很多买车的朋友,首先会在网上查资料,对比车型价格等,首选就是"汽车之家",于是,今天我就给大家扒一扒汽车之家的数据: 一.汽车价格: 首先获取的数据是各款汽车名称.价格范围以及 ...

- nodejs爬虫——汽车之家所有车型数据

应用介绍 项目Github地址:https://github.com/iNuanfeng/node-spider/ nodejs爬虫,爬取汽车之家(http://www.autohome.com.cn ...

- python爬虫---CrawlSpider实现的全站数据的爬取,分布式,增量式,所有的反爬机制

CrawlSpider实现的全站数据的爬取 新建一个工程 cd 工程 创建爬虫文件:scrapy genspider -t crawl spiderName www.xxx.com 连接提取器Link ...

- Scrapy框架爬虫初探——中关村在线手机参数数据爬取

关于Scrapy如何安装部署的文章已经相当多了,但是网上实战的例子还不是很多,近来正好在学习该爬虫框架,就简单写了个Spider Demo来实践.作为硬件数码控,我选择了经常光顾的中关村在线的手机页面 ...

- Python爬虫:用BeautifulSoup进行NBA数据爬取

爬虫主要就是要过滤掉网页中没用的信息.抓取网页中实用的信息 一般的爬虫架构为: 在python爬虫之前先要对网页的结构知识有一定的了解.如网页的标签,网页的语言等知识,推荐去W3School: W3s ...

- Python爬虫入门教程 2-100 妹子图网站爬取

妹子图网站爬取---前言 从今天开始就要撸起袖子,直接写Python爬虫了,学习语言最好的办法就是有目的的进行,所以,接下来我将用10+篇的博客,写爬图片这一件事情.希望可以做好. 为了写好爬虫,我们 ...

- python爬虫实战(六)--------新浪微博(爬取微博帐号所发内容,不爬取历史内容)

相关代码已经修改调试成功----2017-4-13 详情代码请移步我的github:https://github.com/pujinxiao/sina_spider 一.说明 1.目标网址:新浪微博 ...

随机推荐

- python机器学习实现逻辑斯蒂回归

逻辑斯蒂回归 关注公众号"轻松学编程"了解更多. [关键词]Logistics函数,最大似然估计,梯度下降法 1.Logistics回归的原理 利用Logistics回归进行分类的 ...

- 电脑查看当前自己的wifi密码

菜单+R 输入control 点击确认.

- 【Android Studio】安卓开发初体验2——Activity

Activity是什么 Activity用于提供可视化用户界面的组件,可以与用户进行交互来完成某项任务,一个应用程序中可以包含零个或多个活动 Activity的创建 首先将左侧的Active Tool ...

- 关于H5页面在微信浏览器中音视频播放的问题

Android 上,因为各个软件使用的浏览器渲染引擎不一样,所以视频播放的效果差异也很大,这里主要以微信为主.微信使用的是腾讯浏览器自带的X5内核. 而iOS是不允许使用第三方浏览器内核的,就是Goo ...

- ant-design-vue 快速避坑指南

ant-design-vue是蚂蚁金服 Ant Design 官方唯一推荐的Vue版UI组件库,它其实是Ant Design的Vue实现,组件的风格与Ant Design保持同步,组件的html结构和 ...

- redis 在windows 下的安装和使用

1.下载试用 首先下载https://github.com/dmajkic/redis/downloads,我下载的是2.4.5的版本,是个压缩包解压后里面有两个文件夹一个是32bit一个是64位的, ...

- System.Net邮件发送功能踩过的坑

System.Net邮件发送功能踩过的坑 目录 System.Net邮件发送功能踩过的坑 1.EazyEmail邮件发送类库 2.邮件发送授权码与邮件密码 3.通过邮件密码来发送邮件 4.Wiresh ...

- 日志切分神器--logrotate

Blog:博客园 个人 概述 还在自己写定时切分日志的脚本?试试系统自带的logrotate工具吧! logrotate是一个日志文件管理工具.用于分割日志文件,删除旧的日志文件,并创建新的日志文件, ...

- 17flask分页

一,flask_sqlachemy的使用 如果想要展示出来的页面是分页显示,则首先需要知道每页应该分多少个条目,然后通过数据库去查找对应的条数,同时也需要和分页所需的"paginate&qu ...

- cmd,py脚本,py编译的exe,uipath及uibot对它们的调用

UIPATH调用Python编译程序exe 好处: 1)code不以可编辑的状态被用户接触,对于不懂反编译的一般用户,可提升一定的代码安全性: 2)不需要用户机器上安装 python环境. 3)可以将 ...