flume采集log4j日志到kafka

简单测试项目:

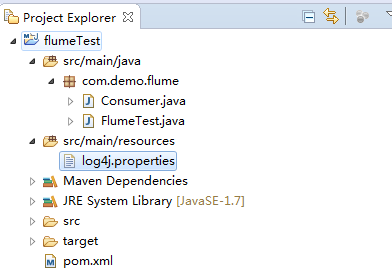

1、新建Java项目结构如下:

测试类FlumeTest代码如下:

- package com.demo.flume;

- import org.apache.log4j.Logger;

- public class FlumeTest {

- private static final Logger LOGGER = Logger.getLogger(FlumeTest.class);

- public static void main(String[] args) throws InterruptedException {

- for (int i = 20; i < 100; i++) {

- LOGGER.info("Info [" + i + "]");

- Thread.sleep(1000);

- }

- }

- }

监听kafka接收消息Consumer代码如下:

- package com.demo.flume;

- /**

- * INFO: info

- * User: zhaokai

- * Date: 2017/3/17

- * Version: 1.0

- * History: <p>如果有修改过程,请记录</P>

- */

- import java.util.Arrays;

- import java.util.Properties;

- import org.apache.kafka.clients.consumer.ConsumerRecord;

- import org.apache.kafka.clients.consumer.ConsumerRecords;

- import org.apache.kafka.clients.consumer.KafkaConsumer;

- public class Consumer {

- public static void main(String[] args) {

- System.out.println("begin consumer");

- connectionKafka();

- System.out.println("finish consumer");

- }

- @SuppressWarnings("resource")

- public static void connectionKafka() {

- Properties props = new Properties();

- props.put("bootstrap.servers", "192.168.1.163:9092");

- props.put("group.id", "testConsumer");

- props.put("enable.auto.commit", "true");

- props.put("auto.commit.interval.ms", "1000");

- props.put("session.timeout.ms", "30000");

- props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

- props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

- KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

- consumer.subscribe(Arrays.asList("flumeTest"));

- while (true) {

- ConsumerRecords<String, String> records = consumer.poll(100);

- try {

- Thread.sleep(2000);

- } catch (InterruptedException e) {

- e.printStackTrace();

- }

- for (ConsumerRecord<String, String> record : records) {

- System.out.printf("===================offset = %d, key = %s, value = %s", record.offset(), record.key(),

- record.value());

- }

- }

- }

- }

log4j配置文件配置如下:

- log4j.rootLogger=INFO,console

- # for package com.demo.kafka, log would be sent to kafka appender.

- log4j.logger.com.demo.flume=info,flume

- log4j.appender.flume = org.apache.flume.clients.log4jappender.Log4jAppender

- log4j.appender.flume.Hostname = 192.168.1.163

- log4j.appender.flume.Port = 4141

- log4j.appender.flume.UnsafeMode = true

- log4j.appender.flume.layout=org.apache.log4j.PatternLayout

- log4j.appender.flume.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %p [%c:%L] - %m%n

- # appender console

- log4j.appender.console=org.apache.log4j.ConsoleAppender

- log4j.appender.console.target=System.out

- log4j.appender.console.layout=org.apache.log4j.PatternLayout

- log4j.appender.console.layout.ConversionPattern=%d [%-5p] [%t] - [%l] %m%n

备注:其中hostname为flume安装的服务器IP,port为端口与下面的flume的监听端口相对应

pom.xml引入如下jar:

- <dependencies>

- <dependency>

- <groupId>org.slf4j</groupId>

- <artifactId>slf4j-log4j12</artifactId>

- <version>1.7.10</version>

- </dependency>

- <dependency>

- <groupId>org.apache.flume</groupId>

- <artifactId>flume-ng-core</artifactId>

- <version>1.5.0</version>

- </dependency>

- <dependency>

- <groupId>org.apache.flume.flume-ng-clients</groupId>

- <artifactId>flume-ng-log4jappender</artifactId>

- <version>1.5.0</version>

- </dependency>

- <dependency>

- <groupId>junit</groupId>

- <artifactId>junit</artifactId>

- <version>4.12</version>

- </dependency>

- <dependency>

- <groupId>org.apache.kafka</groupId>

- <artifactId>kafka-clients</artifactId>

- <version>0.10.2.0</version>

- </dependency>

- <dependency>

- <groupId>org.apache.kafka</groupId>

- <artifactId>kafka_2.10</artifactId>

- <version>0.10.2.0</version>

- </dependency>

- <dependency>

- <groupId>org.apache.kafka</groupId>

- <artifactId>kafka-log4j-appender</artifactId>

- <version>0.10.2.0</version>

- </dependency>

- <dependency>

- <groupId>com.google.guava</groupId>

- <artifactId>guava</artifactId>

- <version>18.0</version>

- </dependency>

- </dependencies>

2、配置flume

flume/conf下:

新建avro.conf 文件内容如下:

当然skin可以用任何方式,这里我用的是kafka,具体的skin方式可以看官网

- a1.sources=source1

- a1.channels=channel1

- a1.sinks=sink1

- a1.sources.source1.type=avro

- a1.sources.source1.bind=192.168.1.163

- a1.sources.source1.port=4141

- a1.sources.source1.channels = channel1

- a1.channels.channel1.type=memory

- a1.channels.channel1.capacity=10000

- a1.channels.channel1.transactionCapacity=1000

- a1.channels.channel1.keep-alive=30

- a1.sinks.sink1.type = org.apache.flume.sink.kafka.KafkaSink

- a1.sinks.sink1.topic = flumeTest

- a1.sinks.sink1.brokerList = 192.168.1.163:9092

- a1.sinks.sink1.requiredAcks = 0

- a1.sinks.sink1.sink.batchSize = 20

- a1.sinks.sink1.channel = channel1

如上配置,flume服务器运行在192.163.1.163上,并且监听的端口为4141,在log4j中只需要将日志发送到192.163.1.163的4141端口就能成功的发送到flume上。flume会监听并收集该端口上的数据信息,然后将它转化成kafka event,并发送到kafka集群flumeTest topic下。

3、启动flume并测试

- flume启动命令:bin/flume-ng agent --conf conf --conf-file conf/avro.conf --name a1 -Dflume.root.logger=INFO,console

- 运行FlumeTest类的main方法打印日志

- 允许Consumer的main方法打印kafka接收到的数据

flume采集log4j日志到kafka的更多相关文章

- flume学习(三):flume将log4j日志数据写入到hdfs(转)

原文链接:flume学习(三):flume将log4j日志数据写入到hdfs 在第一篇文章中我们是将log4j的日志输出到了agent的日志文件当中.配置文件如下: tier1.sources=sou ...

- Centos7 搭建 Flume 采集 Nginx 日志

版本信息 CentOS: Linux localhost.localdomain 3.10.0-862.el7.x86_64 #1 SMP Fri Apr 20 16:44:24 UTC 2018 x ...

- Flume采集处理日志文件

Flume简介 Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集.聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据:同时,Flume提供对数据 ...

- 利用Flume采集IIS日志到HDFS

1.下载flume 1.7 到官网上下载 flume 1.7版本 2.配置flume配置文件 刚开始的想法是从IIS--->Flume-->Hdfs 但在采集的时候一直报错,无法直接连接到 ...

- Flume采集Nginx日志到HDFS

下载apache-flume-1.7.0-bin.tar.gz,用 tar -zxvf 解压,在/etc/profile文件中增加设置: export FLUME_HOME=/opt/apache-f ...

- flume采集MongoDB数据到Kafka中

环境说明 centos7(运行于vbox虚拟机) flume1.9.0(自定义了flume连接mongodb的source插件) jdk1.8 kafka(2.11) zookeeper(3.57) ...

- 一次flume exec source采集日志到kafka因为单条日志数据非常大同步失败的踩坑带来的思考

本次遇到的问题描述,日志采集同步时,当单条日志(日志文件中一行日志)超过2M大小,数据无法采集同步到kafka,分析后,共踩到如下几个坑.1.flume采集时,通过shell+EXEC(tail -F ...

- flume实时采集mysql数据到kafka中并输出

环境说明 centos7(运行于vbox虚拟机) flume1.9.0(flume-ng-sql-source插件版本1.5.3) jdk1.8 kafka(版本忘了后续更新) zookeeper(版 ...

- 带你看懂大数据采集引擎之Flume&采集目录中的日志

一.Flume的介绍: Flume由Cloudera公司开发,是一种提供高可用.高可靠.分布式海量日志采集.聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于采集数据:同时,flum ...

随机推荐

- Sqoop-将Hive ORC表导出到MySQL

Sqoop-将Hive ORC表导出到MySQL sqoop export --connect jdbc:mysql://localhost:3306/test --username root --p ...

- 3.scala容器

3.scala容器 a:focus { outline: thin dotted #333; outline: 5px auto -webkit-focus-ring-color; outline-o ...

- Elasticsearch 配置优化

cluster.routing.allocation.same_shard.host:true 这会防止同一个shard的主副本存在同一个物理机上(因为如果存在一个机器上,副本的高可用性就没有了). ...

- VLAN虚拟局域网技术(一)-计算机网络

本文主要知识来源于学校课程,部分知识来自于H3C公司教材,未经许可,禁止转载.如需转载,请联系作者并注明出处. 1. VLAN(Virtual LAN):我们称之为虚拟局域网,它的作用就是将物理上互 ...

- 关于Android中根据ID名动态获取资源的两个方法

在开发中, 我们习惯了类似下面这种方式去实现引用资源: context.getResources().getDrawable(R.drawable.flower); 但是,当我们提前知道这个资源的id ...

- 在Window工作区按下鼠标左键拖动窗体

Window.DragMove(): 允许使用在窗口工作区的暴露区域上方按下其鼠标左键的鼠标来拖动窗口.(窗口工作区:除去窗体的title.bottom后的剩余部分空间) 使用该方法时注意:一定要在鼠 ...

- 前端工程师(JavaScript)在业余时间如何提高自身能力

1.前端工程师(JavaScript)在业余时间如何提高自身能力? https://www.zhihu.com/question/40186398?sort=created 2.前端开发工程师必读书籍 ...

- “一键”知道自己的IP地址和网络供应商

打开浏览器,然后在地址栏里面输入“www.baidu.com” 进入百度主页以后,在搜索框内输入 “ip”,然后回车就可以了

- 【SQL查询】查询结果翻译成其他值_decode

decode()函数简介: 主要作用:将查询结果翻译成其他值(即以其他形式表现出来,以下举例说明): 使用方法: Select decode(columnname,值1,翻译值1,值2,翻译值2,.. ...

- jsp中的session

浏览器和服务器的异常通话 常用方法 setAttribute(String key,Object value);//设置值 getAttribute(String key); //取值 Invalid ...