Stanford机器学习---第四讲. 神经网络的表示 Neural Networks representation

原文 http://blog.csdn.net/abcjennifer/article/details/7749309

本栏目(Machine learning)包括单参数的线性回归、多参数的线性回归、Octave Tutorial、Logistic Regression、Regularization、神经网络、机器学习系统设计、SVM(Support Vector Machines 支持向量机)、聚类、降维、异常检测、大规模机器学习等章节。所有内容均来自Standford公开课machine learning中Andrew老师的讲解。(https://class.coursera.org/ml/class/index)

第四讲——Neural Networks 神经网络的表示

===============================

(一)、为什么引入神经网络?——Nonlinear hypothesis

(二)、神经元与大脑(Neurons and Brain)

(三)、神经网络的表示形式

(四)、怎样用神经网络实现逻辑表达式?

(五)、分类问题(Classification)

本章主要围绕神经网络的建模及其线性表示(即neural networks的representation)做以初步了解,在下一章中将会有更详细的神经网络如何学习方面的知识。

===============================

(一)、为什么引入神经网络?——Nonlinear hypothesis

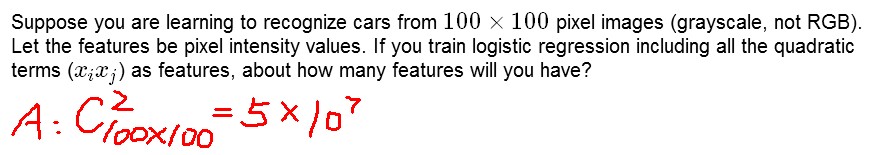

之前我们讨论的ML问题中,主要针对Regression做了分析,其中采用梯度下降法进行参数更新。然而其可行性基于假设参数不多,如果参数多起来了怎么办呢?比如下图中这个例子:从100*100个pixels中选出所有XiXj作为logistic regression的一个参数,那么总共就有5*10^7个feature,即x有这么多维。

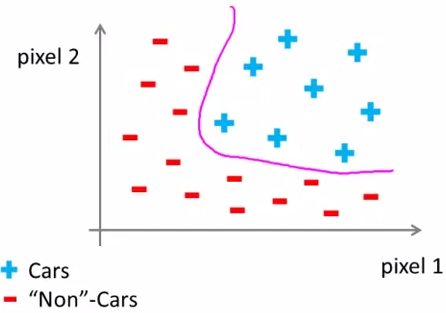

所以引入了Nonlinear hypothesis,应对高维数据和非线性的hypothesis(如下图所示):

===============================

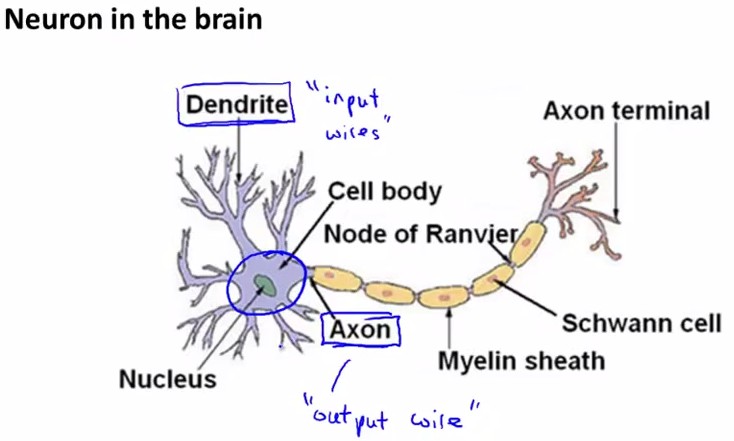

(二)、神经元与大脑(neurons and brain)

神经元工作模式:

神经网络的逻辑单元:输入向量x(input layer),中间层a(2,i)(hidden layer), 输出层h(x)(output layer)。

其中,中间层的a(2,i)中的2表示第二个级别(第一个级别是输入层),i表示中间层的第几个元素。或者可以说,a(j,i) is the activation of unit i in layer j.

===============================

(三)、神经网络的表示形式

从图中可知,中间层a(2,j)是输入层线性组合的sigmod值,输出又是中间层线性组合的sigmod值。

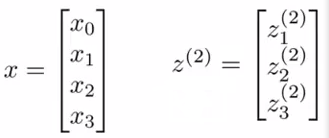

下面我们进行神经网络参数计算的向量化:

令z(2)表示中间层,x表示输入层,则有

,

,

z(2)=Θ(1)x

a(2)=g(z(2))

或者可以将x表示成a(1),那么对于输入层a(1)有[x0~x3]4个元素,中间层a(2)有[a(2)0~a(2)3]4个元素(其中令a(2)0=1),则有

h(x)= a(3)=g(z(3))

z(3)=Θ(2)a(2)

通过以上这种神经元的传递方式(input->activation->output)来计算h(x), 叫做Forward propagation, 向前传递。

这里我们可以发现,其实神经网络就像是logistic regression,只不过我们把logistic regression中的输入向量[x1~x3]变成了中间层的[a(2)1~a(2)3], 即

h(x)=g(Θ(2)0 a(2)0+Θ(2)1 a(2)1+Θ(2)2 a(2)2+Θ(2)3 a(2)3)

而中间层又由真正的输入向量通过Θ(1)学习而来,这里呢,就解放了输入层,换言之输入层可以是original input data的任何线性组合甚至是多项式组合如set x1*x2 as original x1...另外呢,具体怎样利用中间层进行更新下面会更详细地讲;此外,还有一些其他模型,比如:

===============================

(四)、怎样用神经网络实现逻辑表达式?

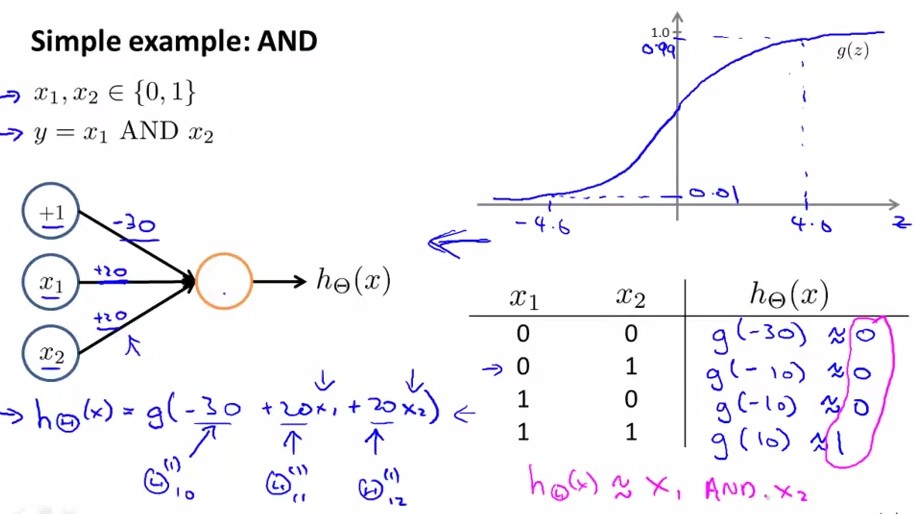

神经网路中,单层神经元(无中间层)的计算可用来表示逻辑运算,比如逻辑AND、逻辑或OR

举例说明:逻辑与AND;下图中左半部分是神经网络的设计与output层表达式,右边上部分是sigmod函数,下半部分是真值表。

给定神经网络的权值就可以根据真值表判断该函数的作用。再给出一个逻辑或的例子,如下图所示:

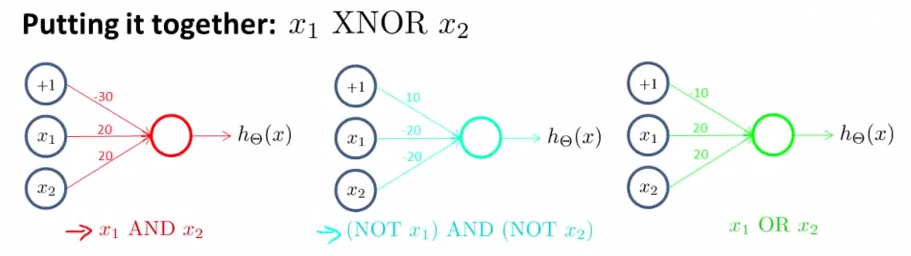

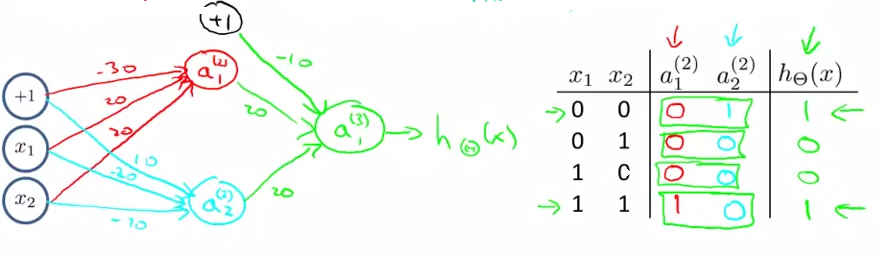

以上两个例子只是单层传递,下面我们再给出一个更复杂的例子,用来实现逻辑表达< x1 XNOR x2 >, 即逻辑同或关系,它由前面几个例子共同实现:

将AND、NOT AND和 OR分别放在下图中输入层和输出层的位置,即可得到x1 XNOR x2,道理显而易见:

a21 = x1 && x2

a22 = (﹁x1)&&(﹁x2)

a31 =a21 ||a21 =(x1 && x2) || (﹁x1)&&(﹁x2) = x1 XNOR x2;

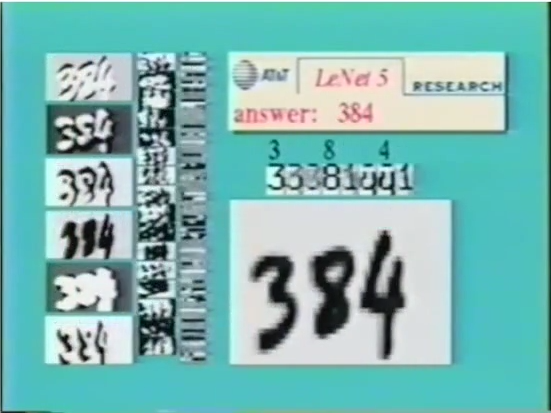

应用:手写识别系统

===============================

(五)、分类问题(Classification)

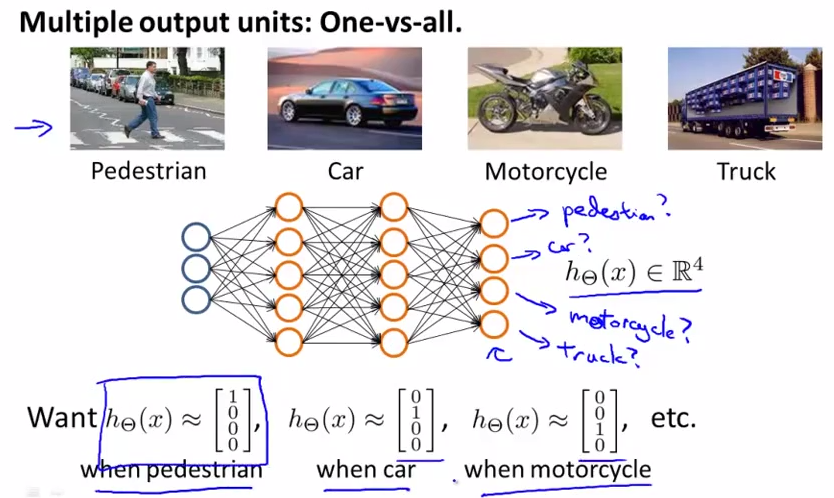

记得上一章中我们讲过的one-vs-all分类问题么?one-vs-all方法是把二类分类问题到多类分类的一个推广,在这里,我们就讲述如何用神经网络进行分类。网络设计如下图所示:

输入向量x有三个维度,两个中间层,输出层4个神经元分别用来表示4类,也就是每一个数据在输出层都会出现[a b c d]T,且a,b,c,d中仅有一个为1,表示当前类。

===============================

小结

本章引入了ML中神经网络的概念,主要讲述了如何利用神经网络的construction及如何进行逻辑表达function的构造,在下一章中我们将针对神经网络的学习过程进行更详细的讲述。

Stanford机器学习---第四讲. 神经网络的表示 Neural Networks representation的更多相关文章

- (原创)Stanford Machine Learning (by Andrew NG) --- (week 4) Neural Networks Representation

Andrew NG的Machine learning课程地址为:https://www.coursera.org/course/ml 神经网络一直被认为是比较难懂的问题,NG将神经网络部分的课程分为了 ...

- 8、神经网络:表述(Neural Networks: Representation)

8.1 非线性假设 我们之前学的,无论是线性回归还是逻辑回归都有这样一个缺点,即:当特征太多时,计算的负荷会非常大. 下面是一个例子: 当我们使用x1, x2 的多次项式进行预测时,我们可以应用的很好 ...

- 第十四章——循环神经网络(Recurrent Neural Networks)(第一部分)

由于本章过长,分为两个部分,这是第一部分. 这几年提到RNN,一般指Recurrent Neural Networks,至于翻译成循环神经网络还是递归神经网络都可以.wiki上面把Recurrent ...

- 第十四章——循环神经网络(Recurrent Neural Networks)(第二部分)

本章共两部分,这是第二部分: 第十四章--循环神经网络(Recurrent Neural Networks)(第一部分) 第十四章--循环神经网络(Recurrent Neural Networks) ...

- 循环神经网络(RNN, Recurrent Neural Networks)介绍(转载)

循环神经网络(RNN, Recurrent Neural Networks)介绍 这篇文章很多内容是参考:http://www.wildml.com/2015/09/recurrent-neur ...

- 循环神经网络(RNN, Recurrent Neural Networks)介绍

原文地址: http://blog.csdn.net/heyongluoyao8/article/details/48636251# 循环神经网络(RNN, Recurrent Neural Netw ...

- (原创)Stanford Machine Learning (by Andrew NG) --- (week 5) Neural Networks Learning

本栏目内容来自Andrew NG老师的公开课:https://class.coursera.org/ml/class/index 一般而言, 人工神经网络与经典计算方法相比并非优越, 只有当常规方法解 ...

- Stanford机器学习---第五讲. 神经网络的学习 Neural Networks learning

原文 http://blog.csdn.net/abcjennifer/article/details/7758797 本栏目(Machine learning)包括单参数的线性回归.多参数的线性回归 ...

- 今天开始学模式识别与机器学习(PRML),章节5.1,Neural Networks神经网络-前向网络。

今天开始学模式识别与机器学习Pattern Recognition and Machine Learning (PRML),章节5.1,Neural Networks神经网络-前向网络. 话说上一次写 ...

随机推荐

- jdbc基础 (三) 大文本、二进制数据处理

LOB (Large Objects) 分为:CLOB和BLOB,即大文本和大二进制数据 CLOB:用于存储大文本 BLOB:用于存储二进制数据,例如图像.声音.二进制文件 在mysql中,只有B ...

- 简单统计SQLSERVER用户数据表大小(包括记录总数和空间占用情况)

在SQLSERVER,简单的组合sp_spaceused和sp_MSforeachtable这两个存储过程,可以方便的统计出用户数据表的大小,包括记录总数和空间占用情况,非常实用,在SqlServer ...

- js遍历json数据

先看看json返回的数据结构: 我需要遍历取出bookreno 与 title 加载到页面容器中去 首先我要取到 recommendedBookList 字典结构数据,然后遍历反射到相应对象 ...

- C#基础知识系列四(运算符汇总)

前言 本节主要来讲C#中的各种运算符.主要包括is运算符.as运算符.checked和unchecked运算符.sizeof运算符.空接合运算符(??).&和&&.移位运算符 ...

- 团队作业--Beta版本冲刺

项目冲刺随笔 第一天 第二天 第三天 第四天 第五天 第六天 第七天

- Andriod开发环境的发展演变

安卓早先只能使用JAVA开发应用程序,现在支持多种编程语言,方便了许多程序员,但主流的应该还是JAVA语言.早先安卓开发经常用到eclipse,但自从google 发布了Android studio后 ...

- 理解jar

对于大多数 Java 开发人员来说,JAR 文件及其 “近亲” WAR 和 EAR 都只不过是漫长的 Ant 或 Maven 流程的最终结果.标准步骤是将一个 JAR 复制到服务器(或者,少数情况下是 ...

- Gallery 图片画廊

Gallery 图片画廊 学习网址http://amazeui.org/widgets/gallery?_ver=2.x

- 【UVALive 3905】BUPT 2015 newbie practice #2 div2-D-3905 - Meteor

http://acm.hust.edu.cn/vjudge/contest/view.action?cid=102419#problem/D The famous Korean internet co ...

- Day1 login

使用流程: 1.程序启动后,显示欢迎信息,提示用户输入用户名: 2.判断用户是否存在,不存在则提示重新输入,或者关闭程序:客户存在则提示客户输入密码: 3.判断密码是否正确,如果不正确则提示用户重新输 ...