利用Hadoop自带example实现wordCount

上次虽然把环境搭好了,但是实际运行起来一堆错误,下面简述一下踩的坑。

1、hadoop fs -put上传文件失败,WARN org.apache.hadoop.hdfs.server.datanode.DataNode: Problem connecting to server: master:8020

解决方案:https://www.cnblogs.com/BoqianLiu/p/10183535.html

2、NodeManager运行一段时间后自行消失

解决方案:同上,第1个问题解决了这个问题也消失了,亏我还给他准备了好几种解决方案。

具体过程:

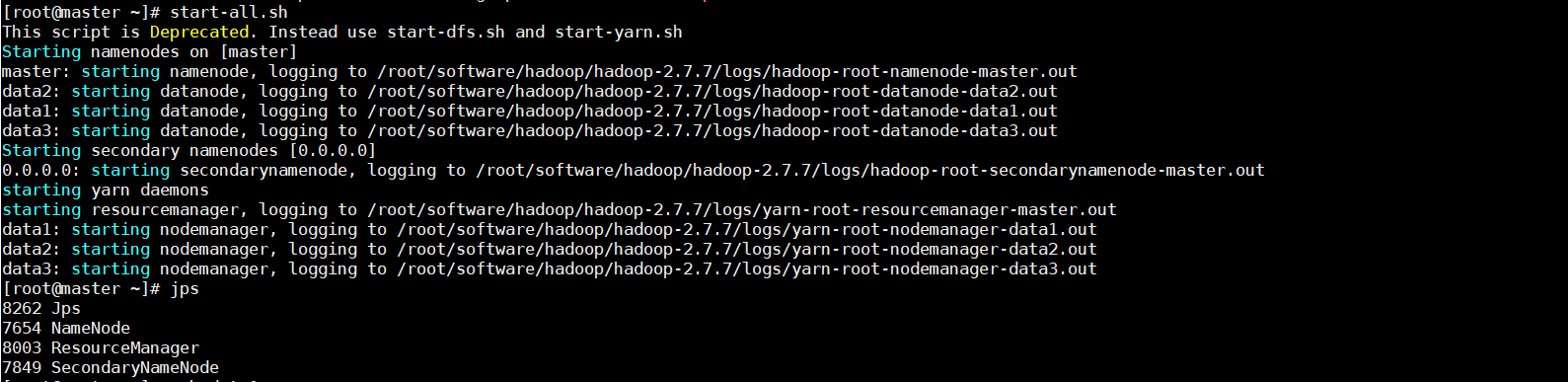

1、开启hdfs与yarn集群

- start-dfs.sh

- start-yarn.sh

我这里测试图省事就直接start-all了,正常工作还是按照人家的建议来,分别开启好一点哈

2、确认hadoop已经成功运行

- ps -ef|grep hadoop

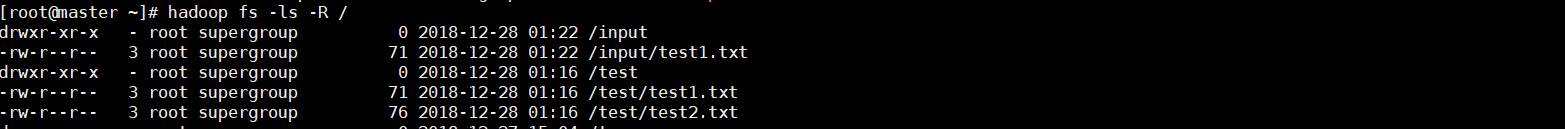

3、在hdfs新建test目录并测试

- hadoop fs -mkdir /test

hadoop fs -ls -R /

4、从本地向test目录上传文件

*.txt表示当前终端目录下所有txt类型的文件

- hadoop fs -put *.txt /test

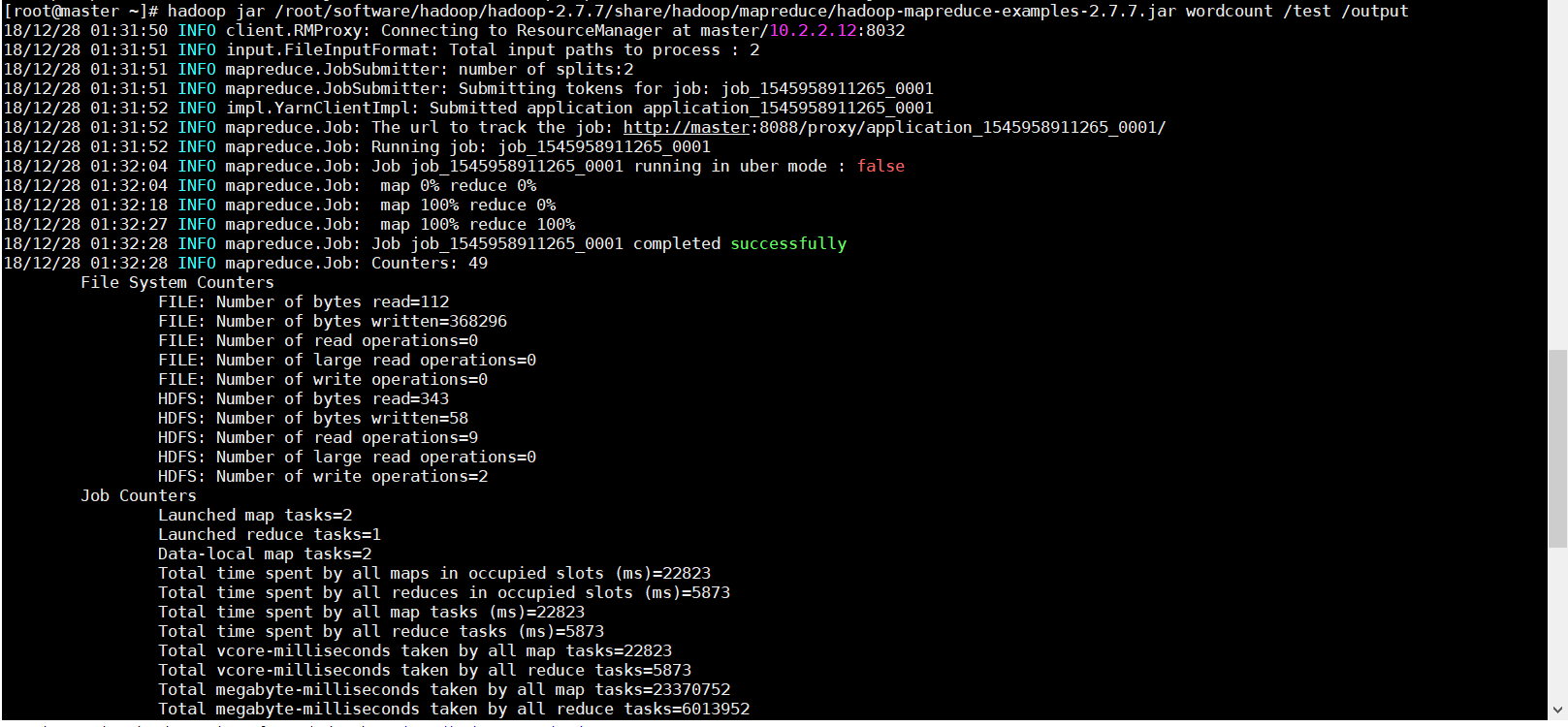

5、运行hadoop自带example里面的wordcount程序

- hadoop jar /root/software/hadoop/hadoop-2.7./share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7..jar wordcount /test /output

这个地方要注意的就是output必须是事先不存在的,如果已经存在会报错FileAlreadyExistsException,即便提前把里面的文件清空也是不可以的。

6、打印/output结果

- hadoop fs -cat /output/part-r-

参考资料:

1、Ubuntu16.04 上运行 Hadoop2.7.3 自带example wordCount摸索记录

2、Hadoop学习之路(七)Hadoop集群shell常用命令

利用Hadoop自带example实现wordCount的更多相关文章

- 利用hadoop自带程序运行wordcount

1.启动hadoop守护进程 bin/start-all.sh 2.在hadoop的bin目录下建立一个input文件夹 JIAS-MacBook-Pro:hadoop- jia$ mkdir inp ...

- Hadoop入门实践之从WordCount程序说起

这段时间需要学习Hadoop了,以前一直听说Hadoop,但是从来没有研究过,这几天粗略看完了<Hadoop实战>这本书,对Hadoop编程有了大致的了解.接下来就是多看多写了.以Hado ...

- hadoop自带例子wordcount的具体运行步骤

1.在hadoop所在目录“usr/local”下创建一个文件夹input root@ubuntu:/usr/local# mkdir input 2.在文件夹input中创建两个文本文件file1. ...

- 执行hadoop自带的WordCount实例

hadoop 自带的WordCount实例可以统计一批文本文件中各单词出现的次数.下面介绍如何执行WordCount实例. 1.启动hadoop [root@hadoop ~]# start-all. ...

- 几个有关Hadoop自带的性能测试工具的应用

http://www.talkwithtrend.com/Question/177983-1247453 一些测试的描述如下内容最为详细,供你参考: 测试对于验证系统的正确性.分析系统的性能来说非常重 ...

- Hadoop_05_运行 Hadoop 自带 MapReduce程序

1. MapReduce使用 MapReduce是Hadoop中的分布式运算编程框架,只要按照其编程规范,只需要编写少量的业务逻辑代码即可实现 一个强大的海量数据并发处理程序 2. 运行Hadoop自 ...

- hadoop学习笔记:运行wordcount对文件字符串进行统计案例

文/朱季谦 我最近使用四台Centos虚拟机搭建了一套分布式hadoop环境,简单模拟了线上上的hadoop真实分布式集群,主要用于业余学习大数据相关体系. 其中,一台服务器作为NameNode,一台 ...

- 利用jdk自带的运行监控工具JConsole观察分析Java程序的运行

利用jdk自带的运行监控工具JConsole观察分析Java程序的运行 原文链接 一.JConsole是什么 从Java 5开始 引入了 JConsole.JConsole 是一个内置 Java 性能 ...

- Hadoop实战3:MapReduce编程-WordCount统计单词个数-eclipse-java-ubuntu环境

之前习惯用hadoop streaming环境编写python程序,下面总结编辑java的eclipse环境配置总结,及一个WordCount例子运行. 一 下载eclipse安装包及hadoop插件 ...

随机推荐

- poj 1032 Parliament 【思维题】

题目地址:http://poj.org/problem?id=1032 Parliament Time Limit: 1000MS Memory Limit: 10000K Total Submi ...

- The Great Pan

The Great Pan Time Limit:1000MS Memory Limit:65536KB ...

- LINQ 学习路程 -- 查询语法 LINQ Query Syntax

1.查询语法 Query Syntax: from <range variable> in <IEnumerable<T> or IQueryable<T> ...

- ML一(概念学习和一般到特殊序)

概念学习和一般到特殊序 Concept Learning and the General-To-Specific Ordering 1 简介 1.1 定义 概念学习(Concept Learning) ...

- Native App vs Web App 以及 Hybrid App的实现原理

移动应用基本的三种类型 1) Native 应用程序 2) Web 应用程序 3) 混合应用程序(Hybrid: Native应用和web应用结合) Native 应用 直接运行在电脑上或者智能 ...

- UVA 291 The House Of Santa Claus(DFS算法)

题意:从 节点1出发,一笔画出 圣诞老人的家(所谓一笔画,就是遍访所有边且每条边仅访问一次). 思路:深度优先搜索(DFS算法) #include<iostream> #include&l ...

- Using SMOTEBoost(过采样) and RUSBoost(使用聚类+集成学习) to deal with class imbalance

Using SMOTEBoost and RUSBoost to deal with class imbalance from:https://aitopics.org/doc/news:1B9F7A ...

- appium-DesiredCapability详解与实战

DesiredCapability对启动app至关重要,是启动app前的准备工作.如果配置错误,app不会成功启动. DesiredCapability有appium公共健值对.Android专有和I ...

- Mysql总结_03_mysql常用命令

一.MySQL服务的启动和停止 net stop mysql net start mysql 二.登陆mysql mysql -u用户名 -p用户密码 键入命令mysql -uroot -p, 回车后 ...

- 关于_T()说明

#define _T(X) L##X _T()是MFC里的宏.VS支持两种编码方式ASCII和Unicode,前者是用单字节编码,只能表示0~255个字符.为了表示各个国家的字符,采用了UNICO ...