分享知识-快乐自己:大数据(hadoop)环境搭建

大数据 hadoop 环境搭建:

-----------------------------------------------------------------

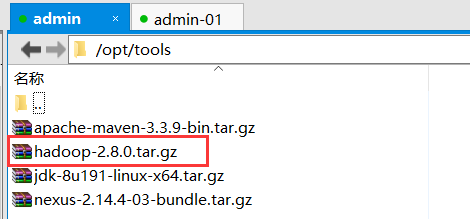

1):下载安装 hadoop(这里使用2.8版本:点我下载)

2):通过 (xftp 或 rz 命令)上传到指定目录下并解压到指定目录(根据自行要求进行选择存放位置):以下为小编存放目录

//解压到指定目录

tar -zxvf hadoop-2.8.0.tar.gz -C ../bigData/

3):配置 hadoop 环境变量

vim /etc/profile

export HADOOP_HOME=/opt/bigData/hadoop-2.8.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

之后让文件生效:

source /etc/profile

4):hadoop 集群搭建:

1):进入 hadoop 的配置文件位置:

cd /opt/bigData/hadoop-2.8.0/etc/hadoop/

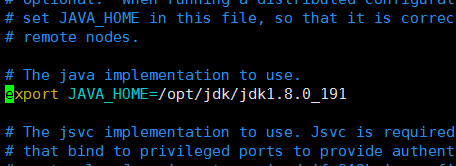

2):配置hadoop-env.sh文件

vim hadoop-env.sh

//在文件中加入[首先查看是否存在此节点,如果有可以直接修改](指定jdk绝对路径)

export JAVA_HOME=/opt/jdk/jdk1.8.0_191

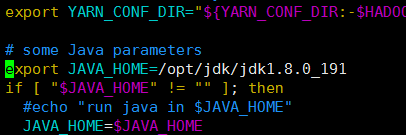

3):配置yarn-env.sh文件

vim yarn-env.sh

//在文件中加入[首先查看是否存在此节点,如果有可以直接修改](指定jdk绝对路径)

export JAVA_HOME=/opt/jdk/jdk1.8.0_191

4):配置slaves文件,增加slave主机名或者IP地址:

vim slaves

//在文件中加入(删除原有的localhost)

192.168.31.207

192.168.31.208

5):配置core-site.xml文件:

vim core-site.xml

//在文件中的configuration节点里加入

<property>

<name>fs.defaultFS</name>

<value>hdfs://admin:9000</value>

</property> <property>

<name>hadoop.tmp.dir</name>

<value>/opt/bigData/hadoop-2.8.0/tmp</value>

</property>

6):配置hdfs-site.xml文件

vim hdfs-site.xml

//在文件中的configuration节点里加入

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>admin:50090</value>

</property> <property>

<name>dfs.replication</name>

<value>2</value>

</property> <property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/bigData/hadoop-2.8.0/hdfs/name</value>

</property> <property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/bigData/hadoop-2.8.0/hdfs/data</value>

</property>

7):配置yarn-site.xml文件

vim yarn-site.xml

//在文件中的configuration节点里加入

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property> <property>

<name>yarn.resourcemanager.address</name>

<value>admin:8032</value>

</property> <property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>admin:8030</value>

</property> <property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property> <property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>admin:8031</value>

</property> <property>

<name>yarn.resourcemanager.admin.address</name>

<value>admin:8033</value>

</property> <property>

<name>yarn.resourcemanager.webapp.address</name>

<value>admin:8088</value>

</property>

8):配置mapred-site.xml文件

mapred-site.xml.template 是存在的。

mapred-site.xml 不存在。

注意:先要copy一份。

cp mapred-site.xml.template mapred-site.xml

然后编辑:

vim mapred-site.xml

//新增以下内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property> <property>

<name>mapreduce.jobhistory.address</name>

<value>admin:10020</value>

</property> <property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>admin:19888</value>

</property>

9):把配置好的hadoop文件复制到其他的子机器中

scp -r /opt/bigData/hadoop-2.8.0 root@admin-01:/opt/bigData/hadoop-2.8.0 scp -r /opt/bigData/hadoop-2.8.0 root@admin-02:/opt/bigData/hadoop-2.8.0

10):把配置好的/etc/profile复制到其他两个子机器中

scp /etc/profile root@admin-01:/etc/profile

scp /etc/profile root@admin-02:/etc/profile

之后在每个子机器中使用 source /etc/profile 使文件生效

11):在master 主机器中运行

hdfs namenode -format //注意:格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。

//所以,格式NameNode时,一定要先删除生成的 name 和 data数据 和log日志,然后再格式化NameNode。

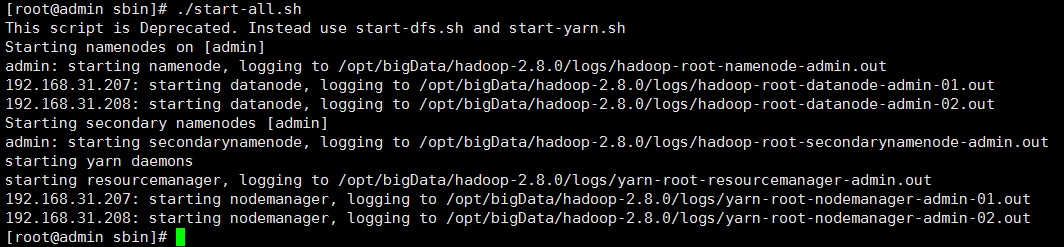

12):在master 主机器中启动hadoop环境:进入/opt/bigData/hadoop-2.8.0/sbin

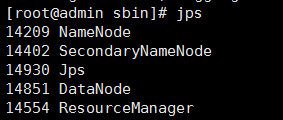

./start-all.sh 启动hadoop集群 ./stop-all.sh 关闭hadoop集群 jps 查看当前已启动的服务

分享知识-快乐自己:大数据(hadoop)环境搭建的更多相关文章

- windows下大数据开发环境搭建(2)——Hadoop环境搭建

一.所需环境 ·Java 8 二.Hadoop下载 http://hadoop.apache.org/releases.html 三.配置环境变量 HADOOP_HOME: C:\hadoop- Pa ...

- 虚拟机CentOs的安装及大数据的环境搭建

大数据问题汇总 1.安装问题 1.安装步骤,详见文档<centos虚拟机安装指南> 2.vi编辑器使用问题,详见文档<linux常用命令.pd ...

- windows下大数据开发环境搭建(4)——Spark环境搭建

一.所需环境 · Java 8 · Python 2.6+ · Scala · Hadoop 2.7+ 二.Spark下载与解压 http://spark.apache.org/downloads.h ...

- windows下大数据开发环境搭建(1)——Java环境搭建

一.Java 8下载 https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html 下载之后 ...

- windows下大数据开发环境搭建(3)——Scala环境搭建

一.所需环境 ·Java 8 二.下载Scala https://www.scala-lang.org/download/ 三.配置环境变量 SCALA_HOME: C:\scala Path: ...

- windows下大数据开发环境搭建(1)——Hadoop环境搭建

所需环境 jdk 8 Hadoop下载 http://hadoop.apache.org/releases.html 配置环境变量 HADOOP_HOME: C:\hadoop-2.7.7 Path: ...

- 大数据_zookeeper环境搭建中的几个坑

文章目录 [] Zookeeper简介 关于zk的介绍, zk的paxos算法, 网上已经有各位大神在写了, 本文主要写我在搭建过程中的几个极有可能遇到的坑. Zookeeper部署中的坑 坑之一 E ...

- 大数据学习环境搭建(CentOS6.9+Hadoop2.7.3+Hive1.2.1+Hbase1.3.1+Spark2.1.1)

node1 192.168.1.11 node2 192.168.1.12 node3 192.168.1.13 备注 NameNode Hadoop Y Y 高可用 DateNode Y Y Y R ...

- 我搭建大数据Hadoop完全分布式环境遇到的坑---hadoop: command not found

搭建大数据hadoop环境,遇到很多问题,这里记录一部分,以备以后查看. [遇到问题].在安装配置完hadoop以后,需要格式化namenode,输入指令:hadoop namenode -forma ...

- 搭建大数据hadoop完全分布式环境遇到的坑

搭建大数据hadoop完全分布式环境,遇到很多问题,这里记录一部分,以备以后查看. 1.在安装配置完hadoop以后,需要格式化namenode,输入指令:hadoop namenode -forma ...

随机推荐

- jfreechart折线图 demo

public class ChartUtil { public static ChartUtil chartUtil; private RoomViewsDataService roomViewsDa ...

- Android控件ListView获取item中EditText值

能够明白,如今没有直接方法能够获得ListView中每一行EditText的值. 解决方式:重写BaseAdapter,然后自行获取ListView中每行输入的EditText值. 大概算法:重写Ba ...

- 对Mybatis的理解

首先Mybatis是一个对象关系映射(Object Relational Mapping,简称ORM)框架,是为了解决面向对象与关系数据库存在的互不匹配的现象.也就是说Mybatis的关注点在于对象与 ...

- EhCache 集群 配置(RMI方式)

这里先说明下环境:JDK1.6.ehcache-core-2.1.0.jar.Tomcat6.Spring3.0.2.使用的是RMI方式配置集群的,这里先吐槽下遇到的情况,在搜相关知识的时候发现到处都 ...

- 【BZOJ3707】圈地 几何

[BZOJ3707]圈地 Description 2维平面上有n个木桩,黄学长有一次圈地的机会并得到圈到的土地,为了体现他的高风亮节,他要使他圈到的土地面积尽量小.圈地需要圈一个至少3个点的多边形,多 ...

- F - Monkey Banana Problem

F - Monkey Banana Problem Time Limit:2000MS Memory Limit:32768KB 64bit IO Format:%lld & ...

- RedisTemplate访问Redis数据结构(介绍和常用命令)

Redis 数据结构简介 Redis 可以存储键与5种不同数据结构类型之间的映射,这5种数据结构类型分别为String(字符串).List(列表).Set(集合).Hash(散列)和 Zset(有序集 ...

- 九度OJ 1324:The Best Rank(最优排名) (排序)

时间限制:1 秒 内存限制:32 兆 特殊判题:否 提交:489 解决:126 题目描述: To evaluate the performance of our first year CS major ...

- 【python】-- paramiko、跳板机(堡垒机)

paramiko Python的paramiko模块,该模块用于连接远程服务器并执行相关命令,常用于作批量管理使用 一.下载: pip3 install paramiko 源码:查看 二.parami ...

- mongodb 的注意点

昨天同事安装mongodb遇到了些问题,问了下我,后拉发现都是些细节没注意(讲道理这应该是很简单,一顿操作就ok的事情) 首先,下载 mongo包, 然后 ,解压安装, 启动之. 问题就出现在他后台启 ...