大数据入门第二十四天——SparkStreaming(二)与flume、kafka整合

前一篇中数据源采用的是从一个socket中拿数据,有点属于“旁门左道”,正经的是从kafka等消息队列中拿数据!

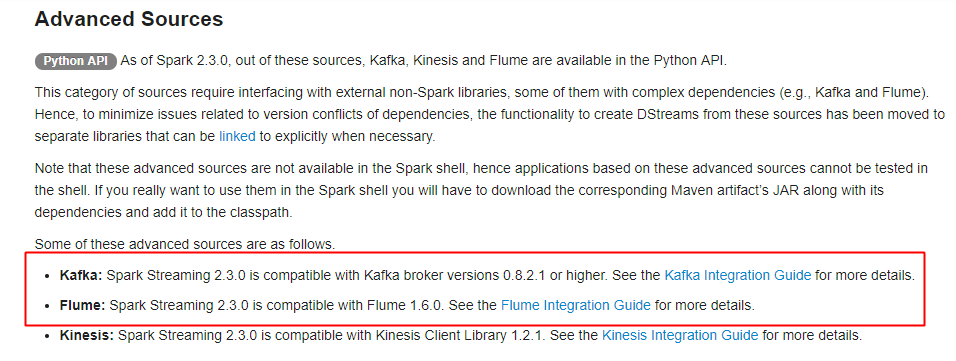

主要支持的source,由官网得知如下:

获取数据的形式包括推送push和拉取pull

一、spark streaming整合flume

1.push的方式

更推荐的是pull的拉取方式

引入依赖:

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming-flume_2.10</artifactId>

<version>${spark.version}</version>

</dependency>

编写代码:

package com.streaming import org.apache.spark.SparkConf

import org.apache.spark.streaming.flume.FlumeUtils

import org.apache.spark.streaming.{Seconds, StreamingContext} /**

* Created by ZX on 2015/6/22.

*/

object FlumePushWordCount { def main(args: Array[String]) {

val host = args(0)

val port = args(1).toInt

val conf = new SparkConf().setAppName("FlumeWordCount")//.setMaster("local[2]")

// 使用此构造器将可以省略sc,由构造器构建

val ssc = new StreamingContext(conf, Seconds(5))

// 推送方式: flume向spark发送数据(注意这里的host和Port是streaming的地址和端口,让别人发送到这个地址)

val flumeStream = FlumeUtils.createStream(ssc, host, port)

// flume中的数据通过event.getBody()才能拿到真正的内容

val words = flumeStream.flatMap(x => new String(x.event.getBody().array()).split(" ")).map((_, 1)) val results = words.reduceByKey(_ + _)

results.print()

ssc.start()

ssc.awaitTermination()

}

}

flume-push.conf——flume端配置文件:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1 # source

a1.sources.r1.type = spooldir

a1.sources.r1.spoolDir = /export/data/flume

a1.sources.r1.fileHeader = true # Describe the sink

a1.sinks.k1.type = avro

#这是接收方

a1.sinks.k1.hostname = 192.168.31.172

a1.sinks.k1.port = 8888 # Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100 # Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

flume-push.conf

2.pull的方式

属于推荐的方式,通过streaming来主动拉取flume产生的数据

编写代码:(依赖同上)

package com.streaming import java.net.InetSocketAddress import org.apache.spark.SparkConf

import org.apache.spark.storage.StorageLevel

import org.apache.spark.streaming.flume.FlumeUtils

import org.apache.spark.streaming.{Seconds, StreamingContext} object FlumePollWordCount {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("FlumePollWordCount").setMaster("local[2]")

val ssc = new StreamingContext(conf, Seconds(5))

//从flume中拉取数据(flume的地址),通过Seq序列,里面可以new多个地址,从多个flume地址拉取

val address = Seq(new InetSocketAddress("172.16.0.11", 8888))

val flumeStream = FlumeUtils.createPollingStream(ssc, address, StorageLevel.MEMORY_AND_DISK)

val words = flumeStream.flatMap(x => new String(x.event.getBody().array()).split(" ")).map((_,1))

val results = words.reduceByKey(_+_)

results.print()

ssc.start()

ssc.awaitTermination()

}

}

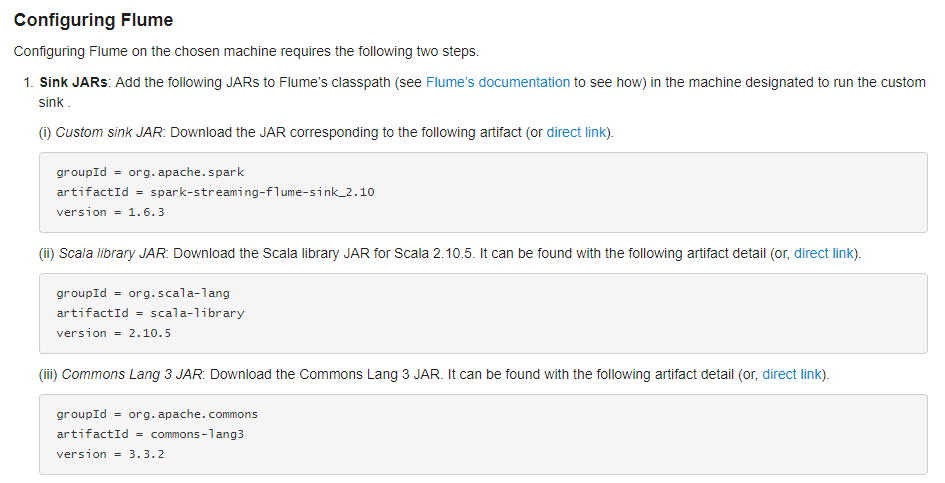

配置flume

通过拉取的方式需要flume的lib目录中有相关的JAR(要通过spark程序来调flume拉取),通过官网可以得知具体的JAR信息:

配置flume:

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1 # source

a1.sources.r1.type = spooldir

a1.sources.r1.spoolDir = /export/data/flume

a1.sources.r1.fileHeader = true # Describe the sink(配置的是flume的地址,等待拉取)

a1.sinks.k1.type = org.apache.spark.streaming.flume.sink.SparkSink

a1.sinks.k1.hostname = mini1

a1.sinks.k1.port = 8888 # Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100 # Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

flume-poll.conf

启动flume,然后启动IDEA中的spark streaming:

bin/flume-ng agent -c conf -f conf/netcat-logger.conf -n a1 -Dflume.root.logger=INFO,console

// -D后参数可选

二、spark streaming整合kafka

前导知识,复习kafka:http://www.cnblogs.com/jiangbei/p/8537625.html

1.引入依赖

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming-kafka_2.10</artifactId>

<version>${spark.version}</version>

</dependency>

2.编写代码

package com.streaming

import org.apache.spark.{HashPartitioner, SparkConf}

import org.apache.spark.storage.StorageLevel

import org.apache.spark.streaming.kafka.KafkaUtils

import org.apache.spark.streaming.{Seconds, StreamingContext}

object KafkaWordCount {

val updateFunc = (iter: Iterator[(String, Seq[Int], Option[Int])]) => {

//iter.flatMap(it=>Some(it._2.sum + it._3.getOrElse(0)).map(x=>(it._1,x)))

iter.flatMap { case (x, y, z) => Some(y.sum + z.getOrElse(0)).map(i => (x, i)) }

}

def main(args: Array[String]): Unit = {

val Array(zkQuorum, group, topics, numThreads) = args

val conf = new SparkConf().setAppName("kafkaWordCount").setMaster("local[2]")

val ssc = new StreamingContext(conf, Seconds(5))

// 设置ck

ssc.checkpoint("F:/ck")

// 产生topic的map

val topicMap = topics.split(",").map((_, numThreads.toInt)).toMap

// data是一个DStream

val data = KafkaUtils.createStream(ssc, zkQuorum, group, topicMap, StorageLevel.MEMORY_AND_DISK_SER)

val words = data.map(_._2).flatMap(_.split(" "))

// 使用update进行累加统计

val wordCounts = words.map((_, 1)).updateStateByKey(updateFunc, new HashPartitioner(ssc.sparkContext.defaultParallelism), true)

// 启动

ssc.start()

ssc.awaitTermination()

}

}

结合kafka也是存在两种拉取数据的形式,包括Receiver和Direct两种形式

更多参考:https://www.cnblogs.com/xlturing/p/6246538.html

但是使用更多的是Direct的直连方式,因为直连方式使用的不需要记录日志,不会影响性能

使用实例,参考:https://blog.csdn.net/ligt0610/article/details/47311771

大数据入门第二十四天——SparkStreaming(二)与flume、kafka整合的更多相关文章

- 大数据入门第二十四天——SparkStreaming(一)入门与示例

一.概述 1.什么是spark streaming Spark Streaming is an extension of the core Spark API that enables scalabl ...

- 大数据入门第二十五天——elasticsearch入门

一.概述 推荐路神的ES权威指南翻译:https://es.xiaoleilu.com/010_Intro/00_README.html 官网:https://www.elastic.co/cn/pr ...

- 大数据入门第二十五天——logstash入门

一.概述 1.logstash是什么 根据官网介绍: Logstash 是开源的服务器端数据处理管道,能够同时 从多个来源采集数据.转换数据,然后将数据发送到您最喜欢的 “存储库” 中.(我们的存储库 ...

- 大数据入门第二十三天——SparkSQL(二)结合hive

一.SparkSQL结合hive 1.首先通过官网查看与hive匹配的版本 这里可以看到是1.2.1 2.与hive结合 spark可以通过读取hive的元数据来兼容hive,读取hive的表数据,然 ...

- 大数据入门第二十二天——spark(一)入门与安装

一.概述 1.什么是spark 从官网http://spark.apache.org/可以得知: Apache Spark™ is a fast and general engine for larg ...

- 大数据入门第十四天——Hbase详解(二)基本概念与命令、javaAPI

一.hbase数据模型 完整的官方文档的翻译,参考:https://www.cnblogs.com/simple-focus/p/6198329.html 1.rowkey 与nosql数据库们一样, ...

- 大数据入门第十四天——Hbase详解(一)入门与安装配置

一.概述 1.什么是Hbase 根据官网:https://hbase.apache.org/ Apache HBase™ is the Hadoop database, a distributed, ...

- 大数据入门第二十二天——spark(二)RDD算子(1)

一.RDD概述 1.什么是RDD RDD(Resilient Distributed Dataset)叫做分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变.可分区.里面的元素可并行计算的 ...

- 大数据入门第二十二天——spark(二)RDD算子(2)与spark其它特性

一.JdbcRDD与关系型数据库交互 虽然略显鸡肋,但这里还是记录一下(点开JdbcRDD可以看到限制比较死,基本是鸡肋.但好在我们可以通过自定义的JdbcRDD来帮助我们完成与关系型数据库的交互.这 ...

随机推荐

- 高性能JavaScript(高性能Ajax)

ajax是一种与服务器通信而无需重载页面的方法(即局部刷新.) 高性能的Ajax应该考虑数据传输技术和数据格式,以及其他的如数据缓存等优化技术. 请求数据 请求数据的常用技术有XMLHttpReque ...

- 活字格Web应用平台学习笔记1 - 下载安装,ready go

今年有一个很重要的职业目标,就是好好学习活字格这个神器,争取在这两个月拿到活字格初级工程师的认证证书.给自己加个油,今天开始好好学习,好好做笔记. 第一步,下载安装 先去活字格官网:http://ww ...

- 本地用maven搭建SpringMvc+redis集成

---恢复内容开始--- 首先本地需要搭建私服,简单说一下搭建私服的步骤 1.为什么使用Nexus 如果没有私服,我们所需的所有构件都需要通过maven的中央仓库和第三方的Maven仓库下载到本地,而 ...

- 什么是套接字(Socket)

应用层通过传输层进行数据通信时,TCP和UDP会遇到同时为多个应用程序进程提供并发服务的问题.多个TCP连接或多个应用程序进程可能需要 通过同一个TCP协议端口传输数据.为了区别不同的应用程序进程和连 ...

- oracle like模糊查询简单用法

like 用法介绍: 1.“_”:匹配单个任意字符 select * from bqh3 where name like '_崔'; 2.“%”:匹配0个或多个任意字符.但有三种情况如下: like ...

- MySQL基础之 索引

MySQL索引讲解 索引的好处: MySQL索引的建立对于MySQL的高效运行是很重要的,索引可以大大提高MySQL的检索速度. 打个比方,如果合理的设计且使用索引的MySQL是一辆兰博基尼的话,那么 ...

- Django商城项目笔记No.7用户部分-注册接口-判断用户名和手机号是否存在

Django商城项目笔记No.7用户部分-注册接口-判断用户名和手机号是否存在 判断用户名是否存在 后端视图代码实现,在users/view.py里编写如下代码 class UsernameCount ...

- FIO_工具_专业

一.FIO工具安装: 1.查看fio是否安装 [root@localhost /]#rpm –qa|grep fio 2.源码安装(推荐) 官网地址:http://freecode.com/proje ...

- pip安装python模块遇到一直出现retrying的问题

最近安装python模块,遇到这样的一个问题如图所示: Retrying (Retry(total=4, connect=None, read=None, redirect=None, status= ...

- 线程同步方式之互斥量Mutex

互斥量和临界区非常相似,只有拥有了互斥对象的线程才可以访问共享资源,而互斥对象只有一个,因此可以保证同一时刻有且仅有一个线程可以访问共享资源,达到线程同步的目的. 互斥量相对于临界区更为高级,可以对互 ...