LeNet

LeNet

模型特点

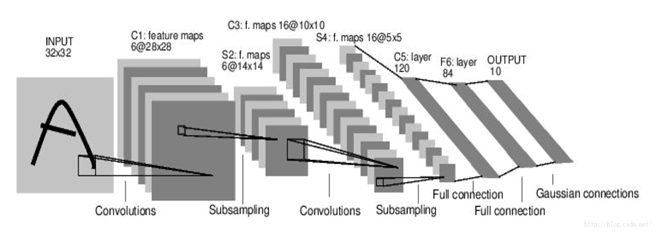

结构模型

图1-1 LeNet结构示意

网络层介绍

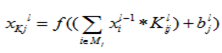

对于卷积层,其计算公式为

其中K表示由L层到L+1层要产生的feature的数量,表示“卷积核”,表示偏置,也就是bias,

令卷积核的大小为5*5,总共就有6*(5*5+1)=156个参数,

对于卷积层C1,每个像素都与前一层的5*5个像素和1个bias有连接,

所以总共有156*28*28=122304个连接(connection)。

对于LeNet5,S2这个pooling层是对C1中的2*2区域内的像素求和再加上一个偏置,

然后将这个结果再做一次映射(sigmoid等函数),所以相当于对S1做了降维,此处共有6*2=12个参数。

S2中的每个像素都与C1中的2*2个像素和1个偏置相连接,所以有6*5*14*14=5880个连接(connection)。

除此外,pooling层还有max-pooling和mean-pooling这两种实现,

max-pooling即取2*2区域内最大的像素,而mean-pooling即取2*2区域内像素的均值。

LeNet5最复杂的就是S2到C3层,其连接如下图所示。

前6个feature map与S2层相连的3个feature map相连接,

后面6个feature map与S2层相连的4个feature map相连接,

后面3个feature map与S2层部分不相连的4个feature map相连接,

最后一个与S2层的所有feature map相连。

卷积核大小依然为5*5,

所以总共有6*(3*5*5+1)+6*(4*5*5+1)+3*(4*5*5+1)+1*(6*5*5+1)=1516个参数。

而图像大小为10*10,所以共有151600个连接。

S4是pooling层,窗口大小仍然是2*2,共计16个feature map,

所以32个参数,16*(25*4+25)=2000个连接。

C5是卷积层,总共120个feature map,每个feature map与S4层所有的feature map相连接,卷积核大小是5*5,

而S4层的feature map的大小也是5*5,所以C5的feature map就变成了1个点,共计有120(25*16+1)=48120个参数。

F6相当于MLP中的隐含层,有84个节点,所以有84*(120+1)=10164个参数。

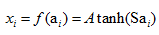

F6层采用了正切函数,计算公式为,

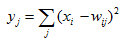

输出层采用了RBF函数,即径向欧式距离函数,计算公式为,

以上就是LeNet5的结构。

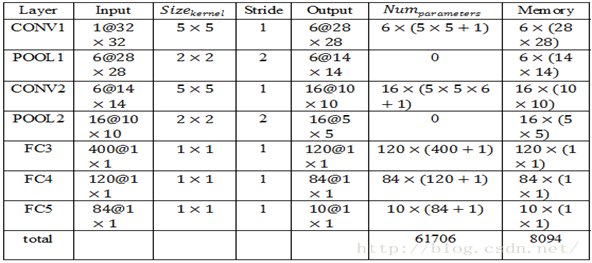

表1 LeNet各层输入输出及资源使用

LeNet的更多相关文章

- 卷积神经网络(CNN)学习算法之----基于LeNet网络的中文验证码识别

由于公司需要进行了中文验证码的图片识别开发,最近一段时间刚忙完上线,好不容易闲下来就继上篇<基于Windows10 x64+visual Studio2013+Python2.7.12环境下的C ...

- caffe_手写数字识别Lenet模型理解

这两天看了Lenet的模型理解,很简单的手写数字CNN网络,90年代美国用它来识别钞票,准确率还是很高的,所以它也是一个很经典的模型.而且学习这个模型也有助于我们理解更大的网络比如Imagenet等等 ...

- #Deep Learning回顾#之LeNet、AlexNet、GoogLeNet、VGG、ResNet

CNN的发展史 上一篇回顾讲的是2006年Hinton他们的Science Paper,当时提到,2006年虽然Deep Learning的概念被提出来了,但是学术界的大家还是表示不服.当时有流传的段 ...

- 基于LeNet网络的中文验证码识别

基于LeNet网络的中文验证码识别 由于公司需要进行了中文验证码的图片识别开发,最近一段时间刚忙完上线,好不容易闲下来就继上篇<基于Windows10 x64+visual Studio2013 ...

- 【Caffe 测试】Training LeNet on MNIST with Caffe

Training LeNet on MNIST with Caffe We will assume that you have Caffe successfully compiled. If not, ...

- CNN网络架构演进:从LeNet到DenseNet

卷积神经网络可谓是现在深度学习领域中大红大紫的网络框架,尤其在计算机视觉领域更是一枝独秀.CNN从90年代的LeNet开始,21世纪初沉寂了10年,直到12年AlexNet开始又再焕发第二春,从ZF ...

- 经典卷积神经网络(LeNet、AlexNet、VGG、GoogleNet、ResNet)的实现(MXNet版本)

卷积神经网络(Convolutional Neural Network, CNN)是一种前馈神经网络,它的人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现. 其中 文章 详解卷 ...

- 卷积神经网络的一些经典网络(Lenet,AlexNet,VGG16,ResNet)

LeNet – 5网络 网络结构为: 输入图像是:32x32x1的灰度图像 卷积核:5x5,stride=1 得到Conv1:28x28x6 池化层:2x2,stride=2 (池化之后再经过激活函数 ...

- 卷积神经网络之LeNet

开局一张图,内容全靠编. 上图引用自 [卷积神经网络-进化史]从LeNet到AlexNet. 目前常用的卷积神经网络 深度学习现在是百花齐放,各种网络结构层出不穷,计划梳理下各个常用的卷积神经网络结构 ...

- 深度学习识别CIFAR10:pytorch训练LeNet、AlexNet、VGG19实现及比较(三)

版权声明:本文为博主原创文章,欢迎转载,并请注明出处.联系方式:460356155@qq.com VGGNet在2014年ImageNet图像分类任务竞赛中有出色的表现.网络结构如下图所示: 同样的, ...

随机推荐

- 高性能优化规范建议Mysql

Mysql高性能优化规范建议 https://www.cnblogs.com/huchong/p/10219318.html 数据库命令规范 所有数据库对象名称必须使用小写字母并用下划线分割 所有数据 ...

- CSS元素、边框、背景、列表样式

一.元素样式 1.width控制元素宽度 2.height控制元素宽度 3.padding控制元素内边距 内容与边框之间的距离 4.margin控制元素外边距 元素边框与其他元素边框之间的距离,如果两 ...

- 【转】Windows消息投递流程:一般窗口消息投递(WM_LBUTTONCLICK)

原文网址:http://blog.csdn.net/hyhnoproblem/article/details/6182646 本例通过在单文档程序的视图中添加WM_LBUTTONCLICK消息处理函数 ...

- am335x_y蜂鸣器驱动

修改文件:1.板级文件/arch/arm/mach-omap2/board-am335xevm.c static struct platform_device buzzer_device= { .na ...

- 5.Appium+真机Demo

1.连接真机后,执行代码时出现错误:A new session could not be created. (Original error: Could not extract PIDs from p ...

- php 面试一般都遇到什么问题

大型互联网公司会从几个方面来考核:第一:专业上,专业分为五个方向,操作系统,网络,算法,语言,数据库,一般情况下,会比较在乎Linux系统的日常使用,包括shell脚本,比较深入的话,会问kernel ...

- springboot 整合 elasticsearch

1引入jar包 <!--elasticsearch--> <dependency> <groupId>org.springframework.boot</gr ...

- RecordingOptions录制设置选项

1.录制思考时间 2.录制方式 3.自定义证书 4.非资源选项

- linux下scp用法

scp 对拷文件夹 和 文件夹下的所有文件 对拷文件并重命名 对拷文件夹 (包括文件夹本身) scp -r /home/wwwroot/www/charts/util root@192.168.1 ...

- 20181124_webAPI基础01_创建一个基础的WebAPI项目

1. webApi属于RESTful架构风格, 而RESTful风格, 是以资源为视角来描述服务的 2. 创建webAPI项目 3. 选择webAPI, 然后mvc会自动引用 4. 点击确定, 就创建 ...