Fast R-CNN学习总结

Fast R-CNN是R-CNN的改良版,同时也吸取了SPP-net中的方法。在此做一下总结。

论文中讲到在训练阶段,训练一个深度目标检测网络(VGG16),训练速度要比R-CNN快9倍左右,比SPP-net快3倍左右。在测试阶段,处理一张图片需要0.3s。在PASCAL VOC 2012数据库上的mAP也达到了66%,比R-CNN高两个百分点。

提出背景

这个方法提出的背景是,R-CNN和SPP-net在目标检测方面还有一些不足。不足表现在一下几点:

1、训练分为多个阶段,首先要微调ConvNet,用来提取特征,然后处理proposal,计算得到的ConvNet特征,使用线性SVM进行分类,最后用bounding box进行回归;

2、训练时间和空间开销大。每一张图像上有大量proposal,还要对每个proposal提取特征,并存到磁盘中;

3、测试阶段速度太慢。要对每张图片上的大量proposal提取特征,然后根据提取的特征进行检测。

创新点

Fast R-CNN的创新点在于:

1、相较于R-CNN和SPP-net,检测结果精确度更高;

2、训练只有一个阶段,将多任务的loss结合在一起;

3、在训练时,可更新所有的层;

4、不需要在硬盘中存储特征。

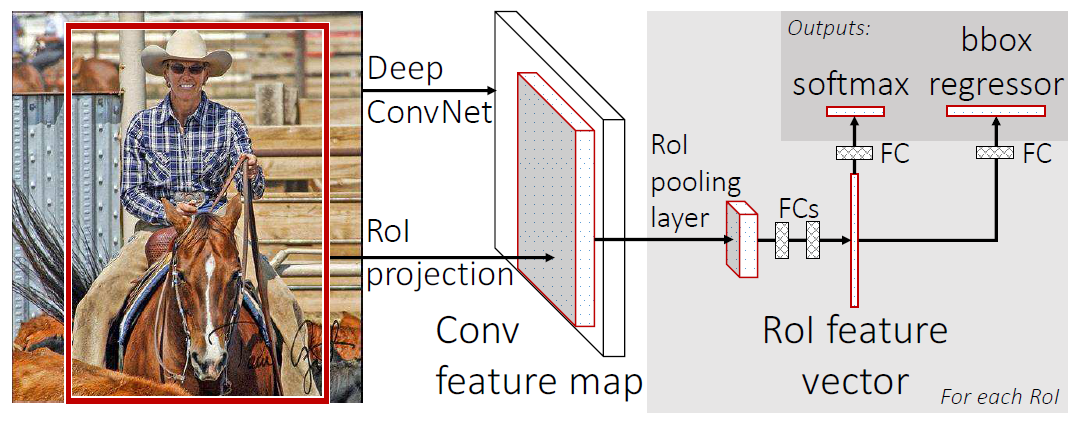

Fast R-CNN的框架

1、我们还是需要使用selective search算法在图像中提取2k个左右的候选框;

2、然后将图像和候选框(即RoIs)信息输入网络中,并在最后的卷积层上对每个RoI求映射关系,并使用RoI pooling layer来将对应的特征统一到相同的大小;

3、最终网络有两个输出,也对应两个loss,一个使用softmax进行分类,另一个进行bounding box回归。

其中的RoI pooling layer是借鉴了SPP-net的方法,只是只有一级“金字塔”,将特征划分为H×W的网格,对每个网格进行max-pooling,提取特征。论文中H=W=7。

Fast R-CNN的训练

我们要对网络进行修改,使用RoI pooling layer替换最后的pooling层(即全连接层之前的pooling层),使用 两个姊妹层替代最后的全连接层和softmax层。两个姊妹层,其中一个是全连接+softmax,用作分类任务;另一个是用于bounding box回归的任务。

在训练阶段,每一个mini-batch中首先加入N张完整图片,而后加入从N张图片中选取的R个候选框。这R个候选框可以复用N张图片前5个阶段的网络特征。实际选择N=2, R=128。N张完整的图像以50%的概率进行水平翻转,R个候选框的构成如下:

| 类别 | 比例 | 方式 |

|---|---|---|

| 前景 | 25% | 与某个真值重叠在[0.5,1]的候选框 |

| 背景 | 75% | 与真值重叠的最大值在[0.1,0.5)的候选框 |

多任务loss

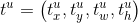

每个RoI都对应着一个ground-truth class  和一个ground-truth bounding box regression target

和一个ground-truth bounding box regression target  。

。

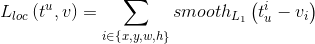

表示K+1个类别各自对应的概率,p由softmax层计算得到。我们将分类任务的loss定义为:

表示K+1个类别各自对应的概率,p由softmax层计算得到。我们将分类任务的loss定义为:

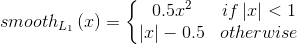

ground-truth bounding box regression target  ,bounding box任务的预测结果

,bounding box任务的预测结果 ,

, 对应正确的类别。因为我们进行bounding box回归时,不考虑背景,所以

对应正确的类别。因为我们进行bounding box回归时,不考虑背景,所以 时,bounding box回归没有对应的loss,而当

时,bounding box回归没有对应的loss,而当 时,对应的loss为:

时,对应的loss为:

其中

所以,最终的loss为:

所以,最终的loss为:

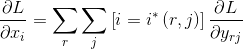

RoI pooling层的反向传播

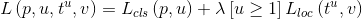

是RoI pooling层输入中的一个节点(可以理解为一个像素),

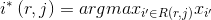

是RoI pooling层输入中的一个节点(可以理解为一个像素), 是对应第r个RoI的第j个输出(也可以理解为一个像素),那么RoI pooling层所做的操作为

是对应第r个RoI的第j个输出(也可以理解为一个像素),那么RoI pooling层所做的操作为 ,其中

,其中 ,

, 是池化得到

是池化得到 的小网格区域,由于不同的RoI会可能会包含同样的像素,所以一个

的小网格区域,由于不同的RoI会可能会包含同样的像素,所以一个 可能对应多个

可能对应多个 ,最终loss关于

,最终loss关于  的偏导数为:

的偏导数为:

Fast R-CNN学习总结的更多相关文章

- R基础学习

R基础学习 The Art of R Programming 1.seq 产生等差数列:seq(from,to,by) seq(from,to,length) for(i in 1:length(x) ...

- 卷积神经网络(CNN)学习笔记1:基础入门

卷积神经网络(CNN)学习笔记1:基础入门 Posted on 2016-03-01 | In Machine Learning | 9 Comments | 14935 Vie ...

- R语言学习 第四篇:函数和流程控制

变量用于临时存储数据,而函数用于操作数据,实现代码的重复使用.在R中,函数只是另一种数据类型的变量,可以被分配,操作,甚至把函数作为参数传递给其他函数.分支控制和循环控制,和通用编程语言的风格很相似, ...

- CNN学习笔记:批标准化

CNN学习笔记:批标准化 Batch Normalization Batch Normalization, 批标准化, 是将分散的数据统一的一种做法, 也是优化神经网络的一种方法. 在神经网络的训练过 ...

- CNN学习笔记:目标函数

CNN学习笔记:目标函数 分类任务中的目标函数 目标函数,亦称损失函数或代价函数,是整个网络模型的指挥棒,通过样本的预测结果与真实标记产生的误差来反向传播指导网络参数学习和表示学习. 假设某分类任务共 ...

- CNN学习笔记:卷积神经网络

CNN学习笔记:卷积神经网络 卷积神经网络 基本结构 卷积神经网络是一种层次模型,其输入是原始数据,如RGB图像.音频等.卷积神经网络通过卷积(convolution)操作.汇合(pooling)操作 ...

- CNN学习笔记:全连接层

CNN学习笔记:全连接层 全连接层 全连接层在整个网络卷积神经网络中起到“分类器”的作用.如果说卷积层.池化层和激活函数等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的特征表示映射到样 ...

- CNN学习笔记:池化层

CNN学习笔记:池化层 池化 池化(Pooling)是卷积神经网络中另一个重要的概念,它实际上是一种形式的降采样.有多种不同形式的非线性池化函数,而其中“最大池化(Max pooling)”是最为常见 ...

- CNN学习笔记:卷积运算

CNN学习笔记:卷积运算 边缘检测 卷积 卷积是一种有效提取图片特征的方法.一般用一个正方形卷积核,遍历图片上的每一个像素点.图片与卷积核重合区域内相对应的每一个像素值乘卷积核 .内相对应点的权重,然 ...

- CNN学习笔记:激活函数

CNN学习笔记:激活函数 激活函数 激活函数又称非线性映射,顾名思义,激活函数的引入是为了增加整个网络的表达能力(即非线性).若干线性操作层的堆叠仍然只能起到线性映射的作用,无法形成复杂的函数.常用的 ...

随机推荐

- Ajax+PHP实现异步图片上传

1.html <!DOCTYPE html> <html> <head> <meta charset="utf-8"> <ti ...

- Hdu 5052 Yaoge’s maximum profit(树链剖分)

题目大意: 给出一棵树.每一个点有商店.每一个商店都有一个价格,Yaoge每次从x走到y都能够在一个倒卖商品,从中得取利益.当然,买一顶要在卖之前.可是没次走过一条路,这条路上的全部商品都会添加一个v ...

- xcode10不兼容问题解决方法,framework编译脚本

XCode10报错:Build/Intermediates.noindex/XCBuildData/build.db": disk I/O error 更改-scheme 为-target ...

- iOS中Block循环引用的问题

说到循环引用问题,想必大家都碰到过吧,比如在使用Block的时候,使用__weakSelf来代替self解决等,但是对于这个,还是有不少可以探索的点,下面我就来说下,希望对大家有所帮助. 是否所有的B ...

- UML架构设计师必备神器

UML-架构设计师必备神器 做过Java开发的一定都听过UML,也都能感觉到它的重要性.由其是在网上搜索一些高级技术介绍,写的好的.阅读量高的.让初.中级程序员容易看懂的.思路清晰的文章一定有UML类 ...

- angular setInterval计时操作

在angular中setInterval方法是单向绑定,只绑定一次,无法实现计时效果, 可以使用$interval实现.附上代码:

- js 时间转换毫秒的四种方法(转)

将时间转换为毫秒数的方法有四个: Date.parse()Date.UTCvalueOf()getTime() 1. Date.parse():该方法接受一个表示日期的字符串参数,然后尝试根据这个日期 ...

- Windows 安装Redis程序

一.系统环境 1.硬件系统:Windows7 64位 2.软件环境: Redis 64位 3.2.100.Redis Desktop Manager. 二.Redis安装 下载地址:https://g ...

- 单片机中不带字库LCD液晶屏显示少量汉字

单片机中不带字库LCD液晶屏如何显示少量汉字,一般显示汉字的方法有1.使用带字库的LCD屏,2.通过SD 卡或者外挂spi flash存中文字库,3.直接将需要的汉字取模存入mcu的flash中. 第 ...

- 适合初学Altium Designer的教学视频

以下推荐的我都亲自看过,个人感觉确实不错,可以有助于了解流程,以及一些设计规范 首先是凡亿的PCB教学,贵是贵了点,不过也有免费的,讲解的很详细,而且还有专门的群,610359270 http://w ...