利用Abot爬虫和visjs 呈现漫威宇宙

1. 引言

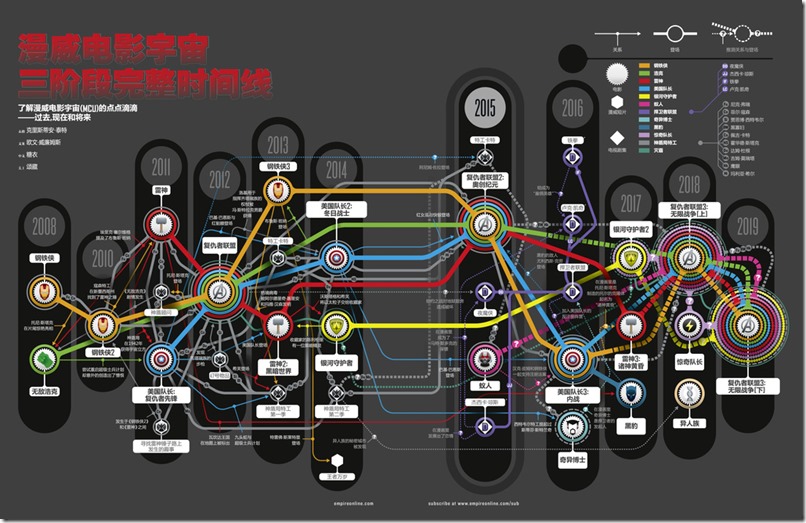

最近接触Abot爬虫也有几天时间了,闲来无事打算从IMDB网站上爬取一些电影数据玩玩。正好美国队长3正在热映,打算爬取漫威近几年的电影并用vis这个JS库呈现下漫威宇宙的相关电影。

Abot是一个开源的C#爬虫,代码非常轻巧。可以参看这篇文章(利用Abot 抓取博客园新闻数据)入门Abot。

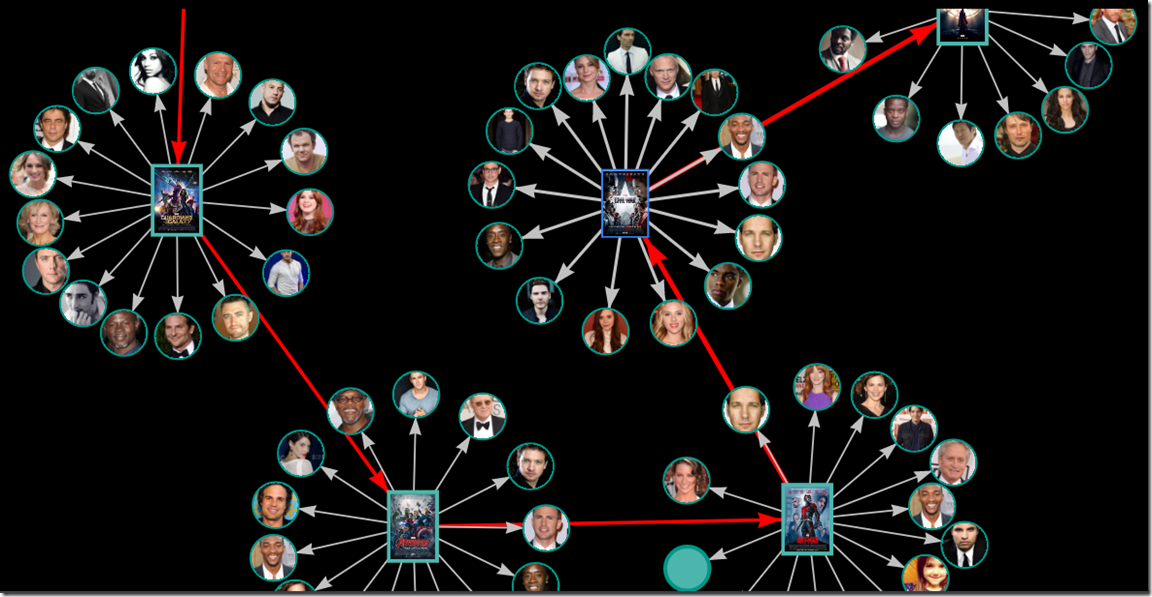

Vis 是一个JS的可视化库类似于D3。vis 提供了像Network 网络图的可视化,TimeLine 可视化等等。这里用到了network,只需要给vis传入简单的节点信息,边的信息就可以自动构建一个网络图。

2. 实现

首先从数据开始,得到漫威宇宙所有相关的电影名称,这个数据网上太多了:

从电影名称到IMDB的电影页面其实有个搜索过程,还好电影数目不多,这里偷个懒直接采用IMDB的电影链接作为种子Url

public static List<string> ImdbFeedMovies = new List<string>()

{

//Iron man 2008

"http://www.imdb.com/title/tt1233205/",

//hunk 2008

"http://www.imdb.com/title/tt0800080/",

//Iron man 2 2010

"http://www.imdb.com/title/tt1228705/",

//Thor 2011

"http://www.imdb.com/title/tt0800369/",

//Captain America

"http://www.imdb.com/title/tt0458339/",

//Averages

"http://www.imdb.com/title/tt0848228/",

//Iron man 3

"http://www.imdb.com/title/tt1300854/",

//thor 2

"http://www.imdb.com/title/tt1981115/",

//Captain America 2

"http://www.imdb.com/title/tt1843866/",

//Guardians of the Galaxy;

"http://www.imdb.com/title/tt2015381/",

//Ultron

"http://www.imdb.com/title/tt2395427/",

//ant-man

"http://www.imdb.com/title/tt0478970/",

//Civil war

"http://www.imdb.com/title/tt3498820/",

//Doctor Strange

"http://www.imdb.com/title/tt1211837/",

//Guardians of the Galaxy 2;

"http://www.imdb.com/title/tt3896198/",

//Thor 3

"http://www.imdb.com/title/tt3501632/",

// Black Panther

"http://www.imdb.com/title/tt1825683/",

//Avengers: Infinity War - Part I

"http://www.imdb.com/title/tt4154756/"

};

有了种子Url 就可以利用Abot 爬取电影的数据,这里只爬取电影名称,电影图片以及演员。

这里定义一些需要用到的数据结构:

public class MarvellItem

{

/// <summary>

/// http://www.imdb.com/title/tt0800369/

/// </summary>

public string ImdbUrl { get; set; }

public string Name { get; set; }

public string Image { get; set; }

} public class ImdbMovie

{

public string ImdbUrl { get; set; }

public string Name { get; set; }

public string Image { get; set; }

public DateTime Date { get; set; } public List<MarvellItem> Actors { get; set; }

} public static readonly Regex MovieRegex = new Regex("http://www.imdb.com/title/tt\\d+", RegexOptions.Compiled);

Abot中爬取页面后最主要的处理函数就是PageCrawlCompletedAsync ,这里给出爬取每个电影页面后的complete Callback函数

private ConcurrentDictionary<string, ImdbMovie> movieResult; //爬取到的电影数据

public void Moviecrawler_ProcessPageCrawlCompletedAsync(object sender, PageCrawlCompletedArgs e)

{

if (MovieRegex.IsMatch(e.CrawledPage.Uri.AbsoluteUri))

{

var csTitle = e.CrawledPage.CsQueryDocument.Select(".title_block > .title_bar_wrapper > .titleBar > .title_wrapper > h1");

string title = HtmlData.HtmlDecode(csTitle.Text().Trim());

var datetime =

e.CrawledPage.CsQueryDocument.Select(

".title_block > .title_bar_wrapper > .titleBar > .title_wrapper > .subtext > a:last > meta");

var year = datetime.Attr("content").Trim();

var csImg = e.CrawledPage.CsQueryDocument.Select(".poster > a > img");

string image = csImg.Attr("src").Trim();

if (!string.IsNullOrEmpty(image))

{

HttpWebRequest webRequest = (HttpWebRequest) WebRequest.Create(image);

webRequest.Credentials = CredentialCache.DefaultCredentials;

var stream = webRequest.GetResponse().GetResponseStream();

if (stream != null)

{

Image bitmap = new Bitmap(stream);

image = e.CrawledPage.Uri.AbsoluteUri.GetHashCode() + ".jpg";

bitmap.Save(image);

}

}

var csTable = e.CrawledPage.CsQueryDocument.Select("#titleCast > table");

var csTrs = csTable.Select("tr", csTable);

List<MarvellItem> actors = new List<MarvellItem>();

foreach (var tr in csTrs)

{

var csTr = new CsQuery.CQ(tr);

var cslink = csTr.Select("td > a", csTr);

if (cslink.Any())

{

string url = NormUrl(cslink.Attr("href").Trim());

string actorTitle = cslink.Select("img", cslink).Attr("title").Trim();

string actorImage = cslink.Select("img", cslink).Attr("src").Trim();

actors.Add(new MarvellItem()

{

Name = actorTitle,

ImdbUrl = url,

Image = actorImage

});

}

}

this.movieResult.TryAdd(e.CrawledPage.Uri.AbsoluteUri, new ImdbMovie()

{

Name = title,

Image = image,

Date = DateTime.Parse(year),

ImdbUrl = e.CrawledPage.Uri.AbsoluteUri,

Actors = actors

});

}

}

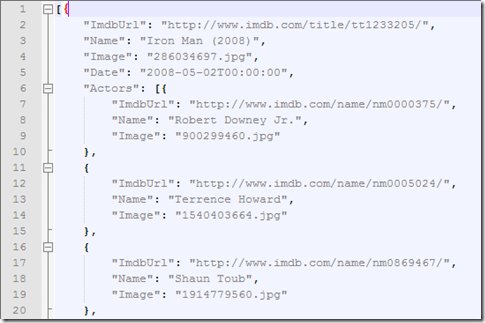

该函数的主要功能就是解析电影页面,得到电影名字 电影图片 和 演员信息。这里面还有一个小trick ,由于IMDB的限制,需要把爬到的图片下载下来,否则在生产环境下<img src=””/> 图片是无法显示的.

更多这个trick的细节可以参看 关于img 403 forbidden的一些思考

对于所有的电影链接,可以采用Task 并行执行:

Task[] movieTasks = new Task[ImdbFeedMovies.Count];

System.Console.WriteLine("Start crawl Movies");

for (var i = 0; i < ImdbFeedMovies.Count; i++)

{

var url = ImdbFeedMovies[i];

movieTasks[i] = new Task(() =>

{

System.Console.WriteLine("Start crawl:" + url);

var crawler = GetManuallyConfiguredWebCrawler();

ConfigMovieCrawl(crawler);

crawler.Crawl(new Uri(url));

System.Console.WriteLine("End crawl:" + url);

});

movieTasks[i].Start();

}

Task.WaitAll(movieTasks);

System.Console.WriteLine("End crawl Movies");

结束后我们得到一堆JSON 数据

把它传到前端:

@model List<ImdbMovie> <div class="clearfix" style="background-color: black; position: relative">

<div id="marvel-graph">

</div>

</div> @section PostScripts{

<script type="text/javascript">

$(function () {

var nodes = [];

var edges = []; @for (int i = 0; i < Model.Count; i++)

{

var film = Model[i];

<text>

nodes.push({

id: '@film.ImdbUrl',

title: '@film.Name',

borderWidth: 4,

shapeProperties: {useBorderWithImage: true},

shape: "image",

image: '@(string.IsNullOrEmpty(film.Image) ? "" : (film.Image.StartsWith("http") ? film.Image : Href("../../Images/marvel/"+film.Image)))',

color: { border: '#4db6ac', background: '#009688' }

}); @if (i != Model.Count - 1)

{

<text>

edges.push({

from: '@film.ImdbUrl',

to: '@Model[i+1].ImdbUrl',

arrows: { to: true },

width: 4,

length:360,

color: "red"

});

</text>

} @foreach (var actor in film.Actors)

{

<text>

nodes.push({

id: '@film.ImdbUrl' + '@actor.ImdbUrl',

title: '@actor.Name',

borderWidth: 4,

shapeProperties: { useBorderWithImage: true },

shape: "circularImage",

image: '@(string.IsNullOrEmpty(actor.Image) ? "" : (actor.Image.StartsWith("http") ? actor.Image : Href("../../Images/marvel/"+actor.Image)))',

}); edges.push({

from: '@film.ImdbUrl',

to: '@film.ImdbUrl' + '@actor.ImdbUrl',

arrows: { to: true }

});

</text>

} </text>

} var container = document.getElementById("marvel-graph"); var visNodes = new vis.DataSet(nodes);

var data = {

nodes: visNodes,

edges: edges

}; var options = {

layout: { improvedLayout: false },

nodes: {

borderWidth: 3,

font: {

color: '#000000',

size: 12,

face: 'Segoe UI'

},

color: { background: '#4db6ac', border: '#009688' }

},

edges: {

color: '#c1c1c1',

width: 2,

font: {

color: '#2d2d2d',

size: 12

},

smooth: {

enabled: false,

type: 'continuous'

}

}

}; var network = new vis.Network(container, data, options);

});

</script>

}

vis network 主要就是 new Network(container, data, options); 传入节点 和 边即可。

最终的效果如图:

欢迎访问我的个人主页 51zhang.net 网站还在不断开发中…..

利用Abot爬虫和visjs 呈现漫威宇宙的更多相关文章

- Abot爬虫和visjs

1. 引言 最近接触Abot爬虫也有几天时间了,闲来无事打算从IMDB网站上爬取一些电影数据玩玩.正好美国队长3正在热映,打算爬取漫威近几年的电影并用vis这个JS库呈现下漫威宇宙的相关电影. Abo ...

- Abot 爬虫

Abot 爬虫分析-整体结构 1. 引言 在Github 上搜索下Web Crawler 有上千个开源的项目,但是C#的仅仅只有168 个,相比于Java 或者Python 确实少的可怜.如果按照St ...

- 利用简易爬虫完成一道基础CTF题

利用简易爬虫完成一道基础CTF题 声明:本文主要写给新手,侧重于表现使用爬虫爬取页面并提交数据的大致过程,所以没有对一些东西解释的很详细,比如表单,post,get方法,感兴趣的可以私信或评论给我.如 ...

- 企业级Python开发大佬利用网络爬虫技术实现自动发送天气预告邮件

前天小编带大家利用Python网络爬虫采集了天气网的实时信息,今天小编带大家更进一步,将采集到的天气信息直接发送到邮箱,带大家一起嗨~~拓展来说,这个功能放在企业级角度来看,只要我们拥有客户的邮箱,之 ...

- Abot 爬虫分析-整体结构

1. 引言 在Github 上搜索下Web Crawler 有上千个开源的项目,但是C#的仅仅只有168 个,相比于Java 或者Python 确实少的可怜.如果按照Stars 排名.可以看到 排在第 ...

- 利用Python爬虫爬取淘宝商品做数据挖掘分析实战篇,超详细教程

项目内容 本案例选择>> 商品类目:沙发: 数量:共100页 4400个商品: 筛选条件:天猫.销量从高到低.价格500元以上. 项目目的 1. 对商品标题进行文本分析 词云可视化 2. ...

- 如何利用python爬虫爬取爱奇艺VIP电影?

环境:windows python3.7 思路: 1.先选取你要爬取的电影 2.用vip解析工具解析,获取地址 3.写好脚本,下载片断 4.将片断利用电脑合成 需要的python模块: ##第一 ...

- 利用python3 爬虫 定制版妹子图mzitu爬取

在刚开始学爬虫的时候,用来练手的基础爬虫就是爬取各种妹子图片,前几天同时说了这个,便准备随便写一个...最后发现真是三天不练..什么都记不住了!!所以花了政治一天重新写了一个爬虫程序,并且支持按照时间 ...

- 如何利用 Python 爬虫实现给微信群发新闻早报?(详细)

1. 场景 经常有小伙伴在交流群问我,每天的早报新闻是怎么获取的? 其实,早期使用的方案,是利用爬虫获取到一些新闻网站的标题,然后做了一些简单的数据清洗,最后利用 itchat 发送到指定的社群中. ...

随机推荐

- MVC5:使用Ajax和HTML5实现文件上传功能

引言 在实际编程中,经常遇到实现文件上传并显示上传进度的功能,基于此目的,本文就为大家介绍不使用flash 或任何上传文件的插件来实现带有进度显示的文件上传功能. 基本功能:实现带有进度条的文件上传功 ...

- vs2013中的“任务列表”菜单

以前在java项目中经常用到todo. 现在vs2013也完美支持了. 首先,对于目前不确定而尚需完善的代码,在前面加 //TODO:by who --注释文字,比如: //TODO:lhl--类目I ...

- 创建Cookie,简单模拟登录,记录登录名,购物车记录先前添加内容,session控制登录

工作任务:模拟淘宝登录和购物车功能:使用cookie记录登录名,下次登录时能够记得上次的登录名,使用cookie模拟购物车功能,使用session记住登录信息并验证是否登录,防止利用url打开网站, ...

- SQLServer性能分析

SQLServer性能分析 当数据库出现性能问题,应用出现运行缓慢的时候,下面这个东东能让你如获至宝 create table #sp_who2 ( SPID int ,status varchar( ...

- Linux下MakeFile初探

make是linux下的编译命令,用于编译和生成Linux下的可执行文件.这个命令处理的对象是Makefile,makefile等.由于make的强大解析能力,makefile文件的编写也变得极为简单 ...

- Android限定EditText的输入类型为数字或者英文(包括大小写),EditText,TextView只能输入两位小数

Android限定EditText的输入类型为数字或者英文(包括大小写) // 监听密码输入框的输入内容类型,不可以输入中文 TextWatcher mTextWatcher = new Tex ...

- Jquery的基本架构

引入 以前学习原生JS然后切换到用JQ的时候总觉得很不习惯,甚至有点排斥用JQ.后来自己写项目一直到公司实习用JQ的这段时间,才深深感受到JQ的强大~JQ不仅做到兼容很多浏览器,还能很方便地使用JS ...

- andriod sdk模拟器安装过程中报错

andriod sdk模拟器安装过程中,出现下述错误: Failed to fetch URL http://dl-ssl.google.com/android/repository/reposito ...

- javaweb回顾第九篇EL表达式

前言:关于EL表示式开发用的非常多,现在我们回顾一下关于如果去操作EL表达式 1:EL表达式语法 所有EL表达式都是由{开始}结束,表达式中用.和[]操作符来访问数据比喻${user.userName ...

- Java并发包中CyclicBarrier的工作原理、使用示例

1. CyclicBarrier的介绍与源码分析 CyclicBarrier 的字面意思是可循环(Cyclic)使用的屏障(Barrier).它要做的事情是,让一组线程到达一个屏障(也可以叫同步点)时 ...