sql 中的Bulk和C# 中的SqlBulkCopy批量插入数据 ( 回顾 and 粗谈 )

通常,我们会对于一个文本文件数据导入到数据库中,不多说,上代码。

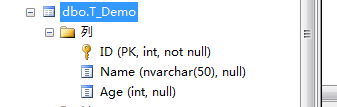

首先,表结构如下.

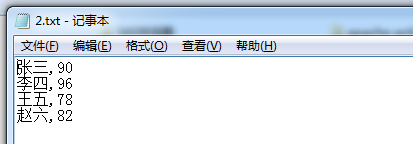

其次,在我当前D盘中有个文本文件名为2.txt的文件。

在数据库中,可以这样通过一句代码插入。

Bulk insert T_Demo

From 'D:\2.txt'

With

( fieldterminator=',',

rowterminator='\n'

)

1) bulk insert: 为Sql server 中一个批量插入的操作

2)T_Demo: 要插入的表

3)'D:\2.txt': 数据源文件所在磁盘上的物理路径

4)with 相当于一些插入的附属条件,可以起这里添加一些约束限制条件等

5) fieldterminator=’,’字段的分割符为”,”一般的txt文本数据源的字段分隔都为逗号,当然也可以为其他,比如”|”

6)rowterminator=’\n’各条信息间的分割符为’\n’,一般的txt文本数据源的信息间的分割都是换行符,即一条信息占一行,也可以用其他格式如:”|\n”

在微软官方给的详细如下:

BULK INSERT

[ database_name . [ schema_name ] . | schema_name . ] [ table_name | view_name ]

FROM 'data_file'

[ WITH

(

[ [ , ] BATCHSIZE = batch_size ]

[ [ , ] CHECK_CONSTRAINTS ]

[ [ , ] CODEPAGE = { 'ACP' | 'OEM' | 'RAW' | 'code_page' } ]

[ [ , ] DATAFILETYPE =

{ 'char' | 'native'| 'widechar' | 'widenative' } ]

[ [ , ] FIELDTERMINATOR = 'field_terminator' ]

[ [ , ] FIRSTROW = first_row ]

[ [ , ] FIRE_TRIGGERS ]

[ [ , ] FORMATFILE = 'format_file_path' ]

[ [ , ] KEEPIDENTITY ]

[ [ , ] KEEPNULLS ]

[ [ , ] KILOBYTES_PER_BATCH = kilobytes_per_batch ]

[ [ , ] LASTROW = last_row ]

[ [ , ] MAXERRORS = max_errors ]

[ [ , ] ORDER ( { column [ ASC | DESC ] } [ ,...n ] ) ]

[ [ , ] ROWS_PER_BATCH = rows_per_batch ]

[ [ , ] ROWTERMINATOR = 'row_terminator' ]

[ [ , ] TABLOCK ]

[ [ , ] ERRORFILE = 'file_name' ]

)]

这里我们主要看with中的一些参数:(部分)

1) BATCHSIZE : 指定批处理中的行数

2) CHECK_CONSTRAINTS:启用约束检查,指定在大容量导入操作期间,必须检查所有对目标表或视图的约束。若没有 CHECK_CONSTRAINTS 选项,则忽略所有 CHECK 和 FOREIGN KEY 约束,并在该操作后将表的约束标记为不可信。始终强制使用 UNIQUE、PRIMARY KEY 和 NOT NULL 约束。

3) FIRE_TRIGGERS

指定将在大容量导入操作期间执行目标表中定义的所有插入触发器。如果为针对目标表的 INSERT 操作定义了触发器,则每次完成批处理操作时均激发触发器。

4) KEEPNULLS

指定空列在大容量导入操作期间应保留 Null 值,而不插入列的任何默认值

5) ORDER ( { column [ ASC | DESC ] } [ ,...n ] )

指定如何对数据文件中的数据排序。如果根据表中的聚集索引(如果有)对要导入的数据排序,则可提高大容量导入的性能

6) ERRORFILE ='file_name'

指定用于收集格式有误且不能转换为 OLE DB 行集的行的文件。这些行将按原样从数据文件复制到此错误文件中。

--------------------------------------------------------------SqlBulkCopy分割线---------------------------------------------------------------------

在C#中,我们可以使用sqlBulkCopy去批量插入数据,其他批量插入方法不在讨论。

上代码......

/// <summary>

/// SqlBulkCopy批量插入数据

/// </summary>

/// <param name="connectionStr">链接字符串</param>

/// <param name="dataTableName">表名</param>

/// <param name="sourceDataTable">数据源</param>

/// <param name="batchSize">一次事务插入的行数</param>

public static void SqlBulkCopyByDataTable(string connectionStr, string dataTableName, DataTable sourceDataTable, int batchSize = )

{

using (SqlConnection connection=new SqlConnection(connectionStr))

{

using (SqlBulkCopy sqlBulkCopy=new SqlBulkCopy(connectionStr,SqlBulkCopyOptions.UseInternalTransaction))

{

try

{

sqlBulkCopy.DestinationTableName = dataTableName;

sqlBulkCopy.BatchSize = batchSize;

for (int i = ; i < sourceDataTable.Columns.Count; i++)

{

sqlBulkCopy.ColumnMappings.Add(sourceDataTable.Columns[i].ColumnName,sourceDataTable.Columns[i].ColumnName);

}

sqlBulkCopy.WriteToServer(sourceDataTable);

}

catch (Exception ex)

{ throw ex;

}

}

}

}

使用方式如下,这里我将插入100万条数据,

在SqlBulkCopyByDataTable方法中每次插入10万条,

其插入方式SqlBulkCopyOptions.UseInternalTransaction (即事务插入,可用其他方式。)

DataTable dt = new DataTable("测试");

dt.Columns.Add("ID",typeof(int));

dt.Columns.Add("Name", typeof(string));

dt.Columns.Add("Age", typeof(int));

for (int i = ; i <= ; i++)

{

DataRow row = dt.NewRow();

row["ID"] = i;

row["Name"] = "名字"+i;

row["Age"] = i;

dt.Rows.Add(row);

}

string connStr = System.Configuration.ConfigurationManager.ConnectionStrings["connStr"].ConnectionString;

Stopwatch stopWatch = new Stopwatch();

stopWatch.Start();

SqlBulkCopyByDataTable(connStr, "T_Demo", dt);

Console.WriteLine(stopWatch.Elapsed);

Console.ReadKey();

用时为如下。

参考: http://blog.csdn.net/xuemoyao/article/details/8506338

本文到此结束。

纯属回顾与粗谈,并没有细说。

请各位见谅。

sql 中的Bulk和C# 中的SqlBulkCopy批量插入数据 ( 回顾 and 粗谈 )的更多相关文章

- C#中的SqlBulkCopy批量插入数据

在C#中,我们可以使用sqlBulkCopy去批量插入数据,其他批量插入方法不在讨论. 1 /// <summary> 2 /// SqlBulkCopy批量插入数据 3 /// < ...

- 用SqlBulkCopy批量插入数据到SqlServer数据库表中

首先创建一个数据库连接类:SQLHelper using System; using System.Collections.Generic; using System.Linq; using Syst ...

- C#批量插入数据到Sqlserver中的四种方式

我的新书ASP.NET MVC企业级实战预计明年2月份出版,感谢大家关注! 本篇,我将来讲解一下在Sqlserver中批量插入数据. 先创建一个用来测试的数据库和表,为了让插入数据更快,表中主键采用的 ...

- C#批量插入数据到Sqlserver中的三种方式

本篇,我将来讲解一下在Sqlserver中批量插入数据. 先创建一个用来测试的数据库和表,为了让插入数据更快,表中主键采用的是GUID,表中没有创建任何索引.GUID必然是比自增长要快的,因为你生 成 ...

- C#_批量插入数据到Sqlserver中的四种方式

先创建一个用来测试的数据库和表,为了让插入数据更快,表中主键采用的是GUID,表中没有创建任何索引.GUID必然是比自增长要快的,因为你生成一个GUID算法所花的时间肯定比你从数据表中重新查询上一条记 ...

- C# 之 批量插入数据到 SQLServer 中

创建一个用来测试的数据库和表,为了让插入数据更快,表中主键采用的是GUID,表中没有创建任何索引.GUID必然是比自增长要快.而如果存在索引的情况下,每次插入记录都会进行索引重建,这是非常耗性能的.如 ...

- C#批量插入数据到Sqlserver中的四种方式 - 转

先创建一个用来测试的数据库和表,为了让插入数据更快,表中主键采用的是GUID,表中没有创建任何索引.GUID必然是比自增长要快的,因为你生成一个GUID算法所花的时间肯定比你从数据表中重新查询上一条记 ...

- 【转载】C#批量插入数据到Sqlserver中的三种方式

引用:https://m.jb51.net/show/99543 这篇文章主要为大家详细介绍了C#批量插入数据到Sqlserver中的三种方式,具有一定的参考价值,感兴趣的小伙伴们可以参考一下 本篇, ...

- C# 批量插入表SQLSERVER SqlBulkCopy往数据库中批量插入数据

#region 帮助实例:SQL 批量插入数据 多种方法 /// <summary> /// SqlBulkCopy往数据库中批量插入数据 /// </summary> /// ...

随机推荐

- [史上最全]C#(VB.NET)中位运算符工作过程剖析(译)

原文地址CodeProject 目录 介绍 “二进制-十进制”相互转换 十进制->二进制 二进制->十进制 OR运算符(按位或|) OR运算符工作方式 FlagsAttribute AND ...

- Linux模块机制浅析

Linux模块机制浅析 Linux允许用户通过插入模块,实现干预内核的目的.一直以来,对linux的模块机制都不够清晰,因此本文对内核模块的加载机制进行简单地分析. 模块的Hello World! ...

- 链表&LRU

简介 链表就是链式存储数据的一种数据结构.双向链表每个数据存储都包含他的前后数据节点的位置信息(索引/指针). class DSChain<T> { //使用栈来进行废弃空间回收 priv ...

- 干货!表达式树解析"框架"(1)

最新设计请移步 轻量级表达式树解析框架Faller http://www.cnblogs.com/blqw/p/Faller.html 关于我和表达式树 其实我也没有深入了解表达式树一些内在实现的原理 ...

- .NET 基础 一步步 一幕幕 [.NET 系列预热]

.NET 系列预热 .NET : 一般指.Net Framework框架.一种平台,一种技术. .NET 下的编程语言有C#,F#,VB:在这里我们主要讲述的C#. .NET 一般都能干什么呢? l ...

- 修改windows自带的Ctrl+Space输入法切换快捷键

使用场景: 多为我等码农使用一些编辑器时,编辑器的默认代码提示热键为 ctrl+space ,但这个热键被系统的输入法开关占用.如果遇到可以设置快捷键的编辑器还好,要是不能设置的话(比如火狐浏览器的代 ...

- Distributed2:Linked Server Login 添加和删除

一,通过 sys.sp_addlinkedsrvlogin 创建Linked Server的Login 当在local Server 上需要访问Linked Server时,Local Server ...

- VB.NET 如何进行调用HTTP外部接口

直接上干货 Private Function POST(ByVal URL$, ByVal data$) Dim http On Error Resume Next http = CreateObj ...

- .NET平台开源项目速览(5)深入使用与扩展SharpConfig组件

上个月在文章:这些.NET开源项目你知道吗?让.NET开源来得更加猛烈些吧 和 .NET平台开源项目速览(1)SharpConfig配置文件读写组件 中都提到了SharpConfig组件,简单轻量级 ...

- 通过监控线程状态来保证socket服务器的稳定运行

云平台中使用的socket服务器是我们自己定义一套通信协议,并通过C#实现的一个socket服务. 该服务目前是和web服务一起运行在IIS容器中,通过启动一个永不退出的新线程来监听端口. 在开发的初 ...