cudnn 卷积例子

#include <iomanip>

#include <iostream>

#include <cstdlib>

#include <vector>

#include <stdio.h>

#include <cuda.h>

#include <cudnn_v7.h> #define CUDA_CALL(f) { \

cudaError_t err = (f); \

if (err != cudaSuccess) { \

std::cout \

<< " Error occurred: " << err << std::endl; \

std::exit(1); \

} \

} #define CUDNN_CALL(f) { \

cudnnStatus_t err = (f); \

if (err != CUDNN_STATUS_SUCCESS) { \

std::cout \

<< " Error occurred: " << err << std::endl; \

std::exit(1); \

} \

} __global__ void dev_const(float *px, float k) {

int tid = threadIdx.x + blockIdx.x * blockDim.x;

px[tid] = k;

} __global__ void dev_iota(float *px) {

int tid = threadIdx.x + blockIdx.x * blockDim.x;

px[tid] = tid;

} void print(const float *data, int n, int c, int h, int w) {

std::vector<float> buffer(1 << 20);

CUDA_CALL(cudaMemcpy(

buffer.data(), data,

n * c * h * w * sizeof(float),

cudaMemcpyDeviceToHost));

int a = 0;

for (int i = 0; i < n; ++i) {

for (int j = 0; j < c; ++j) {

std::cout << "n=" << i << ", c=" << j << ":" << std::endl;

for (int k = 0; k < h; ++k) {

for (int l = 0; l < w; ++l) {

std::cout << std::setw(4) << std::right << buffer[a];

++a;

}

std::cout << std::endl;

}

}

}

std::cout << std::endl;

} int main() {

cudnnHandle_t cudnn;

CUDNN_CALL(cudnnCreate(&cudnn)); // input

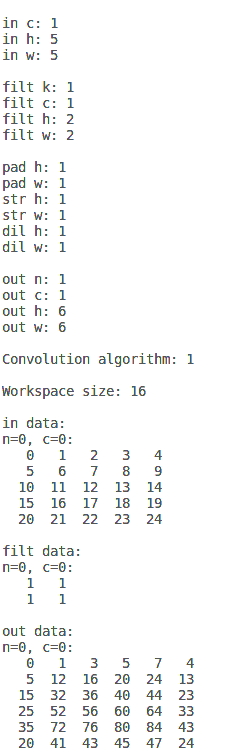

const int in_n = 1;

const int in_c = 1;

const int in_h = 5;

const int in_w = 5;

std::cout << "in_n: " << in_n << std::endl;

std::cout << "in_c: " << in_c << std::endl;

std::cout << "in_h: " << in_h << std::endl;

std::cout << "in_w: " << in_w << std::endl;

std::cout << std::endl; cudnnTensorDescriptor_t in_desc;

CUDNN_CALL(cudnnCreateTensorDescriptor(&in_desc));

CUDNN_CALL(cudnnSetTensor4dDescriptor(

in_desc, CUDNN_TENSOR_NCHW, CUDNN_DATA_FLOAT,

in_n, in_c, in_h, in_w)); float *in_data;

CUDA_CALL(cudaMalloc(

&in_data, in_n * in_c * in_h * in_w * sizeof(float))); // filter

const int filt_k = 1;

const int filt_c = 1;

const int filt_h = 2;

const int filt_w = 2;

std::cout << "filt_k: " << filt_k << std::endl;

std::cout << "filt_c: " << filt_c << std::endl;

std::cout << "filt_h: " << filt_h << std::endl;

std::cout << "filt_w: " << filt_w << std::endl;

std::cout << std::endl; cudnnFilterDescriptor_t filt_desc;

CUDNN_CALL(cudnnCreateFilterDescriptor(&filt_desc));

CUDNN_CALL(cudnnSetFilter4dDescriptor(

filt_desc, CUDNN_DATA_FLOAT, CUDNN_TENSOR_NCHW,

filt_k, filt_c, filt_h, filt_w)); float *filt_data;

CUDA_CALL(cudaMalloc(

&filt_data, filt_k * filt_c * filt_h * filt_w * sizeof(float))); // convolution

const int pad_h = 1;

const int pad_w = 1;

const int str_h = 1;

const int str_w = 1;

const int dil_h = 1;

const int dil_w = 1;

std::cout << "pad_h: " << pad_h << std::endl;

std::cout << "pad_w: " << pad_w << std::endl;

std::cout << "str_h: " << str_h << std::endl;

std::cout << "str_w: " << str_w << std::endl;

std::cout << "dil_h: " << dil_h << std::endl;

std::cout << "dil_w: " << dil_w << std::endl;

std::cout << std::endl; cudnnConvolutionDescriptor_t conv_desc;

CUDNN_CALL(cudnnCreateConvolutionDescriptor(&conv_desc));

CUDNN_CALL(cudnnSetConvolution2dDescriptor(

conv_desc,

pad_h, pad_w, str_h, str_w, dil_h, dil_w,

CUDNN_CONVOLUTION, CUDNN_DATA_FLOAT)); // output

int out_n;

int out_c;

int out_h;

int out_w; CUDNN_CALL(cudnnGetConvolution2dForwardOutputDim(

conv_desc, in_desc, filt_desc,

&out_n, &out_c, &out_h, &out_w)); std::cout << "out_n: " << out_n << std::endl;

std::cout << "out_c: " << out_c << std::endl;

std::cout << "out_h: " << out_h << std::endl;

std::cout << "out_w: " << out_w << std::endl;

std::cout << std::endl; cudnnTensorDescriptor_t out_desc;

CUDNN_CALL(cudnnCreateTensorDescriptor(&out_desc));

CUDNN_CALL(cudnnSetTensor4dDescriptor(

out_desc, CUDNN_TENSOR_NCHW, CUDNN_DATA_FLOAT,

out_n, out_c, out_h, out_w)); float *out_data;

CUDA_CALL(cudaMalloc(

&out_data, out_n * out_c * out_h * out_w * sizeof(float))); // algorithm

cudnnConvolutionFwdAlgo_t algo;

CUDNN_CALL(cudnnGetConvolutionForwardAlgorithm(

cudnn,

in_desc, filt_desc, conv_desc, out_desc,

CUDNN_CONVOLUTION_FWD_PREFER_FASTEST, 0, &algo)); std::cout << "Convolution algorithm: " << algo << std::endl;

std::cout << std::endl; // workspace

size_t ws_size;

CUDNN_CALL(cudnnGetConvolutionForwardWorkspaceSize(

cudnn, in_desc, filt_desc, conv_desc, out_desc, algo, &ws_size)); float *ws_data;

CUDA_CALL(cudaMalloc(&ws_data, ws_size)); std::cout << "Workspace size: " << ws_size << std::endl;

std::cout << std::endl; // perform

float alpha = 1.f;

float beta = 0.f;

dev_iota<<<in_w * in_h, in_n * in_c>>>(in_data);

dev_const<<<filt_w * filt_h, filt_k * filt_c>>>(filt_data, 1.f);

CUDNN_CALL(cudnnConvolutionForward(

cudnn,

&alpha, in_desc, in_data, filt_desc, filt_data,

conv_desc, algo, ws_data, ws_size,

&beta, out_desc, out_data)); // results

std::cout << "in_data:" << std::endl;

print(in_data, in_n, in_c, in_h, in_w); std::cout << "filt_data:" << std::endl;

print(filt_data, filt_k, filt_c, filt_h, filt_w); std::cout << "out_data:" << std::endl;

print(out_data, out_n, out_c, out_h, out_w); // finalizing

CUDA_CALL(cudaFree(ws_data));

CUDA_CALL(cudaFree(out_data));

CUDNN_CALL(cudnnDestroyTensorDescriptor(out_desc));

CUDNN_CALL(cudnnDestroyConvolutionDescriptor(conv_desc));

CUDA_CALL(cudaFree(filt_data));

CUDNN_CALL(cudnnDestroyFilterDescriptor(filt_desc));

CUDA_CALL(cudaFree(in_data));

CUDNN_CALL(cudnnDestroyTensorDescriptor(in_desc));

CUDNN_CALL(cudnnDestroy(cudnn));

return 0;

}

运行:

nvcc conv_cudnn.cu -lcudnn

./a.out

<wiz_tmp_tag id="wiz-table-range-border" contenteditable="false" style="display: none;">

cudnn 卷积例子的更多相关文章

- 由浅入深:CNN中卷积层与转置卷积层的关系

欢迎大家前往腾讯云+社区,获取更多腾讯海量技术实践干货哦~ 本文由forrestlin发表于云+社区专栏 导语:转置卷积层(Transpose Convolution Layer)又称反卷积层或分数卷 ...

- SciPy模块应用

1.图像模糊 图像的高斯模糊是非常经典的图像卷积例子.本质上,图像模糊就是将(灰度)图像I 和一个高斯核进行卷积操作:,其中是标准差为σ的二维高斯核.高斯模糊通常是其他图像处理操作的一部分,比如图像 ...

- Python图像处理库(2)

1.4 SciPy SciPy(http://scipy.org/) 是建立在 NumPy 基础上,用于数值运算的开源工具包.SciPy 提供很多高效的操作,可以实现数值积分.优化.统计.信号处理,以 ...

- Python中的图像处理

第 1 章 基本的图像操作和处理 本章讲解操作和处理图像的基础知识,将通过大量示例介绍处理图像所需的 Python 工具包,并介绍用于读取图像.图像转换和缩放.计算导数.画图和保存结果等的基本工具.这 ...

- Convolutional Neural Networks 笔记

1 Foundations of Convolutional Neural Networks 1.1 cv问题 图像分类.目标检测.风格转换.但是高像素的图片会带来许多许多的特征. 1.2 边缘检测( ...

- TextCNN 代码详解(附测试数据集以及GitHub 地址)

前言:本篇是TextCNN系列的第三篇,分享TextCNN的优化经验 前两篇可见: 文本分类算法TextCNN原理详解(一) 一.textCNN 整体框架 1. 模型架构 图一:textCNN 模型结 ...

- 基本图像操作和处理(python)

基本图像操作和处理(python) PIL提供了通用的图像处理功能,以及大量的基本图像操作,如图像缩放.裁剪.旋转.颜色转换等. Matplotlib提供了强大的绘图功能,其下的pylab/pyplo ...

- Relay外部库使用

Relay外部库使用 本文介绍如何将cuDNN或cuBLAS等外部库与Relay一起使用. Relay内部使用TVM生成目标特定的代码.例如,使用cuda后端,TVM为用户提供的网络中的所有层生成cu ...

- CUDA 矩阵乘法终极优化指南

作者:马骏 | 旷视 MegEngine 架构师 前言 单精度矩阵乘法(SGEMM)几乎是每一位学习 CUDA 的同学绕不开的案例,这个经典的计算密集型案例可以很好地展示 GPU 编程中常用的优化技巧 ...

随机推荐

- 多媒体开发之---开源库ffmeg的log之子解析

用了ffmeg快两年了,对其中的log甚是感兴趣,今天在做8148项目是,解读h264结构,看了<毕-新一代视频压缩编码标准h246> ,在第六章中的重排序里面看到了好熟悉的4x4矩阵zi ...

- Hadoop环境搭建1_JDK+SSH

1 前言: Hadoop 最早是为了在Linux 平台上使用而开发的,但是Hadoop 在UNIX.Windows 和Mac OS X 系统上也运行良好.不过,在Windows 上运行Hadoop 稍 ...

- python 微信跳一跳进阶

上一篇是通过图片识别来计算跳的距离,再计算按压时间,最后通过adb来控制手机跳的 本篇讲的是通过机器学习,来训练的算法进行跳一跳的 链接: github:https://github.com/Prin ...

- 读书笔记-HBase in Action-第三部分应用-(1)OpenTSDB

OpenTSDB是基于HBase的开源监控系统,能够支持上万规模集群监控和上亿数据点採集. 当中TSDB代表Time Series Database,OpenTSDB在时间序列数据的存储和查询上都做了 ...

- EasyNVR无插件H5/HLS/m3u8直播解决方案中Windows系统服务启动错误问题的修复:EasyNVR_Service 服务因 函数不正确。 服务特定错误而停止。

最近在做某地市移动公司景观直播的项目时,遇到一个问题,当我们部署EasyNVR为系统服务后,居然出现了无法启动服务的现象,表面上看,提示是系统服务启动失败,实际通过查看windows 系统日志: 查找 ...

- php在web端播放amr语音(如微信语音)

在使用微信JSSDK的上传下载语音接口时,发现一个问题: 下载的语音在iPhone上不能播放,测试了之后原因竟然是: 微信接口返回的音频内容是amr格式的,但iPhone不支持播放此类型格式. 那么转 ...

- CSS 布局实例系列(四)如何实现容器中每一行的子容器数量随着浏览器宽度的变化而变化?

Hello,小朋友们,还记得我是谁吗?对了,我就是~超威~好啦,言归正传,今天的布局实例是: 实现一个浮动布局,红色容器中每一行的蓝色容器数量随着浏览器宽度的变化而变化,就如下图: 肯定有人心里犯嘀咕 ...

- Django用ajax发送post请求时csrf拦截的解决方案

把下面的代码写在模版文件中就可以了, 注:不是js文件,是模版文件加载的执行的,所有写js里没效果 $.ajaxSetup({ data: {csrfmiddlewaretoken: '{{ csrf ...

- 【prometheus】学习第一篇——prometheus

前言: 说到监控方案,市面上开源的有很多,最常用的zabbix,深入使用zabbix以后,才知道zabbix设计团队有多厉害,简直是一个完美的监控告警方案.但是在针对docker的监控上还差点,需要自 ...

- 通过GPRS将GPS数据上传到OneNet流程

AT OK AT+CGCLASS="B" OK AT+CGDCONT=1,"IP","CMNET" OK AT+CGATT=1 OK AT+ ...