人工神经网络(Artificial Neural Networks)

人工神经网络的产生一定程度上受生物学的启发,因为生物的学习系统是由相互连接的神经元相互连接的神经元组成的复杂网络。而人工神经网络跟这个差不多,它是一系列简单的单元相互密集连接而成的。其中每个单元有一定数量的输入(可能是其他单元的输出),并产生单一的实数值输出(可能成为其他单元的输入)。

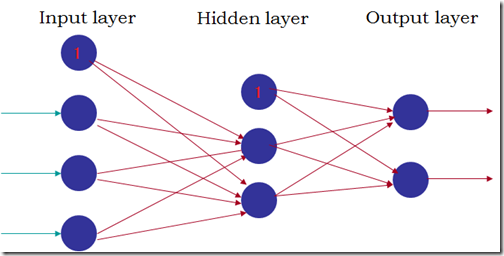

常见的人工神经网络结果如下图:

(1) 网络由三部分组成,输入层、隐藏层和输出层,往往隐藏层只有1层或2层;

(2) 每层由若干个单元组成,所有单元分层互连形成一个无环的前馈网络;

(3) 下一层的某个单元的输入由上一层的所有单元的输出组成,每个输入的权重由相连的边的权值决定。

不同类型的单元对输入的处理方式不同,比较常用是sigmoid单元。sigmoid单元首先对所有输入进行线性组合,然后将线性组合的结果通过sigmoid函数(F(x) = 1/(1+power(e,-x)))映射为0跟1之间的某个值作为输出(sigmoid函数有一个比较有用的特征就是F’(x) = F(x)*( 1-F(x)))。这样,sigmoid单元的输出是输入的非线性函数,并且输出是输入的可微函数。

人工神经网络的学习训练就是为每一条边选取一个合适的权值,使网络输出层的输出和目标值之间的误差平方和最小化。而像反向传播(BackPropagation)这样的算法,就是使用梯度下降来调节各条表的权重,来最佳拟合输入-输出组成的训练数据。

实验:人脸朝向识别

实验数据是具有不同朝向的600多张人脸图片,每个图片的像素是30*32。分为训练集、验证集和测试集,大致图像张数比为6:2:2。训练集用来训练人工神经网络,验证集用来选取在验证集上具有最好性能的网络,而测试集对选中的网络进行最后的评估。

输入:每个像素对应一个网络输入,并且把范围是0-255的亮度值按比例缩放到0-1之间。

输出:使用4个不同的输出单元,每个单元对应一个脸的朝向,取具有最高值的输出作为人脸朝向的预测值。另外,使用0.1和0.9,而不是0和1,例如(0.9,0.1,0.1,01.)表示脸朝向正前方。

网络结构:使用一个隐藏层,隐藏层的单元个数为3个。

其他参数:学习速率设定为0.3,输入单元的权值被设定为0.0,输出单元的权值被初始化为一个较小的随机值。

Python版反向传播算法(随机梯度下降版本)

1.把输入沿网络前向传播

def feedForward(self):

for j in xrange(1,self.hidNum):

sum = 0.0

for i in xrange(self.inNum):

sum += self.inOutput[i]*self.wIn2Hid[i][j]

self.hidOutput[j] = self.sigmoid(sum) for k in xrange(self.outNum):

sum = 0.0

for j in xrange(self.hidNum):

sum += self.hidOutput[j] * self.wHid2Out[j][k]

self.outOutput[k] = self.sigmoid(sum)

2.把误差沿网络反向传播

def backPropagate(self,N=0.3):

# calculate errors for output

for k in xrange(self.outNum):

error = self.targets[k]-self.outOutput[k]

self.outOutputError[k] = self.outOutput[k]*(1-self.outOutput[k])*error # calculate errors for hidden layer

for j in xrange(self.hidNum):

error = 0.0

for k in xrange(self.outNum):

error += self.outOutputError[k]*self.wHid2Out[j][k]

self.hidOutputError[j] = self.hidOutput[j]*(1-self.hidOutput[j])*error # update hid-output weights

for j in xrange(self.hidNum):

for k in xrange(self.outNum):

change = N*self.outOutputError[k]*self.hidOutput[j]

self.wHid2Out[j][k] += change # update input-hid weights

for i in xrange(self.inNum):

for j in xrange(1,self.hidNum):

change = N*self.hidOutputError[j]*self.inOutput[i]

self.wIn2Hid[i][j] += change

实验结果:通过调整输入层、隐藏层中各个单元的权重,网络在验证集上最高的预测准确率是0.892,对应在测试集上的准确率为0.844。

转自本人博客:http://www.datalab.sinaapp.com/

.csharpcode, .csharpcode pre

{

font-size: small;

color: black;

font-family: consolas, "Courier New", courier, monospace;

background-color: #ffffff;

/*white-space: pre;*/

}

.csharpcode pre { margin: 0em; }

.csharpcode .rem { color: #008000; }

.csharpcode .kwrd { color: #0000ff; }

.csharpcode .str { color: #006080; }

.csharpcode .op { color: #0000c0; }

.csharpcode .preproc { color: #cc6633; }

.csharpcode .asp { background-color: #ffff00; }

.csharpcode .html { color: #800000; }

.csharpcode .attr { color: #ff0000; }

.csharpcode .alt

{

background-color: #f4f4f4;

width: 100%;

margin: 0em;

}

.csharpcode .lnum { color: #606060; }

人工神经网络(Artificial Neural Networks)的更多相关文章

- 人工神经网络 Artificial Neural Network

2017-12-18 23:42:33 一.什么是深度学习 深度学习(deep neural network)是机器学习的分支,是一种试图使用包含复杂结构或由多重非线性变换构成的多个处理层对数据进行高 ...

- 吴恩达深度学习第1课第4周-任意层人工神经网络(Artificial Neural Network,即ANN)(向量化)手写推导过程(我觉得已经很详细了)

学习了吴恩达老师深度学习工程师第一门课,受益匪浅,尤其是吴老师所用的符号系统,准确且易区分. 遵循吴老师的符号系统,我对任意层神经网络模型进行了详细的推导,形成笔记. 有人说推导任意层MLP很容易,我 ...

- 循环神经网络(Recurrent Neural Networks, RNN)介绍

目录 1 什么是RNNs 2 RNNs能干什么 2.1 语言模型与文本生成Language Modeling and Generating Text 2.2 机器翻译Machine Translati ...

- 机器学习之Artificial Neural Networks

人类通过模仿自然界中的生物,已经发明了很多东西,比如飞机,就是模仿鸟翼,但最终,这些东西会和原来的东西有些许差异,artificial neural networks (ANNs)就是模仿动物大脑的神 ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第三周:浅层神经网络(Shallow neural networks) -课程笔记

第三周:浅层神经网络(Shallow neural networks) 3.1 神经网络概述(Neural Network Overview) 使用符号$ ^{[

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第四周:深层神经网络(Deep Neural Networks)-课程笔记

第四周:深层神经网络(Deep Neural Networks) 4.1 深层神经网络(Deep L-layer neural network) 有一些函数,只有非常深的神经网络能学会,而更浅的模型则 ...

- 卷积神经网络Convolutional Neural Networks

Convolutional Neural Networks NOTE: This tutorial is intended for advanced users of TensorFlow and a ...

- Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)

3.1 神经网络概述(Neural Network Overview ) (神经网络中,我们要反复计算a和z,最终得到最后的loss function) 3.2 神经网络的表示(Neural Netw ...

- Ng第八课:神经网络表述(Neural Networks: Representation)

8.1 非线性假设 8.2 神经元和大脑 8.3 模型表示 1 8.4 模型表示 2 8.5 特征和直观理解 1 8.6 样本和直观理解 II 8.7 多类分类 8.1 非线性假设 无 ...

随机推荐

- Django路由

一.路由流程 1. 用户浏览器发出请求后,通过根url设置,去找urlpattern变量.在setting.py中对 ROOT_URLCONF进行配置,以确定根URLconf(URL configur ...

- 深入理解Oracle的imp/exp 和各版本之间的规则

Oracle数据中IMP/EXP工具可用于对数据进行迁移.IMP命令用于把Dmp文件从本地导入到远程数据库服务器,而EXP命令则是把数据从远程数据库服务器导出到本地的Dmp文件.其功能相当于Oracl ...

- STM32之定时器

一.定时器简介 1.时钟来源 2.定时器结构(以基本定时器为例) 二.基本定时器的编程方法 1.基本定时器的寄存器 2.例程 /** * @brief 定时器6的初始化,定时周期0.01s * @pa ...

- 深度(Depth)概念

强化对深度的理解 在老版本的NGUI中,UI的显示层次关系是依靠z轴进行的.在新版本的NGUI中,所有UI的z轴都被统一,然后用深度来决定和管理显示的层次关系.关于深度,要记住一下关键点: 1.每一个 ...

- UIAlertView带textField

UIAlertView *alert = [[UIAlertView alloc]initWithTitle:@"校验登录密码" message:@"" del ...

- <二> SQL 基础

left (outer) join 结果集包含连接表的匹配行,也包括左连接表的所有行. select a.a, a.b, a.c, b.c b.d b.f from a left out join b ...

- 简易promise

<!DOCTYPE html><html><head lang="en"> <meta charset="UTF-8" ...

- Xplico

http://zhulinu.blog.51cto.com/539189/850909

- Struts2 interceptor使用经验小结

1. interceptor 调用Spring容器中的bean 在interceptor中常有需要调用Spring Bean的需要,其实很简单和Struts2的Action一样配置即可. Spring ...

- 微信JSSDK与录音相关的坑

欢迎各位转载, 以让微信团队重视这些恼人的BUG. 请注明出处微信JSSDK与录音相关的坑 by lzl124631x 最近一直在做微信JSSDK与录音相关的功能开发, 遇到了各种奇尺大坑, 时不时冷 ...