BP神经网络测试MNIST记录

约定:

所有的初始化权值范围,如下,就是说更换激活函数的情况,没有过大的调整初始权重。

if(randomMode==1):

numpy.random.seed(seedWih)

self.wih = numpy.random.rand(self.hNodes, self.iNodes)-0.5

numpy.random.seed(seedWho)

self.who = numpy.random.rand(self.oNodes, self.hNodes)-0.5

else:

numpy.random.seed(seedWih)

self.wih = numpy.random.normal (0.0, pow(self.hNodes,-0.5), (self.hNodes, self.iNodes))

numpy.random.seed(seedWho)

self.who = numpy.random.normal (0.0, pow(self.oNodes,-0.5), (self.oNodes, self.hNodes))

证明神经网络具有学习能力的方案:

为了减少测试时间,

将MNIST_100迭代训练较多次。

然后将其作为测试数据。如果出现了过拟合状态,承认通过训练其具有学习能力。可以进行下述测试:

参数含义:

输入层节点/隐层结点/输出层节点/学习率/初始化权重的分布方案/输入层和隐层的初始化种子/输出层和隐层的初始化种子/使用的激活函数

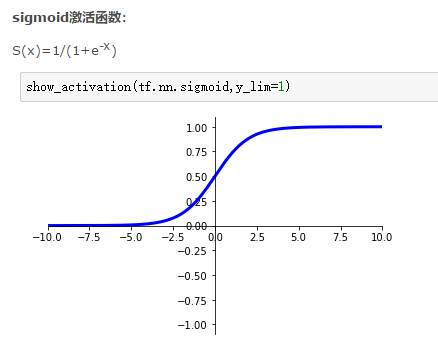

激活函数为:softmax:

训练1代,达到95.17%的测试识别率。参数为:784/100/10/0.1、rand、4、5、softmax.

训练2代,达到96.16%的测试识别率。参数为:784/100/10/0.1、rand、4、5、softmax.

训练3代,达到96.52%的测试识别率。参数为:784/100/10/0.1、rand、4、5、softmax.

训练4代,达到96.43%的测试识别率。参数为:784/100/10/0.1、rand、4、5、softmax.

训练5代,达到96.56%的测试识别率。参数为:784/100/10/0.1、rand、4、5、softmax.

训练6代,达到96.41%的测试识别率。参数为:784/100/10/0.1、rand、4、5、softmax.

调试参数如下:

inputs = numpy.asfarray( all_values [1:])/255.0*0.99+0.01

targets = numpy.zeros(self.nN.oNodes) + 0.01

targets[int (all_values[0])] = 0.99

fx1=numpy.exp(-final_inputs)/((1+numpy.exp(-final_inputs))*(1+numpy.exp(-final_inputs)))

fx2=numpy.exp(-hidden_inputs)/((1+numpy.exp(-hidden_inputs))*(1+numpy.exp(-hidden_inputs)))

self.who += self.lr * numpy.dot((output_errors * fx1),numpy.transpose(hidden_outputs))

self.wih += self.lr * numpy.dot((hidden_errors * fx2),numpy.transpose(inputs))

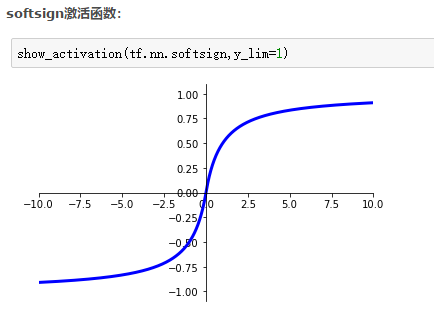

激活函数为:softsign:

一点说明:

为什么学习率取值这样

sigmoid*2-1

训练5代,达到65.58%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

训练10代,达到74.39%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

训练15代,达到76.49%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

训练20代,达到83.34%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

训练25代,达到91.8%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

训练30代,达到92.43%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

训练35代,达到92.54%的测试识别率。参数为:784/80/10/0.05、normal、4、5、softsign.

调试参数如下:

inputs = numpy.asfarray( all_values [1:])/255.0*0.5

targets = numpy.zeros(self.nN.oNodes) -0.99

targets[int (all_values[0])] = 0.99

fx1=numpy.exp(-final_inputs)/((1+numpy.exp(-final_inputs))*(1+numpy.exp(-final_inputs)))

fx2=numpy.exp(-hidden_inputs)/((1+numpy.exp(-hidden_inputs))*(1+numpy.exp(-hidden_inputs)))

self.who += self.lr * numpy.dot((output_errors * fx1),numpy.transpose(hidden_outputs))

self.wih += self.lr * numpy.dot((hidden_errors * fx2),numpy.transpose(inputs))

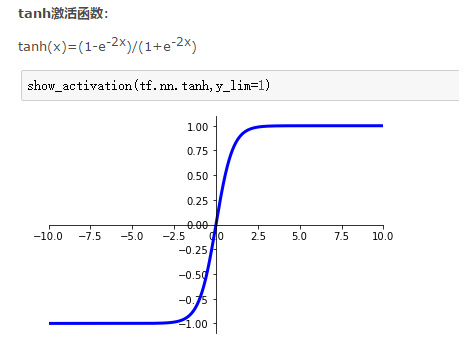

激活函数为:tanh:

训练1代,达到93.57%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

训练2代,达到94.44%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

训练3代,达到94.73%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

训练4代,达到94.47%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

训练5代,达到95.05%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

训练6代,达到95.33%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

训练7代,达到94.86%的测试识别率。参数为:784/80/10/0.05、normal、4、5、tanh.

调试参数如下:

inputs = numpy.asfarray( all_values [1:])/255.0*0.5

targets = numpy.zeros(self.nN.oNodes) -0.99

targets[int (all_values[0])] = 0.99

fx1=numpy.exp(-2*final_inputs)/((1+numpy.exp(-2*final_inputs))*(1+numpy.exp(-2*final_inputs)))

fx2=numpy.exp(-2*hidden_inputs)/((1+numpy.exp(-2*hidden_inputs))*(1+numpy.exp(-2*hidden_inputs)))

self.who += self.lr * numpy.dot((output_errors * fx1),numpy.transpose(hidden_outputs))

self.wih += self.lr * numpy.dot((hidden_errors * fx2),numpy.transpose(inputs))

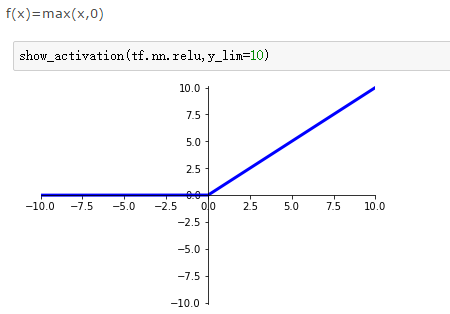

激活函数为:relu:

部分说明:

关于学习率。过大的学习率导致学习能力丢失,如0.1的学习率在这里过大。

训练1代,达到95.34%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练2代,达到96.12%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练3代,达到96.65%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练4代,达到96.8%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练5代,达到96.95%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练6代,达到97.08%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练7代,达到97.32%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

训练8代,达到97.23%的测试识别率。参数为:784/100/10/0.001、rand、4、5、relu.

调试参数如下:

inputs = numpy.asfarray( all_values [1:])/255.0*0.99+0.01

targets = numpy.zeros(self.nN.oNodes) + 0.01

targets[int (all_values[0])] = 10

final_inputs[final_inputs>0]=1

hidden_inputs[hidden_inputs>0]=1

final_inputs[final_inputs<0]=0

hidden_inputs[hidden_inputs<0]=0

fx1=final_inputs;fx2=hidden_inputs

self.who += self.lr * numpy.dot((output_errors * fx1),numpy.transpose(hidden_outputs))

self.wih += self.lr * numpy.dot((hidden_errors * fx2),numpy.transpose(inputs))

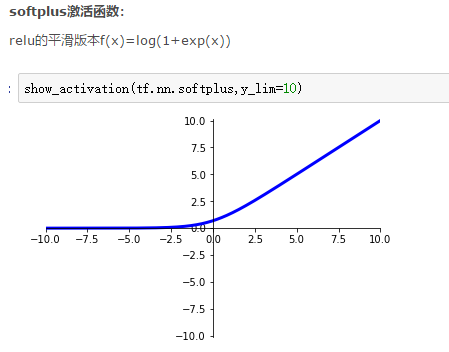

激活函数为:softplus:

训练1代,达到95.62%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练2代,达到96.47%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练3代,达到96.85%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练4代,达到97.06%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练5代,达到97.18%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练6代,达到97.29%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练7代,达到97.34%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练8代,达到97.39%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练9代,达到97.5%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练10代,达到97.54%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练11代,达到97.61%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

训练12代,达到97.6%的测试识别率。参数为:784/100/10/0.001、rand、4、5、softplus.

调试参数如下:

inputs = numpy.asfarray( all_values [1:])/255.0*0.99+0.01

targets = numpy.zeros(self.nN.oNodes) + 0.01

targets[int (all_values[0])] = 10

fx1=numpy.exp(final_inputs)/(1+numpy.exp(final_inputs))

fx2=numpy.exp(hidden_inputs)/(1+numpy.exp(hidden_inputs))

self.who += self.lr * numpy.dot((output_errors * fx1),numpy.transpose(hidden_outputs))

self.wih += self.lr * numpy.dot((hidden_errors * fx2),numpy.transpose(inputs))

BP神经网络测试MNIST记录的更多相关文章

- 机器学习入门-BP神经网络模型及梯度下降法-2017年9月5日14:58:16

BP(Back Propagation)网络是1985年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一. B ...

- bp神经网络模型推导与c语言实现(转载)

转载出处:http://www.cnblogs.com/jzhlin/archive/2012/07/28/bp.html BP 神经网络中的 BP 为 Back Propagation 的简写,最 ...

- BP神经网络模型及梯度下降法

BP(Back Propagation)网络是1985年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一. B ...

- BP神经网络模型与学习算法

一,什么是BP "BP(Back Propagation)网络是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最 ...

- BP神经网络模型及算法推导

一,什么是BP "BP(Back Propagation)网络是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最 ...

- Python实现bp神经网络识别MNIST数据集

title: "Python实现bp神经网络识别MNIST数据集" date: 2018-06-18T14:01:49+08:00 tags: [""] cat ...

- 粒子群优化算法对BP神经网络优化 Matlab实现

1.粒子群优化算法 粒子群算法(particle swarm optimization,PSO)由Kennedy和Eberhart在1995年提出,该算法模拟鸟集群飞行觅食的行为,鸟之间通过集体的协作 ...

- Matlab实现BP神经网络预测(附实例数据及代码)

BP神经网络介绍 神经网络是机器学习中一种常见的数学模型,通过构建类似于大脑神经突触联接的结构,来进行信息处理.在应用神经网络的过程中,处理信息的单元一般分为三类:输入单元.输出单元和隐含单元. 顾名 ...

- BP神经网络公式推导及实现(MNIST)

BP神经网络的基础介绍见:http://blog.csdn.net/fengbingchun/article/details/50274471,这里主要以公式推导为主. BP神经网络又称为误差反向传播 ...

随机推荐

- 将秒数转为HH:MM:SS格式的时间

/** * 将秒数转为HH:MM:SS格式的时间 * @param $seconds * @return string */ public static function GetHHMMSSB ...

- as3.0复制影片简介(自我复制的三种形式)

//mc是被复制影片简介的实例名,(===在库中找到mc影片简介,右击“属性”,点击“为actionscript导出”,选中确定即可===这个是重点) var newSprite:Sprite=mc; ...

- 1、__del__ 2、item系列 3、__hash__ 4、__eq__

1.__del__ 析构方法 释放一个空间之前之前 垃圾回收机制 2.item系列 和对象使用[ ]访问值有联系 __getitem__ __setitem__ __delit ...

- RelativeLayout 相对布局

根据父容器来定位: 想位于哪,哪个属性就设置为true 左对齐:android:layout_alighParentLeft 右对齐:android:layout_alighParentRight 顶 ...

- oracle数据库导入导出问题

场景描述: 1.做一个从UAT到PRD的Schema迁移,UAT环境有sys用户,PRD环境没有sys用户,由于权限限制,没办法使用expdp/impdp,只好选择exp/imp命令: 2.UAT和P ...

- Mobile Game Development with Unity Build Once, Deploy Anywhere

本书从自上而下的角度介绍了Unity游戏引擎的功能,并提供了具体的.面向项目的指导,说明了如何在真实的游戏场景中使用这些功能,以及如何从头开始构建让玩家爱不释手的2D和3D游戏.主要内容有:探索Uni ...

- use crunch compression

Crunch is a lossy compression format on top of DXTR texture compression. Textures will be converted ...

- java类封装成dll

@参考文章1,@参考文章2,@参考文章3 1,建立测试类,注意英文注释部分,用汉语直接编译会乱码 public class Hello { //native method is used for ca ...

- es6问答

1. 箭头函数的特点 *箭头函数this的指向是定义时所在的对象,而不是使用时所在的对象: * 箭头函数不能做构造函数 * 不能使用argument对象 *不能使用yield命令 2.let cons ...

- 亚像素Sub Pixel

亚像素Sub Pixel 评估图像处理算法时,通常会考虑是否具有亚像素精度. 亚像素概念的引出: 图像处理过程中,提高检测方法的精度一般有两种方式:一种是提高图像系统的光学放大倍数和CCD相机的分辨率 ...