在线学习和在线凸优化(online learning and online convex optimization)—凸化方法4

一些在线预测问题可以转化到在线凸优化框架中。下面介绍两种凸化技术:

一些在线预测问题似乎不适合在线凸优化框架。例如,在线分类问题中,预测域(predictions domain)或损失函数不是凸的。我们描述了两种凸化技术,它们允许我们在其他场景中使用在线凸优化框架。

1.Convexification by Randomization

为了演示randomization技术,我们考虑一个专家建议的预测问题:每个在线回合中,学习者必须从d位给定专家的建议中进行选择。

表示选到的专家,然后学习机收到一个向量

,其中

表示听从第

个专家的建议所遭受的损失,学习机需要支付的损失为

。在这种情况下,decision space是离散的,因此非凸。

有限假设类(finite hypothesis class)的在线分类问题可以很容易地作为具有专家建议问题的预测的特例。 因此,Cover’s impossibility result意味着没有算法可以通过专家建议问题获得预测的low Regret。

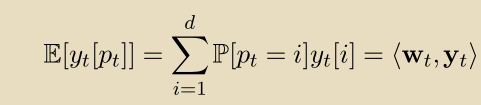

然而,正如我们在下面所示,通过允许学习者随机化他的预测,我们可以将问题转化为在线凸优化框架,因此可以获得针对该问题的low Regret算法。令是probability simplex,S是一个凸集。

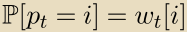

在第 t回合,学习者选择 ,并且基于

,并且基于 根据

根据 随机抽取一个专家,学习机支付期望损失:

随机抽取一个专家,学习机支付期望损失:

现在,我们将问题转化成了在线凸优化。

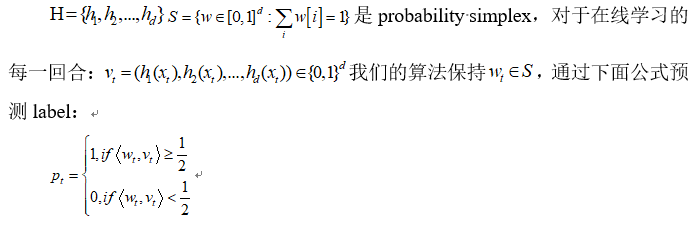

2.Convexification by Surrogate Loss Functions

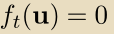

为了解释第二种凸化技术,我们再次从有限假设类的在线分类具体问题开始。 回想一下,我们用来回避 Cover’s impossibility result的技术之一依赖于可实现性假设(realizability assumption)。我们假设存在使得对于所有的t有

。有了这个假设,我们描述了Halving算法并且表明它最多

个预测错误。我们现在使用在线凸优化语言得出类似的保证:

S是一个凸集,对于所有t是一个凸函数,我们转化得到一个在线凸优化问题。

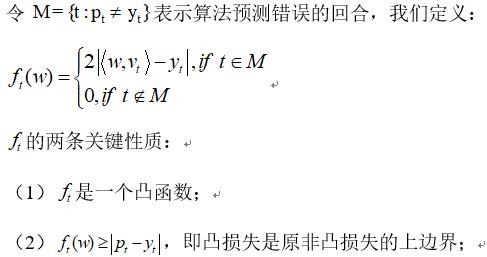

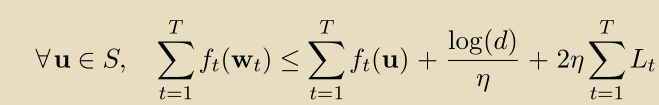

接下来的部分中,我们将推导出在线凸优化问题的算法。 特别是,这些算法之一具有如下的regret bound:

其中,是一个参数,在这里设置为1/4,

是函数

关于L1范数的Lipschitz参数。在我们的案例中,

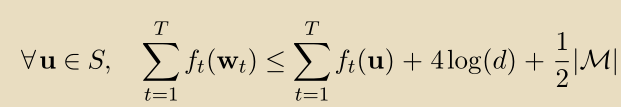

,因此:

通过的 surrogate property,我们获得:

这种类型的界限,其中错误的数量受到 competing hypothesis的convex surrogate loss的上限,通常被称为relative loss bound。

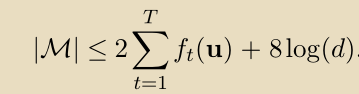

在realizable的情况下,我们可以进一步简化 relative loss bound如下。 由于bound适用于所有u∈S,因此它特别适用于向量u=(0,...,0,1,0,...,0),其中1位于对应于 true hypothesis 的位置。

通过我们的构造,对于所有t, ,产生:

,产生:

未完,待续。。。。。。

下一节分析FTL算法

在线学习和在线凸优化(online learning and online convex optimization)—凸化方法4的更多相关文章

- 在线学习和在线凸优化(online learning and online convex optimization)—FTL算法5

最自然的学习规则是使用任何在过去回合中损失最小的向量. 这与Consistent算法的精神相同,它在在线凸优化中通常被称为Follow-The-Leader,最小化累积损失. 对于任何t: 我们谈到了 ...

- 在线学习和在线凸优化(online learning and online convex optimization)—基础介绍1

开启一个在线学习和在线凸优化框架专题学习: 1.首先介绍在线学习的相关概念 在线学习是在一系列连续的回合(rounds)中进行的: 在回合,学习机(learner)被给一个question:(一个向量 ...

- 在线学习和在线凸优化(online learning and online convex optimization)—在线凸优化框架3

近年来,许多有效的在线学习算法的设计受到凸优化工具的影响. 此外,据观察,大多数先前提出的有效算法可以基于以下优雅模型联合分析: 凸集的定义: 一个向量 的Regret定义为: 如前所述,算法相对于竞 ...

- 在线学习和在线凸优化(online learning and online convex optimization)—在线分类问题2

紧接上文,我们讲述在线分类问题 令,为0-1损失,我们做出如下的简化假设: 学习者的目标是相对于hypotheses set: H具有low regret,其中H中的每个函数是从到{0,1}的映射,并 ...

- CMU Convex Optimization(凸优化)笔记1--凸集和凸函数

CMU凸优化笔记--凸集和凸函数 结束了一段时间的学习任务,于是打算做个总结.主要内容都是基于CMU的Ryan Tibshirani开设的Convex Optimization课程做的笔记.这里只摘了 ...

- Convex optimization 凸优化

zh.wikipedia.org/wiki/凸優化 以下问题都是凸优化问题,或可以通过改变变量而转化为凸优化问题:[5] 最小二乘 线性规划 线性约束的二次规划 半正定规划 Convex functi ...

- 在线学习和在线凸优化(online learning and online convex optimization)—FTRL算法6

- 在线学习--online learning

在线学习 online learning Online learning并不是一种模型,而是模型的训练方法.能够根据线上反馈数据,实时快速的进行模型调优,使得模型能够及时反映线上的变化,提高线上预测的 ...

- 各大公司广泛使用的在线学习算法FTRL详解

各大公司广泛使用的在线学习算法FTRL详解 现在做在线学习和CTR常常会用到逻辑回归( Logistic Regression),而传统的批量(batch)算法无法有效地处理超大规模的数据集和在线数据 ...

随机推荐

- 运用MQTT-JMeter插件测试MQTT服务器性能

今天我们介绍XMeter团队带来的新版MQTT-JMeter插件,您可以更为方便地添加MQTT连接.发布.订阅取样器,构造组合的应用场景,例如背景连接.多发少收.少发多收,计算消息转发时延等.利用该插 ...

- Zookeeper Ha集群简介+jdbcClient访问Ha集群环境

Hadoop-HA机制HA概述high available(高可用) 所谓HA(high available),即高可用(7*24小时不中断服务). 实现高可用最关键的策略是消除单点故障.HA严格来说 ...

- java集合与包装类

一.集合概述 1 为什么需要使用集合? 引入案例:存储每天产生的新闻. 是要解决数组的局限性(定长),由于数组定长,可能会导致内存浪费或者内存不够. 需要一种技术:能够根据数据量而动态伸缩内存空间一种 ...

- 手机浏览器User-Agent信息

ChormeMozilla/5.0 (Linux; Android 4.2.1; AMOI N828 Build/JOP40D) AppleWebKit/537.36 (KHTML, like Gec ...

- OpenWrt路由器通过LuCI界面实现Guest SSID功能

转自: http://blog.ltns.info/linux/guest_ssid_over_openwrt_router/ 之前尝试过 Tomato路由器设置VLAN实现Guest SSID功能, ...

- 使用vivado将bit文件转化为mcs文件

使用vivado将bit文件转化为mcs文件 1.在Tcl Console中运行脚本: write_cfgmem -force -format MCS -size 64 -interface spix ...

- java线程池ThreadPoolExecutor类使用详解

在<阿里巴巴java开发手册>中指出了线程资源必须通过线程池提供,不允许在应用中自行显示的创建线程,这样一方面是线程的创建更加规范,可以合理控制开辟线程的数量:另一方面线程的细节管理交给线 ...

- 移动互联网终端的touch事件判断方向

var pressX = 0, pressY = 0; document.body.addEventListener('touchmove', function(event) { // 如果这个元素的 ...

- DateGridView标题列头添加复选框

第一:添加列标题时,添加两个空格——用于显示复选框: 第二:实现列标题添加复选框,代码如下: private void AddCheckeBoxToDGVHeader(DataGridView dgv ...

- Azure REST API (4) 在Python环境下,使用Azure REST API

<Windows Azure Platform 系列文章目录> 之前遇到的项目中,客户需要在Python环境下,监控Azure VM的CPU利用率,在这里简单记录一下. 笔者的环境是Win ...