Nginx日志文件配置与切割

Nginx日志的指令主要有两条:

log_format,设置日志的格式

access_log,指定日志文件的存放路径、格式和缓存大小

两条指令在Nginx配置文件中的位置可以在http{……..}之间,也可以在虚拟主机之间,即server(…….)两个大括号之间。

log_format 语法如下:

log_format name format [format …]

name表示定义的格式名称(name名称在Nginx配置文件中是不能重复的)

format表示定义的格式样式。log_format有一个默认的、无须设置的combined日志格式设置

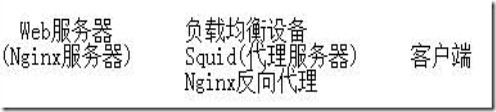

如上图:Nginx服务器不能获取到客户端的真实IP地址。

原因:由于在客户端和Web服务器之间增加了中间层(比如反向代理服务器),因此Web服务器无法直接拿到客户端的lP,通

过$remote_addr变量拿到的将是反向代理服务器的IP地址。但是,反向代理服务器在转发请求的HTTP头信息中,可以增加X-

Forwarded-For信息,用以记录原有的客户端lP地址和原来客户端请求的服务器地址。

这时候,就要用log_format指令来设置日志格式,让日志记录X-Forwarded-For信息中的lP地址,即客户的真实IP。例如,创建一个

名为mylogformat的日志格式,再用$http_x_forwarded_for变量记录用户的X-Forwarded-For lP地址:

access_log 语法如下

access_log path [format [buffer=size | off ] ]

其中path表示日志文件的存放路径,format表示使用log_format指令设置的日志格式的名称,buffer=size表示设置内存缓冲区的大小,例如可以设置buffer=32k。

(1)如果不想记录日志,可以使用以下指令关闭日志记录:

access_log off

(2)如果想使用默认的combined格式的日志记录,可以使用以下示例:

access_log /data1/logs/filename.log

或者

access_log /data1/logs/filename.log combined;

(3)如果想使用自定义格式的日志记录,可以使用以下示例,其中的mylogformat是日志格式名称:

(4)在Nginx 0.7.4之后的版本中,access_log指令中的日志文件路径可包含变量,例如:

access_log /data1/logs/$server_name.log combined;

nginx日志文件的切割

生产环境中的服务器,由于访问日志文件增长速度非常快,日志太大会严重影响服务器效率。同时,为了方便对日志进行分析计算,须要对日志文件进行定时切割。定时切割的方式有按月切割、按天切割、按小时切割等。最常用的是按天切割。

Nginx不支持像Apache 一样使用cronolog来轮转日志,但是可以采用以下方式来实现日志文件的切割:

mv /data1/logs/access.log /data1/logs/20111030.log

kill -USR1 Nginx主进程号

通过mv命令将日志文件重命名为/data1/logs/20111030.log,然后发送kill -USR1信号给Nginx的主进程号,让Nginx重新生成一个新的日志文件/data1/logs/access.log。

如果想每天定时切割日志,还须要借助crontab。我们可以写一个按天切割的日志,按年、月

份目录存放日志的shell脚本:

vi /usr/local/webserver/nginx/sbin/cut_nginx_log.sh

输入以下内容并保存:

另外,配置crontab每天凌晨00:00定时执行这个脚本:

crontab –e

输入以下内容并保存:

在很多时候,我们会非常关注网站的访问量,比如网站的日PV是多少、网站某个功能上线之后点击量是多少,像这些东西都是需要从web容器中的访问日志统计出来的,下面我们看一下如何在nginx中统计网站的访问信息

1、设置Nginx访问日志记录格式

在默认情况下,nginx只是记录相关get信息,像post页面是不记录的,所以下面需要修改nginx.conf,让其访问日志记录post等请求信息,在nginx.conf中server段中加入如下信息

log_format access '$remote_addr - $remote_user [$time_local]

"$request"' '$status $body_bytes_sent "$http_referer"'

'"$http_user_agent" $http_x_forwarded_for';

access_log /usr/local/nginx/logs/access.log access;

2、设置日志定期截取

设

置日志定期截取一是为了方便查阅,二是为了I/O拥塞(截止到目前笔者维护过的服务器中单台服务器日访问日志大小就达到1.6G,如果不定期截取,由于文

件内容较大,后期对文件进程查询、移动时将会严重影响系统性能)。nginx日志格式不像apache、resin那么人性化,nginx访问日志无法在

nginx的配置文件中设置成按日期格式存储,目前常见的设置方法主要靠第三方工具或者脚本来实现,下面我们就通过一个最简单的脚本进行实现

#vi /etc/nginx_access_log.sh

#!/bin/bash

mv /usr/local/nginx/logs/access.log /opt/nginx_access_`date +%Y%m%d`.log

killall -s USR1 nginx

脚本说明:这个脚本主要实现两个功能,一是将nginx访问日志按照日期移动到目的地,而是移动完毕后让nginx重新生成日志文件

#chmod +x /etc/nginx_access_log.sh

使用cron服务定期执行该脚本,下面设置成的是每晚23点59执行,这样nginx访问日志正好记录的是全天的访问记录

#crontab -e

59 23 * * * /etc/nginx_access_log.sh

3、日志查询

下面做一个最简单的统计,统计http://blog.luwenju.com页面的日点击量是多少

#grep -c 'http://blog.luwenju.com/' /opt/nginx_access_20110815.log

396

总结:像本篇文章所介绍的统计方法只适合访问量较小、应用相对简单的网站,像复杂应用、访问量较大的网站还需要借助第三方工具来统计,目前应用最广泛的是awstats,《Nginx日志分析(下)》将介绍如何使用awstats来分析nginx日志

http://bbs.chinaunix.net/forum.php?mod=viewthread&tid=3582157

第一步,日志的处理。

最好每天分割一下日志,一开始没注意这个工作,结果不久日志文件就上G了,很痛苦。分割日志很简单,首先把日志文件复制到别的地方,然后再通知nginx重新生成日志就可以了。shell脚本如下:

!/bin/bash

logs_path

=

"

/nginx/logs/

"

mv ${logs_path}access

.

log

${logs_path}access_$(date

-

d

"

yesterday

"

+

"

%Y%m%d

"

)

.

log

kill

-

USR1 `cat

/

nginx

/

logs

/

nginx

.

pid`

代码中的/nginx/logs指的是nginx的log日志文件所在目录,生成了以昨天日期命名的日志文件。

为了达到每天自动分割的目的,在crontab中加入以下部分:

0

*

*

*

sh

/

home

/

zyf

/

sh

/

cut_nginx_log

.

sh

这样就每天的0点1分把nginx日志重命名为日期格式,并重新生成今天的新日志文件。

=

"

/nginx/logs/access_%YYYY-0%MM-0%DD-24.log

"

这个意思是要去读取nginx昨天的日志文件,关于后边%YYYY-0%MM-0%DD-24的设置,规则如下:

#

You can also use tags in this filename if you need a dynamic file name

# depending on date or time (Replacement is made by AWStats at the beginning

# of its execution). This is available tags :

# %YYYY-n is replaced with 4 digits year we were n hours ago

# %YY-n is replaced with 2 digits year we were n hours ago

# %MM-n is replaced with 2 digits month we were n hours ago

# %MO-n is replaced with 3 letters month we were n hours ago

# %DD-n is replaced with day we were n hours ago

# %HH-n is replaced with hour we were n hours ago

# %NS-n is replaced with number of seconds at 00:00 since 1970

# %WM-n is replaced with the week number in month (1-5)

# %Wm-n is replaced with the week number in month (0-4)

# %WY-n is replaced with the week number in year (01-52)

# %Wy-n is replaced with the week number in year (00-51)

# %DW-n is replaced with the day number in week (1-7, 1=sunday)

# use n=24 if you need (1-7, 1=monday)

# %Dw-n is replaced with the day number in week (0-6, 0=sunday)

# use n=24 if you need (0-6, 0=monday)

# Use 0 for n if you need current year, month, day, hour

第三步,开始分析、生成结果。

usr

/

local

/

awstats

/

wwwroot

/

cgi

-

bin

/

awstats

.

pl

-

update

-

config

=

www

.

xxxxke

.

com

这个命令会把结果生成到/var/lib/awstats 目录下 awstatsXXXX.www.XXXX.com.txt文件。

当然啦,这样看起来不太方便哦,呵呵,可以再用下面的命令来生成html页面,相当漂亮:

perl /usr/local/awstats/tools/awstats_buildstaticpages.pl -update \

-config=www.xxxxoke.com -lang=cn \

-dir=/html/awstats \

-awstatsprog=/usr/local/awstats/wwwroot/cgi-bin/awstats.pl

这样就会在/html/awstats目录下生成很漂漂的分析结果页,很暴力很强大。

第四步,自动化。

要是每天都去服务器上运行几条命令肯定是件令人烦燥的事情,所以呢,linux的世界里有crontab这样的好东东,很简单,下面是我的crontab

0

*

*

*

sh

/

home

/

zyf

/

sh

/

cut_nginx_log

.

sh

0

1

*

*

*

/

usr

/

local

/

awstats

/

wwwroot

/

cgi

-

bin

/

awstats

.

pl

-

update

-

config

=

www

.

xxxxke

.

com

0

2

*

*

*

perl

/

usr

/

local

/

awstats

/

tools

/

awstats_buildstaticpages

.

pl

-

update

-

config

=

www

.

xxxxke

.

com

-

lang

=

cn

-

dir

=/

html

/

awstats

-

awstatsprog

=/

usr

/

local

/

awstats

/

wwwroot

/

cgi

-

bin

/

awstats

.

pl

-------------------------------------------------------------------------

大功告成,打完收功……

http://www.cnblogs.com/amboyna/archive/2009/08/09/1542171.html

Nginx日志文件配置与切割的更多相关文章

- nginx日志文件的定时切割与归纳

应用环境:生产环境中的Nginx服务器,由于访问日志文件增长速度非常快,日志太大会严重影响服务器效率.同时,为了 方便对日志进行分析计算,须要对日志文件进行定时切割.定时切割的方式有按月切割.按天切割 ...

- 虚拟主机ip配置,nginx.conf文件配置及日志文件切割

今天粗略整理了一下虚拟主机配置,nginx.conf文件的配置,及日志文件的切割,记录如下: nginx虚拟主机配置:1.IP地址配置,2.绑定ip地址和虚拟主机详情:1.ip地址的配置:ifconf ...

- 如何对Nginx日志文件进行切割保存

日积月累下,日志文件会越来越大,日志文件太大严重影响服务器效率,须要定时对日志文件进行切割. 切割的方式有按月切割.按天切割.按小时切割,一般都是按天切割. 那么如何进行切割呢? 思路: 创建日志文件 ...

- Nginx 日志文件切割

Nginx 是一个非常轻量的 Web 服务器,体积小.性能高.速度快等诸多优点.但不足的是也存在缺点,比如其产生的访问日志文件一直就是一个,不会自动地进行切割,如果访问量很大的话,将 导致日志文件容量 ...

- nginx日志文件切割

#!/bin/bash #脚本对日志文件进行切割 #脚本需要crontab 每天定时执行 #Nginx 日志文件的存放路径 logs_path="/../logs/" mkdir ...

- 转:Nginx 日志文件切割

http://www.cnblogs.com/benio/archive/2010/10/13/1849935.html 偶然发现access.log有21G大,所以将其切割. Nginx 是一个非常 ...

- nginx日志文件的配置

文章来源 运维公会: nginx日志文件的配置 1.日志介绍 nginx有两种日志,一种是访问日志,一种是错误日志. 访问日志中记录的是客户端对服务器的所有请求. 错误日志中记录的是在访问过程中,因为 ...

- nginx(四)初识nginx日志文件

nginx 日志相关指令主要有两条,一条是log_format,用来设置日志格式,另外一条是access_log,用来指定日志文件的存放路径.格式和缓存大小,通俗的理解就是先用log_format来定 ...

- 使用logrotate管理nginx日志文件

本文转载自:http://linux008.blog.51cto.com/2837805/555829 描述:linux日志文件如果不定期清理,会填满整个磁盘.这样会很危险,因此日志管理是系统管理员日 ...

随机推荐

- Hibernate自定义主键

Hibernate自定义主键,通过此方法可以解决一此特殊的主键ID,在了解自定义主键时,先了解下Hibernate有自带的10种生成主键方法. 1) assigned主键由外部程序负责生成,无需Hib ...

- pyqt 动态显示时间方法例子学习

# -*- coding: utf-8 -*- # python:2.x __author__ = 'Administrator' import sys,datetime from PyQt4.QtC ...

- [Hapi.js] Replying to Requests

hapi's reply interface is one of it's most powerful features. It's smart enough to detect and serial ...

- UIImage图片处理

#pragma mark - #pragma mark - 缩放处理 + (UIImage *)scaleImage:(UIImage *)image withScale:(float)scale { ...

- 两个iframe联动刷新 JS代码

1.iframe代码: <iframe id="famUpload" src="report.asp?syear=<%=Year(now())%>&qu ...

- C#中静态类、静态方法和静态变量的简单说明

静态方法与静态变量一样,属于类本身,而不属于哪个类的一个对象.调用一个被定义为static的方法,只有通过在它前面加上这个类的名称.一般定义里说是可以通过实例调用的.其他语言我还没测试,但是在C#中是 ...

- Asp.net文件缓存依赖

Asp.net文件缓存依赖 using System; using System.Collections.Generic; using System.Linq; using System.Web; u ...

- 常用网站--前端开发类+网页设计类+平面素材类+flash类

前端开发类 animate CSS 前端开发网 我爱CSS 大家网 W3School jQuery开发技术详解教程视频 jQuery中文社区 jQueryChina 网页设计类 禅意花园 CSS Do ...

- 在VS中如何用C++连接Mysql

在如鹏网上看到的如何用C连接Mysql,解决了大二时的一直困惑,大喜! 第一步下载 安装的数据库是如鹏网的Mysql :http://pan.baidu.com/s/1c0m3xIw 提取码:m9sn ...

- TCP的状态

在TCP层,有个FLAGS字段,这个字段有以下几个标识:SYN, FIN, ACK, PSH, RST, URG. 其中,对于我们日常的分析有用的就是前面的五个字段. 它们的含义是: SYN表示建立连 ...