Java爬取网络博客文章

前言

近期本人在某云上购买了个人域名,本想着以后购买与服务器搭建自己的个人网站,由于需要筹备的太多,暂时先搁置了,想着先借用GitHub Pages搭建一个静态的站,搭建的过程其实也曲折,主要是域名地址配置把人搞废了,不过总的来说还算顺利,网站地址 https://chenchangyuan.cn(空博客,样式还挺漂亮的,后期会添砖加瓦)

利用git+npm+hexo,再在github中进行相应配置,网上教程很多,如果有疑问欢迎评论告知。

本人以前也是搞过几年java,由于公司的岗位职责,后面渐渐地被掰弯,现在主要是做前端开发。

所以想利用java爬取文章,再将爬取的html转化成md(目前还未实现,欢迎各位同学指导)。

1.获取个人博客所有url

查看博客地址https://www.cnblogs.com/ccylovehs/default.html?page=1

根据你自己写的博客数量进行遍历

将博客的详情页地址存放在set集合中,详情页地址https://www.cnblogs.com/ccylovehs/p/9547690.html

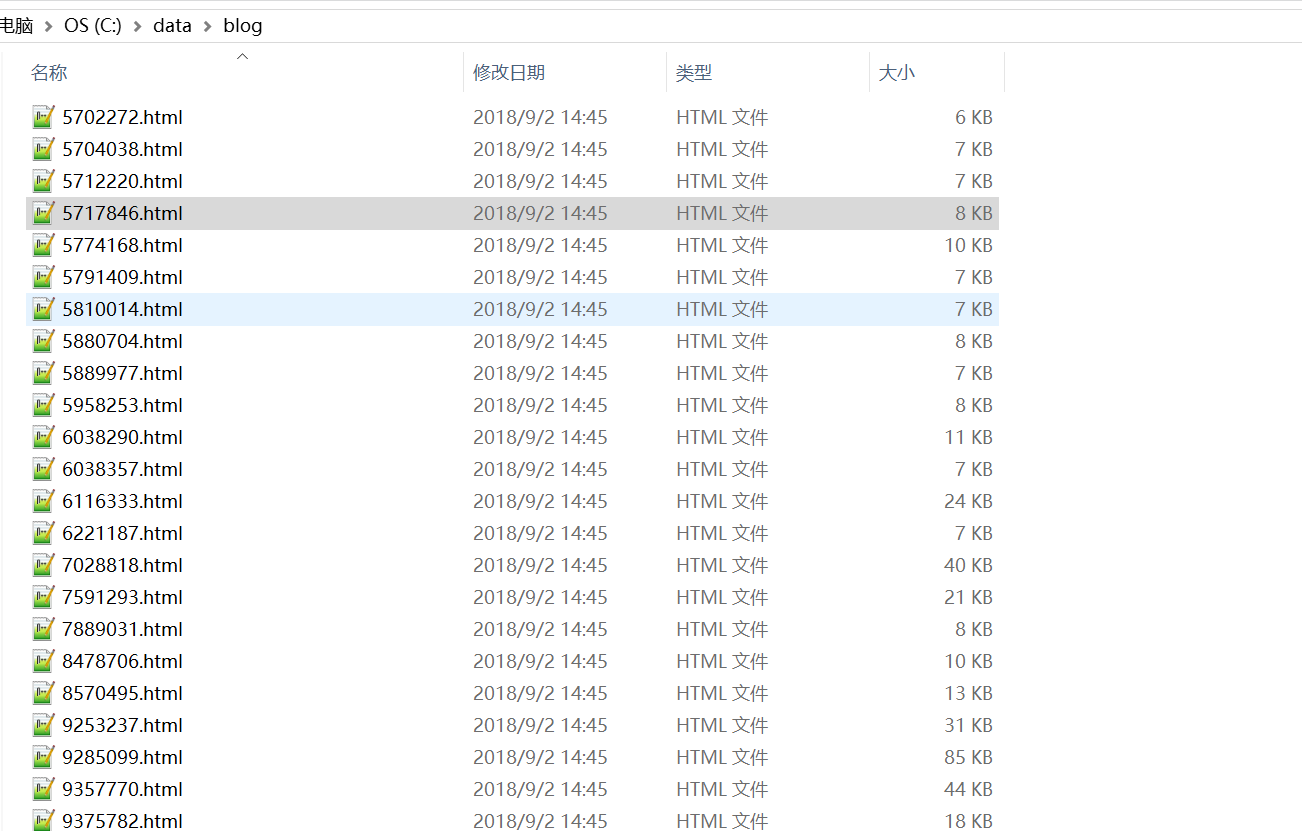

2.详情页url生成html文件

遍历set集合,依次生成html文件

文件存放在C://data//blog目录下,文件名由捕获组1生成

3.代码实现

package com.blog.util; import java.io.BufferedReader;

import java.io.File;

import java.io.InputStreamReader;

import java.io.OutputStreamWriter;

import java.io.PrintStream;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.Iterator;

import java.util.Set;

import java.util.TreeSet;

import java.util.regex.Matcher;

import java.util.regex.Pattern; /**

* @author Jack Chen

* */

public class BlogUtil { /**

* URL_PAGE:cnblogs url

* URL_PAGE_DETAIL:详情页url

* PAGE_COUNT:页数

* urlLists:所有详情页url Set集合(防止重复)

* p:匹配模式

* */

public final static String URL_PAGE = "https://www.cnblogs.com/ccylovehs/default.html?page=";

public final static String URL_PAGE_DETAIL = "https://www.cnblogs.com/ccylovehs/p/([0-9]+.html)";

public final static int PAGE_COUNT = 3;

public static Set<String> urlLists = new TreeSet<String>();

public final static Pattern p = Pattern.compile(URL_PAGE_DETAIL); public static void main(String[] args) throws Exception {

for(int i = 1;i<=PAGE_COUNT;i++) {

getUrls(i);

}

for(Iterator<String> i = urlLists.iterator();i.hasNext();) {

createFile(i.next());

}

} /**

* @param url

* @throws Exception

*/

private static void createFile(String url) throws Exception {

Matcher m = p.matcher(url);

m.find();

String fileName = m.group(1);

String prefix = "C://data//blog//";

File file = new File(prefix + fileName);

PrintStream ps = new PrintStream(file); URL u = new URL(url);

HttpURLConnection conn = (HttpURLConnection) u.openConnection();

conn.connect();

BufferedReader br = new BufferedReader(new InputStreamReader(conn.getInputStream(), "utf-8"));

String str; while((str = br.readLine()) != null){

ps.println(str);

}

ps.close();

br.close();

conn.disconnect();

} /**

* @param idx

* @throws Exception

*/

private static void getUrls(int idx) throws Exception{

URL u = new URL(URL_PAGE+""+idx);

HttpURLConnection conn = (HttpURLConnection) u.openConnection();

conn.connect();

BufferedReader br = new BufferedReader(new InputStreamReader(conn.getInputStream(), "utf-8"));

String str;

while((str = br.readLine()) != null){

if(null != str && str.contains("https://www.cnblogs.com/ccylovehs/p/")) {

Matcher m = p.matcher(str);

if(m.find()) {

System.out.println(m.group(1));

urlLists.add(m.group());

}

}

}

br.close();

conn.disconnect();

} }

4.结语

如果觉得对您有用的话,麻烦动动鼠标给我一颗star,您的鼓励是我最大的动力

https://github.com/chenchangyuan/getHtmlForJava

由于不想一篇篇的手动生成md文件,下一步需要将html文件批量的转化成md文件,以便完善个人博客内容,未完待续~~~

我的博客即将搬运同步至腾讯云+社区,邀请大家一同入驻:https://cloud.tencent.com/developer/support-plan?invite_code=2kglkq1jyzc4w

Java爬取网络博客文章的更多相关文章

- windows下使用python的scrapy爬虫框架,爬取个人博客文章内容信息

scrapy作为流行的python爬虫框架,简单易用,这里简单介绍如何使用该爬虫框架爬取个人博客信息.关于python的安装和scrapy的安装配置请读者自行查阅相关资料,或者也可以关注我后续的内容. ...

- Python爬取CSDN博客文章

0 url :http://blog.csdn.net/youyou1543724847/article/details/52818339Redis一点基础的东西目录 1.基础底层数据结构 2.win ...

- python 爬虫 爬取序列博客文章列表

python中写个爬虫真是太简单了 import urllib.request from pyquery import PyQuery as PQ # 根据URL获取内容并解码为UTF-8 def g ...

- JAVA爬虫挖取CSDN博客文章

开门见山,看看这个教程的主要任务,就去csdn博客,挖取技术文章,我以<第一行代码–安卓>的作者为例,将他在csdn发表的额博客信息都挖取出来.因为郭神是我在大学期间比较崇拜的对象之一.他 ...

- Hello Python!用 Python 写一个抓取 CSDN 博客文章的简单爬虫

网络上一提到 Python,总会有一些不知道是黑还是粉的人大喊着:Python 是世界上最好的语言.最近利用业余时间体验了下 Python 语言,并写了个爬虫爬取我 csdn 上关注的几个大神的博客, ...

- Python爬虫学习之正则表达式爬取个人博客

实例需求:运用python语言爬取http://www.eastmountyxz.com/个人博客的基本信息,包括网页标题,网页所有图片的url,网页文章的url.标题以及摘要. 实例环境:pytho ...

- Python 爬取CSDN博客频道

初次接触python,写的很简单,开发工具PyCharm,python 3.4很方便 python 部分模块安装时需要其他的附属模块之类的,可以先 pip install wheel 然后可以直接下载 ...

- scrapy爬虫框架实例一,爬取自己博客

本篇就是利用scrapy框架来抓取本人的博客,博客地址:http://www.cnblogs.com/shaosks scrapy框架是个比较简单易用基于python的爬虫框架,相关文档:http:/ ...

- Python爬虫:爬取自己博客的主页的标题,链接,和发布时间

代码 # -*- coding: utf-8 -*- """ ------------------------------------------------- File ...

随机推荐

- oracle 索引移动到不同的分区

最近系统空间不够,要进行数据库清理,truncate数据之后,发现数据不连续,导致这个表空间占用巨大,想过使用shrink.move.但是shrink得效率比较慢,选择了move.语句大概如此: SE ...

- PageHelper分页+前台BootStrap_pagination样式/BootStrap_table样式

一.PagerHelper分页+前台BootStrap_pagination样式: 效果: 1.引入pageHelper插件:2种方式 pageHelper所需jar包:pagehelper-5 ...

- ExtJS中获取选中行的数据

listeners: { select:function(rowModel,record){ var data = rowModel.getLastSelected(); console.log(&q ...

- mongodb聚合操作

1. mongodb的聚合是什么 聚合(aggregate)是基于数据处理的聚合管道,每个文档通过一个由多个阶段(stage)组成的管道,可以对每个阶段的管道进行分组.过滤等功能,然后经过一系列的处理 ...

- log4j日志的使用

1.引架包和导配置文件log4j.properties <dependency> <groupId>org.slf4j</groupId> <artifact ...

- Java基础之Java常用类--Object类,字符串相关类,包装类,日期相关类,数字相关类

Java是一种面向对象的语言,也就是将万事万物可以描述为对象,特点如下: 1.面向对象是常见的一种思考习惯,符合人们的思考习惯.2.面向对象的出现,将复杂的事情简单化.3.面向对象的出现,将之前过程中 ...

- Exception in thread "main" java.lang.UnsupportedClassVersionError: org/apache/ma ven/cli/Maven

此异常是由于jdk版本和maven版本不一致导致的 在maven官网上的说明是这样的:Maven 3.3+ require JDK 1.7 or above to execute - they sti ...

- navibar记录

@import (reference) "kmc-common.less"; .kmc{ font-family: PingFangSC-Reguxlar; font-weight ...

- CTF中文件包含的一些技巧

i春秋作家:lem0n 原文来自:浅谈内存取证 0x00 前言 网络攻击内存化和网络犯罪隐遁化,使部分关键数字证据只存在于物理内存或暂存于页面交换文件中,这使得传统的基于文件系统的计算机取证不能有效应 ...

- 面试官问我,Redis分布式锁如何续期?懵了。

前言 上一篇[面试官问我,使用Dubbo有没有遇到一些坑?我笑了.]之后,又有一位粉丝和我说在面试过程中被虐了.鉴于这位粉丝是之前肥朝的粉丝,而且周一又要开启新一轮的面试,为了回馈他长期以来的支持,所 ...