课程回顾-Neural Network & Deep Learning

数据

计算

算法发展

Logistics Regression

Numpy

reshape的计算代价很小,所以你不确定数据维度的时候都可以放上

一些解决潜在bug的trick

做了归一化之后梯度下降更易收敛

激活函数

对于权值要做随机初始化

为什么要深层网络

Reference

为什么深度学习发展了

数据

- 对于小量数据来说,神经网络表现比线性回归、SVM

- 对于大量数据来说神经网络比SVM好

- 对于大量数据来说,大的网络比小的网络好

- 由于电脑的大量使用数据越来越多

计算

- GPUs.

- Powerful CPUS.

- Distributed computing.

- ASICs

算法发展

Relu等新的技巧提出

Logistics Regression

y=sigmoid(wTx)" role="presentation" style="font-size: 100%; display: inline-block; position: relative;">y=sigmoid(wTx)

Numpy

reshape的计算代价很小,所以你不确定数据维度的时候都可以放上

一些解决潜在bug的trick

- 如果不设置向量的维度,那么默认值会是(m,),并且转置操作不会使用,你必须将其reshape成(m,1)。尽量不要使用rank=1的矩阵

- 计算前尝试检验维度,如

assert(a.shape == (5,1))

- 如果发现了rank=1的矩阵,做reshape

做了归一化之后梯度下降更易收敛

激活函数

- tanh在隐层使用会比较好(mean=0)

- sigmoid和tanh会存在问题,因为当值极小或极大会造成梯度接近零

- relu更加常用

- 选择激活函数的准则:如果你的分类结果是0和1,用sigmoid,否则用relu

对于权值要做随机初始化

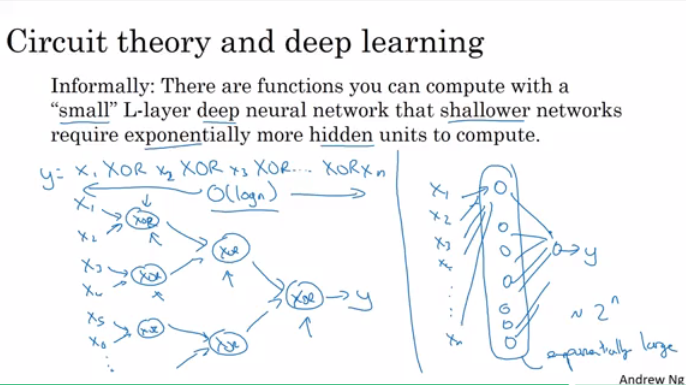

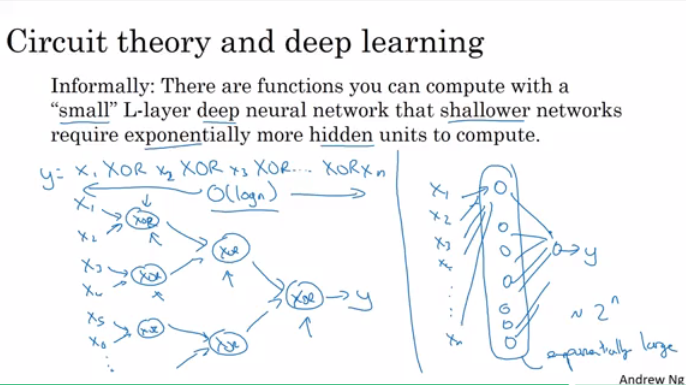

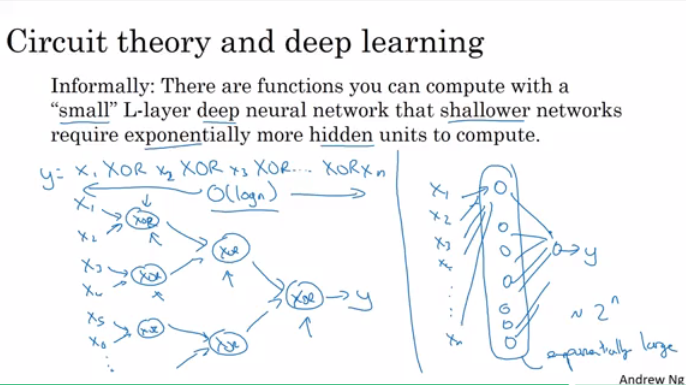

为什么要深层网络

- 一层层分析,类似人脑

- 几层的深度网络完成的功能,需要指数个数的隐藏单元来完成。

http://blog.csdn.net/column/details/17767.html

Reference

assert(a.shape == (5,1))- tanh在隐层使用会比较好(mean=0)

- sigmoid和tanh会存在问题,因为当值极小或极大会造成梯度接近零

- relu更加常用

- 选择激活函数的准则:如果你的分类结果是0和1,用sigmoid,否则用relu

对于权值要做随机初始化

为什么要深层网络

- 一层层分析,类似人脑

- 几层的深度网络完成的功能,需要指数个数的隐藏单元来完成。

http://blog.csdn.net/column/details/17767.html

Reference

- 一层层分析,类似人脑

- 几层的深度网络完成的功能,需要指数个数的隐藏单元来完成。

http://blog.csdn.net/column/details/17767.html

Reference

https://github.com/mbadry1/DeepLearning.ai-Summary

课程回顾-Neural Network & Deep Learning的更多相关文章

- (Deep) Neural Networks (Deep Learning) , NLP and Text Mining

(Deep) Neural Networks (Deep Learning) , NLP and Text Mining 最近翻了一下关于Deep Learning 或者 普通的Neural Netw ...

- 【深度学习Deep Learning】资料大全

最近在学深度学习相关的东西,在网上搜集到了一些不错的资料,现在汇总一下: Free Online Books by Yoshua Bengio, Ian Goodfellow and Aaron C ...

- 机器学习(Machine Learning)&深度学习(Deep Learning)资料(Chapter 2)

##机器学习(Machine Learning)&深度学习(Deep Learning)资料(Chapter 2)---#####注:机器学习资料[篇目一](https://github.co ...

- Deep Learning 和 Knowledge Graph howto

领军大家: Geoffrey E. Hinton http://www.cs.toronto.edu/~hinton/ 阅读列表: reading lists and survey papers fo ...

- Deep Learning in R

Introduction Deep learning is a recent trend in machine learning that models highly non-linear repre ...

- Deep Learning Enables You to Hide Screen when Your Boss is Approaching

https://github.com/Hironsan/BossSensor/ 背景介绍 学生时代,老师站在窗外的阴影挥之不去.大家在玩手机,看漫画,看小说的时候,总是会找同桌帮忙看着班主任有没有来. ...

- Deep learning:三十四(用NN实现数据的降维)

数据降维的重要性就不必说了,而用NN(神经网络)来对数据进行大量的降维是从2006开始的,这起源于2006年science上的一篇文章:reducing the dimensionality of d ...

- Deep Learning for Robotics 资源汇总

1 前言 在最新Nature的Machine Intelligence 中Lecun.Hinton和Bengio三位大牛的Review文章Deep Learning中.最后谈The Future Of ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第二周:(Basics of Neural Network programming)-课程笔记

第二周:神经网络的编程基础 (Basics of Neural Network programming) 2.1.二分类(Binary Classification) 二分类问题的目标就是习得一个分类 ...

随机推荐

- Qt自定义滚动条(不使用样式表)

前面使用Qt 样式表实现滚动条,在实际工作中,发现存在一些瑕疵,例如如果在主窗口中绘制背景,则有可能给滚动条染色,还有如果想实现特殊的效果,则必须使用自定义风格,即从QStyle的子类派生出新的类型. ...

- Chapter4_控制执行流程

总结java中所有的与流程控制有关的知识 (1)表达式判断 Java中只允许true或者false来作为判断条件,不允许用0或者非0值作为判断条件. (2)if-else 与流程密切相关的语句,决定了 ...

- hashtable and hashmap

hashmap的bucket 和 ‘负载因子’的介绍 https://blog.csdn.net/wenyiqingnianiii/article/details/52204136

- -1.记libgdx初次接触

学习一门技术最难的是开发环境变量配置和工具配置,以下为我初次接触libgdx时遇到的问题 几个难点记录下 gradle 直接用下到本地,然后放到d盘,链接到就行(gradle-wrapper.prop ...

- 强联通分量-tarjan算法

定义:在一张有向图中,两个点可以相互到达,则称这两个点强连通:一张有向图上任意两个点可以相互到达,则称这张图为强连通图:非强连通图有极大的强连通子图,成为强联通分量. 如图,{1},{6}分别是一个强 ...

- python0301

1 .pycharm的使用 2.格式化输出 # name = input('请输入姓名')# age = input('请输入年龄')# hobby = input('请输入爱好')# msg = ' ...

- Windows和Office激活汇总

Windows和Office是常用的软件.多数情况下,即使不激活,也会使用一部分功能.今天来看一下很多前辈的工作成果. 1. Windows 7&10 1.1 永久激活 通过key 分享几个常 ...

- 初探ansible

Ansible 基于ssh的自动化运维工具 ansible 配置文件详解 ansible.cfg 文件 文件默认放置在/etc/ansible下,ansible读取配置文件的顺序是: 当前命令执行目录 ...

- vim快捷键速查

一.移动 h/j/k/l 左/下/上/右 W w 移动到下一个单词开头 E e 移动到下一个单词结尾 B b ...

- JS 控制输入框输入表情emoji 显示在页面上

问题描述: 最近做一个评论回复的功能遇到了用户输入框输入表情,存入数据库的时候转变成了问号??? 起初为了避免这个问题,做了一个过滤表情的控制 var inputText = $('#pinglun' ...