强化学习模型实现RL-Adventure

源代码:https://github.com/higgsfield/RL-Adventure

在Pytorch1.4.0上解决bug后的复现版本:https://github.com/lucifer2859/DQN

DQN Adventure: from Zero to State of the Art

This is easy-to-follow step-by-step Deep Q Learning tutorial with clean readable code.

The deep reinforcement learning community has made several independent improvements to the DQN algorithm. This tutorial presents latest extensions to the DQN algorithm in the following order:

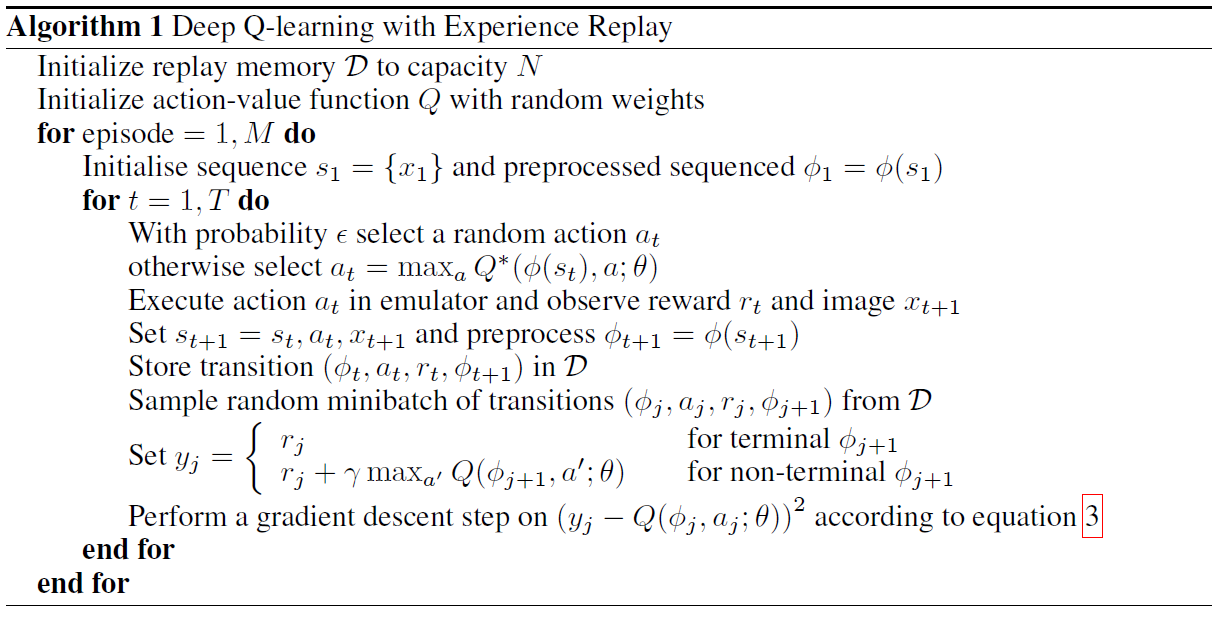

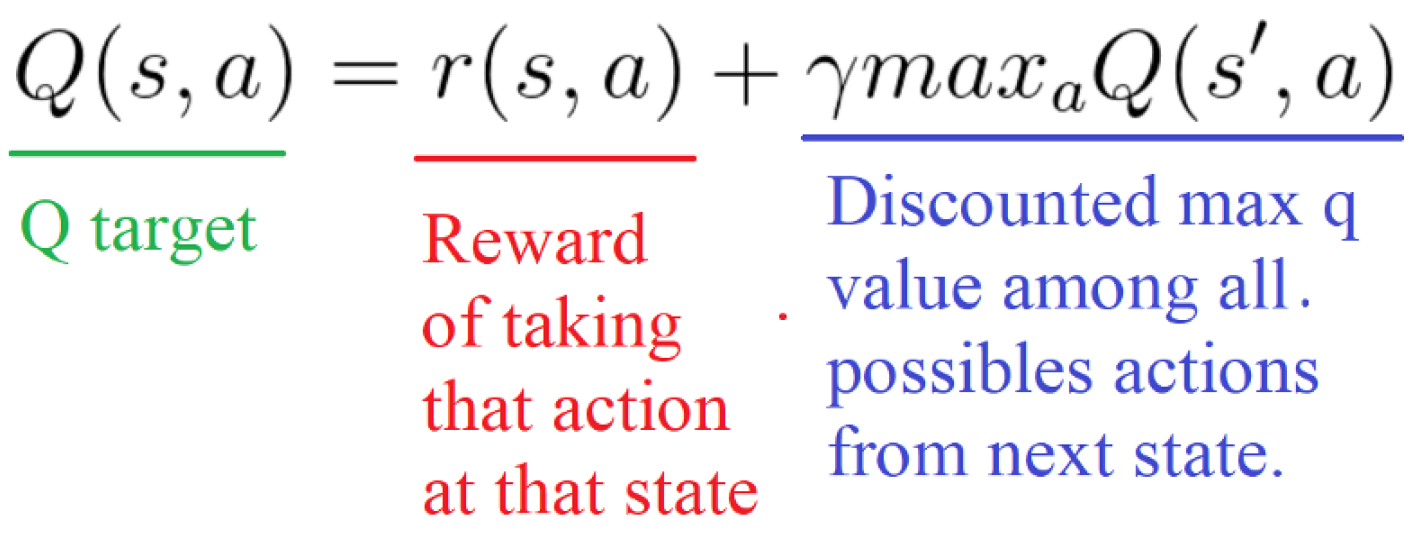

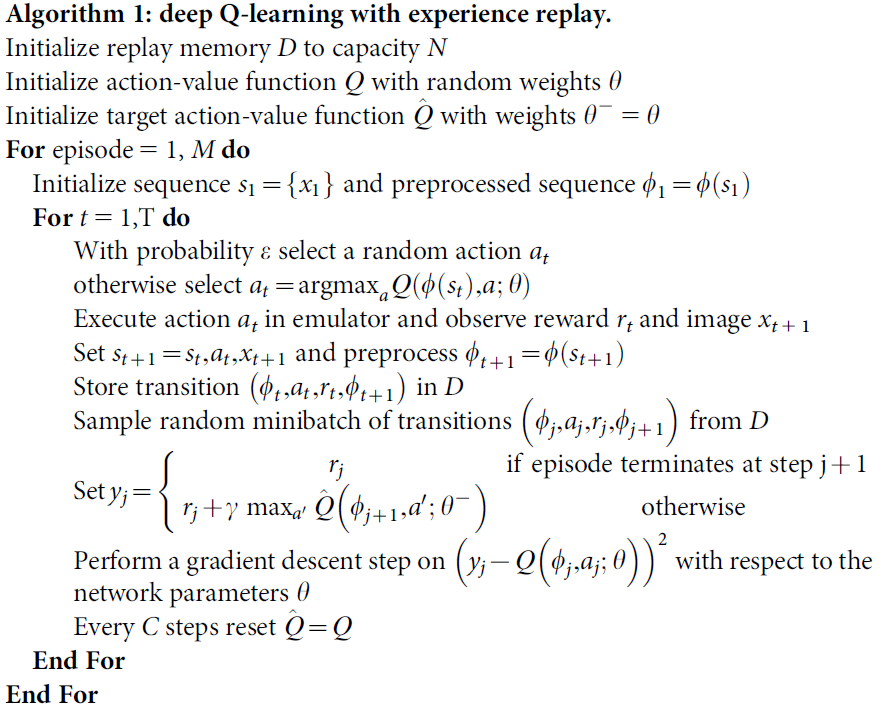

1. Playing Atari with Deep Reinforcement Learning(DQN with experience replay)

[[arxiv]](https://www.cs.toronto.edu/~vmnih/docs/dqn.pdf) CoRR 2013

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/1.dqn.ipynb)

本文提出了基于经验回放的DQN,标志着DQN的诞生,也标志着深度强化学习的诞生。

经验回放(experience replay):将经验(即历史的状态、动作、奖励等)存储起来,再在存储的经验中按一定的规则采样。

经验回放主要有"存储"和"采样回放"两大关键步骤。

- 存储:将轨迹以(St,At,Rt+1,St+1)等形式存储起来;

- 采样回放:使用某种规则从存储的(St,At,Rt+1,St+1)中随机取出一条或多条经验。

经验回放有以下好处。

- 在训练Q网络时,可以消除数据的关联,使得数据更像是独立同分布的(独立同分布是很多有监督学习的证明条件)。这样可以减小参数更新的方差,加快收敛。

- 能够重复使用经验,对于数据获取困难的情况尤其有用。

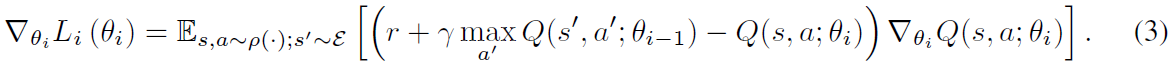

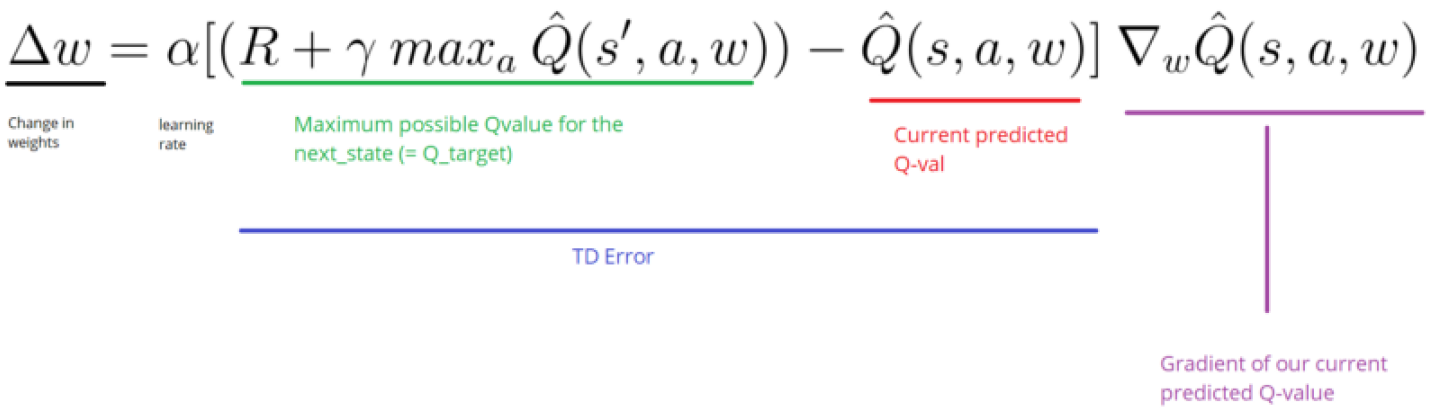

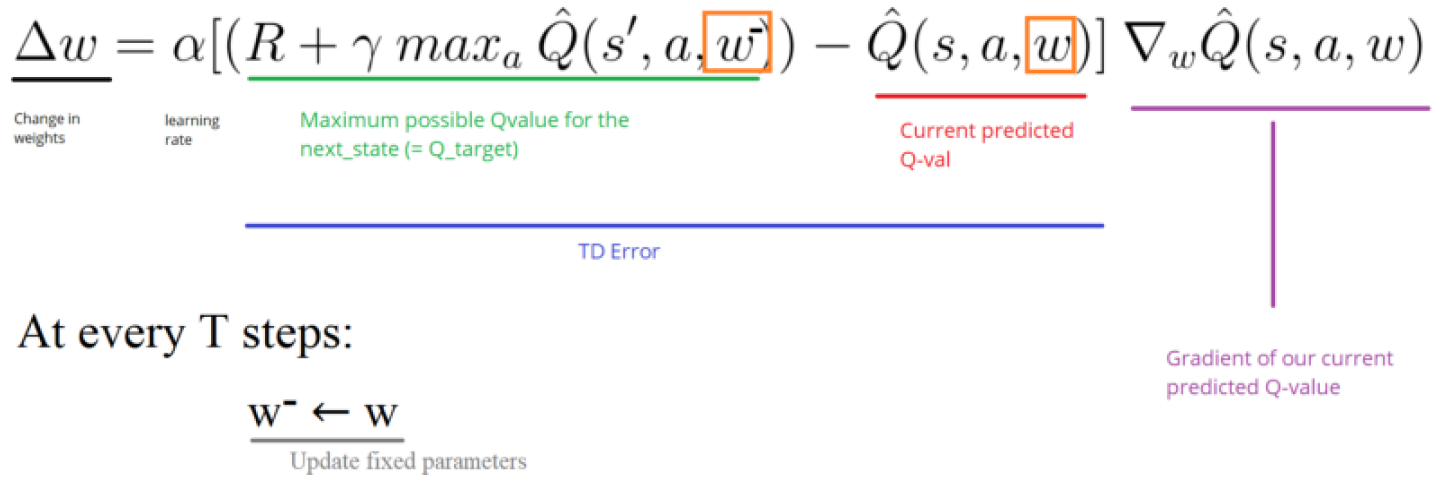

2. Human-level control through deep reinforcement learning(DQN with target network)

[[arxiv]](https://www.nature.com/articles/nature14236) Nature 2015

[[code]](https://github.com/devsisters/DQN-tensorflow)

本文提出了目标网络(target network)这一概念,目标网络是在原有的神经网络之外再搭建一份结构完全相同的网络。原先就有的神经网络称为评估网络(evaluation network)。在学习的过程中,使用目标网络来进行自益得到回报的评估值,作为学习的目标。在权重更新的过程中,只更新评估网络的权重,而不更新目标网络的权重。这样,更新权重时针对的目标就不会再每次迭代都变化,是一个固定的目标。在完成一定次数的更新后,再将评估网络的权重值赋给目标网络,进而进行下一批更新。这样,目标网络也能得到更新。由于在目标网络没有变化的一段时间内回报的估计是相对固定的。目标网络的引入增加了学习的稳定性。所以,目标网络目前已经成为深度Q学习的主流做法。

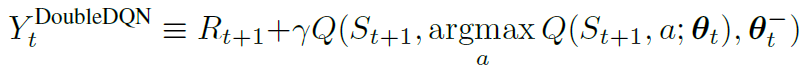

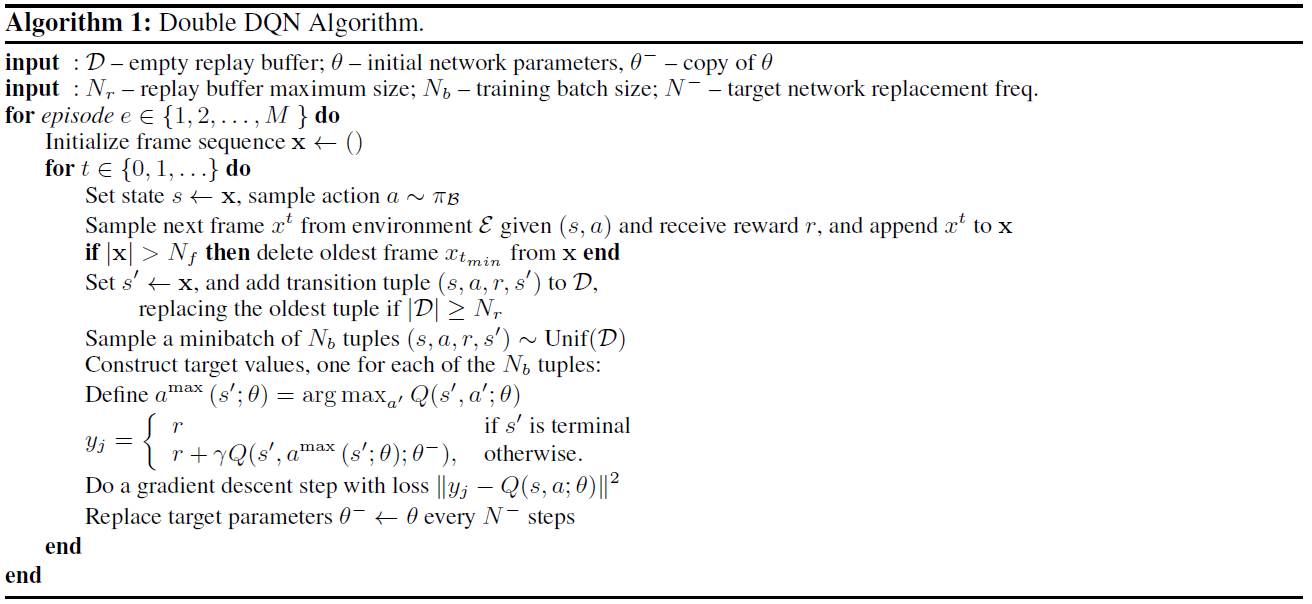

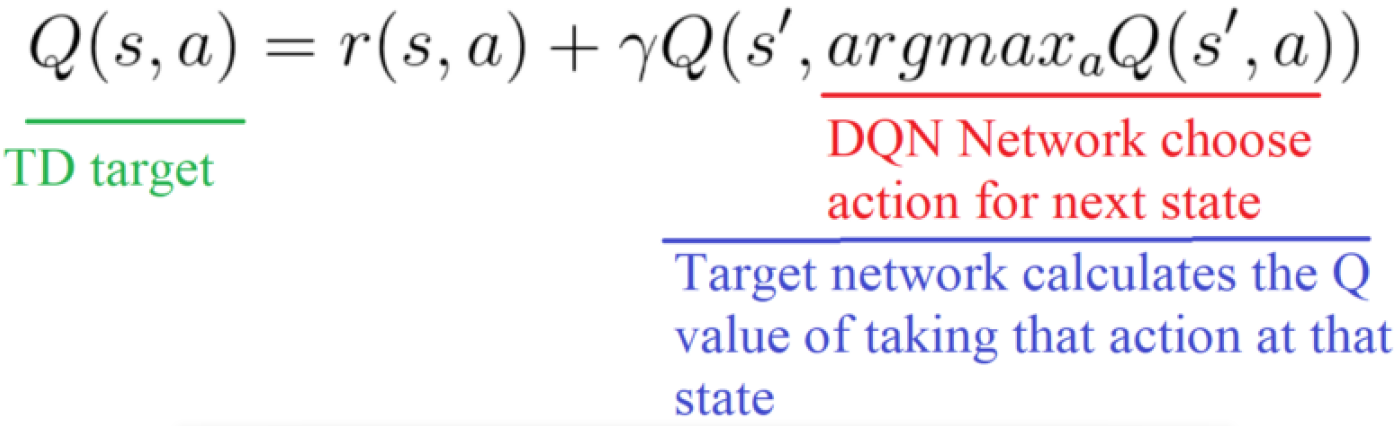

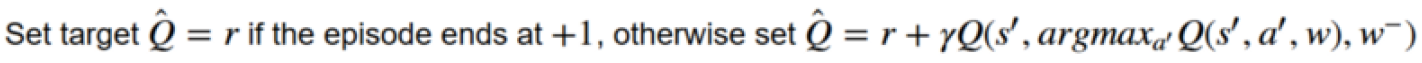

3. Deep Reinforcement Learning with Double Q-learning(Double DQN)

[[arxiv]](https://arxiv.org/abs/1509.06461) AAAI 2016

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/2.double%20dqn.ipynb)

双重Q学习可以消除最大化偏差(maximization bias)。

本文将双重Q学习用于DQN,得到双重DQN(Double DQN,DDQN)。考虑到DQN已经有了评估网络和目标网络两个网络,所以双重DQN在估计回报时只需要用评估网络确定动作,用目标网络确定回报的估计即可。

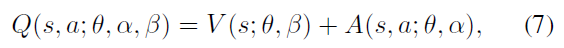

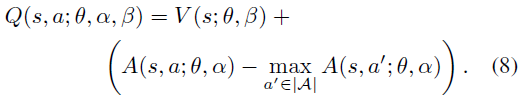

4. Dueling Network Architectures for Deep Reinforcement Learning(Dueling DQN)

[[arxiv]](https://arxiv.org/abs/1511.06581) ICML 2016

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/3.dueling%20dqn.ipynb)

本文提出了一种神经网络结构——对偶网络(dual network)。

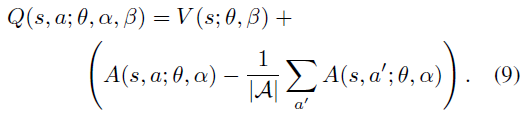

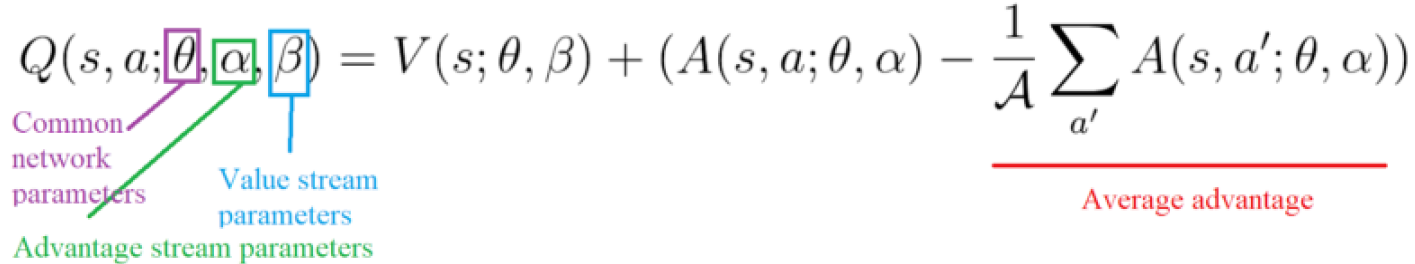

对偶网络理论利用动作价值函数和状态价值函数之差定义了一个新的函数——优势函数A(advantage function):

由于同一个Q函数事实上存在着无穷多种分解为V函数和A函数的方式。为了不给训练带来不必要的麻烦,往往可以通过增加一个由优势函数导出的量,使得等效的优势函数满足固定的特征,使得分解唯一。常见的方法有以下两种:

- 考虑优势函数的最大值,令

- 考虑优势函数的平均值,令

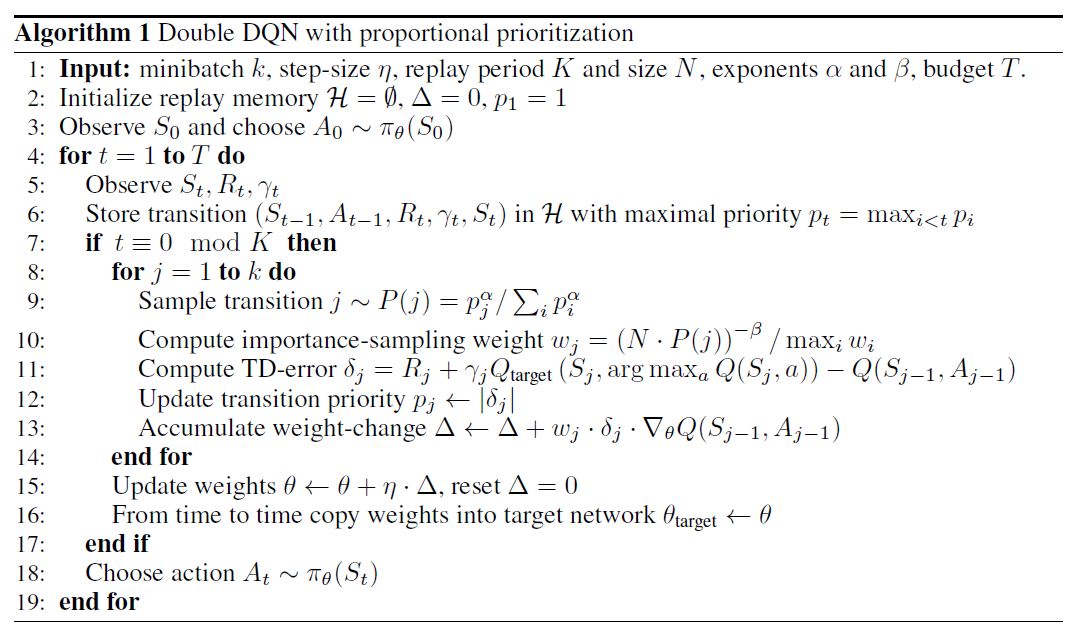

5. Prioritized Experience Replay(PER,Prioritized DQN)

[[arxiv]](https://arxiv.org/abs/1511.05952) ICLR 2016

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/4.prioritized%20dqn.ipynb)

本文提出了优先回放。优先回放的思想是为经验池里的经验指定一个优先级,在选取经验时更倾向于选择优先级高的经验。

6. Noisy Networks for Exploration(Noisy DQN)

[[arxiv]](https://arxiv.org/abs/1706.10295) ICLR 2018

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/5.noisy%20dqn.ipynb)

[[blog]](https://zhuanlan.zhihu.com/p/138504673)

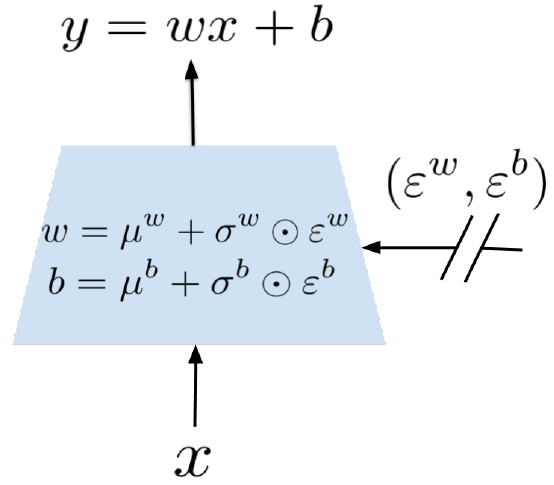

本文提出了一种将参数化的噪音加入到神经网络权重上去的方法来增加强化学习中的探索,称为NoisyNet。

用于探索的NoisyNet可以替代原本的ε-贪婪策略(DQN -> NoisyNet-DQN)。

Noisy Linear Layer:

The NoisyNet-DQN Loss:

The NoisyNet-Dueling Loss:

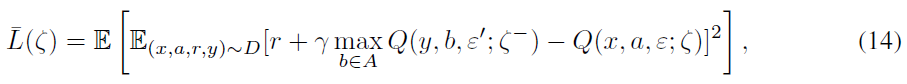

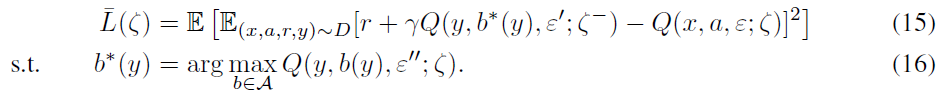

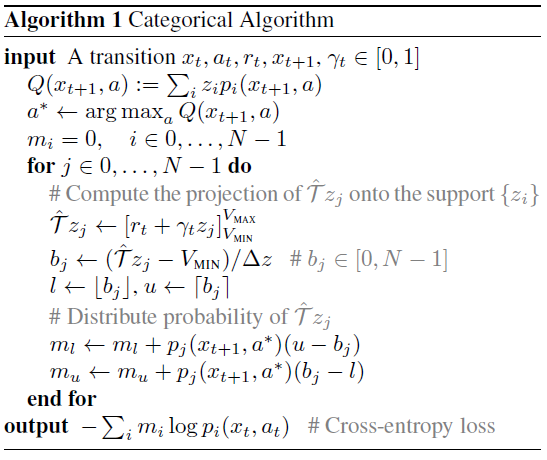

7. A Distributional Perspective on Reinforcement Learning(C51)

[[arxiv]](https://arxiv.org/pdf/1707.06887.pdf) ICML 2017

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/6.categorical%20dqn.ipynb)

[[blog]](https://www.cnblogs.com/lucifer1997/p/13278861.html)

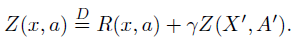

本文主张采用分布观点来进行强化学习,研究的主要对象是期望价值为Q的随机回报Z。此随机回报也由递归方程描述,但具有分布性质:

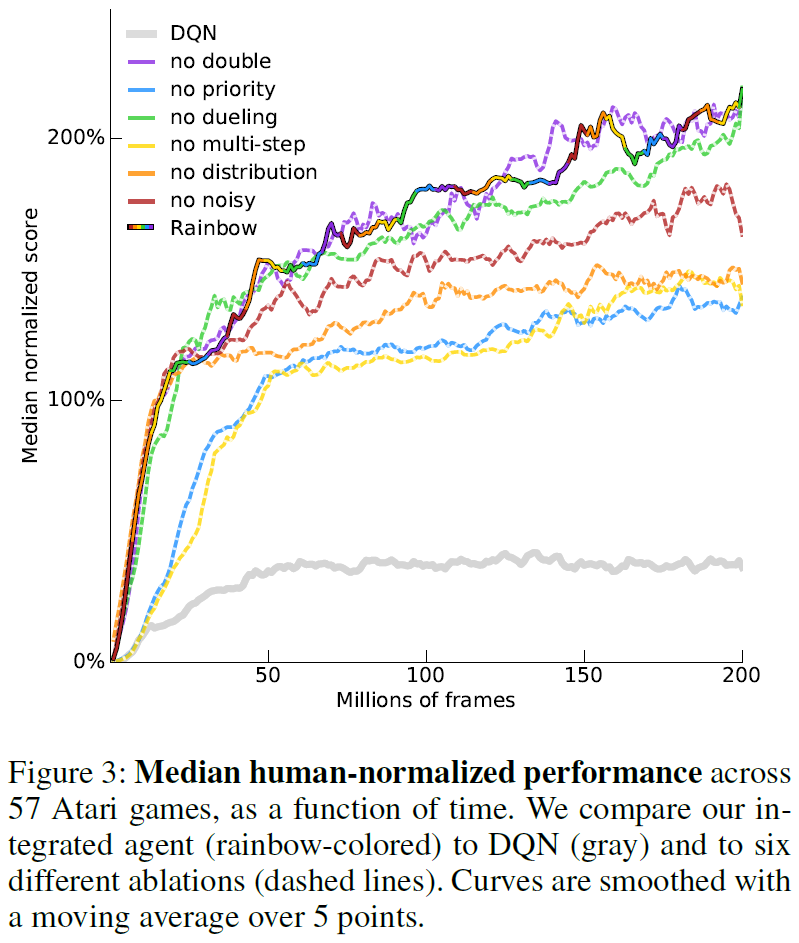

8. Rainbow: Combining Improvements in Deep Reinforcement Learning

[[arxiv]](https://arxiv.org/abs/1710.02298) AAAI 2018

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/7.rainbow%20dqn.ipynb)

源代码缺乏关键的多步回报以及优先重播的实现。

[[code]](https://github.com/Kaixhin/Rainbow)

9. Dopamine: A Research Framework for Deep Reinforcement Learning

[[arxiv]](https://arxiv.org/abs/1812.06110)

[[code]](https://github.com/google/dopamine)

Dopamine Rainbow智能体(Castro et al., 2018),是对原始Rainbow智能体的开源实现(Hessel et al., 2018),但是做出了一些简化的设计选择。原始智能体通过使用(a) 分布学习目标,(b) 多步回报,(c) Adam优化器,(d) 优先回放,(e) 双重Q学习,(f) 对偶结构,以及(g) 带噪的探索网络。Dopamine Rainbow智能体仅使用这些调整的前四个,在Hessel et al. (2018)的原始分析中被确定为该智能体最重要的方面。

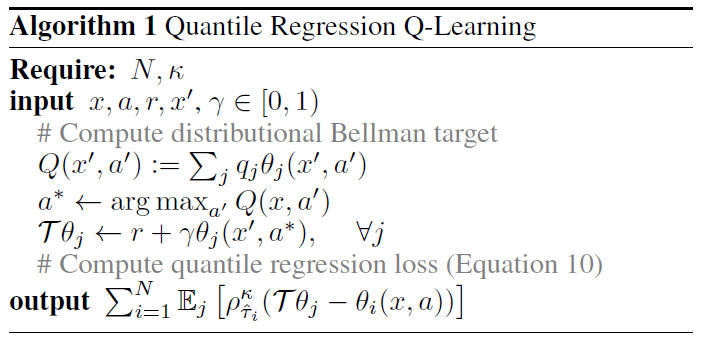

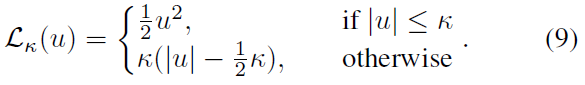

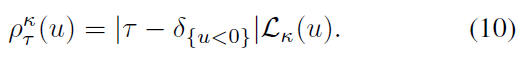

10. Distributional Reinforcement Learning with Quantile Regression(QR-DQN)

[[arxiv]](https://arxiv.org/pdf/1710.10044.pdf) AAAI 2018

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/8.quantile%20regression%20dqn.ipynb)

[[blog]](https://www.cnblogs.com/lucifer1997/p/13278817.html)

首先,本文将现有结果扩展到近似分布设置。其次,本文提出了一种与理论公式相一致的新颖的分布强化学习算法。

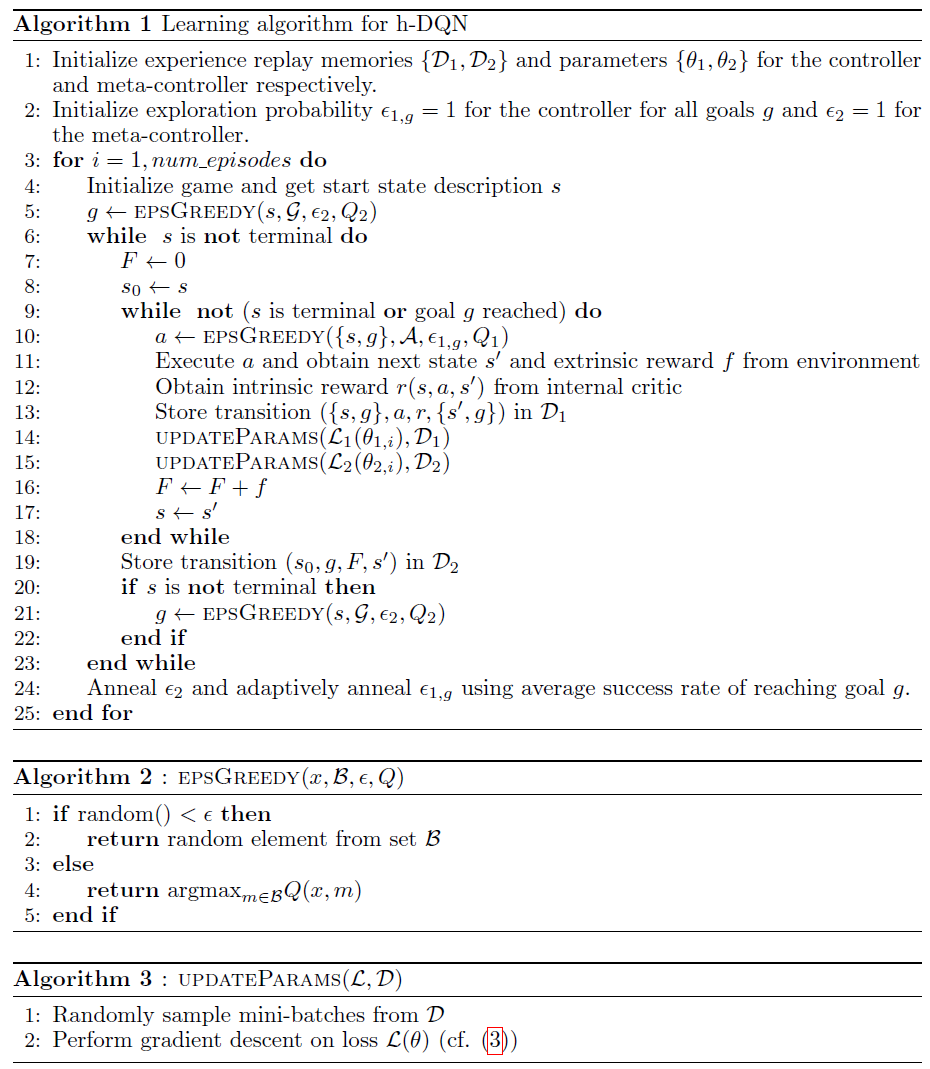

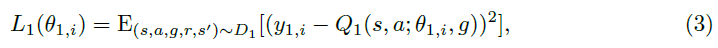

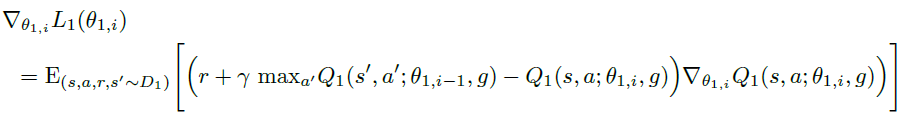

11. Hierarchical Deep Reinforcement Learning: Integrating Temporal Abstraction and Intrinsic Motivation

[[arxiv]](https://arxiv.org/abs/1604.06057) NIPS 2016

[[code]](https://github.com/higgsfield/RL-Adventure/blob/master/9.hierarchical%20dqn.ipynb)

12. Neural Episodic Control

[[arxiv]](https://arxiv.org/pdf/1703.01988.pdf) ICML 2017

[[code]](#)

强化学习模型实现RL-Adventure的更多相关文章

- 论文:利用深度强化学习模型定位新物体(VISUAL SEMANTIC NAVIGATION USING SCENE PRIORS)

这是一篇被ICLR 2019 接收的论文.论文讨论了如何利用场景先验知识 (scene priors)来定位一个新场景(novel scene)中未曾见过的物体(unseen objects).举例来 ...

- 基于TORCS和Torch7实现端到端连续动作自动驾驶深度强化学习模型(A3C)的训练

基于TORCS(C++)和Torch7(lua)实现自动驾驶端到端深度强化学习模型(A3C-连续动作)的训练 先占坑,后续内容有空慢慢往里填 训练系统框架 先占坑,后续内容有空慢慢往里填 训练系统核心 ...

- 强化学习之五:基于模型的强化学习(Model-based RL)

本文是对Arthur Juliani在Medium平台发布的强化学习系列教程的个人中文翻译,该翻译是基于个人分享知识的目的进行的,欢迎交流!(This article is my personal t ...

- 强化学习(十七) 基于模型的强化学习与Dyna算法框架

在前面我们讨论了基于价值的强化学习(Value Based RL)和基于策略的强化学习模型(Policy Based RL),本篇我们讨论最后一种强化学习流派,基于模型的强化学习(Model Base ...

- 深度学习-强化学习(RL)概述笔记

强化学习(Reinforcement Learning)简介 强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益.其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予 ...

- 强化学习 3—— 使用蒙特卡洛采样法(MC)解决无模型预测与控制问题

一.问题引入 回顾上篇强化学习 2 -- 用动态规划求解 MDP我们使用策略迭代和价值迭代来求解MDP问题 1.策略迭代过程: 1.评估价值 (Evaluate) \[v_{i}(s) = \sum_ ...

- 【整理】强化学习与MDP

[入门,来自wiki] 强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益.其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予的奖励或惩罚的刺激下,逐步形成对刺激的 ...

- (转) 深度强化学习综述:从AlphaGo背后的力量到学习资源分享(附论文)

本文转自:http://mp.weixin.qq.com/s/aAHbybdbs_GtY8OyU6h5WA 专题 | 深度强化学习综述:从AlphaGo背后的力量到学习资源分享(附论文) 原创 201 ...

- 强化学习论文(Scalable agent alignment via reward modeling: a research direction)

原文地址: https://arxiv.org/pdf/1811.07871.pdf ======================================================== ...

随机推荐

- sql数据管理语句

一.数据管理 1.增加数据 INSERT INTO student VALUES(1,'张三','男',20); -- 插入所有字段.一定依次按顺序插入 -- 注意不能少或多字段值 如只需要插入部分字 ...

- gerrit安装指南

Gerrit的基本介绍 Gerrit 是一个Git服务器,它基于 git 版本控制系统,使用网页界面来进行审阅工作.Gerrit 旨在提供一个轻量级框架,用于在代码入库之前对每个提交进行审阅,更改将上 ...

- Maven——软件开发中一个神奇的项目管理工具

由于本人是从c++转入从事JAVA工作的 所以很多东西要从头学起,相信有很多跟我一样的人吧,那么我们一起来学习. 今天我们一起来认识下Maven这个工具,很多人可能会问题了,为什么说是工具呢?不是写代 ...

- 读/写docx文件

安装 pip install python-docx 1.建立新Word文档 建立新文档需要调用Document对象的save方法,一个Document对象代表一个Word文档,该方法的参数是保存的文 ...

- MySQL选错索引导致的线上慢查询事故

前言 又和大家见面了!又两周过去了,我的云笔记里又多了几篇写了一半的文章草稿.有的是因为质量没有达到预期还准备再加点内容,有的则完全是一个灵感而已,内容完全木有.羡慕很多大佬们,一周能产出五六篇文章, ...

- html实现a元素href的URL链接自动刷新或新窗口打开

有时我们想实现这样一个功能,点击一个链接,如果这个链接浏览器已经打开过,则刷新已经打开的链接窗口:如果这个链接没有打开过,则使用新窗口打开这个链接页面. 这是一个非常好的体验增强功能,可以有效避免浏览 ...

- 5.19 省选模拟赛 小B的夏令营 概率 dp 前缀和优化dp

LINK:小B的夏令营 这道题是以前从没见过的优化dp的方法 不过也在情理之中. 注意读题 千万不要像我这个sb一样 考完连题意都不知道是啥. 一个长方形 要求从上到下联通的概率. 容易发现 K天只是 ...

- springboot集成mongo

大家可以关注我的微信公众号“秦川以北” 后续更多精彩实用内容分享 在项目中配置,mongoDB数据库,spring整合 1. 引入pom依赖 <dependency> <group ...

- 三个技巧帮助Docker镜像瘦身

在构建Docker容器时,应该尽量想办法获得体积更小的镜像,因为传输和部署体积较小的镜像速度更快. 但RUN语句总是会创建一个新层,而且在生成镜像之前还需要使用很多中间文件,在这种情况下,该如何获得体 ...

- Python的基本运用(一)

1.a**b 表示a的b次方. 2.def something(a,b): 定义函数,注意 python的缩进 . 3.print (a)与print a 的区别,python3中不支持print ...