Generative model 和Discriminative model

学习音乐自动标注过程中设计了有关分类型模型和生成型模型的东西,特地查了相关资料,在这里汇总。

http://blog.sina.com.cn/s/blog_a18c98e50101058u.html

新宇教你机器学习之 Generative vs discriminative models

在机器学习中,经常会提到Generative model 和Discriminative model。这是什么意思呢?

Classification是Machine learning里面的一个问题。

就是说当你被给予一个测试数据的时候,你要把它分类给A还是B。

举例说就是,如果现在有两个类,A:牛逼 B:傻逼

当你看到一个人的时候(你的测试数据),你要把它分给A类还是B类呢?这类问题通常是这样解决的:

首先取很多很多A类人,并且找到他们的特征(比如说讲话多少,个子多高),然后取很多很多B类,也找相同的特征,对机器进行训练。每个人的每个特征都会有一个对应的数值。

当然我这里取的特征不太好(个子跟牛逼傻逼没什么关系 ,是不是?)

当你把所有你训练的人的特征都放在图上的时候,就会得到下图:

在这个feature space里面,每一个点都代表一个人,位置取决于他讲话和身高。 在训练的时候,我人为的给他们标好了标签。红色全部都牛逼,蓝色全部都傻逼。 然后当有一个新的人出现的时候,你提取他讲话多少和身高,就会得到上图的黑点。现在问题就是,他牛不牛逼呢?你要把它归给牛逼还是傻逼呢?

In Discriminative Model:

We model this problem as finding the probability of y given x. P(y|x).

意思就是我们去找测试数据”y”属于”牛逼”的概率,再找测试数据属于傻逼的概率。最后哪个大就把测试数据分给那个类 。

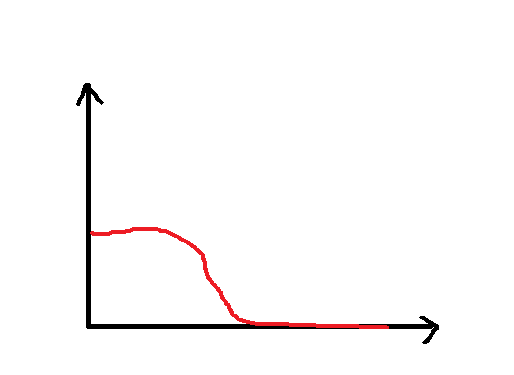

比如说下图就是测试数据属于红色的概率。(因为红色的点大部分集中在左边)

很容易看出黑点会被分配给蓝色类在discriminative model下。

In Generative Mode:

我们要找的是marginal probability,P(x,y)= P(y|x)*f(x)

这里F(x) 是x的密度函数。比如说Normal distribution。

意思就是说我们要找y属于x的概率,再乘以x出现在这个位置的几率。(应该是这样理解吧)

在这种情况下测试数据就不一定会被分配给蓝色类了。

要注意的是:

*很多时候想要找到f(x) 是一件很难的事情。因为你有的训练数据可能不够多,你无法知道x的真正密度函数

所以discriminative model其实也是有很多优点的。

http://freemind.pluskid.org/machine-learning/discriminative-modeling-vs-generative-modeling/

Discriminative Modeling vs Generative Modeling

机器学习的算法或者模型的分类有很多种,其中有一种分法把模型分为 Discriminative Modeling (判别模型)和 Generative Modeling (生成模型)两种。为了写起来方便我们以下简称 DM 和 GM 。在一个基本的机器学习问题中,我们通常有输入 和输出 两个部分,简单地来说,DM 关注于 和 的关系,或者说在给定某个 的情况下所对应的 应该满足的规律或分布;而 GM 则试图描述 和 的联合分布。两种视角各有各的优缺点,本文我们就试图来对两种建模方式做一些基本的了解。

我们不妨从具体的算法出发。记得我最初接触机器学习相关的东西的时候,做的是一个垃圾邮件分类的项目,当时我们在做的就是尝试各种不同的算法,其中有两种典型的算法 Naive Bayes 和 Logistic Regression 实际上就分别是 GM 和 DM 的两种最基本的算法。所以我们在这里也不妨用垃圾邮件分类这个场景来了解一下 DM 和 GM 。

垃圾邮件分类如今可算是一个非常古老的问题了,从 Gmail 的自动垃圾过滤来看,目前的 state-of-the-art 已经可以非常成熟了:precision 上来说,我从 2005 年到 2012 年这段时间内被误判为垃圾邮件的好邮件大概一共四、五封吧(当然可能还会有一些我压根就没有看到的被误杀掉的邮件);recall 上则稍微逊色一点,偶尔会在收件箱里出现 spam 。当然 recall 比 precision 略差也情有可原:

- precision 和 recall 之间是一个 trade-off ,对于垃圾邮件分类来说,将正常邮件标记为垃圾邮件和将垃圾邮件认为是正常邮件相比,前者是严重得多的错误,所以一般会倾向于调高 precision 。

- spammer 在不断地进化,针对 anti-spam 工具设计新的 spam 。

但总的来说因该也算是机器学习在实际中应用最成熟的领域之一了。当然好的应用算法、数据、工程各个方面都是非常重要的,这里我们只讲一些基本模型,毕竟不能跑题了呀!^_^一般机器学习算法在处理文本文档的时候多用 Vector Space Model (VSM) 来把一个文档转化为一个定长的向量进行处理。VSM 需要先构建一个词典,用 表示词典中的 个单词(这里 是 feature 的缩写),我们用 表示 个训练数据(文档)。

VSM 将每个文档转化为一个 维的向量,每个维度对应一个单词(feature)。最简单的 VSM 只判断单词是否在文档中出现,例如,我们用 表示文档 所对应的向量的第 维,那么

这种模型有一个好处是它产生出来的向量是 binary 的:每个维度上只有 0 或者 1 出现,因此处理起来可能会更简单一些。更复杂一点的 VSM 可能会将 设为单词 在文档 中出现的次数或者 TF-IDF 值。当然我们也可以跳出词典的限制,此时 并不一定对应某个单词,而表示任意一个 feature ,例如,当 的发件人在我的通讯录里的时候, ,否则等于 。

Naive Bayes 这个算法可以从它的名字来进行解读。首先它是根据 Bayes 公式来进行分类的。令 和 分别代表“文档”和“是否是 spam”的随机变量( 表示是 spam )。这里我们对 和 这两个概率模型进行建模,从而可以算出

在对文档 行分类的时候我们分别计算

然后比较两个概率值,简单的办法是看哪个大就分为哪一类,复杂一点的情况可以在两个概率值相差不大的时候输出“不知道” -.-bb。注意上式中红色部分两个式子是一样的,由于我们只是要比较两个值的相对大小,因此一样的部分可以直接省略,从而我们其实只是在比较 和 这两个概率值,这是可以通过模型直接计算出来的。

接下来看两个模型,首先是 ,由于 只取 0 和 1 两个值,因此用一个 Bernoulli Distribution 即可描述,该模型只有一个参数 。而 则分别是两个模型 和 ,每一个模型又是所有特征的联合概率分布,例如:

这里 “Naive” 出现了,由于 一般比较大,这么多特征的联合概率分布建模和处理起来都非常费力,于是这里做了一个非常 Naive 的假设,就是所有的特征之间是相互独立的(更确切地说,是相对于 条件独立的),根据独立性的定义,这里的联合概率可以写为每个特征各自的概率的乘积:

注意这是非常强的一个假设(否则也不会被命了 “Naive” 这样的名字吧?:D),例如如果每个 feature 表示单词的话,就要求一封邮件中各个单词出现与否是相互独立的,这明显是不符合实际情况的,不过 Naive Bayes 模型视乎在垃圾邮件分类问题中还是效果挺不错的。这样一来,对一个联合概率分布进行建模就简化为对每个 feature 进行建模。最简单的情况,如果特征是 binary 的话,我们仍然可以和 一样用 Bernoulli Distribution 。如果用了 TF-IDF 之类的连续特征的话,则可以用高斯分布之类的进行建模。在本文中我们只考虑 binary feature 的情况。

接下来我们来看 Logistic Regression ,这个算法直接对 进行建模,两类的模型如下:

很容易验证这两项相加等于 ,并且

换句话说,分类边界实际上是一个线性函数,这也是 Logistic Regression 模型设计的 motivation 。这里就可以先做一个简单的对比:Naive Bayes 需要同时对 和 进行建模,得到联合分布 ,因此是生成模型,由于 是个比较复杂的东西,建模起来很痛苦,于是 Naive Bayes 不得不做了很强的假设,从此一辈子戴上了 “Naive” 的帽子。而 Logistic Regression 作为一个典型的判别模型,则直接对 进行建模,而不关心 ,从而免去了许多麻烦和纠结,也不需要做那么大的取舍。

不过话虽如此,但是 Logistic Regression 也做了另一个很强的假设就是 linear model,接下来我们将看到实际上 Logistic Regression 是和 Naive Bayes 同流合污的。我们暂时回到 Naive Bayes ,由于它是 GM ,对 进行了建模,那我们来看看把它转化为一个 DM 会怎么样呢?也就是说,在我们已有的 模型下,去求 ,或者,为了和 Logistic Regression 那里进行对比,我们直接去求

此外,我们还可以对式 (eq: 1) 进行一下简单的变形:

这里 是 indicator function ,当下标中的条件满足时等于一,否则等于零。由于 本身就是 binary feature ,所以在倒数第二个等式中我们用了 来进行化简。对 可以做类似的变形,于是式 (eq: 2) 可以进一步化为

式子看起来有点复杂,不过如果我们把所有的常数项合并之后记为 ,而把 的系数合并之后记为 的话,就可以看到这个模型和 Logistic Regression 是一模一样的。像 Naive Bayes 和 Logistic Regression 这样的通常被称为 Generative-Discriminative Pair ,类似的还有Hidden Markov Model 和 Linear-chain Conditional Random Field 等。

一般来说,DM 比 GM 看起来更诱人一些,特别是我们的目标就是分类的时候,DM 直接建模 进行分类,而 GM 则先建模 然后再通过该模型计算 进行分类。

首先 的估计本身会很困难,需要的计算量和训练数据量都会非常巨大,像 Naive Bayes 那样为了使得模型复杂度被控制在可以处理的范围内就不得不做了非常强的假设。值得注意的是,虽然 Naive Bayes 的模型从某种程度上来说是相互对应的,但是两者实际上是差别很大的算法,比如如果 严重违背了独立性假设的话,Naive Bayes 的性能有可能会受到严重影响,而 Logistic Regression 则不太会受到 上的相关性之类的限制。比如,在自然语言处理中分析句子的语法树的时候,为了提高性能通常会使用一些冗余度和相关性非常高的特征,这个时候如果使用独立性假设很强的 GM 来处理,效果就不好,但如果不做很强的独立性假设,模型的复杂度又会指数级别增长,很快就无法处理了。不过用对等的 DM Conditional Random Field 来做的话,就可以不用 care 特征之间的关联与否,而有效地利用 rich feature set 。

其次 GM 实际上分两步来解决问题,多余的迂回步骤有可能会积累更多的误差。关于这个问题 Vapnik 有一句比较有名的话就是说的:

One should solve the problem directly and never solve a more general problem as an intermediate step.V.N. Vapnik. Stastical Learning Theory. John Wiley & Sons, 1998.

Andrew Ng 和 Michael Jordan 在 2001 年的一篇 NIPS 论文 (Ng & Jordan, 2001) 中分析过,对于一对 generative-discriminative pair 来说,DM 有比 GM 更低的 asymptote error。不过 GM 也并不是一无是处,在同一篇论文中,他们也给出了另一个结论,就是 GM 能比对应的 DM 更快地达到 asymptote error ,也就是说虽然最终 DM 会 outperform GM ,但是在 DM 还未达到它的 asymptote error 之前,GM 可能先达到了自己的 asymptote error,从而在一段时间内反而 outperform DM。

虽然 asymptote error 之类的可能在实际中并不一定很有参考价值,不过 GM 在实用上也还有另一个优点:那就是处理 latent variable 或者 partially observed data 以及 partially labeled data 之类的:因为它同时对 和 都建立了概率模型,所以如果 中有出现没有观察到的量的时候,就可以很自然地使用 EM 框架 来进行处理。极端情况下,在完全没有 label 信息的情况下,GM 仍然是可以工作的——unsupervised learning 可以看成是 GM 的一种。

总而言之,DM 和 GM 之间的争论也不是一天两天的事情了,虽然好像看起来 DM 更靠谱一些,但是 GM 也有它自己的优势,并且在具体的实际问题中 GM 和 DM 哪个效果更好也并不是能一下子“看”出来的。所以大概两者之间的争斗还会不断持续下去吧——或者说称为是和平共处?:P

References

- Ng, A. Y., & Jordan, M. I. (2001). On Discriminative vs. Generative Classifiers: A comparison of logistic regression and naive Bayes. In NIPS (841-848).

另外我还在Stackoverflow上找到了以下较为简明的解释:

A generative algorithm models how the data was generated in order to categorize a signal. It asks the question: based on my generation assumptions, which category is most likely to generate this signal?

A discriminative algorithm does not care about how the data was generated, it simply categorizes a given signal.

Generative model 和Discriminative model的更多相关文章

- 转Generative Model 与 Discriminative Model

没有完全看懂,以后再看,特别是hmm,CRF那里,以及生成模型产生的数据是序列还是一个值,hmm应该是序列,和图像的关系是什么. [摘要] - 生成模型(Generative Model) :无 ...

- Generative Model 与 Discriminative Model

[摘要] - 生成模型(Generative Model) :无穷样本==>概率密度模型 = 产生模型==>预测 - 判别模型(Discriminative Model): ...

- Generative Model vs Discriminative Model

In this post, we are going to compare the two types of machine learning models-generative model and ...

- 生成模型(Generative Model)和 判别模型(Discriminative Model)

引入 监督学习的任务就是学习一个模型(或者得到一个目标函数),应用这一模型,对给定的输入预测相应的输出.这一模型的一般形式为一个决策函数Y=f(X),或者条件概率分布P(Y|X). 监督学习方法又可以 ...

- 生成模型(Generative Model)Vs 判别模型(Discriminative Model)

概率图分为有向图(bayesian network)与无向图(markov random filed).在概率图上可以建立生成模型或判别模型.有向图多为生成模型,无向图多为判别模型. 判别模型(D ...

- MVC中@Html.DisPlayFor(model=>model.newsName)和 @Model.newsName的区别

MVC中,在Controllers查询到数据,返回一个实体给View并显示,可以用@Html.DisPlayFor(model=>model.newsName)和 @Model.newsName ...

- 【转载】Analysis Service Tabular Model #003 Multidimensional Model VS Tabular Model 我们该如何选择?

由于Multidimensional Model 和 Tabular Model 并不能互相转换, 所以在项目之初就应该要考虑好选择哪一种模型进行开发. 以下只是一些建议: Licensing 许可和 ...

- JFinal项目eclipse出现the table mapping of model: com.gexin.model.scenic.Scenic not exists or the ActiveRecordPlugin not start.

JFinal项目eclipse出现the table mapping of model: com.gexin.model.scenic.Scenic not exists or the ActiveR ...

- MVC:一个View显示多个Model(多个Model你可以使用ViewBag或ViewData , 或者:Model["myInfo"] as)

MVC:一个View显示多个Model 多个Model你可以使用ViewBag或ViewData , 或者:Model["myInfo"] as. 比如: Tuple<str ...

随机推荐

- CI cookie 存放数组

#ci cookie 由于不能存放数组,所有必须序列化之后在存入数组中 #定义数组 $cookie_array=array( 'shop_id'=>$gid, 'shop_name'=> ...

- Asp.Net中使用水晶报表

Asp.Net中使用水晶报表(上) 在我们对VS.Net中的水晶报表(Crystal Reports)进行研究之前,我和我朋友对如何将这个复杂的东东加入我们的Web应用有着非常的好奇心.一周以后,在阅 ...

- VC++Debug避免F11步进不想要的函数中

It's often useful to avoid stepping into some common code like constructors or overloaded operators. ...

- pandas基础: Series和DataFrame的简单介绍

一.pandas 是什么 pandas 是基于 NumPy 的一个 Python 数据分析包,主要目的是为了数据分析.它提供了大量高级的数据结构和对数据处理的方法. pandas 有两个主要的数据结构 ...

- Windows查看网络端口被占用情况netstat命令

在windows命令行窗口下执行: C:\>netstat -aon|findstr "80" TCP 127.0.0.1:80 0.0.0.0:0 ...

- hdu3625(第一类斯特林数)

与第二类有些区别! #include <stdio.h> #include <stdlib.h> #include <string.h> #include < ...

- 【MVC model 验证失效 】【Unexpected token u in JSON at position 0】【jquery-plugin-validation】

问题描述:mvc model 调用jquery-plugin-validation 实现 前台的数据验证,时报错 Unexpected token u in JSON at position 0 很讨 ...

- vue+node+mongoDB 火车票H5(二)---vux和less的配置

vue基本环境配置好之后,就可以开始开发页面了 开发页面之前先了解一下项目结构,原始的目录结构为: config是配置文件,环境配置好了开发阶段可以不再去修改了,node_modules文件夹是打包的 ...

- JavaBean 介绍

// Person.java public class Person{ private String name; private int age; // 无参构造函数 public Person(){ ...

- Super Jumping! Jumping! Jumping!---hdu1087(动态规划)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=1087 题意就是给你n个数,找出某个序列的最大和,这个序列满足依次增大的规则: 哎,这个题之前做过,但是 ...