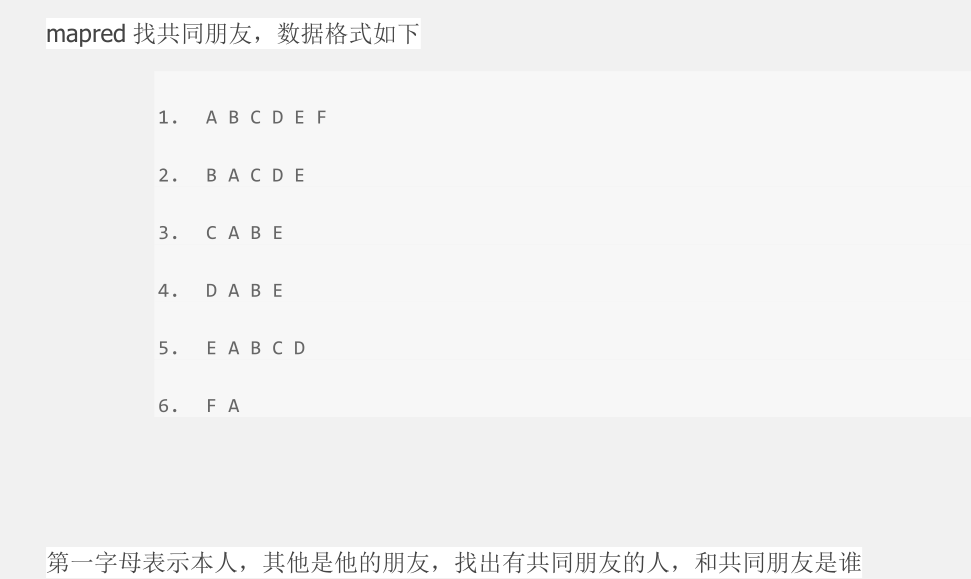

MapReduce实现共同朋友问题

答案:

package com.duking.mapreduce; import java.io.IOException;

import java.util.Set;

import java.util.StringTokenizer;

import java.util.TreeSet; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser; public class FindFriends { /**

* map方法

* @author duking

*

*/

public static class Map extends Mapper<Object, Text, Text, Text> { /**

* 实现map方法

*/

public void map(Object key, Text value, Context context) throws IOException, InterruptedException { //将输入的每一行数据切分后存到persions中

StringTokenizer persions = new StringTokenizer(value.toString()); //定义一个Text 存放本人信息owner

Text owner = new Text(); //定义一个Set集合,存放朋友信息

Set<String> set = new TreeSet<String>(); //将这一行的本人信息存入owner中

owner.set(persions.nextToken()); //将所有的朋友信息存放到Set集合中

while(persions.hasMoreTokens()){

set.add(persions.nextToken());

} //定义一个String数组存放朋友信息

String[] friends = new String[set.size()];

//将集合转换为数组,并将集合中的数据存放到friend

friends = set.toArray(friends); //将朋友进行两两组合

for(int i=0;i<friends.length;i++){

for(int j=i+1;j<friends.length;j++){

String outputkey = friends[i]+friends[j];

context.write(new Text(outputkey), owner);

}

} } } /**

* Reduce方法

* @author duking

*

*/

public static class Reduce extends Reducer<Text, Text, Text, Text> { /**

* 实现Reduce方法

*/

public void reduce(Text key, Iterable<Text> values,Context context) throws IOException, InterruptedException { String commonfriends = ""; for (Text val : values){

if(commonfriends == ""){

commonfriends = val.toString();

}else{

commonfriends = commonfriends + ":" +val.toString();

}

} context.write(key,new Text(commonfriends));

}

} /**

* main

* @param args

* @throws Exception

*/

public static void main(String[] args) throws Exception { Configuration conf = new Configuration(); conf.set("mapred.job.tracker", "192.168.60.129:9000"); //指定待运行参数的目录为输入输出目录

String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs(); /* 指定工程目录下的input output为输入输出目录

String[] ioArgs = new String[] {"input", "output" };

String[] otherArgs = new GenericOptionsParser(conf, ioArgs).getRemainingArgs();

*/ if (otherArgs.length != 2) { //判断运行参数个数 System.err.println("Usage: Data Deduplication <in> <out>"); System.exit(2); } // set maprduce job name

Job job = new Job(conf, "findfriends");

job.setJarByClass(FindFriends.class); // 设置map reduce处理类

job.setMapperClass(Map.class);

job.setReducerClass(Reduce.class); // 设置输出类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class); //设置输入输出路径

FileInputFormat.addInputPath(job, new Path(otherArgs[0]));

FileOutputFormat.setOutputPath(job, new Path(otherArgs[1])); System.exit(job.waitForCompletion(true) ? 0 : 1); } }

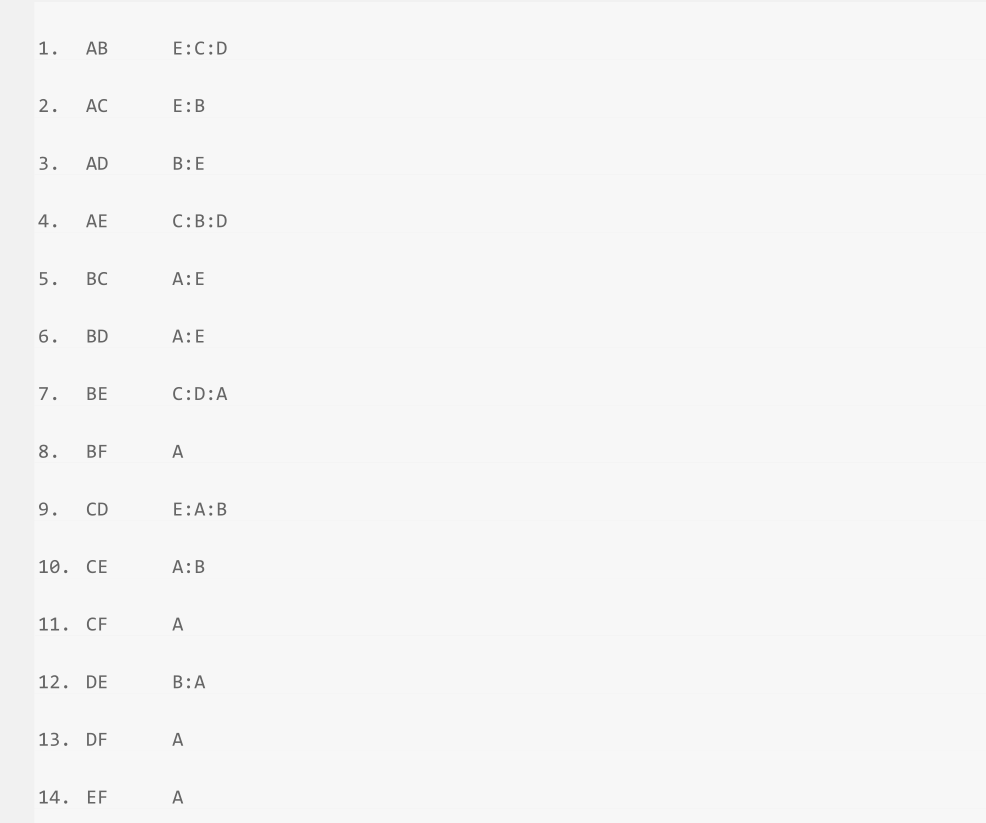

结果

MapReduce实现共同朋友问题的更多相关文章

- 【hadoop2.2(yarn)】基于yarn成功执行分布式map-reduce,记录问题解决过程。

hadoop2.x改进了hadoop1.x的架构, 具体yarn如何工作以及改进了什么可以在网上学, 这里仅记录我个人搭建的问题和理解,希望能帮助遇到困难的朋友. 在开始前,必须了解yarn版本的ma ...

- MapReduce实现二度好友关系

一.问题定义 我在网上找了些,关于二度人脉算法的实现,大部分无非是通过广度搜索算法来查找,犹豫深度已经明确了2以内:这个算法其实很简单,第一步找到你关注的人:第二步找到这些人关注的人,最后找出第二步结 ...

- SQL Server优化技巧之SQL Server中的"MapReduce"

日常的OLTP环境中,有时会涉及到一些统计方面的SQL语句,这些语句可能消耗巨大,进而影响整体运行环境,这里我为大家介绍如何利用SQL Server中的”类MapReduce”方式,在特定的统计情形中 ...

- MapReduce:详解Shuffle过程(转)

/** * author : 冶秀刚 * mail : dennyy99@gmail.com */ Shuffle过程是MapReduce的核心,也被称为奇迹发生的地方.要想理解MapRedu ...

- MapReduce:详解Shuffle过程

Shuffle过程是MapReduce的核心,也被称为奇迹发生的地方.要想理解MapReduce, Shuffle是必须要了解的.我看过很多相关的资料,但每次看完都云里雾里的绕着,很难理清大致的逻辑, ...

- [大牛翻译系列]Hadoop(5)MapReduce 排序:次排序(Secondary sort)

4.2 排序(SORT) 在MapReduce中,排序的目的有两个: MapReduce可以通过排序将Map输出的键分组.然后每组键调用一次reduce. 在某些需要排序的特定场景中,用户可以将作业( ...

- mapreduce编程模型你知道多少?

上次新霸哥给大家介绍了一些hadoop的相关知识,发现大家对hadoop有了一定的了解,但是还有很多的朋友对mapreduce很模糊,下面新霸哥将带你共同学习mapreduce编程模型. mapred ...

- 【原创】MapReduce编程系列之二元排序

普通排序实现 普通排序的实现利用了按姓名的排序,调用了默认的对key的HashPartition函数来实现数据的分组.partition操作之后写入磁盘时会对数据进行排序操作(对一个分区内的数据作排序 ...

- MapReduce:Shuffle过程的流程

Shuffle过程是MapReduce的核心,Shuffle描述着数据从map task输出到reduce task输入的这段过程. 1.map端

随机推荐

- 一个非常棒的jQuery 评分插件--好东西要分享

现在做网页已经不仅限于实现功能了,更多的是要实现功能的同时追求更加美观的实现.比如页面上让用户评分的功能,你完全可以放5个RdioButton让用户选择分数,也可以用DropDownList来实现,但 ...

- Redis集群部署文档(Ubuntu15.10系统)

Redis集群部署文档(Ubuntu15.10系统)(要让集群正常工作至少需要3个主节点,在这里我们要创建6个redis节点,其中三个为主节点,三个为从节点,对应的redis节点的ip和端口对应关系如 ...

- CentOS下调整home和根分区大小的方法

解决外挂硬盘的问题. 目标:将VolGroup-lv_home缩小到20G,并将剩余的空间添加给VolGroup-lv_root 1.首先查看磁盘使用情况[root@jb51.net~]# df -h ...

- A Magic Lamp---hdu3183(链表删除| RMQ)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=3183 给你一个长度<1000的数a,和m<len(a); 让把数a删除m个数字之后剩下的数 ...

- nginx 哈希表结构图

- Git查看、删除远程分支和tag

本站文章除注明转载外,均为本站原创或者翻译. 本站文章欢迎各种形式的转载,但请18岁以上的转载者注明文章出处,尊重我的劳动,也尊重你的智商: 本站部分原创和翻译文章提供markdown格式源码,欢迎使 ...

- php微信支付回调验证

//字典排序拼接字符串 function getWxPaySignature($arr){ ksort($arr); $str = ''; foreach ($arr as $k=>$a){ $ ...

- .globl分析

Uboot中常看到.globl .globl _start _start: b reset .align .globl _TEXT_BASE _TEXT_BASE: .globl _start /* ...

- POJO,简单的Java对象

POJO = "Plain Ordinary Java Object",简单的Java对象,是为了避免和EJB混淆所创造的简称,是MartinFowler等发明的一个术语,用来表示 ...

- R语言之多重共线性的判别以及解决方法

多重共线性(Multicollinearity)是指线性回归模型中的解释变量之间由于存在精确相关关系或高度相关关系而使模型估计失真或难以估计准确. 1.可以计算X矩阵的秩qr(X)$rank,如果 ...