HDFS基础入门

HDFS简介

HDFS(全称:Hadoop Distribute File System)分布式文件系统,是Hadoop核心组成。

HDFS中的重要概念

分块存储

HDFS中的文件在物理上是分块存储的,块的大小可以通过配置参数来规定;Hadoop2.x版本默认的block大小是128M

命名空间

HDFS支持传统的层次性文件组织结构。用户或者应用程序可以创建目录,然后将文件保存在这些目录里。文件系统名字空间的层次结构和大多数现有的文件系统类似:用户可以创建、删除、移动或重命名这些文件。

NameNode负责维护文件系统的名字空间,任何对文件系统名字空间或属性的修改都被NameNode记录下来。

NameNode元数据

我们把目录结构及文件分块位置信息叫做元数据。NameNode的元数据记录每一个文件对应的block信息。

DataNode数据存储

文件的各个block的具体存储管理由DataNode负责。一个block会有多个DataNode来存储,DataNode会定时向NameNode来汇报自己持有的block信息。

副本机制

为了容错,文件的所有block都会有副本。每隔文件的block大小和副本数都是可配置的。副本数默认是3个。

一次写入,多次读出

HDFS是设计成适应一次写入,多次读出的场景,且不支持文件的随机修改。正因为如此,HDFS适合用来做大数据分析的底层存储服务,而不适合做网盘等应用。(修改不方便,延迟大)

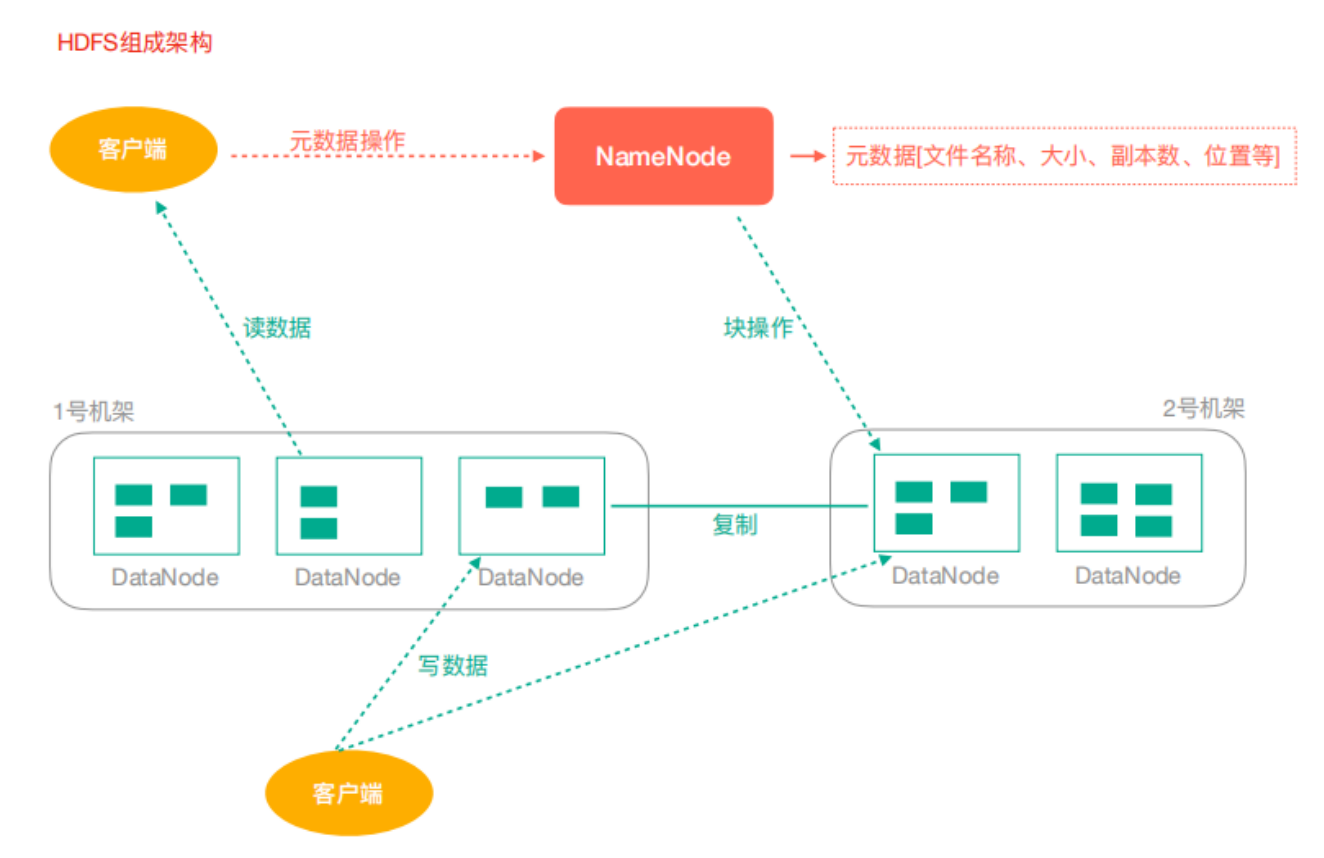

HDFS架构

NameNode:Hdfs集群的管理者

- 维护管理Hdfs的名称空间

- 维护副本策略

- 记录文件块的映射关系

- 负责处理客户端读写请求

DataNode:NameNode下达命令,DataNode执行实际操作

- 保存实际的数据块

- 负责数据块的读写

Client:客户端

- 上传文件到HDFS的时候,Client负责将文件切分成Block,然后进行上传

- 请求NameNode交互,获取文件的位置信息

- 读取或写入文件,与DataNode交互

- Client可以使用一些命令来管理HDFS或者访问HDFS

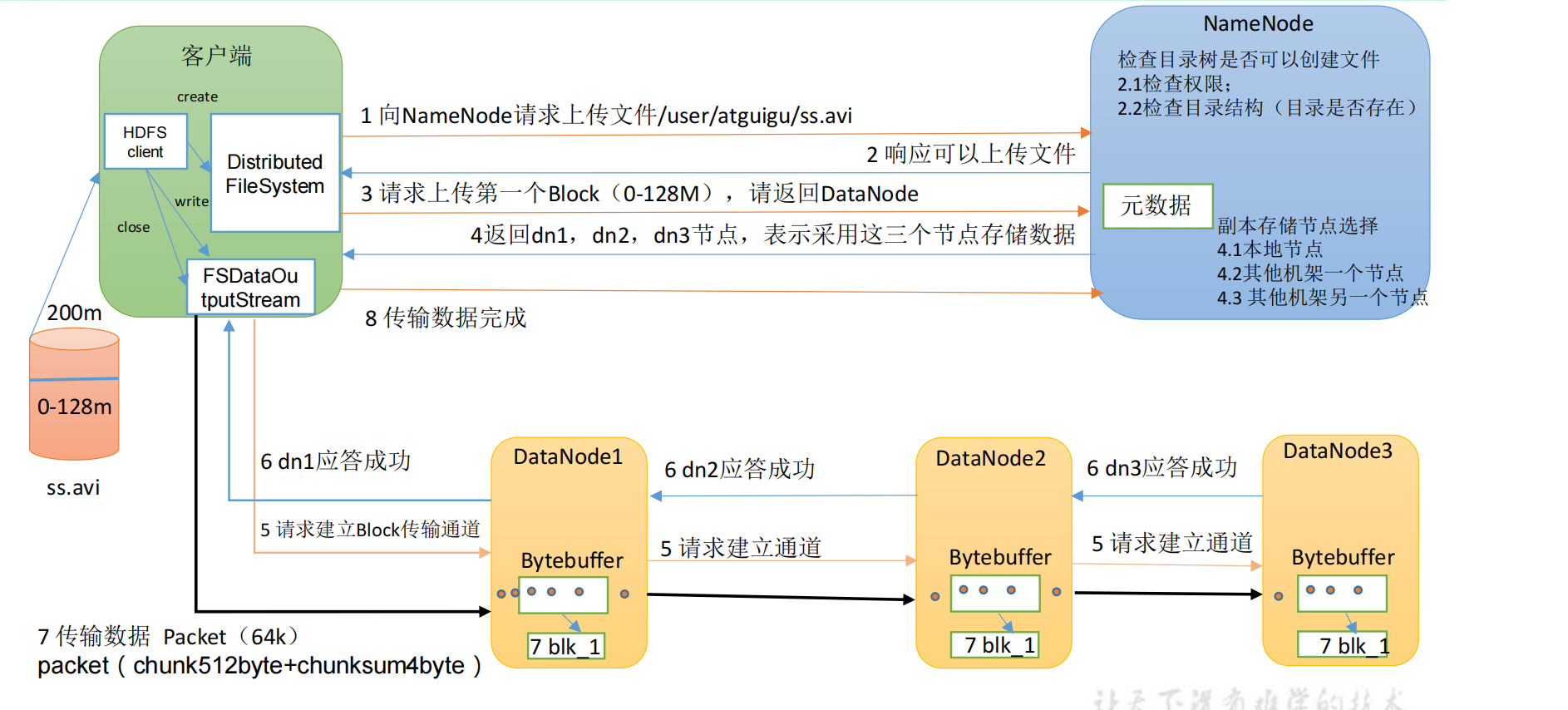

写数据流程:

HDFS客户端操作

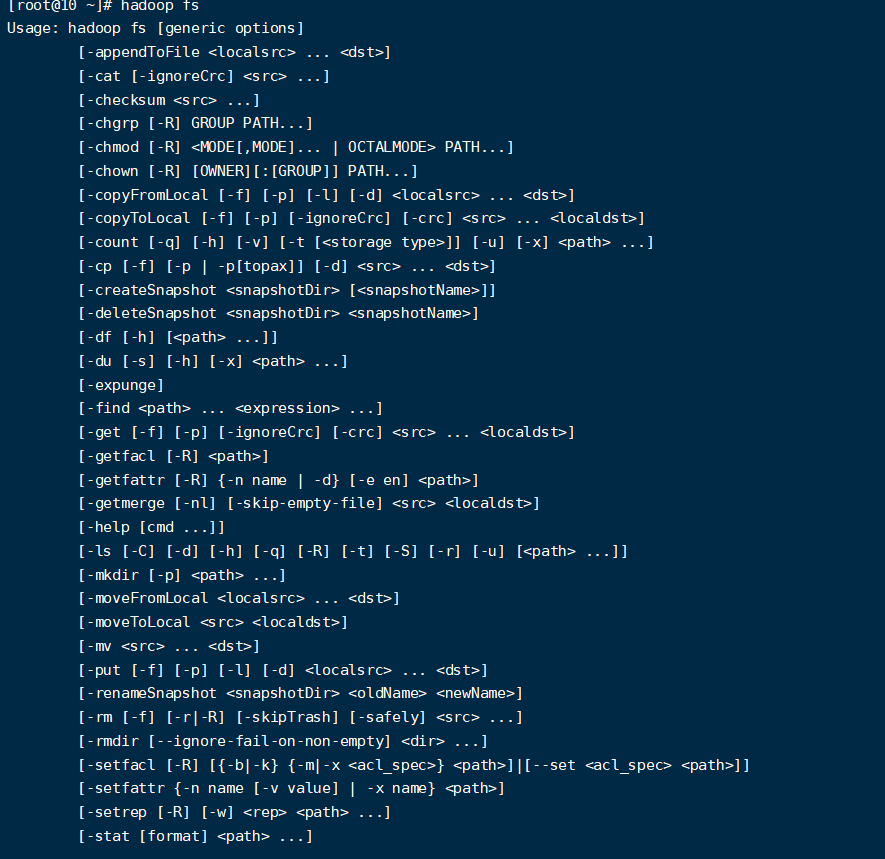

Shell客户端

- 查看所有命令

hadoop fs

- 查看命令帮助

#查看rm的帮助信息

hadoop fs -help rm

- 显示目录信息

hadoop fs -ls /

- 创建目录

hadoop fs -mkdir -p /test/data

- 从本地剪切到HDFS

hadoop fs -moveFromLocal ./word.txt /test/data

- 追加文件内容到指定文件

hadoop fs -appendToFile test.txt /test/data/word.txt

- 显示文件内容

hadoop fs -cat /test/data/word.txt

- 修改文件所属权限

hadoop fs -chmod 666 /test/data/word.txt

hadoop fs -chown root:root /test/data/word.txt

- 从本地文件系统拷贝文件到HDFS路径去

hadoop fs -copyFromLocal test.txt /test

- 从HDFS拷贝到本地

hadoop fs -copyToLocal /test/data/word.txt /opt

- 从HDFS的一个路径拷贝到HDFS的另一个路径

hadoop fs -cp /test/data/word.txt /test/input/t.txt

- 在HDFS目录中移动文件

hadoop fs -mv /test/input/t.txt /

- 从HDFS中下载文件,等同于copyToLocal

hadoop fs -get /t.txt ./

- 从本地上传文件到HDFS,等同于copyFromLocal

hadoop fs -put ./yarn.txt /user/root/test/

- 显示一个文件的末尾

hadoop fs -tail /t.txt

- 删除文件或文件夹

hadoop fs -rm /t.txt

- 删除空目录

hadoop fs -rmdir /test

- 统计文件夹的大小信息

hadoop fs -du -s -h /test

hadoop fs -du -h /test

- 设置HDFS的副本数量

hadoop fs -setrep 10 /lagou/bigdata/hadoop.txt

注意:这里设置的副本数只是记录在NameNode的元数据中,是否真的会有这么多副本,还得看DataNode的数量。因为目前只有3台设备,最多也就3个副本,只有节点数的增加到10台时,副本数才能达到10.

Java客户端

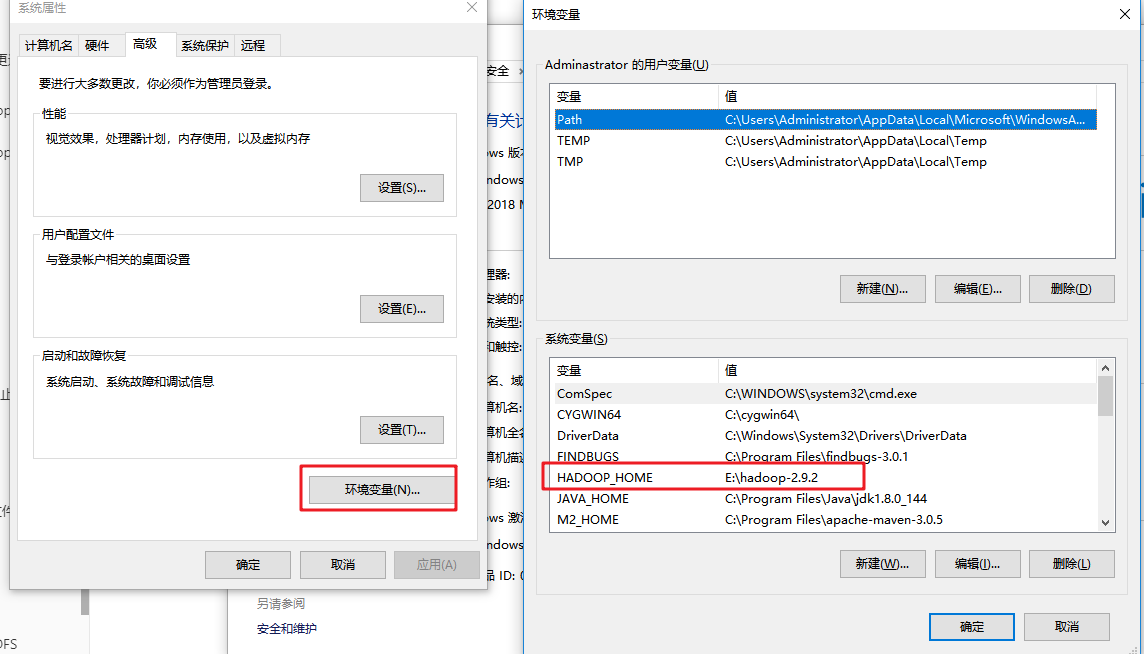

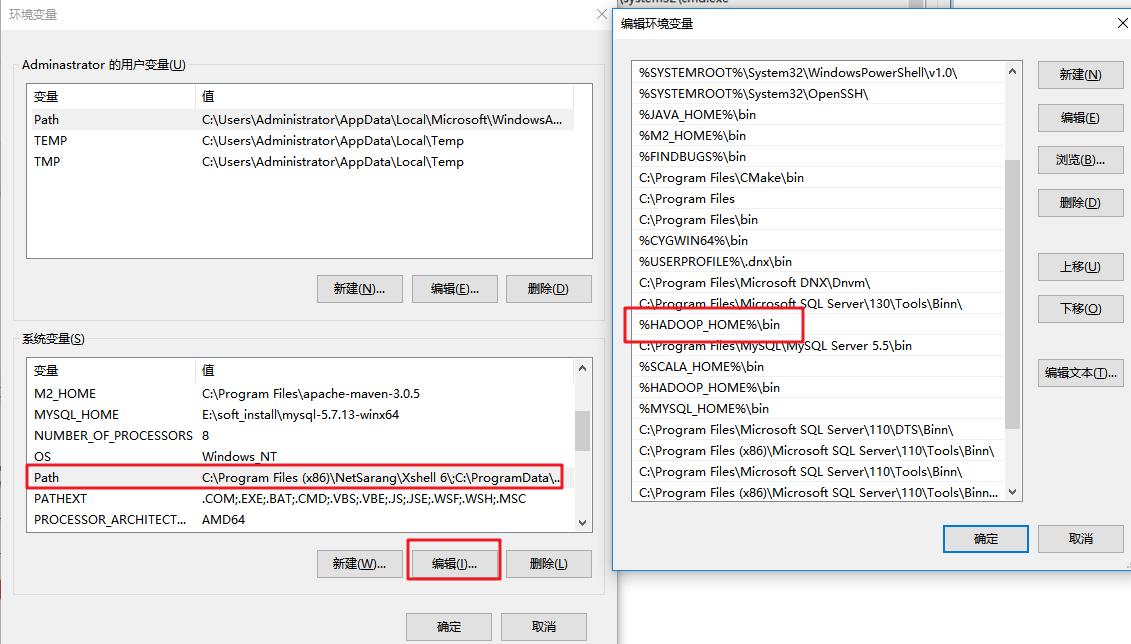

环境准备

- 将Hadoop安装包解压到非中文路径

- 配置环境变量

- 依赖导入

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>${hadoop-version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop-version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>${hadoop-version}</version>

</dependency>

- 配置文件(可选步骤)

将hdfs-site.xml(内容如下)拷贝到项目的resources下

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

参数优先级排序:(1)代码中设置的值 >(2)用户自定义配置文件 >(3)服务器的默认配置

HDFS Java API

- 上传文件

@Test

public void testCopyFromLocalFile() throws Exception{

Configuration conf = new Configuration();

FileSystem fs=FileSystem.get(new URI("hdfs://192.168.56.103:9000"),conf,"root");

fs.copyFromLocalFile(new Path("e://aa.txt"),new Path("/cc.txt"));

fs.close();

}

为了方便,下面的示例就隐藏构建FileSystem的过程

- 下载文件

@Test

public void testCopyToLocalFile() throws Exception{

fs.copyToLocalFile(false,new Path("/aa.txt"),new Path("e://cd.txt"),true);

}

- 删除文件

@Test

public void testDelete() throws Exception{

fs.delete(new Path("/aa.txt"),true);

}

- 查看文件名称、权限、长度、块信息等

public void testList() throws IOException {

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true);

while (listFiles.hasNext()){

LocatedFileStatus status = listFiles.next();

//文件名称

System.out.println(status.getPath().getName());

System.out.println(status.getLen());

System.out.println(status.getPermission());

System.out.println(status.getGroup());

BlockLocation[] blockLocations = status.getBlockLocations();

Stream.of(blockLocations).forEach(

block->{

String[] hosts = new String[0];

try {

hosts = block.getHosts();

} catch (IOException e) {

e.printStackTrace();

}

System.out.println(Arrays.asList(hosts));

}

);

System.out.println("-----------华丽的分割线----------");

}

}

- 文件夹判断

@Test

public void testListStatus() throws IOException {

FileStatus[] fileStatuses = fs.listStatus(new Path("/"));

Stream.of(fileStatuses).forEach(fileStatus -> {

String name = fileStatus.isFile() ? "文件:" + fileStatus.getPath().getName() : "文件夹:"+fileStatus.getPath().getName();

System.out.println(name);

});

}

- 通过I/O流操作HDFS

- IO流上传文件

@Test

public void testIOUpload() throws IOException {

FileInputStream fis = new FileInputStream(new File("e://11.txt"));

FSDataOutputStream fos = fs.create(new Path("/io_upload.txt"));

IOUtils.copyBytes(fis,fos,new Configuration());

IOUtils.closeStream(fis);

IOUtils.closeStream(fos);

}

- IO流下载文件

@Test

public void testDownload() throws IOException{

FSDataInputStream fis = fs.open(new Path("/io_upload.txt"));

FileOutputStream fos = new FileOutputStream(new File("e://11_copy.txt"));

IOUtils.copyBytes(fis,fos,new Configuration());

IOUtils.closeStream(fis);

IOUtils.closeStream(fos);

}

- seek定位读取

@Test

public void readFileSeek() throws IOException{

FSDataInputStream fis = fs.open(new Path("/io_upload.txt"));

IOUtils.copyBytes(fis,System.out,1024,false);

//从头再次读取

fis.seek(0);

IOUtils.copyBytes(fis,System.out,1024,false);

IOUtils.closeStream(fis);

}

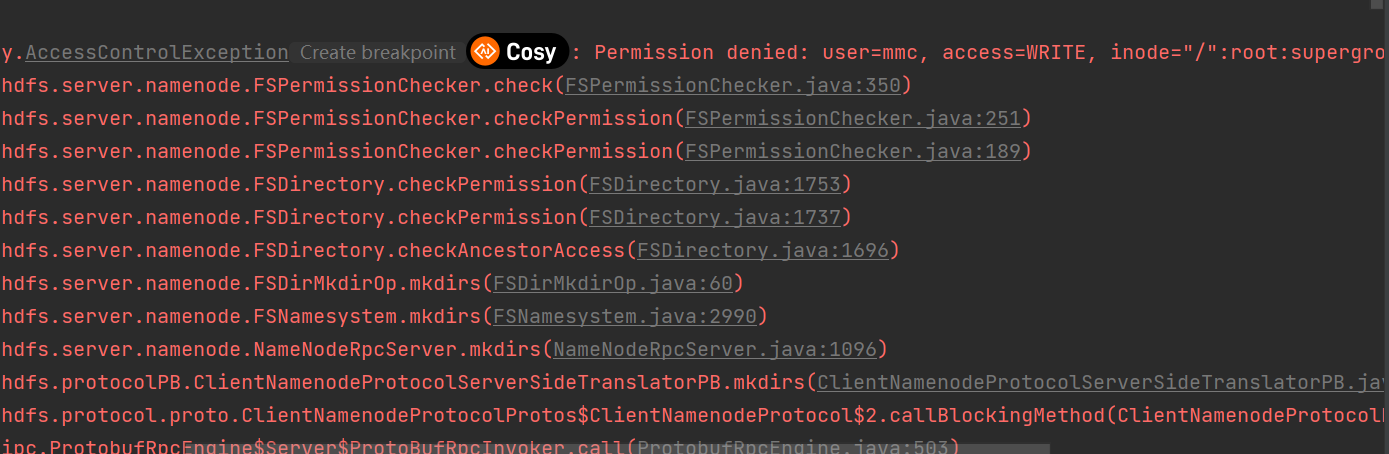

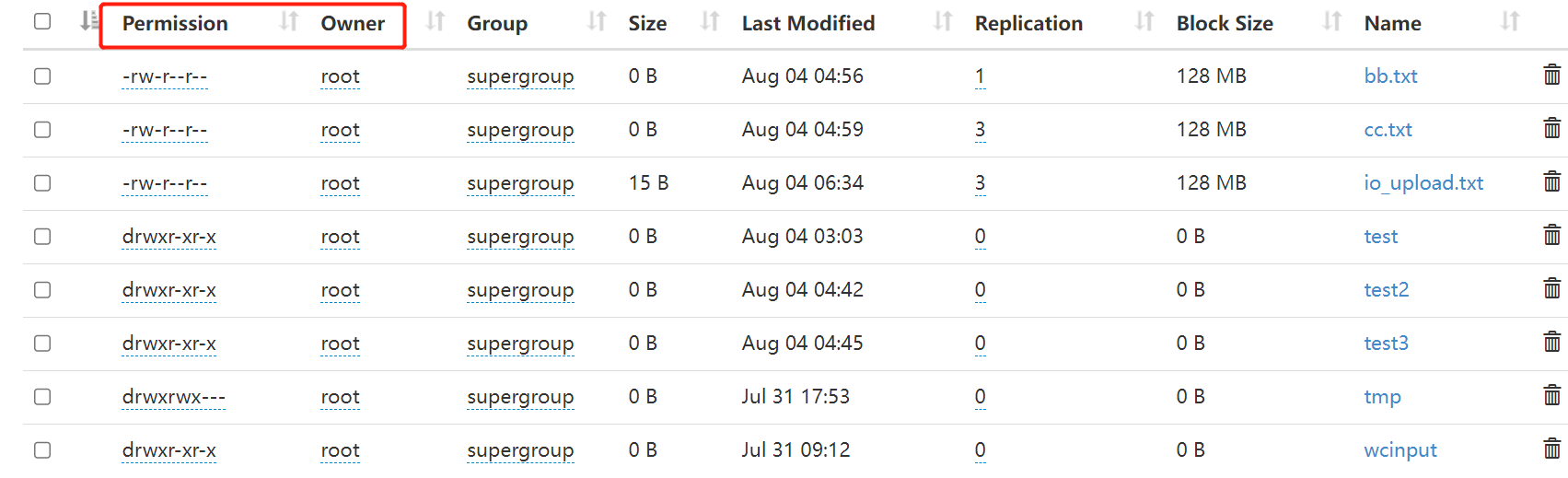

HDFS文件权限问题

HDFS的文件权限和linux系统的文件权限机制类似。如果在linux系统中root用户使用hadoop命令创建了一个文件,那么该文件的owner就是root。

当出现权限问题时,解决方法有如下几种:

- 获取FileSystem对象时指定有权限的用户

- 关闭HDFS权限校验,修改hdfs-site.xml

#添加如下属性

<property>

<name>dfs.permissions</name>

<value>true</value>

</property>

- 直接修改HDFS的文件或目录权限为777,允许所有用户操作

hadoop fs -chmod -R 777 /

HDFS基础入门的更多相关文章

- Hadoop学习笔记—2.不怕故障的海量存储:HDFS基础入门

一.HDFS出现的背景 随着社会的进步,需要处理数据量越来越多,在一个操作系统管辖的范围存不下了,那么就分配到更多的操作系统管理的磁盘中,但是却不方便管理和维护—>因此,迫切需要一种系统来管理多 ...

- 每天收获一点点------Hadoop之HDFS基础入门

一.HDFS出现的背景 随着社会的进步,需要处理数据量越来越多,在一个操作系统管辖的范围存不下了,那么就分配到更多的操作系统管理的磁盘中,但是却不方便管理和维护—>因此,迫切需要一种系统来管理多 ...

- 【原创 Hadoop&Spark 动手实践 5】Spark 基础入门,集群搭建以及Spark Shell

Spark 基础入门,集群搭建以及Spark Shell 主要借助Spark基础的PPT,再加上实际的动手操作来加强概念的理解和实践. Spark 安装部署 理论已经了解的差不多了,接下来是实际动手实 ...

- js学习笔记:webpack基础入门(一)

之前听说过webpack,今天想正式的接触一下,先跟着webpack的官方用户指南走: 在这里有: 如何安装webpack 如何使用webpack 如何使用loader 如何使用webpack的开发者 ...

- 「译」JUnit 5 系列:基础入门

原文地址:http://blog.codefx.org/libraries/junit-5-basics/ 原文日期:25, Feb, 2016 译文首发:Linesh 的博客:JUnit 5 系列: ...

- .NET正则表达式基础入门

这是我第一次写的博客,个人觉得十分不容易.以前看别人写的博客文字十分流畅,到自己来写却发现十分困难,还是感谢那些为技术而奉献自己力量的人吧. 本教程编写之前,博主阅读了<正则指引>这本入门 ...

- 从零3D基础入门XNA 4.0(2)——模型和BasicEffect

[题外话] 上一篇文章介绍了3D开发基础与XNA开发程序的整体结构,以及使用Model类的Draw方法将模型绘制到屏幕上.本文接着上一篇文章继续,介绍XNA中模型的结构.BasicEffect的使用以 ...

- 从零3D基础入门XNA 4.0(1)——3D开发基础

[题外话] 最近要做一个3D动画演示的程序,由于比较熟悉C#语言,再加上XNA对模型的支持比较好,故选择了XNA平台.不过从网上找到很多XNA的入门文章,发现大都需要一些3D基础,而我之前并没有接触过 ...

- Shell编程菜鸟基础入门笔记

Shell编程基础入门 1.shell格式:例 shell脚本开发习惯 1.指定解释器 #!/bin/bash 2.脚本开头加版权等信息如:#DATE:时间,#author(作者)#mail: ...

随机推荐

- 566. Reshape the Matrix - LeetCode

Question 566. Reshape the Matrix Solution 题目大意:给一个二维数组,将这个二维数组转换为r行c列 思路:构造一个r行c列的二维数组,遍历给出二给数组nums, ...

- 152-技巧-Power Query 快速合并文件夹中表格之自定义函数 TableXlsxCsv

152-技巧-Power Query 快速合并文件夹中表格之自定义函数 TableXlsxCsv 附件下载地址:https://jiaopengzi.com/2602.html 一.背景 在我们使用 ...

- HTML区块

1.HTML 可以通过 <div> 和 <span>将元素组合起来. 2.HTML <div> 元素 HTML <div> 元素是块级元素,它可用于组合 ...

- 记一次 JDK SPI 配置不生效的问题 → 这么简单都不会,还是回家养猪吧

开心一刻 今天去幼儿园接小侄女,路上聊起了天 小侄女:小叔,今天我吃东西被老师发现了 我:老师说了什么 小侄女:她说拿出来,跟小朋友一起分享 我:那你拿出来了吗 小侄女一脸可怜的看向我,说道:没有,我 ...

- U8g2图形库与STM32移植(I2C,软件与硬件)

U8g2图形库 简介 U8g2 是一个用于嵌入式设备的简易图形库,可以在多种 OLED 和 LCD 屏幕上,支持包括 SSD1306 等多种类型的底层驱动,并可以很方便地移植到 Arduino .树莓 ...

- Arraylist集合、对象数组

Arraylist集合 ArrayList是List接口的一个实现类,它是程序中最常见的一种集合. 他的特点:在增加或删除指定位置的元素时,会创建新的数组,效率比较低,因此不适合做大量的增删操作,Ar ...

- .NET中按预定顺序执行任务

更新记录 本文迁移自Panda666原博客,原发布时间:2021年7月1日. 一.说明 在.NET中线程可以定义按先后顺序进行执行,适合部分有先后次序的业务逻辑.Task也可以按照预定义的先后顺序执行 ...

- 8.shell编程之免交互

shell编程之免交互 目录 shell编程之免交互 Here Document免交互 免交互定义 Here Document变量设定 多行的注释 expect expect 定义 expect基本命 ...

- redis主从复制(九)

先来简单了解下redis中提供的集群策略, 虽然redis有持久化功能能够保障redis服务器宕机也能恢复并且只有少量的数据损失,但是由于所有数据在一台服务器上,如果这台服务器出现硬盘故障,那就算是有 ...

- Python基础学习_03

程序的流程控制 1.程序的组织结构 (1)顺序结构 (2)选择结构 (3)循环结构 2.对象的布尔值 以下对象的布尔值为False False,数值0,None,空字符串,空列表,空元组,空字典,空集 ...