HDFS连接JAVA,HDFS常用API

先在pom.xml中导入依赖包

<dependencies>

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-hdfs -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.6</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-common -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.6</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-client -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.6</version>

</dependency> <!-- https://mvnrepository.com/artifact/junit/junit -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.3</version>

</dependency> </dependencies>

hdfs连接Java

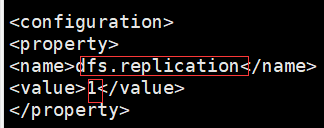

1.先获取配置文件(hdfs-site.xml)

Configuration cg = new Configuration(); 导入的是import org.apache.hadoop.conf.Configuration;

cg.set("dfs.replication","1"); 1是备份数量

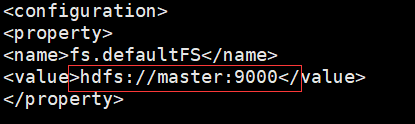

2.获取连接地址(core-site.xml)

URI uri = new URI("hdfs://master:9000");

3.创建(获取)hdfs文件管理系统的对象,同过对象操作hdfs

FileSystem fs = FileSystem.get(uri, cg);

常用HDFSAPi:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.junit.Before;

import org.junit.Test; import java.io.*;

import java.net.URI; public class HdfsApi {

FileSystem fs; @Before

public void main() throws Exception {

Configuration cg = new Configuration();

cg.set("dfs.replication", "1");

URI uri = new URI("hdfs://master:9000");

fs = FileSystem.get(uri, cg); } @Test

public void mk() throws IOException {

boolean mk = fs.mkdirs(new Path("/test"));

} @Test

public void del() throws IOException {

//false表示不迭代删除也可以不加,true可以进行多目录迭代删除

boolean del = fs.delete(new Path("/test"),false);

System.out.println(del); } @Test

public void listStatus() throws IOException { //对比图在下

//查看目录下文件列表

FileStatus[] fileStatuses = fs.listStatus(new Path("/data/data"));

System.out.println(fileStatuses); //[Lorg.apache.hadoop.fs.FileStatus;@106cc338

System.out.println("-------------------------------");

for (FileStatus fileStatus : fileStatuses) {

System.out.println(fileStatus.getLen()); //文件大小 以B字节为单位

System.out.println(fileStatus.getReplication()); //副本个数

System.out.println(fileStatus.getPermission()); //读写状态

System.out.println(fileStatus.getBlockSize()); //固定的一个block大小128MB

System.out.println(fileStatus.getAccessTime()); //创建文件时的时间戳

System.out.println(fileStatus.getPath()); //文件路径

System.out.println("-----------------");

}

/*输出结果

log4j:WARN No appenders could be found for logger (org.apache.hadoop.util.Shell).

log4j:WARN Please initialize the log4j system properly.

log4j:WARN See http://logging.apache.org/log4j/1.2/faq.html#noconfig for more info.

[Lorg.apache.hadoop.fs.FileStatus;@106cc338

-------------------------------

180

1

rw-r--r--

134217728

1631969331482

hdfs://master:9000/data/data/cource.txt

-----------------

138540

1

rw-r--r--

134217728

1631963067585

hdfs://master:9000/data/data/score.txt

-----------------

41998

1

rw-r--r--

134217728

1631963067890

hdfs://master:9000/data/data/students.txt

-----------------

*/ } @Test

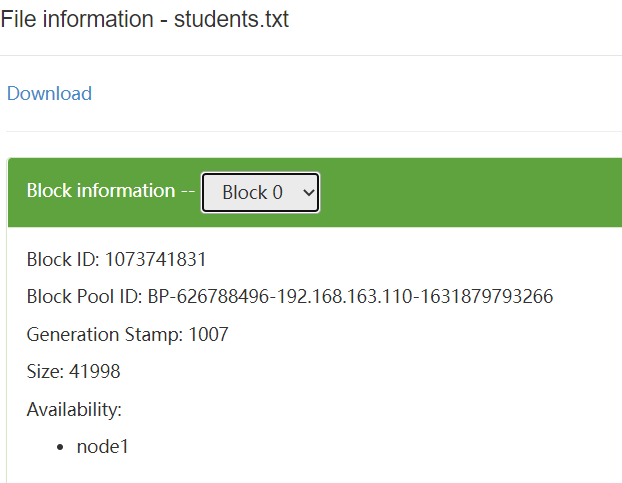

public void listBlockLocation() throws IOException { //对比图在下

BlockLocation[] fbl =

fs.getFileBlockLocations(

new Path("/data/data/students.txt"),0,1000000000);

for (BlockLocation bl : fbl) {

String[] hosts = bl.getHosts();

for (String host : hosts) {

System.out.println(host);

} //node1 表示文件存在node1,因为文件小于一个block,所以这里只存在一个节点 System.out.println(bl.getLength()); //41998 size大小 String[] names = bl.getNames();

for (String name : names) {

System.out.println(name);

} //192.168.163.120:50010 node1的地址 System.out.println(bl.getOffset()); //0 偏移量 String[] topologyPaths = bl.getTopologyPaths();

for (String topologyPath : topologyPaths) {

System.out.println(topologyPath);

} // /default-rack/192.168.163.120:50010 } } @Test

public void open() throws IOException {

FSDataInputStream open = fs.open(new Path("/data/data/students.txt"));

BufferedReader br = new BufferedReader(new InputStreamReader(open)); //因为文件中有中文,所以将字节流转为字符流来读取

String len;

while ((len=br.readLine())!=null){

System.out.println(len);

}

br.close();

} @Test

public void create() throws IOException {

FSDataOutputStream fos = fs.create(new Path("/data/data/test.txt"));

BufferedWriter bw = new BufferedWriter(new OutputStreamWriter(fos));

bw.write("你好");

bw.write("世界");

bw.newLine();

bw.write("我和我的祖国");

bw.flush();

bw.close(); } }

HDFS连接JAVA,HDFS常用API的更多相关文章

- Java 之常用API(一)

常用API 1 API概述 2 Scanner类与String类 3 StringBuilder类 NO.one API概述 1.1 API概述 API(Application Programm ...

- Java之常用API

API概述 什么是API API (Application Programming Interface) :应用程序编程接口 java中的API 指的就是 JDK 中提供的各种功能的 Java类,这些 ...

- Java 基础 常用API (System类,Math类,Arrays, BigInteger,)

基本类型包装类 基本类型包装类概述 在实际程序使用中,程序界面上用户输入的数据都是以字符串类型进行存储的.而程序开发中,我们需要把字符串数据,根据需求转换成指定的基本数据类型,如年龄需要转换成int类 ...

- Java 基础 常用API (Object类,String类,StringBuffer类)

Java API Java 的API(API: Application(应用) Programming(程序) Interface(接口)) Java API就是JDK中提供给我们使用的类,这些类将底 ...

- Java 之常用API(二)

Object类 & System类 日期相关类 包装类 & 正则表达式 Object类 & System类 1.1 Object类 1.1.1 概述 Object类是Java语 ...

- java selenium常用API(WebElement、iFrame、select、alert、浏览器窗口、事件、js) 一

WebElement相关方法 1.点击操作 WebElement button = driver.findElement(By.id("login")); button.clic ...

- java自学-常用api

API(Application Programming Interface),应用程序编程接口.Java API是JDK中提供给我们使用的类的说明文档.即jdk包里边写好的类,这些类将底层的代码实现封 ...

- Java的常用API

Object类 1.toString方法在我们直接使用输出语句输出对象的时候,其实通过该对象调用了其toString()方法. 2.equals方法方法摘要:类默认继承了Object类,所以可以使用O ...

- Java的常用API之System类简介

Syetem类 java.lang.System类中提供了大量的静态方法,可以获取与系统相关的信息或系统级操作,在System类的API文档中,常用的方法有: public static long c ...

随机推荐

- JVM常用命令(九)

前面东西说完后,现在可以说一些和我们平时进行性能调优相关的东西了,那怎么看和我们JVM性能调优相关的东西呢,其实这对我们开发来说是一个比较头痛的问题,其实我们JDK官网给了一些我们相关的指令,我们可以 ...

- Emoji与unicode特殊字符的处理

遇到了一个很让人纠结的问题:emoji表情在使用的过程中,会莫名其妙的消失,或者变成乱码,同时数据库用utf8mb4来存储,但是也出现了问题,冷备过后,导入进库的时候,变成了不可见字符,神奇的消失了! ...

- UIKit绘图演练

一般使用UIKit给我们提供的绘图来绘制一些文字,图片这些东西. UIKit给我们提供画图的方法底层也是分为四步.所以也必须在drawRect方法当中去写. 1.如何画文字? ...

- Ajax向服务器发起请求

Ajax向服务器发起请求的三个步骤: 1:创建Ajax 2:打开Ajax,打开Ajax请求 3:向服务器发起请求:需要知道地址和是get请求还是post方法 向服务器发起请求的两个方法:open 和 ...

- homestead 入坑安装

1.在使用 Homestead 之前,需要先安装 Virtual Box.VMWare.Parallels 或 Hyper-V (四选一,我们通常选择 VirtualBox,因为只有它是免费的)以及 ...

- 一行代码轻松修改 Text Field 和 Text View 的光标颜色 — By 昉

众所周知,Text Field 和 Text View 的光标颜色默认都是系统应用的那种蓝色,如图: 而在实际开发中为了让视觉效果更统一,我们可能会想把那光标的颜色设置成和界面色调一致的颜色.其实在 ...

- NSString 类介绍及用法

1.NSString常见方法 NSString是 Objective-C 中核心处理字符串的类之一 创建常量字符串,注意使用"@"符号. NSString *astring = @ ...

- docker平时使用异常记录

GPU主机重启后,启动使用GPU的容器报错 docker: Error response from daemon: Unknown runtime specified nvidia. 解决办法:修改/ ...

- 【论文阅读笔记】-针对RSA的短解密指数的密码学分析(Cryptanalysis of Short RSA Secret Exponents)

目录 1. 介绍 polynomially larger 2. 连分数背景知识 3. 连分数算法 4. 连分数算法在RSA中的应用 5. 例子 6. 对RSA连分数攻击的反制 7. 对于攻击的改进 8 ...

- Selenium对应版本

下面是谷歌浏览器与chromedriver的版本对应关系,供参考: ChromeDriver v2.45 (2018-12-10)----------Supports Chrome v70-72Chr ...