Hbase(五) hbase内部原理

一、系统架构

客户端连接hbase依赖于zookeeper,hbase存储依赖于hadoop

client:

1、包含访问 hbase 的接口, client 维护着一些 cache(缓存) 来加快对 hbase 的访问,比如 region 的 位置信息。 (经常使用的表的位置信息)

zookeeper:

1、保证任何时候,集群中只有一个 master

2、存贮所有 Region 的寻址入口----root 表在哪台服务器上。 -root-这张表的位置信息

3、实时监控 RegionServer 的状态,将 RegionServer 的上线和下线信息实时通知给 Master

4、存储 Hbase 的 schema(表的描述信息),包括有哪些 table,每个 table 有哪些 column family

master职责:

1、为 RegionServer 分配 region

2、负责 RegionServer 的负载均衡

3、发现失效的 RegionServer 并重新分配其上的 region

4、 HDFS 上的垃圾文件( hbase)回收

5、处理 schema 更新请求(增加,删除,修改)( JDBC:crud)

RegionServer 职责

1、 RegionServer 维护 Master 分配给它的 region,处理对这些 region 的 IO 请求

2、 RegionServer 负责切分在运行过程中变得过大的 region

可以看到, client 访问 hbase 上数据的过程并不需要 master 参与(寻址访问 zookeeper 和 RegioneServer,数据读写访问 RegioneServer), master 仅仅维护者 table 和 region 的元数据 信息,负载很低。

.meta. 存的是所有的 region 的位置信息,那么 RegioneServer 当中 region 在进行分裂之后 的新产生的 region,是由 master 来决定发到哪个 RegioneServer,这就意味着,只有 master 知道 new region 的位置信息,所以,由 master 来管理.meta.这个表当中的数据的 CRUD

(一张表数据大于10G时,会被分为两个region)

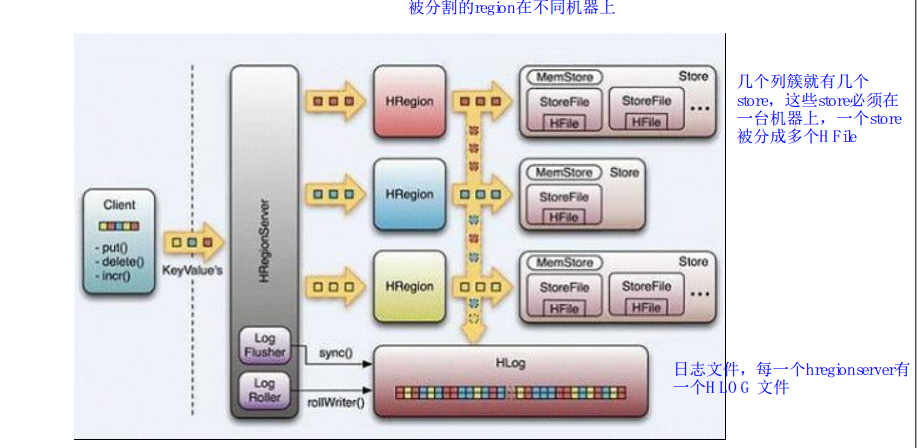

二、物理存储

1、整体物理结构

hfile 到达三个就会合并

hfile 到达三个就会合并

(1)Table 中的所有行都按照 row key 的字典序排列。

(2) Table 在行的方向上分割为多个 Hregion。

(3) region 按大小分割的(默认 10G),每个表一开始只有一个 region,随着数据不断插入表, region 不断增大,当增大到一个阀值的时候, Hregion 就会等分会两个新的 Hregion。当 table 中的行不断增多,就会有越来越多的 Hregion。

(4) Hregion 是 Hbase 中分布式存储和负载均衡的最小单元。最小单元就表示不同的 Hregion 可以分布在不同的 HRegion server 上。但一个 Hregion 是不会拆分到多个 server 上的。

(5) HRegion 虽然是负载均衡的最小单元,但并不是物理存储的最小单元。事实上, HRegion 由一个或者多个 Store 组成, 每个 store 保存一个 column family。每个 Strore 又由一个 memStore 和 0 至多个 StoreFile 组成

2、MemStore 和 StoreFile

一个 region 由多个 store 组成,每个 store 包含一个列族的所有数据 Store 包括位于内存的 memstore 和位于硬盘的 storefile

写操作先写入 memstore,当 memstore 中的数据量达到某个阈值, HRegionServer 启动flushcache 进程写入 storefile, 每次写入形成单独一个 Hfile

当 storefile 大小超过一定阈值后,会把当前的 region 分割成两个,并由 HMaster 分配给相应的 region 服务器,实现负载均衡

客户端检索数据时,先在 memstore 找,找不到再找 storefile

(memstore 存储了一部分hfile数据,最新的)

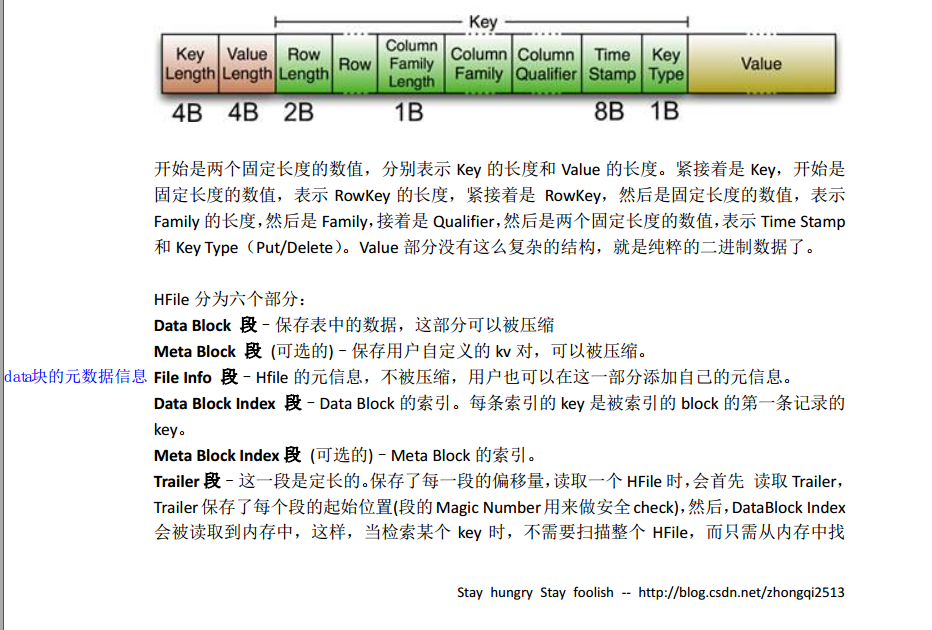

3、storefile 和hfile结构

StoreFile 以 HFile 格式保存在 HDFS 上,请看下图 Hfile 的数据组织格式:

4、Hlog(WAL) 增删改一定被记录下来

WAL 意为 Write ahead log(http://en.wikipedia.org/wiki/Write-ahead_logging),类似 mysql 中的 binlog,用来 做灾难恢复之用, Hlog 记录数据的所有变更,一旦数据修改,就可以从 log 中进 行恢复。

每个 Region Server 维护一个 Hlog,而不是每个 Region 一个。这样不同 region(来自不同 table) 的日志会混在一起,这样做的目的是不断追加单个文件相对于同时写多个文件而言,可以减 少磁盘寻址次数,因此可以提高对 table 的写性能。带来的麻烦是,如果一台 region server

下线,为了恢复其上的 region,需要将 region server 上的 log 进行拆分,然后分发到其它 region server 上进行恢复。

HLog 文件就是一个普通的 Hadoop Sequence File:

(1)HLog Sequence File 的 Key 是 HLogKey 对象, HLogKey 中记录了写入数据的归属信息,除 了 table 和 region 名字外,同时还包括 sequence number 和 timestamp, timestamp 是”写入 时间”, sequence number 的起始值为 0,或者是最近一次存入文件系统中 sequence number。

(2)HLog Sequece File 的 Value 是 HBase 的 KeyValue 对象,即对应 HFile 中的 KeyValue,可参见上文描述。

5、寻址机制

现在假设我们要从 user_info 里面寻找一条 RowKey 是 rk0001 的数据。那么我们应该遵循以 下步骤:

(1) 从.META.表里面查询哪个 Region 包含这条数据。

(2)获取管理这个 Region 的 RegionServer 地址。

(3) 连接这个 RegionServer, 查到这条数据。

系统如何找到某个 RowKey (或者某个 RowKey range)所在的 region bigtable 使用三层类似 B+树的结构来保存 region 位置。

第一层是保存 zookeeper 里面的文件,它持有 root region 的位置。

第二层 root region 是.META.表的第一个 region 其中保存了.META.表其它 region 的位置。通过 root region,我们就可以访问.META.表的数据。

.META.是第三层,它是一个特殊的表,保存了 hbase 中所有数据表的 region 位置信息。

说明:

(1)root region 永远不会被 split,保证了最多需要三次跳转,就能定位到任意 region 。

(2).META.表每行保存一个 region 的位置信息, rowkey 采用表名+表的最后一行编码而成。

(3) 为了加快访问, .META.表的全部 region 都保存在内存中。

(4)client 会将查询过的位置信息保存缓存起来,缓存不会主动失效,因此如果 client 上的缓存 全部失效,则需要进行最多 6 次网络来回,才能定位到正确的 region(其中三次用来发现缓 存失效,另外三次用来获取位置信息)。

三、读写过程

1、读请求过程

(1)客户端通过 zookeeper 以及 root 表和 meta 表找到目标数据所在的 regionserver(就是数据 所在的 region 的主机地址)

(2)联系 regionserver 查询目标数据

(3) regionserver 定位到目标数据所在的 region,发出查询请求

(4)region 先在 memstore 中查找,命中则返回

(5) 如 果 在 memstore 中 找 不 到 , 则 在 storefile 中 扫 描 ( 可 能 会 扫 描 到 很 多 的 storefile----bloomfilter)

( bloomfilter,布隆过滤器:迅速判断一个元素是不是在一个庞大的集合内,但是他有一个 弱点:它有一定的误判率)

(误判率:原本不存在与该集合的元素,布隆过滤器有可能会判断说它存在,但是,如果布 隆过滤器,判断说某一个元素不存在该集合,那么该元素就一定不在该集合内)

2、写请求过程

(1) client 向 region server 提交写请求

(2) region server 找到目标 region

(3) region 检查数据是否与 schema 一致

(4)如果客户端没有指定版本,则获取当前系统时间作为数据版本

(5)将更新写入 WAL log

(6)将更新写入 Memstore

(7)判断 Memstore 的是否需要 flush 为 Store 文件。

(先写日志文件,再写memstore)

细节描述:

hbase 使用 MemStore 和 StoreFile 存储对表的更新。

数据在更新时首先写入 Log(WAL log)和内存(MemStore)中, MemStore 中的数据是排序的,当 MemStore 累计到一定阈值时,就会创建一个新的 MemStore,并 且将老的 MemStore 添加到 flush 队列,由单独的线程 flush 到磁盘上,成为一个 StoreFile。

于此同时,系统会在 zookeeper 中记录一个 redo point,表示这个时刻之前的变更已经持久化了。当系统出现意外时,可能 导致内存(MemStore)中的数据丢失,此时使用 Log(WAL log)来恢复 checkpoint 之后的数据。

StoreFile 是只读的,一旦创建后就不可以再修改。

因此 Hbase 的更新其实是不断追加的操作。 当一个 Store 中的 StoreFile 达到一定的阈值后,就会进行一次合并 (minor_compact, major_compact),将对同一个 key 的修改合并到一起,形成一个大的 StoreFile,当 StoreFile 的 大小达到一定阈值后,又会对 StoreFile 进行 split,等分为两个 StoreFile。 由于对表的更新 是不断追加的, compact 时,需要访问 Store 中全部的 StoreFile 和 MemStore,将他们按 row key 进行合并,由于 StoreFile 和 MemStore 都是经过排序的,并且 StoreFile 带有内存中索引, 合并的过程还是比较快。

四、RegionServer 工作机制

1、 region 分配

任何时刻,一个 region 只能分配给一个 region server。master 记录了当前有哪些可用的 region server。以及当前哪些 region 分配给了哪些 region server,哪些 region 还没有分配。当需要 分配的新的 region,并且有一个 region server 上有可用空间时, master 就给这个 region server

发送一个装载请求,把 region 分配给这个 region server。 region server 得到请求后,就开始 对此 region 提供服务。

2、 region server 上线

master 使用 zookeeper 来跟踪 region server 状态。当某个 region server 启动时,会首先在 zookeeper 上的 server 目录下建立代表自己的 znode。由于 master 订阅了 server 目录上的变 更消息,当 server 目录下的文件出现新增或删除操作时, master 可以得到来自 zookeeper 的

实时通知。因此一旦 region server 上线, master 能马上得到消息。

3、 region server 下线

当 region server 下线时,它和 zookeeper 的会话断开, zookeeper 而自动释放代表这台 server 的文件上的独占锁。 master 就可以确定:

(1)region server 和 zookeeper 之间的网络断开了。

(2)region server 挂了。

无论哪种情况,region server 都无法继续为它的 region 提供服务了,此时 master 会删除 server 目录下代表这台 region server 的 znode 数据,并将这台 region server 的 region 分配给其它还 活着的同志。

五、master工作机制

master 上线

master 启动进行以下步骤:

(1) 从 zookeeper上获取唯一一个代表 active master 的锁,用来阻止其它 master 成为 master。

(2)扫描 zookeeper 上的 server 父节点,获得当前可用的 region server 列表。

(3)和每个 region server 通信,获得当前已分配的 region 和 region server 的对应关系。

(4)扫描.META.region 的集合,计算得到当前还未分配的 region,将他们放入待分配 region 列表。

master 下线

由于 master 只维护表和 region 的元数据,而不参与表数据 IO 的过程, master 下线仅导 致所有元数据的修改被冻结(无法创建删除表,无法修改表的 schema,无法进行 region 的负 载均衡,无法处理 region 上下线,无法进行 region 的合并,唯一例外的是 region 的 split 可

以正常进行,因为只有 region server 参与),表的数据读写还可以正常进行。因此 master 下 线短时间内对整个 hbase 集群没有影响。

从上线过程可以看到, master 保存的信息全是可以冗余信息(都可以从系统其它地方 收集到或者计算出来)

因此,一般 hbase 集群中总是有一个 master 在提供服务,还有一个以上的 master 在等 待时机抢占它的位置。

Hbase(五) hbase内部原理的更多相关文章

- HBase(五): HBase运维管理

HBase自带的很多工具可用于管理.分析.修复和调试,这些工具一部分的入口是hbase shell 客户端,另一部分是在hbase的Jar包中. 目录: hbck hfile 数据备份与恢复 Snap ...

- HBase学习-HBase原理

1.系统架构 1.1 图解 从HBase的架构图上可以看出,HBase中的组件包括Client.Zookeeper.HMaster.HRegionServer.HRegion.Store.MemS ...

- HBase数据模型和读写原理

Hbase的数据模型和读写原理: HBase是一个开源可伸缩的分布式数据库,他根据Google Bigtable数据模型构建在hadoop的hdfs存储系统之上. HBase是一个稀疏.多维度 ...

- 大数据技术之_11_HBase学习_01_HBase 简介+HBase 安装+HBase Shell 操作+HBase 数据结构+HBase 原理

第1章 HBase 简介1.1 什么是 HBase1.2 HBase 特点1.3 HBase 架构1.3 HBase 中的角色1.3.1 HMaster1.3.2 RegionServer1.3.3 ...

- JVM 内部原理(五)— 基本概念之 Java 虚拟机官方规范文档,第 7 版

JVM 内部原理(五)- 基本概念之 Java 虚拟机官方规范文档,第 7 版 介绍 版本:Java SE 7 每位使用 Java 的程序员都知道 Java 字节码在 Java 运行时(JRE - J ...

- HBase存储及读写原理介绍

一.HBase介绍及其特点 HBase是一个开源的非关系型分布式数据库,它参考了谷歌的BigTable建模,实现的编程语言为Java.它是Apache软件基金会的Hadoop项目的一部分,运行于HDF ...

- hbase总结~hbase配置和使用

Base配置和使用文档......................................................................................... ...

- Hbase总结(一)-hbase命令,hbase安装,与Hive的区别,与传统数据库的区别,Hbase数据模型

Hbase总结(一)-hbase命令 下面我们看看HBase Shell的一些基本操作命令,我列出了几个常用的HBase Shell命令,如下: 名称 命令表达式 创建表 create '表名称', ...

- Flume(2)-拓扑结构与Agent内部原理

一. 拓扑结构 1. 串行模式 这种模式是将多个flume给顺序连接起来了,从最初的source开始到最终sink传送的目的存储系统.此模式不建议桥接过多的flume数量, flume数量过多不仅会影 ...

随机推荐

- EF6+MVC5之Oracleo数据库的CodeFirst方式实现

http://www.oracle.com/technetwork/topics/dotnet/whatsnew/index.htm http://www.knowsky.com/887470.htm ...

- MySQL数据库之单双表查询

单表查询 先创建表 #创建表 create table employee( id int not null unique auto_increment, name varchar(20) not nu ...

- oracle 查看锁表及解锁的语句

解锁语句: alter system kill session 'sid, serial#'; alter system kill session '23, 1647'; 查询那些对象被锁: sele ...

- Unity中StopCoroutine不起作用怎么办

1,只有StartCoroutine使用一个字符串方法名时才能用StopCoroutine(string CoroutineName)停用. 2, public Coroutine coroutine ...

- 利用xlsxwriter生成数据报表

#!/usr/bin/env python# -*- coding:utf-8 -*-import os,xlsxwriter,datetimeimport ConfigParserfrom send ...

- Catch That Cow:BFS:加标记数组:不加标记数组

Catch That Cow Problem Description Farmer John has been informed of the location of a fugitive cow a ...

- hadoop 中balance 机制

Hadoop的HDFS集群非常容易出现机器与机器之间磁盘利用率不平衡的情况,比如集群中添加新的数据节点.当HDFS出现不平衡状况的时候,将引发很多问题,比如MR程序无法很好地利用本地计算的优势,机器之 ...

- loadrunner socket协议问题归纳(4)---buffer接收变长和定长的数据

测试场景:聊天系统 用户登录后,要先向服务器发送用户名,然后可以发送聊天信息,同时也可以接受聊天信息. 如果接受的字符为定长时,可以设定接受长度.recv buf2 66 #include " ...

- 希尔排序(java实现)

上篇blog中介绍的直接插入排序,希尔排序就是对直接插入排序的一个优化.比如有这么一种情况:对一个无序数组进行从小到大的排序,但是数组的最后一个位置的数是最小的,我们要把它挪到第一个位置,其他位置的都 ...

- hdu 1241--入门DFS

Oil Deposits Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others) Tot ...