Batch Normalization 和 DropOut

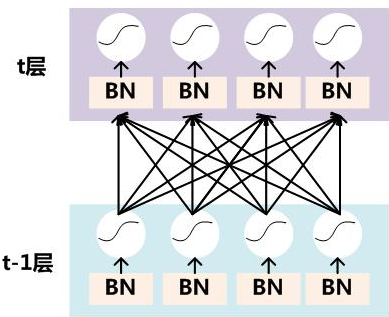

Batch-Normalization

https://www.cnblogs.com/guoyaohua/p/8724433.html

有几点需要注意:

- \(x^{(k)}\)指的是t层的输入. 也就是t-1层的输出x权重的变换

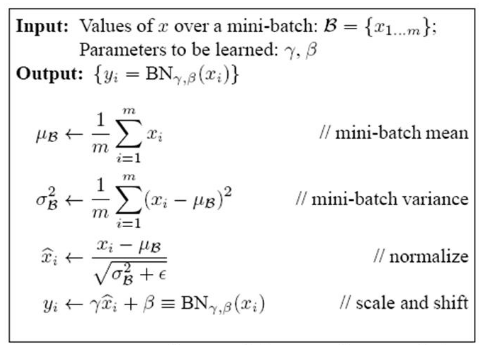

- 训练时,在做BN的时候, \(E(x)^{(k)}\)是mini-batch里面, m个样本所获得的均值,也就是说: \(E\)不是这一层, 连向这个神经元的权重的均值, 而是连向这个神经元的激活值的均值, 分母是mini-batch里面的样本数量

测试时候如何使用BN

求各层全局评均的均值方差, 作为测试时候的均值方差

测试时的输入难到不可以求均值方差?

- 测试的时候, 有可能只要一个sample, 那么这时候, 就没法求方差了

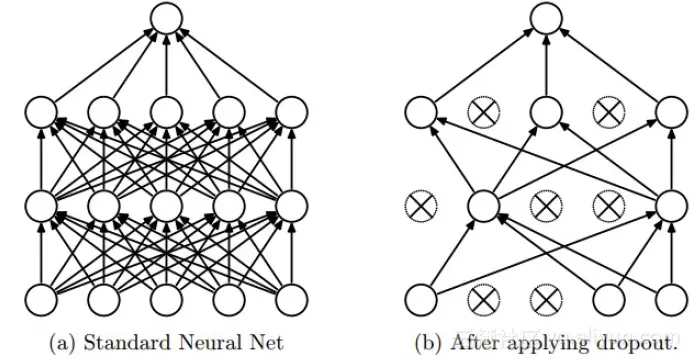

Dropout

参考博客

https://blog.csdn.net/program_developer/article/details/80737724

个人细节理解

假设有100个神经元, dropout概率p取0.5

- 训练时: 一共50个神经元参与训练

- 测试时, 所有的神经元都参与, 但是, 这样的话, 和没有dropout差异不大, 所以, 在测试阶段, 所有的神经元权重都将乘以概率p

- dropout可以理解为一种集成学习的策略, 因为每次训练, drop掉的神经元不一样, 这就相当于每次都训练一个不同的神经网络

- dropout有点像正则化, 减小权重使得网络对特征的鲁棒性更高

BN和dropout一般不同时使用,如果一定要同时使用,可以将dropout放置于BN后面。

droput之后改变了数据的标准差(令标准差变大,若数据均值非0时,甚至均值也会产生改变)。

如果同时又使用了BN归一化,由于BN在训练时保存了训练集的均值与标准差。dropout影响了所保存的均值与标准差的准确性(不能适应未来预测数据的需要),那么将影响网络的准确性。

Batch Normalization 和 DropOut的更多相关文章

- 激活函数,Batch Normalization和Dropout

神经网络中还有一些激活函数,池化函数,正则化和归一化函数等.需要详细看看,啃一啃吧.. 1. 激活函数 1.1 激活函数作用 在生物的神经传导中,神经元接受多个神经的输入电位,当电位超过一定值时,该神 ...

- Batch Normalization 与Dropout 的冲突

BN或Dropout单独使用能加速训练速度并且避免过拟合 但是倘若一起使用,会产生负面效果. BN在某些情况下会削弱Dropout的效果 对此,BN与Dropout最好不要一起用,若一定要一起用,有2 ...

- deeplearning.ai 改善深层神经网络 week3 超参数调试、Batch Normalization和程序框架

这一周的主体是调参. 1. 超参数:No. 1最重要,No. 2其次,No. 3其次次. No. 1学习率α:最重要的参数.在log取值空间随机采样.例如取值范围是[0.001, 1],r = -4* ...

- Batch Normalization&Dropout浅析

一. Batch Normalization 对于深度神经网络,训练起来有时很难拟合,可以使用更先进的优化算法,例如:SGD+momentum.RMSProp.Adam等算法.另一种策略则是高改变网络 ...

- caffe︱深度学习参数调优杂记+caffe训练时的问题+dropout/batch Normalization

一.深度学习中常用的调节参数 本节为笔者上课笔记(CDA深度学习实战课程第一期) 1.学习率 步长的选择:你走的距离长短,越短当然不会错过,但是耗时间.步长的选择比较麻烦.步长越小,越容易得到局部最优 ...

- 【转载】 深度学习总结:用pytorch做dropout和Batch Normalization时需要注意的地方,用tensorflow做dropout和BN时需要注意的地方,

原文地址: https://blog.csdn.net/weixin_40759186/article/details/87547795 ------------------------------- ...

- 深度学习基础系列(九)| Dropout VS Batch Normalization? 是时候放弃Dropout了

Dropout是过去几年非常流行的正则化技术,可有效防止过拟合的发生.但从深度学习的发展趋势看,Batch Normalizaton(简称BN)正在逐步取代Dropout技术,特别是在卷积层.本文将首 ...

- 从Bayesian角度浅析Batch Normalization

前置阅读:http://blog.csdn.net/happynear/article/details/44238541——Batch Norm阅读笔记与实现 前置阅读:http://www.zhih ...

- 深度学习网络层之 Batch Normalization

Batch Normalization Ioffe 和 Szegedy 在2015年<Batch Normalization: Accelerating Deep Network Trainin ...

- 使用TensorFlow中的Batch Normalization

问题 训练神经网络是一个很复杂的过程,在前面提到了深度学习中常用的激活函数,例如ELU或者Relu的变体能够在开始训练的时候很大程度上减少梯度消失或者爆炸问题.但是却不能保证在训练过程中不出现该问题, ...

随机推荐

- UG474

为了对工程的资源利用率进行优化,我们首先需要知道当前工程对资源的利用率情况.在Vivado下,我们可以查看工程的资源利用率情况,在下面这张图中,其罗列出了整个工程所使用的资源情况.首先,下面我们需要一 ...

- 出海业务如何搭建国内也能快速访问的https网站与接口(无需备案)

背景信息 由于最近在搭建我的出海网站 https://www.idatariver.com/zh-cn , 感兴趣的可以看看. 其中一个环节便是给后端API接口加上ssl,毕竟http看着不如http ...

- 加密与安全:非对称加密算法 RSA 1024 公钥、秘钥、明文和密文长度

RSA 1024 是指公钥及私钥分别是 1024bit,也就是 1024/8 = 128Bytes. RSA 原理 RSA 算法密钥长度的选择是安全性和程序性能平衡的结果,密钥长度越长,安全性越好,加 ...

- mybatis-plus处理blob字段

转载自:www.javaman.cn 在 Spring Boot 项目中使用 MyBatis-Plus 处理 longblob 字段时,我们可以按照以下步骤进行操作.假设 longblob 存储的是字 ...

- kettle多个表一起迁移-通过配置文件配置需要同步的字段,非全字段同步

kettle多个表一起迁移-通过配置文件配置需要同步的字段,非全字段同步 欢迎关注博主公众号「Java大师」, 专注于分享Java领域干货文章, 关注回复「999」获取本例源文件, 免费领取全网最热的 ...

- Python爬虫实战系列3:今日BBNews编程新闻采集

一.分析页面 打开今日BBNews网址 https://news.bicido.com ,下拉选择[编程]栏目 1.1.分析请求 F12打开开发者模式,然后点击Network后点击任意一个请求,Ctr ...

- Oss流程分析

最新式上传方案是:前端上传获取token,然后token中带有bucket.账号.回调地址等相关信息,前端直接上传到阿里云,阿里云上传成功后回调之前设定好的地址,完成上传.(下图是技术负责人的图,盗来 ...

- Performance Improvements in .NET 8 & 7 & 6 -- String【翻译】

原文:https://devblogs.microsoft.com/dotnet/performance-improvements-in-net-8/#strings-arrays-and-spans ...

- 记录--form 表单恢复初始数据

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 form 表单恢复初始数据 在现代的 Web 开发中,表单是不可或缺的组件之一.用户可以通过表单输入和提交数据,而开发者则需要对这些数据进 ...

- 鸿蒙HarmonyOS实战-ArkTS语言(状态管理)

前言 状态管理是指在应用程序中维护和更新应用程序状态的过程.在一个程序中,可能有很多不同的组件和模块,它们需要共享和相互作用的状态.如果没有一个明确的方式来管理这些状态,就会导致代码混乱.不易维护和难 ...