基于keras的时域卷积网络(TCN)

1 前言

时域卷积网络(Temporal Convolutional Network,TCN)属于卷积神经网络(CNN)家族,于2017年被提出,目前已在多项时间序列数据任务中击败循环神经网络(RNN)家族。

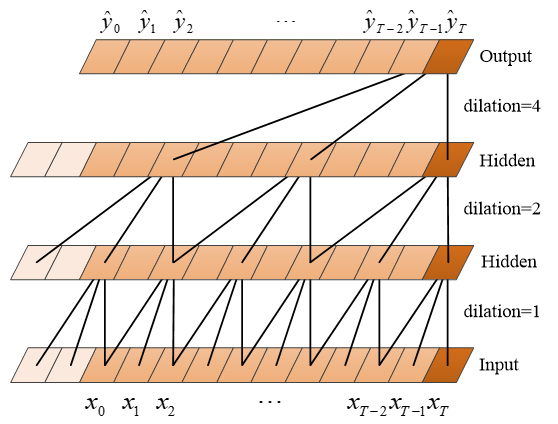

TCN 网络结构

TCN 网络结构

图中,xi 表示第 i 个时刻的特征,可以是多维的。

TCN源码见-->GitHub - philipperemy/keras-tcn: Keras Temporal Convolutional Network.,由于源码过于复杂,新手不易上手,笔者参照源码,手撕了个简洁版的TCN,与君共享。

本文以 MNIST 手写数字分类为例,讲解 TCN 模型。关于 MNIST 数据集的说明,见使用TensorFlow实现MNIST数据集分类。

笔者工作空间如下:

代码资源见-->时域卷积网络(TCN)案例模型

2 实验

TCN.py

from tensorflow.examples.tutorials.mnist import input_data

from keras.models import Model

from keras.layers import add,Input,Conv1D,Activation,Flatten,Dense

#载入数据

def read_data(path):

mnist=input_data.read_data_sets(path,one_hot=True)

train_x,train_y=mnist.train.images.reshape(-1,28,28),mnist.train.labels,

valid_x,valid_y=mnist.validation.images.reshape(-1,28,28),mnist.validation.labels,

test_x,test_y=mnist.test.images.reshape(-1,28,28),mnist.test.labels

return train_x,train_y,valid_x,valid_y,test_x,test_y

#残差块

def ResBlock(x,filters,kernel_size,dilation_rate):

r=Conv1D(filters,kernel_size,padding='same',dilation_rate=dilation_rate,activation='relu')(x) #第一卷积

r=Conv1D(filters,kernel_size,padding='same',dilation_rate=dilation_rate)(r) #第二卷积

if x.shape[-1]==filters:

shortcut=x

else:

shortcut=Conv1D(filters,kernel_size,padding='same')(x) #shortcut(捷径)

o=add([r,shortcut])

o=Activation('relu')(o) #激活函数

return o

#序列模型

def TCN(train_x,train_y,valid_x,valid_y,test_x,test_y):

inputs=Input(shape=(28,28))

x=ResBlock(inputs,filters=32,kernel_size=3,dilation_rate=1)

x=ResBlock(x,filters=32,kernel_size=3,dilation_rate=2)

x=ResBlock(x,filters=16,kernel_size=3,dilation_rate=4)

x=Flatten()(x)

x=Dense(10,activation='softmax')(x)

model=Model(input=inputs,output=x)

#查看网络结构

model.summary()

#编译模型

model.compile(optimizer='adam',loss='categorical_crossentropy',metrics=['accuracy'])

#训练模型

model.fit(train_x,train_y,batch_size=500,nb_epoch=30,verbose=2,validation_data=(valid_x,valid_y))

#评估模型

pre=model.evaluate(test_x,test_y,batch_size=500,verbose=2)

print('test_loss:',pre[0],'- test_acc:',pre[1])

train_x,train_y,valid_x,valid_y,test_x,test_y=read_data('MNIST_data')

TCN(train_x,train_y,valid_x,valid_y,test_x,test_y)

网络各层输出尺寸:

__________________________________________________________________________________________________

Layer (type) Output Shape Param # Connected to

==================================================================================================

input_1 (InputLayer) (None, 28, 28) 0

__________________________________________________________________________________________________

conv1d_1 (Conv1D) (None, 28, 32) 2720 input_1[0][0]

__________________________________________________________________________________________________

conv1d_2 (Conv1D) (None, 28, 32) 3104 conv1d_1[0][0]

__________________________________________________________________________________________________

conv1d_3 (Conv1D) (None, 28, 32) 2720 input_1[0][0]

__________________________________________________________________________________________________

add_1 (Add) (None, 28, 32) 0 conv1d_2[0][0]

conv1d_3[0][0]

__________________________________________________________________________________________________

activation_1 (Activation) (None, 28, 32) 0 add_1[0][0]

__________________________________________________________________________________________________

conv1d_4 (Conv1D) (None, 28, 32) 3104 activation_1[0][0]

__________________________________________________________________________________________________

conv1d_5 (Conv1D) (None, 28, 32) 3104 conv1d_4[0][0]

__________________________________________________________________________________________________

add_2 (Add) (None, 28, 32) 0 conv1d_5[0][0]

activation_1[0][0]

__________________________________________________________________________________________________

activation_2 (Activation) (None, 28, 32) 0 add_2[0][0]

__________________________________________________________________________________________________

conv1d_6 (Conv1D) (None, 28, 16) 1552 activation_2[0][0]

__________________________________________________________________________________________________

conv1d_7 (Conv1D) (None, 28, 16) 784 conv1d_6[0][0]

__________________________________________________________________________________________________

conv1d_8 (Conv1D) (None, 28, 16) 1552 activation_2[0][0]

__________________________________________________________________________________________________

add_3 (Add) (None, 28, 16) 0 conv1d_7[0][0]

conv1d_8[0][0]

__________________________________________________________________________________________________

activation_3 (Activation) (None, 28, 16) 0 add_3[0][0]

__________________________________________________________________________________________________

flatten_1 (Flatten) (None, 448) 0 activation_3[0][0]

__________________________________________________________________________________________________

dense_1 (Dense) (None, 10) 4490 flatten_1[0][0]

==================================================================================================

Total params: 23,130

Trainable params: 23,130

Non-trainable params: 0

网络训练结果:

Epoch 28/30

- 6s - loss: 0.0112 - acc: 0.9966 - val_loss: 0.0539 - val_acc: 0.9854

Epoch 29/30

- 6s - loss: 0.0080 - acc: 0.9977 - val_loss: 0.0536 - val_acc: 0.9872

Epoch 30/30

- 6s - loss: 0.0099 - acc: 0.9965 - val_loss: 0.0486 - val_acc: 0.9892

test_loss: 0.055041389787220396 - test_acc: 0.9855000048875808

可以看到,TCN模型的预测精度为 0.9855, 超越了 seq2seq模型案例分析 中 AttSeq2Seq 模型(0.9825)、基于keras的双层LSTM网络和双向LSTM网络 中 DoubleLSTM 模型(0.9789)和 BiLSTM 模型(0.9795)、基于keras的残差网络 中 ResNet 模型(0.9721)。

3 拓展延申

有时候,并不需要最后一层 TCN 输出序列的所有步,而只需要最后一层 TCN 输出序列的第一步或最后一步。这时候,需要借助 lambda 关键字定义 Lambda 层,取代 Flatten 层。如下:

from keras.layers import Lambda

......

x=ResBlock(x,filters=16,kernel_size=3,dilation_rate=4)

x=Lambda(lambda x: x[:,0,:])(x) #此前是:x=Flatten()(x)

x=Dense(10,activation='softmax')(x)

......

lambda 关键字用于定义匿名函数,应用如下:

import numpy as np

f=lambda x: x*x+x+1

x=np.array([1,2,3])

y=f(x)

print(y) #输出:[ 3 7 13]

声明:本文转自基于keras的时域卷积网络(TCN)

基于keras的时域卷积网络(TCN)的更多相关文章

- R-FCN:基于区域的全卷积网络来检测物体

http://blog.csdn.net/shadow_guo/article/details/51767036 原文标题为“R-FCN: Object Detection via Region-ba ...

- 时空卷积网络TCN

1.写在前面 实验表明,RNN 在几乎所有的序列问题上都有良好表现,包括语音/文本识别.机器翻译.手写体识别.序列数据分析(预测)等. 在实际应用中,RNN 在内部设计上存在一个严重的问题:由于网络一 ...

- 用keras作CNN卷积网络书本分类(书本、非书本)

本文介绍如何使用keras作图片分类(2分类与多分类,其实就一个参数的区别...呵呵) 先来看看解决的问题:从一堆图片中分出是不是书本,也就是最终给图片标签上:“书本“.“非书本”,简单吧. 先来看看 ...

- 基于孪生卷积网络(Siamese CNN)和短时约束度量联合学习的tracklet association方法

基于孪生卷积网络(Siamese CNN)和短时约束度量联合学习的tracklet association方法 Siamese CNN Temporally Constrained Metrics T ...

- keras搭建密集连接网络/卷积网络/循环网络

输入模式与网络架构间的对应关系: 向量数据:密集连接网络(Dense层) 图像数据:二维卷积神经网络 声音数据(比如波形):一维卷积神经网络(首选)或循环神经网络 文本数据:一维卷积神经网络(首选)或 ...

- 基于 Keras 用 LSTM 网络做时间序列预测

目录 基于 Keras 用 LSTM 网络做时间序列预测 问题描述 长短记忆网络 LSTM 网络回归 LSTM 网络回归结合窗口法 基于时间步的 LSTM 网络回归 在批量训练之间保持 LSTM 的记 ...

- 基于TensorFlow解决手写数字识别的Softmax方法、多层卷积网络方法和前馈神经网络方法

一.基于TensorFlow的softmax回归模型解决手写字母识别问题 详细步骤如下: 1.加载MNIST数据: input_data.read_data_sets('MNIST_data',one ...

- TCN时间卷积网络——解决LSTM的并发问题

TCN是指时间卷积网络,一种新型的可以用来解决时间序列预测的算法.在这一两年中已有多篇论文提出,但是普遍认为下篇论文是TCN的开端. 论文名称: An Empirical Evaluation of ...

- 【GCN】图卷积网络初探——基于图(Graph)的傅里叶变换和卷积

[GCN]图卷积网络初探——基于图(Graph)的傅里叶变换和卷积 2018年11月29日 11:50:38 夏至夏至520 阅读数 5980更多 分类专栏: # MachineLearning ...

- OverFeat:基于卷积网络的集成识别、定位与检测

摘要:我们提出了一个使用卷积网络进行分类.定位和检测的集成框架.我们展示了如何在ConvNet中有效地实现多尺度和滑动窗口方法.我们还介绍了一种新的深度学习方法,通过学习预测对象边界来定位.然后通过边 ...

随机推荐

- MCU芯片设计流程

MCU设计流程 1.产品开发整体流程 Integrated Product Development(IPD) TR-Technique Review-技术评审 xDCP-管理层决定是否开发 这里的验证 ...

- [转帖]CoreDNS loop 插件异常问题

https://zhuanlan.zhihu.com/p/476611162 背景 最近有遇到一个客户集群,发现集群中的 CoreDNS 老是异常 (loop 插件检测到有回路后进行 panic) ...

- [转帖]oracle中Rman增量备份下各级别level的区别

RMAN备份分为全备和增量备份两部分 增量备份:分为0 1 2级 ORACLE官方解释: A level 1 incremental backup can be either of the foll ...

- [转帖]TIKV扩容之刨坑填坑

01 背景 某tidb集群收到告警,TIKV 节点磁盘使用率85%以上,联系业务无法快速删除数据,于是想到扩容TIKV 节点,原先TIKV 节点机器都是6TB的硬盘,目前只有3TB的机器可扩,也担心r ...

- [转帖]配置ftp连接对象存储bucket子目录的方法

https://developer.jdcloud.com/article/1838 配置ftp连接对象存储bucket子目录的方法 京东云技术交付部 2021-01-27 IP归属:未知 441 ...

- [转帖]Arm vs X86 (unfinished)

http://home.ustc.edu.cn/~shaojiemike/posts/arm/ ARM Ltd history 诞生 1981年,被Intel拒绝的Acorn(橡子) Comput ...

- css中使用蒙层会带来哪些问题。

css中使用蒙层会带来哪些问题. 1==> 如果蒙层设置的背景颜色或者透明度. 蒙层里面的子集元素将会受到影响: 此时子集元素可能不能注册点击的事件. 因为蒙层将它覆盖住了 2==> 此时 ...

- 【调研】VictoriaMetrics的上报api能否替换prometheus的api?

prometheus的上报api在:https://github.com/prometheus/client_golang VictoriasMetrics的上报API在:https://github ...

- hadoop实践02---eclipse操作hdfs的api上传文件

1.eclipse中编写代码后双击main方法--->Run as ---> java application ,然后指定的文件 就会提交到hdfs中. 2.查看文件:http://192 ...

- Flask 实现Token认证机制

在Flask框架中,实现Token认证机制并不是一件复杂的事情.除了使用官方提供的flask_httpauth模块或者第三方模块flask-jwt,我们还可以考虑自己实现一个简易版的Token认证工具 ...