[Kubernetes]谈谈容器跨主机网络

继上篇文章:[Kubernetes]浅谈容器网络,自己给自己挖的坑,这篇文章来谈谈容器跨主机网络.

要理解容器"跨主通信"的原理,就要来谈谈 Flannel 这个项目.

Flannel 项目是 CoreOS 公司主推的容器网络方案.提供容器网络功能的,分别是: VXLAN , host-gw , UDP .

这三种不同的实现,代表了三种容器跨主机网络的主流实现方法.这里主要讲 VXLAN 和 UDP 模式.

先从 UDP 模式讲起.

- 宿主机 Node 1 上有一个容器 container-1 ,它的 IP 地址是 100.96.1.2 ,对应的 docker0 网桥的地址是: 100.96.1.1/24

- 宿主机 Node 2 上有一个 container-2 , 它的 IP 地址是 100.96.2.3 ,对应的 docker0 网桥的地址是: 100.96.2.1/24

我们现在的任务,就是让 container-1 访问 container-2 .

这种情况下, container-1 容器里的进程发起的 IP 包,其源地址就是 100.96.1.2 , 目的地址就是 100.96.2.3 .由于目的地址 100.96.2.3 并不在 Node 1 的 docker0 网桥的网段里,所以这个 IP 包会被交给默认路由规则,通过容器的网关进入 docker0 网桥,从而出现在宿主机上.

这时候,这个 IP 包的下一个目的地,就取决于宿主机上的路由规则了.此时, Flannel 已经在宿主机上创建出一系列的路由规则,以 Node1 为例,来看一下:

# 在 Node 1 上

$ ip route

default via 10.168.0.1 dev eth0

100.96.0.0/16 dev flannel0 proto kernel scope link src 100.96.1.0

100.96.1.0/24 dev docker0 proto kernel scope link src 100.96.1.1

10.168.0.0/24 dev eth0 proto kernel scope link src 10.168.0.2

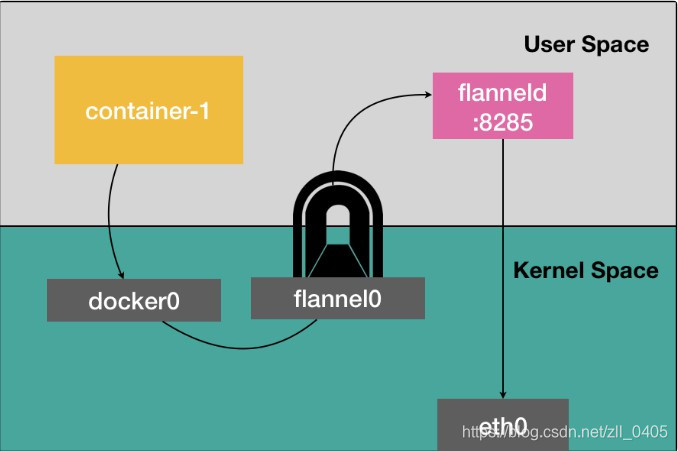

我们能够看到,由于 IP 包的目的地址是 100.96.2.3 ,它现在匹配不到本机 docker0 网桥对应的 100.96.1.0/24 网段,只能匹配到第二条,也就是 100.96.0.0/16 对应的这条路由规则,从而进入到一个叫作 flannel0 的设备中.这个 flannel0 设备是一个 TUN 设备( Tunnel 设备)

在 Linux 中, TUN 设备是一种工作在三层( Network Layer )的虚拟网络设备. TUN 设备的功能非常简单,就是:在操作系统内核和用户应用程序之间传递 IP 包.

此时, IP 包根据路由表进入 flannel0 设备后,宿主机上的 flanneld进程,就会收到这个 IP 包,然后根据目的地址将它发送给 Node2 宿主机.

那么, flanneld 是如何知道这个 IP 地址对应的容器,是运行在 Node2 上面的呢?

在由 Flannel 管理的容器网络中,一台宿主机上的所有容器,都属于该宿主机被分配的一个"子网",在上面举的例子中, Node1 的子网是 100.96.1.0/24 , container-1 的 IP 地址是 100.96.1.2 . Node2 的子网是 100.96.2.0/24 , container-2 的 IP 地址是 100.96.2.3

而这些子网与宿主机的对应关系,保存在 Etcd 中.所以, flanneld 进程在处理 IP 包时,可以根据目的 IP 的地址,匹配到对应的子网,在 Etcd 中找到这个子网对应的宿主机的 IP 地址即可.

当然,这个请求得以完成的原因是,每台宿主机上的 flanneld ,都监听着一个 8285 端口,所以 flanneld 只要把 UDP 包发往 Node2 的 8285 端口即可.接下来就是 flanneld 会直接把这个 IP 包发送给它所管理的 TUN 设备,即 flannel0 设备.,此时 Linux 内核网络栈就会负责处理这个 IP 包,根据相关规则,把这个 IP 包转发给 docker0 网桥.接下来的流程大家就清楚了(如果忘记了,可以再回去看看:[Kubernetes]浅谈容器网络), docker0 网桥会扮演二层交换机的角色,将数据包发送给正确的端口,进而通过 Veth Pair 设备到 container-2 的 Network Namespace 中.

以上就是大概的一个流程.

来一张图,看看会不会理解的更好一些:

我们能够看到, Flannel UDP 模式提供的其实是一个三层的 Overlay 网络,即:它首先对发出端的 IP 包进行 UDP 封装,然后在接收端进行解封装拿到原始的 IP 包,进而把这个 IP 包转发给目标容器.

但是UDP模式有严重的性能问题,相比于两台宿主机之间的直接通信,基于 Flannel UDP 模式的容器通信多了一个额外的步骤,即 flanneld 的处理过程.因为这个过程中,由于使用到了 flannel0 这个 TUN 设备,所以仅仅在发出 IP 包的这个过程中,就需要经过用户态与内核态之间的数据拷贝,具体如下所示:

但是我们在进行系统级编程时,有一个非常重要的优化原则,就是要减少用户态到内核态的切换次数,并且把核心的处理逻辑都放在内核态进行.

基于这个问题,咱们来看看 VXLAN 模式.

VXLAN(即 Virtual Extensible LAN 虚拟可扩展局域网),是 Linux 内核本身就支持的一种网络虚拟化技术,因此 VXLAN 完全可以在内核态上实现上述封装和解封装的工作,从而通过与前面类似的"隧道"机制,构建出覆盖网络( Overlay Network ).

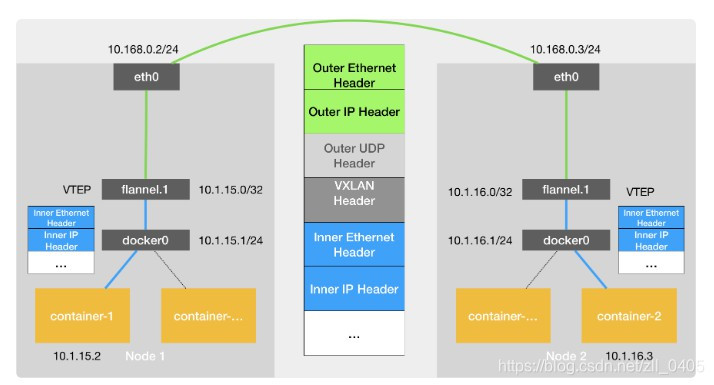

VXLAN 的覆盖网络的设计思想是:在现有的三层网络上,“覆盖"一层虚拟的,由内核 VXLAN 模块负责维护的二级网络,使得连接在这个 VXLAN 二层网络上的"主机”(虚拟机或者容器都可以)之间,可以像在同一个局域网( LAN )里那样自由通信,当然,实际上这些"主机"可能分布在不同的宿主机上,甚至是分布在不同的物理机房里.而为了能够在二层网络上打通"隧道", VXLAN 会在宿主机上设置一个特殊的网络设备作为"隧道"的两端,这个设备就叫作 VTEP(即: VXLAN Tunnel End Point 虚拟隧道端点). VTEP 设备的作用,和 flanneld 进程非常相似,只是它进行封装和解封装的对象,是二层数据帧,并且这个工作的执行流程,是在内核中完成的.来看一下示意图:

图中每台宿主机上名叫 flannel.1 的设备,就是 VXLAN 所需的 VTEP 设备,它既有 IP 地址,也有 MAC 地址.而接下来 Flannel VXLAN 模式的具体工作方式,就和实际网络中工作的方式差不多了.

VXLAN 模式组建的覆盖网络,其实就是一个由不同宿主机上的 VTEP 设备,也就是 flannel.1 设备组成的虚拟二层网络,对于 VTEP 设备来说,它发出的"内部数据帧"就仿佛是一直在这个虚拟的二层网络上流动一样,而这也正是「覆盖网络」的含义.

以上内容来自我学习<深入剖析Kubernetes>专栏文章之后的一些见解,有偏颇之处,还望指出.

感谢您的阅读~

[Kubernetes]谈谈容器跨主机网络的更多相关文章

- centos7下安装docker(15.5容器跨主机网络--flanneld)

flannel是由CoreOS研究的一种覆盖网络(overlay network)网络工具,目的是帮助每一个host主机有一个完整的子网: 功能是:让集群中不同节点的主机创建的容器都有一个唯一的虚拟I ...

- docker容器跨主机网络overlay

前提:已部署好docker服务服务预计部署情况如下10.0.0.134 Consul服务10.0.0.135 host1 主机名mcw510.0.0.134 host2 主机名mcw6host1与 ...

- centos7下安装docker(15.7容器跨主机网络---calico)

Calico是一个纯三层的虚拟网络方案,Calico为每个容器分配一个IP,每个host都是router,把不同host的容器连接起来.与vxlan不同的是:calico不对数据包进行封装,不需要NA ...

- 跨主机网络概述 - 每天5分钟玩转 Docker 容器技术(48)

前面已经学习了 Docker 的几种网络方案:none.host.bridge 和 joined 容器,它们解决了单个 Docker Host 内容器通信的问题.本章的重点则是讨论跨主机容器间通信的方 ...

- 安装docker跨主机网络flannel

一.实验环境 机器 操作系统 安装服务 172.16.4.36 centos7 docker etcd flannel 172.16.4.37 centos7 docker etcd flanne ( ...

- Docker跨主机网络——overlay

前言 在Docker网络--单host网络一文中,我为大家总结了Docker的单机网络相关知识和操作,单机网络比较容易.本文我为大家总结Docker跨主机通信相关知识.同样本文大部分内容以CloudM ...

- Docker 网络管理及容器跨主机通信

1.网络模式 docker支持四种网络模式,使用--net选项指定: host,--net=host,如果指定此模式,容器将不会获得一个独立的network namespace,而是和宿主机共用一个. ...

- centos7下安装docker(15.2跨主机网络-overlay)

为支持容器跨主机通信,Docker提供了overlay driver,使用户可以创建基于VxLAN的overlay网络.VxLAN可将二层数据封装到UDP进行传输,VxLAN提供与VLAN相同的以太网 ...

- overlay实现容器跨主机通信

本节内容: Docker容器跨主机通信方案 环境信息 升级内核 安装docker 防火墙设置和开启内核转发 安装启动consul 启动Docker 创建overlay network 创建容器 测试容 ...

随机推荐

- Appium 客户端类库

Appium 支持以下语言的客户端类库: 语言 Ruby Python Java JavaScript PHP C# Objective-C 锁定注意,一些方法类似 endTestCoverage() ...

- 2019-04-05 Spring Boot学习记录

1. 使用步骤 ① 在pom.xml 增加父级依赖(spring-boot-starter-parent) ② 增加项目起步依赖,如spring-boot-starter-web ③ 配置JDK版本插 ...

- servlet(2)servlet过滤器

1.servlet过滤器 用于动态的拦截servlet请求或响应,以变更或使用其中的信息. (1)过滤器和servlet是多对多的关系,即一个过滤器可以用于一个或多个servlet,多个过滤器也可以用 ...

- Cnblogs美化总结

测试 扩展阅读 [转载]详谈如何定制自己的博客园皮肤 - 云+社区 - 腾讯云谢谢!! [PS]3步搞定博客园界面风格 - nowgood - 博客园 [分享]博客美化(6)为你的博文自动添加目录 - ...

- 分别使用POI和JXL导出数据到Excel

1.使用POI 引入jar包 <!-- poi HSSF is our port of the Microsoft Excel 97(-2007) file format (BIFF8) to ...

- 用video标签流式加载

video标签 浏览器的video标签通常是接收一个src属性,然后浏览器就会根据这个src属性来自动加载视频.这个过程是浏览器来加载video的. 这种方式有什么问题吗? mp4文件不能流式加载 w ...

- maven私服nexus清理释放磁盘空间

应用背景: 自建的maven私服(或者叫私仓)nexus在使用过程中,因很多服务不断迭代更新上传jar包至nexus中,底层存放在一个叫Blob Stores的存储中,最近发现该存储已增大至好几百G, ...

- OpenLayers学习笔记(十一)— 飞机速度矢量线预测

在机场使用的空管系统中,飞机的速度矢量线差不多是这样的: 模拟飞机飞行时的速度矢量线,这里就大概做个类似效果: 什么叫速度矢量线呢,个人理解就是根据飞机当前速度和航向预测它在未来一段时间内的飞机轨迹, ...

- noi.ac89A 电梯

题目 思路 首先按照\(t\)排序!!!! 首先考虑一个暴力\(dp\) 用\(f[i]\)表示前\(i\)个人到达地点所需要的时间. 那么就有如下的转移 \[f_i = min_{1 \le j \ ...

- 关于vue-router 中参数传递的那些坑(params,query)

1.query方式传参和接受参数 传参 this.$router.push({ path:'/xxx' query:{ idname:id } })接收的方式:this.$route.query.id ...