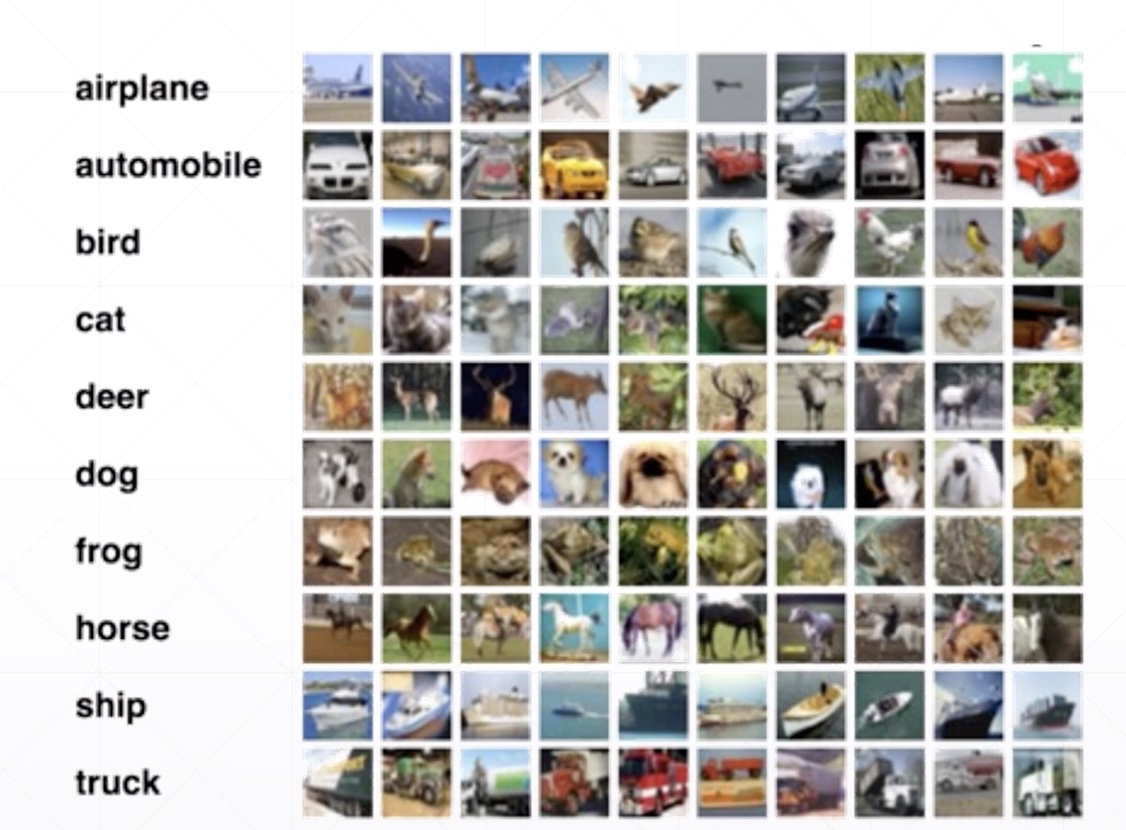

CIFAR10自定义网络实战

CIFAR10

MyDenseLayer

import os

import tensorflow as tf

from tensorflow.keras import datasets, layers, optimizers, Sequential, metrics

from tensorflow import keras

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

def preprocess(x, y):

# [0, 255] --> [-1,1]

x = 2 * tf.cast(x, dtype=tf.float32) / 255. - 1

y = tf.cast(y, dtype=tf.int32)

return x, y

batch_size = 128

# x --> [32,32,3], y --> [10k, 1]

(x, y), (x_val, y_val) = datasets.cifar10.load_data()

y = tf.squeeze(y) # [10k, 1] --> [10k]

y_val = tf.squeeze(y_val)

y = tf.one_hot(y, depth=10) # [50k, 10]

y_val = tf.one_hot(y_val, depth=10) # [10k, 10]

print('datasets:', x.shape, y.shape, x_val.shape, y_val.shape, x.min(),

x.max())

train_db = tf.data.Dataset.from_tensor_slices((x, y))

train_db = train_db.map(preprocess).shuffle(10000).batch(batch_size)

test_db = tf.data.Dataset.from_tensor_slices((x_val, y_val))

test_db = test_db.map(preprocess).batch(batch_size)

sample = next(iter(train_db))

print('batch:', sample[0].shape, sample[1].shape)

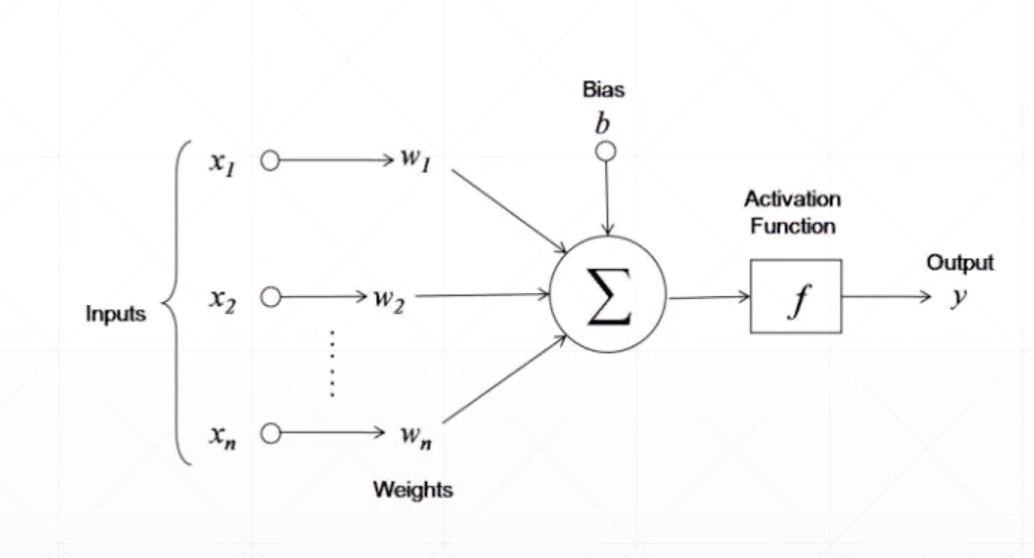

class MyDense(layers.Layer):

# to replace standard layers.Dense()

def __init__(self, inp_dim, outp_dim):

super(MyDense, self).__init__()

self.kernel = self.add_variable('w', [inp_dim, outp_dim])

# self.bias = self.add_variable('b', [outp_dim])

def call(self, inputs, training=None):

x = inputs @ self.kernel

return x

class MyNetwork(keras.Model):

def __init__(self):

super(MyNetwork, self).__init__()

self.fc1 = MyDense(32 * 32 * 3, 256)

self.fc2 = MyDense(256, 128)

self.fc3 = MyDense(128, 64)

self.fc4 = MyDense(64, 32)

self.fc5 = MyDense(32, 10)

def call(self, inputs, training=None):

"""inputs: [b,32,32,32,3]"""

x = tf.reshape(inputs, [-1, 32 * 32 * 3])

# [b,32*32*32] --> [b, 256]

x = self.fc1(x)

x = tf.nn.relu(x)

# [b, 256] --> [b,128]

x = self.fc2(x)

x = tf.nn.relu(x)

# [b, 128] --> [b,64]

x = self.fc3(x)

x = tf.nn.relu(x)

# [b, 64] --> [b,32]

x = self.fc4(x)

x = tf.nn.relu(x)

# [b, 32] --> [b,10]

x = self.fc5(x)

return x

network = MyNetwork()

network.compile(optimizer=optimizers.Adam(lr=1e-3),

loss=tf.losses.CategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

network.fit(train_db, epochs=5, validation_data=test_db, validation_freq=1)

network.evaluate(test_db)

network.save_weights('weights.ckpt')

del network

print('saved to ckpt/weights.ckpt')

network = MyNetwork()

network.compile(optimizer=optimizers.Adam(lr=1e-3),

loss=tf.losses.CategoricalCrossentropy(from_logits=True),

metircs=['accuracy'])

network.fit(train_db, epochs=5, validation_data=test_db, validation_freq=1)

network.load_weights('weights.ckpt')

print('loaded weights from file.')

network.evaluate(test_db)

datasets: (50000, 32, 32, 3) (50000, 10) (10000, 32, 32, 3) (10000, 10) 0 255

batch: (128, 32, 32, 3) (128, 10)

Epoch 1/5

391/391 [==============================] - 7s 19ms/step - loss: 1.7276 - accuracy: 0.3358 - val_loss: 1.5801 - val_accuracy: 0.4427

Epoch 2/5

391/391 [==============================] - 7s 18ms/step - loss: 1.5045 - accuracy: 0.4606 - val_loss: 1.4808 - val_accuracy: 0.4812

Epoch 3/5

391/391 [==============================] - 6s 17ms/step - loss: 1.3919 - accuracy: 0.5019 - val_loss: 1.4596 - val_accuracy: 0.4921

Epoch 4/5

391/391 [==============================] - 7s 18ms/step - loss: 1.3039 - accuracy: 0.5364 - val_loss: 1.4651 - val_accuracy: 0.4950

Epoch 5/5

391/391 [==============================] - 6s 16ms/step - loss: 1.2270 - accuracy: 0.5622 - val_loss: 1.4483 - val_accuracy: 0.5030

79/79 [==============================] - 1s 11ms/step - loss: 1.4483 - accuracy: 0.5030

saved to ckpt/weights.ckpt

Epoch 1/5

391/391 [==============================] - 7s 19ms/step - loss: 1.7216 - val_loss: 1.5773

Epoch 2/5

391/391 [==============================] - 10s 26ms/step - loss: 1.5010 - val_loss: 1.5111

Epoch 3/5

391/391 [==============================] - 8s 21ms/step - loss: 1.3868 - val_loss: 1.4657

Epoch 4/5

391/391 [==============================] - 8s 20ms/step - loss: 1.3021 - val_loss: 1.4586

Epoch 5/5

391/391 [==============================] - 7s 17ms/step - loss: 1.2276 - val_loss: 1.4583

loaded weights from file.

79/79 [==============================] - 1s 12ms/step - loss: 1.4483

1.4482733222502697CIFAR10自定义网络实战的更多相关文章

- Docker单机网络实战

前言 Docker系列文章: 此篇是Docker系列的第八篇,大家一定要按照我做的Demo都手敲一遍,印象会更加深刻的,加油! 为什么要学习Docker Docker基本概念 Docker镜像基本原理 ...

- 卷积神经网络特征图可视化(自定义网络和VGG网络)

借助Keras和Opencv实现的神经网络中间层特征图的可视化功能,方便我们研究CNN这个黑盒子里到发生了什么. 自定义网络特征可视化 代码: # coding: utf-8 from keras.m ...

- SpringBoot2.x过滤器Filter和使用Servlet3.0配置自定义Filter实战

补充:SpringBoot启动日志 1.深入SpringBoot2.x过滤器Filter和使用Servlet3.0配置自定义Filter实战(核心知识) 简介:讲解SpringBoot里面Filter ...

- [docker]docker自带的overlay网络实战

overlay网络实战 n3启动consul docker run -d -p 8500:8500 -h consul --name consul progrium/consul -server -b ...

- Docker 自定义网络

1.创建自定义网络 docker network create -d bridge --subnet 172.25.0.0/16 network_name 2.redis docker 添加到网络 d ...

- docker-compose 使用自定义网络并绑定 IP

0x00 事件 原先使用了 docker network create mynetwork 的方式创建了自定义网络,在使用 docker-compose 工具运行服务的时候,需要容器使用 mynetw ...

- Docker-Bridge Network 03 自定义网络

本节介绍自定义bridge network的自定义网络. 1.前言2.创建自定义网络2.1 创建网络2.2 指定网段创建网络3.创建容器3.1 指定网络创建容器3.2 指定IP创建容器4.通信4.1 ...

- Docker系列(28)- 自定义网络

自定义网络 网络模式 bridge:桥接docker(默认,自己创建也可以使用bridge模式) none:不配置网络 host:和宿主机共享网络 container:容器网络联通!(用的少!局限性大 ...

- 云计算和大数据时代网络技术揭秘(十二)自定义网络SDN

软件定义网络——SDN SDN是网络技术热点,即软件定义网络,OpenFlow是实现SDN思想的一个框架标准, open是指公开.开放,具体为控制平面的规则由各个通信厂家自定义变为公开的技术标准, f ...

随机推荐

- Html5培训之精髓

一.核心技术(可去各技术官网学习) 1.html5的六大核心技术:Html5,CSS3,JavaScript,WebSocket,PhoneGap,Node.js,它们覆盖了设备端,浏览器端和云端的开 ...

- 处理页面载入图片js(等比例压缩图片)

第一页面html <div class="admin">${answer.content}</div> <div class="admin ...

- ubuntu 用shell脚本实现将当前文件夹下全部文件夹中的某一类文件复制到同一文件夹下

当前文件夹下有一些文件和文件夹,当中每一个文件夹里都有若干.txt文件. 如今要求在当前文件夹创建一个新文件夹all,且将那些文件夹全部.txt文件 都复制到文件夹all.在ubuntu12.04的s ...

- 李洪强iOS开发之- 点击屏幕遮挡键盘

李洪强iOS开发之- 点击屏幕遮挡键盘 实现的效果: 01 - 给当前的view添加点击事件,使点击屏幕的时候,让键盘退出 /** * 点击屏幕 隐藏键盘 * * @param tap */-(vo ...

- android自己定义开关控件

近日在android项目要使用开关控件.可是android中自带的开关控件不太惬意,所以就打算通过自己定义View写一个开关控件 ios的开关控件当然就是我要仿照的目标. 先上图: waterma ...

- Xamarin.Android 记事本(二)自定义AlertDialog

导读 1.自定义一个AlertDialog 2.添加一条数据 正文 记事本应当有一个添加功能,这里我打算在右上角放一个item,然后点击这个item弹出一个对话框,输入名称,点击确定跳转到另一个act ...

- Spark理论学习笔记(一)

1.调度 分为FIFO和FAIR两种模式 创建调度池:sc.setLocalProperty("spark.scheduler.pool", "pool6") ...

- redis06----消息订阅

使用办法: 订阅端: Subscribe 频道名称 发布端: publish 频道名称 发布内容 r1:>publish news "aaaaaa" "" ...

- Spark基本原理

仅作<Spark快速大数据分析>学习笔记 定义:Spark是一个用来实现 快速 而 通用 的集群计算平台:(通用的大数据处理引擎:) 改进了原Hadoop MapReduce处理模型,体现 ...

- Linux 高精度定时器hrtimer 使用示例【转】

本文转载自:http://blog.csdn.net/dean_gdp/article/details/25481225 hrtimer的基本操作 Linux的传统定时器通过时间轮算法实现(timer ...