python爬取数据保存到Excel中

# -*- conding:utf-8 -*- # 1.两页的内容

# 2.抓取每页title和URL

# 3.根据title创建文件,发送URL请求,提取数据

import requests

from lxml import etree

import time, random, xlwt # 专家委员会成员的xpath(‘//tbody//tr[@height='29']’) class Doc_spider(object): def __init__(self):

self.base_url = 'http://www.bjmda.com'

self.url = 'http://www.bjmda.com/Aboutus/ShowClass.asp?ClassID=12&page={}'

self.headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'} def get_request(self, url):

'''发送请求,返回html'''

response = requests.get(url, headers=self.headers).content.decode('gbk')

# time.sleep(random.random())

html = etree.HTML(response)

return html def parse_page_html(self, html, url):

'''提取列表页的专家委员会title和URL''' url_lists = html.xpath('//tr/td[2]/a[2]/@href')[1:]

temp_lists = html.xpath('//tr/td[2]/a[2]/text()')[1:]

title_lists = [title.rstrip() for title in temp_lists] urls = []

titles = [] for i in range(len(title_lists)):

url = self.base_url + url_lists[i]

title = title_lists[i]

urls.append(url)

titles.append(title) return urls, titles def parse_detail(self, html):

'''详细页的提取数据,返回每组列表信息''' lists = html.xpath("//td[@id='fontzoom']//tr")

content_list = []

for list in lists:

contents = list.xpath('.//td//text()')

new = []

for i in contents:

new.append(''.join(i.split()))

content_list.append(new) return content_list def save_excel(self, sheet_name, contents, worksheet, workbook):

'''保存数据到Excel''' # 创建一个workbook 设置编码

#workbook = xlwt.Workbook()

# 创建一个worksheet

#worksheet = workbook.add_sheet(sheet_name) try: for i in range(len(contents)):

if len(contents[i+1])>1:

content_list = contents[i + 1] # 写入excel

# 参数对应 行, 列, 值

worksheet.write(i, 0, label=content_list[0])

worksheet.write(i, 1, label=content_list[1])

worksheet.write(i, 2, label=content_list[2])

if len(contents[i+1])>3:

worksheet.write(i, 3, label=content_list[3]) # 保存

#workbook.save(sheet_name + '.xls')

# time.sleep(0.1)

except:

print(sheet_name,'保存OK') pass def run(self):

# 1.发送专家委员会列表页请求

urls = [self.url.format(i + 1) for i in range(2)] # 创建一个workbook 设置编码

workbook = xlwt.Workbook() for url in urls:

html = self.get_request(url)

# 2.提取委员会的title和URL

list_urls, titles = self.parse_page_html(html, url) for i in range(len(list_urls)):

url_detail = list_urls[i]

# 每个委员会的名称

title_detail = titles[i]

# 3.创建每个委员会文件,发送每个委员会的请求

html_detail = self.get_request(url_detail)

# 4.提取专家委员会详细页的内容

contents = self.parse_detail(html_detail)

# 保存每个委员会的所有人 # 创建一个worksheet

worksheet = workbook.add_sheet(title_detail)

self.save_excel(title_detail, contents,worksheet,workbook)

workbook.save('专家委员会.xls')

print('保存结束,请查看') if __name__ == '__main__':

doc = Doc_spider()

doc.run()

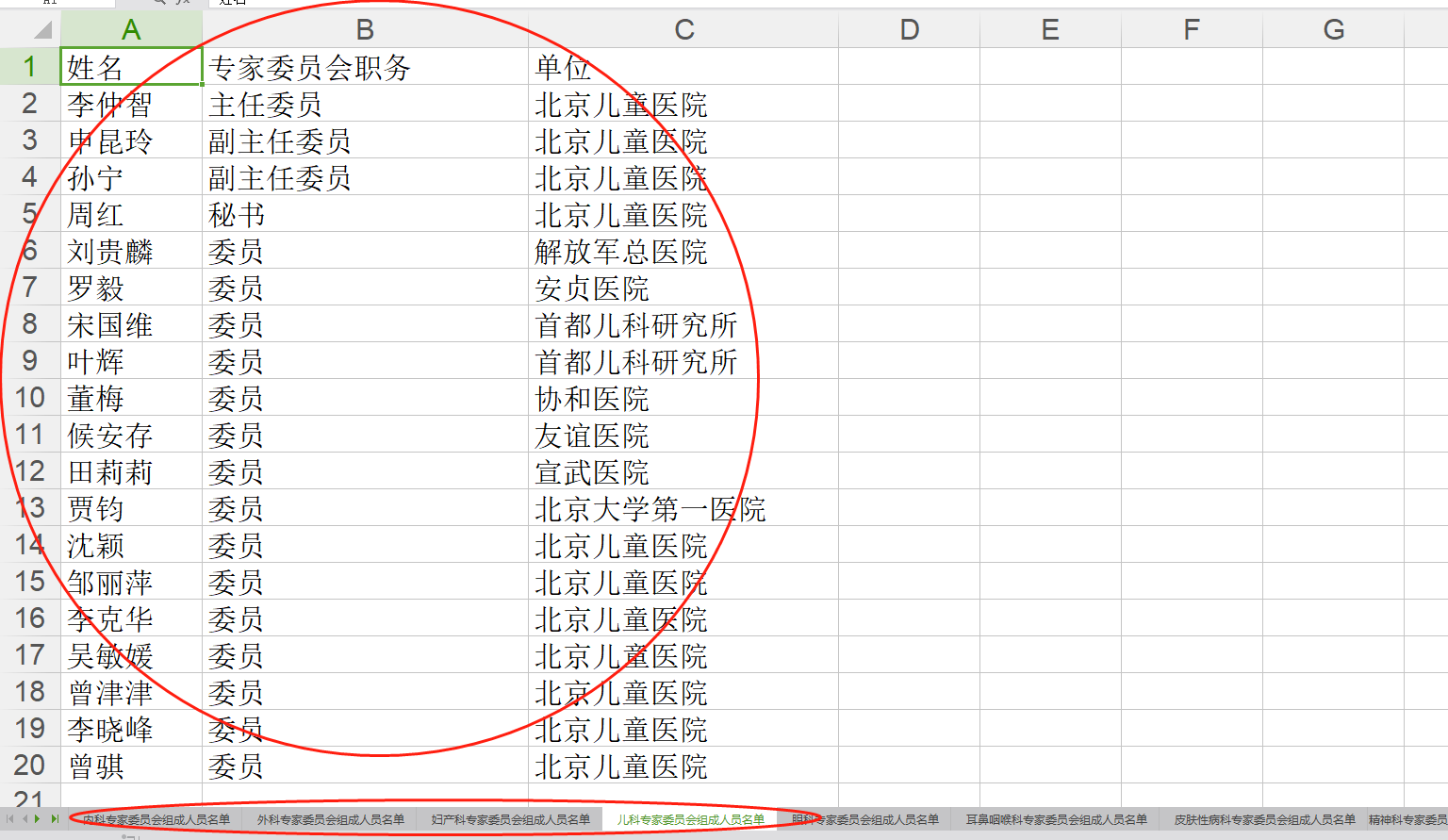

这个小程序可以爬取该网站的医生专家的信息,分不同的专科保存到同一个Excel中。

# -*- conding:utf-8 -*- import xlwt # 创建工作workbook

workbook = xlwt.Workbook() # 创建工作表worksheet,填入表名

worksheet = workbook.add_sheet('表名') # 在表中写入相应的数据

worksheet.write(0, 0, 'hello world')

worksheet.write(1, 1, '你好') # 保存表

workbook.save('hello.xls')

python爬取数据保存到Excel中的更多相关文章

- 「拉勾网」薪资调查的小爬虫,并将抓取结果保存到excel中

学习Python也有一段时间了,各种理论知识大体上也算略知一二了,今天就进入实战演练:通过Python来编写一个拉勾网薪资调查的小爬虫. 第一步:分析网站的请求过程 我们在查看拉勾网上的招聘信息的时候 ...

- python之scrapy爬取数据保存到mysql数据库

1.创建工程 scrapy startproject tencent 2.创建项目 scrapy genspider mahuateng 3.既然保存到数据库,自然要安装pymsql pip inst ...

- 关于爬取数据保存到json文件,中文是unicode解决方式

流程: 爬取的数据处理为列表,包含字典.里面包含中文, 经过json.dumps,保存到json文件中, 发现里面的中文显示未\ue768这样子 查阅资料发现,json.dumps 有一个参数.ens ...

- 将爬取的数据保存到mysql中

为了把数据保存到mysql费了很多周折,早上再来折腾,终于折腾好了 安装数据库 1.pip install pymysql(根据版本来装) 2.创建数据 打开终端 键入mysql -u root -p ...

- 1.scrapy爬取的数据保存到es中

先建立es的mapping,也就是建立在es中建立一个空的Index,代码如下:执行后就会在es建lagou 这个index. from datetime import datetime fr ...

- Excel文件数据保存到SQL中

1.获取DataTable /// <summary> /// 查询Excel文件中的数据 /// </summary> /// <param name="st ...

- c# 抓取和解析网页,并将table数据保存到datatable中(其他格式也可以,自己去修改)

使用HtmlAgilityPack 基础请参考这篇博客:https://www.cnblogs.com/fishyues/p/10232822.html 下面是根据抓取的页面string 来解析并保存 ...

- Sql数据保存到Excel文件中

public string ExportExcel( DataSet ds,string saveFileName) { try { if (ds == null) return "数据库为 ...

- 爬取伯乐在线文章(四)将爬取结果保存到MySQL

Item Pipeline 当Item在Spider中被收集之后,它将会被传递到Item Pipeline,这些Item Pipeline组件按定义的顺序处理Item. 每个Item Pipeline ...

随机推荐

- P4097 [HEOI2013]Segment

传送门 简单来说就是对于每条线段,先把它拆成\(O(logn)\)条,然后对于每一条再\(O(logn)\)判断在所有子区间的优劣程度 //minamoto #include<bits/stdc ...

- QRCoder生成二维码

现在二维码支付越来越流行,二维码使用的地方越来越多,项目中也需要一个二维码生成工具,QRCoder是一个简单的生成二维码的库,用C#.NET编写,他是开源的MIT-license. 二维码简介 二维条 ...

- JSP/Servlet Web应用中.properties文件的放置与读取

本地项目 在本地类库中,我经常使用当前目录来放置.properties文件,这时调用方只要引用我的jar,并且将我的.properties放在他的classpath里面即可,比如: p.load(ne ...

- IDEA 提示Cannot resolve symbol

将Springboot项目,构建为多个模块的时候,idea的有些类中报错Cannot resolve symbol 解决: 1.File->Invalidate Caches/Restart 清 ...

- Android开发笔记(3)——GridLayout

笔记链接:http://www.cnblogs.com/igoslly/p/6799939.html GirdLayout 计算器实例及详尽的笔记:http://www.cnblogs.com/sky ...

- [Windows Server 2008] IP安全策略限制端口方法

★ 欢迎来到[护卫神·V课堂],网站地址:http://v.huweishen.com ★ 护卫神·V课堂 是护卫神旗下专业提供服务器教学视频的网站,每周更新视频. ★ 本节我们将带领大家:限制143 ...

- (转)Hibernate框架基础——映射普通属性

http://blog.csdn.net/yerenyuan_pku/article/details/52739871 持久化对象与OID 对持久化对象的要求 提供一个无参的构造器.使Hibernat ...

- autocad 注册表

序号 版本号1 版本号2 描述 1 R15.0 1:804 2002中文版 2 R15.0 1:409 2002英文版 3 R16.0 201:804 2004中文版 4 R16.0 201:409 ...

- ThinkPHP---thinkphp实用项

[一]代码调试 (1)跟踪信息 ①简介:用于展示系统执行的相关状况,类似于快递的物流信息.ThinkPHP中默认关闭.如需使用,则通过配置项SHOW_PAGE_TRACE(显示页面跟踪)来配置. ②位 ...

- luogu P4172 [WC2006]水管局长 LCT维护动态MST + 离线

Code: #include<bits/stdc++.h> #define maxn 1200000 #define N 120000 using namespace std; char ...