Neural Networks and Deep Learning 课程笔记(第二周)神经网络的编程基础 (Basics of Neural Network programming)

总结

一、处理数据

1.1 向量化(vectorization)

- (height, width, 3) ===> 展开shape为(heigh*width*3, m)的向量

1.2 特征归一化(Normalization)

- 一般数据,使用标准化(Standardlization), z(i) = (x(i) - mean) / delta,mean与delta代表X的均值和标准差,最终特征处于【-1,1】区间

- 对于图片,可直接使用 Min-Max Scaliing,即将每个特征直接除以 255,使值处于 【-1,1】之间

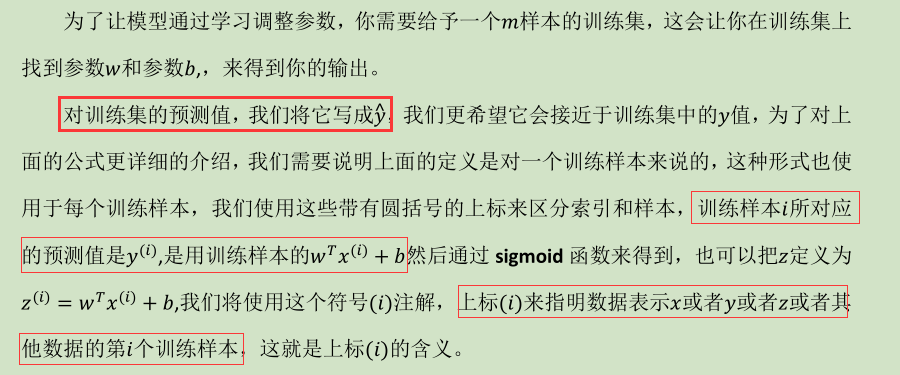

二、初始化参数

- 一般将w 和 b随机初始化。这里用逻辑回归思想,设为0

三、梯度下降(Gradient descent)

- 根据w, b和训练集,来训练数据。需要设定迭代次数与learning rate α

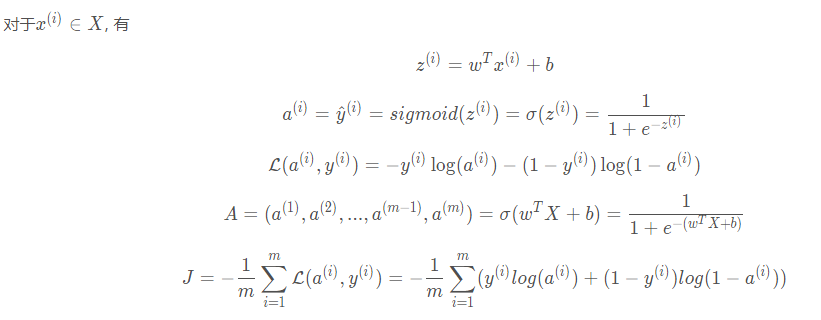

3.1 计算代价函数(前向传播)

# 激活函数

A = sigmoid(w.T.dot(X) + b)

# 代价函数

cost = -np.sum(Y * np.log(A) + (1-Y) * np.log(1 - A)) / m

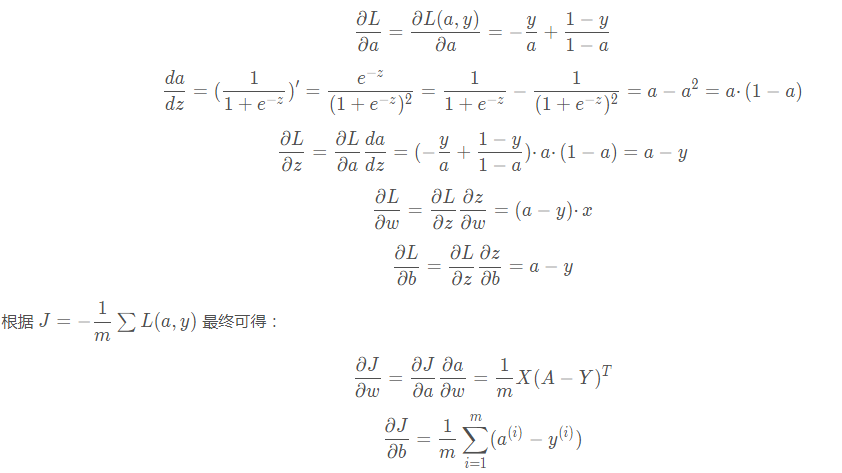

3.2 反向传播计算梯度

dw = X.dot((A - Y).T) / m

db = np.sum(A - Y) / m

3.3 更新参数(w, b)

w = w - learning_rate * dw

b = b - learning_rate * db

四、预测测试集

- 用训练好的模型(训练后的参数w, b),对测试集使用 y_hat = sigmoid(wx + b),计算预测结果的概率( np.round(y_hat)))

详细内容

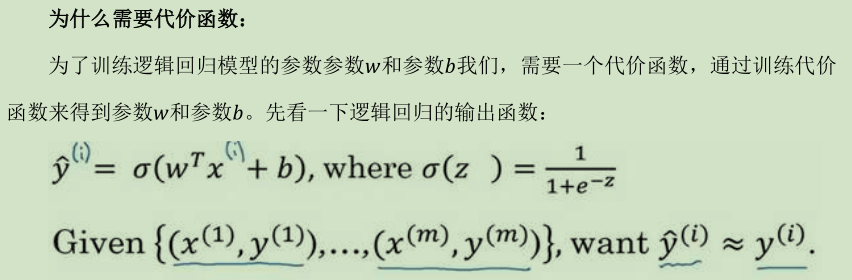

逻辑回归

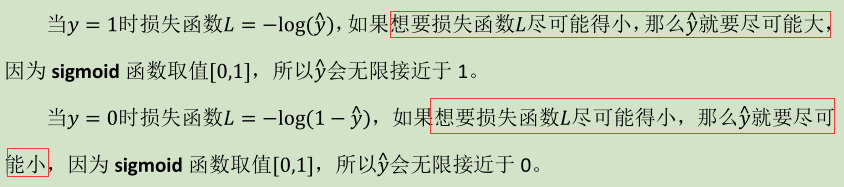

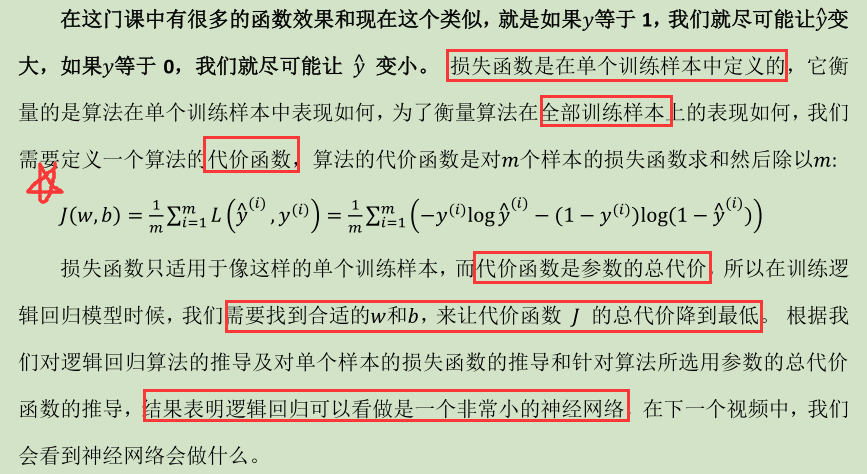

(1) 逻辑回归的代价函数(Logistic Regression Cost Function )

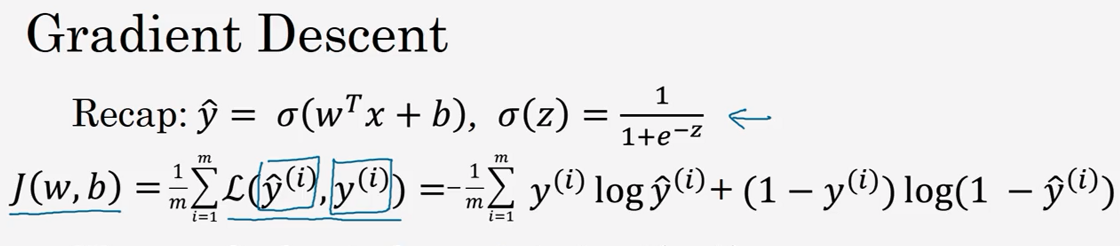

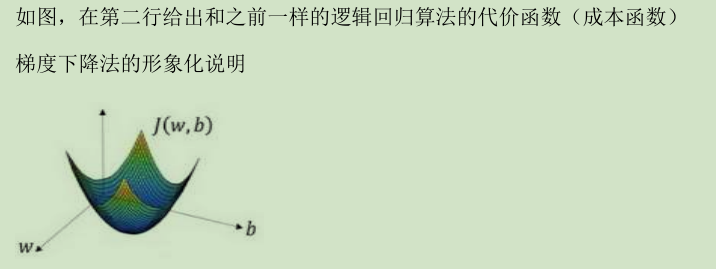

(2) 梯度下降法(Gradient Descent )

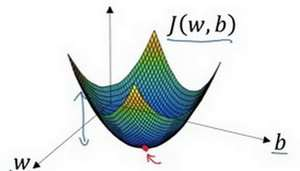

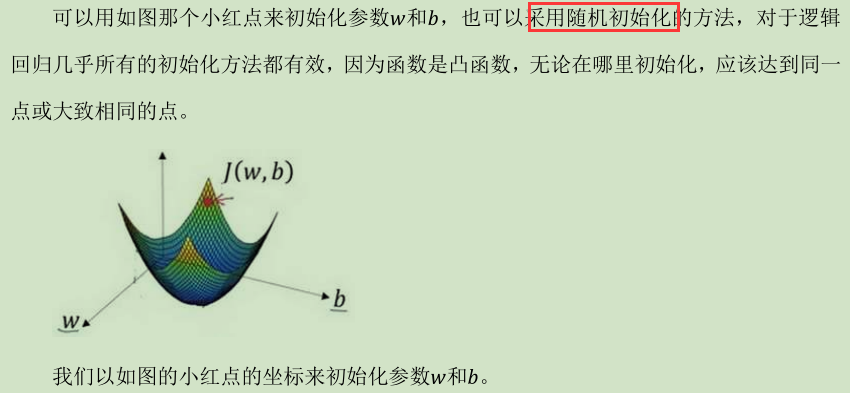

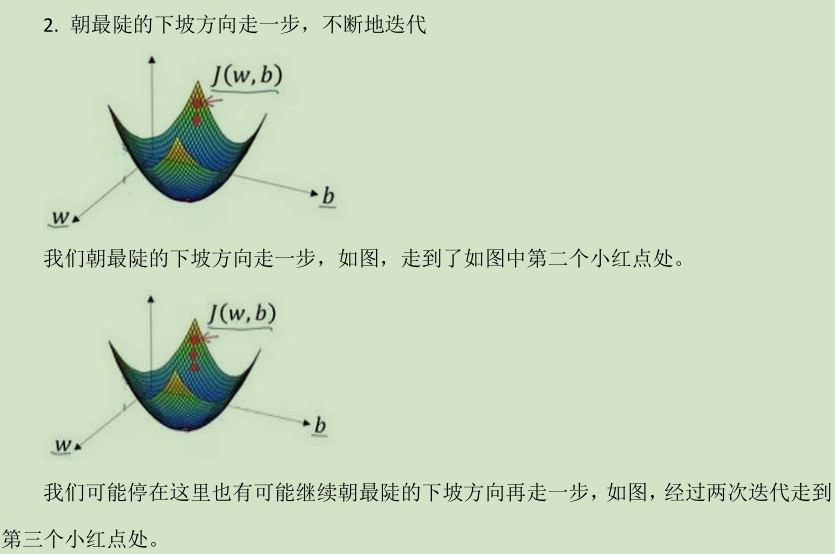

在你测试集上,通过最小化代价函数(成本函数)J(w,b)来训练的参数 w 和 b

假定代价函数(成本函数)J(

Neural Networks and Deep Learning 课程笔记(第二周)神经网络的编程基础 (Basics of Neural Network programming)的更多相关文章

- Neural Networks and Deep Learning 课程笔记(第四周)深层神经网络(Deep Neural Networks)

1. 深层神经网络(Deep L-layer neural network ) 2. 前向传播和反向传播(Forward and backward propagation) 3. 总结 4. 深层网络 ...

- Neural Networks and Deep Learning 课程笔记(第三周)浅层神经网络(Shallow neural networks)

3.1 神经网络概述(Neural Network Overview ) (神经网络中,我们要反复计算a和z,最终得到最后的loss function) 3.2 神经网络的表示(Neural Netw ...

- Neural Networks and Deep Learning学习笔记ch1 - 神经网络

近期開始看一些深度学习的资料.想学习一下深度学习的基础知识.找到了一个比較好的tutorial,Neural Networks and Deep Learning,认真看完了之后觉得收获还是非常多的. ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第四周:深层神经网络(Deep Neural Networks)-课程笔记

第四周:深层神经网络(Deep Neural Networks) 4.1 深层神经网络(Deep L-layer neural network) 有一些函数,只有非常深的神经网络能学会,而更浅的模型则 ...

- 课程一(Neural Networks and Deep Learning),第三周(Shallow neural networks)—— 3.Programming Assignment : Planar data classification with a hidden layer

Planar data classification with a hidden layer Welcome to the second programming exercise of the dee ...

- 课程一(Neural Networks and Deep Learning),第三周(Shallow neural networks)—— 0、学习目标

Learn to build a neural network with one hidden layer, using forward propagation and backpropagation ...

- 课程一(Neural Networks and Deep Learning),第三周(Shallow neural networks)—— 2、Practice Questions

1.以下哪一项是正确的?(检查所有适用的) (A,D,F,G) A. a[2] 表示第二层的激活函数值向量. B. X 是一个矩阵, 其中每一行都是一个训练示例. C. a[2] (12) 表示第二 ...

- 课程一(Neural Networks and Deep Learning),第三周(Shallow neural networks)—— 1、两层神经网络的单样本向量化表示与多样本向量化表示

如上图所示的两层神经网络, 单样本向量化: ...

- 吴恩达深度学习笔记1-神经网络的编程基础(Basics of Neural Network programming)

一:二分类(Binary Classification) 逻辑回归是一个用于二分类(binary classification)的算法.在二分类问题中,我们的目标就是习得一个分类器,它以对象的特征向量 ...

随机推荐

- Vue的router使用

<div id="app"> <router-link to="/home">home</router-link> < ...

- (一) 关于配置travis-ci持续集成python pytest测试的相关记录

首先由于公司用上了高大上的travis-ci商用版,一直想试着学学弄弄看.现在要写openapi的相关测试,而且要在travis-ci上集成.我就想体验一下这个过程.所以自己弄了一个public的仓库 ...

- grep 匹配打印的上下几行

如果在只是想匹配模式的上下几行,grep可以实现. $grep -5 'parttern' inputfile //打印匹配行的前后5行 $grep -C 5 'parttern' input ...

- 《使用swoole》

第一 在windows系统搭建swoole环境: 首先,安装cygwin:步骤截图如下 其次,使用cygwin安装swoole: 打开cygwin的终端,进入~目录,并将swoole-src上传到~目 ...

- 常见的HTTP报头(头参数)

本内容摘抄自<RESTful WebServices> 中文译本附录C '常见的HTTP报头'. 原文作者:Leonard Ricbardson & Sam Ruby 翻译:徐涵. ...

- python之tkinter使用-Grid(网格)布局管理器

# 使用tkinter编写登录窗口 # Grid(网格)布局管理器会将控件放置到一个二维的表格里,主控件被分割为一系列的行和列 # stricky设置对齐方式,参数N/S/W/E分别表示上.下.左.右 ...

- codeforces580C

Kefa and Park CodeForces - 580C 一棵以1为根的树,树上有些点是红的.一个叶子是合法的当且仅当从根到它的路径上出现的连续红点个数不超过m.求有多少个叶子是合法的.Inpu ...

- Windows 下vim的配置文件_vimrc

set nocompatible source $VIMRUNTIME/vimrc_example.vim source $VIMRUNTIME/mswin.vim behave mswin set ...

- BZOJ1131[POI2008]Sta——树形DP

题目描述 给出一个N个点的树,找出一个点来,以这个点为根的树时,所有点的深度之和最大 输入 给出一个数字N,代表有N个点.N<=1000000 下面N-1条边. 输出 输出你所找到的点,如果具有 ...

- ACM-ICPC 2018 焦作赛区网络预赛 E Jiu Yuan Wants to Eat (树链剖分+线段树)

题目链接:https://nanti.jisuanke.com/t/31714 题意:给你一棵树,初始全为0,有四种操作: 1.u-v乘x 2.u-v加x 3. u-v取反 4.询问u-v ...