【大数据系列】基于MapReduce的数据处理 SequenceFile序列化文件

为键值对提供持久的数据结构

1、txt纯文本格式,若干行记录

2、SequenceFile

key-value格式,若干行记录,类似于map

3、编写写入和读取的文件

package com.slp; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.SequenceFile;

import org.apache.hadoop.io.SequenceFile.Reader;

import org.apache.hadoop.io.SequenceFile.Writer;

import org.apache.hadoop.io.Text;

import org.junit.Test;

public class TestSequenceFile { @Test

public void write() throws IOException{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://www.node1.com:9000/");

FileSystem fs = FileSystem.get(conf);

Path path = new Path("hdfs://www.node1.com:9000/home/hadoop/seq.seq");

Writer writer = SequenceFile.createWriter(fs, conf, path, IntWritable.class, Text.class);

writer.append(new IntWritable(1), new Text("tom1"));

writer.append(new IntWritable(2), new Text("tom2"));

writer.append(new IntWritable(3), new Text("tom3"));

writer.append(new IntWritable(4), new Text("tom4"));

writer.close();

System.out.println("over");

} @Test

public void readSeq() throws IOException{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://www.node1.com:9000/");

FileSystem fs = FileSystem.get(conf);

Path path = new Path("hdfs://www.node1.com:9000/home/hadoop/seq.seq");

Reader reader = new SequenceFile.Reader(fs, path, conf);

IntWritable key = new IntWritable();

Text value = new Text();

while(reader.next(key, value)){

System.out.println(key+"="+value);

}

reader.close();

}

}测试方法的输出为:

1=tom1

2=tom2

3=tom3

4=tom4

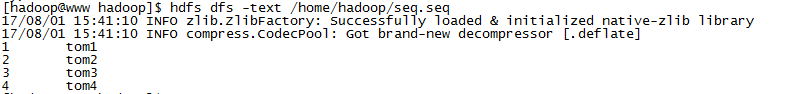

4、查看文件

【大数据系列】基于MapReduce的数据处理 SequenceFile序列化文件的更多相关文章

- 【大数据系列】MapReduce详解

MapReduce是hadoop中的一个计算框架,用来处理大数据.所谓大数据处理,即以价值为导向,对大数据加工,挖掘和优化等各种处理. MapReduce擅长处理大数据,这是由MapReduce的设计 ...

- 【大数据系列】MapReduce示例好友推荐

package org.slp; import org.apache.hadoop.io.LongWritable; import org.apache.hadoop.io.Text; import ...

- 【大数据系列】MapReduce示例一年之内的最高气温

一.项目采用maven构建,如下为pom.xml中引入的jar包 <project xmlns="http://maven.apache.org/POM/4.0.0" xml ...

- 大数据系列之分布式计算批处理引擎MapReduce实践-排序

清明刚过,该来学习点新的知识点了. 上次说到关于MapReduce对于文本中词频的统计使用WordCount.如果还有同学不熟悉的可以参考博文大数据系列之分布式计算批处理引擎MapReduce实践. ...

- 大数据系列之分布式计算批处理引擎MapReduce实践

关于MR的工作原理不做过多叙述,本文将对MapReduce的实例WordCount(单词计数程序)做实践,从而理解MapReduce的工作机制. WordCount: 1.应用场景,在大量文件中存储了 ...

- 大数据系列4:Yarn以及MapReduce 2

系列文章: 大数据系列:一文初识Hdfs 大数据系列2:Hdfs的读写操作 大数据谢列3:Hdfs的HA实现 通过前文,我们对Hdfs的已经有了一定的了解,本文将继续之前的内容,介绍Yarn与Yarn ...

- 大数据系列之并行计算引擎Spark介绍

相关博文:大数据系列之并行计算引擎Spark部署及应用 Spark: Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎. Spark是UC Berkeley AMP lab ( ...

- 大数据系列(2)——Hadoop集群坏境CentOS安装

前言 前面我们主要分析了搭建Hadoop集群所需要准备的内容和一些提前规划好的项,本篇我们主要来分析如何安装CentOS操作系统,以及一些基础的设置,闲言少叙,我们进入本篇的正题. 技术准备 VMwa ...

- 大数据实时处理-基于Spark的大数据实时处理及应用技术培训

随着互联网.移动互联网和物联网的发展,我们已经切实地迎来了一个大数据 的时代.大数据是指无法在一定时间内用常规软件工具对其内容进行抓取.管理和处理的数据集合,对大数据的分析已经成为一个非常重要且紧迫的 ...

随机推荐

- 多媒体开发之h264中的sps---sps信息提取之帧率

------------------------------author:pkf -----------------------------------------time:2015-8-20 --- ...

- Maven使用国内镜像

^_^ <mirrors> <!-- mirror | Specifies a repository mirror site to use instead of a given re ...

- Java虚拟机垃圾收集器与内存分配策略

Java虚拟机垃圾收集器与内存分配策略 概述 那些内存须要回收,什么时候回收.怎样回收是GC须要完毕的3件事情. 程序计数器.虚拟机栈与本地方法栈这三个区域都是线程私有的,内存的分配与回收都具有确定性 ...

- ASP.NET EntityFrameworkCore code first 多对多设计

摘要:参考网址:https://docs.microsoft.com/zh-cn/ef/core/get-started/full-dotnet/new-db场景:使用ASP.NETEntityFra ...

- LVS 实现负载均衡原理及安装配置详解

负载均衡集群是 load balance 集群的简写,翻译成中文就是负载均衡集群.常用的负载均衡开源软件有nginx.lvs.haproxy,商业的硬件负载均衡设备F5.Netscale.这里主要是学 ...

- docker默认ip查询

查询docker ip地址 docker-machine ip default

- scala 日期格式转换

scala> val format = new java.text.SimpleDateFormat("dd-MM-yyyy") 注意MM必须要大写 format: java ...

- Scripting.FileSystemObject对象的详细技巧指南

Scripting.FileSystemObject对象的详细技巧指南 FileSystemObject对象提供对计算机文件系统的访问: powered by 25175.net 在代码内操作文本文件 ...

- Link1123:转换到COFF期间失败:文件无效或损坏

当在编译VS项目时,出现如下错误: 这个错误,表明在连接阶段出错.COFF为Common Object File Format,通用对象文件格式,它的出现为混合语言编程带来方便 ...

- Java时间日期字符串格式转换大全

import java.text.*; import java.util.Calendar; public class VeDate { /** * 获取现在时间 * * @return 返回时间类型 ...