Paper | Non-Local ConvLSTM for Video Compression Artifact Reduction

【这是MFQE 2.0的第一篇引用,也是博主学术生涯的第一篇引用。最重要的是,这篇文章确实抓住了MFQE方法的不足之处,而不是像其他文章,随意改改网络罢了。虽然引的是arXiv版本,但是很开心!欢迎大家引用TPAMI版本!】

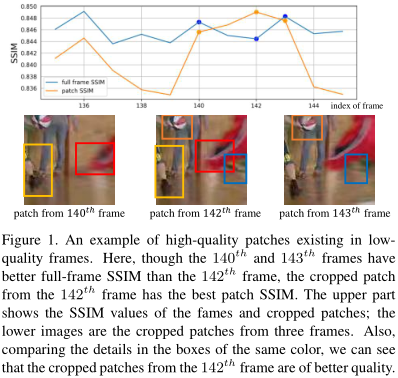

在MFQE的基础上,作者提出了一个问题:“好”帧里的块的质量就好吗?“差”帧里的块的质量就差吗?显然不一定,因为帧的好/坏是由整张图像的综合质量决定的(如PSNR)。

为了解决这个问题,作者提出用non-local结合ConvLSTM的思路。众所周知,NL是很耗时的,因此作者提出了一种近似计算帧间相似性的方法,从而加速NL过程。由于使用了ConvLSTM,因此本方法不再需要精确的MC。

1. 方法

1.1 框图

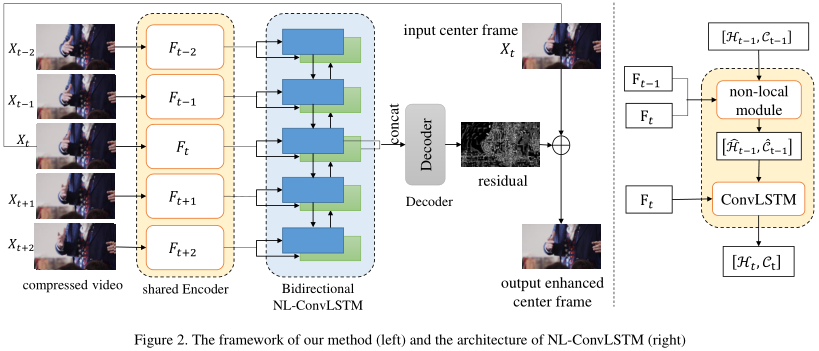

图画得很清楚。这是一个典型的Conv-LSTM,会连续输入多帧的卷积特征。在输出端,当前帧对应的双向隐藏层特征被拼接,进一步处理,最后作为残差与输入相加,即得到输出。

关键在于Conv-LSTM细胞的改进。由于去掉了MC组分,因此如果存在较大的运动位移,LSTM对运动的建模很可能失败。为此,作者引入了NL机制来建模运动位移。但是注意,这里的NL用来捕捉特征图间像素的相似性,而不是特征图内像素的相似性。因此,上一特征图\(F_t\)也要输入NL模块,但不输入Conv-LSTM细胞!

1.2 NL流程

我们具体讲一下改进后Conv-LSTM的工作流程。以下都以单向举例。

首先,ConvLSTM的经典输入输出格式是:输入当前特征图\(F_t\)、上一时刻隐藏层状态\(H_{t-1}\)和上一时刻细胞状态\(C_{t-1}\),输出当前时刻的隐藏层状态\(H_{t}\)和细胞状态\(C_{t}\):

\[

[H_{t}, C_{t}] = \text{ConvLSTM} (F_t, [H_{t-1}, C_{t-1}])

\]

为了让LSTM更好地建模运动位移,尤其是大尺度运动,作者在Conv-LSTM前引入NL技术,但是是特征图间的NL:

\[

S_t = \text{NL} (F_{t-1}, F_{t})

\]

\(S_t\)代表像素相似性,计算公式为:

\[

D_t(i,j) = \Vert F_{t-1} (i) - F_t (j) \Vert_2

\]

\[

S_t(i,j) = \frac{\exp (-D_t(i,j) / \beta)}{\sum_i \exp ((-D_t(i,j) / \beta)}

\]

其中,\(S_t(i,j)\)说的是 \(t-1\)特征图的第\(i\)个元素 与 当前\(t\)特征图的第\(j\)个元素 的相似度。显然要求关于\(i\)求和为1,因此用分母归一化。

NL的第二步,就是基于计算出的相似度,执行扭曲:

\[

[\hat{H}_{t}, \hat{C}_{t}] = \text{NLWarp} ([H_{t-1}, C_{t-1}], S_t)

\]

具体操作很简单:

\[

[\hat{H}_{t}, \hat{C}_{t}] = [\hat{H}_{t-1} \cdot S_t, \hat{C}_{t-1} \cdot S_t]

\]

【论文中的公式(4)有误,时刻写错了?】

1.3 加速版NL

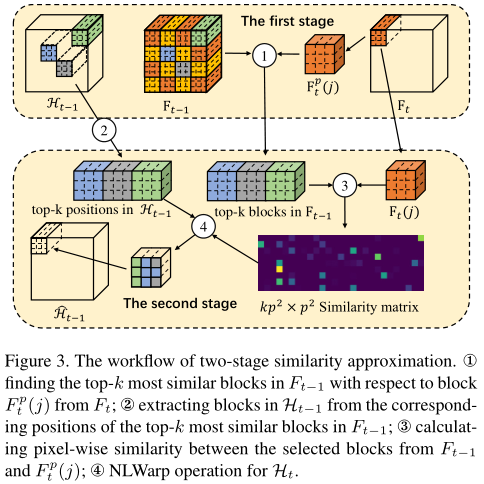

如果严格按照以上步骤算,运动复杂度会很高。为此,作者引入了两步NL方法来近似 欧几里得距离\(D_t\) 和 特征图间像素相似度\(S_t\)。

首先,对输入的特征图\(F_{t-1}\)和\(F_t\),我们作\(p \times p\)的平均池化,得到\(F^p_{t-1}\)和\(F_t^p\)。实验取\(p = 10\)。

然后我们再算它们的欧几里得距离矩阵\(D_t^p\)。此时,我们就能得到最相关的k个点。实验取\(k = 4\)。

这k个点对应原\(F_{t-1}\)的\(k \times p^2\)个点。后续操作就和上面一致了。

换句话说,这里有两点加速:(1)并不考虑所有点的相互关系,而只考虑前k个(其他的S为0);(2)先池化,在低维度上计算相似度。一个点代表一个块。

2. 实验

表2的前两列说明:输入多帧比输入单帧效果更好。作者还尝试了输入前后共20帧,结果比表2第4列还好。

作者尝试将NL换成了MC,结果不如NL,在dpsnr上差了20%。

NL找到的相似块也比较准。参见论文图4,红框是黄框的检测相似框。

Conv-LSTM耗时很猛,比对比算法高出好几倍,是MFQE 1.0的6-7倍。原因是要处理相邻多帧。但作者的加速已经很有效了,比原始NL加速了4倍。

3. 总结

本文对Fig1中阐释的问题进行了一定程度的处理。原因是:1、光流很难顾及全局关系,但相关度矩阵很擅长处理远距离关系。这就类似于GNN相比于传统CNN的优势。2、输入更多的相邻帧。

因此,本文的核心贡献是:在用Conv-LSTM建模时序和空域关系的同时,加入NL辅助完成了类似MC的功能。

Paper | Non-Local ConvLSTM for Video Compression Artifact Reduction的更多相关文章

- Paper | One-to-Many Network for Visually Pleasing Compression Artifacts Reduction

目录 故事 网络设计 网络前端 升采样中的平移-均值化 网络度量 训练 发表于2017年CVPR. 目标:JPEG图像去压缩失真. 主要内容: 同时使用感知损失.对抗损失和JPEG损失(已知量化间隔, ...

- DeepCoder: A Deep Neural Network Based Video Compression

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! Abstract: 在深度学习的最新进展的启发下,我们提出了一种基于卷积神经网络(CNN)的视频压缩框架DeepCoder.我们分别对预测 ...

- Paper | A Pseudo-Blind Convolutional Neural Network for the Reduction of Compression Artifacts

目录 非盲增强网络结构 训练目标 压缩系数预测子网络 网络结构 根据块QP判决结果得到帧QP预测结果 保持时序连续性 实验 发表在2019年TCSVT. 本文提出了一个兼具 预测压缩系数 和 非盲去压 ...

- Paper | Compression artifacts reduction by a deep convolutional network

目录 1. 故事 2. 方法 3. 实验 这是继SRCNN(超分辨)之后,作者将CNN的战火又烧到了去压缩失真上.我们看看这篇文章有什么至今仍有启发的故事. 贡献: ARCNN. 讨论了low-lev ...

- CVPR 2017 Paper list

CVPR2017 paper list Machine Learning 1 Spotlight 1-1A Exclusivity-Consistency Regularized Multi-View ...

- Video processing systems and methods

BACKGROUND The present invention relates to video processing systems. Advances in imaging technology ...

- paper 27 :图像/视觉显著性检测技术发展情况梳理(Saliency Detection、Visual Attention)

1. 早期C. Koch与S. Ullman的研究工作. 他们提出了非常有影响力的生物启发模型. C. Koch and S. Ullman . Shifts in selective visual ...

- SCI&EI 英文PAPER投稿经验【转】

英文投稿的一点经验[转载] From: http://chl033.woku.com/article/2893317.html 1. 首先一定要注意杂志的发表范围, 超出范围的千万别投,要不就是浪费时 ...

- ### Paper about Event Detection

Paper about Event Detection. #@author: gr #@date: 2014-03-15 #@email: forgerui@gmail.com 看一些相关的论文. 1 ...

随机推荐

- IT兄弟连 HTML5教程 介绍HTML5给你认识 习题

1.关于HTML5说法正确的是:(C) A.HTML5只是对HTML4的一个简单升级 B.所有主流浏览器都支持HTML5 C.HTML5新增了离线缓存机制 D.HTML5主要是针对移动端进行了优化 2 ...

- Apollo的基本概念和集成实战

基本概念 使用场景 是一个分布式的配置中心.适用于微服务: 核心功能 集中管理不同环境,不同集群的配置: 配置修改后可以实时推送到应用端: 具备规范的权限,流程治理特性: 开发技术 服务端使用spri ...

- nodejs环境下的socket通信

结构: socket是应用层和传输层的桥梁.(传输层之上的协议所涉及的数据都是在本机处理的,并没进入网络中) 涉及数据: socket所涉及的数据是报文,是明文. 作用: 建立长久链接,供网络上的两个 ...

- html背景音乐

标签<audio> 参用属性 autoplay="autoplay"自动播放 controls="controls",在页面内显示显示控件,如播放按 ...

- PyCharm 2017: Remote debugging using remote interpreter doesn't work

I set up a remote interpreter and verified that I can run a script using the remote interpreter. Con ...

- Kubernetes容器日志收集

日志采集方式 日志从传统方式演进到容器方式的过程就不详细讲了,可以参考一下这篇文章Docker日志收集最佳实践,由于容器的漂移.自动伸缩等特性,日志收集也就必须使用新的方式来实现,Kubernetes ...

- Django JsonResponse 不自动设置 cookie 的解决方案

[背景] 目前在做一个前后端分离的 web 项目,后端使用的是 django 框架,所有的 API 都只返回 json :就在这个过程中遇到了一个问题,那就是对于所有的 JsonResponse dj ...

- Android Studio 提高开发效率的插件

好久没有更新博客了,最近搞个listview搞得半死不活的,心累~~ 今天带来的是Android Studio插件的整理,全是我已经安装使用的,写这篇博文的目的也是因为我怕我自己给忘记怎么用(尴尬) ...

- Redisson实现分布式锁(1)---原理

Redisson实现分布式锁(1)---原理 有关Redisson作为实现分布式锁,总的分3大模块来讲. 1.Redisson实现分布式锁原理 2.Redisson实现分布式锁的源码解析 3.Redi ...

- SpringBoot2使用Jetty容器(替换默认Tomcat)

https://blog.csdn.net/hanchao5272/article/details/99649252 Jetty和tomcat的比较 Tomcat和Jetty都是一种Servlet ...