ELK收集windows服务器日志笔记

一、软件版本

1.jdk-8u211-linux-x64.rpm

2.elasticsearch-6.8.1.rpm

3.logstash-6.8.1.rpm

4.kibana-6.8.1-x86_64.rpm

5.winlogbeat-6.8.4-windows-x86_64 在windows服务器安装配置

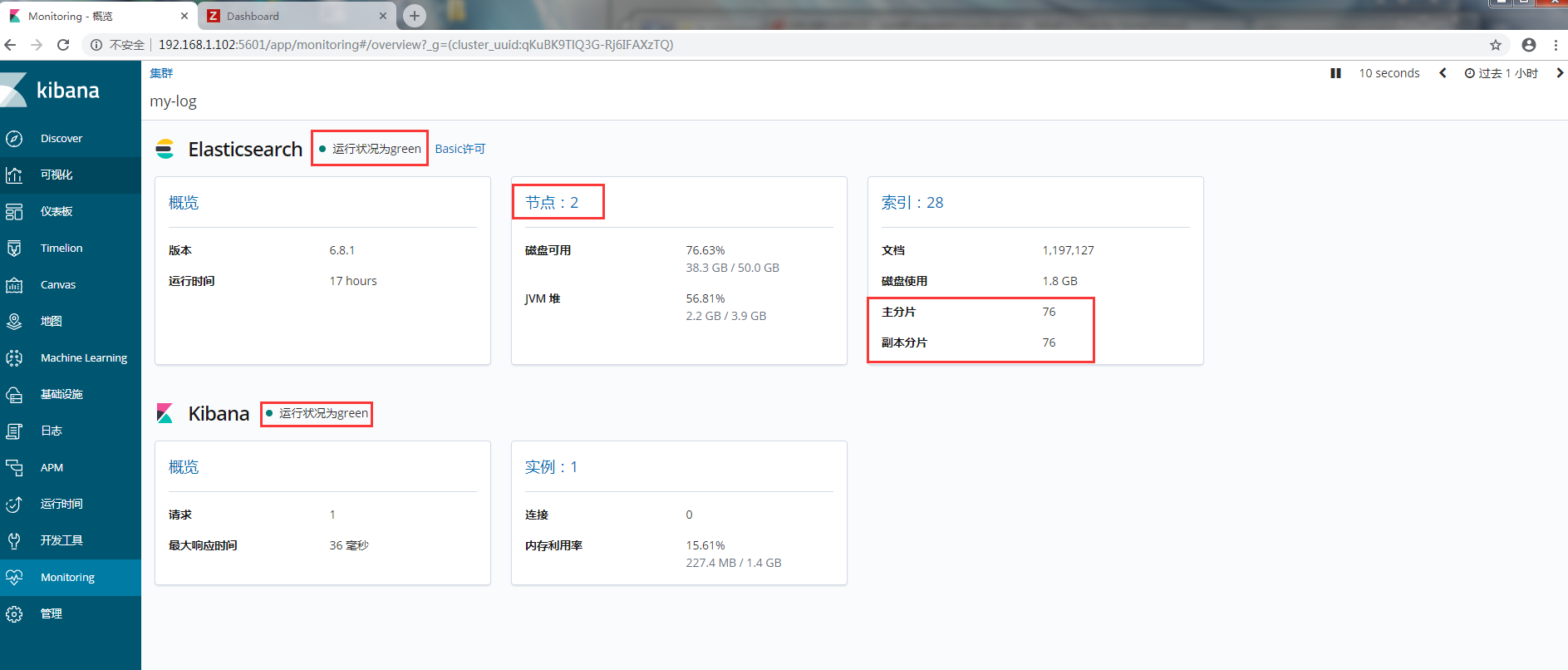

说明:elasticsearch做集群 主机1:192.168.1.102 主机2:192.168.1.104

logstash和kibana安装在主机1上

二、安装软件

2.1 主机1和主机2:jdk-8u211-linux-x64.rpm和elasticsearch-6.8.1.rpm 并配置elasticsearch

说明:elasticsearch依赖jdk环境,所以先安装jdk-8u211-linux-x64.rpm

yum -y localinstall jdk-8u211-linux-x64.rpm

yum -y localinstall elasticsearch-6.8.1.rpm

创建数据目录和日志目录及权限修改

[root@linux-elk1 ~]# mkdir -p /elk/{data,logs}

[root@linux-elk1 ~]# chown elasticsearch.elasticsearch /elk/ -R

修改内存限制,内存锁定需要进行配置需要2g以上内存,否则会导致无法启动elasticsearch。

[root@linux-elk1 ~]# vim /usr/lib/systemd/system/elasticsearch.service

在[Service]下加入下面这行内容

LimitMEMLOCK=infinity

[root@linux-elk1 ~]# vim /etc/elasticsearch/jvm.options

-Xms2g

-Xmx2g #最小和最大内存限制.

编辑配置文件:vim /etc/elasticsearch/elasticsearch.yml

[root@logsystem src]# grep -v "^#" /etc/elasticsearch/elasticsearch.yml

cluster.name: my-log

node.name: node-1

path.data: /elk/data

path.logs: /elk/logs

network.host: 192.168.1.102

http.port: 9200

discovery.zen.ping.unicast.hosts: ["192.168.1.102","192.168.1.104"]

设置开机启动

systemctl enable elasticsearch.service

systemctl daemon-reload

systemctl start elasticsearch.service

查看状态

systemctl status elasticsearch.service

正在运行,查看端口

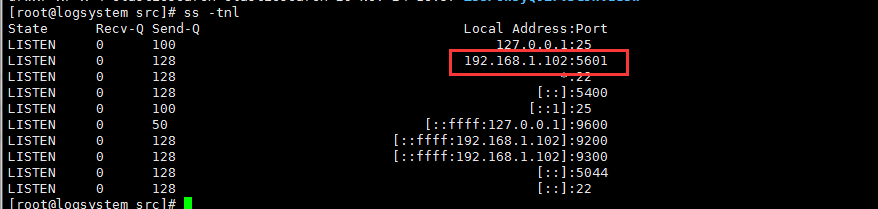

ss -tnl

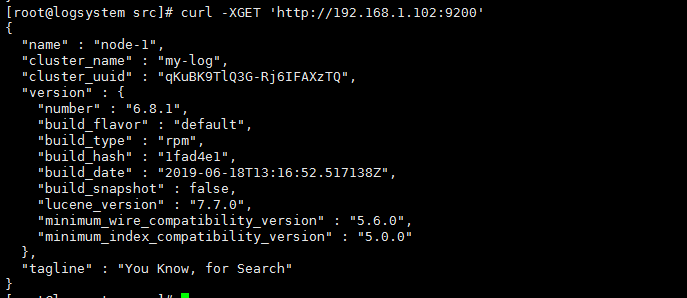

查看信息,也是一种检测。若能出现如下信息,则说明配置正确

curl http://192.168.1.102:9200

集群有状态: green ,red , yellow

绿色表示一切是好的(集群功能齐全)

黄色意味着所有数据是可用的,但是一些副本尚未分配(集群功能齐全)

红色意味着一些数据不可用

即使一个集群是红色的,它仍然是部分功能(即它将继续搜索请求从服务可用的碎片)但是你可能需要尽快修复它,因为你有缺失的数据。

Restful API:

四类API

1. 检查集群,节点,索引等健康与否,以及获取其相应状态

2.管理集群,节点,索引及元数据

3.执行CRUD操作

4.执行高级操作,如paging ,filtering等

ES访问接口:9200/tcp

语法:

curl -X<VERB> '<PROTOCOL>://host:port/<PATH>?QUERY_STRING/' -d '<BODY>'

查看elasticsearch相关信息 json格式的

[root@logsystem ~]# curl http://192.168.1.102:9200/_cluster/health?pretty=true

{

"cluster_name" : "elasticsearch",

"status" : "green",

"timed_out" : false,

"number_of_nodes" : 1,

"number_of_data_nodes" : 1,

"active_primary_shards" : 0,

"active_shards" : 0,

"relocating_shards" : 0,

"initializing_shards" : 0,

"unassigned_shards" : 0,

"delayed_unassigned_shards" : 0,

"number_of_pending_tasks" : 0,

"number_of_in_flight_fetch" : 0,

"task_max_waiting_in_queue_millis" : 0,

"active_shards_percent_as_number" : 100.0

}

[root@logsystem ~]# curl -X GET http://192.168.1.102:9200/_cat/nodes?v

ip heap.percent ram.percent cpu load_1m load_5m load_15m node.role master name

192.168.1.102 7 95 1 0.00 0.01 0.05 mdi * node-1

[root@logsystem ~]# curl -X GET http://192.168.1.102:9200/_cat/indices?help

[root@logsystem ~]# curl -X GET 'http://192.168.1.102:9200/_cluster/state/version?pretty'

{

"cluster_name" : "elasticsearch",

"cluster_uuid" : "qKuBK9TlQ3G-Rj6IFAXzTQ",

"version" : 16,

"state_uuid" : "SzhdF4PvRIGFbwlI_PD_cg"

}

2.2主机1: logstash-6.8.1.rpm 并配置

wget https://artifacts.elastic.co/downloads/logstash/logstash-6.8.1.rpm

yum -y localinstall logstash-6.8.1.rpm

[root@logsystem ~]cd /etc/logstash/conf/

vim system-log.conf

input{

beats{

add_field => {"myid"=>"windows_log"}

port => 5044

}

beats {

add_field => {"myid"=>"nginx_log"}

port => 5400

}

stdin{}

}

output{

if [myid] == "windows_log"{

elasticsearch{

hosts=>"192.168.1.102:9200"

index=>"%{type}-%{+YYYY-MM-dd}"

}

}

if [myid] == "nginx_log"{

elasticsearch{

hosts=>"192.168.1.102:9200"

index=>"nginx_pj_log-%{+YYYY-MM-dd}"

}

}

stdout{ codec=>rubydebug }

}

启动logstash:

[root@logsystem src]# nohup logstash -f /etc/logstash/conf.d/server_log.conf &

测试配置文件是否有语法错误:

[root@logsystem ~]logstash -f /etc/logstash/conf/system-log.conf

数据类型

Array: [item1,item2,...]

Boolean: true,false

Bytes:

Codec: 编码器

Hash: key=>value

Number:

Password:

Path:文件系统路径

String:字符串

字段引用 []

条件判断: == ,!=,<,>, in ,not in ,and,or ....

常用imput Plugin

imput插件:

File :从指定的文件中读取事件流,按行来标记一个事件。

使用FileWatch(Ruby开发)来监听文件是否变化; .sincedb保存文件的相关信息数据库中。

[root@logsystem logstash]# rpm -ql logstash |grep "patterns" 查找pattern

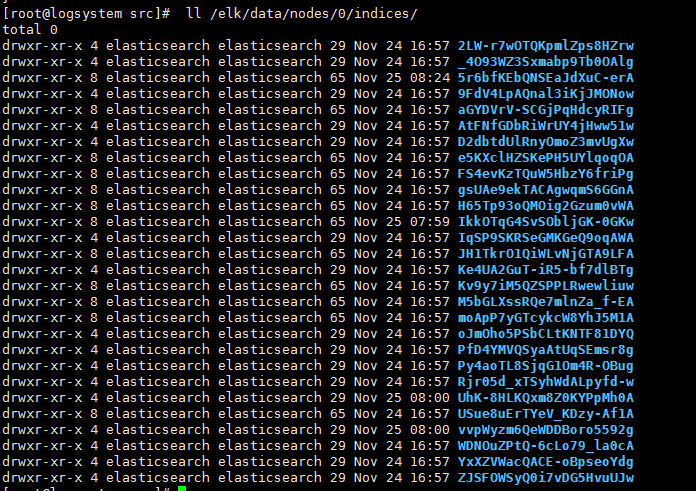

elasticsearch服务收到数据验证:

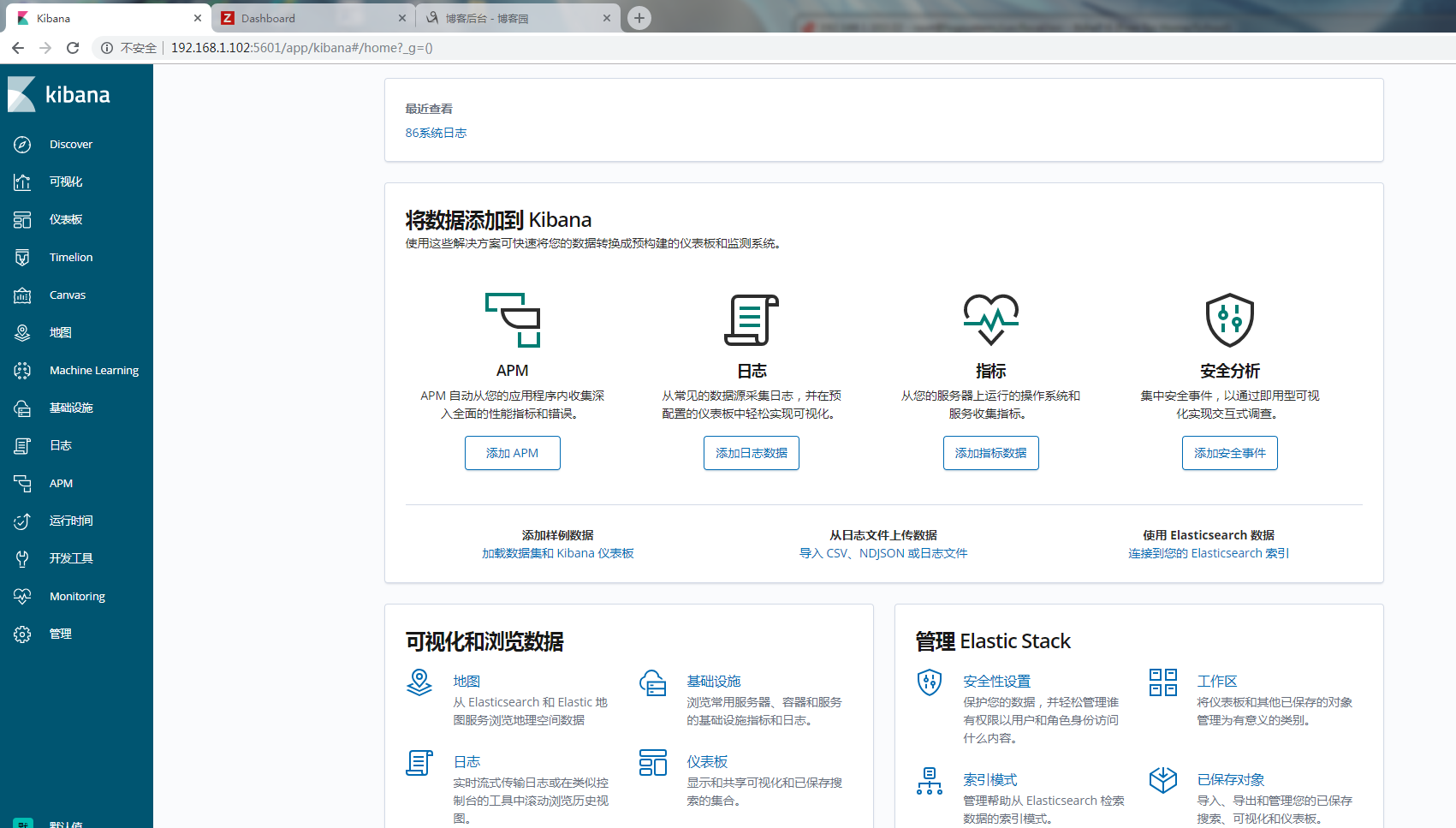

2.3主机1:安装配置kibana

[root@logsystem src]# wget https://artifacts.elastic.co/downloads/kibana/kibana-6.8.1-x86_64.rpm

安装

[root@logsystem src]# yum localinstall kibana-6.8.1-x86_64.rpm -y

配置

[root@logsystem src]# vim /etc/kibana/kibana.yml

server.port: 5601 #监听端口

server.host: "192.168.1.102" #监听地址

elasticsearch.hosts: ["http://192.168.1.102:9200"] #elasticsearch服务器地址

i18n.locale: "zh-CN" #修改中文

[root@logsystem src]# systemctl start kibana

[root@logsystem src]# systemctl enable kibana

查看服务

访问:http://192.168.1.102:5601

2.4 收集服务器日志上安装winlogbeat-6.8.4-windows-x86_64

解压到 C:\Program Files

重新命名文件夹为winlogbeat

用管理员身份打开windows的 powershell

运行以下命令来安装服务

PS C:\Users\Administrator> cd 'C:\Program Files\Winlogbeat'

PS C:\Program Files\Winlogbeat> .\install-service-winlogbeat.ps1

不能安装时,令来关闭一些安全防护,输入命令后按Y确认

PS C:\Program Files\Winlogbeat> set-executionpolicy remotesigned

PS C:\Program Files\Winlogbeat> set-executionpolicy Bypass

winlogbeat.yml 配置文件修改:

winlogbeat.event_logs:

- name: Application #应用程序事件;

ignore_older: 8h #忽略8小时后的日志,初次启用传日志很有用;

provider: #过虑源yml列表

- Application Error

- Application Hang

- Windows Error Reporting

- name: Security #安全日志

ignore_older: 8h

event_id: 4624, 4625, 4700-4800, -4735 #事件ID 匹配中事件ID发送

- name: System #系统日志

ignore_older: 8h

检查配置语法

. \winlogbeat.exe test config -c .\winlogbeat.yml -e

启动winlogbeat

C:\Program Files\Winlogbeat> Start-Service winlogbeat

Windlogbeat基本配置

1.配置发送日志到logstash

output.logstash:

# The Logstash hosts

hosts: ["10.10.10.10:5044"]

2.配置发送日志到elasticsearch

output.elasticsearch:

hosts: ["10.10.10.10:9200"]

template.name: "winlogbeat"

template.path: "winlogbeat.template.json"

template.overwrite: false

坑1:插件存放路径

报错:

org.elasticsearch.bootstrap.StartupException: java.lang.IllegalArgumentException: Property [elasticsearch.version] is missing for plugin [head]

at org.elasticsearch.bootstrap.Elasticsearch.init(Elasticsearch.java:125) ~[elasticsearch-5.2.2.jar:5.2.2]

at org.elasticsearch.bootstrap.Elasticsearch.execute(Elasticsearch.java:112) ~[elasticsearch-5.2.2.jar:5.2.2]

at org.elasticsearch.cli.SettingCommand.execute(SettingCommand.java:54) ~[elasticsearch-5.2.2.jar:5.2.2]

at org.elasticsearch.cli.Command.mainWithoutErrorHandling(Command.java:122) ~[elasticsearch-5.2.2.jar:5.2.2]

at org.elasticsearch.cli.Command.main(Command.java:88) ~[elasticsearch-5.2.2.jar:5.2.2]

at org.elasticsearch.bootstrap.Elasticsearch.main(Elasticsearch.java:89) ~[elasticsearch-5.2.2.jar:5.2.2]

at org.elasticsearch.bootstrap.Elasticsearch.main(Elasticsearch.java:82) ~[elasticsearch-5.2.2.jar:5.2.2]

原因:新版本的elasticsearch不允许插件放入/usr/share/elasticsearch/plugins 目录下。(插件bigdesk,head ...)

解决:把插件移到其它目录即可

ELK收集windows服务器日志笔记的更多相关文章

- salt收集windows服务器日志时间

定义收集时间区间: time.ps1 $a = get-date $b = $a.adddays(-) $c = $b.tostring('yyyy-MM-dd') $d = get-date -fo ...

- elk收集windows日志

参考网站:https://www.secpulse.com/archives/55636.html https://blog.csdn.net/qq_38094271/article/details/ ...

- ELK收集Nginx自定义日志格式输出

1.ELK收集日志的有两种常用的方式: 1.1:不修改源日志格式,简单的说就是在logstash中转通过 grok方式进行过滤处理,将原始无规则的日志转换为规则日志(Logstash自定义日志格式) ...

- 带你了解zabbix整合ELK收集系统异常日志触发告警~

今天来了解一下关于ELK的“L”-Logstash,没错,就是这个神奇小组件,我们都知道,它是ELK不可缺少的组件,完成了输入(input),过滤(fileter),output(输出)工作量,也是我 ...

- ELK收集Nginx|Tomcat日志

1.Nginx 日志收集,先安装Nginx cd /usr/local/logstash/config/etc/,创建如下配置文件,代码如下 Nginx.conf input { file { typ ...

- 搭建ELK收集PHP的日志

架构: filebeat --> redis -->logstash --> es --> kibana 每个客户端需要安装filebeat收集PHP日志 filebeat把收 ...

- elk收集tomcat的日志

logstash收集tomcat的日志 不要修改下tomcat中server.xml的日志格式,否则tomcat无法启动,试过多次,不行,就用自带的日志让logstash去收集 首先给tomcat日志 ...

- ELK收集tomcat访问日志并存取mysql数据库案例

这个案例中,tomcat产生的日志由filebeat收集,然后存取到redis中,再由logstash进行过滤清洗等操作,最后由elasticsearch存储索引并由kibana进行展示. 1.配置t ...

- ELK收集tomcat状态日志

1.先查看之前的状态日志输出格式:在logs/catalina.out这个文件中 最上面的日志格式我们可能不太习惯使用,所以能输出下面的格式是最好的,当然需要我们自定义日志格式,接下来看看如何修改 2 ...

随机推荐

- 谈一谈AOP面向切面编程

AOP是什么 : AOP面向切面编程他是一种编程思想,是指在程序运行期间,将某段代码动态的切入到指定方法的指定位置,将这种编程方式称为面向切面编程 AOP使用场景 : 日志 事务 使用AOP的好处是: ...

- Vue中实现聊天窗口overflow:auto自动滚动到底部,实现显示当前最新聊天消息

在做消息的项目,当有新消息的时候让新消息出现在最底部,此时的box用的是overflow:auto 注意:vue项目需要注意在dom结构渲染完再进行操作 <div class="mai ...

- 安装mysql5.7(亲手实操)

https://files-cdn.cnblogs.com/files/yucoder/%E5%AE%89%E8%A3%85mysql5.7.pdf

- linux指令-date

1.在linux中要显示日期,则可以直接输入指令date 2.如果想以这样2016/12/26的方式输出呢,那就是,Y是年份,m是月份,d是日 date +%Y/%m/%d 3.如果要显示时间,则da ...

- 在.Net Core中记录日志

一个完善的系统,必然会有非常完善的日志记录,用户的操作.系统的运行状况等信息被完整的记录下来,方便我们对系统进行维护和改进..net core 也为日志记录提供了内置的支持. 在控制台程序中记录日志 ...

- Python之利用Whoosh搭建轻量级搜索

本文将简单介绍Python中的一个轻量级搜索工具Whoosh,并给出相应的使用示例代码. Whoosh简介 Whoosh由Matt Chaput创建,它一开始是一个为Houdini 3D动画软 ...

- javascript数据结构

学习数据结构非常重要.首要原因是数据结构和算法可以很高效的解决常见问题.作为前端,通过javascript学习数据结构和算法要比学习java和c版本容易的多. 在讲数据结构之前我们先了解一下ES6的一 ...

- CSS flex 布局快速入门

以前已经学过flex了,一直没做笔记,现在做下笔记再回忆下. 首先,flex布局的迷之属性们,如果一知半解,机械记忆的话,那不到半个月基本忘光光.先感受一下这12个flex布局属性,是不是很“迷”人. ...

- 画线缩放、瞳距缩放、Line延长到指定长度,内附效果,源码供应,解压就跑

前言 公司项目需要做个画线缩放,我司称之为瞳距缩放,简而言之就是:2张图,从第一张图画一条线,再从第二个图画一条线,第二条线以第一条为基准,延长到一致的长度,并同比缩放图片:文字太枯燥,请先实例图 例 ...

- MongoDB(八):索引

1. 索引 索引支持查询的有效地提高效率.没有索引,MongoDB必须扫描集合的每个文档,以选择与查询语句匹配的文档.这种扫描效率很低,需要MongoDB处理大量的数据. 索引是特殊的数据结构,以易于 ...