Python 爬虫之 Beautifulsoup4,爬网站图片

安装:

pip3 install beautifulsoup4

pip install beautifulsoup4

Beautifulsoup4 解析器使用 lxml,原因为,解析速度快,容错能力强,效率够高

安装解析器:

pip install lxml

使用方法:

- 加载 beautifulsoup4 模块

- 加载 urllib 库的 urlopen 模块

- 使用 urlopen 读取网页,如果是中文,需要添加 utf-8 编码模式

- 使用 beautifulsoup4 解析网页

#coding: utf8

#python 3.7 from bs4 import BeautifulSoup

from urllib.request import urlopen #if chinese apply decode()

html = urlopen("https://www.anviz.com/product/entries/1.html").read().decode('utf-8')

soup = BeautifulSoup(html, features='lxml')

all_li = soup.find_all("li",{"class","product-subcategory-item"})

for li_title in all_li:

li_item_title = li_title.get_text()

print(li_item_title)

Beautifulsoup4文档: https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/#id13

方法同 jQuery 类似:

//获取所有的某个标签:soup.find_all('a'),find_all() 和 find() 只搜索当前节点的所有子节点,孙子节点

find_all()

soup.find_all("a") //查找所有的标签

soup.find_all(re.compile("a")) //查找匹配包含 a 的标签

soup.find_all(id="link2")

soup.find_all(href=re.compile("elsie")) //搜索匹配每个tag的href属性

soup.find_all(id=True) //搜索匹配包含 id 的属性

soup.find_all("a", class_="sister") //搜索匹配 a 标签中 class 为 sister

soup.find_all("p", class_="strikeout")

soup.find_all("p", class_="body strikeout")

soup.find_all(text="Elsie") //搜索匹配内容为 Elsie

soup.find_all(text=["Tillie", "Elsie", "Lacie"])

soup.find_all("a", limit=2) //当搜索内容满足第2页时,停止搜索

//获取tag中包含的文本内容

get_text()

soup.get_text("|")

soup.get_text("|", strip=True)

//用来搜索当前节点的父辈节点

find_parents()

find_parent()

//用来搜索兄弟节点

find_next_siblings() //返回所有符合条件的后面的兄弟节点

find_next_sibling() //只返回符合条件的后面的第一个tag节点

//用来搜索兄弟节点

find_previous_siblings() //返回所有符合条件的前面的兄弟节点

find_previous_sibling() //返回第一个符合条件的前面的兄弟节点

find_all_next() //返回所有符合条件的节点

find_next() //返回第一个符合条件的节点

find_all_previous() //返回所有符合条件的节点

find_previous() //返回第一个符合条件的节点

.select() 方法中传入字符串参数,即可使用CSS选择器的语法找到tag

soup.select("body a")

soup.select("head > title")

soup.select("p > a")

soup.select("p > a:nth-of-type(2)")

soup.select("#link1 ~ .sister")

soup.select(".sister")

soup.select("[class~=sister]")

soup.select("#link1")

soup.select('a[href]')

soup.select('a[href="http://example.com/elsie"]')

.wrap() 方法可以对指定的tag元素进行包装 [8] ,并返回包装后的结果

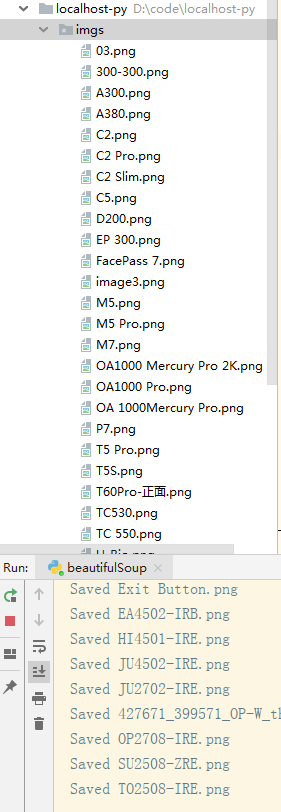

爬取 anviz 网站产品列表图片: demo

使用了

BeautifulSoup

requests

os

#Python 自带的模块有以下几个,使用时直接 import 即可

import json

import random //生成随机数

import datetime

import time

import os //建立文件夹

#coding: utf8

#python 3.7 from bs4 import BeautifulSoup

import requests

import os URL = "https://www.anviz.com/product/entries/2.html"

html = requests.get(URL).text

os.makedirs("./imgs/",exist_ok=True)

soup = BeautifulSoup(html,features="lxml") all_li = soup.find_all("li",class_="product-subcategory-item")

for li in all_li:

imgs = li.find_all("img")

for img in imgs:

imgUrl = "https://www.anviz.com/" + img["src"]

r = requests.get(imgUrl,stream=True)

imgName = imgUrl.split('/')[-]

with open('./imgs/%s' % imgName, 'wb') as f:

for chunk in r.iter_content(chunk_size=):

f.write(chunk)

print('Saved %s' % imgName)

爬取的这个 URL 地址是写死的,其实这个网站是分三大块的,末尾 ID 不一样,还没搞明白怎么自动全爬。

Python 爬虫之 Beautifulsoup4,爬网站图片的更多相关文章

- Python爬虫学习之爬美女图片

最近看机器学习挺火的,然后,想要借助业余时间,来学习Python,希望能为来年找一份比较好的工作. 首先,学习得要有动力,动力,从哪里来呢?肯定是从日常需求之中来.我学Python看网上介绍.能通过P ...

- python爬虫——利用BeautifulSoup4爬取糗事百科的段子

import requests from bs4 import BeautifulSoup as bs #获取单个页面的源代码网页 def gethtml(pagenum): url = 'http: ...

- python爬虫-基础入门-爬取整个网站《3》

python爬虫-基础入门-爬取整个网站<3> 描述: 前两章粗略的讲述了python2.python3爬取整个网站,这章节简单的记录一下python2.python3的区别 python ...

- python爬虫-基础入门-爬取整个网站《2》

python爬虫-基础入门-爬取整个网站<2> 描述: 开场白已在<python爬虫-基础入门-爬取整个网站<1>>中描述过了,这里不在描述,只附上 python3 ...

- python爬虫-基础入门-爬取整个网站《1》

python爬虫-基础入门-爬取整个网站<1> 描述: 使用环境:python2.7.15 ,开发工具:pycharm,现爬取一个网站页面(http://www.baidu.com)所有数 ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- Python 爬虫入门之爬取妹子图

Python 爬虫入门之爬取妹子图 来源:李英杰 链接: https://segmentfault.com/a/1190000015798452 听说你写代码没动力?本文就给你动力,爬取妹子图.如果 ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫教程-17-ajax爬取实例(豆瓣电影)

Python爬虫教程-17-ajax爬取实例(豆瓣电影) ajax: 简单的说,就是一段js代码,通过这段代码,可以让页面发送异步的请求,或者向服务器发送一个东西,即和服务器进行交互 对于ajax: ...

- Python爬虫实战之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 对百度贴吧的任意帖子进行抓取 指定是否只抓取楼主发帖 ...

随机推荐

- linux--top工具分析

top分析工具详解 第一行:10:01:23 当前系统时间126 days, 14:29 系统已经运行了126天14小时29分钟(在这期间没有重启过)2 users 当前有2个用户登录系统 loa ...

- postman---postman发送请求

前面简单的介绍了Postman的页面介绍和功能介绍,今天我们一起学习postman如何发送请求 发送请求 我们介绍过http协议有多种请求方式,各个请求方法都代表不同的结果.例如,GET使您可以从服务 ...

- Linux 修改/etc/sudoers 可被任何修改,如何解决

今天不小心,修改了/etc/sudoers的权限 改成了 777的权限, 于是每次使用sudo都会弹出 sudo:sudo /etc/sudoers is world writable sudo:no ...

- 22.Java基础_StringBuilder类

String类对象的拼接操作:执行到s+="world"语句时,常量池会先创建"world"对象,再去创建"helloworld"对象,最后 ...

- win10安装配置mongodb

1. 下载MongoDB并安装官网下载地址:https://blog.csdn.net/qq_41127332/article/details/80755595 ,选择合适的版本进行下载.我选择是3. ...

- 让人又爱又恨的this

this是个神奇的东西, 既可以帮助我们把模拟的类实例化. 又可以在事件绑定里准确指向触发元素. 还可以帮助我们在对象方法中操作对象的其他属性或方法. 甚至可以在使用apply.call.bing.f ...

- leetcode494. 目标和

给定一个非负整数数组,a1, a2, ..., an, 和一个目标数,S.现在你有两个符号 + 和 -.对于数组中的任意一个整数,你都可以从 + 或 -中选择一个符号添加在前面. 返回可以使最终数组和 ...

- H5开发 连接蓝牙打印机 打印标签(斑马ZR628)

1.连接蓝牙打印机(先用手机自带蓝牙进行配对),然后绑定出已配对的蓝牙设备(用来选择/切换打印机之用),代码如下 已配对蓝牙设备,中显示的就是已连接的,点击一下即可 代码: <!DOCTYPE ...

- 数据仓库002 - 复习Linux shell命令 - echo bash_profile bashrc which命令的理解 alias history

1.echo 打印 . echo 的作用是在屏幕上打印输出内容,与文件和持久化可以理解为没有丝毫关联.如:在屏幕上打印“ echo 的作用是打印文字! ” 实例1:输出系统的环境变量名称 $PATH ...

- ros局部路径规划-DWA学习

ROS的路径规划器分为全局路径和局部路径规划,其中局部路径规划器使用的最广的为dwa,个人理解为: 首先全局路径规划会生成一条大致的全局路径,局部路径规划器会把全局路径给分段,然后根据分段的全局路径的 ...