Kafka笔记8(管理Kafka)

使用kafka-topic.sh工具可以执行大部分操作 创建/修改/删除/查看集群里的主题。要使用全部功能,需要通过--zookeeper参数提供zookeerper连接字符串

创建主题:

创建主题需要3个参数: 主题名字 复制系数 分区数量

格式: kafka-topic.sh --zookeeper <zookeeper connect> --create --topic <string> --replication-factor <integer> --partitions <integer>

如果不需要基于机架信息的分配策略,使用参数--disable-rack-aware

增加主题分区的数量至16:

kafka-topic.sh --zookeeper <zookeeper connect> --alter --topic my-topic --partition 16

减少主题分区数量: 会导致消息乱序,只能删除分区数量,重新创建

删除主题:

配置参数 delete.topic.enable=true

kafka-topic.sh --zookeeper <zookeeper connect> --delete --topic my-topic

列出集群所有主题

kafka-topic.sh --zookeeper <zookeeper connect> --list

列出主题详细信息

列出集群所有主题详细信息

kafka-topic.sh --zookeeper <zookeeper connect> -describe

找出所有包含覆盖配置的主题 --topic-with-overrides

列出所有包含不同步副本的分区 --under-replicated-partitions

kafka-topic.sh --zookeeper <zookeeper connect> --describe --under-replicated-partitions

列出所有没有首领的分区 --unavailable-partitions

列出新版本的消费者群组

Kafka-consumer-groups.sh --new-consumer --bootstrap-server <kafka集群主机:port/kafka-cluster> --list

获取旧版本消费者群组testgroup详细信息

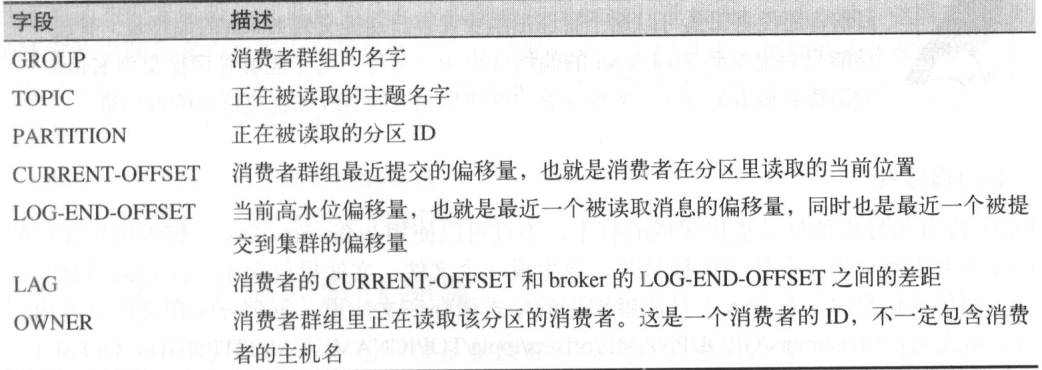

kafka-consumer-group.sh --zookeeper <zookeeper connect> --describe --group testgroup

删除消费者群组

kafka-consumer-groups.sh --zookeeper <zookeeper connect> --delete --group testgroup

删除消费者群组testgroup中my-topic 主题的偏移量

kafka-consumer-groups.sh --zookeeper <zookeeper connect> --delete --group testgroup --topic my-topic

导出群组testgroup的偏移量到offsets文件

kafka-run-class.sh kafka.tools.ExportZkOffsets --zkconnect <zookeeper connect> --group testgroup --output-file offsets

导入偏移量:

先关闭消费者

kafka-run-class.sh kafka.tools.ImportZkOffsets --zkconnect <zookeeper connect> --inpiut-file offsets

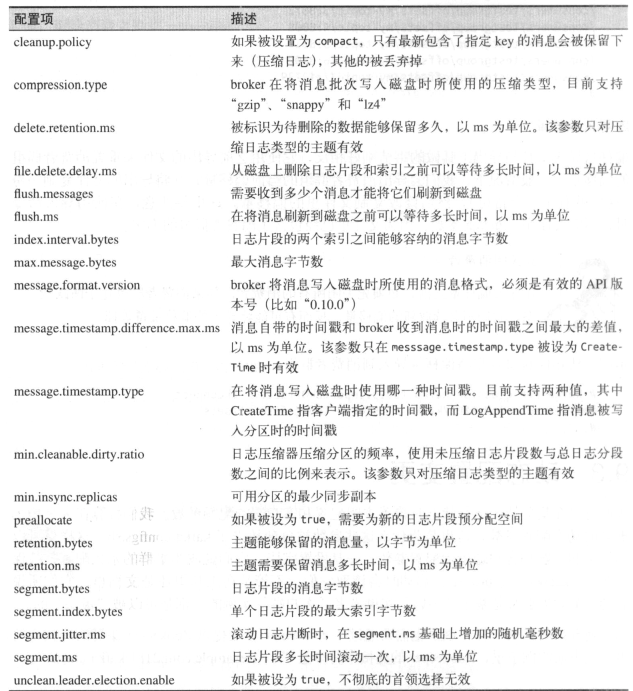

更改主题配置的命令格式:

kafka-configs.sh --zookeeper <zookeeper connect> --alter --entity-type topics --entity-name <topic name > -add-config <key>=<value>[,<key>=<value>...]

将主题my-topic 消息保留时间设置为1小时

kafka-confihs.sh --zookeeper <zookeeper connect> --alter --entity-type topic --entity-name my-topic -add-config retention.ms=3600000

更改客户端配置命令格式:

kafka-configs.sh --zookeeper <zookeeper connect> --alter --entity-type clients --entity-name <client ID> -add-config <key>=<value>....

列出主题my-topic 所有被覆盖的配置:

kafka-configs.sh --zookeeper <zookeeper connect> --describe --entity-type topics --entity-name my-topic

删除主题my-topic的retention.ms覆盖配置

kafka-config.sh --zookeeper <zookeeper connect> --alter --entity-type topics --entity-name my-topic --delete-config retention.ms

在一个包含1主题和8个分区集群里启动首选的副本选举

kafka-preferred-replica-election.sh --zookeeper <zookeeper connect>

通过partitions.json 文件里指定分区清单来启动副本的选举

kafka-prefered-replica-election.sh --zookeeper <zookeeper connect> --path-to-json-file partitions.json

修改分区副本:

为topic.json文件里的主题生成迁移步骤,以便将这些主题迁移至broker0 和 broker1上

kafka-reassign-partitions.sh --zookeeper <zookeeper connect> --generate --topics-to-move-json-file topics.json --broker-list 0,1

使用reassign.json 来执行建议的分区分配方案:

kafka-reassign-partitions.sh --zookeeper <zookeeper connect> --execute --reassignment-json-file reassign.json

验证reassign.json文件里指定的分区重分配情况:

kafka-reassign-partitions.sh --zookeeper <zookeeper connect> --verify --reassignment-json-file reassign.json

解码日志片段000052368601.log ,显示消息的概要信息

kafka-run-class.sh kafka.tools.DumpLogSegments --files 000052368601.log

解码日志片段000001.log,显示消息内容

kafka-run-class.sh kafka.tools.DumpLogSegments --files 000001.log --print-data-log

验证日志片段00001.log索引文件的正确性

kafka-run-class.sh kafka.tools.DumpLogSegments --files 00001.index,000001.log --index-sanity-check

// --verify-index-only 将会检查索引的匹配度

对broker1和broker2上以my-开头的主题副本进行验证

kafka-replica-verification.sh --broker-list kafka1.com:9092,kafka2.com:9092 --topic-white-list 'my-*'

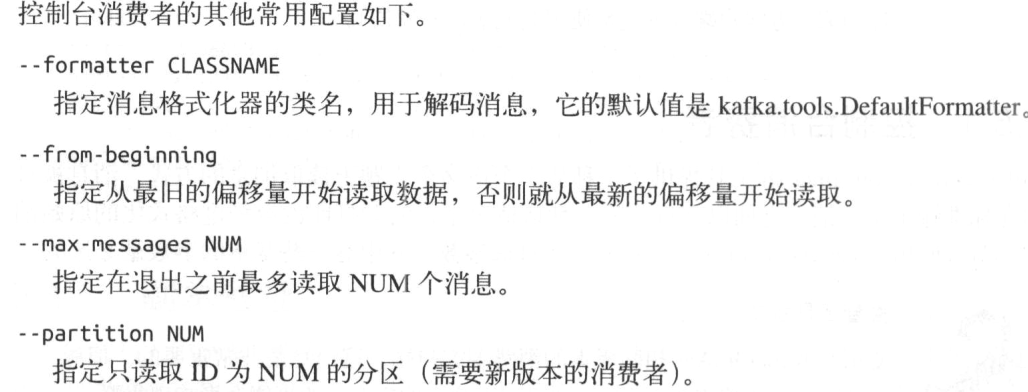

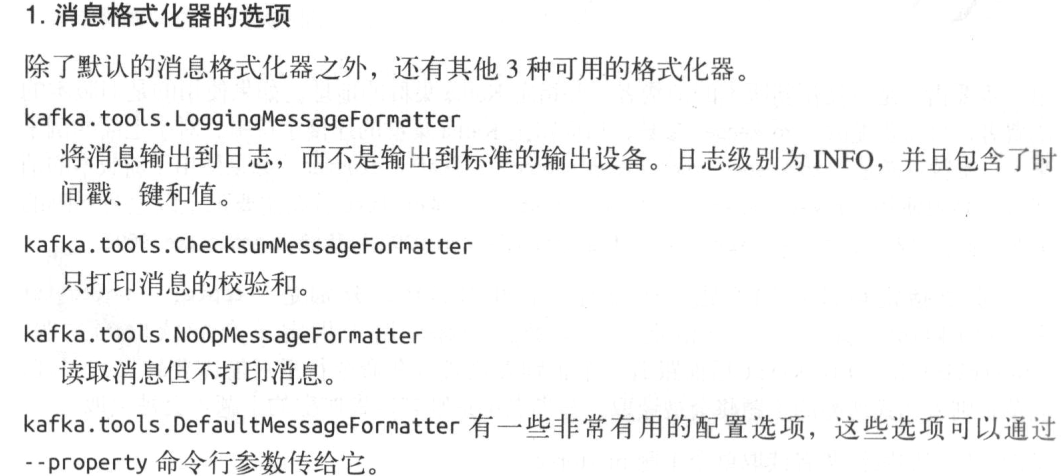

使用旧版消费者读取单个主题

kafka-console-consumer.sh --zookeeper <zookeeper connect> --topic my-topic

向主题my-topic 生成2个消息

kafka-console-producer.sh --broker-list kafka1.com:9092,kafka2.com:9092 --topic my-topic

Kafka笔记8(管理Kafka)的更多相关文章

- Kafka:docker安装Kafka消息队列

安装之前先看下图 Kafka基础架构及术语 Kafka基本组成 Kafka cluster: Kafka消息队列(存储消息的队列组件) Zookeeper: 注册中心(kafka集群依赖zookee ...

- 《Apache kafka实战》读书笔记-管理Kafka集群安全之ACL篇

<Apache kafka实战>读书笔记-管理Kafka集群安全之ACL篇 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 想必大家能看到这篇博客的小伙伴,估计你对kaf ...

- 《Apache Kafka实战》读书笔记-调优Kafka集群

<Apache Kafka实战>读书笔记-调优Kafka集群 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.确定调优目标 1>.常见的非功能性要求 一.性能( ...

- 《Apache Kafka 实战》读书笔记-认识Apache Kafka

<Apache Kafka 实战>读书笔记-认识Apache Kafka 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.kafka概要设计 kafka在设计初衷就是 ...

- Kafka集群管理工具kafka-manager的安装使用

一.kafka-manager简介 kafka-manager是目前最受欢迎的kafka集群管理工具,最早由雅虎开源,用户可以在Web界面执行一些简单的集群管理操作.具体支持以下内容: 管理多个集群 ...

- Kafka笔记1(初步认识)

Kafka 被称为“分布式提交日志”或“分布式流平台” 文件系统或数据库提交日志用来提供所有事务的持久记录,通过重放这些日志重建系统状态,同时Kafka数据是按照一定顺序持久化保存的,可以按需读取 K ...

- kafka集群管理工具kafka-manager部署安装

一.kafka-manager 简介 为了简化开发者和服务工程师维护Kafka集群的工作,yahoo构建了一个叫做Kafka管理器的基于Web工具,叫做 Kafka Manager.这个管理工具可以很 ...

- Linux Kafka集群管理工具kafka-manager的安装使用

一.kafka-manager简介 kafka-manager是目前最受欢迎的kafka集群管理工具,最早由雅虎开源,用户可以在Web界面执行一些简单的集群管理操作.具体支持以下内容: 管理多个集群 ...

- Kafka笔记整理(一)

Kafka简介 消息队列(Message Queue) 消息 Message 网络中的两台计算机或者两个通讯设备之间传递的数据.例如说:文本.音乐.视频等内容. 队列 Queue 一种特殊的线性表(数 ...

- Kafka笔记整理(三):消费形式验证与性能测试

Kafka消费形式验证 前面的<Kafka笔记整理(一)>中有提到消费者的消费形式,说明如下: .每个consumer属于一个consumer group,可以指定组id.group.id ...

随机推荐

- [C#]_[使用微软OpenXmlSDK (OpenXmlReader)读取xlsx表格] 读取大数据量100万条数据Excel文件解决方案

1.OpenXmlSDK是个很好的类库,可惜只能通过C#调用,C#的童鞋又福气了. 2.服务端程序由于没法安装office,所以这个对asp.net网站来说是最理想的库了.需要.net 4.0版本 ...

- python面试题整理

1.谈谈你对csrf的理解和django中CSRF防护机制. 什么是 CSRF CSRF, Cross Site Request Forgery, 跨站点伪造请求.举例来讲,某个恶意的网站上有一个指向 ...

- entityframework单例模式泛型用法

public class yms_Entity<T> where T :DbContext { private static T _instance; public static read ...

- Linux安装Tomcat-Nginx-FastDFS-Redis-Solr-集群——【第九集-补充-之安装mariadb】

由于也是第一次安装,再此不必献丑了,贴上参考链接: 1,指导我为什么使用mariadb而不是用mysql:https://blog.csdn.net/liumiaocn/article/details ...

- Scala数组| 集合

arrays :+ 5尾部 头部5 +: arrays TODO 声明不可变数组,不能删; 默认情况下,scala中集合的声明全都是不可变的 val arrays: Array[Int] = Ar ...

- ArrayList Vector

100000条数据时:测了4次,分别是9ms/13ms:8ms/6ms:8ms/6ms:8ms/6ms[其中/前为ArrayList数据,/后为Vector数据]1000000条数据时:测了4次,分别 ...

- Yarn集群的搭建、Yarn的架构和WordCount程序在集群提交方式

一.Yarn集群概述及搭建 1.Mapreduce程序运行在多台机器的集群上,而且在运行是要使用很多maptask和reducertask,这个过程中需要一个自动化任务调度平台来调度任务,分配资源,这 ...

- [MNIST数据集]输入图像的预处理

因为MNIST数据是28*28的黑底白字图像,而且输入时要将其拉直,也就是可以看成1*784的二维张量(张量的值在0~1之间),所以我们要对图片进行预处理操作,是图片能被网络识别. 以下是代码部分 i ...

- ubuntu16.04中supervisor安装与简单使用(转载)

ubuntu16.04中supervisor安装与简单使用 supervisor 进程管理是可以让进程在后台运行,而不占用控制台影响使用 1. 安装 supervisor sudo apt insta ...

- 1. Scala概述

1.1 概述 联邦理工学院洛桑(EPFL)的Martin Odersky于2001年开始设计Scala Scala是Scalable Language的简写,是一门多范式的编程语言 1.2 Scala ...