大数据系列之kafka-java实现

Java源码GitBub地址: https://github.com/fzmeng/kafka-demo

关于kafka安装步骤可见文章 http://www.cnblogs.com/cnmenglang/p/6520166.html

在上篇文章中使用shell 命令处理了kafka的消息生产与消息消费。下面介绍Java语言对kafka的消息生产与消息消费的处理。

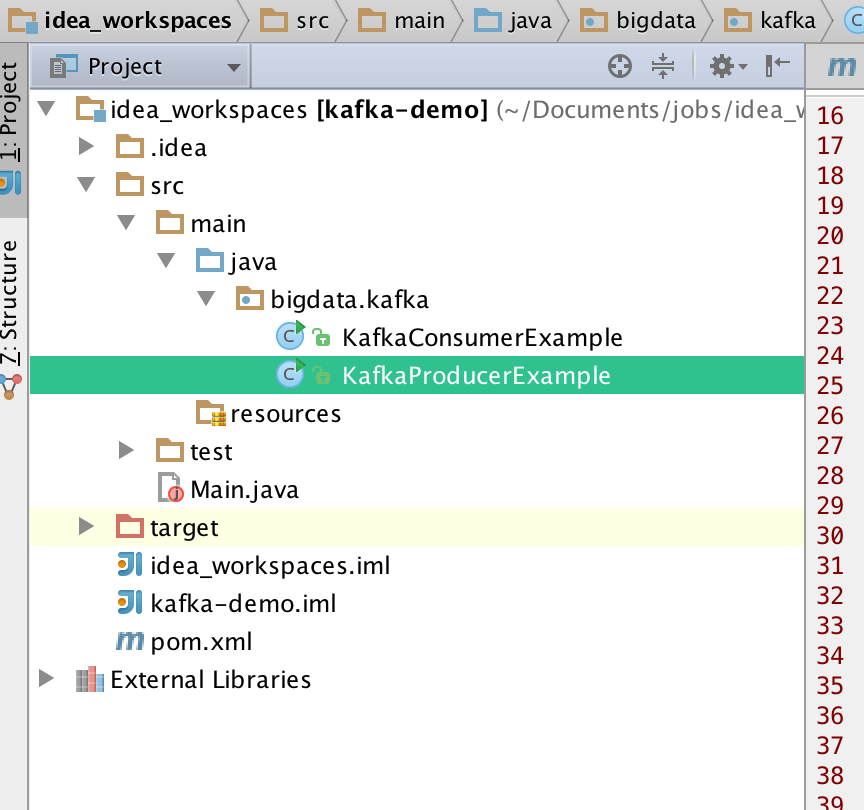

1.代码结构如图

2.pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.</modelVersion> <groupId>mfz.kafka</groupId>

<artifactId>kafka-demo</artifactId>

<version>1.0-SNAPSHOT</version> <properties>

<kafka.version>0.10.2.0</kafka.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>${kafka.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka_2.11 -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka_2.</artifactId>

<version>${kafka.version}</version>

</dependency>

</dependencies> <build>

<plugins>

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<version>2.3</version>

<configuration>

<classifier>dist</classifier>

<appendAssemblyId>true</appendAssemblyId>

<descriptorRefs>

<descriptor>jar-with-dependencies</descriptor>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

2 . 生产者 KafKaProducerExample.java

package bigdata.kafka; import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord; import java.util.Properties; /**

* @author mengfanzhu

* @Package bigdata.kafka

* @Description: kafka生产者

* @date 17/3/8 17:20

*/

public class KafkaProducerExample { public void produceMessage()

{

Properties props = getConfig();

Producer<String, String> producer = new KafkaProducer<String, String>(props);

String topic="slavetest",key,value;

for (int i = 0; i < 1000; i++) {

key = "key"+i;

value="value"+i;

System.out.println("TOPIC: slavetest;发送KEY:"+key+";Value:"+value);

producer.send(new ProducerRecord<String, String>(topic, key,value));

try {

Thread.sleep(1000);

}

catch (InterruptedException e) {

e.printStackTrace();

}

} producer.close();

} // config

public Properties getConfig()

{

Properties props = new Properties();

props.put("bootstrap.servers", "10.211.55.3:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

return props;

} public static void main(String[] args)

{

KafkaProducerExample example = new KafkaProducerExample();

example.produceMessage();

}

}

3.消费者 KafkaConsumerExample.java

package bigdata.kafka; import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.errors.WakeupException; import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

import java.util.Properties;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.atomic.AtomicBoolean; /**

* @author mengfanzhu

* @Package bigdata.kafka

* @Description: kafka 消费者

* @date 17/3/8 17:21

*/

public class KafkaConsumerExample { //config

public static Properties getConfig()

{

Properties props = new Properties();

props.put("bootstrap.servers", "10.211.55.3:9092");

props.put("group.id", "testGroup");

props.put("enable.auto.commit", "true");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); return props;

} public void consumeMessage()

{

// launch 3 threads to consume

int numConsumers = 1;

final String topic = "slavetest";

final ExecutorService executor = Executors.newFixedThreadPool(numConsumers);

final List<KafkaConsumerRunner> consumers = new ArrayList<KafkaConsumerRunner>();

for (int i = 0; i < numConsumers; i++) {

KafkaConsumerRunner consumer = new KafkaConsumerRunner(topic);

consumers.add(consumer);

executor.submit(consumer);

} Runtime.getRuntime().addShutdownHook(new Thread()

{

@Override

public void run()

{

for (KafkaConsumerRunner consumer : consumers) {

consumer.shutdown();

}

executor.shutdown();

try {

executor.awaitTermination(5000, TimeUnit.MILLISECONDS);

}

catch (InterruptedException e) {

e.printStackTrace();

}

}

});

} // Thread to consume kafka data

public static class KafkaConsumerRunner

implements Runnable

{

private final AtomicBoolean closed = new AtomicBoolean(false);

private final KafkaConsumer<String, String> consumer;

private final String topic; public KafkaConsumerRunner(String topic)

{

Properties props = getConfig();

consumer = new KafkaConsumer<String, String>(props);

this.topic = topic;

} public void handleRecord(ConsumerRecord record)

{

System.out.println("name: " + Thread.currentThread().getName() + " ; topic: " + record.topic() + " ; offset" + record.offset() + " ; key: " + record.key() + " ; value: " + record.value());

} public void run()

{

try {

// subscribe 订阅`topic

consumer.subscribe(Arrays.asList(topic));

while (!closed.get()) {

//read data

ConsumerRecords<String, String> records = consumer.poll(10000);

// Handle new records

for (ConsumerRecord<String, String> record : records) {

handleRecord(record);

}

}

}

catch (WakeupException e) {

// Ignore exception if closing

e.printStackTrace();

if (!closed.get()) {

throw e;

}

}

finally {

consumer.close();

}

} // Shutdown hook which can be called from a separate thread

public void shutdown()

{

closed.set(true);

consumer.wakeup();

}

} public static void main(String[] args)

{

KafkaConsumerExample example = new KafkaConsumerExample();

example.consumeMessage();

}

}

4.运行效果

附加:代码不多,但是这样直接运行可能会导致消息消费失败,或是异常 "...Failed to send messages after 3 tries.."。原因是因为远程链接kafka时需要指定broker的地址(严格来说是所监听的网络接口,或者网卡)。

解决方案:

修改config/service.properties文件,默认是注释的。

大数据系列之kafka-java实现的更多相关文章

- 大数据系列之kafka监控kafkaoffsetmonitor安装

1.下载kafkaoffsetmonitor的jar包,可以到github搜索kafkaoffsetmonitor,第一个就是,里面可以下载编译好了的包. KafkaOffsetMonitor-ass ...

- 大数据系列之Kafka安装

先简单说下安装kafka的流程..(可配置多个zookeeper,这篇文只说一个zookeeper场景) 1.环境配置:jdk1.7+ (LZ用的是jdk1.8) 2.资料准备:下载 kafka_2. ...

- 大数据系列之Flume+kafka 整合

相关文章: 大数据系列之Kafka安装 大数据系列之Flume--几种不同的Sources 大数据系列之Flume+HDFS 关于Flume 的 一些核心概念: 组件名称 功能介绍 Agent ...

- 大数据系列(3)——Hadoop集群完全分布式坏境搭建

前言 上一篇我们讲解了Hadoop单节点的安装,并且已经通过VMware安装了一台CentOS 6.8的Linux系统,咱们本篇的目标就是要配置一个真正的完全分布式的Hadoop集群,闲言少叙,进入本 ...

- 大数据系列(2)——Hadoop集群坏境CentOS安装

前言 前面我们主要分析了搭建Hadoop集群所需要准备的内容和一些提前规划好的项,本篇我们主要来分析如何安装CentOS操作系统,以及一些基础的设置,闲言少叙,我们进入本篇的正题. 技术准备 VMwa ...

- 大数据系列之并行计算引擎Spark介绍

相关博文:大数据系列之并行计算引擎Spark部署及应用 Spark: Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎. Spark是UC Berkeley AMP lab ( ...

- 大数据系列之数据仓库Hive安装

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列之数据仓库Hive命令使用及JDBC连接

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列之分布式计算批处理引擎MapReduce实践-排序

清明刚过,该来学习点新的知识点了. 上次说到关于MapReduce对于文本中词频的统计使用WordCount.如果还有同学不熟悉的可以参考博文大数据系列之分布式计算批处理引擎MapReduce实践. ...

- 大数据系列之数据仓库Hive原理

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

随机推荐

- MethodHandle

JDK7为间接调用方法引入新的API,在java.lang.invoke包下,可以看作为反射的升级版,但它不像反射API那样显得冗长.繁重 主要的类 MethodHandle 方法句柄.对可直接执行的 ...

- 【明哥报错簿】之 mybatis异常invalid comparison: java.util.Date and java.lang.String

背景:数据库为postgresql,表字段属性为timestamp格式 原因是mybatis 3.3.0中对于时间参数进行比较时的一个bug. 如果拿传入的时间类型参数与空字符串''进行对比判断则会引 ...

- SQL 临时表或表变量替代游标(转)

1.如果表没有自动增长的标识列(int) 使用临时表 SELECT IDENTITY(int) NewID ,.. INTO #tmp FROM YouTable 2.表有标识列 使用表变量 INSE ...

- 什么是P问题,NP问题和NPC问题

转载自:Matrix67的博客 什么是P问题.NP问题和NPC问题 这或许是众多OIer最大的误区之一. 你会经常看到网上出现“这怎么做,这不是NP问题吗”.“这个只有搜了,这已经被证明是NP问 ...

- [JSOI2007]字符加密 后缀数组

题面:洛谷 题解: 我们考虑,如果可以将环上每个长度为len的串都提取出来,再做个排序,那这题我们就做出来了! 但是提取$n^2$,怎么办? 考虑破环成链,再扩充为原来的2倍. 然后直接做后缀排序,把 ...

- linux内核设计与实现第七周读书笔记

第七章 链接 链接(linking)是将各种代码和数据部分收集起来并组合成为一个单一文件的过程,这个文件可被加载(或被拷贝)到存储并执行.链接可以执行于编译时(compile time),也就是在源代 ...

- Ibatis的resultMap和查询数据的对应关系

iBatis和MyBatis 中返回数据对应关系 直接进入主题,现在的项目改用MyBatis了,感觉跟iBatis还是不一样的,比如在判断空值上面,iBatis是有标签的<isNotEmpty& ...

- bzoj 3622 DP + 容斥

LINK 题意:给出n,k,有a,b两种值,a和b间互相配对,求$a>b$的配对组数-b>a的配对组数恰好等于k的情况有多少种. 思路:粗看会想这是道容斥组合题,但关键在于如何得到每个a[ ...

- Redhat安装配置VNC服务器

1. 检查安装VNC服务器 # rpm -qa|grep vnc 如果返回信息中有tigervnc-server,说明已安装了VNC:如果没有: # yum install tigervnc # yu ...

- python 常用模块之ConfigParser

在程序中使用配置文件来灵活的配置一些参数是一件很常见的事情,配置文件的解析并不复杂,在Python里更是如此,在官方发布的库中就包含有做这件事情的库,那就是ConfigParser, Python C ...