flink 1.10.0源码编译

1.安装git

yum -y install git

2.安装maven

安装了3.3以下低版本的maven会有提示升级,这里安装3.6.3

tar zxvf apache-maven-3.6.3-bin.tar.gz

cd apache-maven-3.6.3/

vi conf/settings.xml

增加以下mirror,下载依赖会快很多

<mirror>

<id>nexus-aliyun</id>

<mirrorOf>*,!jeecg,!jeecg-snapshots,!mapr-releases</mirrorOf>

<name>nexus aliyun</name>

<url>https://maven.aliyun.com/nexus/content/groups/public</url>

</mirror>

<mirror>

<id>mapr-aliyun</id>

<mirrorOf>mapr-releases</mirrorOf>

<name>mapr-releases</name>

<url>https://maven.aliyun.com/repository/content/mapr-public</url>

</mirror>

3.拉代码

git clone https://github.com/apache/flink.git

进入到 flink目录后,切换到需要打包的分支

git checkout release-1.10.0

mvn clean install -DskipTests -Dhadoop.version=2.6.5 -Dmaven.javadoc.skip=true -DCheckStyle.skip=true -Drat.skip=true -Dscala.version=2.11.8

然后就开始编译了

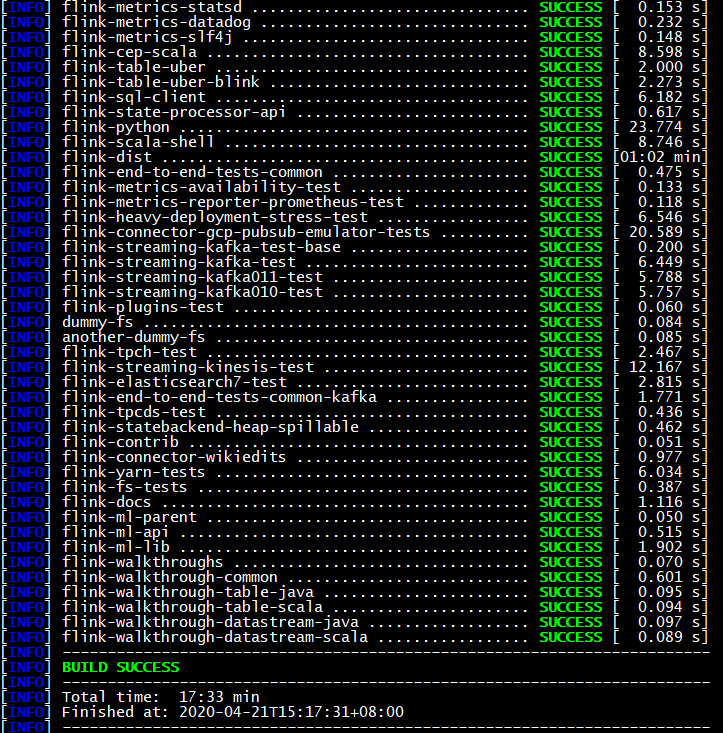

第一次编译,如果运气好,半个小时左右能完成,但是通常会遇到各种各样的问题,在解决问题后编译成功花费了17多分钟

问题解决

1.报错缺少kafka-schema-registry-client-3.3.1.jar 包

[ERROR] Failed to execute goal on project flink-avro-confluent-registry: Could not resolve dependencies for project org.apache.flink:flink-avro-confluent-registry:jar:1.6.2: Could not find artifact io.confluent:kafka-schema-registry-client:jar:3.3.1 in nexus-osc (http://maven.aliyun.com/nexus/content/repositories/central) -> [Help 1]

手动下载kafka-schema-registry-client-3.3.1.jar包,下载地址如下:

将下载的kafka-schema-registry-client-3.3.1.jar上传至主节点的目录下/home/tmp/

手动安装缺少的kafka-schema-registry-client-3.3.1.jar包

mvn install:install-file -DgroupId=io.confluent -DartifactId=kafka-schema-registry-client -Dversion=3.3.1 -Dpackaging=jar -Dfile=/home/tmp/kafka-schema-registry-client-3.3.1.jar

1.安装git

yum -y install git

2.安装maven

安装了3.3以下低版本的maven会有提示升级,这里安装3.6.3

tar zxvf apache-maven-3.6.3-bin.tar.gz

cd apache-maven-3.6.3/

vi conf/settings.xml

增加以下mirror,下载依赖会快很多

<mirror> <id>nexus-aliyun</id> <mirrorOf>*,!jeecg,!jeecg-snapshots,!mapr-releases</mirrorOf> <name>nexus aliyun</name></mirror><mirror> <id>mapr-aliyun</id> <mirrorOf>mapr-releases</mirrorOf> <name>mapr-releases</name></mirror> |

3.拉代码

git clone http://gitlab.xxx.com/dataplatform/flink-1.10.git

输入用户名和密码

切换到需要打包的分支

git checkout dev

mvn clean install -DskipTests -Dhadoop.version=2.6.5 -Dmaven.javadoc.skip=true -DCheckStyle.skip=true -Drat.skip=true -Dscala.version=2.11.8

然后就开始编译了

第一次编译,如果运气好,半个小时左右能完成,但是通常会遇到各种各样的问题,在解决问题后编译成功花费了17多分钟

flink 1.10.0源码编译的更多相关文章

- Spark1.0.0 源码编译和部署包生成

问题导读:1.如何对Spark1.0.0源码编译?2.如何生成Spark1.0的部署包?3.如何获取包资源? Spark1.0.0的源码编译和部署包生成,其本质只有两种:Maven和SBT,只不过针对 ...

- hadoop-1.2.0源码编译

以下为在CentOS-6.4下hadoop-1.2.0源码编译步骤. 1. 安装并且配置ant 下载ant,将ant目录下的bin文件夹加入到PATH变量中. 2. 安装git,安装autoconf, ...

- hadoop-2.6.0源码编译问题汇总

在上一篇文章中,介绍了hadoop-2.6.0源码编译的一般流程,因个人计算机环境的不同, 编译过程中难免会出现一些错误,下面是我编译过程中遇到的错误. 列举出来并附上我解决此错误的方法,希望对大家有 ...

- ambari 2.5.0源码编译安装

参考:https://www.ibm.com/developerworks/cn/opensource/os-cn-bigdata-ambari/index.html Ambari 是什么 Ambar ...

- hadoop-2.0.0-mr1-cdh4.2.0源码编译总结

准备编译hadoop-2.0.0-mr1-cdh4.2.0的同学们要谨慎了.首先看一下这篇文章: Hadoop作业提交多种方案 http://www.blogjava.net/dragonHadoop ...

- Ubantu16.04进行Android 8.0源码编译

参考这篇博客 经过测试,8.0源码下载及编译之后,占用100多G的硬盘空间,尽量给ubantu系统多留一些硬盘空间,如果后续需要在编译好的源码上进行开发,需要预留更多的控件,为了防止后续出现文件权限问 ...

- Spark2.0.0源码编译

Hive默认使用MapReduce作为执行引擎,即Hive on mr,Hive还可以使用Tez和Spark作为其执行引擎,分别为Hive on Tez和Hive on Spark.由于MapRedu ...

- Tomcat8.0源码编译

最近打算开始研究一下Tomcat的工作原理,拜读一下源码.所以先从编译源码开始了.尽管网上有那么多的资料,但是总是觉得,自己研究一遍,写一遍,在动手做一遍能够让我们更加深入的了解.现在整个社会都流行着 ...

- 使用Maven将Hadoop2.2.0源码编译成Eclipse项目

编译环境: OS:RHEL 6.3 x64 Maven:3.2.1 Eclipse:Juno SR2 Linux x64 libprotoc:2.5.0 JDK:1.7.0_51 x64 步骤: 1. ...

- jmeter4.0 源码编译 二次开发

准备: 1.jmeter4.0源码 - apache-jmeter-4.0_src.zip 2.IDE Eclipse - Oxygen.3 Release (4.7.3) 3.JDK - 1.8.0 ...

随机推荐

- Android IO 框架 Okio 的实现原理,到底哪里 OK?

本文已收录到 AndroidFamily,技术和职场问题,请关注公众号 [彭旭锐] 提问. 前言 大家好,我是小彭. 今天,我们来讨论一个 Square 开源的 I/O 框架 Okio,我们最开始接触 ...

- 简单了解C语言如何构建多文件项目

简单理解C语言如何构建工程 首先我们最好有一个好用的编辑器,vscode也好,visual studio也罢,dev也行,这里我们使用的是code::block: 一.了解C语言工程的构建原理 首 ...

- 学习Java Day11

今天学习了二维数组:

- 在react项目如何捕获错误

在React项目是如何捕获错误的? 一.是什么 错误在我们日常编写代码是非常常见的 举个例子,在react项目中去编写组件内JavaScript代码错误会导致 React 的内部状态被破坏,导致整个应 ...

- 安卓开发 java控制UI

创建布局管理器对象 设置背景 设置活动界面 按钮事件 按钮显示

- LeetCode 39. 组合总和 40.组合总和II 131.分割回文串

欢迎关注个人公众号:爱喝可可牛奶 LeetCode 39. 组合总和 40.组合总和II 131.分割回文串 LeetCode 39. 组合总和 分析 回溯可看成对二叉树节点进行组合枚举,分为横向和纵 ...

- jsHtml解码

//将HTML代码转换为文本 function HTMLDecode(text) { var temp = document.createElement("div"); temp. ...

- vscode+eslint项目规范化,自动格式化配置(项目中用到的)

项目如果没有格式化插件就会变得十分拥挤,并且因为个人的开发习惯不同,会导致多人配合的时候,某些人的格式不能与你的兼容 导致项目大面积冲突,这样一来统一的格式和开发规范就十分必要了. 1.下载使用vsc ...

- RocketMQ - 消费者Rebalance机制

客户端是通过Rebalance服务做到高可靠的.当发生Broker掉线.消费者实例掉线.Topic 扩容等各种突发情况时,消费者组中的消费者实例是怎么重平衡,以支持全部队列的正常消费的呢? Rebal ...

- Spring cloud Sleuth 分布式链路跟踪

在微服务框架种. 一个由客户端发起的请求在后端系统种会经过不同的服务节点来调用协同产生的最后的请求结果. 每一个前端请求都会形成一条复杂的分布式服务调用的链路.链路种出现任何一环出现高延时或者错误都会 ...