Kubernetes_从零开始搭建k8s集群(亲测可用)

一、前言

本文讲述从零开始搭建k8s集群,均使用国内镜像,版本均统一,使用两个虚拟机,一个主节点,一个从节点,保证k8s一次搭建成功。

注意:Kubernetes,简称K8s,是用8代替名字中间的8个字符“ubernete”而成的缩写。

二、Centos最小化安装

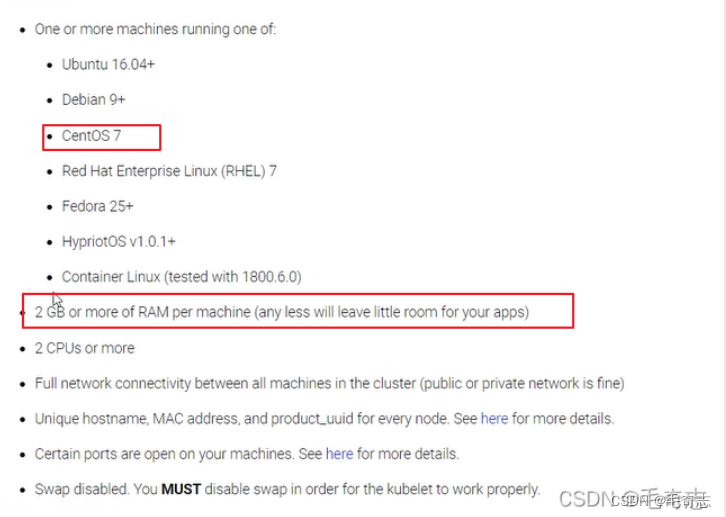

安装K8S需要使用Centos7,每个机器至少2个处理器和2G,这是k8s官网是要求的。

2.1 vmware最小化安装centos7

vmware最小化安装centos7,下载好镜像,不断下一步,直到完成。

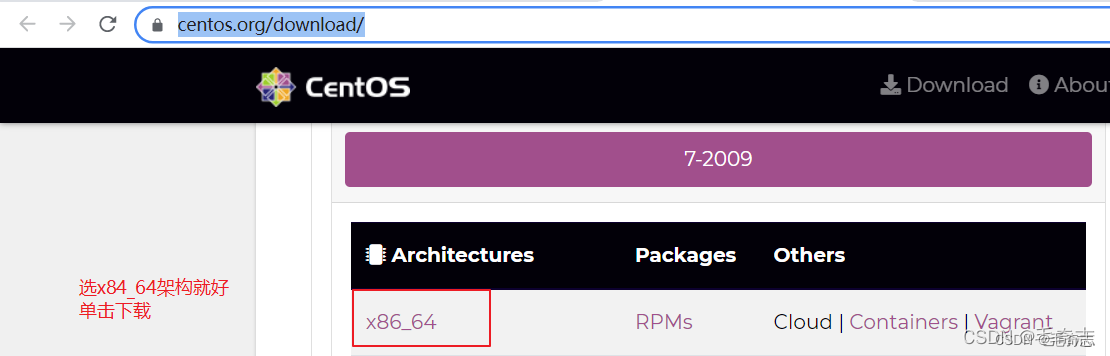

先到官网 https://www.centos.org/download/ 下载centos.iso,如下:

国内的,直接选阿里云镜像就好 http://mirrors.aliyun.com/centos/7.9.2009/isos/x86_64/

具体安装可以参见 https://www.cnblogs.com/liuhui-xzz/p/10155511.html

其实没这么麻烦,只需要配置磁盘这个必选就好了,其他都不用配置,不断下一步,最好就安装好了。

2.2 配置静态IP

创建好的虚拟机 ping www.baidu.com 失败,需要配置好静态ip,才能连同外网。

输入 vi /etc/sysconfig/network-scripts/ifcfg-ens33 然后按照如下图编辑,最后 service network restart 保存即可

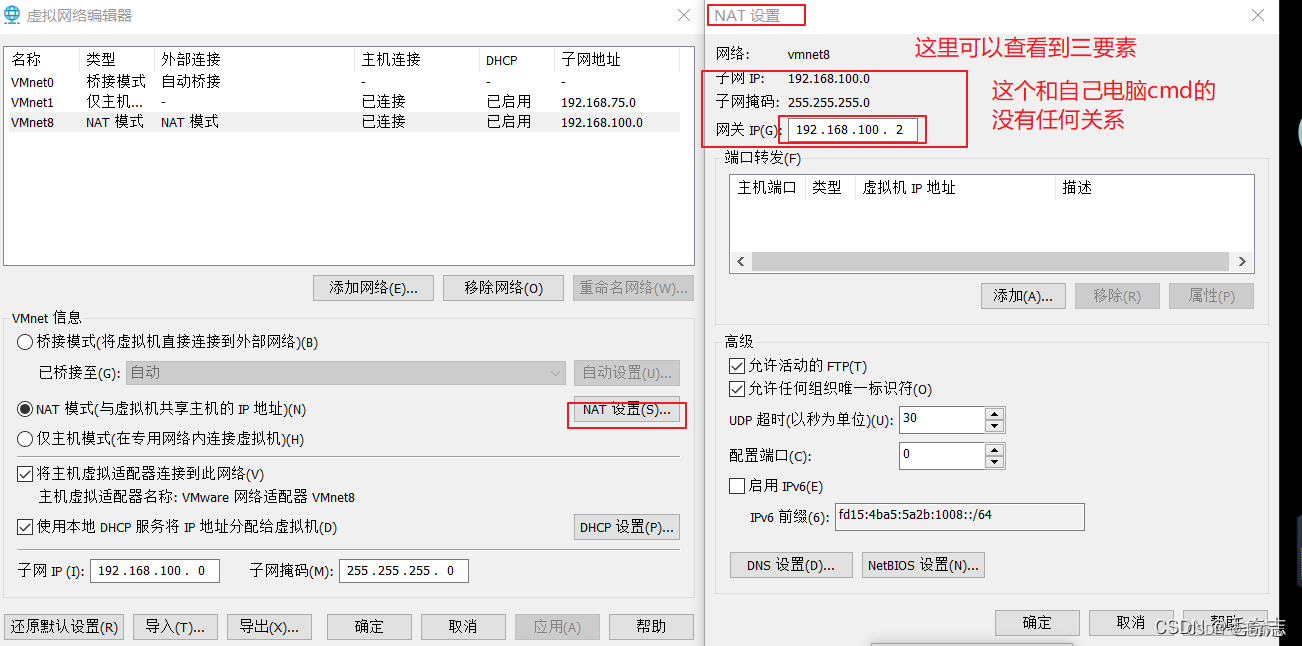

BOOTPROTO=static ONBOOT=yes DNS1=114.114.114.114 这三个是写死的,那么其他三个ip 子网掩码 网关是如何确定的呢?这个和本机的ip无关,只和vmware的虚拟网络编辑器有关。

vware的虚拟网络编辑器,需要配置子网掩码、子网ip、网关ip

首先是子网掩码,一般都是C类,配置为 255.255.255.0 ,没什么好说的,然后是子网ip,这个子网ip要受到子网掩码的限制,只有前面三个字节,最后一个字节为0,一般是 xxx.xxx.xxx.0,这里子网IP配置为192.168.100.0,然后再是网关(就是虚拟网络编辑器的ip),网关ip又受到子网ip的限制,前面三个字节需要和子网ip一样,表示是这个子网段内的ip,这里配置为192.168.100.2,其他可以配置为该子网内任意一个 192.168.100.1 - 192.168.100.127,如下图:

配置好虚拟网络编辑器之后,再来看静态ip的三个字段,NETMASK=255.255.255.0 没问题,c类都是这样配置,然后是网关ip GATEWAY,这里必须和虚拟网络编辑器的那个网关ip一致就是192.168.100.2,所以配置GATEWAY=192.168.100.2,然后就是自己的IPADDR了,要保证两点,在子网段内 且 不和网关ip及该子网段内其他ip冲突,在子网段内就是 192.168.100 开头,不和网关ip及该子网段内其他ip冲突,就是最后一个不能为 2 或者其他用过的,所以一个是 150 一个是151,即 192.168.100.150 和 192.168.100.151 。

配置静态ip之后,就可以用xshell连接并操作了,不用再使用vmware敲命令,也有yum命令,缺少什么都可以随时下载,比如最小安装没有wget命令,可以yum -y install wget。

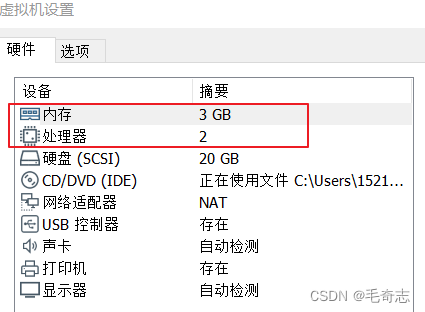

因为我们的两个虚拟机需要作为K8S的两个节点,每个虚拟机处理数量一定要大于等于2,每个虚拟机内存数量一定要大于等于2G,vmware默认是每个虚拟机处理器数量是1,内存是1G,需要手动设置一下,

三、K8S集群搭建

从3.1到3.6,所有机器都执行

3.7和3.8只在主节点上执行

3.9的kube join只在从节点上执行(测试kubectl get nodes在主节点上执行,因为从节点没有.kube/,无法通过kubectl操作k8s集群)

3.10集群新建pod测试,在主节点上执行,因为从节点没有.kube/,无法通过kubectl操作k8s集群

3.1 更新yum

3台机器都需要执行

yum -y update

yum install -y conntrack ipvsadm ipset jq sysstat curl iptables libseccomp

3.2 安装Docker

在每一台机器上都安装好Docker,版本为18.09.0

01 安装必要的依赖

sudo yum install -y yum-utils \

device-mapper-persistent-data \

lvm2

02 设置docker仓库

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

然后设置一下阿里云镜像加速器

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://orptaaqe.mirror.aliyuncs.com"]

}

EOF

sudo systemctl daemon-reload

03 安装docker

yum install -y docker-ce-18.09.0 docker-ce-cli-18.09.0 containerd.io

04 启动docker

sudo systemctl start docker && sudo systemctl enable docker

05 检查docker是否安装并启动好了

ps -ef|grep docker

3.3 修改hosts文件

01 机器192.168.100.150执行两句

sudo hostnamectl set-hostname m

vi /etc/hosts

192.168.100.150 m

192.168.100.151 w1

02 机器192.168.100.151执行两句

sudo hostnamectl set-hostname w1

vi /etc/hosts

192.168.100.150 m

192.168.100.151 w1

03 每天机器上都要测试

ping m

ping w1

每个步骤配置完成之后,都要局部测试,这样才不会出问题

3.4 系统基础前提配置

每个机器上都要执行(机器192.168.100.150 和 机器192.168.100.151),如下:

# (1)关闭防火墙

systemctl stop firewalld && systemctl disable firewalld

# (2)关闭selinux

setenforce 0

sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

# (3)关闭swap 且 写入到 /etc/fstab 文件中,保证重启机器也生效

swapoff -a

sed -i '/swap/s/^\(.*\)$/#\1/g' /etc/fstab

# (4)配置iptables的ACCEPT规则

iptables -F && iptables -X && iptables -F -t nat && iptables -X -t nat && iptables -P FORWARD ACCEPT

# (5)设置系统参数

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

3.5 安装 kubeadm, kubelet and kubectl

每个机器上都要执行(机器192.168.100.150 和 机器192.168.100.151),如下:

(1)配置yum源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

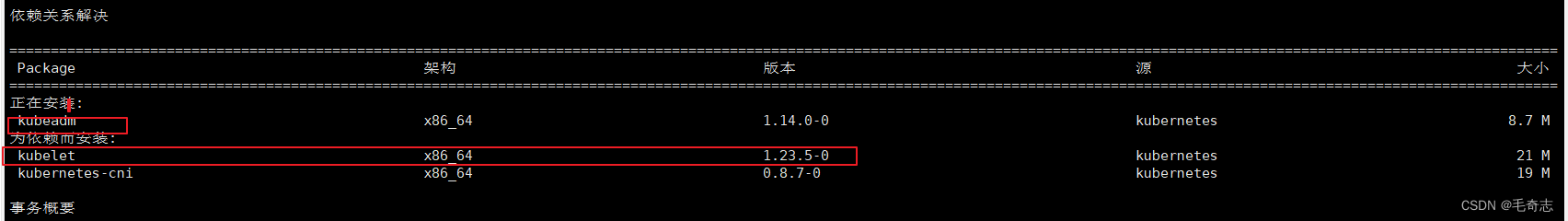

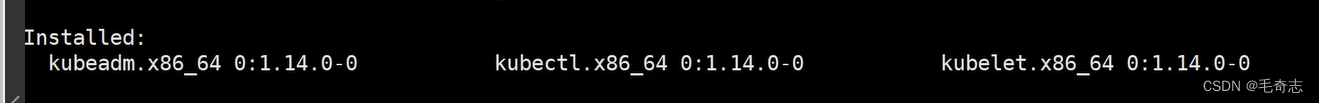

(2)安装kubeadm&kubelet&kubectl

yum install -y kubectl-1.14.0-0

yum install -y kubelet-1.14.0-0

yum install -y kubeadm-1.14.0-0

这三个东西一定要保证版本统一,一定要安装这个安装顺序来完成

因为kubeadm依赖kubelet,如果先安装kubeadm,则kubelet的1.23版本就会被安装上去,然后再执行 yum install -y kubelet-1.14.0-0 会安装不上去,然后版本不统一,主节点初始化init报错

这才是正确的

及时测试:

kubectl version

kubelet --version

kubeadm version

版本必须都是 1.4.0,如果版本错了要删除

yum -y remove kubelet

yum -y remove kubectl

yum -y remove kubeadm

(3) docker和k8s设置同一个cgroup

# 编辑docker的daemon.json文件,每个节点都要执行

vi /etc/docker/daemon.json

"exec-opts": ["native.cgroupdriver=systemd"],

systemctl restart docker

# kubelet,这边如果发现输出directory not exist,也说明是没问题的,大家继续往下进行即可

sed -i "s/cgroup-driver=systemd/cgroup-driver=cgroupfs/g" /etc/systemd/system/kubelet.service.d/10-kubeadm.conf

systemctl enable kubelet && systemctl start kubelet

3.6 配置国内镜像

(1) 创建kubeadm.sh脚本,用于拉取镜像/打tag/删除原有镜像

#!/bin/bash

set -e

KUBE_VERSION=v1.14.0

KUBE_PAUSE_VERSION=3.1

ETCD_VERSION=3.3.10

CORE_DNS_VERSION=1.3.1

GCR_URL=k8s.gcr.io

ALIYUN_URL=registry.cn-hangzhou.aliyuncs.com/google_containers

images=(kube-proxy:${KUBE_VERSION}

kube-scheduler:${KUBE_VERSION}

kube-controller-manager:${KUBE_VERSION}

kube-apiserver:${KUBE_VERSION}

pause:${KUBE_PAUSE_VERSION}

etcd:${ETCD_VERSION}

coredns:${CORE_DNS_VERSION})

for imageName in ${images[@]} ; do

docker pull $ALIYUN_URL/$imageName

docker tag $ALIYUN_URL/$imageName $GCR_URL/$imageName

docker rmi $ALIYUN_URL/$imageName

done

(2) 运行脚本和查看镜像

# 运行脚本

sh ./kubeadm.sh

# 查看镜像

docker images

至此,上面的3.1到3.6是每个节点都要执行的,就是机器 192.168.100.150 和 192.168.100.151 都要同时执行的,在Xshell里面,通过

3.7 kube init初始化master

到此为止,两个机器 192.168.100.150 和 192.168.100.151 还需要没有主次之分,还没有说哪个是k8s的主节点,现在 3.7 这个步骤只需要在 192.168.100.150 节点执行,让这个机器成为k8s主节点。

(2)初始化master节点

kubeadm init --kubernetes-version=1.14.0 \

--apiserver-advertise-address=192.168.100.150 --pod-network-cidr=10.244.0.0/16

在 192.168.100.150 机器上执行,然后这个 --apiserver-advertise-address=192.168.100.150 这样写

会得到一句

kubeadm join 192.168.100.150:6443 --token 7oahxf.bk0rywevgu0xjouy

–discovery-token-ca-cert-hash sha256:4f84a48cc41343848d0b2f807c38937bc96d3d43e821f06b0c143a5282a38204

一定要复制粘贴出来,下一个步骤在 192.168.100.151 机器上执行这句。

初始化完成执行后,继续只在 主节点 上执行,这三句,如下:

mkdir -p $HOME/.kube

cd .kube/

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

注意:我们所说的只有主节点才能通过 kubectl 命令操作k8s集群是因为,只有主节点上才完成这三步操作,才有 .kube 目录,如果从节点上也完成了这三句,也有 .kube 目录,也是可以通过 kubectl 命令操作k8s集群的。

(4) 测试:验证pod和健康检查(这两句也是只在master节点上执行)

# 验证pod

kubectl get pods -n kube-system

# 健康检查(不要怀疑,就是healthz)

curl -k https://localhost:6443/healthz

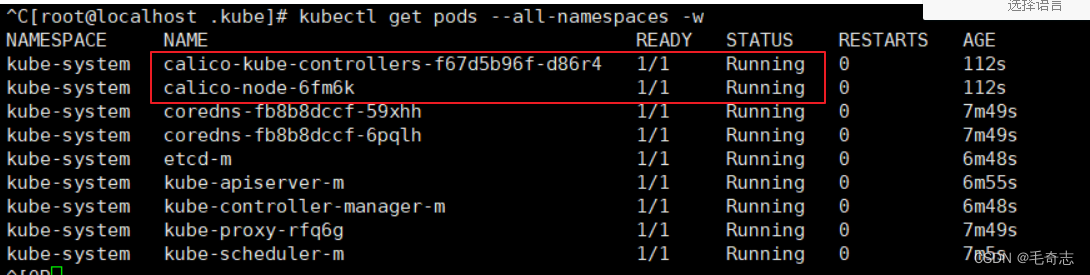

3.8 部署calico网络插件

k8s中,网络插件是为了k8s集群内部通信,所以必须安装一个网络插件,有很多选择,这里选择calico,同样在master节点上操作

# 在k8s中安装calico(这条命令很快的)

kubectl apply -f https://docs.projectcalico.org/v3.9/manifests/calico.yaml

# 确认一下calico是否安装成功 -w可以实时变化(看到calico都好了表示网络插件好了)

kubectl get pods --all-namespaces -w

测试验证是否安装成功,这里的calico两个显示Running就表示安装成功了。

从3.1到3.6,所有机器都执行,3.7和3.8只在主节点上执行,接下来的3.9的kube join只在从节点上执行(测试kubectl get nodes在主节点上执行,因为从节点没有.kube/,无法通过kubectl操作k8s集群)

3.9 kube join

(1) 在从节点上执行kube join命令,如下

kubeadm join 192.168.100.150:6443 --token 7oahxf.bk0rywevgu0xjouy \

--discovery-token-ca-cert-hash sha256:4f84a48cc41343848d0b2f807c38937bc96d3d43e821f06b0c143a5282a38204

记得保存初始化master节点的最后打印信息,注意这边大家要自己的,下面我的只是一个参考

(2)在master节点上检查集群信息(node的正常状态是ready,pod的正常状态是running)

kubectl get nodes

当每个节点都是Ready,表示完成。

3.10 新建Pod测试整个集群

(1)定义pod.yml文件,比如pod_nginx_rs.yaml

cat > pod_nginx_rs.yaml <<EOF

apiVersion: apps/v1

kind: ReplicaSet

metadata:

name: nginx

labels:

tier: frontend

spec:

replicas: 3

selector:

matchLabels:

tier: frontend

template:

metadata:

name: nginx

labels:

tier: frontend

spec:

containers:

- name: nginx

image: nginx

ports:

- containerPort: 80

EOF

(2)根据pod_nginx_rs.yml文件创建pod

kubectl apply -f pod_nginx_rs.yaml

(3)查看pod

kubectl get pods

kubectl get pods -o wide

kubectl describe pod nginx

(4)感受通过rs将pod扩容

kubectl scale rs nginx --replicas=5

kubectl get pods -o wide

(5)删除pod

kubectl delete -f pod_nginx_rs.yaml

四、尾声

从零开始搭建k8s集群,完成了。

天天打码,天天进步!!

Kubernetes_从零开始搭建k8s集群(亲测可用)的更多相关文章

- 安装k8s集群(亲测)

先安装一台虚拟机,然后进行克隆,因为前面的步骤都是一样的,具体代码如下: Last login: Mon Nov 25 00:40:34 2019 from 192.168.180.1 ##安装依赖包 ...

- kubeadm 搭建 K8S集群

kubeadm是K8s官方推荐的快速搭建K8s集群的方法. 环境: Ubuntu 16.04 1 安装docker Install Docker from Ubuntu’s repositories: ...

- kubeadm搭建K8s集群及Pod初体验

基于Kubeadm 搭建K8s集群: 通过上一篇博客,我们已经基本了解了 k8s 的基本概念,也许你现在还是有些模糊,说真的我也是很模糊的.只有不断地操作去熟练,强化自己对他的认知,才能提升境界. 我 ...

- 教你用multipass快速搭建k8s集群

目录 前言 一.multipass快速入门 安装 使用 二.使用multipass搭建k8s集群 创建3台虚拟机 安装master节点 安装node节点 测试k8s集群 三.其他问题 不能拉取镜像:报 ...

- K8S集群Master高可用实践

K8S集群Master高可用实践 https://blog.51cto.com/ylw6006/2164981 本文将在前文基础上介绍k8s集群的高可用实践,一般来讲,k8s集群高可用主要包含以 ...

- 搭建K8S集群

一.前言 我们将现有的虚拟机称之为Node1,用作主节点.为了减少工作量,在Node1安装Kubernetes后,我们利用VirtualBox的虚拟机复制功能,复制出两个完全一样的虚拟机作为工作节点. ...

- 1 搭建K8s集群

官网:https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/install-kubeadm/#installing ...

- Rancher 下图形界面 搭建 K8S 集群

首先我们准备4台 2核3G 的 centos 7 温馨提示:先安装好一台 CentOS 的虚拟机,并且安装好 docker,永久关闭防火墙. 再这个基础上我们分别克隆出四台 Rancher.K8S1. ...

- 从0到1搭建k8s集群系列1:安装虚拟机及docker

前言 本系列文章记录了本人学习k8s集群搭建的过程,从k8s基本组件的安装.到部署mysql服务到k8s集群.部署web项目到k8s集群以及安装可视化界面管理工具kuboard. 因为k8s的组件安装 ...

- CentOS7 使用 kubeadm 搭建 k8s 集群

一 安装Docker-CE 前言 Docker 使用越来越多,安装也很简单,本次记录一下基本的步骤. Docker 目前支持 CentOS 7 及以后的版本,内核要求至少为 3.10. Docker ...

随机推荐

- KingbaseESV8R3对于order by null列的处理

背景 客户遇到一个现象order by 列是null的时候,最后一行总是显示相同的值.不要问我为什么对空值排序,意义何在?客户代码如此,客户不愿意改代码,作为dba大家都懂的.客户认为即使对null排 ...

- KingbaseES V8R6 集群环境wal日志清理

案例说明: 1.对于集群中的wal日志,除了需要在备库执行recovery外,在集群主备切换(switchover或failover)时,sys_rewind都要读取wal日志,将数据库恢复到一致性状 ...

- 【读书笔记】C#高级编程 第六章 数组

(一)同一类型和不同类型的多个对象 如果需要使用同一类型的多个对象,就可以使用数组或集合(后面章讲). 如果需要使用不同类型的多个对象,可以使用Tuple(元组)类型. (二)简单数组 如果需要使用同 ...

- Gitea 1.17.2 | 带来视觉提升、完善资源校验、加强安全性等42项优化

Gitea 1.17.2 合并了 42 个 Pull Request,现已正式发布,我们建议所有用户升级到此版本.您可以到阅读原文了解更详细的介绍. 致谢:@zeripath 为 Gitea 贡献了诸 ...

- 04-MyBatisPlus条件构造器

一.wapper介绍 Wrapper : 条件构造抽象类,最顶端父类 AbstractWrapper : 用于查询条件封装,生成 sql 的 where 条件 QueryWrapper : Entit ...

- 微服务系列之授权认证(一) OAuth 2.0 和 OpenID Connect

1.传统架构的授权认证 传统应用架构,用户使用账号密码登录后,可以使用前端cookie存储登录状态,也可以使用后端session方式存储登录状态,小应用这么做其实很高效实用,当应用需要横向扩展时,就需 ...

- 微服务系列之Api文档 swagger整合

1.前言 微服务架构随之而来的前后端彻底分离,且服务众多,无论是前后端对接亦或是产品.运营翻看,一个现代化.规范化.可视化.可尝试的文档是多么重要,所以我们这节就说说swagger. Swagger是 ...

- 第六章:Django 综合篇 - 11:分页 Paginator

分页功能是几乎所有的网站上都需要提供的功能,当你要展示的条目比较多时,必须进行分页,不但能减小数据库读取数据压力,也有利于用户浏览. Django又很贴心的为我们提供了一个Paginator分页工具, ...

- Traefik 2.0 暴露 Redis(TCP) 服务

文章转载自:https://mp.weixin.qq.com/s?__biz=MzU4MjQ0MTU4Ng==&mid=2247484452&idx=1&sn=0a17b907 ...

- csv2ECharts,**一行命令查看数据趋势图 工具分享**

csv2ECharts 一行命令查看数据趋势图! 联系:luomgf@163.com,欢迎交流提出建议 只有一个文件,基于shell,实现将CSV格式数据转化为数据图.运维中尝尝需要查看某个监控指标的 ...