python爬虫学习心得:中国大学排名(附代码)

今天下午花时间学习了python爬虫的中国大学排名实例,颇有心得,于是在博客园与各位分享

首先直接搬代码:

import requests

from bs4 import BeautifulSoup

import bs4 def getHTMLText(url):

try:

r = requests.get(url,timeout = 30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "" def fillUnivList(ulist, html):

soup = BeautifulSoup(html,"html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr,bs4.element.Tag):

tds = tr.find_all('td')

ulist.append([tds[0].string,tds[1].string,tds[3].string]) def printUnivList(ulist,num):

tplt = "{0:^10}\t{1:{3}^10}\t{2:^10}"

print(tplt.format("排名","学校","总分",chr(12288)))

for i in range(num):

u = ulist[i]

print(tplt.format(u[0],u[1],u[2],chr(12288))) def main():

uinfo = []

url = "http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html"

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo,20)

main()

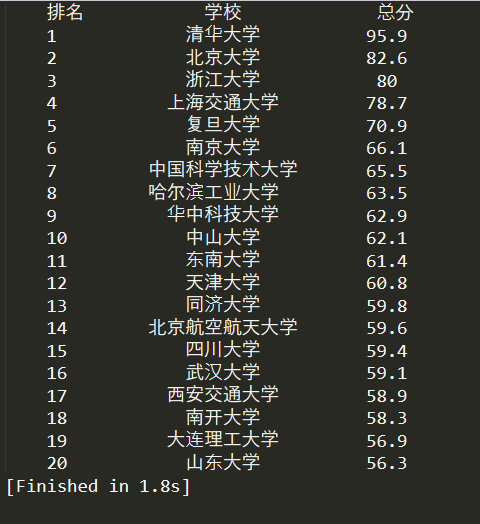

再附上大学排名截图:

那么,现在开始代码心得讲解:

首先开始分析网页结构:

打开http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html

打开chrome网页分析工具:

可以发现大学排名,学校名称,省市,总分等都处在tbody标签内

而大学名称、省市等,都处于tr标签内的td中

好,分析完成,开始构建函数架构:

主要思想为:获取网页html文本,得到需求数据,并将需求数据转化为列表,最后将列表输出

下一步:开始补充getHTMLText()部分的代码:

这里我用try except形式编写代码:

首先获取网页url,时限为30s,j接着运用 r.raise_for_status()(如果 HTTP 请求返回了不成功的状态码, r.raise_for_status() 会抛出一个 HTTPError异常)

然后将网页转码为r.apparent_encoding

返回一个r.text

这里代码运行中如果出现错误,则会return "",返回一个空字符串

接下来开始编写fillUnivList()部分代码

我们先做一锅汤,定义为soup,然后在这锅汤中遍历tr的孩子,这里每一个tr都对应一所大学的信息

而且我们需要滤掉非标签类型的其他信息,所以运用isinstance对函数类型做一个判断

if isinstance(tr,bs4.element.Tag):

这行代码就是检测标签类型,如果标签不是bs4库定义的类型,将过滤掉,同时为了运用这个方法,我们也就需要引入bs4库

由于tr标签已经被解析出来,接下来就需要对tr标签中的td标签做查询

if isinstance(tr,bs4.element.Tag):

tds = tr.find_all('td')

这里把查询到的td标签存入tds列表中

再然后在ulist表中增加:排名,大学名和总分的对应字段

ulist.append([tds[0].string,tds[1].string,tds[3].string])

接着来编写printUnivList()函数

注意:这里的{:^10}表示取10位居中对齐,^是居中对齐,\t是横向制表符。

ok,主要代码完成,希望可以帮到你。

python爬虫学习心得:中国大学排名(附代码)的更多相关文章

- python爬虫学习心得

作为一名python的忠实爱好者,我开始接触爬虫是在2017年4月份,最开始接触它的时候遇到两个梗,一个是对python还不算太了解(当然现在也仍然在努力学习它的有关内容),二是对爬虫心怀一份敬畏之心 ...

- Python爬虫学习第一记 (翻译小助手)

1 # Python爬虫学习第一记 8.24 (代码有点小,请放大看吧) 2 3 #实现有道翻译,模块一: $fanyi.py 4 5 import urllib.request 6 import u ...

- Python之爬虫-中国大学排名

Python之爬虫-中国大学排名 #!/usr/bin/env python # coding: utf-8 import bs4 import requests from bs4 import Be ...

- python网络爬虫-中国大学排名定向爬虫

爬虫定向爬取中国大学排名信息 #!/usr/bin/python3 import requests from bs4 import BeautifulSoup import bs4 #从网络上获取大学 ...

- 《Python爬虫学习系列教程》学习笔记

http://cuiqingcai.com/1052.html 大家好哈,我呢最近在学习Python爬虫,感觉非常有意思,真的让生活可以方便很多.学习过程中我把一些学习的笔记总结下来,还记录了一些自己 ...

- [转]《Python爬虫学习系列教程》

<Python爬虫学习系列教程>学习笔记 http://cuiqingcai.com/1052.html 大家好哈,我呢最近在学习Python爬虫,感觉非常有意思,真的让生活可以方便很多. ...

- python爬虫学习(1) —— 从urllib说起

0. 前言 如果你从来没有接触过爬虫,刚开始的时候可能会有些许吃力 因为我不会从头到尾把所有知识点都说一遍,很多文章主要是记录我自己写的一些爬虫 所以建议先学习一下cuiqingcai大神的 Pyth ...

- python爬虫学习 —— 总目录

开篇 作为一个C党,接触python之后学习了爬虫. 和AC算法题的快感类似,从网络上爬取各种数据也很有意思. 准备写一系列文章,整理一下学习历程,也给后来者提供一点便利. 我是目录 听说你叫爬虫 - ...

- Python爬虫学习:三、爬虫的基本操作流程

本文是博主原创随笔,转载时请注明出处Maple2cat|Python爬虫学习:三.爬虫的基本操作与流程 一般我们使用Python爬虫都是希望实现一套完整的功能,如下: 1.爬虫目标数据.信息: 2.将 ...

随机推荐

- 部署kube-proxy组件

目录 前言 创建kube-proxy证书签名请求 创建和分发 kubeconfig 文件 创建kube-proxy配置文件 分发和创建kube-proxy配置文件 创建和分发 kube-proxy s ...

- Android手机打造你的Python&Java开发工具!

开发者桌面 之前写过一篇文章:将Android手机打造成你的python开发者桌面 在安卓手机上通过Termux软件,创建一个模拟Linux系统,它的好处就是无需root,即可在手机中编写Python ...

- Aria2GUI for macOS - 百度网盘高速下载

目录 一. aria2gui 1.1 下载地址:aria2gui 1.2 安装 1.2.1 方式一:手动安装 1.2.2 方式二:Homebrew安装 二. YAAW for Chrome 2.1 下 ...

- JavaScript1 基础

JavaScript的组成 ·ECMAScript 描述了语言的语法和基本对象/ ·DOM 文档对象模型,描述处理网页内容/ BOM 浏览器对象模型 描述与浏览器进行交互的方法和接口 引入方式/ h ...

- 洛谷 题解 P2296 【寻找道路】

Problem P2296 [寻找道路] solution 首先声明,这题我用了spfa,而: 关于spfa:它死了. 杀手: NOI 2018−T1 出题人 感谢出题人,没有卡spfa 用时: 20 ...

- 转-友晶Sdram_Control_4Port的全页操作Bug?

http://www.cnblogs.com/edaplayer/p/3678897.html 以前在学校初学fpga的时候碰到sdram就搞不定了,现在突然发现网上有好多现成的代码,友晶的,alte ...

- 【React】354- 一文吃透 React 事件机制原理

大纲 主要分为4大块儿,主要是结合源码对 react事件机制的原理 进行分析,希望可以让你对 react事件机制有更清晰的认识和理解. 当然肯定会存在一些表述不清或者理解不够标准的地方,还请各位大神. ...

- 【MySql】使用学习

[MySql]使用学习 =================================================== 1.太多的连接 Too many connections ======= ...

- 大数据项目2(Java8聚合操作)

前言:为很好的理解这些方法,你需要熟悉java8特性Lambda和方法引用的使用 一:简介 我们用集合的目的,往往不是简单的仅仅把数据保存哪里.而是要检索(遍历)或者去计算或统计....操作集合里面的 ...

- webpack实践(三)- html-webpack-plugin

webpack系列博客中代码均在github上:https://github.com/JEmbrace/webpack-practice <webpack实践(一)- 先入个门> < ...