受限玻尔兹曼机(Restricted Boltzmann Machine)

受限玻尔兹曼机(Restricted Boltzmann Machine)

作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/

1. 生成模型

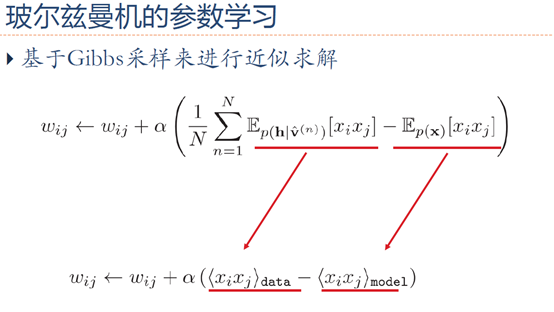

2. 参数学习

3. 对比散度学习算法

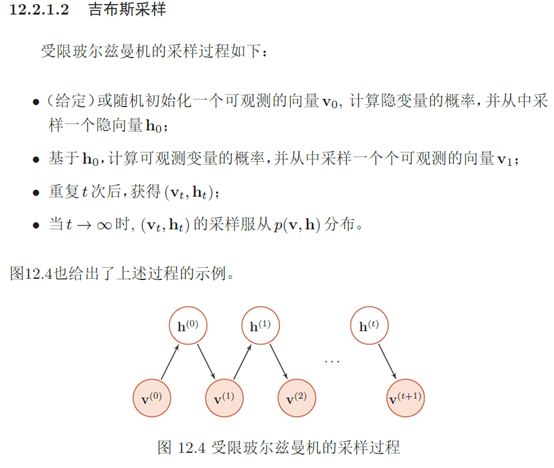

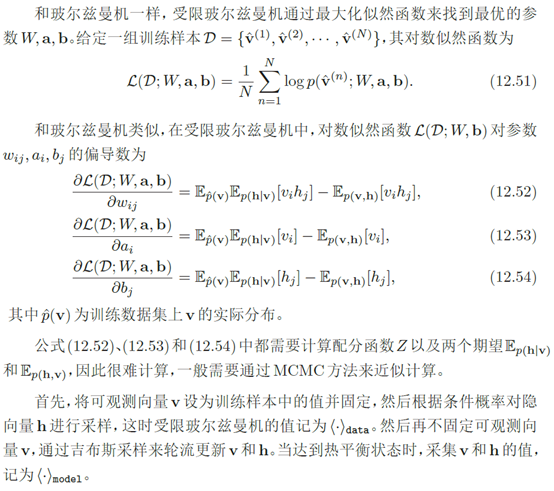

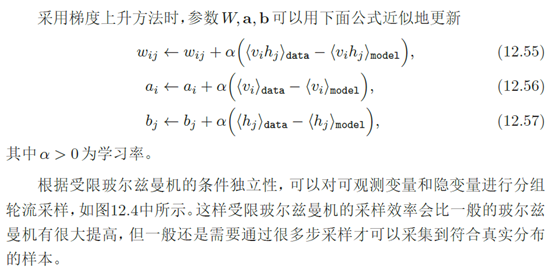

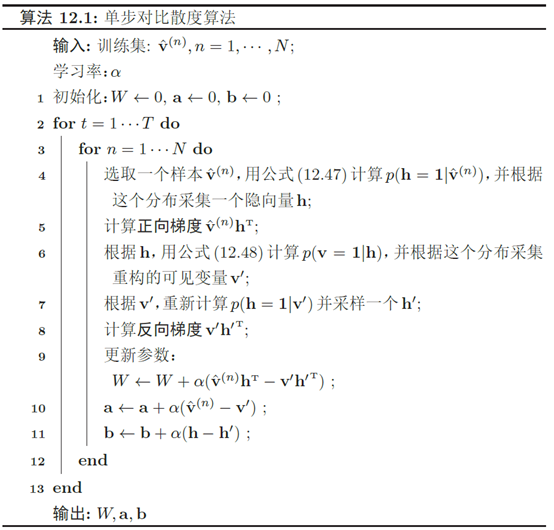

由于受限玻尔兹曼机的特殊结构,因此可以使用一种比吉布斯采样更有效 的学习算法,即对比散度(Contrastive Divergence)对比散度算法仅需k步吉布斯采样。为了提高效率,对比散度算法用一个训练样本作为可观测向量的初始值。然后,交替对可观测向量和隐藏向量进行吉布斯采样,不需要等到收敛,只需要k步就足够了。这就是CD-k 算法。通常,k = 1就可以学得很好。对比散度的流程如算法12.1所示。

4. MATLAB程序解读

% maxepoch -- 最大迭代次数maximum number of epochs

% numhid -- 隐含层神经元数number of hidden units

% batchdata -- 分批后的训练数据集the data that is divided into batches (numcases numdims numbatches)

% restart -- 如果从第1层开始学习,就置restart为1set to 1 if learning starts from beginning %作用:训练RBM,利用1步CD算法 直接调用权值迭代公式不使用反向传播

%可见的、二元的、随机的像素通过对称加权连接连接到隐藏的、二元的、随机的特征检测器

epsilonw = 0.1; % Learning rate for weights 权重学习率 alpha

epsilonvb = 0.1; % Learning rate for biases of visible units 可视层偏置学习率 alpha

epsilonhb = 0.1; % Learning rate for biases of hidden units 隐藏层偏置学习率 alpha

weightcost = 0.0002; %权衰减,用于防止出现过拟合

initialmomentum = 0.5; %动量项学习率,用于克服收敛速度和算法的不稳定性之间的矛盾

finalmomentum = 0.9; [numcases numdims numbatches]=size(batchdata);%[numcases numdims numbatches]=[每批中的样本数 每个样本的维数 训练样本批数] if restart ==1 %是否为重新开始即从头训练

restart=0;

epoch=1; % Initializing symmetric weights and biases. 初始化权重和两层偏置

vishid = 0.1*randn(numdims, numhid);% 连接权值Wij 784*1000

hidbiases = zeros(1,numhid);% 隐含层偏置项bi

visbiases = zeros(1,numdims);% 可视化层偏置项aj poshidprobs = zeros(numcases,numhid); %样本数*隐藏层NN数,隐藏层输出p(h1|v0)对应每个样本有一个输出 100*1000

neghidprobs = zeros(numcases,numhid); %重构数据驱动的隐藏层

posprods = zeros(numdims,numhid); % 表示p(h1|v0)*v0,用于更新Wij即<vihj>data 784*1000

negprods = zeros(numdims,numhid); %<vihj>recon

vishidinc = zeros(numdims,numhid); % 权值更新的增量 ΔW

hidbiasinc = zeros(1,numhid); % 隐含层偏置项更新的增量 1*1000 Δb

visbiasinc = zeros(1,numdims); % 可视化层偏置项更新的增量 1*784 Δa

batchposhidprobs=zeros(numcases,numhid,numbatches); % 整个数据隐含层的输出 每批样本数*隐含层维度*批数

end for epoch = epoch:maxepoch %每个迭代周期

fprintf(1,'epoch %d\r',epoch);

errsum=0;

for batch = 1:numbatches %每一批样本

fprintf(1,'epoch %d batch %d\r',epoch,batch);

%%CD-1

%%%%%%%%% START POSITIVE PHASE 正向梯度%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

data = batchdata(:,:,batch); %data里是100个图片数据

poshidprobs = 1./(1 + exp(-data*vishid - repmat(hidbiases,numcases,1))); %隐藏层输出p(h=1|v0)=sigmod函数=1/(1+exp(-wx-b)) 根据这个分布采集一个隐变量h

batchposhidprobs(:,:,batch)=poshidprobs; %将输出存入一个三位数组

posprods = data' * poshidprobs; %p(h|v0)*v0 更新权重时会使用到 计算正向梯度vh'

poshidact = sum(poshidprobs); %隐藏层中神经元概率和,在更新隐藏层偏置时会使用到

posvisact = sum(data); %可视层中神经元概率和,在更新可视层偏置时会使用到

%%%%%%%%% END OF POSITIVE PHASE %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%%gibbs采样

poshidstates = poshidprobs > rand(numcases,numhid); %将隐藏层输出01化表示,大于随机概率的置1,小于随机概率的置0,gibbs抽样,设定状态 %%%%%%%%% START NEGATIVE PHASE 反向梯度%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

negdata = 1./(1 + exp(-poshidstates*vishid' - repmat(visbiases,numcases,1))); %01化表示之后算vt=p(vt|ht-1)重构的数据 p(v=1|h)=sigmod(W*h+a) 采集重构的可见变量v'

neghidprobs = 1./(1 + exp(-negdata*vishid - repmat(hidbiases,numcases,1))); %ht=p(h|vt)使用重构数据隐藏层的输出 p(h=1|v)=sigmod(W'*v+b) 采样一个h'

negprods = negdata'*neghidprobs; %计算反向梯度v'h';

neghidact = sum(neghidprobs);

negvisact = sum(negdata);

%%%%%%%%% END OF NEGATIVE PHASE %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%%更新参数

err= sum(sum( (data-negdata).^2 )); %整批数据的误差 ||v-v'||^2

errsum = err + errsum; if epoch>5 %迭代次数不同调整冲量

momentum=finalmomentum;

else

momentum=initialmomentum;

end %%%%%%%%% UPDATE WEIGHTS AND BIASES 更新权重和偏置%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

vishidinc = momentum*vishidinc + ...

epsilonw*( (posprods-negprods)/numcases - weightcost*vishid); %权重的增量 ΔW=alpha*(vh'-v'h')

visbiasinc = momentum*visbiasinc + (epsilonvb/numcases)*(posvisact-negvisact); %可视层增量 Δa=alpha*(v-v')

hidbiasinc = momentum*hidbiasinc + (epsilonhb/numcases)*(poshidact-neghidact); %隐含层增量 Δb=alpha*(h-h') vishid = vishid + vishidinc; %a=a+Δa

visbiases = visbiases + visbiasinc; %W=W+ΔW

hidbiases = hidbiases + hidbiasinc; %b=b+Δb

%%%%%%%%%%%%%%%% END OF UPDATES %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% end

fprintf(1, 'epoch %4i error %6.1f \n', epoch, errsum);

end

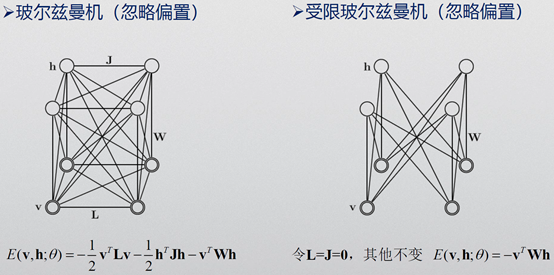

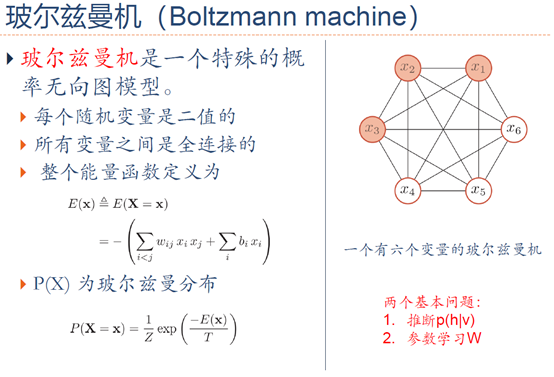

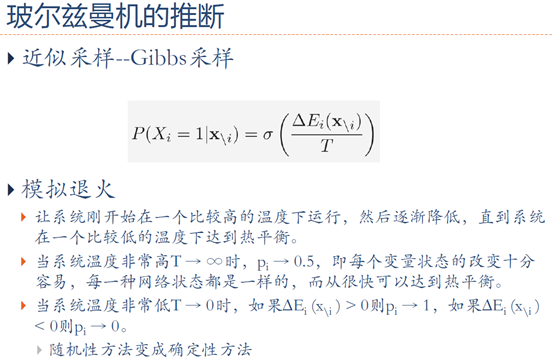

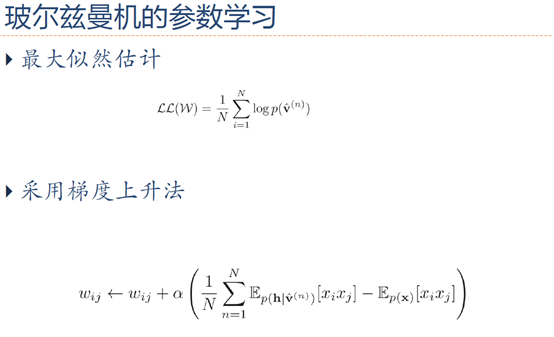

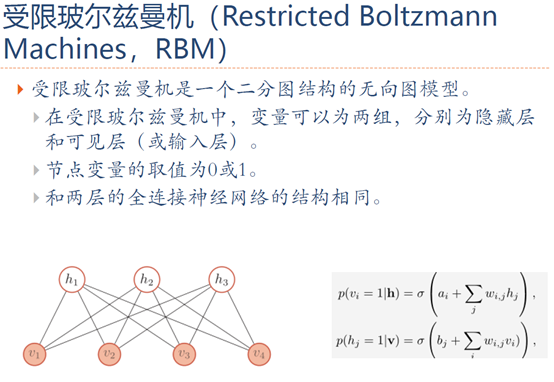

5. 玻尔兹曼机与受限玻尔兹曼机

6. 参考文献

[1] 邱锡鹏, 神经网络与深度学习[M]. 2019.

[2] Salakhutdinov R, Hinton G. Deep boltzmann machines[C]//Artificial intelligence and statistics. 2009: 448-455.

[3] Hinton, Training a deep autoencoder or a classifieron MNIST digits. 2006.

[4] Hinton G E. Training products of experts by minimizing contrastive divergence[J]. Neural computation, 2002, 14(8): 1771-1800.

[5] Hinton G E. A practical guide to training restricted Boltzmann machines[M]//Neural networks: Tricks of the trade. Springer, Berlin, Heidelberg, 2012: 599-619.

[8] Deep Learning(深度学习)学习笔记整理系列之(四)

[9] Restricted Boltzmann Machines (RBM)

受限玻尔兹曼机(Restricted Boltzmann Machine)的更多相关文章

- 受限玻尔兹曼机(Restricted Boltzmann Machine, RBM) 简介

受限玻尔兹曼机(Restricted Boltzmann Machine,简称RBM)是由Hinton和Sejnowski于1986年提出的一种生成式随机神经网络(generative stochas ...

- 机器学习理论基础学习19---受限玻尔兹曼机(Restricted Boltzmann Machine)

一.背景介绍 玻尔兹曼机 = 马尔科夫随机场 + 隐结点 二.RBM的Representation BM存在问题:inference 精确:untractable: 近似:计算量太大 因此为了使计算简 ...

- 受限玻尔兹曼机(Restricted Boltzmann Machine,RBM)

这篇写的主要是翻译网上一篇关于受限玻尔兹曼机的tutorial,看了那篇博文之后感觉算法方面讲的很清楚,自己收获很大,这里写下来作为学习之用. 原文网址为:http://imonad.com/rbm/ ...

- 限制玻尔兹曼机(Restricted Boltzmann Machine)RBM

假设有一个二部图,每一层的节点之间没有连接,一层是可视层,即输入数据是(v),一层是隐藏层(h),如果假设所有的节点都是随机二值变量节点(只能取0或者1值)同时假设全概率分布满足Boltzmann 分 ...

- 限制Boltzmann机(Restricted Boltzmann Machine)

起源:Boltzmann神经网络 Boltzmann神经网络的结构是由Hopfield递归神经网络改良过来的,Hopfield中引入了统计物理学的能量函数的概念. 即,cost函数由统计物理学的能量函 ...

- RBM:深度学习之Restricted Boltzmann Machine的BRBM学习+LR分类—Jason niu

from __future__ import print_function print(__doc__) import numpy as np import matplotlib.pyplot as ...

- Boltzmann Machine 玻尔兹曼机入门

Generative Models 生成模型帮助我们生成新的item,而不只是存储和提取之前的item.Boltzmann Machine就是Generative Models的一种. Boltzma ...

- 受限波兹曼机导论Introduction to Restricted Boltzmann Machines

Suppose you ask a bunch of users to rate a set of movies on a 0-100 scale. In classical factor analy ...

- 受限玻尔兹曼机(RBM)原理总结

在前面我们讲到了深度学习的两类神经网络模型的原理,第一类是前向的神经网络,即DNN和CNN.第二类是有反馈的神经网络,即RNN和LSTM.今天我们就总结下深度学习里的第三类神经网络模型:玻尔兹曼机.主 ...

随机推荐

- Violet音乐社区需求分析说明书

目录 一.引言 1.1 编写目的 1.2 开发背景 1.3 开发工具 二.项目需求 2.1 角色定义 2.2 模块划分 2.3 功能概述 2.4 数据流图 三.前端页面 四.软件要求 4.1 性能要求 ...

- idea找不到terminal

起因是这样的,我要用命令行,懒,不想开cmd但是该死的我的idea找不见terminal,好奇怪哦,于是我查了一下,原来设置它蒙蔽了我的眼. 下面给出流程: 一般像我这样比较好学的好孩子不懂就比较喜欢 ...

- 利用Flask中的werkzeug.security模块加密

1.这种加密方式的原理:加密时混入一段"随机"字符串(盐值)再进行哈希加密.即使 密码相同,如果盐值不同,那么哈希值也是不一样的.现在网站开发中主要是运 用这种加密方法. 2.这个 ...

- ifconfig|grep eth0|awk '{print $5}' 命令详解

因需要将linx下获取某个网中的MAC地址,可以使用如下命令获取: ifconfig|grep eth0|awk '{print $5}' ifconfig: 输出linux下所有网口的信息(包括IP ...

- Gaussian field consensus论文解读及MATLAB实现

Gaussian field consensus论文解读及MATLAB实现 作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/ 一.Introduction ...

- IT人的立功,立言,立德三不朽

最近几个月很忙,忙着当奶爸,忙着做加班狗,忙着补裤裆学技术……以至于快忘了要思考人生了! 古人立志穷极一生追求“立德”,“立功”,“立言”,以求不朽,为万世所景仰,为后人所传颂,实现人生的意义.立德者 ...

- 【洛谷5299】[PKUWC2018] Slay the Spire(组合数学)

点此看题面 大致题意: 有\(n\)张强化牌\(a_i\)和\(n\)张攻击牌\(b_i\),每张牌有一个权值(强化牌的权值大于\(1\)),每张强化牌能使所有攻击牌的权值乘上这张强化牌的权值,每张攻 ...

- pytorch固定部分参数

pytorch固定部分参数 不用梯度 如果是Variable,则可以初始化时指定 j = Variable(torch.randn(5,5), requires_grad=True) 但是如果是m = ...

- Python变量与内存管理

Python变量与内存管理 –与C语言中的变量做对比,更好的理解Python的变量. 变量 变量在C语言中 全局变量:其存放在内存的静态变量区中. 局部变量:代码块中存放在内存的代码区当中,当被调 ...

- 关于js里的那一堆事件

分类 事件名 触发描述 一般事件 onclick 鼠标点击事件 ondbclick 鼠标双击事件 onmousedown/up 鼠标按下/松开事件 onmouseover/move/out 鼠标悬浮/ ...