MindSpore 如何实现一个线性回归 —— Demo示例

如何使用 MindSpore 实现一个简单的 线性回归呢???

根据前面的mindspore的基本操作的学习写出了下面的 一个简单的线性回归算法。

import mindspore

import numpy as np #引入numpy科学计算库

import matplotlib.pyplot as plt #引入绘图库

np.random.seed(123) #随机数生成种子

#from sklearn.model_selection import train_test_split#从sklearn里面引出训练与测试集划分 import mindspore.nn as nn

import mindspore.ops as ops

from mindspore import Tensor

from mindspore import ParameterTuple, Parameter

from mindspore import dtype as mstype # 训练数据集

def creat_dataset():

n_x=2*np.random.rand(500,1)#随机生成一个0-2之间的,大小为(500,1)的向量

n_y=5+3*n_x+np.random.randn(500,1)#随机生成一个线性方程的,大小为(500,1)的向量

x = Tensor(n_x, dtype=mindspore.float32)

y = Tensor(n_y, dtype=mindspore.float32)

return x, y class Net(nn.Cell):

def __init__(self, input_dims, output_dims):

super(Net, self).__init__()

self.matmul = ops.MatMul() self.weight_1 = Parameter(Tensor(np.random.randn(input_dims, 128), dtype=mstype.float32), name='weight_1')

self.bias_1 = Parameter(Tensor(np.zeros(128), dtype=mstype.float32), name='bias_1')

self.weight_2 = Parameter(Tensor(np.random.randn(128, 64), dtype=mstype.float32), name='weight_2')

self.bias_2 = Parameter(Tensor(np.zeros(64), dtype=mstype.float32), name='bias_2')

self.weight_3 = Parameter(Tensor(np.random.randn(64, output_dims), dtype=mstype.float32), name='weight_3')

self.bias_3 = Parameter(Tensor(np.zeros(output_dims), dtype=mstype.float32), name='bias_3') def construct(self, x):

x = self.matmul(x, self.weight_1)+self.bias_1

x = self.matmul(x, self.weight_2)+self.bias_2

x = self.matmul(x, self.weight_3)+self.bias_3

return x class LossNet(nn.Cell):

def __init__(self, net):

super(LossNet, self).__init__()

self.net = net

self.pow = ops.Pow()

self.mean = ops.ReduceMean() def construct(self, x, y):

_x = self.net(x)

loss = self.mean(self.pow(_x - y, 2))

return loss class GradNetWrtX(nn.Cell):

def __init__(self, net):

super(GradNetWrtX, self).__init__()

self.net = net

self.params = ParameterTuple(net.trainable_params())

self.grad_op = ops.GradOperation(get_by_list=True) def construct(self, x, y):

gradient_function = self.grad_op(self.net, self.params)

return gradient_function(x, y) def train(epochs, loss_net, x, y, print_flag=False):

# 构建加和操作

ass_add = ops.AssignAdd()

para_list = loss_net.trainable_params() for epoch in range(epochs):

grad_net = GradNetWrtX(loss_net)

grad_list = grad_net(x, y) for para, grad in zip(para_list, grad_list):

ass_add(para, -0.000001*grad) if print_flag and (epoch%100 == 0):

print("epoch: %s, loss: %s"%(epoch, loss_net(x, y))) def main():

epochs = 10000

x, y = creat_dataset() net = Net(x.shape[-1], y.shape[-1])

loss_net = LossNet(net)

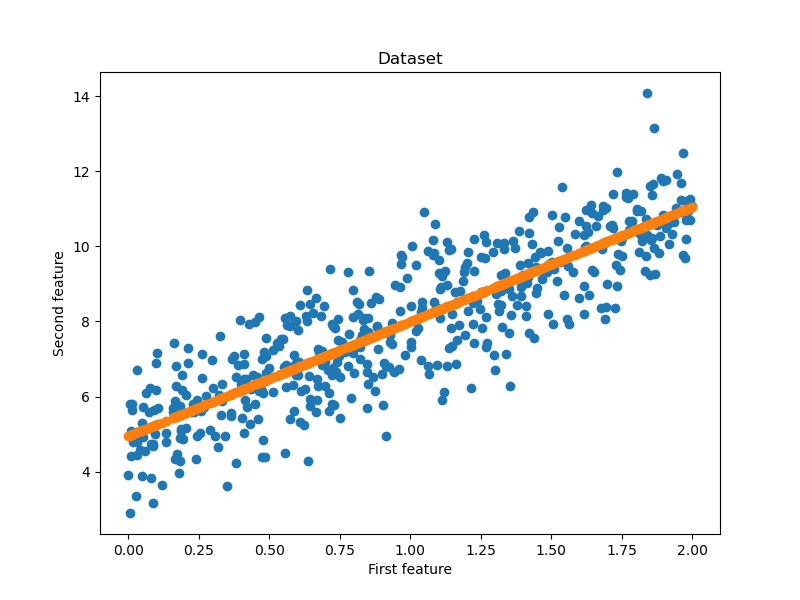

train(epochs, loss_net, x, y, False) y_hat = net(x) fig=plt.figure(figsize=(8,6))#确定画布大小

plt.title("Dataset")#标题名

plt.xlabel("First feature")#x轴的标题

plt.ylabel("Second feature")#y轴的标题

plt.scatter(x.asnumpy(), y.asnumpy())#设置为散点图

plt.scatter(x.asnumpy(), y_hat.asnumpy())#设置为散点图

plt.show()#绘制出来 if __name__ == '__main__':

""" 设置运行的背景context """

from mindspore import context

# 为mindspore设置运行背景context

context.set_context(mode=context.PYNATIVE_MODE, device_target='GPU')

import time

a = time.time()

main()

b = time.time()

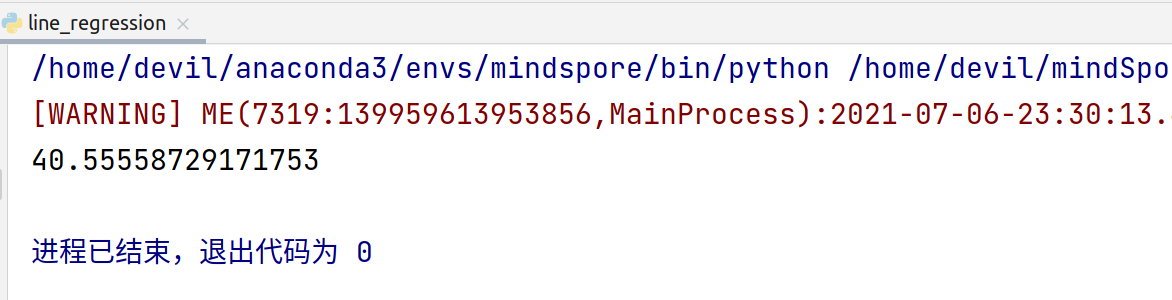

print(b-a)

最终结果:

多次运行后,平均运行时间:

41秒

运行环境:

Ubuntu18.04系统

i7-9700HQ

笔记本显卡 1660ti

======================================================================================

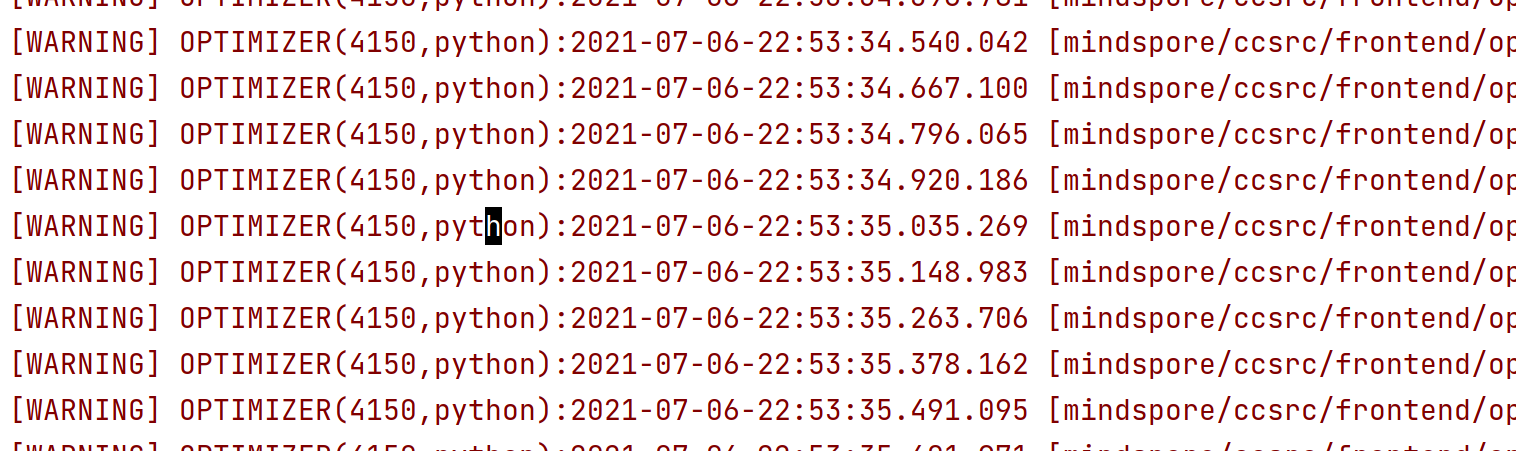

发现一个神奇的事情,如果我们把context的模式设置为 GRAPH_MODE

也就是:

context.set_context(mode=context.GRAPH_MODE, device_target='GPU')

那么运行过程中会不停的提示警告:

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:07.536.303 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1116905_construct_wrapper, J user: 1116905_construct_wrapper:construct{[0]: 7496, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:07.664.157 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117054_construct_wrapper, J user: 1117054_construct_wrapper:construct{[0]: 7497, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:07.787.667 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117203_construct_wrapper, J user: 1117203_construct_wrapper:construct{[0]: 7498, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:07.906.649 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117352_construct_wrapper, J user: 1117352_construct_wrapper:construct{[0]: 7499, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.021.086 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117501_construct_wrapper, J user: 1117501_construct_wrapper:construct{[0]: 7500, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.136.975 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117650_construct_wrapper, J user: 1117650_construct_wrapper:construct{[0]: 7501, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.271.804 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117799_construct_wrapper, J user: 1117799_construct_wrapper:construct{[0]: 7502, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.380.832 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1117948_construct_wrapper, J user: 1117948_construct_wrapper:construct{[0]: 7503, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.489.950 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1118097_construct_wrapper, J user: 1118097_construct_wrapper:construct{[0]: 7504, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.599.613 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1118246_construct_wrapper, J user: 1118246_construct_wrapper:construct{[0]: 7505, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.707.115 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1118395_construct_wrapper, J user: 1118395_construct_wrapper:construct{[0]: 7506, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

[WARNING] OPTIMIZER(4150,python):2021-07-06-23:07:08.812.025 [mindspore/ccsrc/frontend/optimizer/ad/dfunctor.cc:860] FindPrimalJPair] J operation has no relevant primal call in the same graph. Func graph: 1118544_construct_wrapper, J user: 1118544_construct_wrapper:construct{[0]: 7507, [1]: x, [2]: y, [3]: ValueNode<UMonad> U}

具体代码:

import mindspore

import numpy as np #引入numpy科学计算库

import matplotlib.pyplot as plt #引入绘图库

np.random.seed(123) #随机数生成种子

#from sklearn.model_selection import train_test_split#从sklearn里面引出训练与测试集划分 import mindspore.nn as nn

import mindspore.ops as ops

from mindspore import Tensor

from mindspore import ParameterTuple, Parameter

from mindspore import dtype as mstype # 训练数据集

def creat_dataset():

n_x=2*np.random.rand(500,1)#随机生成一个0-2之间的,大小为(500,1)的向量

n_y=5+3*n_x+np.random.randn(500,1)#随机生成一个线性方程的,大小为(500,1)的向量

x = Tensor(n_x, dtype=mindspore.float32)

y = Tensor(n_y, dtype=mindspore.float32)

return x, y class Net(nn.Cell):

def __init__(self, input_dims, output_dims):

super(Net, self).__init__()

self.matmul = ops.MatMul() self.weight_1 = Parameter(Tensor(np.random.randn(input_dims, 128), dtype=mstype.float32), name='weight_1')

self.bias_1 = Parameter(Tensor(np.zeros(128), dtype=mstype.float32), name='bias_1')

self.weight_2 = Parameter(Tensor(np.random.randn(128, 64), dtype=mstype.float32), name='weight_2')

self.bias_2 = Parameter(Tensor(np.zeros(64), dtype=mstype.float32), name='bias_2')

self.weight_3 = Parameter(Tensor(np.random.randn(64, output_dims), dtype=mstype.float32), name='weight_3')

self.bias_3 = Parameter(Tensor(np.zeros(output_dims), dtype=mstype.float32), name='bias_3') def construct(self, x):

x = self.matmul(x, self.weight_1)+self.bias_1

x = self.matmul(x, self.weight_2)+self.bias_2

x = self.matmul(x, self.weight_3)+self.bias_3

return x class LossNet(nn.Cell):

def __init__(self, net):

super(LossNet, self).__init__()

self.net = net

self.pow = ops.Pow()

self.mean = ops.ReduceMean() def construct(self, x, y):

_x = self.net(x)

loss = self.mean(self.pow(_x - y, 2))

return loss class GradNetWrtX(nn.Cell):

def __init__(self, net):

super(GradNetWrtX, self).__init__()

self.net = net

self.params = ParameterTuple(net.trainable_params())

self.grad_op = ops.GradOperation(get_by_list=True) def construct(self, x, y):

gradient_function = self.grad_op(self.net, self.params)

return gradient_function(x, y) def train(epochs, loss_net, x, y, print_flag=False):

# 构建加和操作

ass_add = ops.AssignAdd()

para_list = loss_net.trainable_params() for epoch in range(epochs):

grad_net = GradNetWrtX(loss_net)

grad_list = grad_net(x, y) for para, grad in zip(para_list, grad_list):

ass_add(para, -0.000001*grad) if print_flag and (epoch%100 == 0):

print("epoch: %s, loss: %s"%(epoch, loss_net(x, y))) def main():

epochs = 10000

x, y = creat_dataset() net = Net(x.shape[-1], y.shape[-1])

loss_net = LossNet(net)

train(epochs, loss_net, x, y, False) y_hat = net(x) fig=plt.figure(figsize=(8,6))#确定画布大小

plt.title("Dataset")#标题名

plt.xlabel("First feature")#x轴的标题

plt.ylabel("Second feature")#y轴的标题

plt.scatter(x.asnumpy(), y.asnumpy())#设置为散点图

plt.scatter(x.asnumpy(), y_hat.asnumpy())#设置为散点图

plt.show()#绘制出来 if __name__ == '__main__':

""" 设置运行的背景context """

from mindspore import context

# 为mindspore设置运行背景context

#context.set_context(mode=context.PYNATIVE_MODE, device_target='GPU')

context.set_context(mode=context.GRAPH_MODE, device_target='GPU') import time

a = time.time()

main()

b = time.time()

print(b-a)

最终结果:

============================================================

可以看到不同 context 模式的设置,运行时间相差20倍左右。

# 为mindspore设置运行背景context

context.set_context(mode=context.GRAPH_MODE, device_target='GPU')

context.set_context(mode=context.PYNATIVE_MODE, device_target='GPU')

具体原因是什么,这里也是搞不太清楚???

本文作为尝试使用mindspore功能,具体原因也就不深究了。

MindSpore 如何实现一个线性回归 —— Demo示例的更多相关文章

- LeadTools Android 入门教学——运行第一个Android Demo

LeadTools 有很多Windows平台下的Demo,非常全面,但是目前开发手机应用的趋势也越来越明显,LeadTools也给大家提供了10个Android的Demo,这篇文章将会教你如何运行第一 ...

- 一个数据源demo

前言 我们重复造轮子,不是为了证明我们比那些造轮子的人牛逼,而是明白那些造轮子的人有多牛逼. JDBC介绍 在JDBC中,我们可以通过DriverManager.getConnection()创建(而 ...

- 快速搭建一个直播Demo

缘由 最近帮朋友看一个直播网站的源码,发现这份直播源码借助 阿里云 .腾讯云这些大公司提供的SDK 可以非常方便的搭建一个直播网站.下面我们来给大家讲解下如何借助 腾讯云 我们搭建一个简易的 直播示例 ...

- Visual Studio 2017 - Windows应用程序打包成exe文件(2)- Advanced Installer 关于Newtonsoft.Json,LINQ to JSON的一个小demo mysql循环插入数据、生成随机数及CONCAT函数 .NET记录-获取外网IP以及判断该IP是属于网通还是电信 Guid的生成和数据修整(去除空格和小写字符)

Visual Studio 2017 - Windows应用程序打包成exe文件(2)- Advanced Installer Advanced Installer :Free for 30 da ...

- 【分享】Vue 资源典藏(UI组件、开发框架、服务端、辅助工具、应用实例、Demo示例)

Vue 资源典藏,包括:UI组件 开发框架 服务端 辅助工具 应用实例 Demo示例 element ★11612 - 饿了么出品的Vue2的web UI工具套件 Vux ★7503 - 基于Vue和 ...

- kafka_2.11-0.8.2.1+java 生产消费程序demo示例

Kafka学习8_kafka java 生产消费程序demo示例 kafka是吞吐量巨大的一个消息系统,它是用scala写的,和普通的消息的生产消费还有所不同,写了个demo程序供大家参考.kaf ...

- SpringBoot整合Swagger2(Demo示例)

写在前面 由于公司项目采用前后端分离,维护接口文档基本上是必不可少的工作.一个理想的状态是设计好后,接口文档发给前端和后端,大伙按照既定的规则各自开发,开发好了对接上了就可以上线了.当然这是一种非常理 ...

- Vue UI组件 开发框架 服务端 辅助工具 应用实例 Demo示例

Vue UI组件 开发框架 服务端 辅助工具 应用实例 Demo示例 element ★11612 - 饿了么出品的Vue2的web UI工具套件 Vux ★7503 - 基于Vue和WeUI的组件库 ...

- Go学习【02】:理解Gin,搭一个web demo

Go Gin 框架 说Gin是一个框架,不如说Gin是一个类库或者工具库,其包含了可以组成框架的组件.这样会更好理解一点. 举个 下面的示例代码在这:github 利用Gin组成最基本的框架.说到框架 ...

- ArcGIS API for JavaScript开发环境搭建及第一个实例demo

原文:ArcGIS API for JavaScript开发环境搭建及第一个实例demo ESRI公司截止到目前已经发布了最新的ArcGIS Server for JavaScript API v3. ...

随机推荐

- 【前端求助帖】关于使用element-plus select 模板嵌套popover中使用select选择后,上一个select自动关闭的问题

主页代码如下 项目使用的是Vue3+vite, 下载后,直接pnpm i安装依赖, pnpm dev 就是可以跑起来 <el-button type="warning" ...

- SQLBI_精通DAX课程笔记_01_DAX介绍

一:函数式语言 DAX是一个函数式语言,应用于Analysis Services , PowerPivot , 和Power Bi . 二:共同与不同 2.1 共同点 DAX与PowerPivot ...

- NetMvc通过亚马逊方式服务器端和客户端上传MinIO顺利解决

前言: 1.由于项目是.NET Framework 4.7 MVC LayUI,所以需要找一个资源站点存放项目中静态资源文件: 2.需要支持服务端和客户端都支持上传文件方式: 3.调用简单,涉及库越少 ...

- 向Web服务器端上传文件

server.py import flaskapp = flask.Flask(__name__)@app.route('/upload', methods=['POST'])def uploadFi ...

- C++类与对象详解

什么是类和对象 类和对象的概念 类是对象的抽象,对象是对客观事物的抽象. 用通俗的话来说: 类是类别的意思,是数据类型. 对象是类别下的具体事物. 也就是说: 类是数据类型,对象是变量. 比如: 水果 ...

- 【HDC 2024】华为云开发者联盟驱动应用创新,赋能开发者成长

本文分享自华为云社区<[HDC 2025]华为云开发者联盟驱动应用创新,赋能开发者成长>,作者:华为云社区精选. 6月21日到23日,华为开发者大会(HDC 2024)于东莞松山湖举行,这 ...

- 如何在Spring Boot框架下实现高效的Excel服务端导入导出?

前言 Spring Boot是由Pivotal团队提供的全新框架,其设计目的是用来简化新Spring应用的初始搭建以及开发过程.该框架使用了特定的方式来进行配置,从而使开发人员不再需要定义样板化的配置 ...

- Linux驱动中的等待队列与休眠

Linux驱动中的等待队列与休眠 原文:https://blog.csdn.net/mengluoxixiang/article/details/46239523?spm=1001.2014.3001 ...

- 升级到 MySQL 8.4,MySQL 启动报错:io_setup() failed with EAGAIN

问题 最近碰到一个 case,一台主机上,部署了多个实例.之前使用的是 MySQL 8.0,启动时没有任何问题.但升级到 MySQL 8.4 后,部分实例在启动时出现了以下错误. [Warning] ...

- CentOS中增加网络连接数的方法

CentOS默认对外访问,发起的TCP链接总数小于28232个. 可以通过以下命令的结果计算出来 $ cat /proc/sys/net/ipv4/ip_local_port_range 我这里得到的 ...