【VMware VCF】VMware Cloud Foundation Part 06:部署 VI 工作负载域。

VMware Cloud Foundation 标准架构中,管理域和 VI 工作负载域需要分开部署,管理域是初始构建(Bring-up)中部署的一个工作负载域并且只有一个,管理域专门用于承载管理相关组件虚拟机。之前文章(VMware Cloud Foundation Part 05:部署 SDDC 管理域。)已经完成了管理域的相关部署,现在我们需要为实际的生产业务系统部署 VI 工作负载域。

一、VI 域部署架构

1)拓扑架构

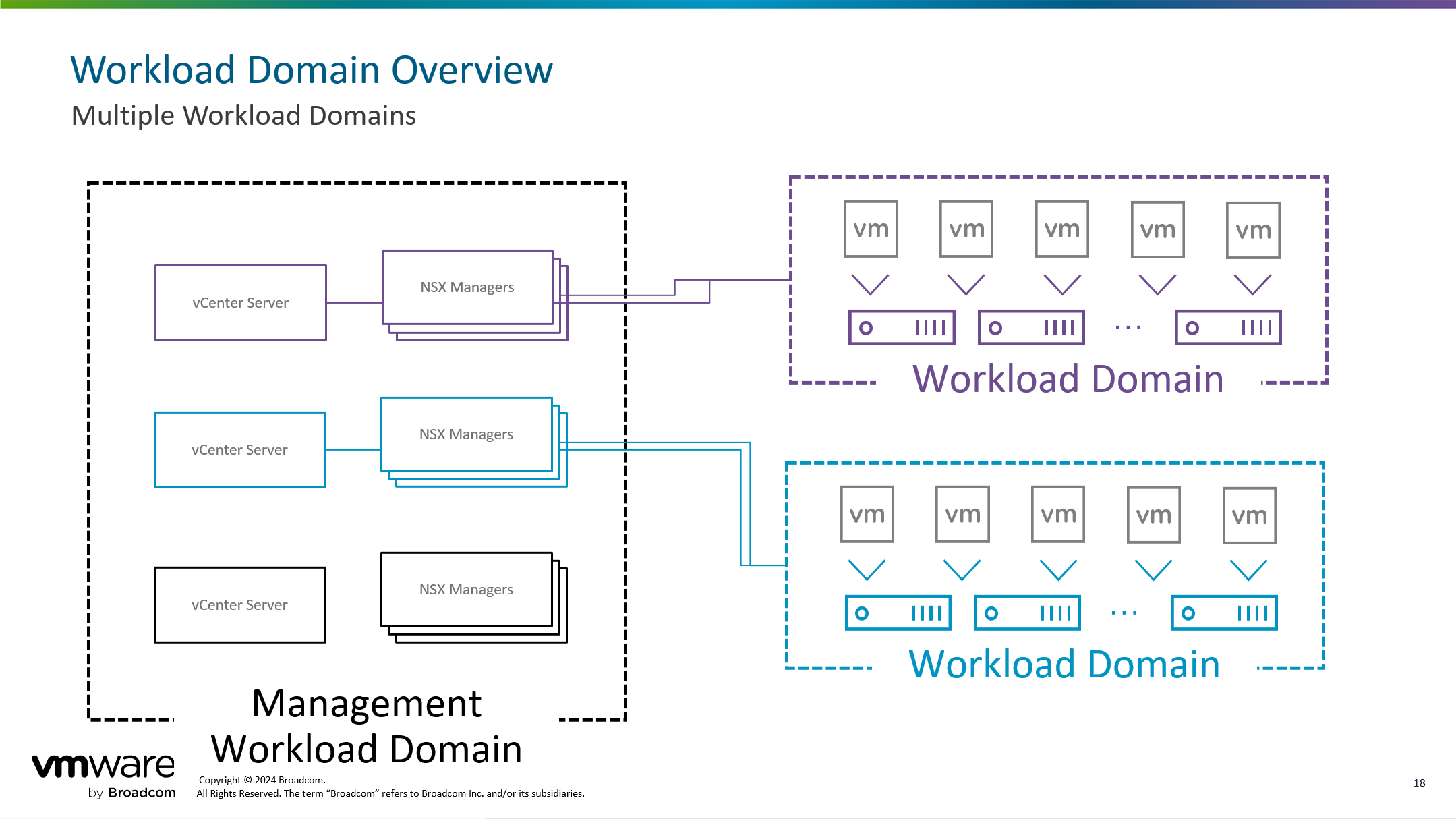

- VI 工作负载域(本地多个)

一个 VCF 实例中可以有多个 VI 工作负载域,每个 VI 工作负载域中可以有多个 vSphere 集群。每个 VI 域的管理组件默认情况下都具有一个 vCenter Server 组件和一个由 3 个 NSX Manager 节点所组成的集群,其中所有 VI 工作负载域的管理组件虚拟机都运行在管理域中。

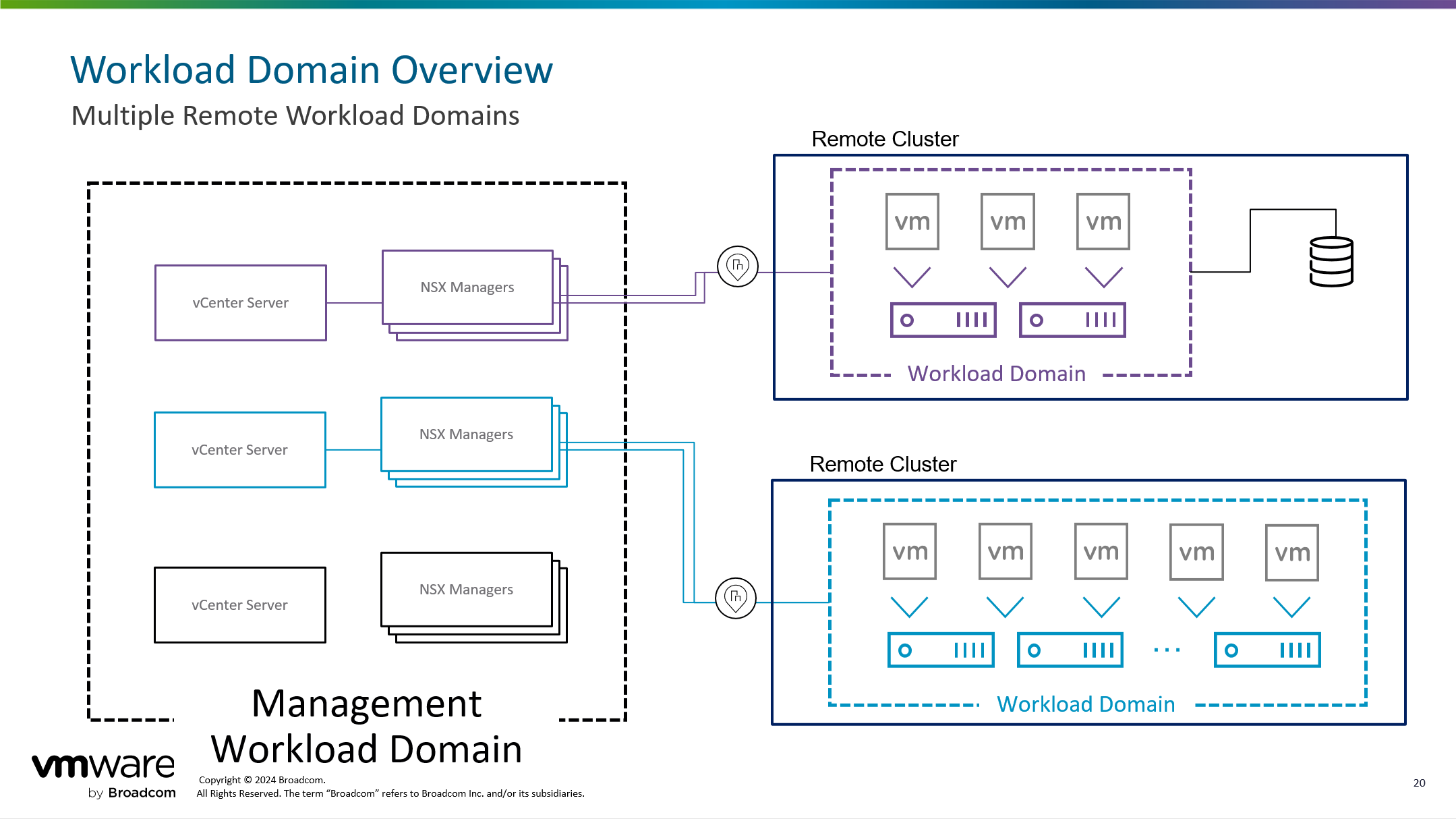

- VI 工作负载域(远端集群)

在常规的 VCF 实例中,不管是管理域还是 VI 工作负载域都位于同一数据中心,VCF 还支持位于远端站点的 VI 工作负载域。这有点类似于总部和分支机构的意思,位于总部的 VCF 实例包含管理域和本地 VI 工作负载域,可以在总部的 VCF 管理域上添加位于分支机构的 VI 工作负载域,这些位于分支机构的远端 VI 工作负载域统一由总部的管理域进行生命周期管理,并且远端 VI 工作负载域的管理组件也运行在总部的管理域中,只是 VI 域中的真实物理主机位于分支机构。远端分支机构 VI 工作负载域与总部管理域之间通常使用广域网(WAN)专线进行连接,使用这种拓扑架构具有很多要求和细节,具体请查看 VCF 产品文档。

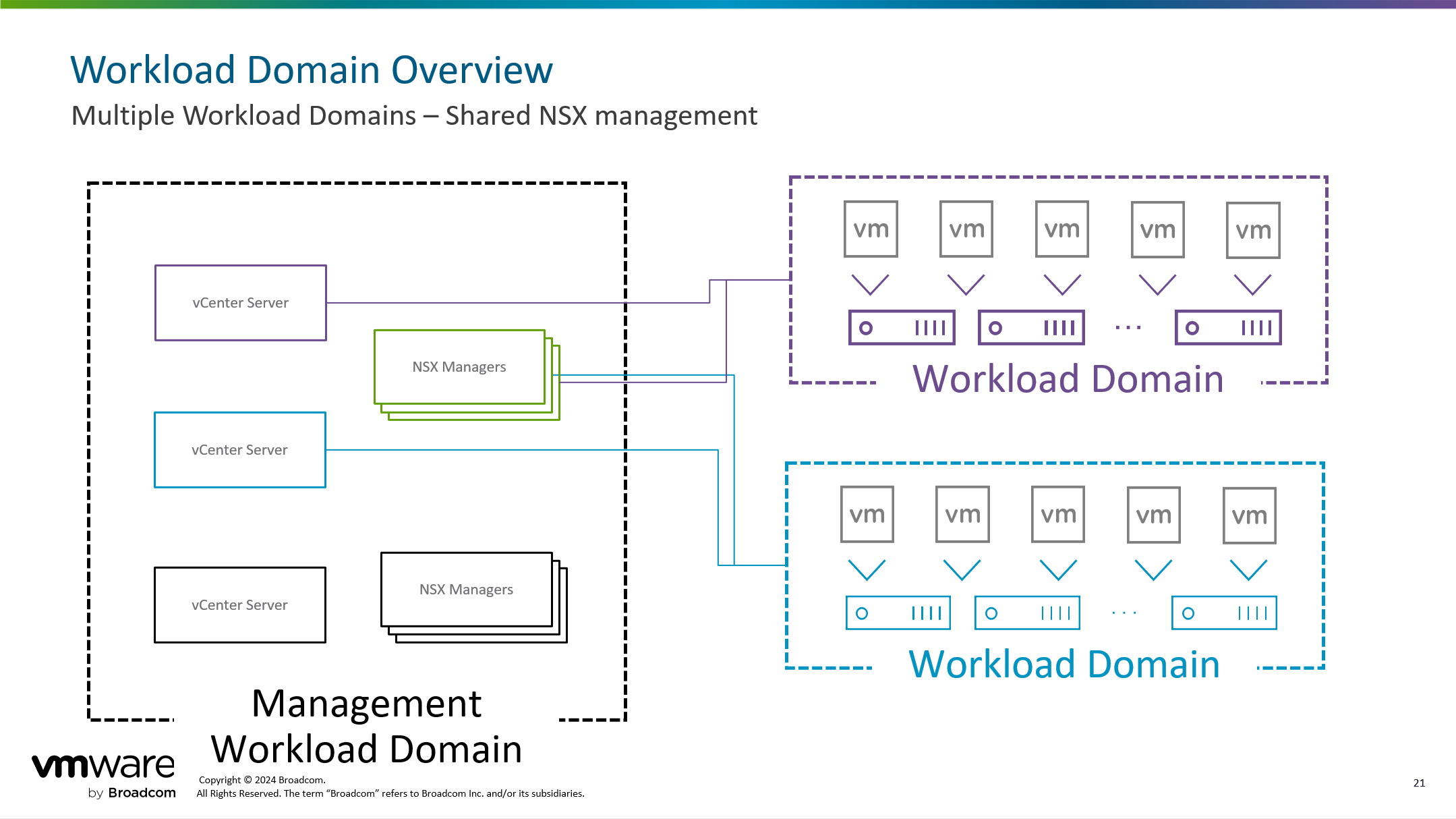

- VI 工作负载域(共享 NSX 集群)

在常规的 VCF 实例中,部署 VI 工作负载域时会将 VI 域的管理组件部署在管理域中, 当部署第一个 VI 域时,必须部署 NSX 管理组件,一个由 3 节点组成的集群;当部署第二个以及后续 VI 域时,在部署 NSX 管理组件的时候,可以选择加入到现有 VI 域的 NSX 管理组件中而无需部署新的 NSX 管理组件。

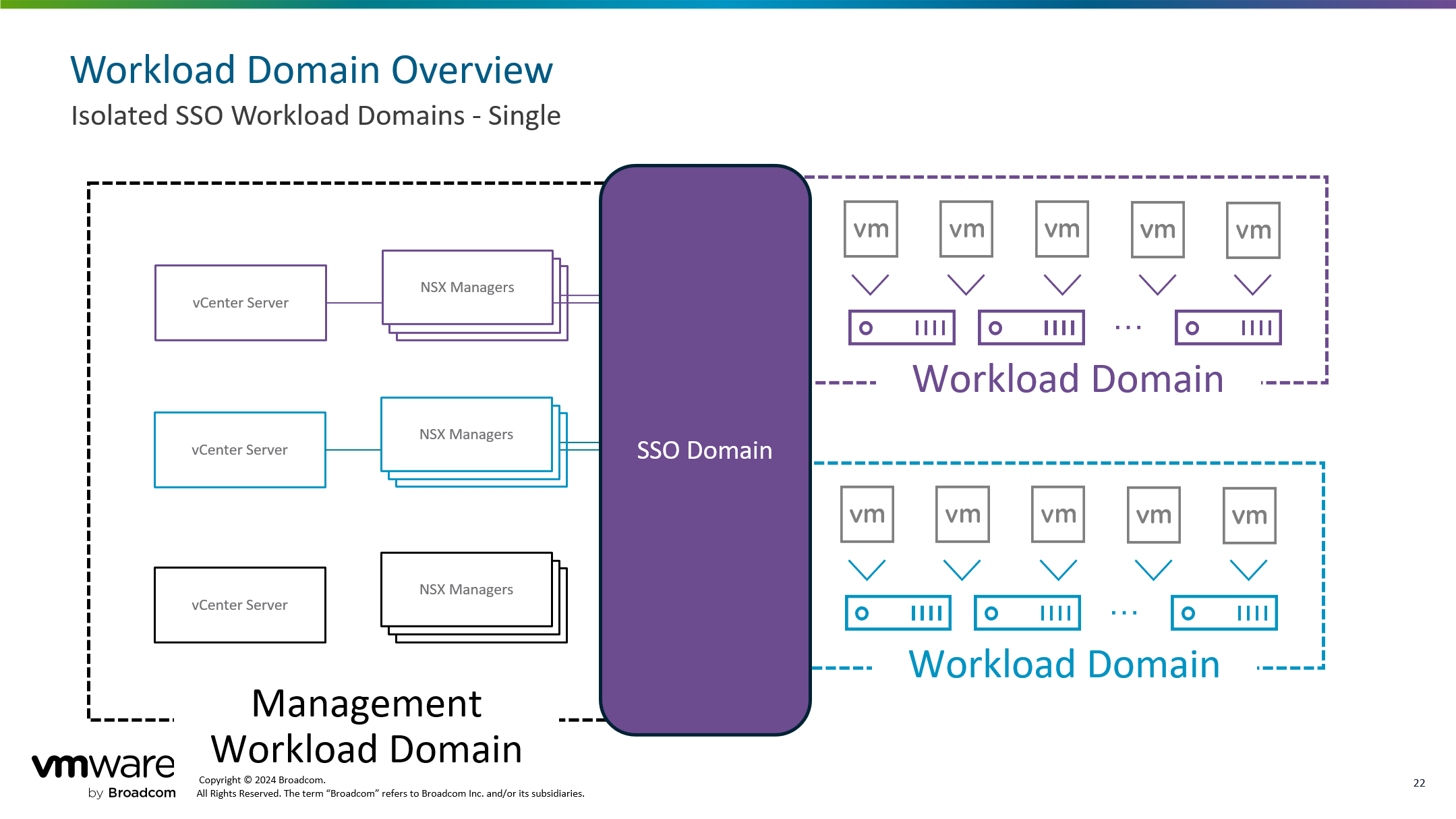

- VI 工作负载域(单个 SSO 域)

在常规的 VCF 实例中,部署 VI 工作负载域时会将 VI 域的管理组件部署在管理域中, 当部署每一个 VI 域时始终都会部署一个独立的 vCenter Server 组件。对于 vCenter Server 组件来说,支持在部署的时候将 SSO 域加入到管理域的 SSO 域当中,所有部署的 VI 域都可以加入到单个 SSO 域当中。这种方式叫增强型链接模式 Enhanced Linked Mode(ELM),如果你还不知道这个功能,可以查看之前的这篇(使用cmsso-util命令进行链接、删除、修改多个vCenter Server(VCSA)的SSO域。)文章。

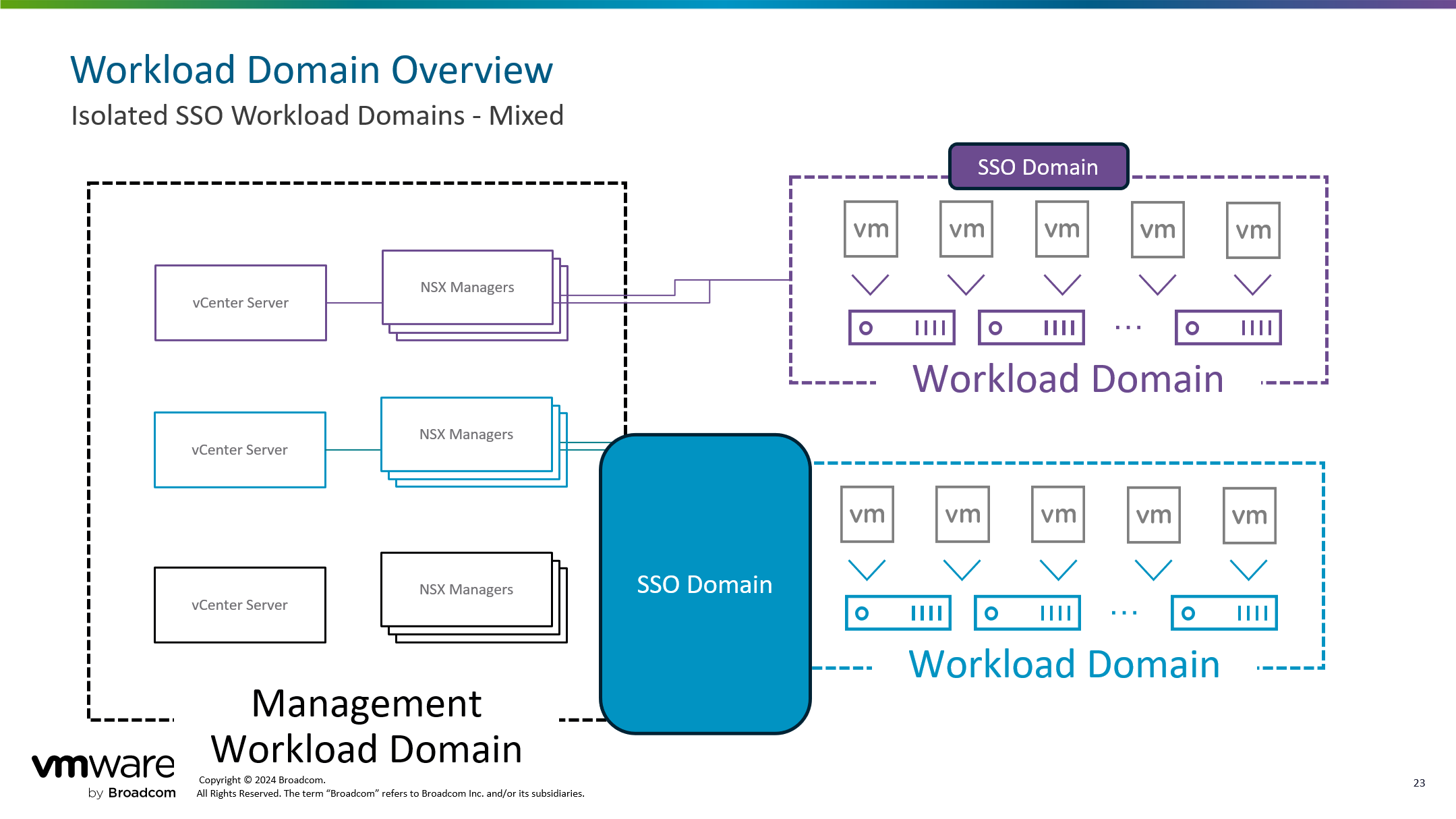

- VI 工作负载域(混合 SSO 域)

可以将 VI 域的 vCenter Server 组件加入到现有管理域的 SSO 域当中,也可以在部署其他 VI 域的时候将 vCenter Server 配置到单独的 SSO 域当中,支持混合 SSO 域。

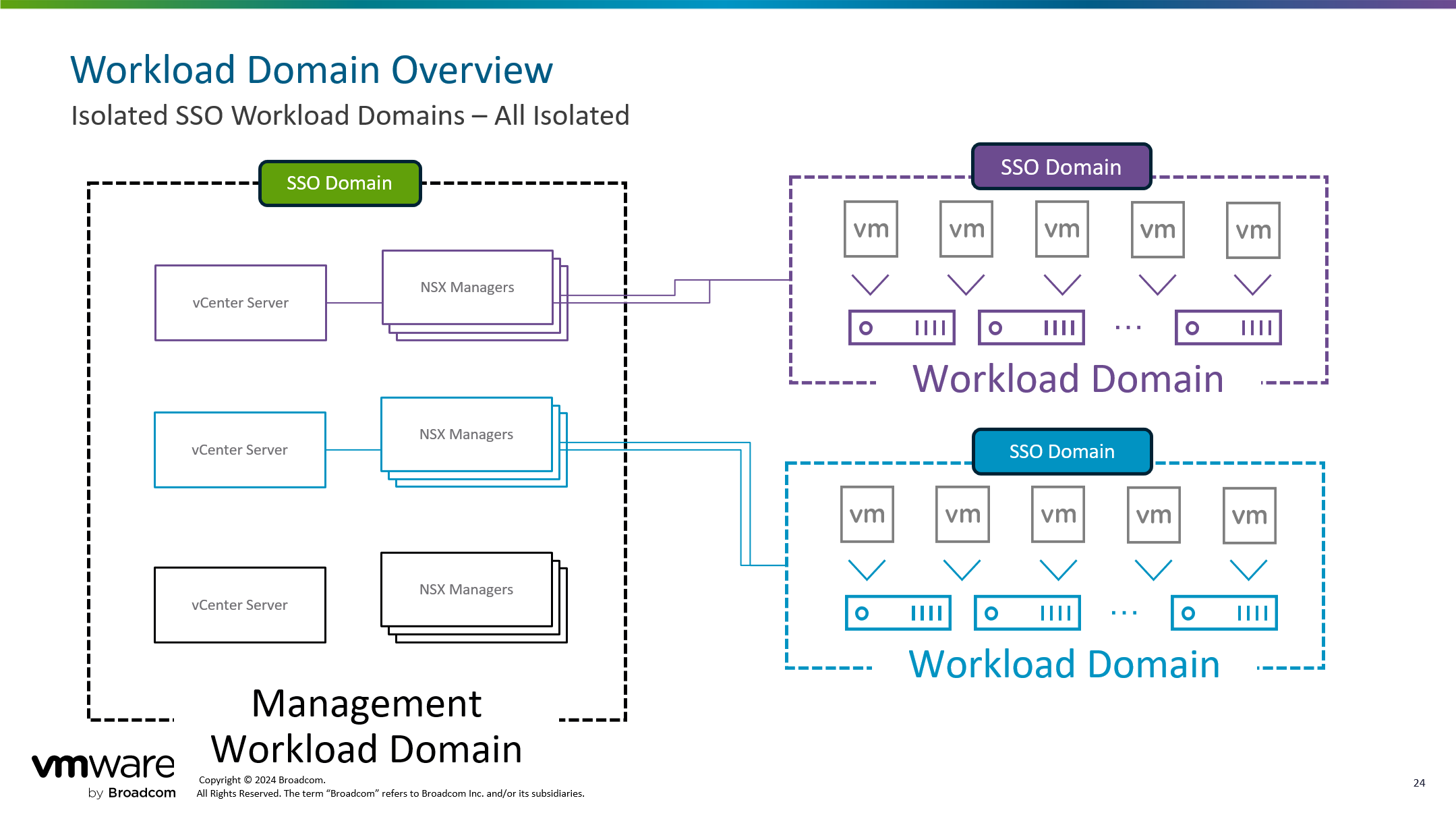

- VI 工作负载域(独立 SSO 域)

所有 SSO 域都可以独立进行部署,管理域和每一个 VI 工作负载域分别属于不同的 SSO 域当中。

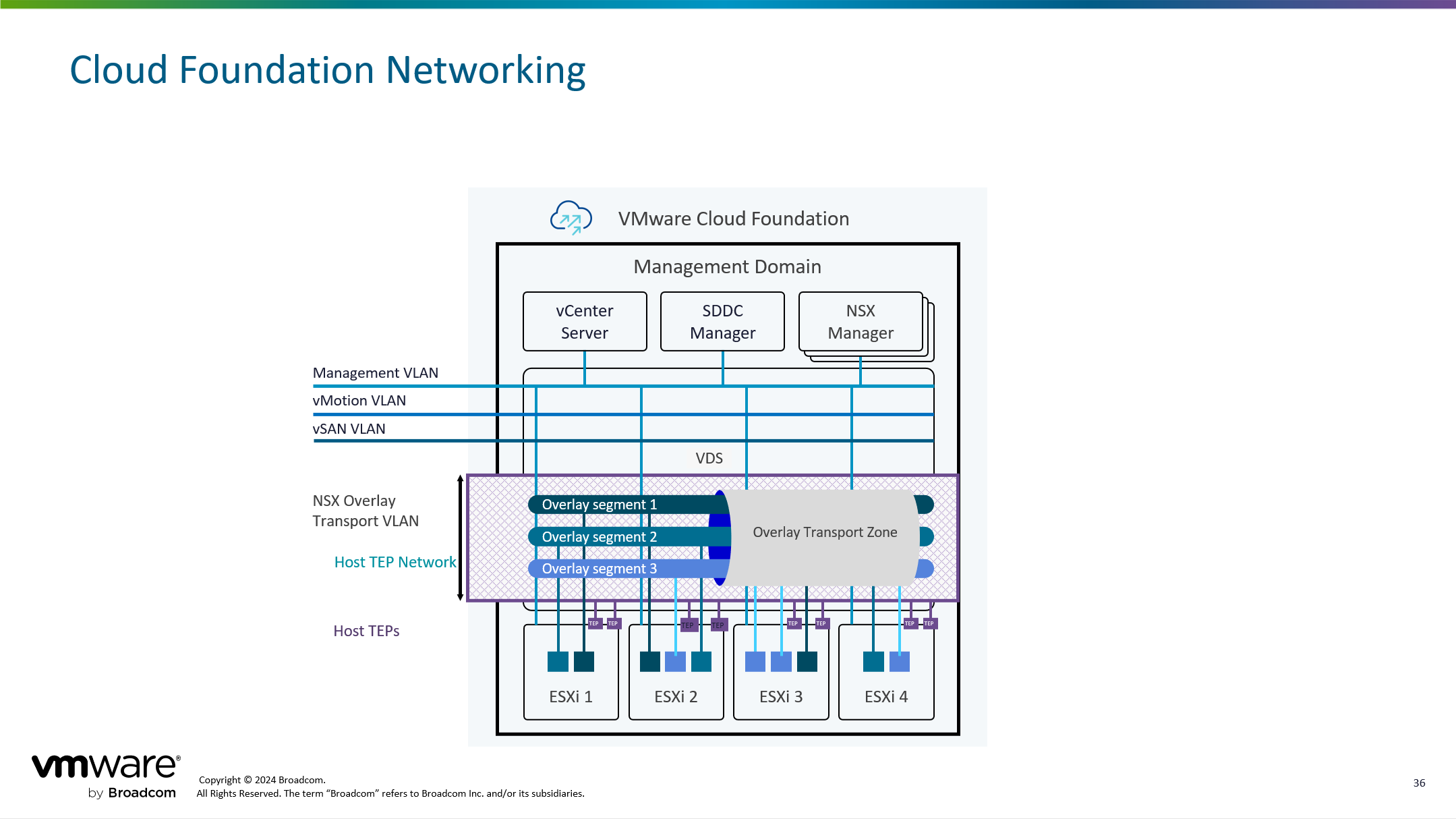

2)网络架构

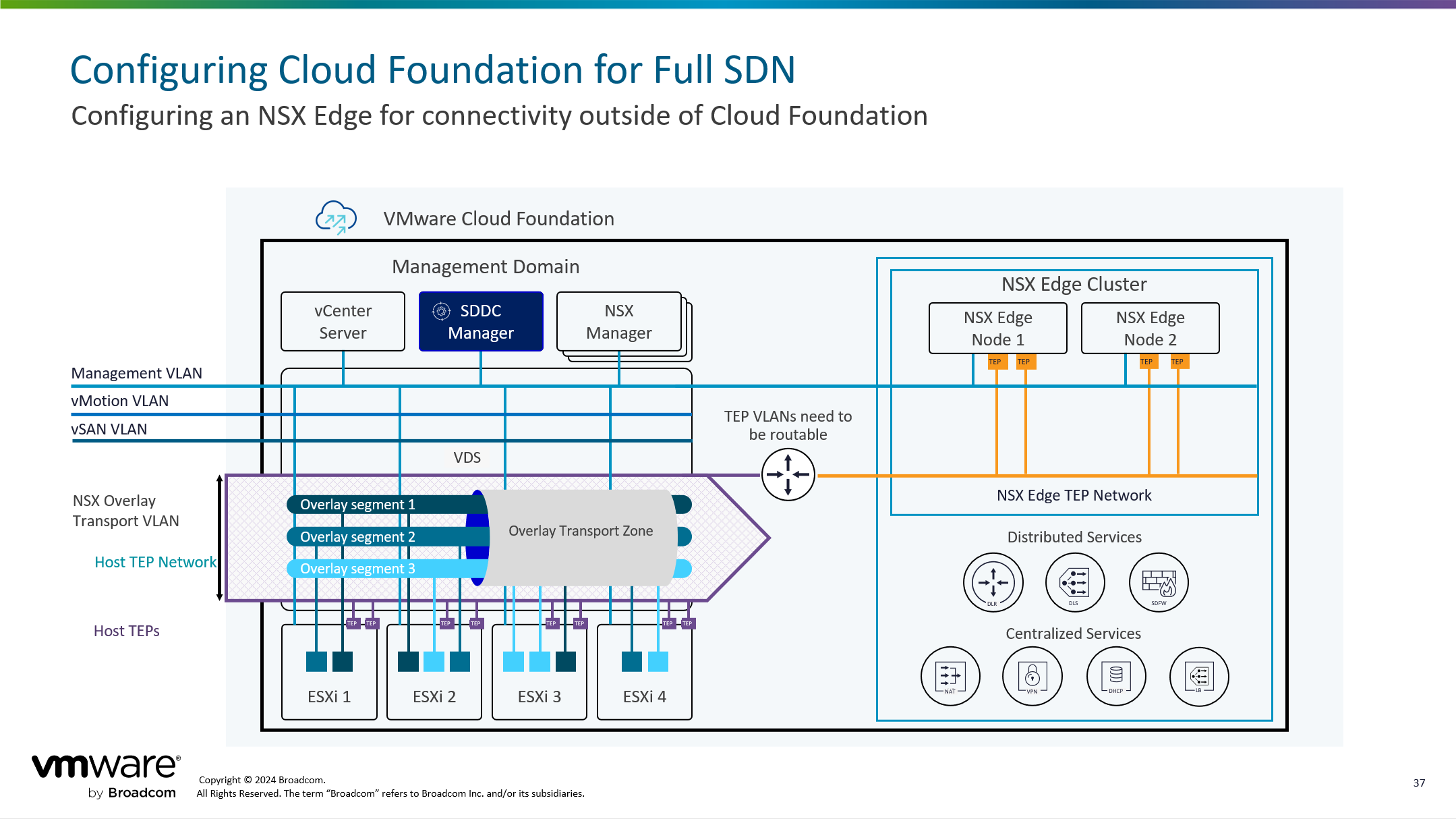

VI 工作负载域的网络架构其实和管理域的网络拓扑几乎是差不多的,当然有一点点区别,比如 VI 管理域不会有单独的管理组件 VM Management 网络,对于 VI 管理域来说只有 vCenter Server 和 NSX Manager 管理组件虚拟机,这些虚拟机会直接部署到管理域之上,并且这些虚拟机会直接与管理域上面分配给管理域组件的 VM Management 网络一起使用,也即是说 VI 域管理组件和管理域管理组件使用同一个网络,同一个端口组。而其他的网络,vMotion 网络和 NSX 网络一样,如果使用了 vSAN 存储,那会存在 vSAN 网络。

当然,与管理域一样,如果想实现完整的 SDDC 架构,同样还需要单独部署 NSX Edge 节点并配置 Edge 网络,以实现南北向路由和网络。

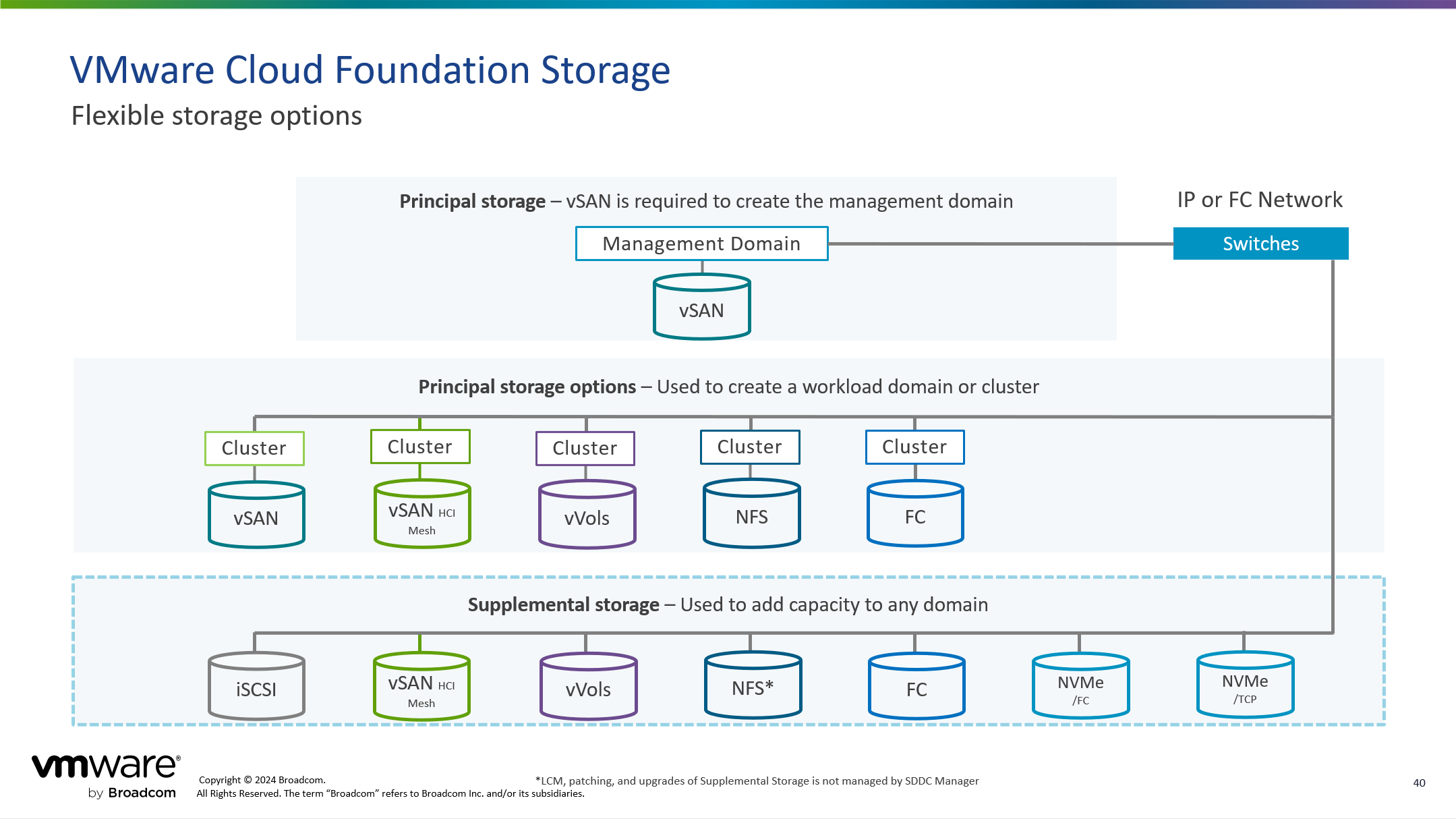

3)存储架构

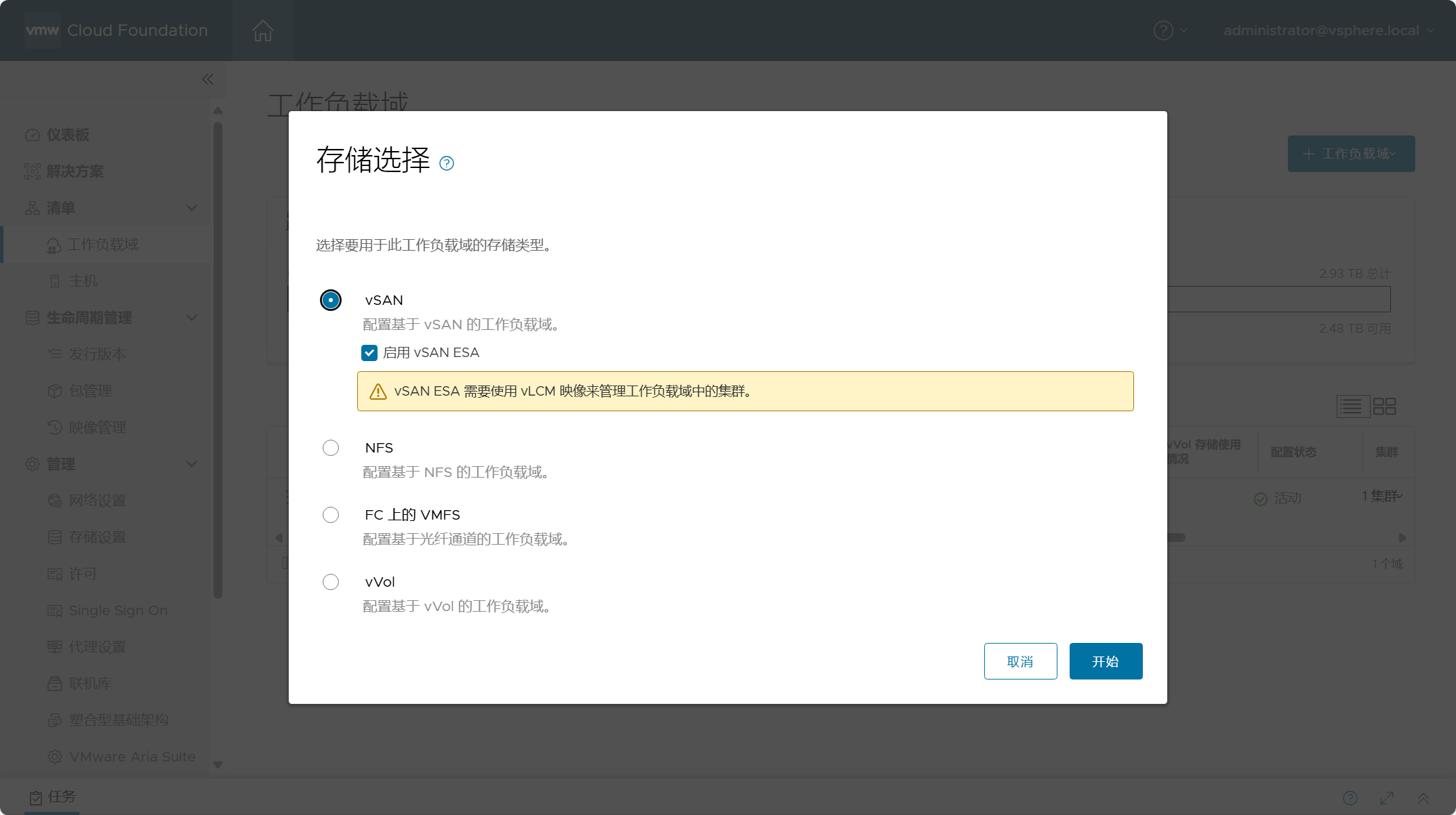

部署管理域时,只能将 vSAN 存储作为主体存储(Principal storage)进行初始构建,当部署完管理域后,后续可以登录管理域 vCenter Server 添加其他补充存储(Supplemental storage)进行使用,如下图所示。VI 工作负载域与管理域在存储使用方式上有所不同,在初始构建 VI 工作负载域时,主体存储中 vSAN 不再是唯一可选项,还可以使用如 FC、NFS 以及 vVols 等存储类型作为 VI 域的主体存储,然后部署完 VI 域后可以登录 VI 域 vCenter Server 添加其他补充存储(Supplemental storage)进行使用,如下图所示。对于构建 VI 域来说,使用不同类型的主体存储对于构成 VI 域的初始组成主机有些区别,比如,如果选择 vSAN 作为 VI 域的主体存储,那么至少需要准备 3 台 ESXi 主机进行构建 VI 域(管理域是 4 台),而使用 FC 类型的共享存储,可以只需准备 2 台 ESXi 主机用于构建 VI 域。使用不同类型的存储具有不同的注意细节,具体请查看 VCF 产品文档。

二、VI 域部署准备

与部署管理域时一样,部署 VI 工作负载域时同样需要做一些前期准备,比如安装用于构建 VI 域的 ESXi 主机,创建分配给 VI 域主机的网络池等。当然,如果在真实环境中还涉及到网络的规划和配置等,由于我这边是在嵌套环境中进行测试,所以可能会有很多忽略的地方,具体情况请以实际为主。

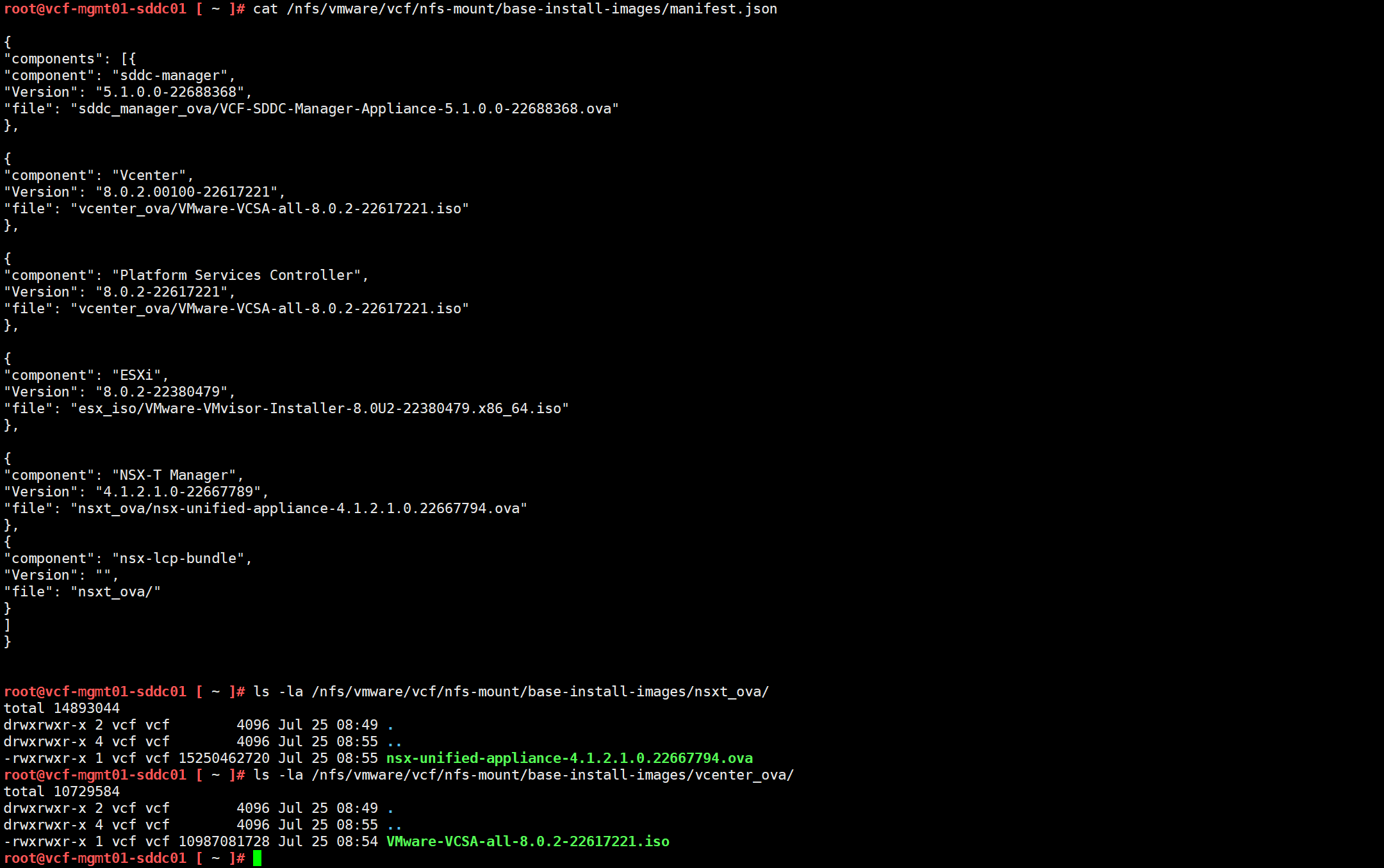

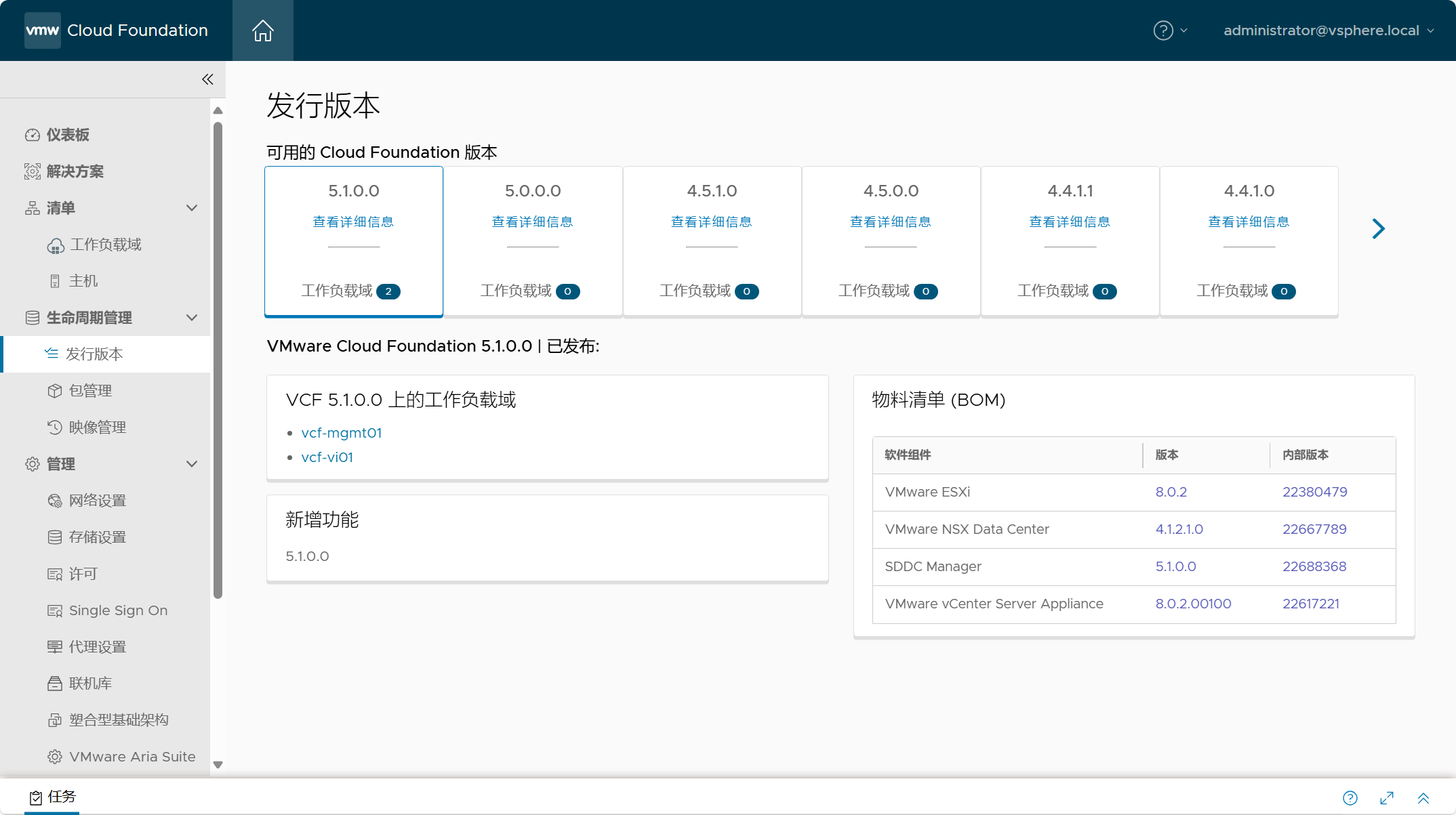

首先说明一下,之前的环境以及本次测试环境全部是基于 VMware Cloud Foundation 5.1.0 版本进行的,所以请严格按照该版本所发行说明中的 BOM 物料清单进行环境准备以及按照产品文档中的手册说明进行相关测试,对于任何操作所可能导致的风险请自行评估和承担。

1)准备 ESXi 主机

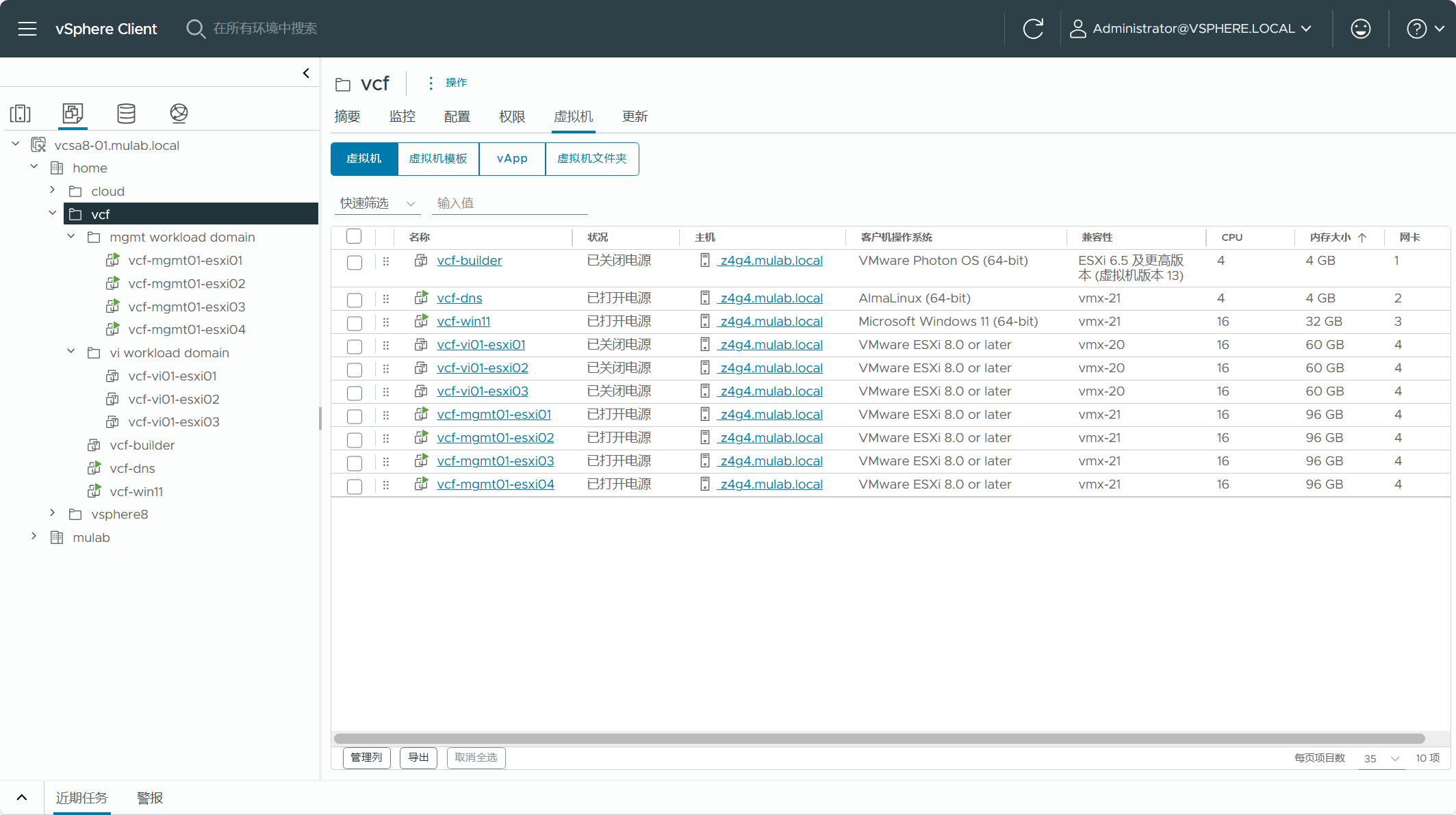

与部署管理域时一样,构建 VI 工作负载域所使用的主体存储类型还是选择 vSAN ESA 架构,所以我准备了 3 台嵌套 ESXi 主机(vcf-vi01-esxi01~vcf-vi01-esxi03),如下图所示。

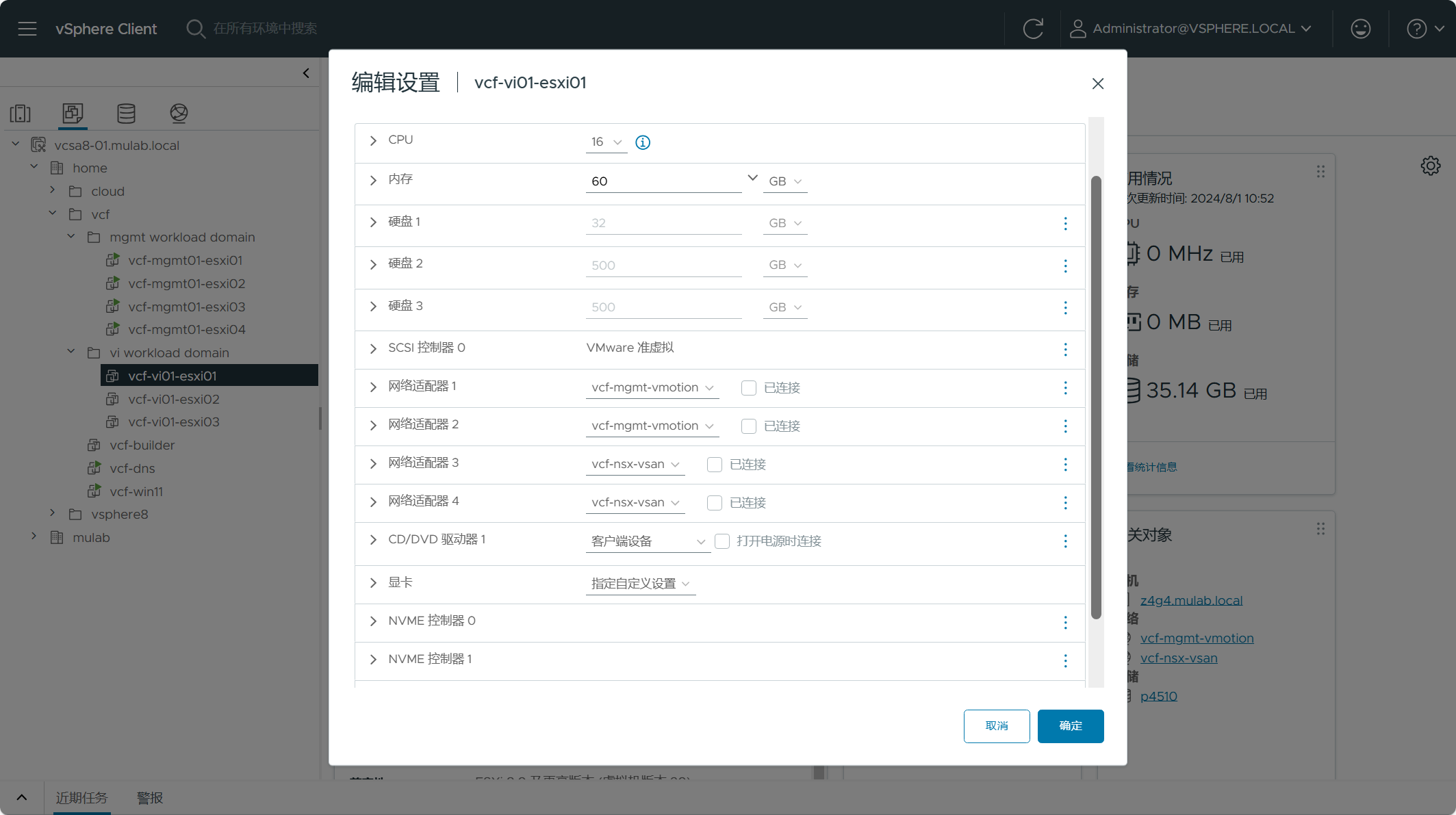

关于这 3 台嵌套 ESXi 主机的虚拟机的配置如下图所示,与管理域的嵌套 ESXi 虚拟机配置有一点区别,比如我将内存设置为 60 GB,因为 VI 域相对来说占用内存较低一些,因为 VI 域管理组件都运行在管理域上。但是,如果后续要部署 NSX Edge 节点以及部署其他解决方案,请一定将内存调高一些。其他所有配置与管理域虚拟机的配置一样,请根据情况自行进行调整。

注意,请完全参考管理域嵌套 ESXi 主机的安装和配置过程执行 VI 域嵌套 ESXi 主机的安装和配置,具体过程我这边就不再赘述了,有需要请查看之前这篇(VMware Cloud Foundation Part 04:准备 ESXi 主机。)文章。

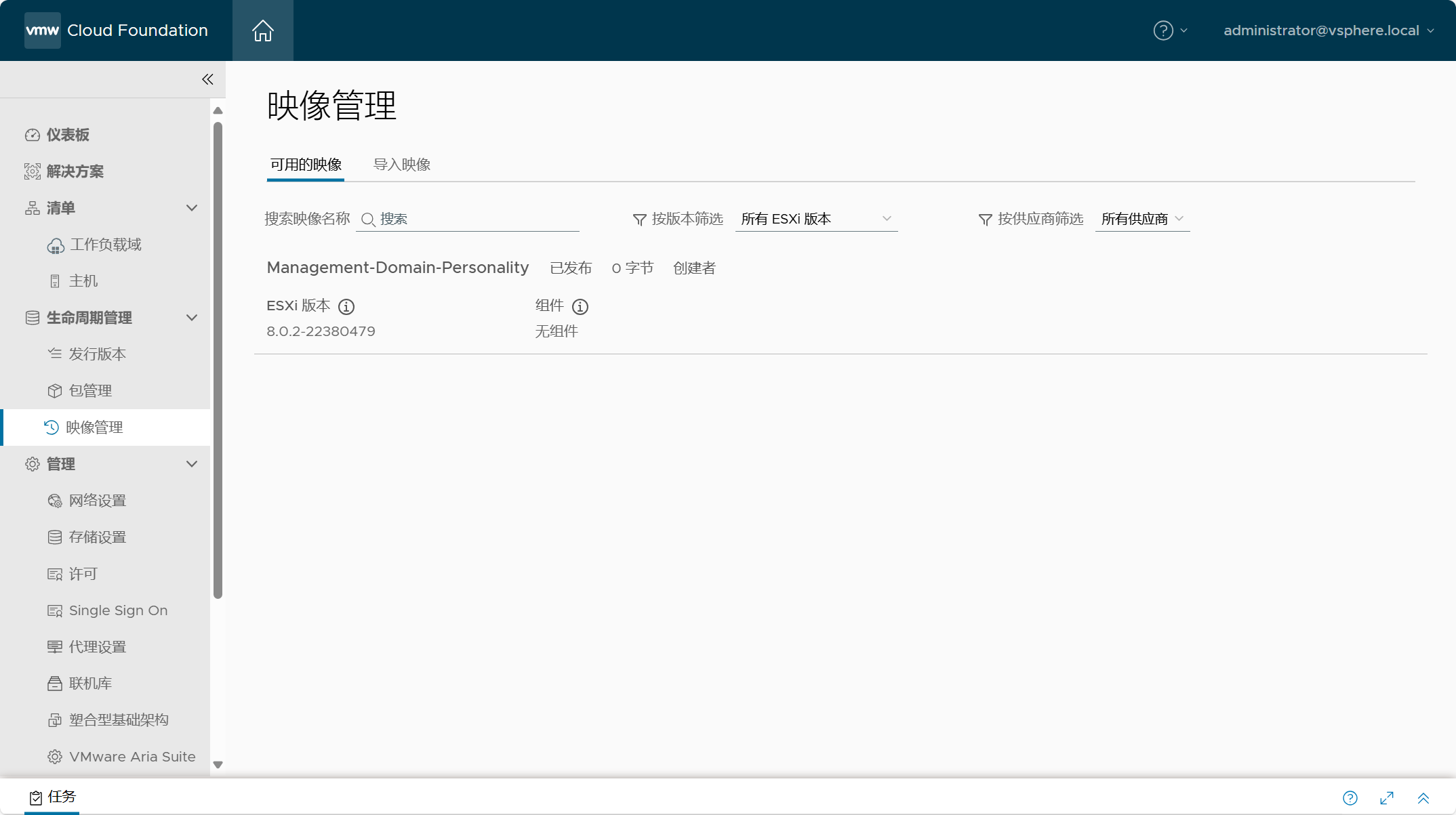

2)准备 vLCM 映像

如果你跟我一样使用 vSAN ESA 架构部署 VI 工作负载域,那需要准备 vLCM 基于集群生命周期管理的映像。VCF 使用 vSphere 中的 vLCM 进行相关管理组件的生命周期管理,如果使用了 vSAN ESA 则只能使用基于映像的方式,使用 vSAN OSA 可以使用基于基准的方式,不过基于基准的生命周期管理方式已弃用,在未来的版本中会被移除,建议采用基于映像的管理方式。如果你还不知道什么是 vLCM,可以查看之前这篇(使用vSphere Lifecycle Manager(vLCM)管理独立主机和集群的生命周期。)文章。

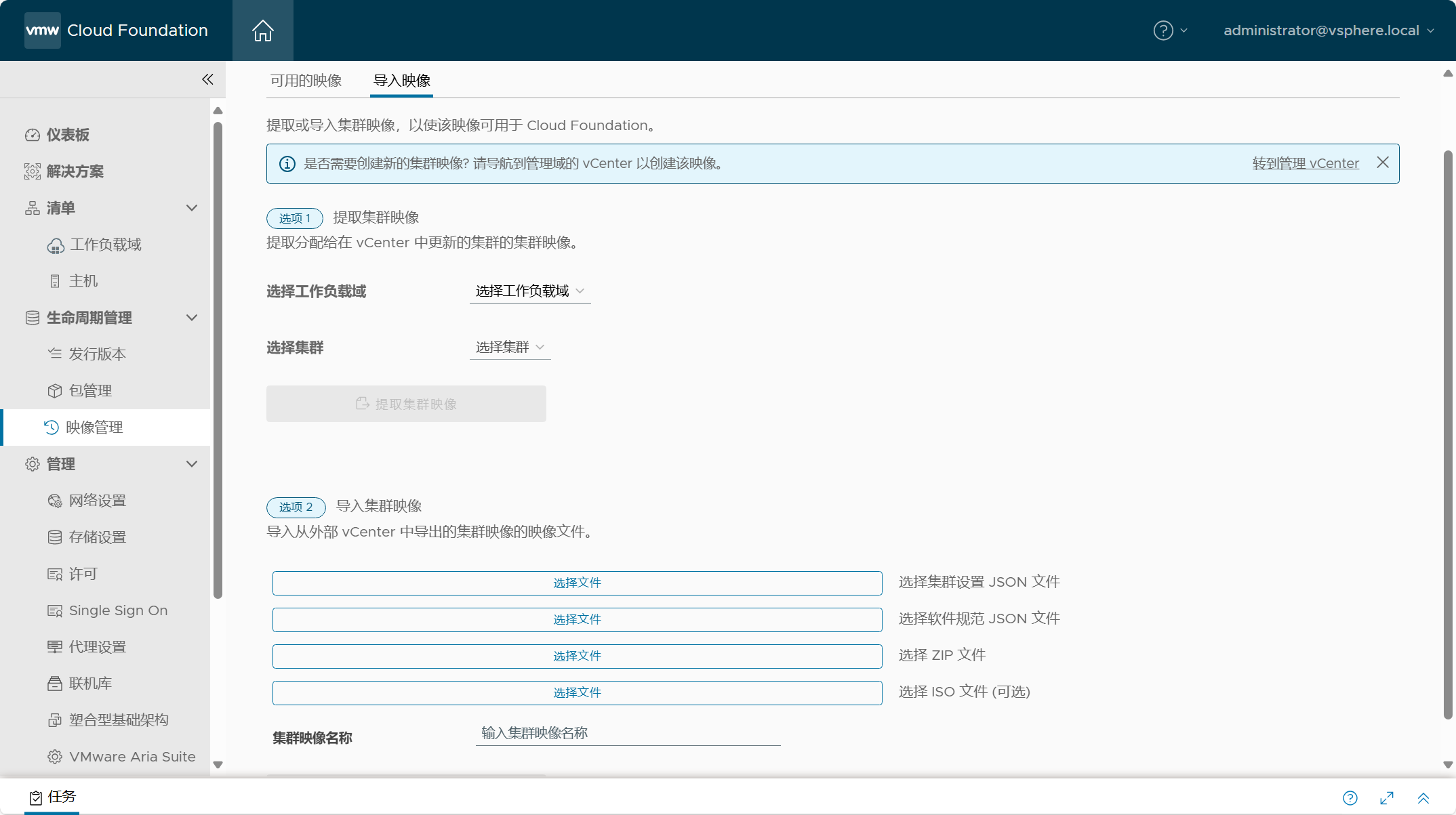

导航到 SDDC Manager->生命周期管理->映像管理,在“可用的映像”选项卡下面可以看到所有可用的映像,如下图所示,当前已经存在一个可以的映像(Management-Domain-Personality),这个映像是在部署管理域时自动从管理域集群中提取的映像,可以看到只有基础 ESXi 映像,没有其他供应商加载项、组件等,因为我部署的管理域的 ESXi 主机系统是使用的官方标准 ISO 安装映像。我后续安装的 VI 域的 ESXi 主机系统也是使用的同样的安装镜像,用于 VI 域集群的 vLCM 映像与管理域的映像一样,所以后续在部署 VI 域时我就直接使用这个管理域的映像了。

如果部署 VI 域的 ESXi 主机使用了不同的安装映像,那么可以在“导入映像”选项卡中手动提取或导入用于 VI 域的集群映像。这种方式在实际环境中可能很常见,比如用于 VI 域的 ESXi 主机使用了与管理域不同品牌的物理服务器,那对应的用于 ESXi 系统的安装镜像肯定也会不一样,这样你就需要设置单独的集群映像,VCF 提供了以下两种选项可以用于提取或导入不同的集群映像。选项 1 比较适用于当前已经有了相同品牌或型号服务器的工作负载域,这样你可以直接从这个工作负载域中的集群提取映像。选项 2 比较适用于初始构建工作负载域时从本地导入映像的方式,支持 JSON 配置文件、ZIP 以及 ISO 格式映像文件。这两种选项可根据情况灵活搭配使用。

3)准备 VI 域网络池

部署管理域时,我们需要准备一个 Excel 参数表,在这个参数表中有一个 “Hosts and Networks” 参数表,里面定义了用于 vMotion 和 vSAN 网络的地址段,这些地址段在部署管理域时会自动分配给这些主机的 vmkernel 网卡,用于相同的网络类型之间传输流量。可以查看这篇(VMware Cloud Foundation Part 03:准备 Excel 参数表。)文章了解更多细节。

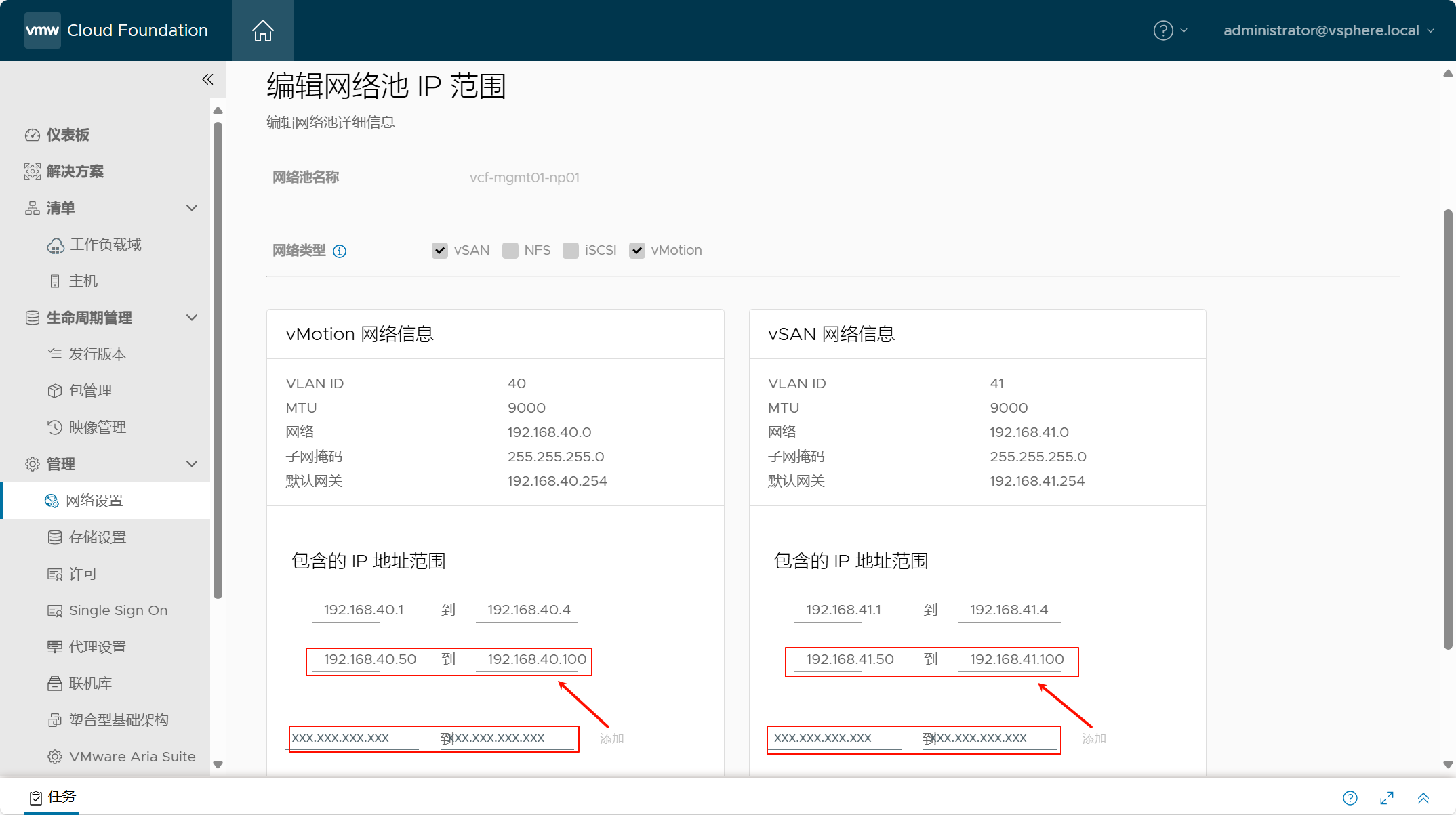

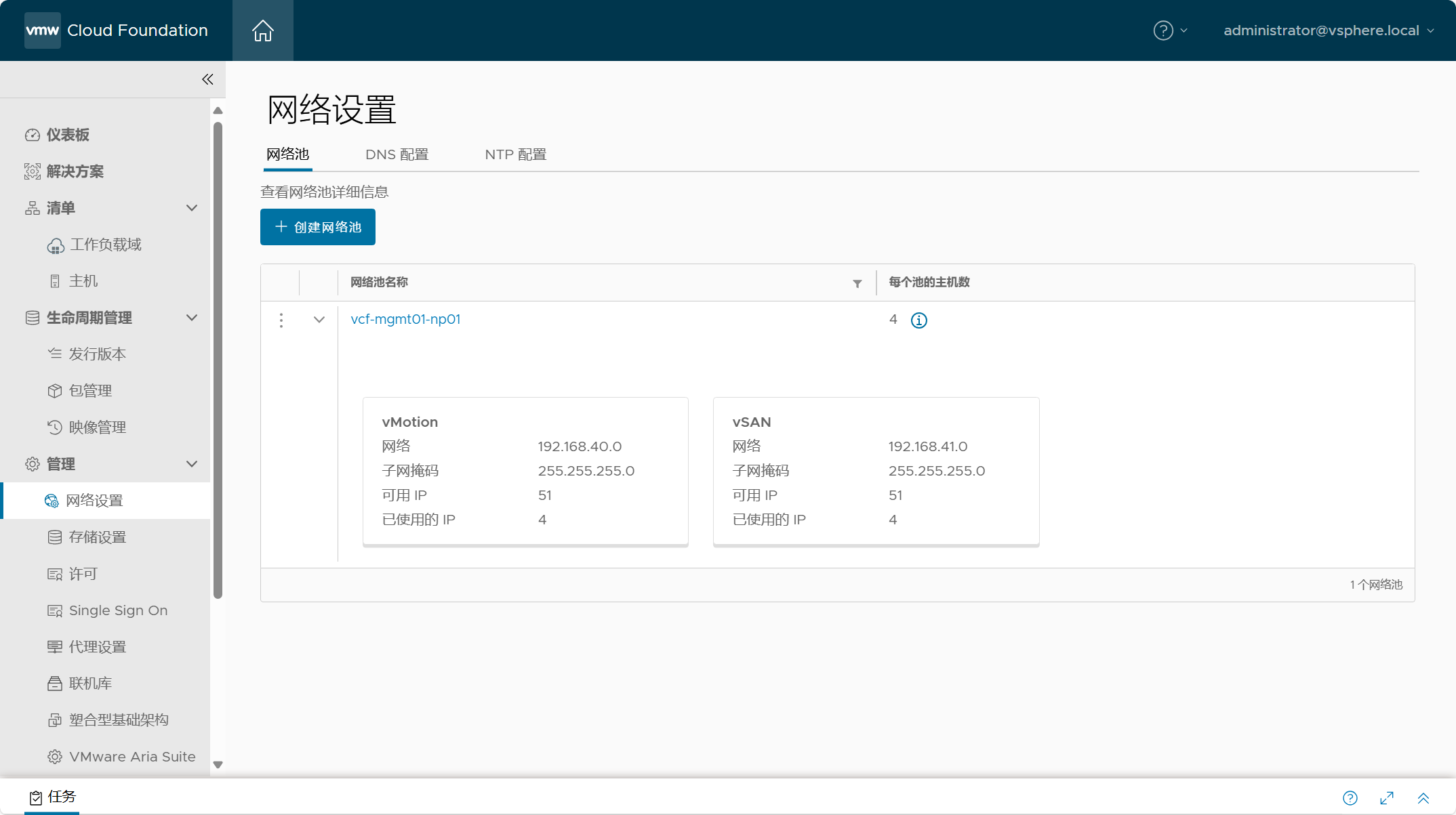

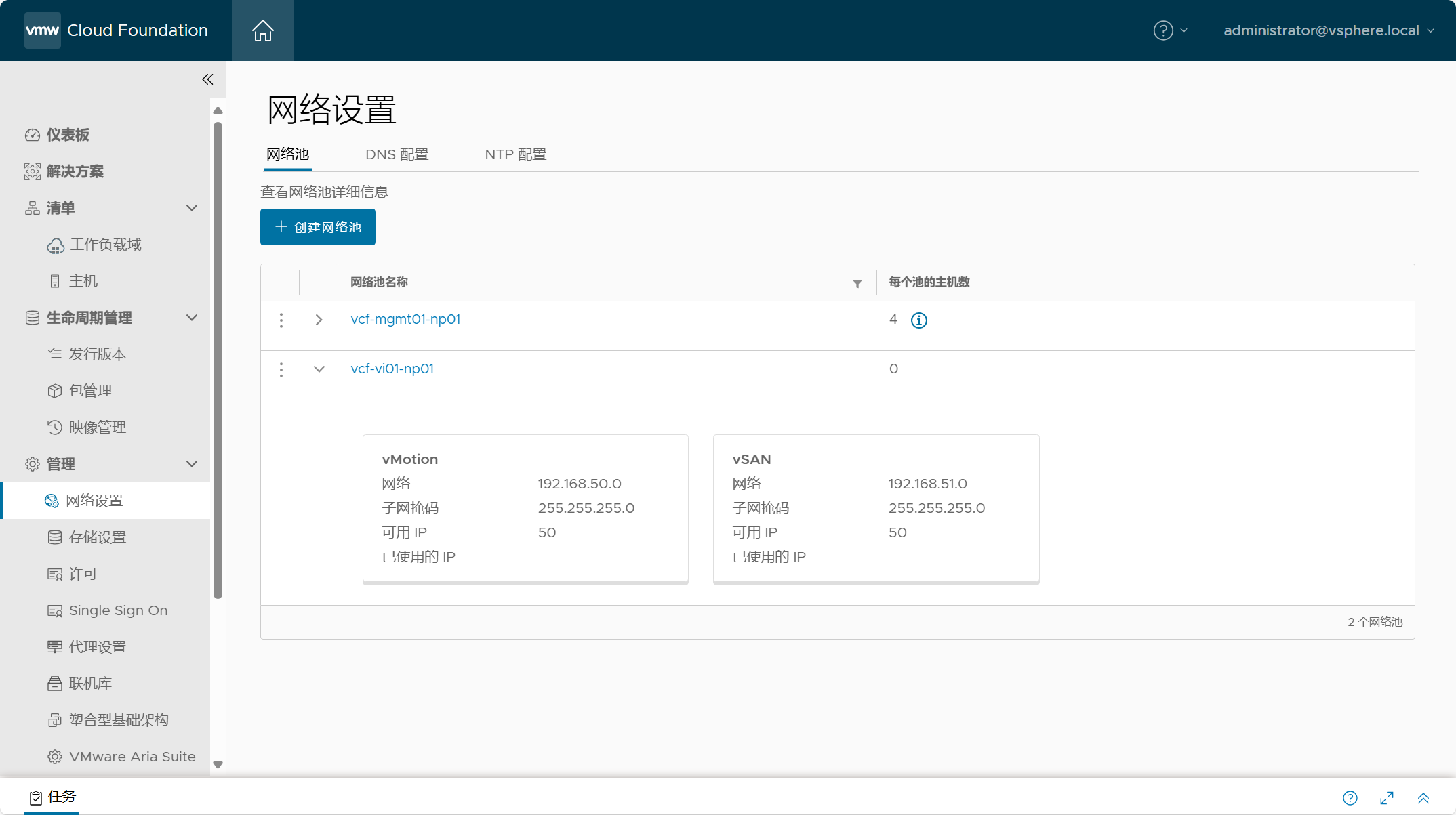

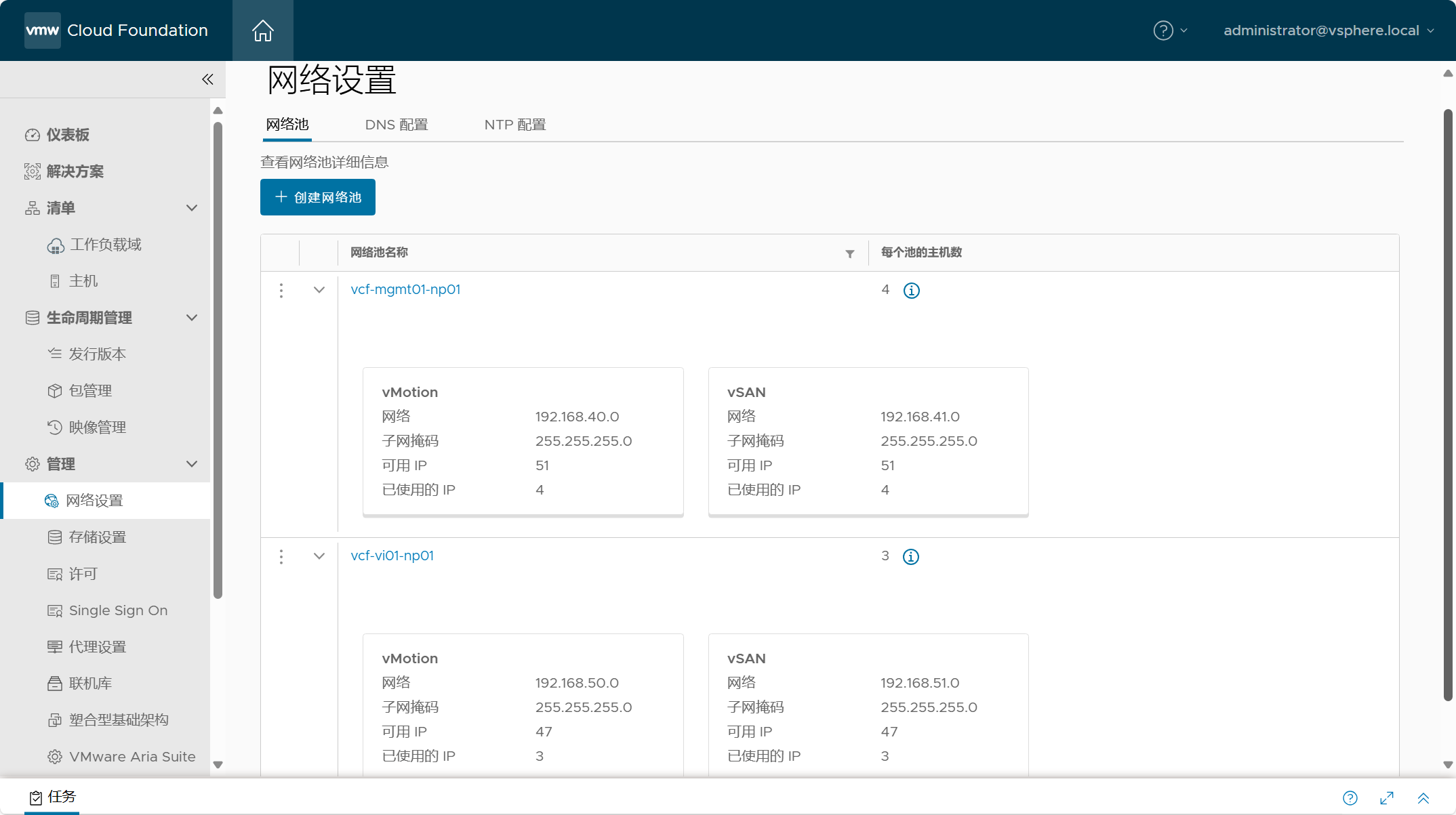

导航到 SDDC Manager->管理->网络设置,你可以在“网络池”选项卡看到之前部署参数表所配置的用于管理域主机的网络池,如下所示。可以点击编辑网络池,向网络池中的网络类型增加 IP 地址段,这样当需要向管理域增加集群或扩展集群主机时进行使用。

当向网络池增加 IP 地址后,相应的可用 IP 数也会增加。注意,这个只能增加,不能缩减,如果要缩减只能删除网络池后再重新添加。

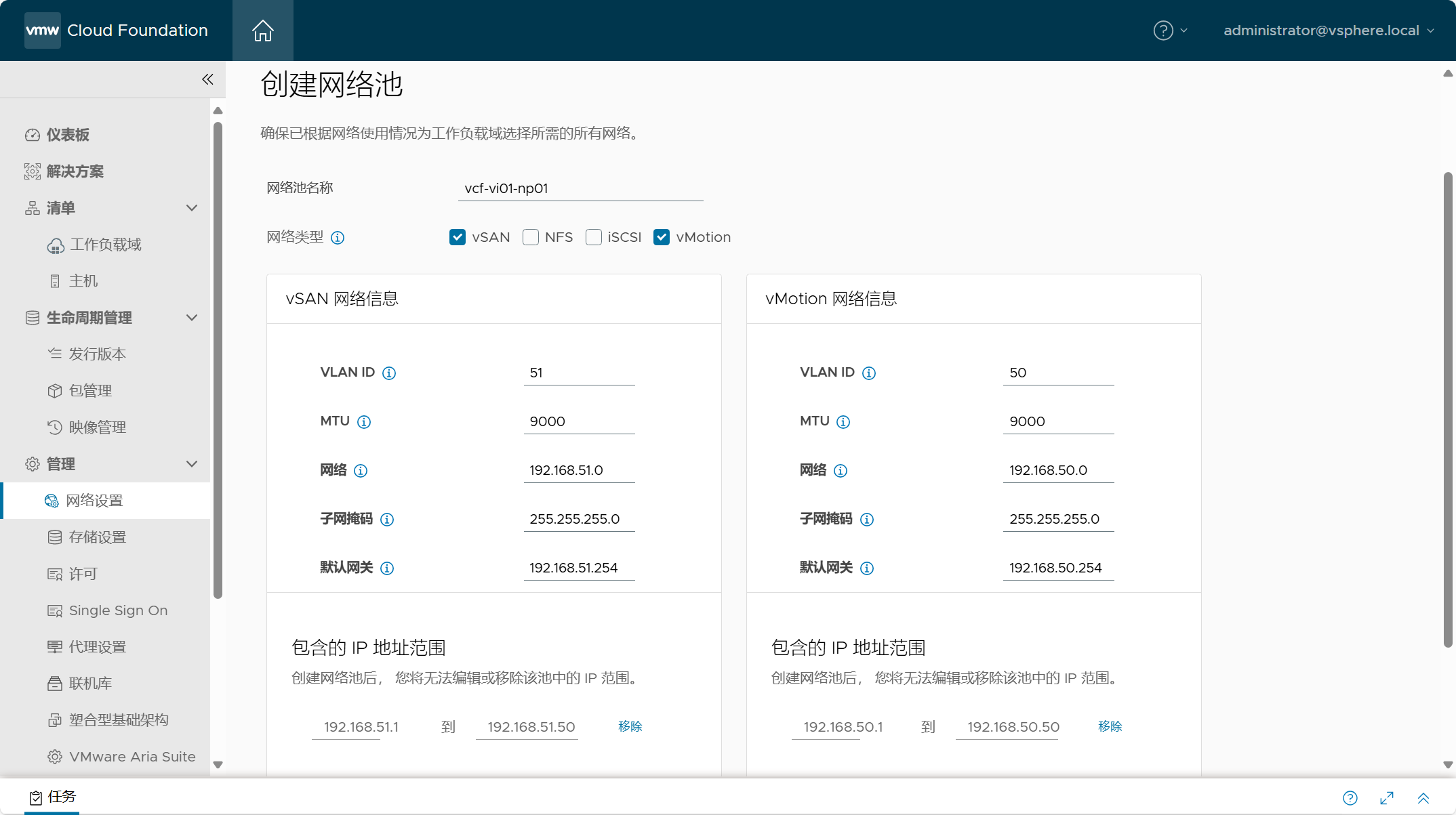

上面所创建的网络池已经用于管理域了,就只能被管理域主机所使用,不能用于 VI 工作负载域,如果要添加 VI 域,则需要创建单独用于 VI 域的网络地址池或者使用已经用于 VI 域的网络池(并且具有可用IP)。点击“创建网络池”,下面创建用于 VI 域的网络池,配置网络池的名称为 vcf-vi01-np01,选择需要给那些网络类型分配 IP 地址,当主机应用了这个网络池,如果启用了相应的服务,则会自动从网络池中获取地址。我这边只需要使用 vMotion 和 vSAN 网络,所以勾选这两种网络类型,并在下面配置用于这两种网络类型的 VLAN 和 地址等信息。注意,每个网络池中的每种网络类型只能属于一个网络,不能和其他网络池中的网络重叠,比如上面管理域的网络池中的 vMotion 网络类型的 VLAN 为 40,网段为 192.168.40/24,在新创建的这个网络池里不能设置相同的网络,所以我设置了 50 网段。可根据需要自行设置 IP 地址范围,默认网关我已经提前在物理 ESXi 主机的标准交换机上配置了虚拟 vmkernel 网关,具体可参考之前的文章。

保存后,可以看到已经创建好用于 VI 域的网络池。

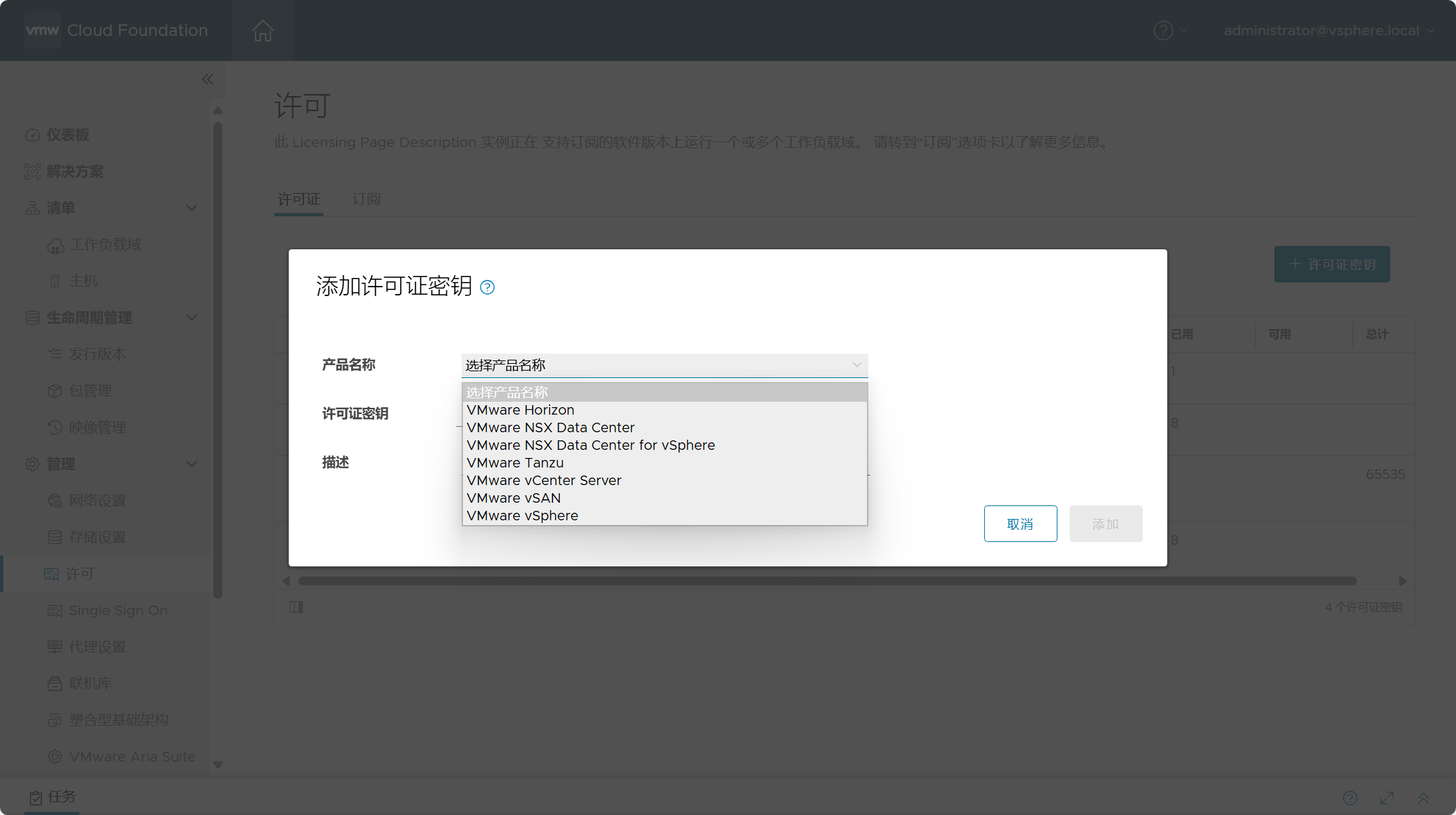

4)准备 VI 域组件许可

默认情况下,部署管理域组件的时候已经分配了相关组件许可,这在实际环境中,可能这些许可只够满足管理域组件的使用。那在部署 VI 域的时候,就需要单独添加用于 VI 域组件的 License 许可,在部署 VI 域之前需要提前将这些许可添加到 SDDC Manager 可置备的许可清单中,在部署配置 VI 域过程中需要使用到。

导航到 SDDC Manager->管理->许可,点击“许可证密钥”,将用于 VI 域管理组件的所有许可添加到 SDDC Manager 中。

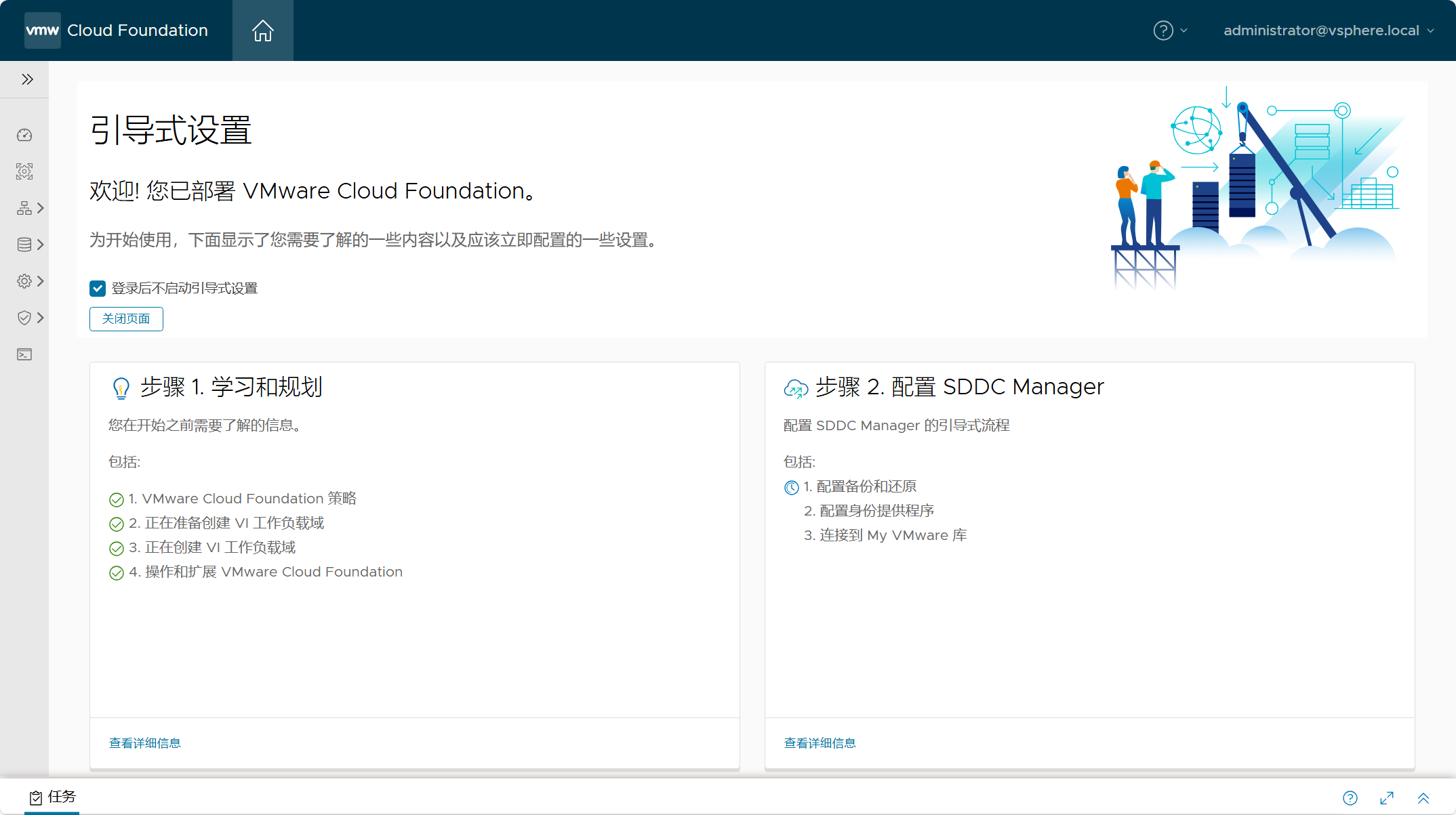

三、VI 域部署技巧

在正式部署 VI 工作负载域之前,可能有一些技巧也许有一定帮助,特别是对于我这种物理硬件资源不是很充足的环境来说,要完整的部署一套 VCF 环境真的是太难了,因为真的是太吃资源了!对于刚接触 VMware Cloud Foundation 的同学来说,建议使用 SDDC Manager 中的引导式设置来了解 VCF 有关的内容以及相关配置的注意事项,这对于学习和管理 VCF 来说非常具有帮助。

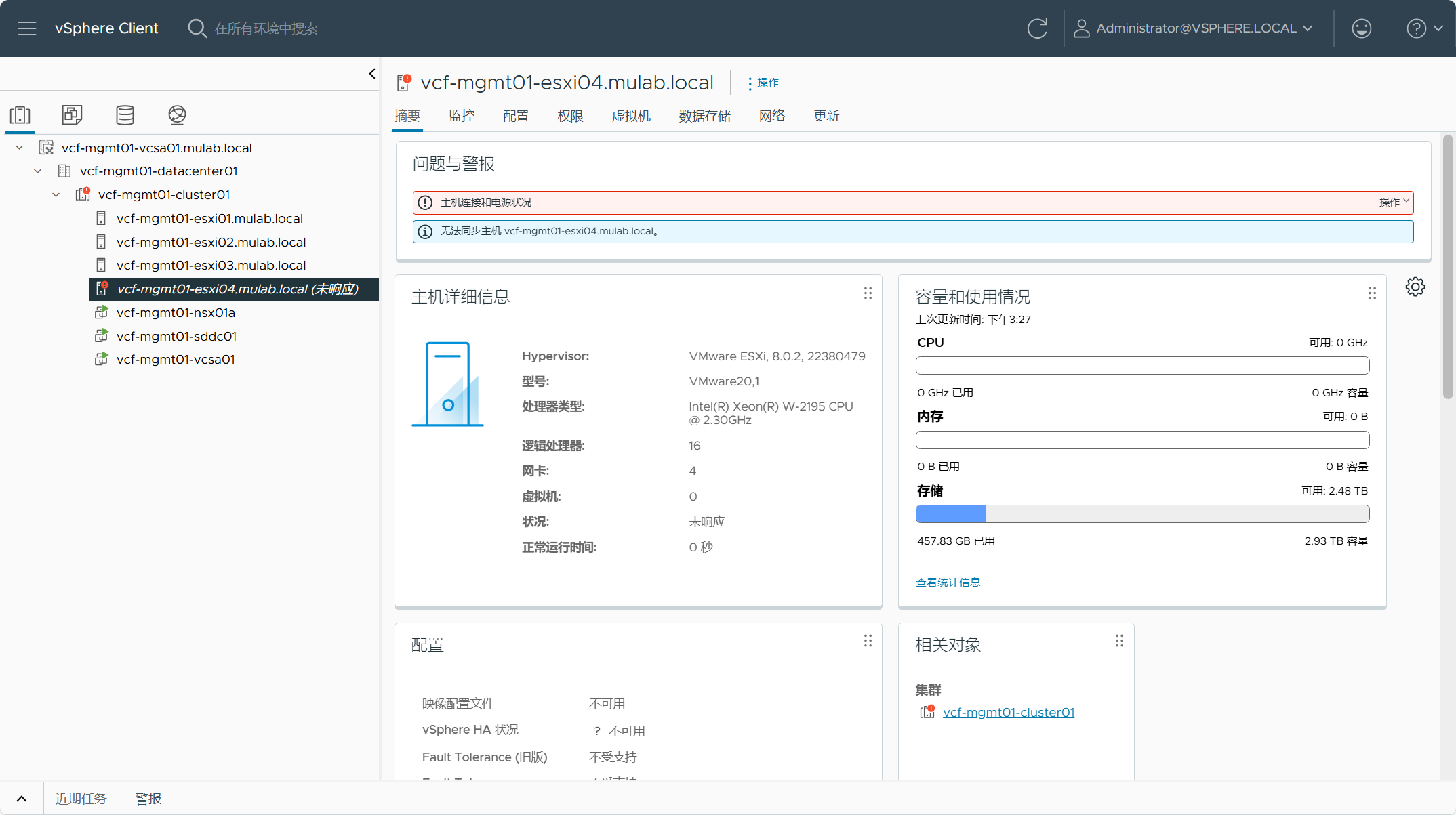

1)关闭管理域主机

由于我这边物理 ESXi 主机资源有限,无法满足同时运行管理域和 VI 域所有组件,所以我将管理域中的一台 ESXi 主机给关机了,勉勉强强能够部署一个 VI 工作负载域。这个需要在正式开始执行部署 VI 域任务的时候关掉,并且需要在“验证管理工作负载域是否具有足够的资源以部署 NSX”这个任务之后进行关闭,或者在部署 vCenter Server 组件之前关闭也行。当然,如果你的资源充足,可以直接忽略。

2)vSAN ESA HCL

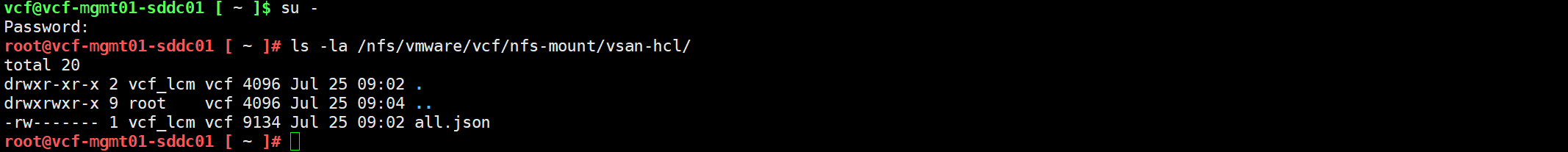

由于将要部署 vSAN ESA 架构的 VI 工作负载域,所以在部署过程中同样需要验证 ESXi 主机的 vSAN HCL 兼容性。因为使用了嵌套 ESXi 主机,肯定不在官方兼容性列表里,所以之前在部署管理域的时候,我们使用了一个脚本来生成嵌套 ESXi 主机的自定义 vSAN HCL 文件。我在部署 VI 域的时候确认了一下,因为之前部署管理域的时候,已经将我们上传的自定义 vSAN HCL 文件同步到 SDDC Manager 中了,所以我在部署 VI 域的时候没有遇到兼容性问题,如果有问题,在执行任务的时候应该会遇到“Perform vSAN ESA Auto Disk Claim”失败,这时解决办法就是重新将之前生成的自定义 vSAN HCL 文件上传到 SDDC Manager 虚拟机中并替换如下文件:/nfs/vmware/vcf/nfs-mount/vsan-hcl/all.json,然后配置文件所有权为 vcf_lcm:vcf 即可。

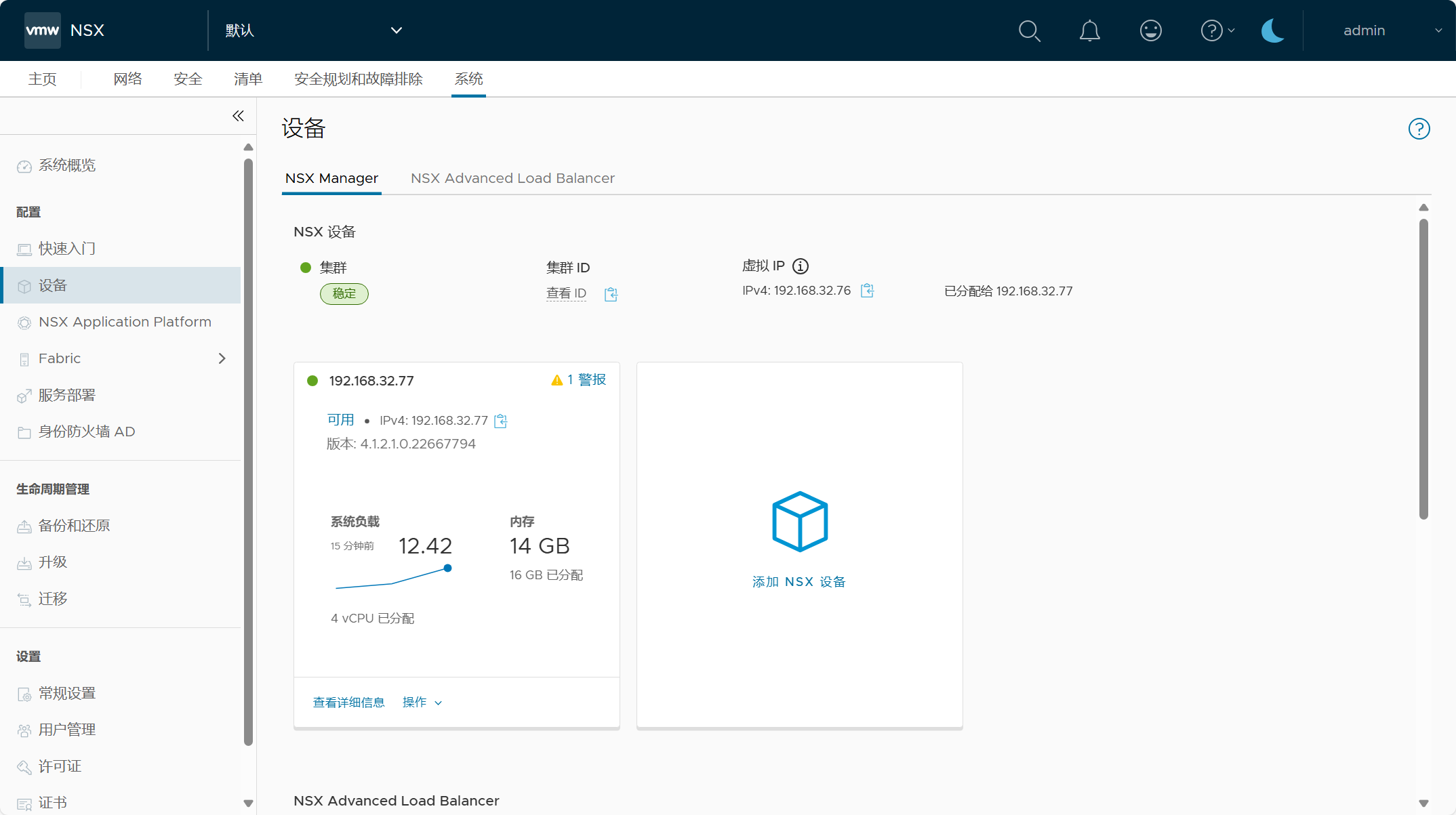

3)NSX Manager

默认情况下,部署 VI 域管理组件 NSX 的时候会创建一个由 3 个 NSX Manager 节点所组成的 NSX 集群。这与部署管理域时的情况一样,由于是测试学习环境并且因为物理资源不足,所以有一个技巧可以只部署 1 个 NSX Manager 节点,如果是实际环境并且资源很充足的情况下,默认即可。下面是部署 NSX Manager 的大小的默认配置。

| NSX Manager 部署大小 | 内存 | vCPU | 磁盘 | 内存预留(默认) | VM 硬件版本 |

| Extra Small | 8 GB | 2 | 300 GB | All | 10 or later |

| Small | 16 GB | 4 | 300 GB | All | 10 or later |

| Medium | 24 GB | 6 | 300 GB | All | 10 or later |

| Large | 48 GB | 12 | 300 GB | All | 10 or later |

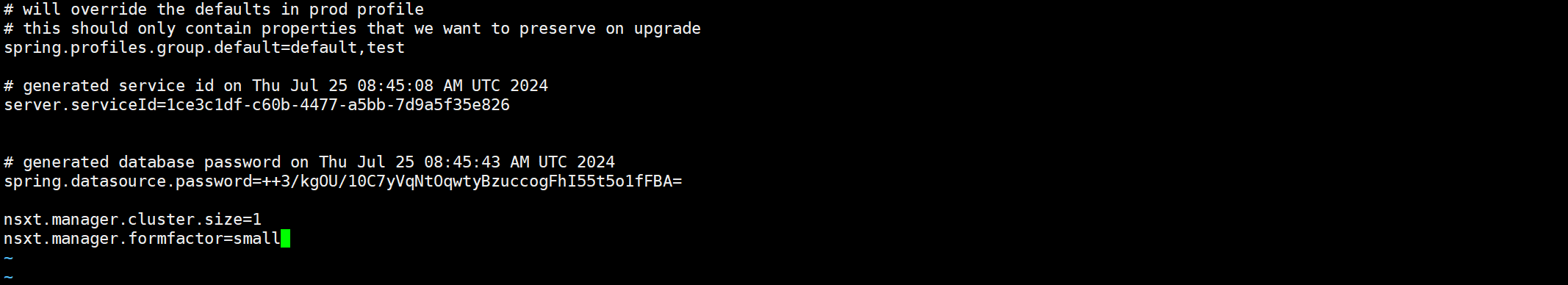

以 vcf 用户登录到 SDDC Manager 并切换到 root 用户,然后修改如下 application-prod.properties 文件。

vim /etc/vmware/vcf/domainmanager/application-prod.properties添加自定义参数如下,NSX Manager 的部署数量为 1 以及部署大小为 small。

nsxt.manager.cluster.size=1

nsxt.manager.formfactor=small

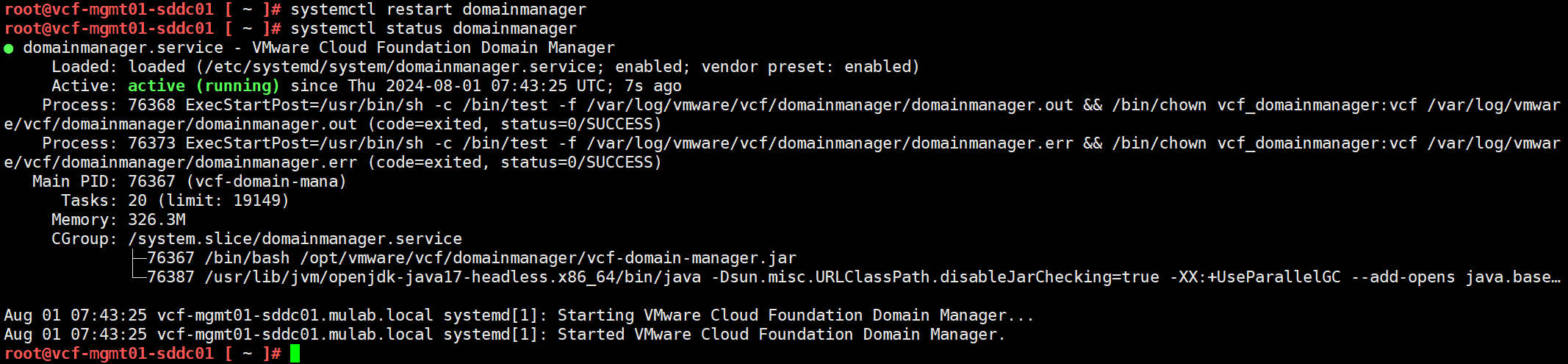

保存配置后,重启域管理器服务,并确保服务运行正常。

systemctl restart domainmanager

针对于 NSX Manager 虚拟机内存预留,其实也有方法可以在部署之前,将 NSX Manager OVA 模板中的预定义配置调整为无预留,不过比较麻烦,如果不是特别紧缺的情况下,也可以在部署完 NSX Manager 虚拟机之后,再登录 vCenter Server 对其进行修改。

四、VI 域部署过程

1)VI 域组件地址

针对当前环境,为所有的 VI 工作负载域的管理组件规划好 IP 地址信息,请一定提前在 DNS 服务器上配置好正反向域名解析。

| 组件名称 | 主机名 | IP地址 | 子网掩码 | 网关 | DNS/NTP 服务器 |

| ESXi | vcf-vi01-esxi01.mulab.local | 192.168.32.71 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 |

| vcf-vi01-esxi02.mulab.local | 192.168.32.72 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 | |

| vcf-vi01-esxi03.mulab.local | 192.168.32.73 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 | |

| vCenter Server | vcf-vi01-vcsa01.mulab.local | 192.168.32.75 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 |

| NSX Manager | vcf-vi01-nsx01.mulab.local | 192.168.32.76 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 |

| vcf-vi01-nsx01a.mulab.local | 192.168.32.77 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 | |

| vcf-vi01-nsx01b.mulab.local | 192.168.32.78 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 | |

| vcf-vi01-nsx01c.mulab.local | 192.168.32.79 | 255.255.255.0 | 192.168.32.254 | 192.168.32.3 |

2)添加服役主机

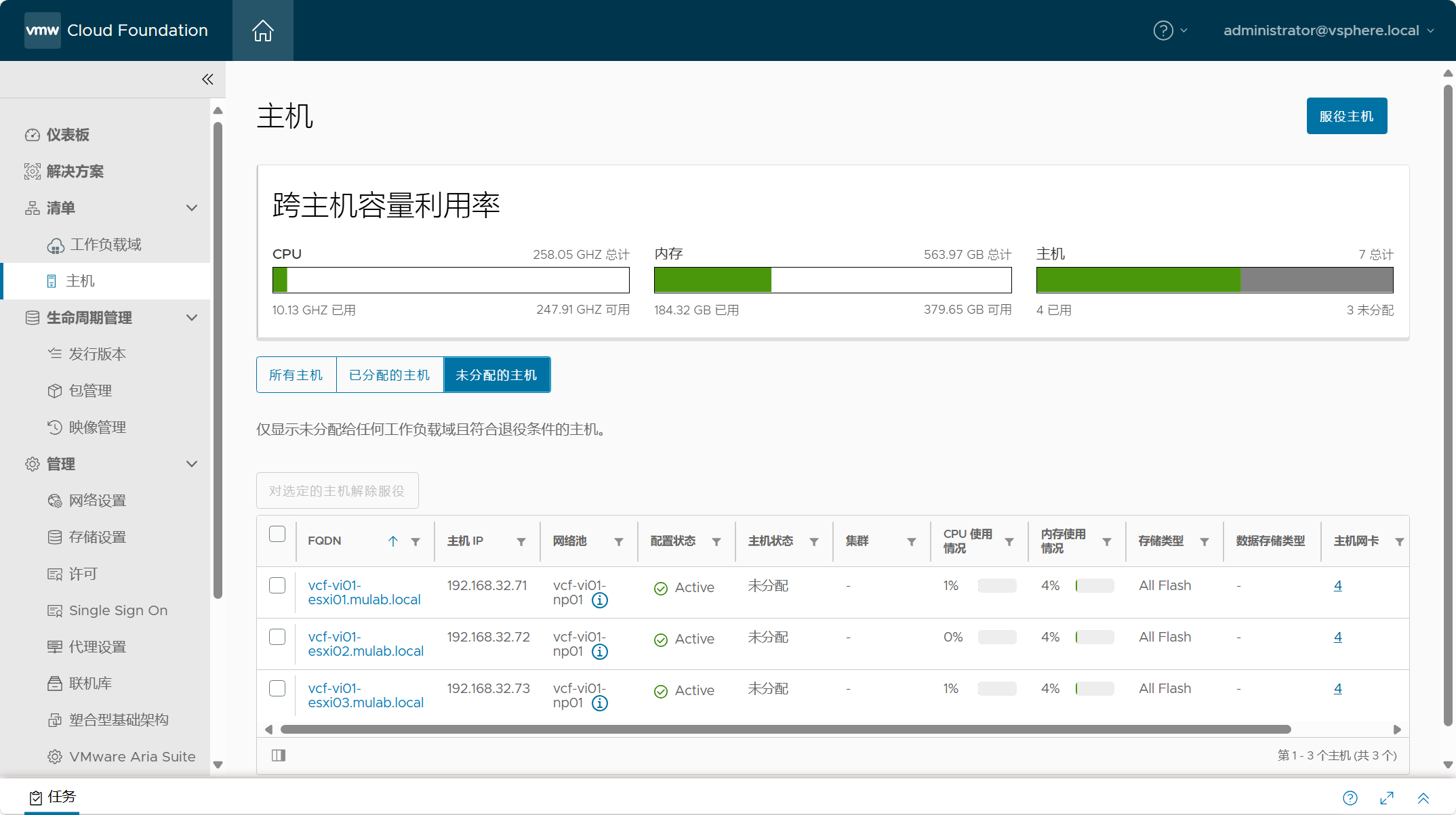

部署 VI 工作负载域之前,首先需要将用于工作负载域的 ESXi 主机添加到 SDDC Manager 清单。同时,不管是任何一种工作负载域(管理域/VI 域)需要扩容主机,都需要先添加服役主机。

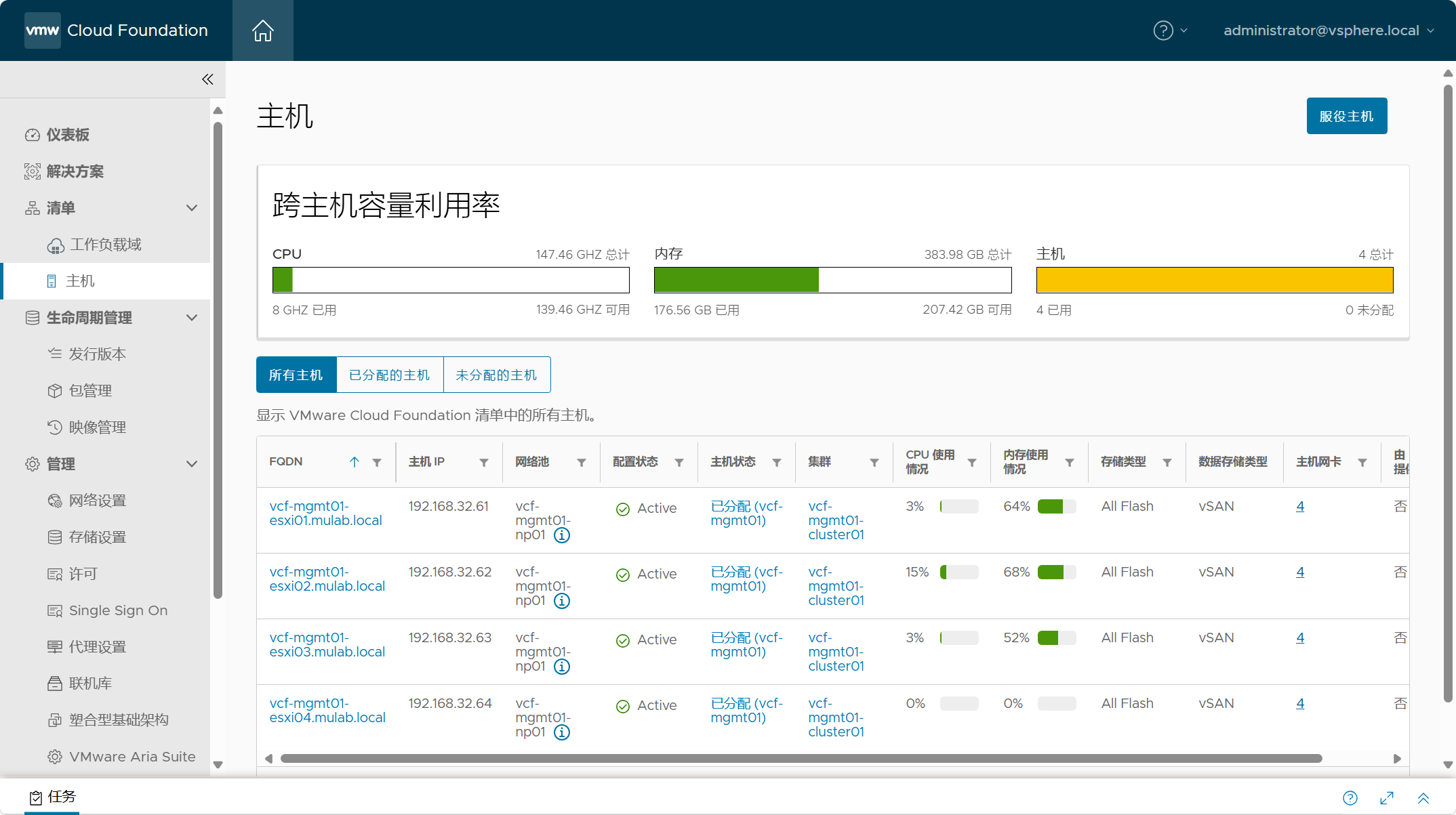

导航到 SDDC Manager->清单->主机,这里展示了所有已分配的主机和未分配的主机,我们需要点击“服役主机”添加工作流将用于 VI 域的 ESXi 主机添加到清单中。

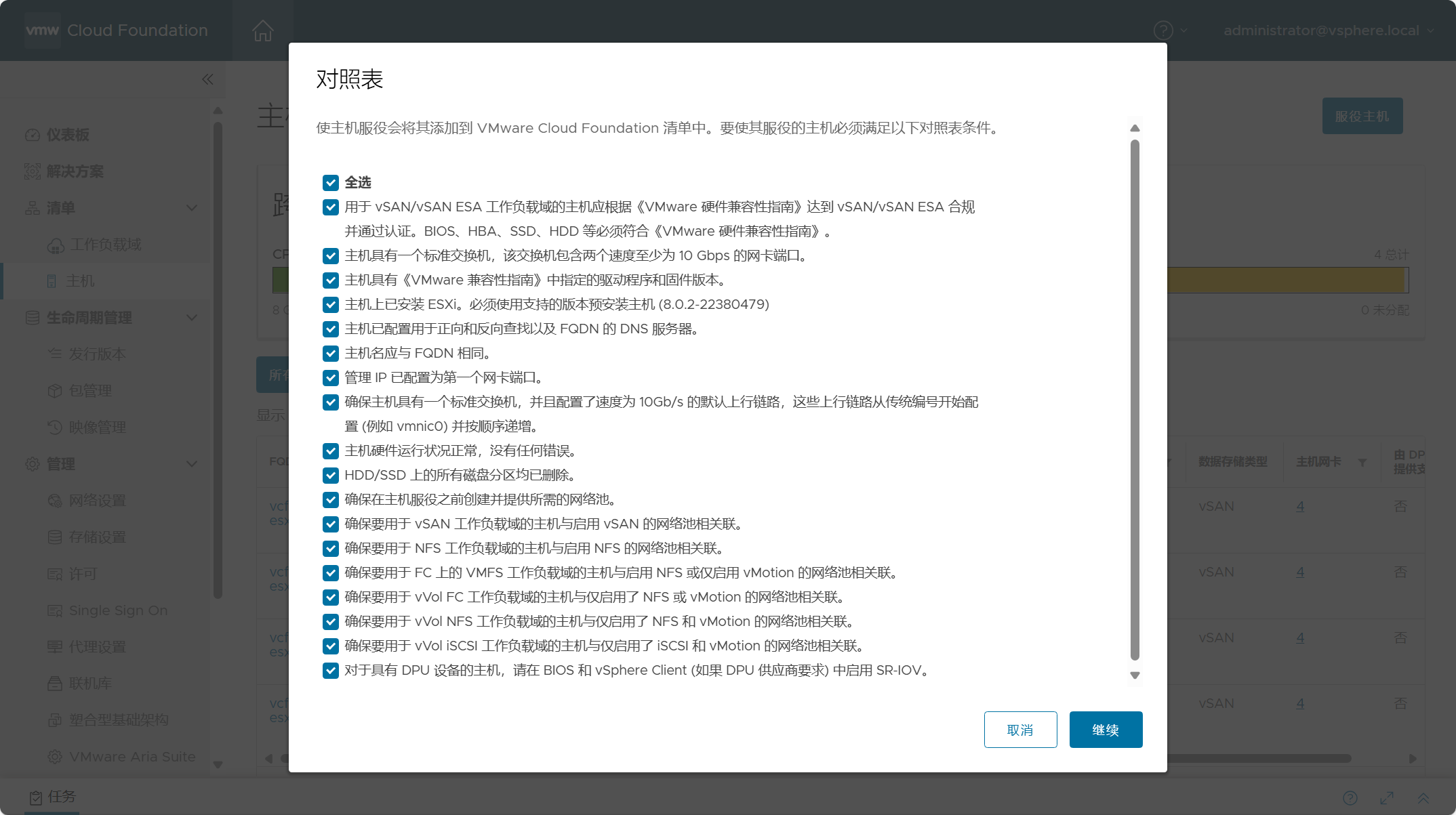

勾选全部,确保已知晓添加条件和要求,点击继续。

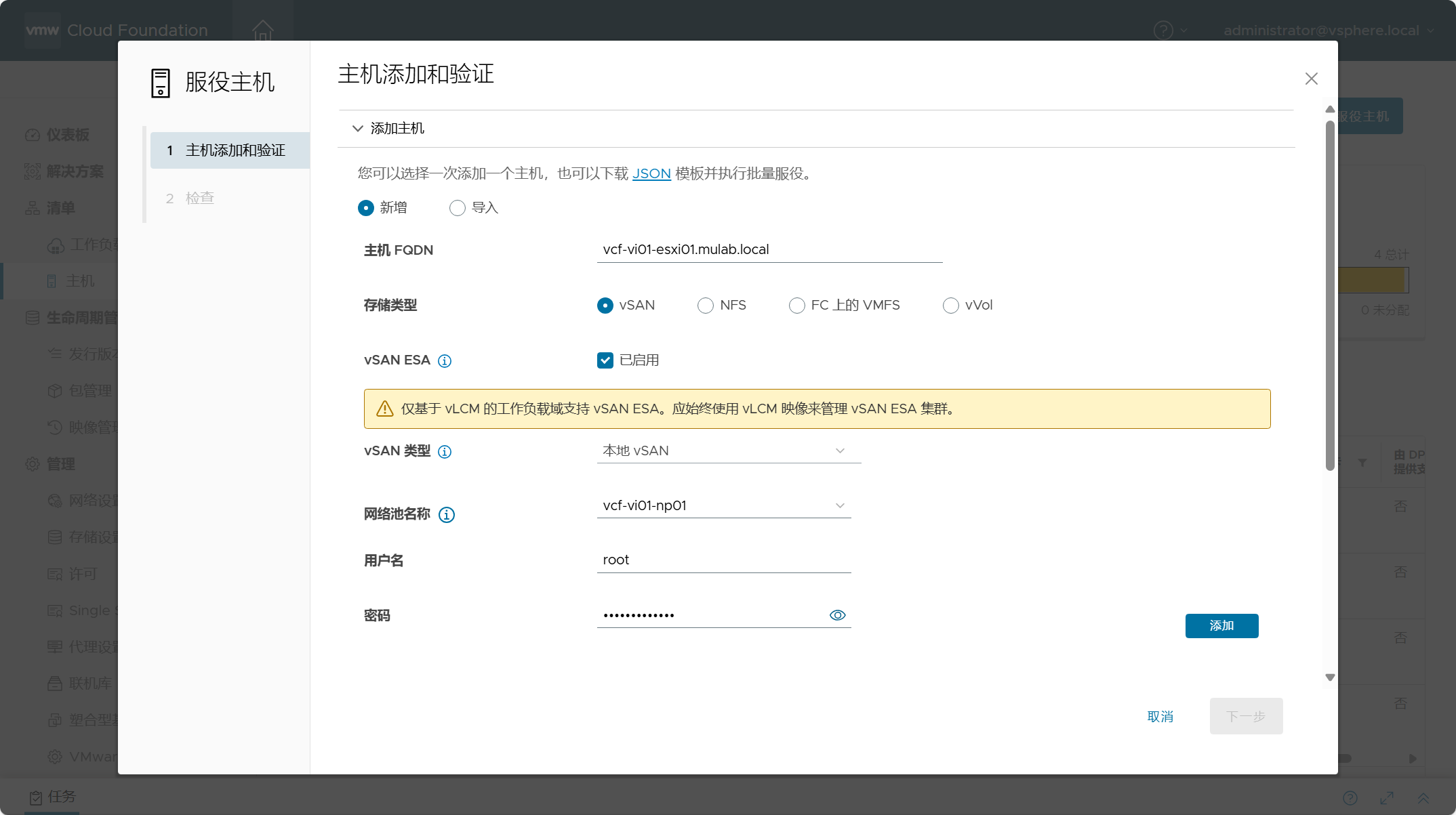

添加主机有两种方式,一种是选择“新增”一台一台添加主机,另外一种是选择“导入”从 JSON 模板文件中批量添加主机。

选择“新增”,输入 ESXi 主机的 FQDN。选择存储类型,VI 域支持下图中的几种类型的主体存储,其实在这里添加主机的时候选择哪种存储类型就已经提前定了后面部署 VI 域时所选择的主机存储类型,当你选择哪种存储类型,后面的时候也就只能使用你选择的存储类型。比如,当你选择 vSAN 时,这台主机就被标记为 vSAN 主机了,后面部署 VI 域或者扩容 VI 域主机的时候,就只能用于 vSAN,这个地方选择了后不能修改,只能将服役主机移除,并重新添加服役主机。由于我们需要部署 vSAN ESA 架构,所以需要勾选“vSAN ESA”,这个地方可以看到 vSAN ESA 只能由 vLCM 基于映像的生命周期方法进行管理。vSAN ESA 的 vSAN 类型只能选择“本地 vSAN”。网络池名称这里一定要选择之前我们创建用于 VI 域的网络池(vcf-vi01-np01)。最后,输入 ESXi 主机的用户名和密码,即可点击添加。

如果你不勾选 vSAN ESA,也就是 vSAN OSA,这时 vSAN 类型可以选择“本地 vSAN”或 “vSAN 计算集群”,选择 vSAN 计算集群的主机本地可以没有存储,然后通过 vSAN Mesh 功能远程挂载其他集群的 vSAN 存储,这个功能现在叫具有数据存储共享的 vSAN HCI。如果你还不知道什么叫具有数据存储共享的 vSAN HCI,可以查看这篇(创建vSAN Max集群并配置挂载远程数据存储。)文章。

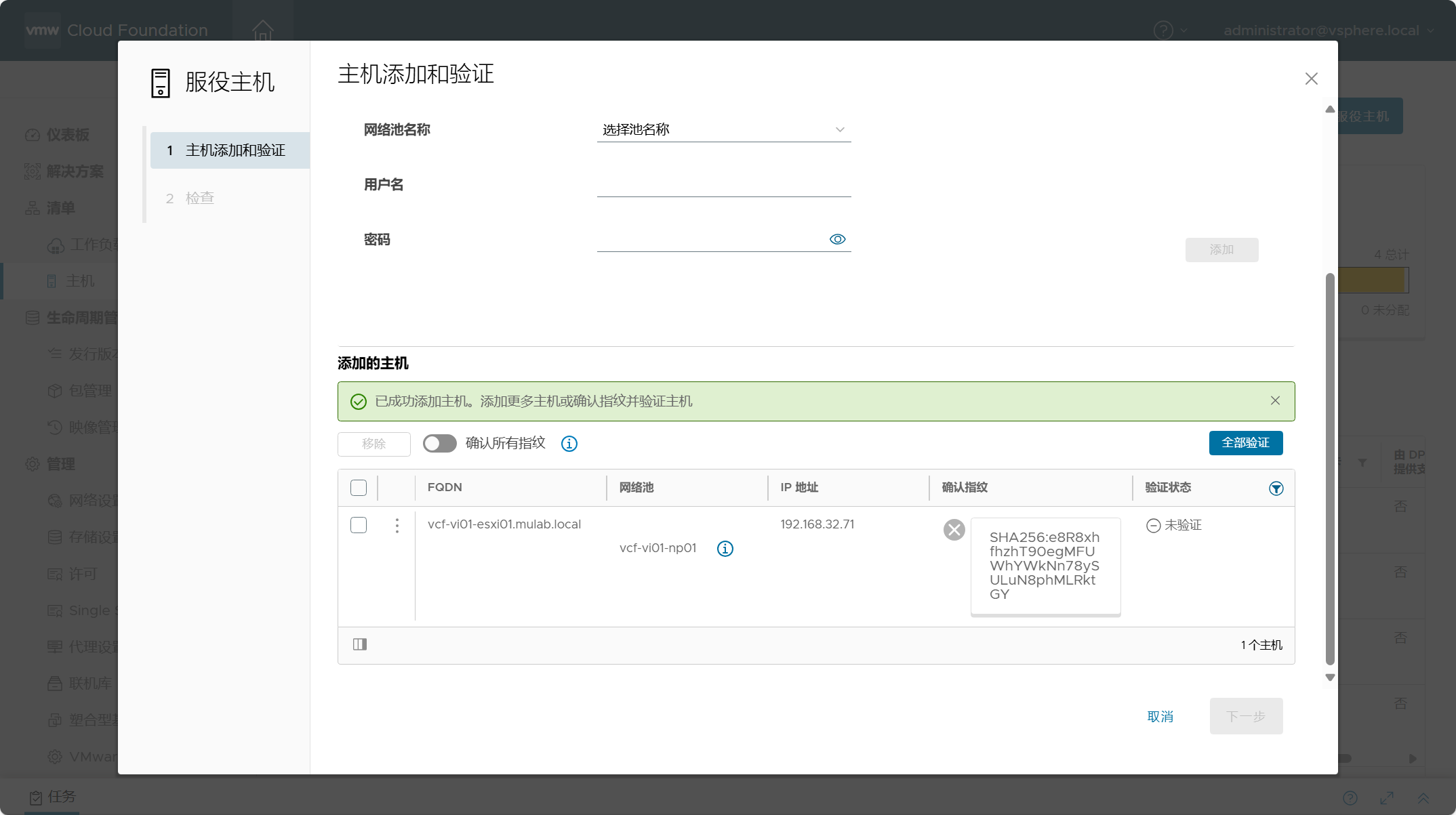

配置好后,点击“添加”,可以看到主机已经加入到待验证列表。

如果选择“导入”选项,我们可以点击下载 JSON 模板,然后将我们环境中的信息填入到 JSON 文件中去,这样就可以批量添加主机了,如下所示。

{

"hostsSpec": [

{

"hostfqdn": "vcf-vi01-esxi02.mulab.local",

"username": "root",

"storageType": "VSAN_ESA",

"password": "Vcf5@password",

"networkPoolName": "vcf-vi01-np01",

"vVolStorageProtocolType": "-- VMFS_FC/ISCSI/NFS --"

},

{

"hostfqdn": "vcf-vi01-esxi03.mulab.local",

"username": "root",

"storageType": "VSAN_ESA",

"password": "Vcf5@password",

"networkPoolName": "vcf-vi01-np01",

"vVolStorageProtocolType": "-- VMFS_FC/ISCSI/NFS --"

}

]

}选择“上载”,将 JSON 模板文件上传, JSON 文件中配置的主机会自动添加到待验证列表。

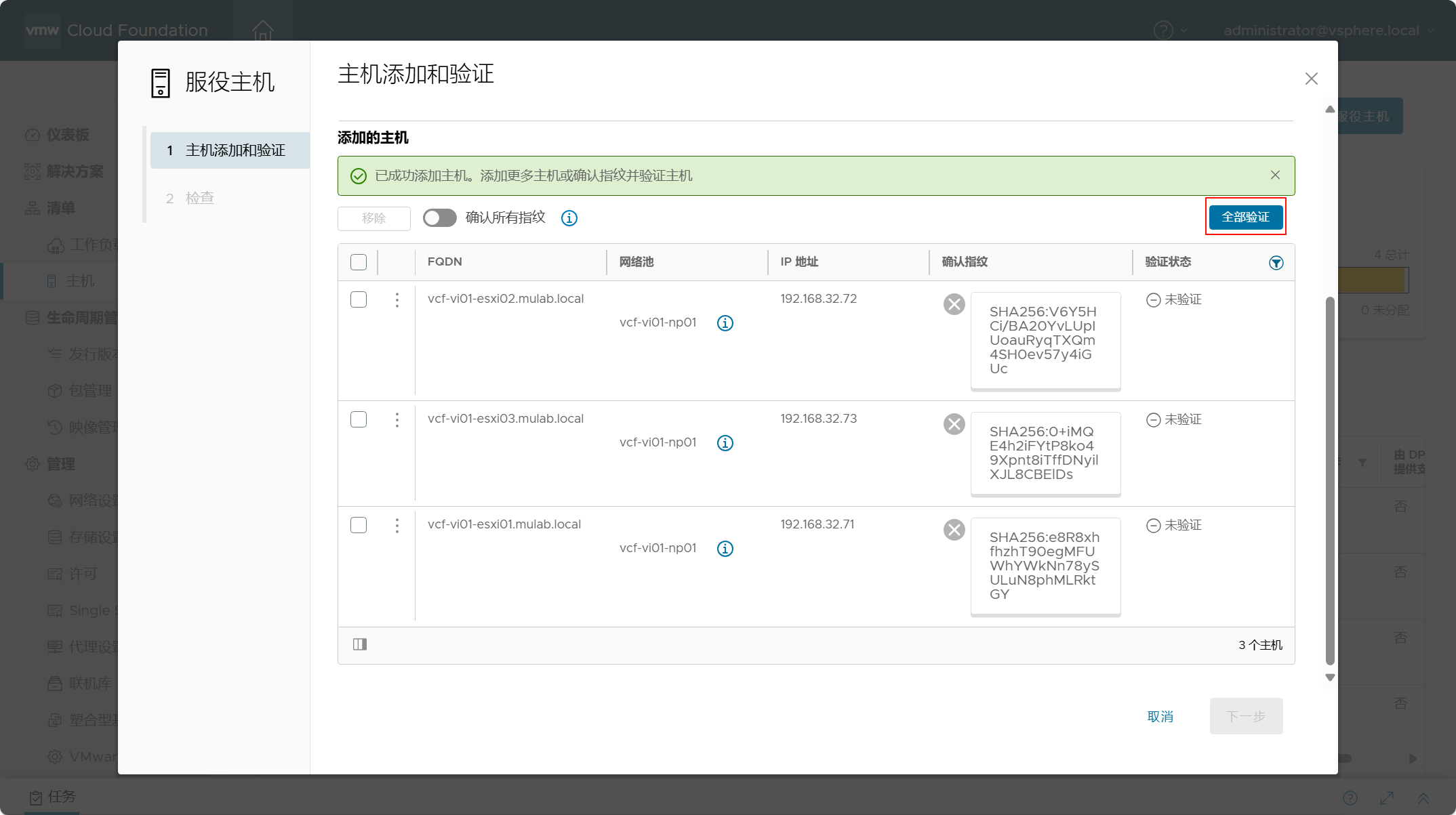

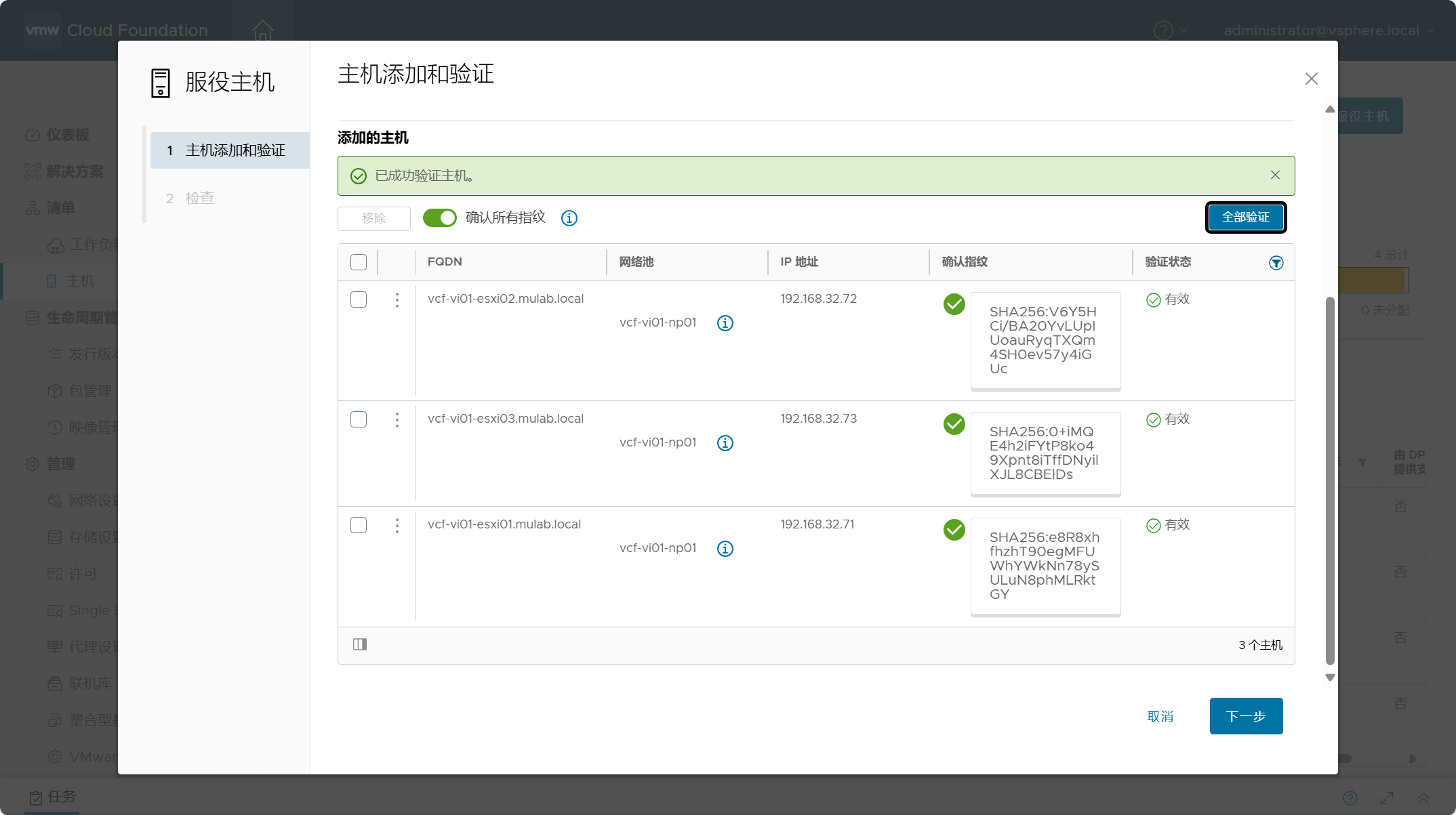

这时,确定配置信息正确,点击“全部验证”,确保所有主机可以验证。

已验证成功。如果有不成功的,请移除主机矫正后重新添加进来验证。

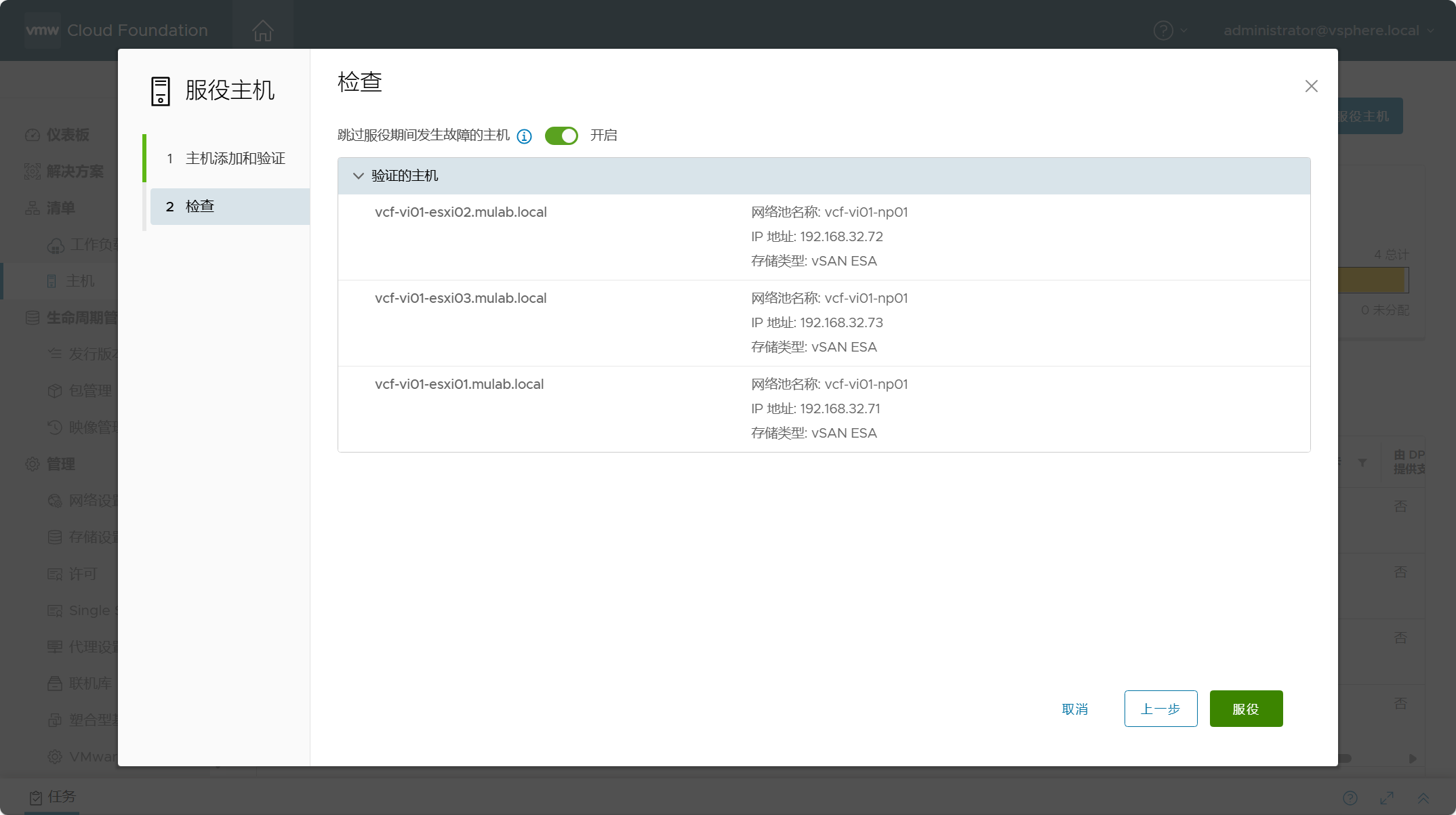

检查所有主机是否配置正确,点击“服役”,开始执行添加任务。

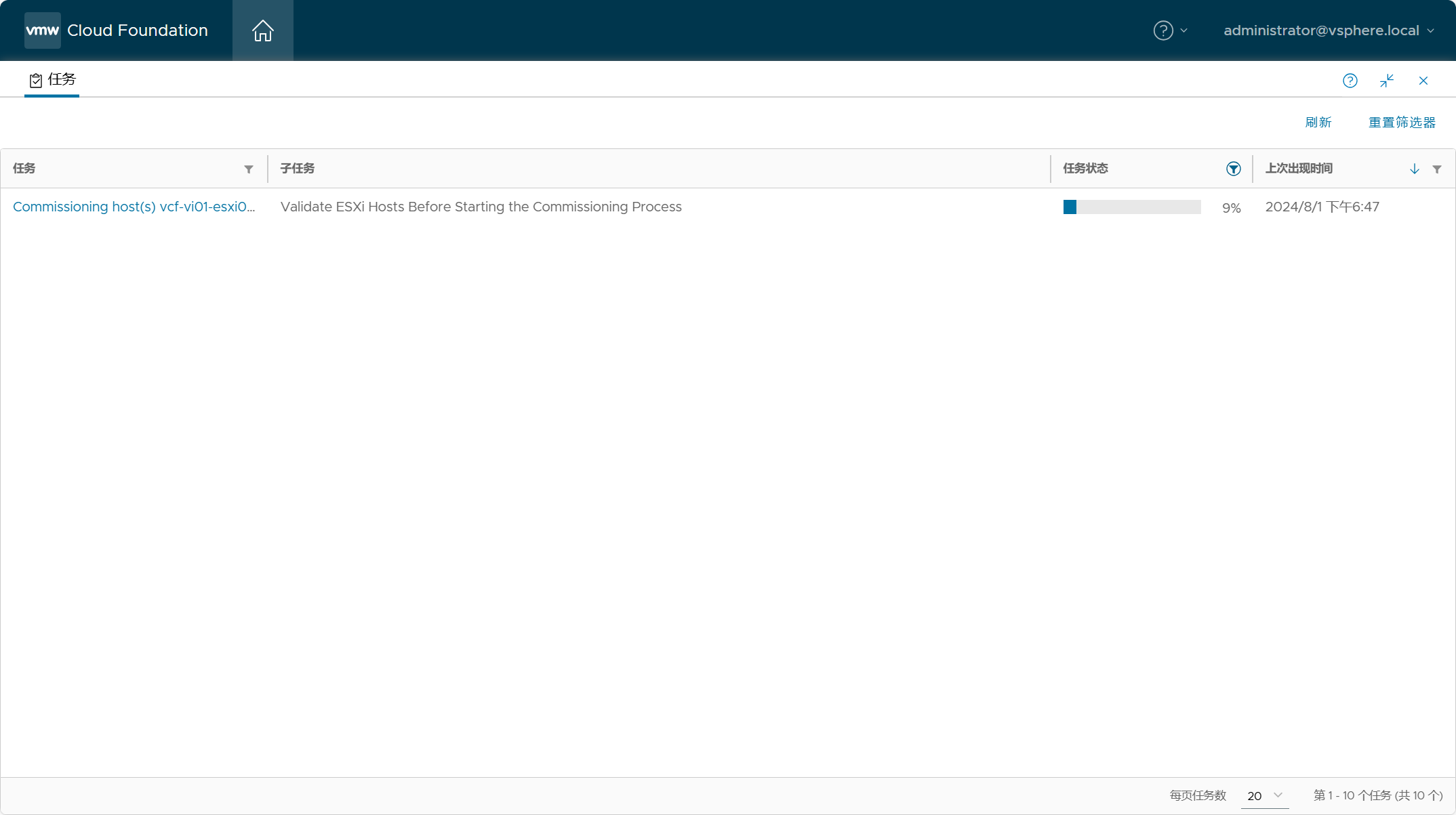

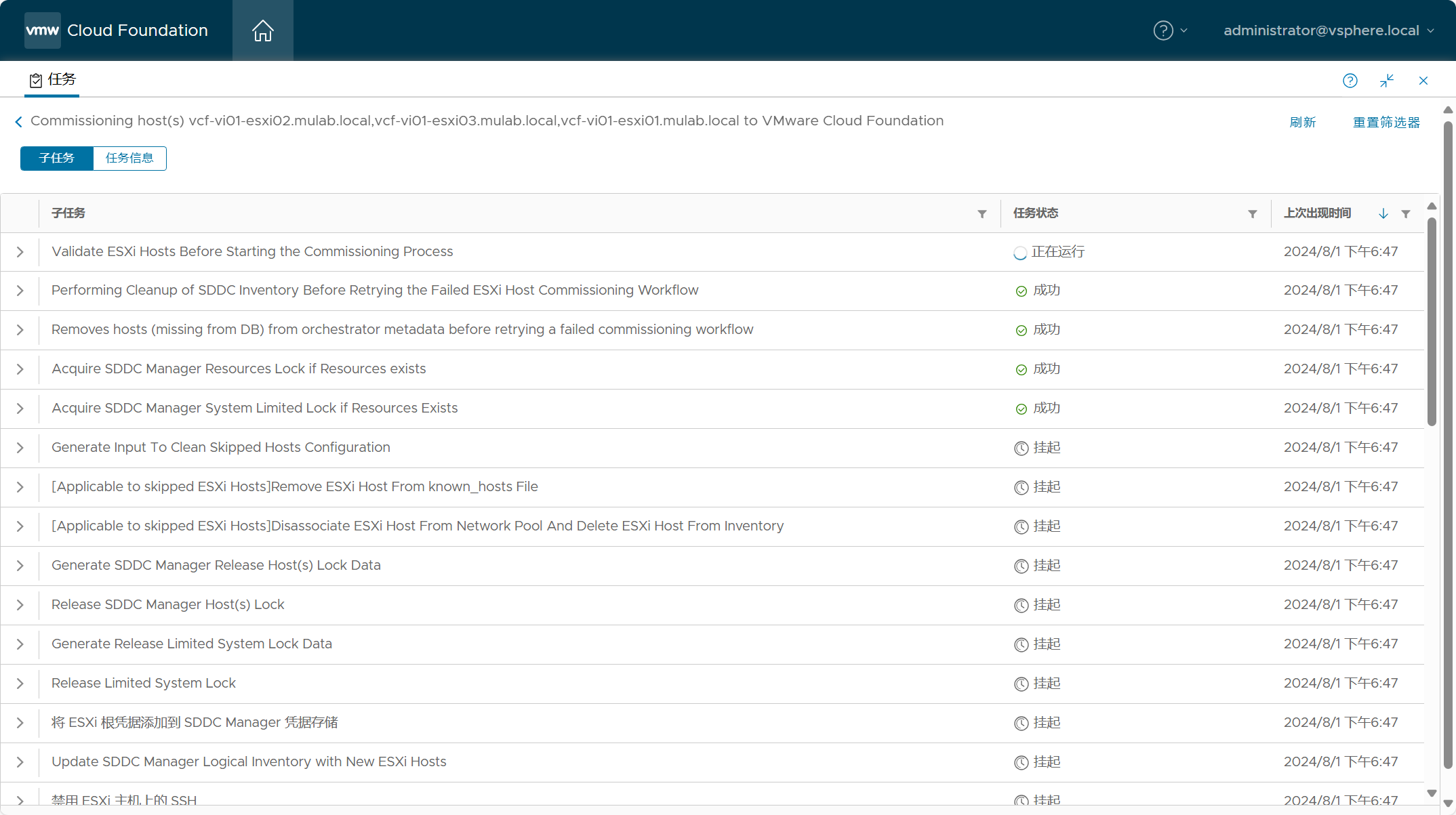

点击底部“任务”窗口,可以查看任务状态。

点击该任务进入子任务视图,可以查看具体执行任务的情况。

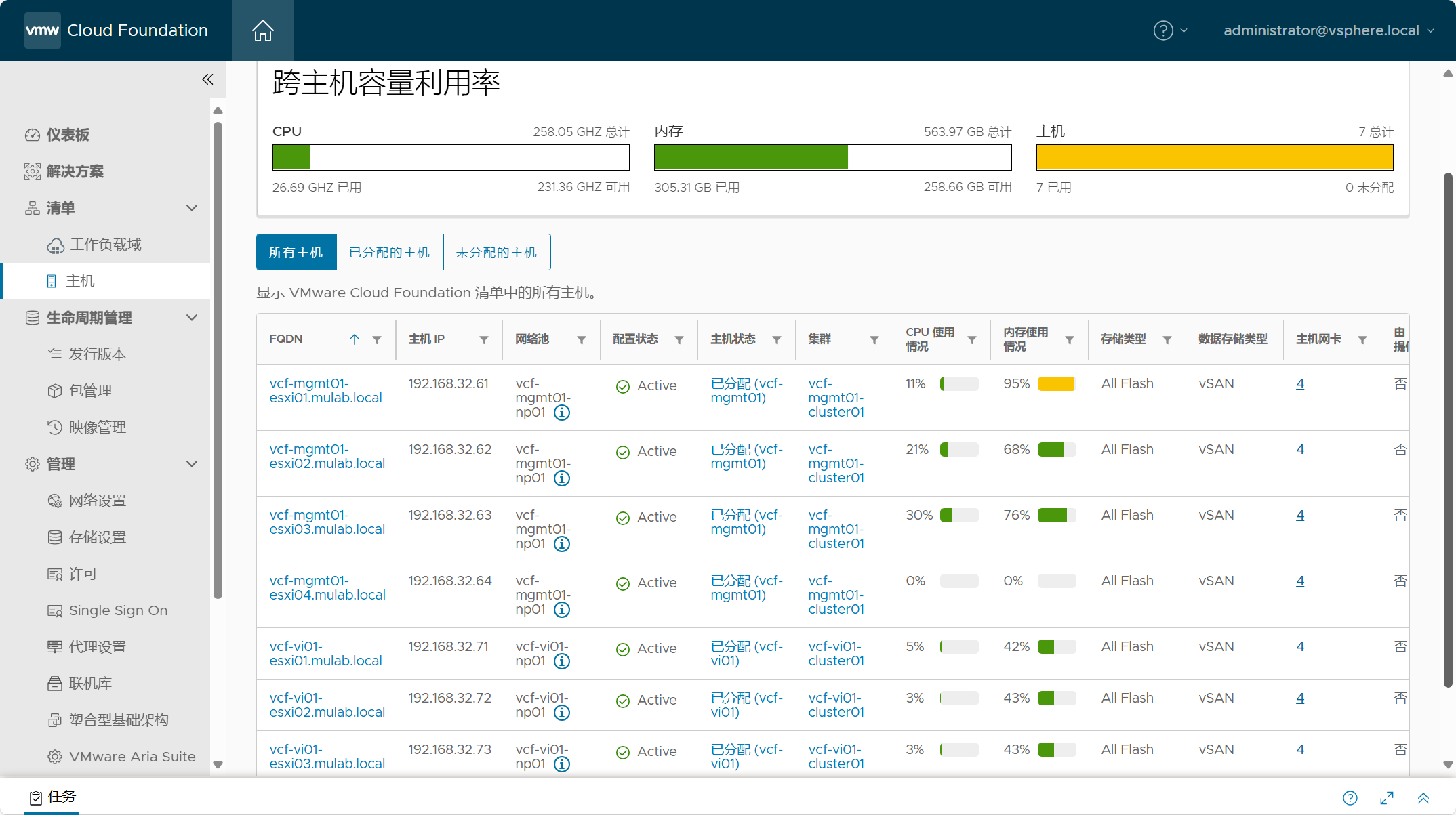

如果一切顺利,导航到 SDDC Manager->清单->主机->未分配主机,你应该能看到刚才添加的服役主机。

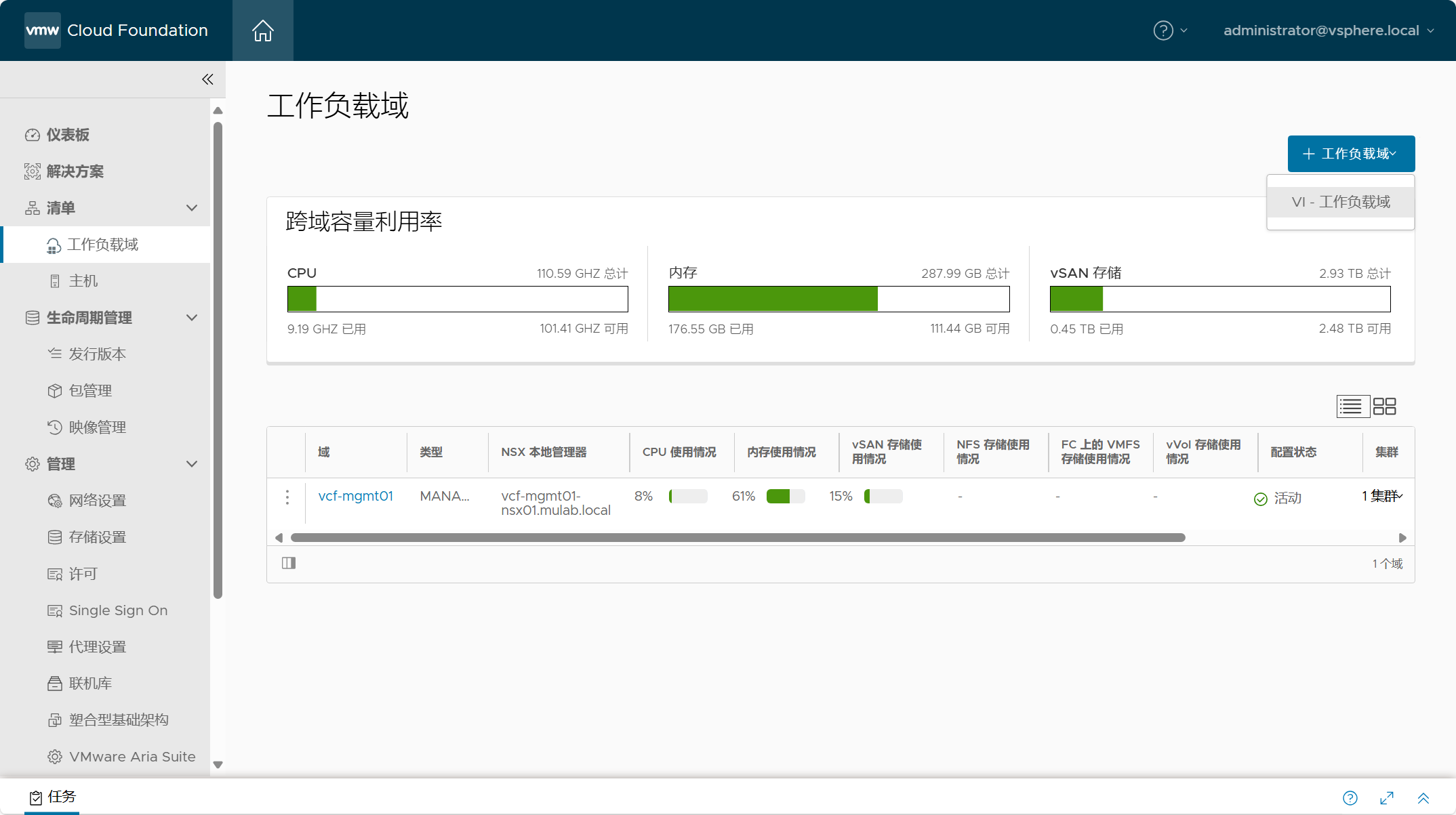

3)部署 VI 工作负载域

如果上面一切准备就绪后,现在可以正式执行 VI 工作负载域部署工作流。导航到 SDDC Manager->清单->工作负载域,点击“VI - 工作负载域”。

选择“vSAN”并勾选“启用 vSAN ESA”,点击开始。

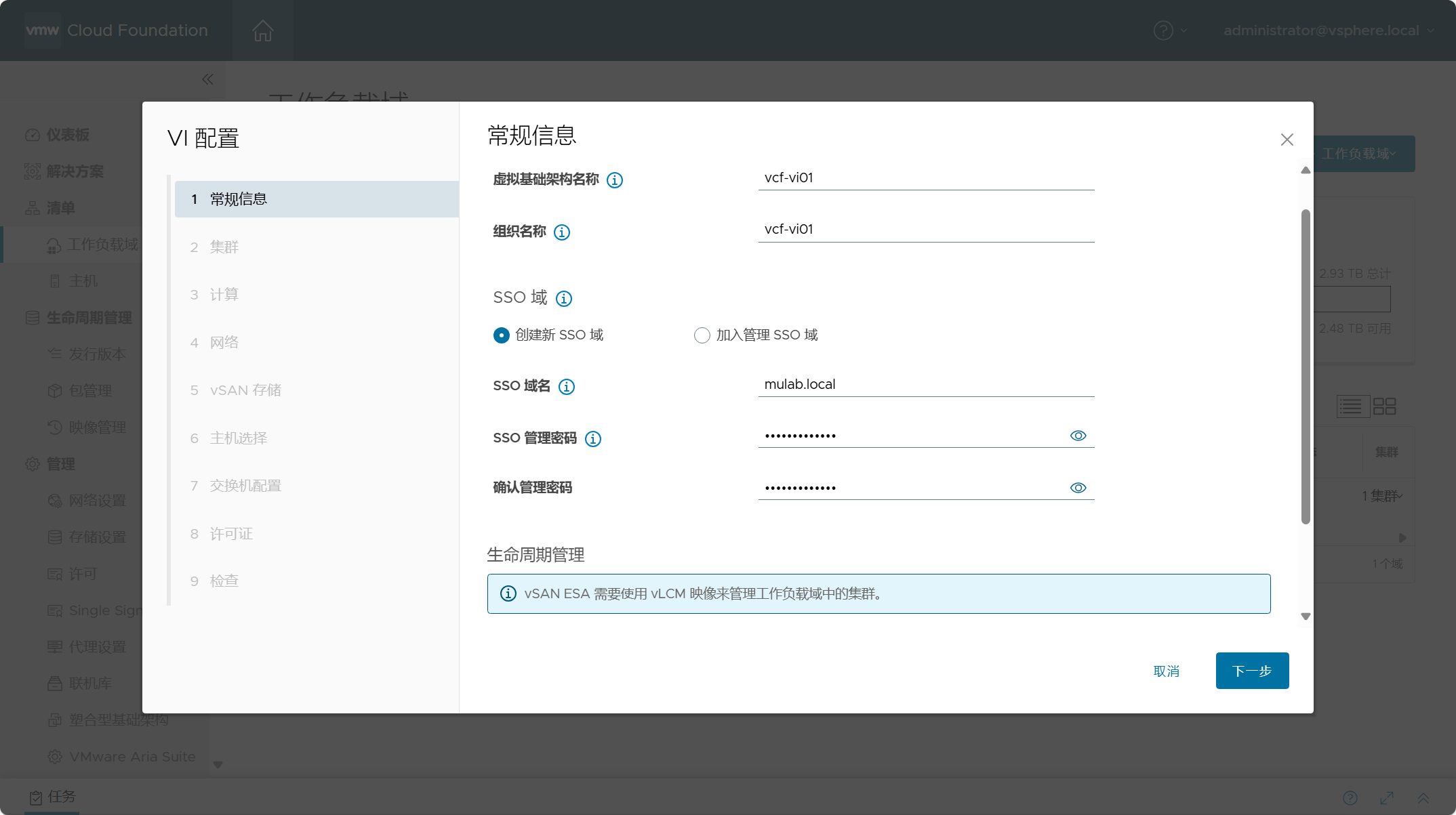

设置 VI 工作负载域的名称以及组织名称,并选择 VI 域的 SSO 域的方式。之前已经说过了区别,我这里就选择“创建新 SSO 域”选项。我个人觉得如果是使用 ELM 方式,可能会增加对于组件生命周期管理的复杂度,如果分开也许会更灵活一些。

注:VMware Cloud Foundation 5.0 开始,在部署新的 VI 工作负载域时,您才可以选择加入管理域 SSO 域或者创建新的 SSO 域。

配置独立的 SSO 域名以及 SSO 管理员的密码;因为选择 vSAN ESA,生命周期管理只能是基于 vLCM 映像,不可改。点击下一步。

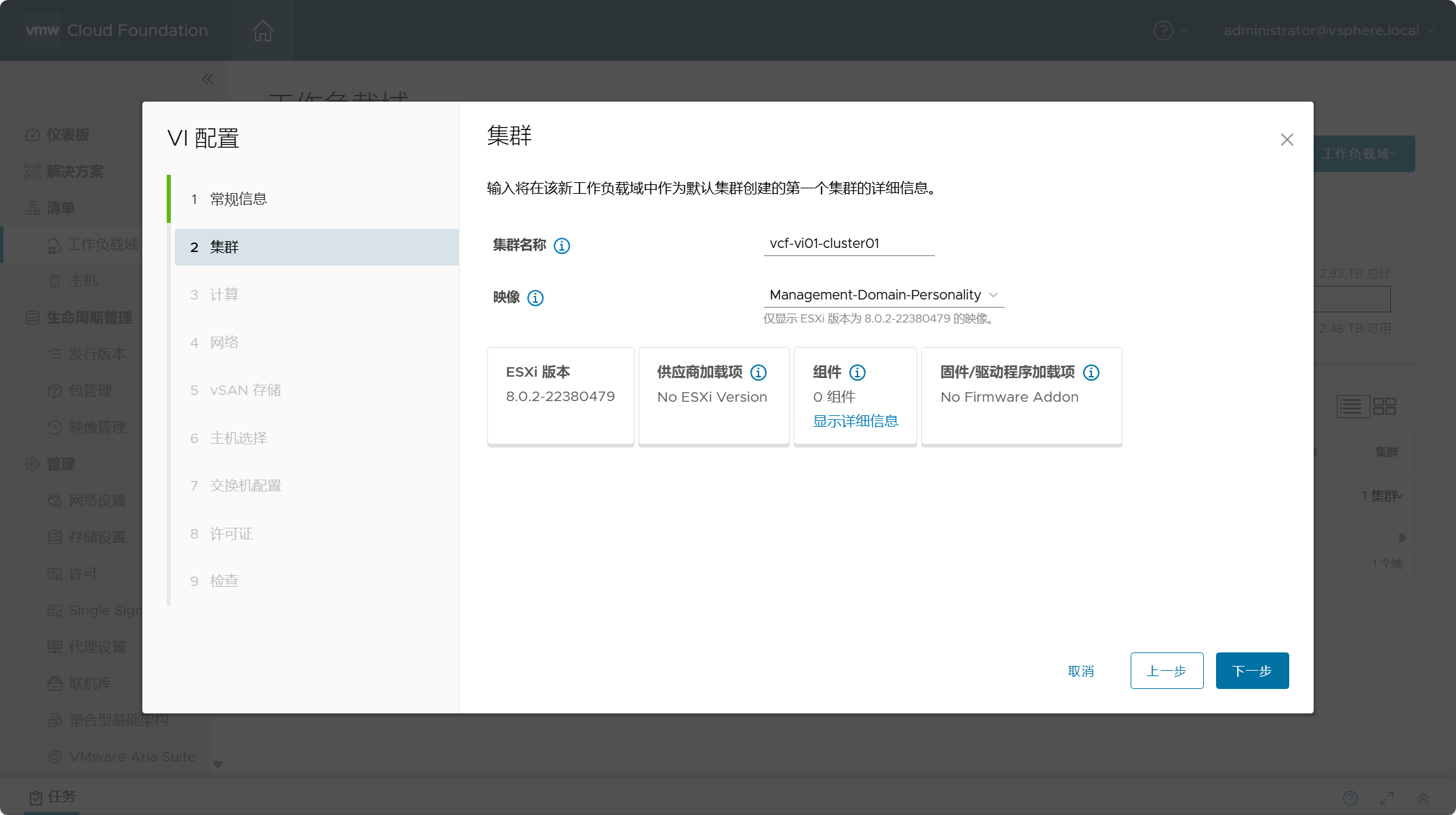

设置 VI 域中默认集群的名称,并选择集群的映像,这里就选择管理域所提取的映像。

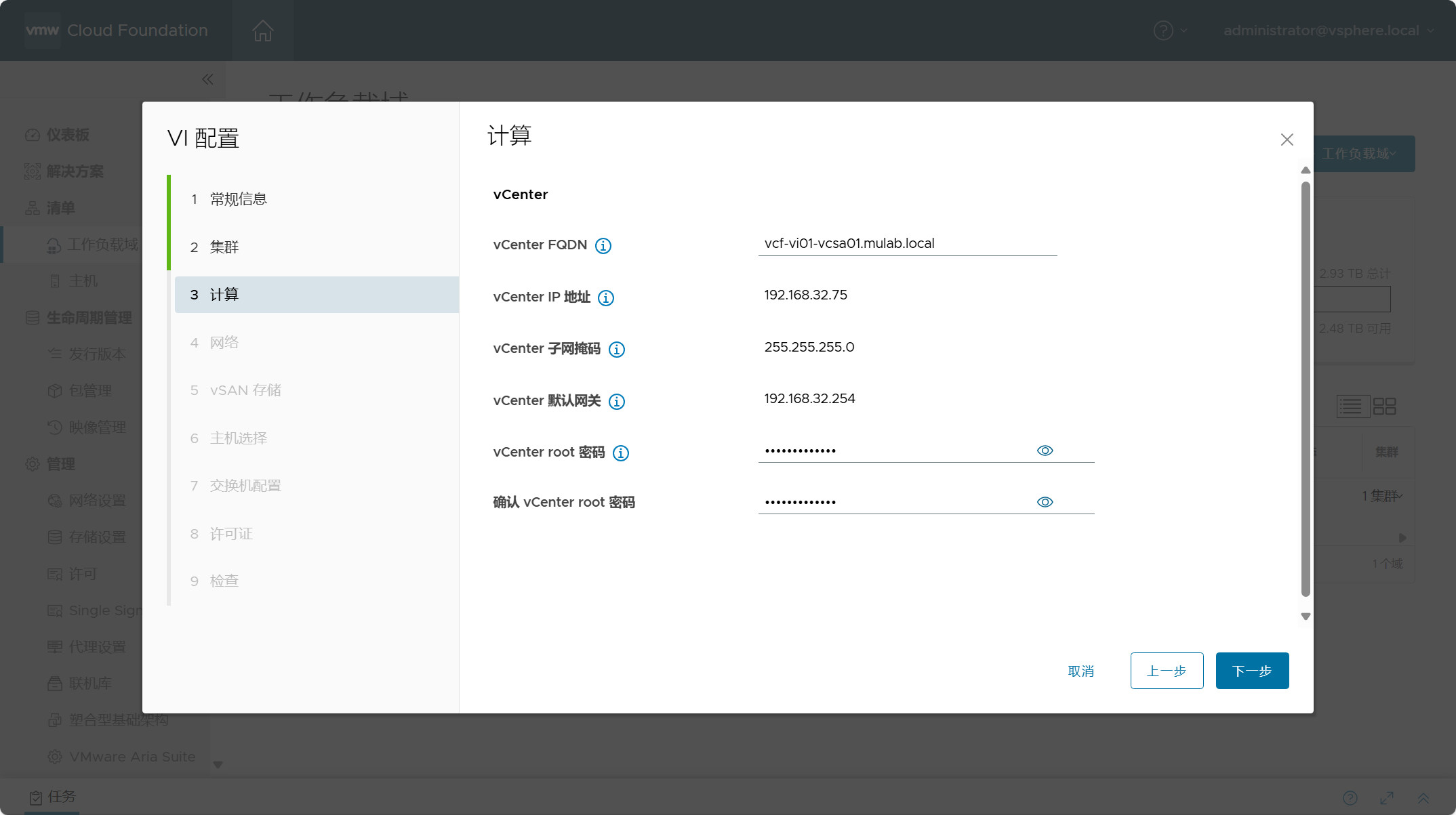

配置 vCenter Server 组件的地址信息,输入 FQDN 后会自动填充 IP 地址信息,设置 vCenter Server 的 root 密码。点击下一步。

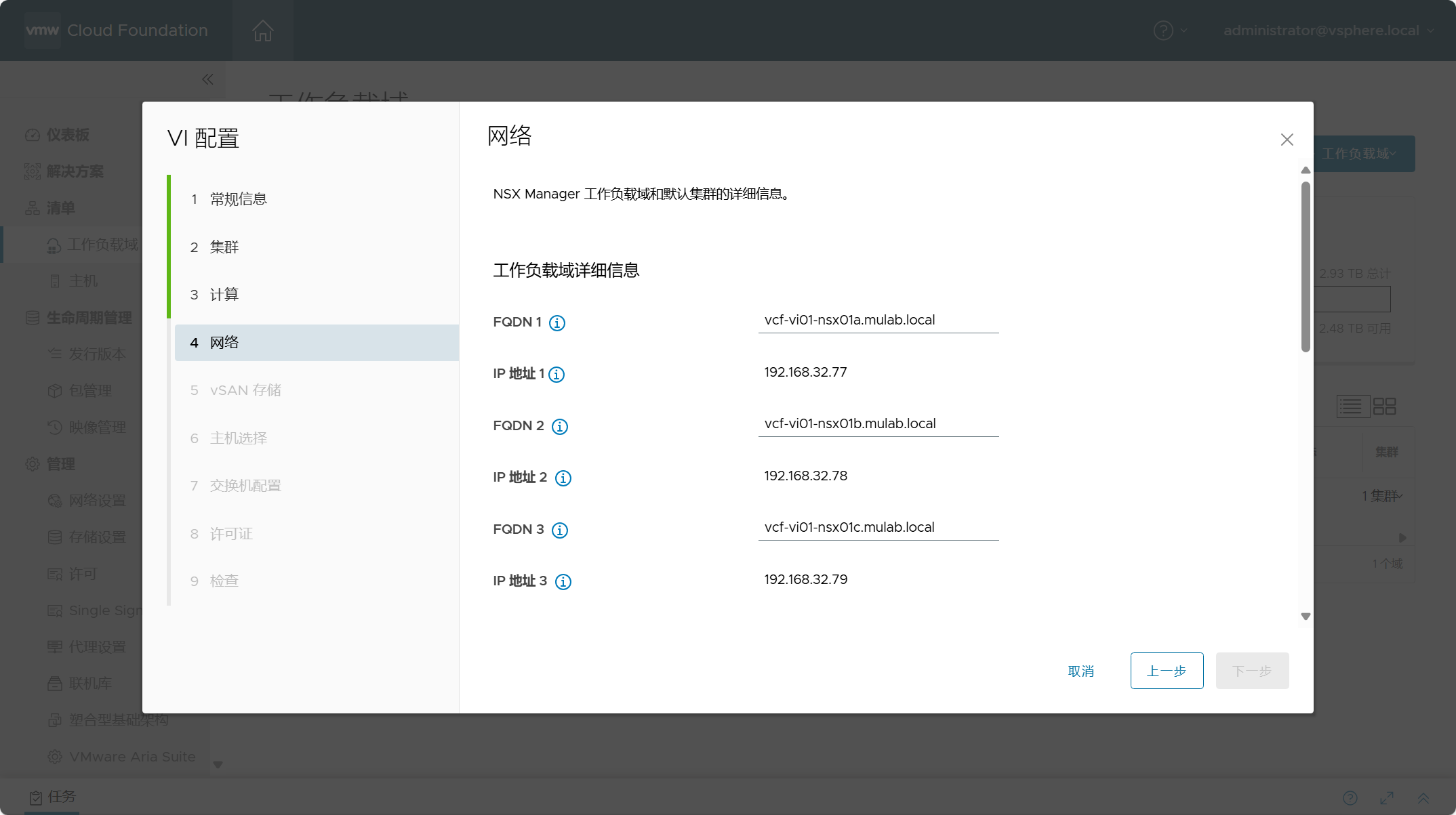

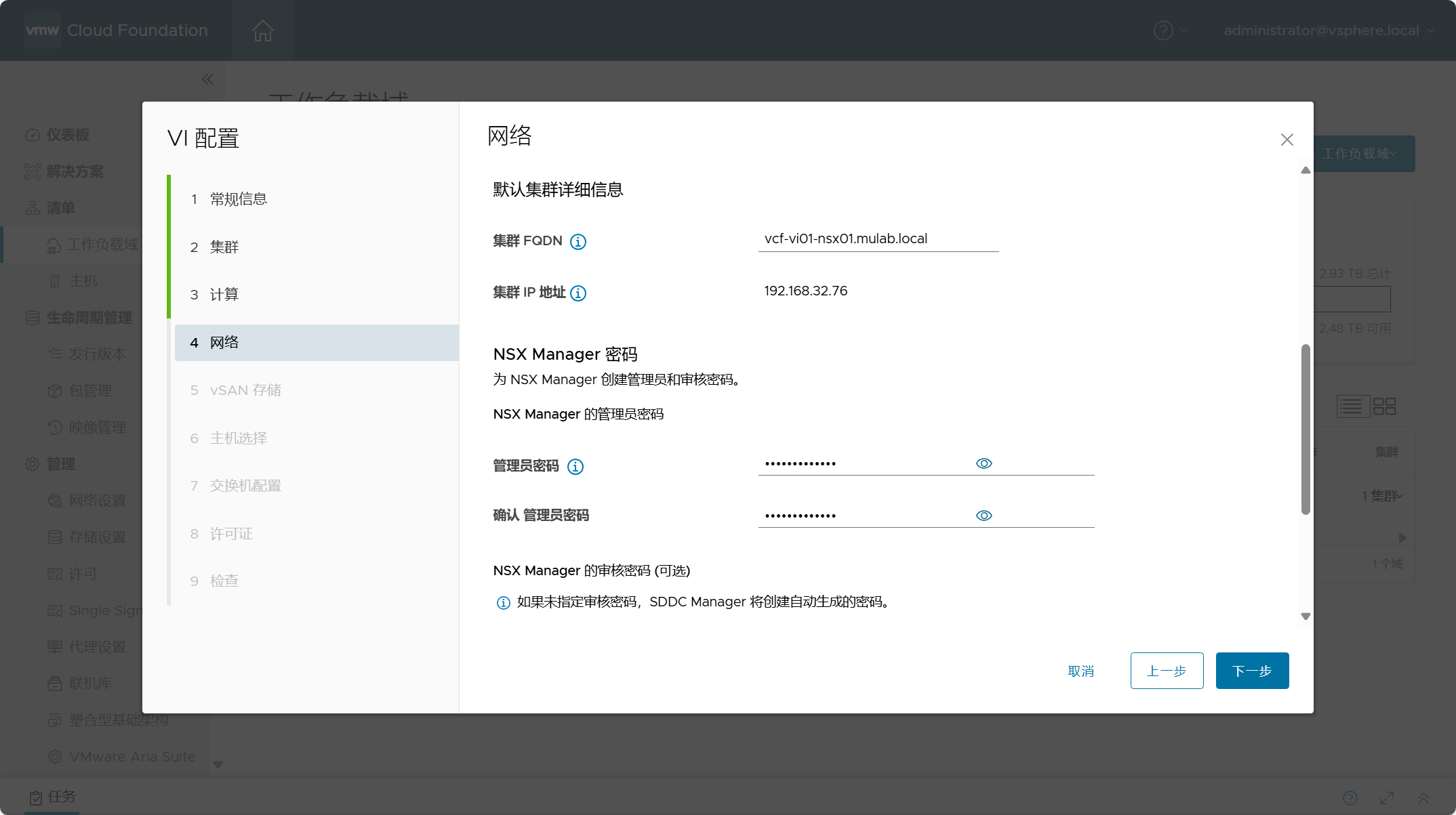

配置 NSX Manager 组件的地址信息,输入 FQDN 后会自动填充 IP 地址信息,设置 NSX Manager 的管理员(admin)密码。因为之前在配置文件里已经配置了只部署 1 个节点,但是这里的信息都是必填项所以还是要填,后面在部署中只会部署一个 NSX Manager 节点,点击下一步。

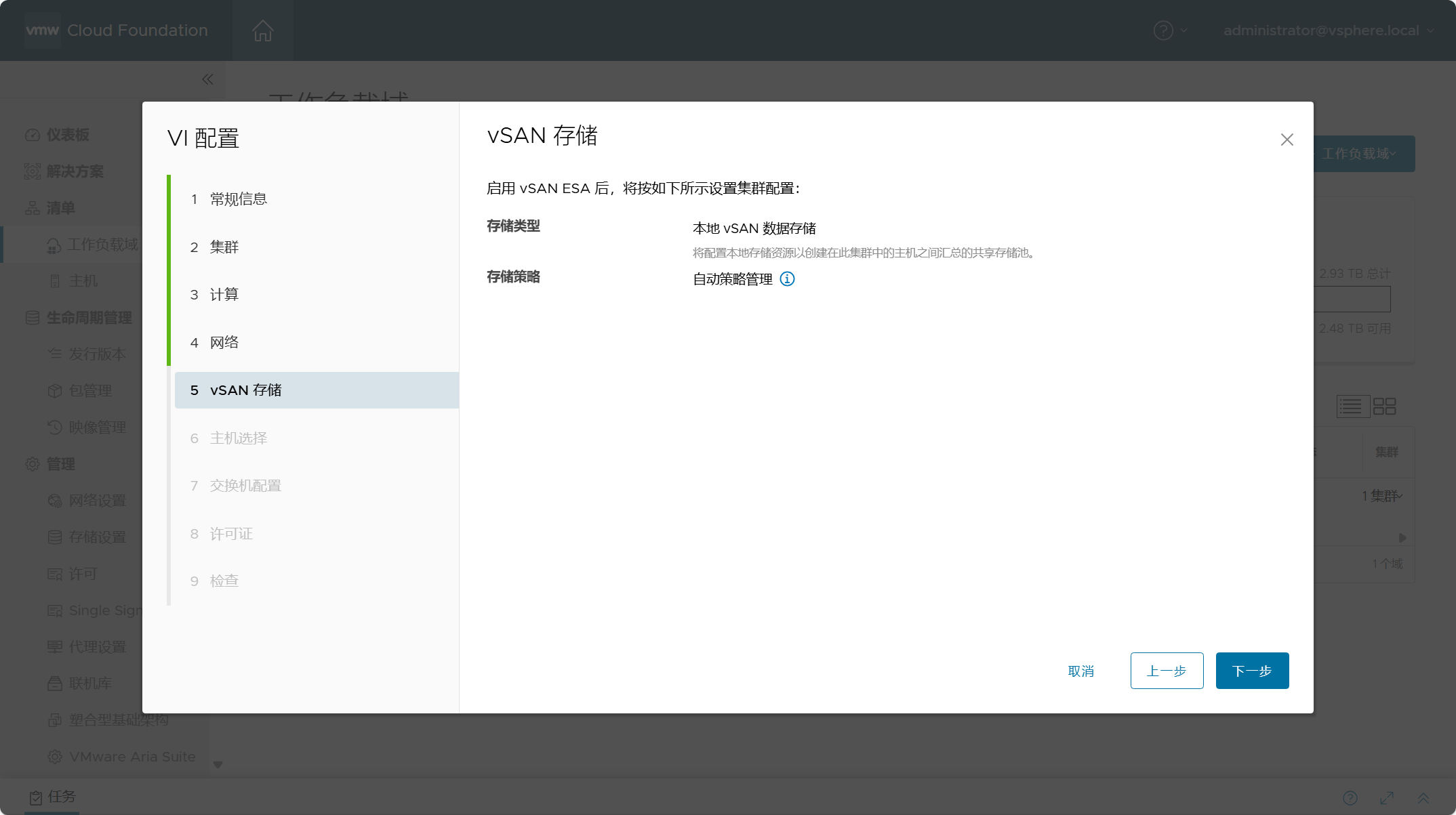

启用 vSAN ESA 架构,默认将使用自动策略管理,vSAN 将根据集群中的主机数量,自动配置默认存储策略。

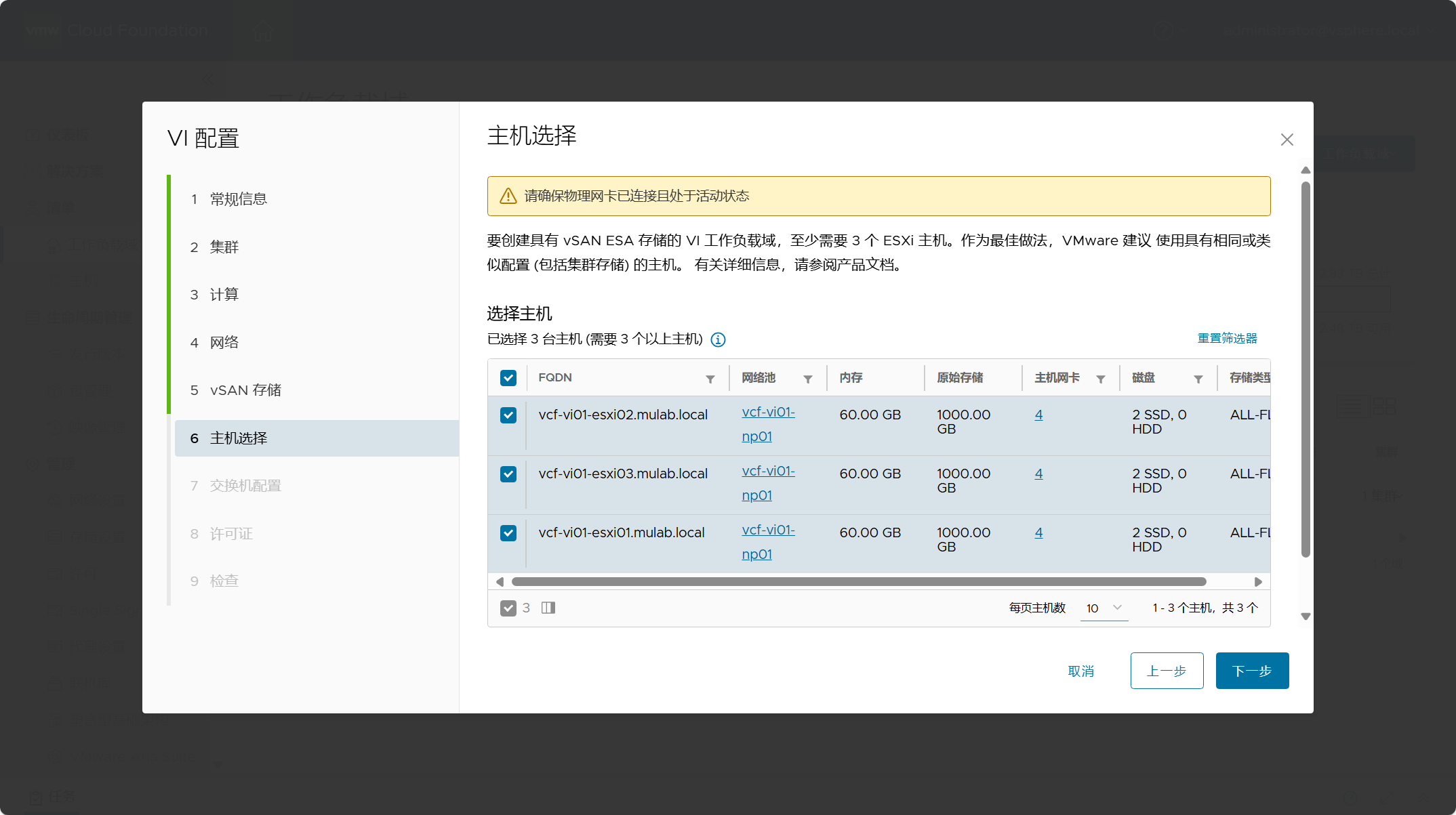

选择用于部署 VI 工作负载域的 ESXi 主机。可以看到,部署 vSAN ESA 架构至少需要 3 个以上主机。

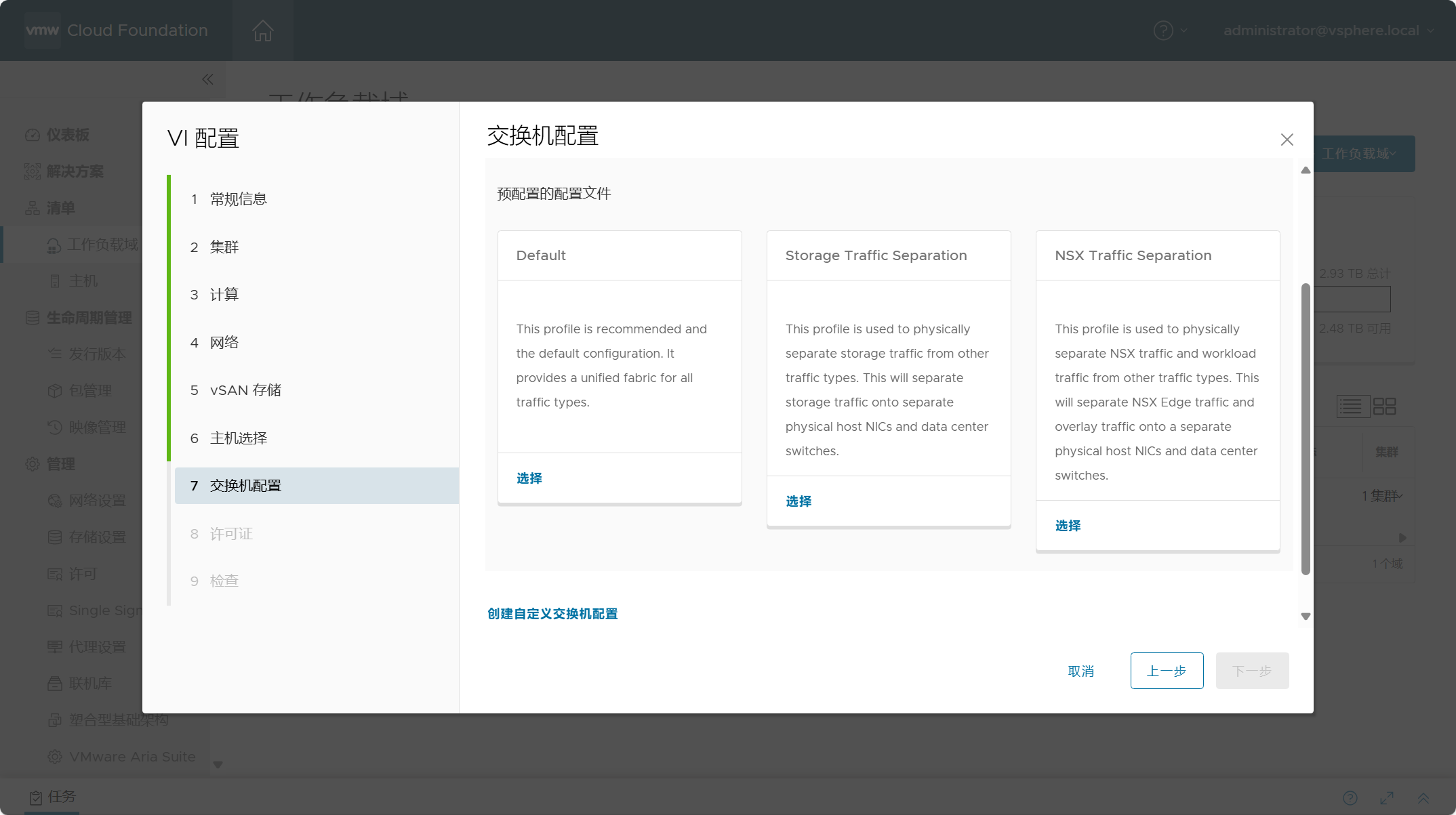

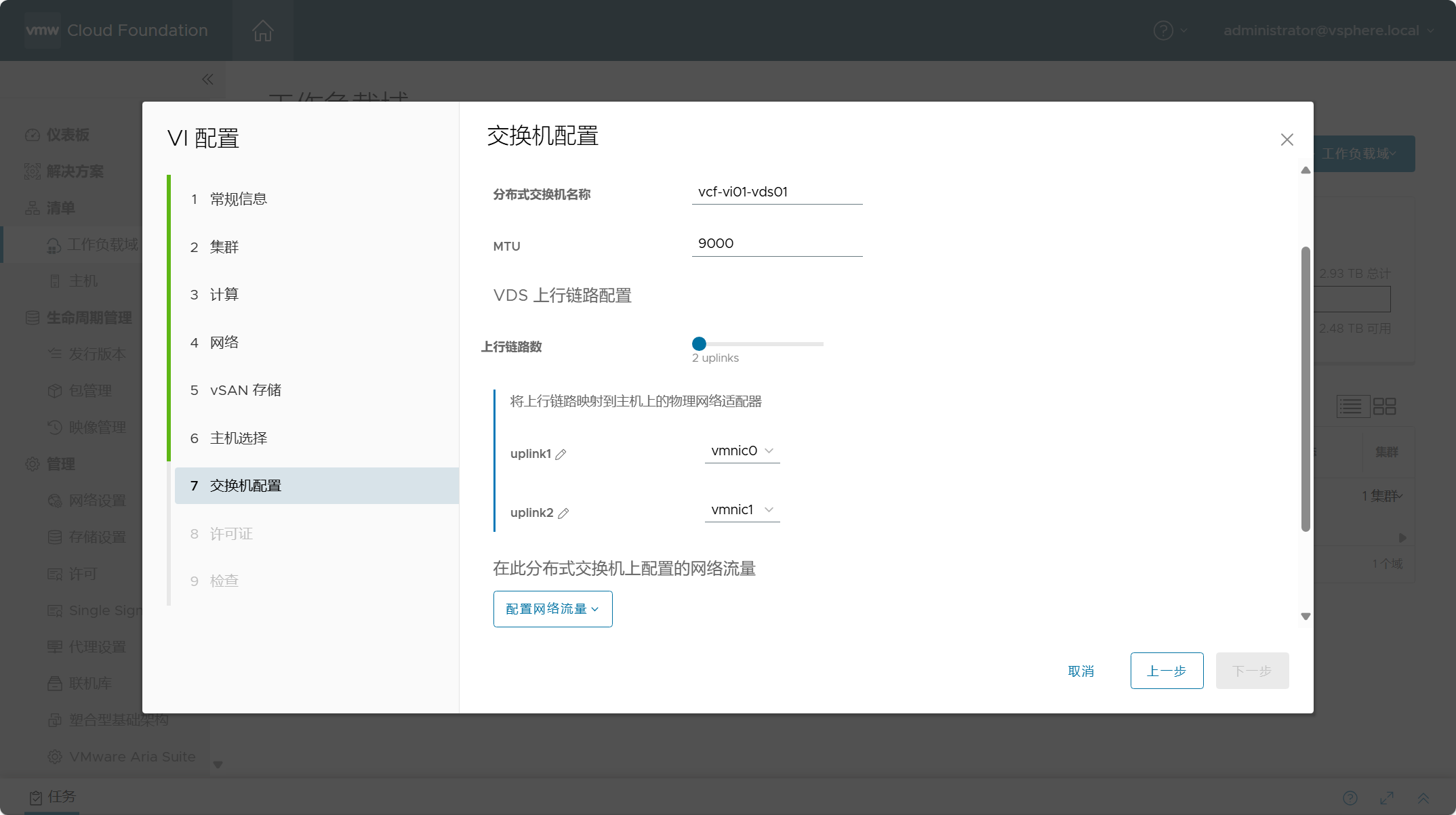

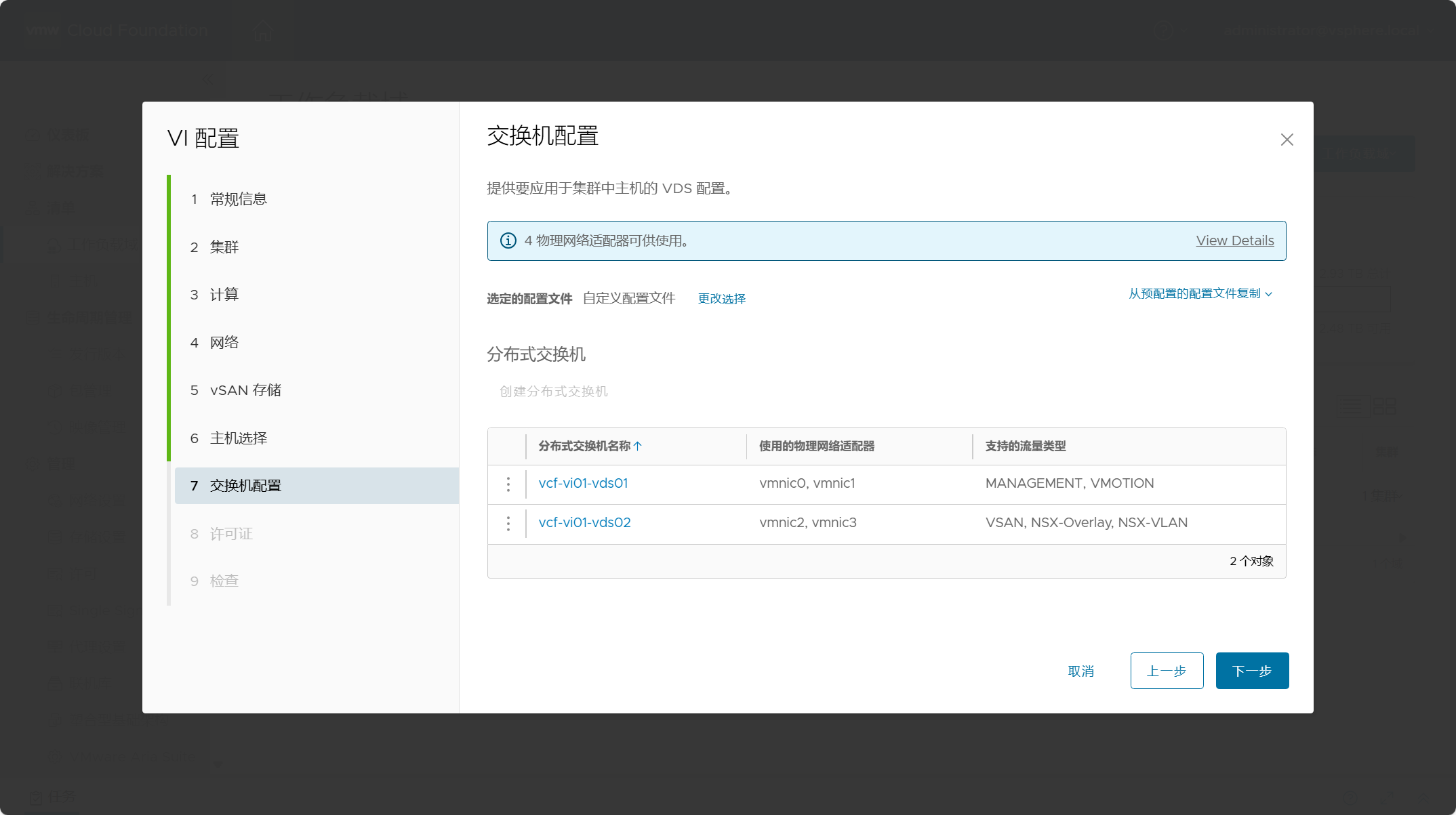

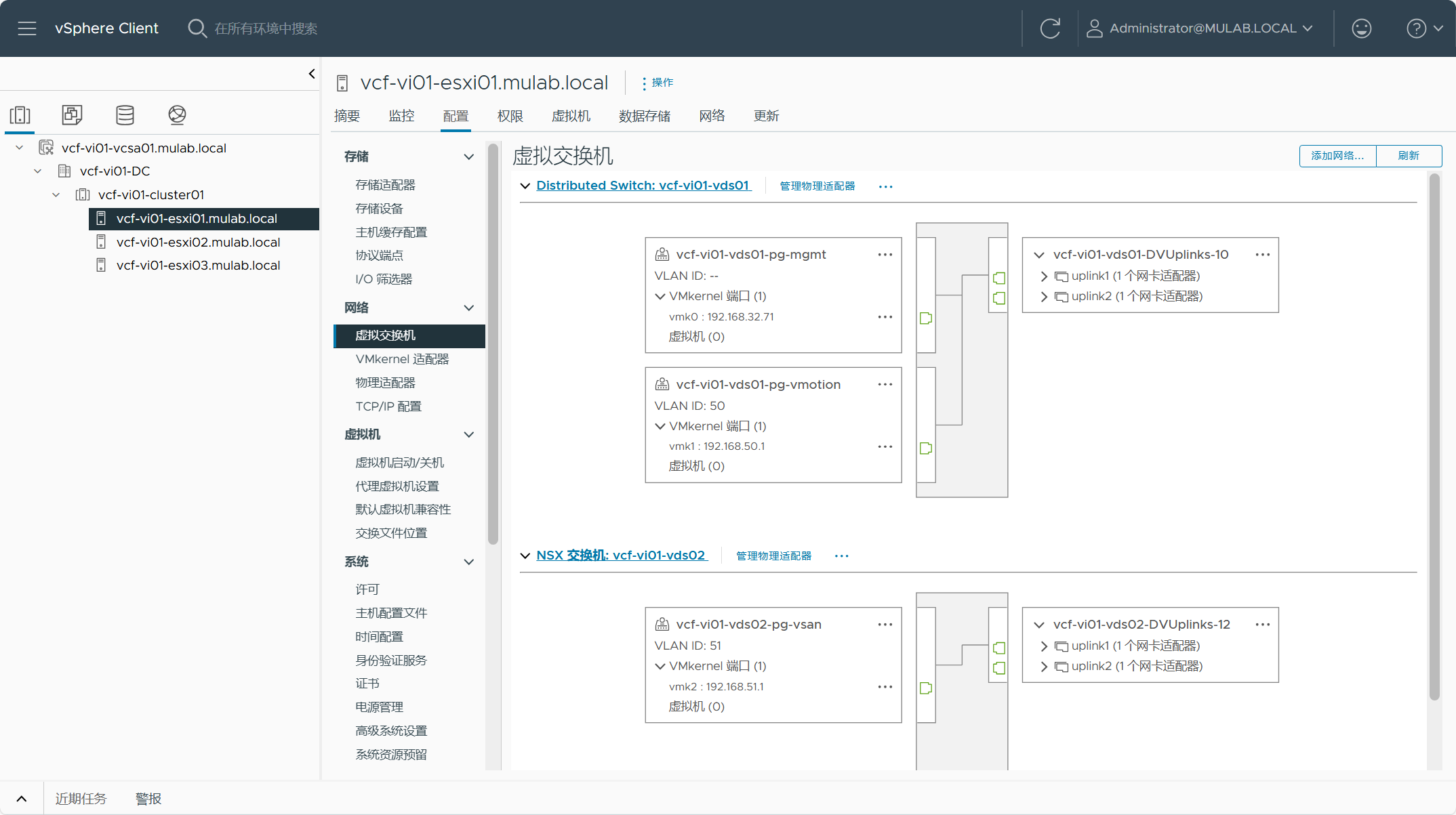

VI 工作负载域默认集群的虚拟机交换机配置。默认提供三个预配置文件,分别是 Default、Storage Traffic Separation 以及 NSX Traffic Separation。Default 配置文件的意思是将所有网络类型(Management、vMotion、vSAN、NSX)的流量都跑在同一分布式交换机上面;Storage Traffic Separation 配置文件的意思是将 vSAN 网络类型的流量单独放在一个分布式交换机上面,其他网络类型的流量放在另一个分布式交换机上面;NSX Traffic Separation 配置文件的意思是将 NSX 网络类型的流量单独放在一个分布式交换机上面,其他网络类型的流量放在另一个分布式交换机上面。这是不是跟之前部署管理域时选择 Excel 参数表中的 Profile-1、Profile-2 以及 Profile-3 配置文件一模一样?!这里的意思也是同理。还可以选择“创建自定义交换机配置”,自行配置网卡网络类型的分配,我这边就选择自定义了,创建与之前管理域一样的分配。

点击“创建自定义交换机配置”,我们可以手动创建分布式交换机并配置网络类型,点击“创建分布式交换机”。

创建第一个分布式交换机,设置交换机的名称、MTU和上行链路端口。准备将这个交换机用于管理和 vMotion 网络,点击“配置网络流量”。

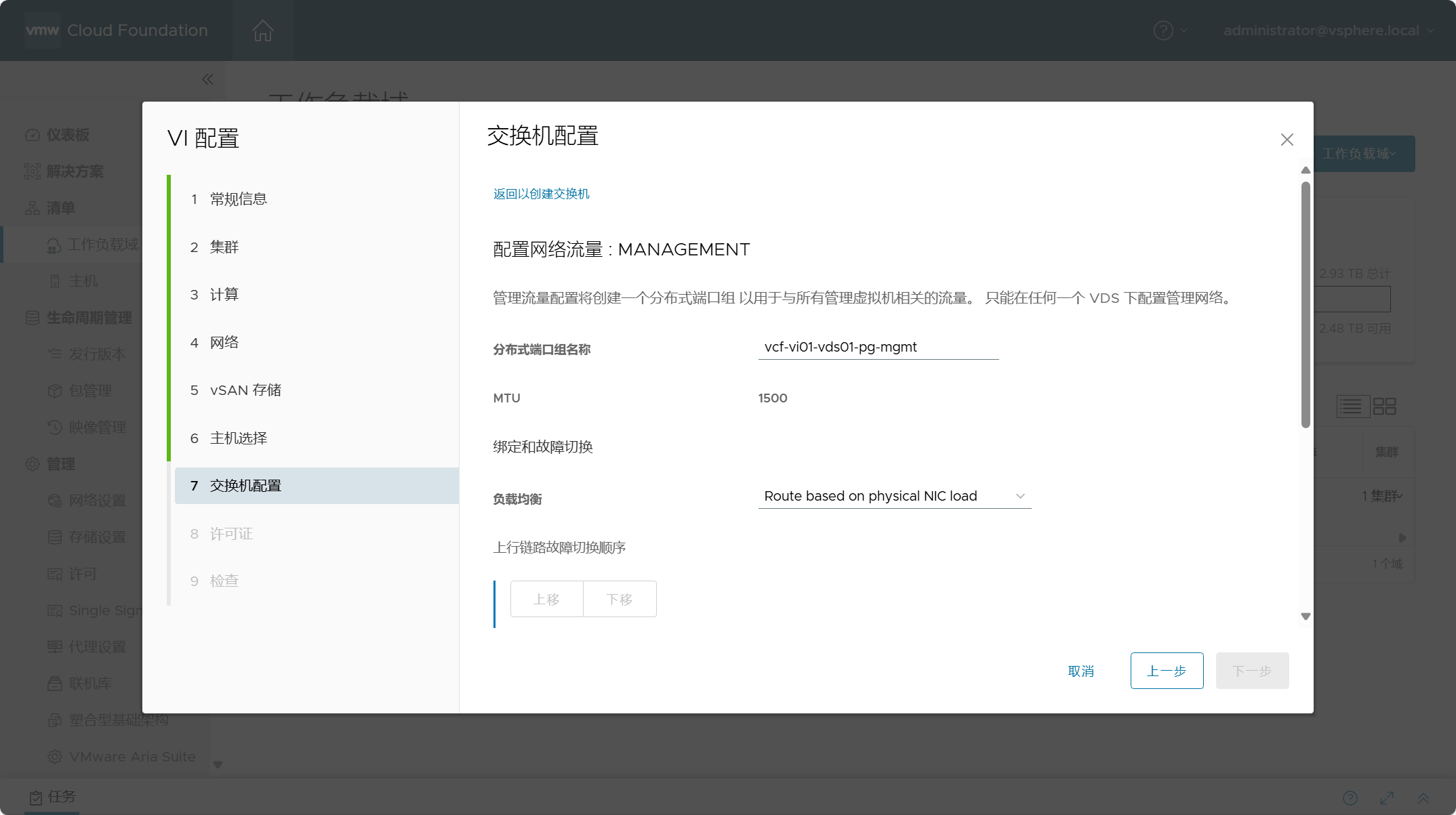

选择“Management”网络流量,配置分布式端口组的名称,设置绑定和故障切换负载均衡方式,其他默认即可。

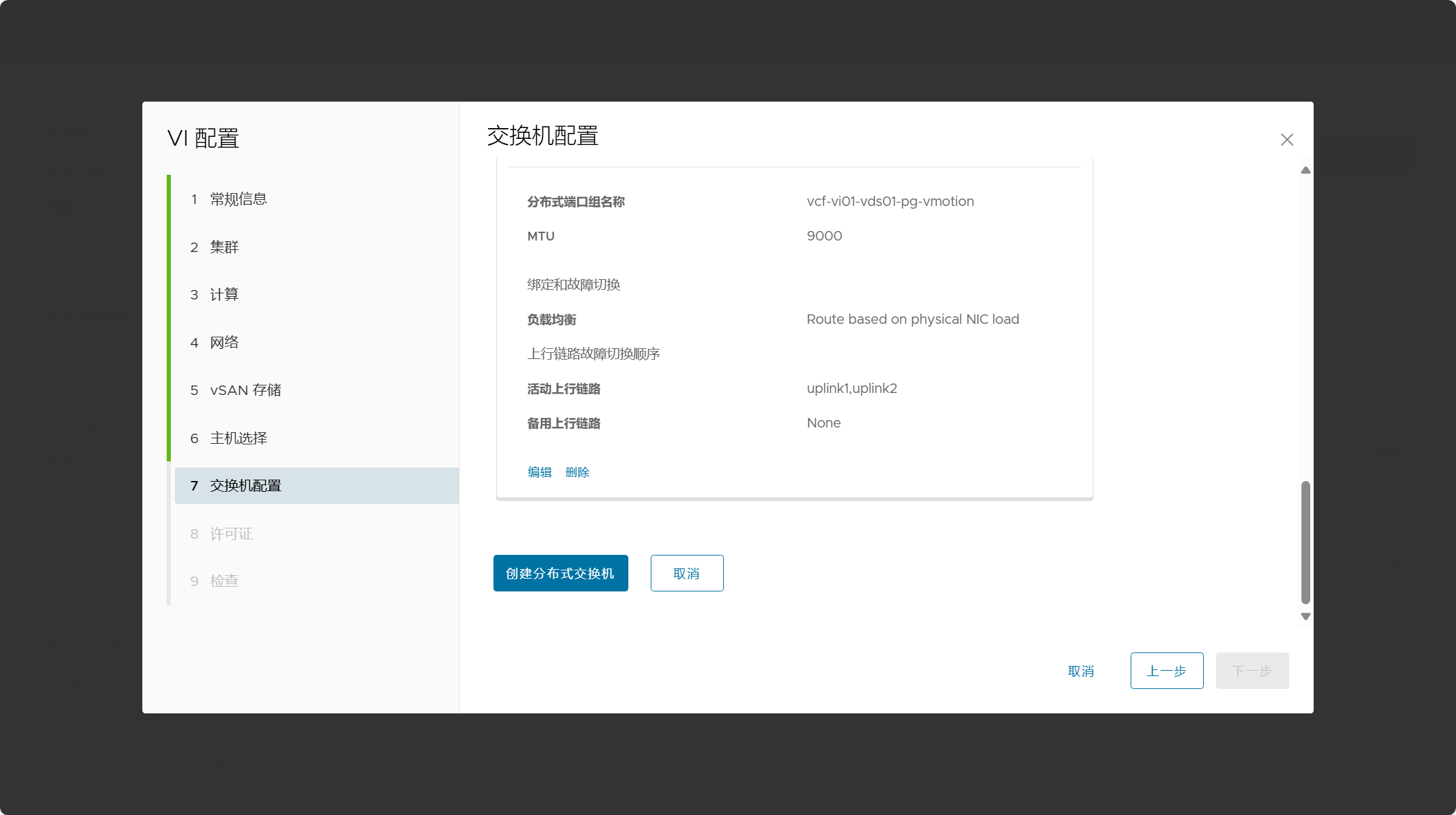

选择“vMotion”网络流量,配置分布式端口组的名称,设置绑定和故障切换负载均衡方式,其他默认即可。

配置好后,点击“创建分布式交换机”。

现在已完成一个分布式交换机的配置,还需要创建另外一个分布式交换机。

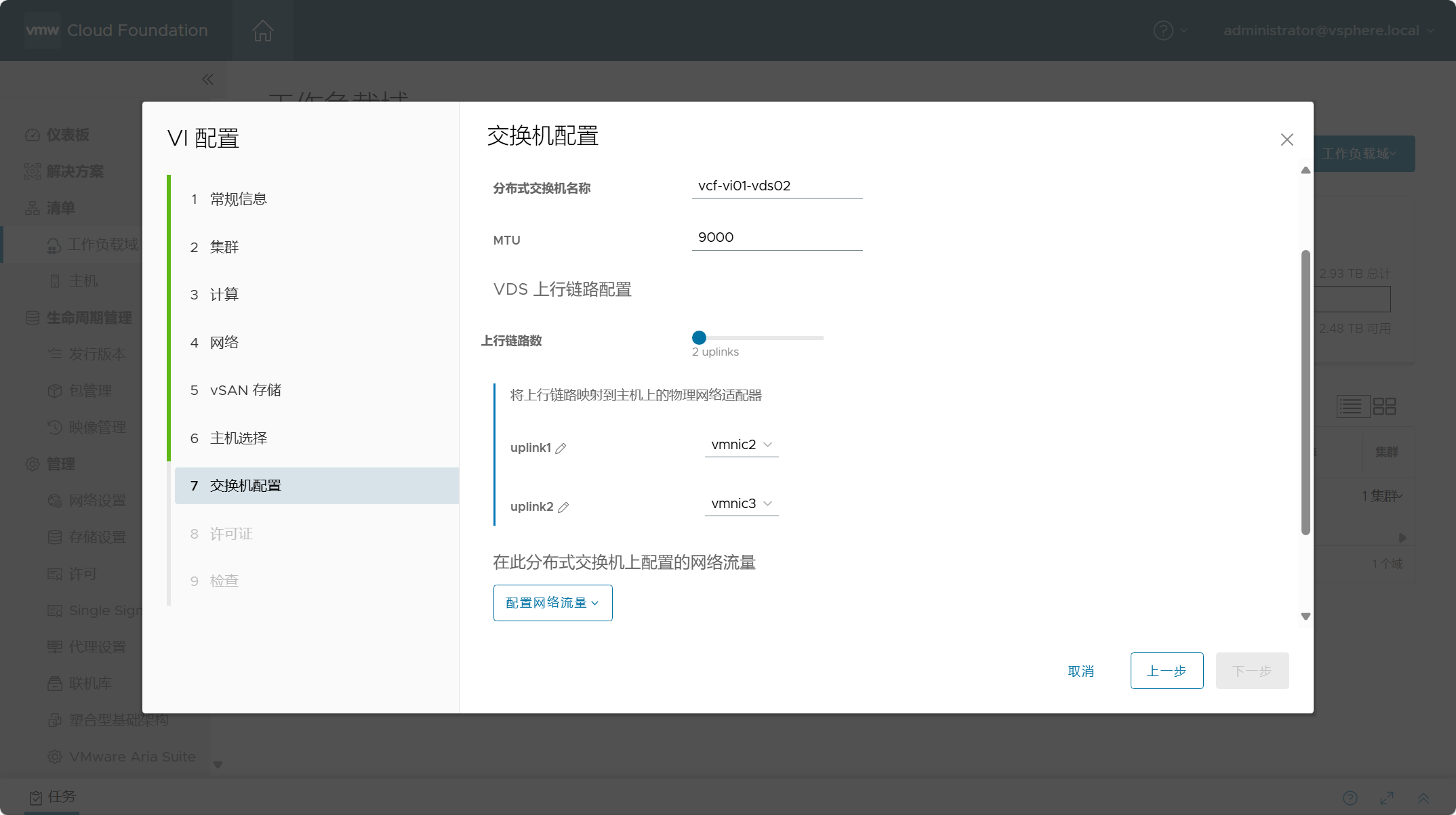

创建第二个分布式交换机,设置交换机的名称、MTU和上行链路端口。准备将这个交换机用于 vSAN 和 NSX 网络,点击“配置网络流量”。

选择“vSAN”网络流量,配置分布式端口组的名称,设置绑定和故障切换负载均衡方式,其他默认即可。

选择“NSX”网络流量,操作模式选择标准,如果有 DPU 设备,则需要选择增强型数据路径;传输区域类型包含 Overlay 网络和 VLAN 网络;设置覆盖网络传输区域的名称。

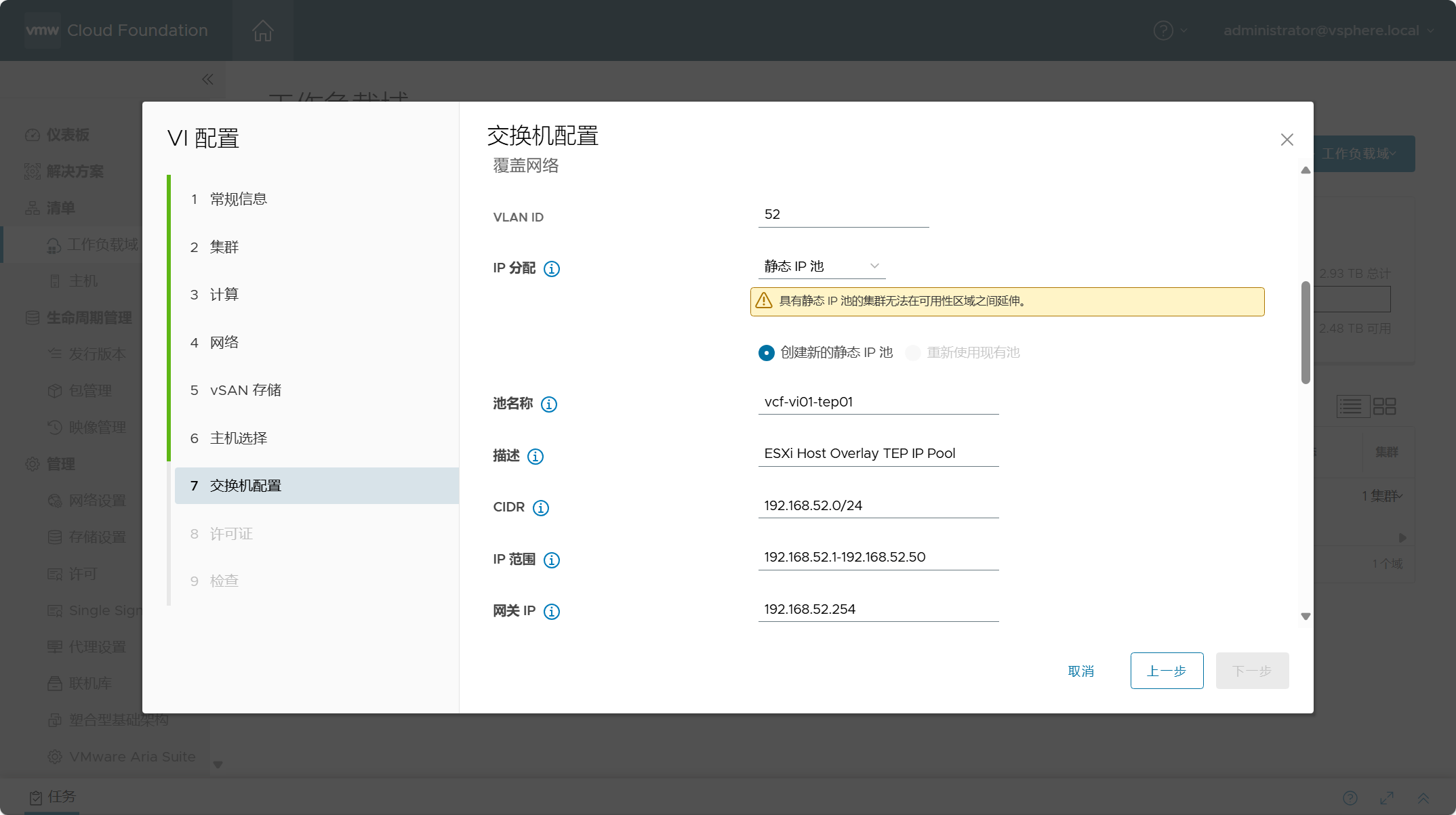

设置 NSX Overlay 网络的 VLAN 以及 TEP 地址池。

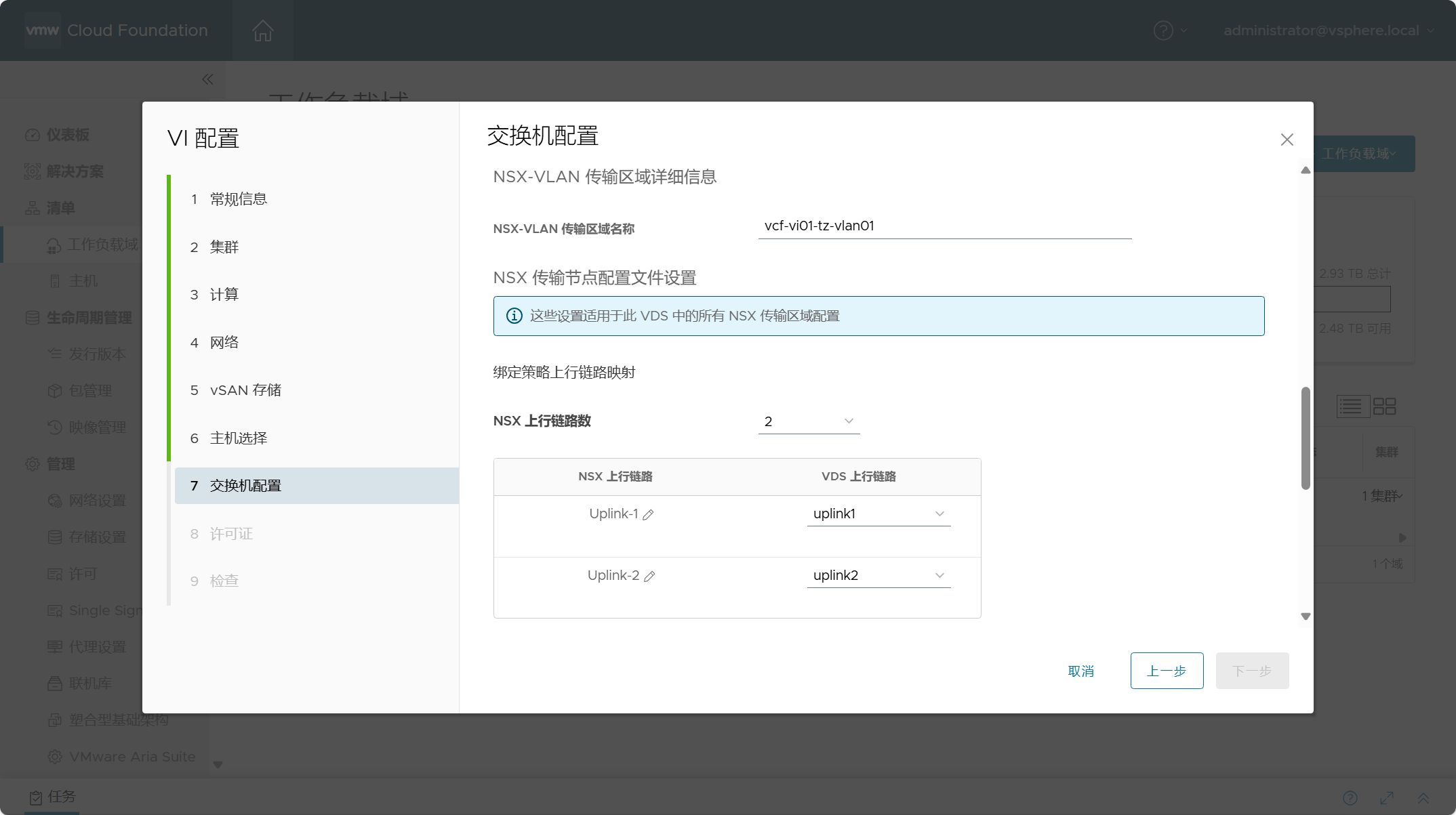

设置 NSX VLAN 传输区域的名称,传输节点配置文件的上行链路为 2,根据 ESXi 主机分配给 NSX 网络的端口数而定。

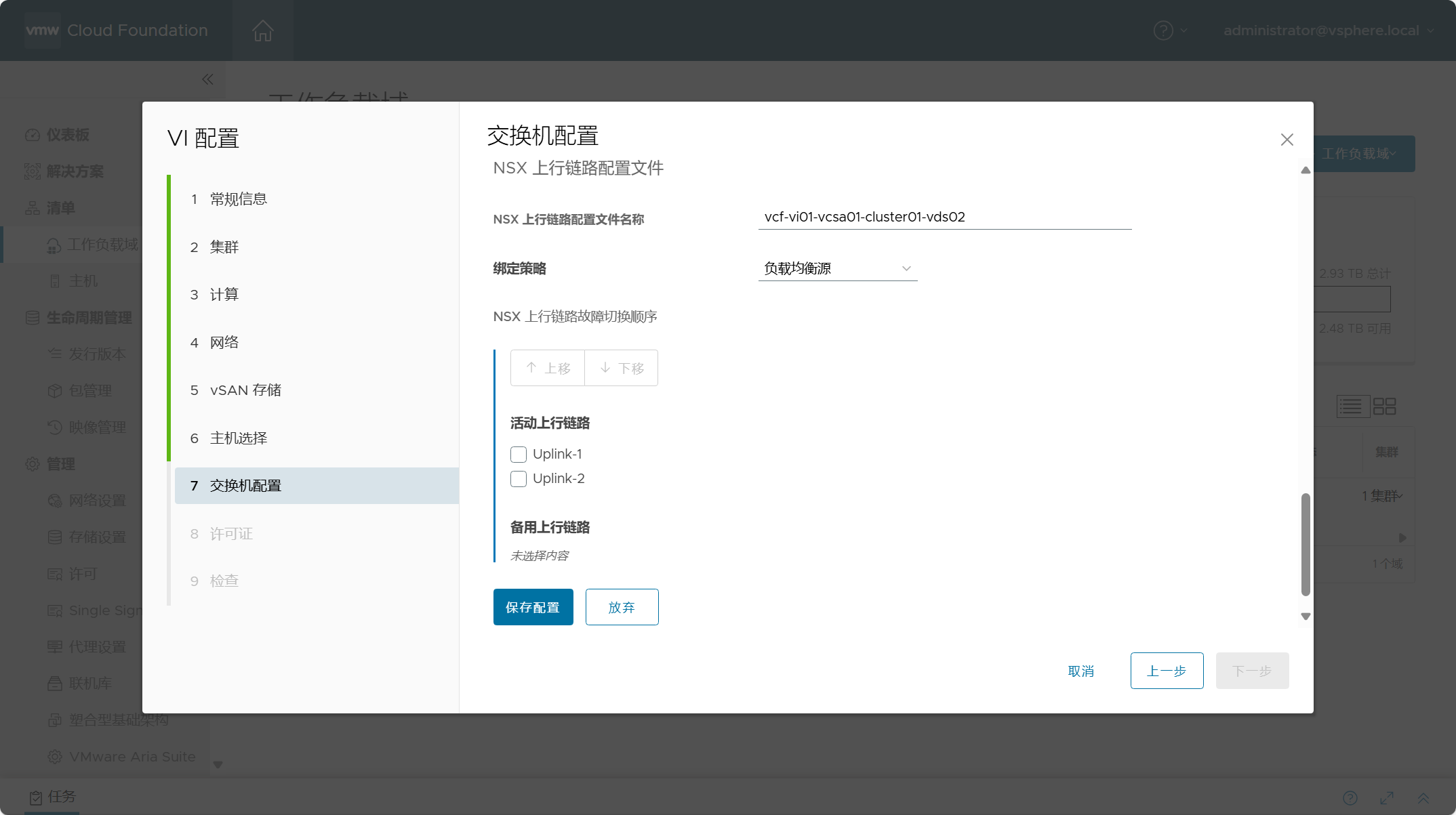

NSX 传输节点配置文件名称,绑定策略选择“负载均衡源”,其他默认,点击保存配置。

所有配置完成后,点击“创建分布式交换机”。

已完成所有分布式交换机的创建以及网络流量类型的分配,确认没有问题,点击下一步。

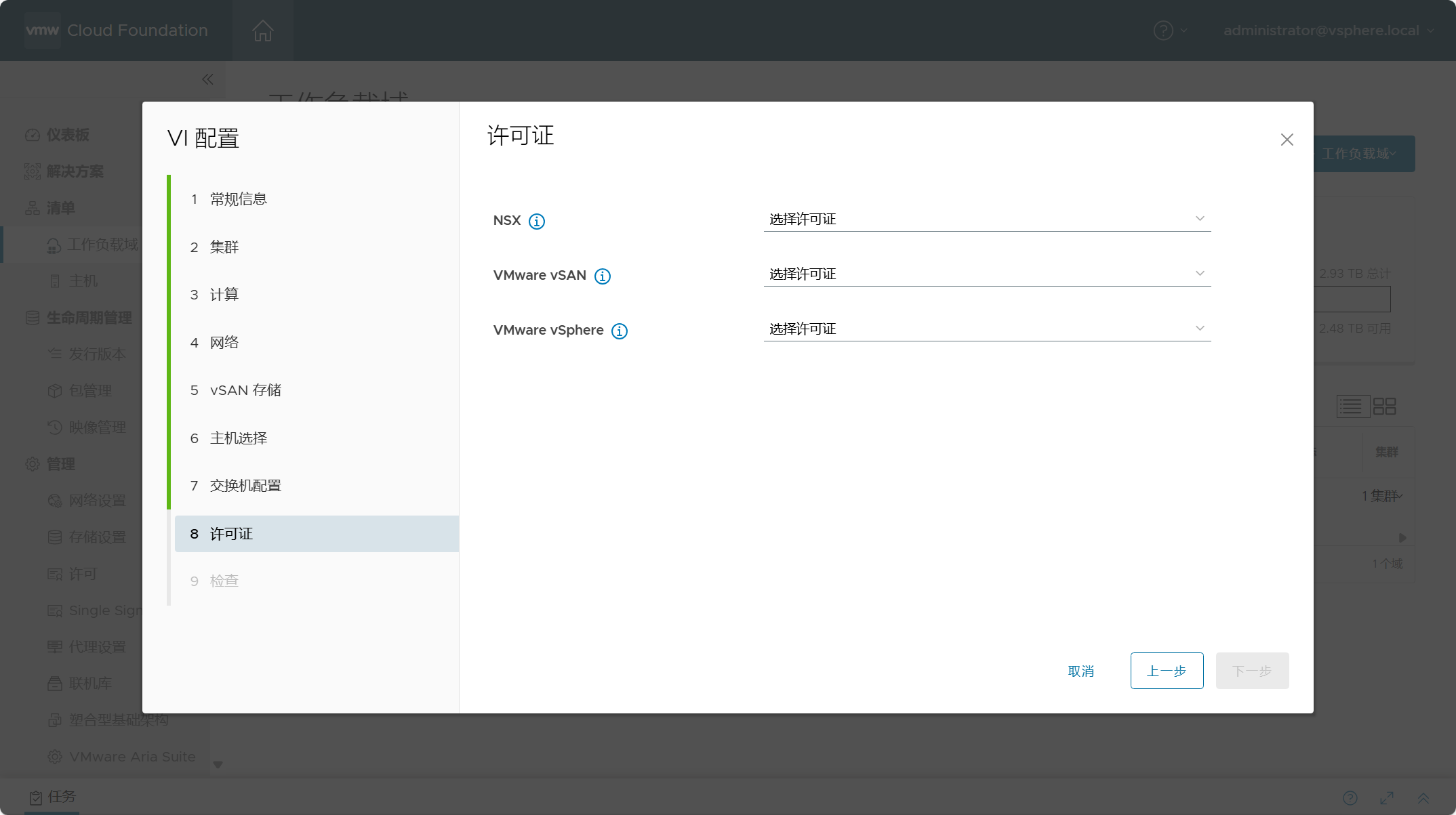

选择用于 VI 工作负载域组件的 License 许可。

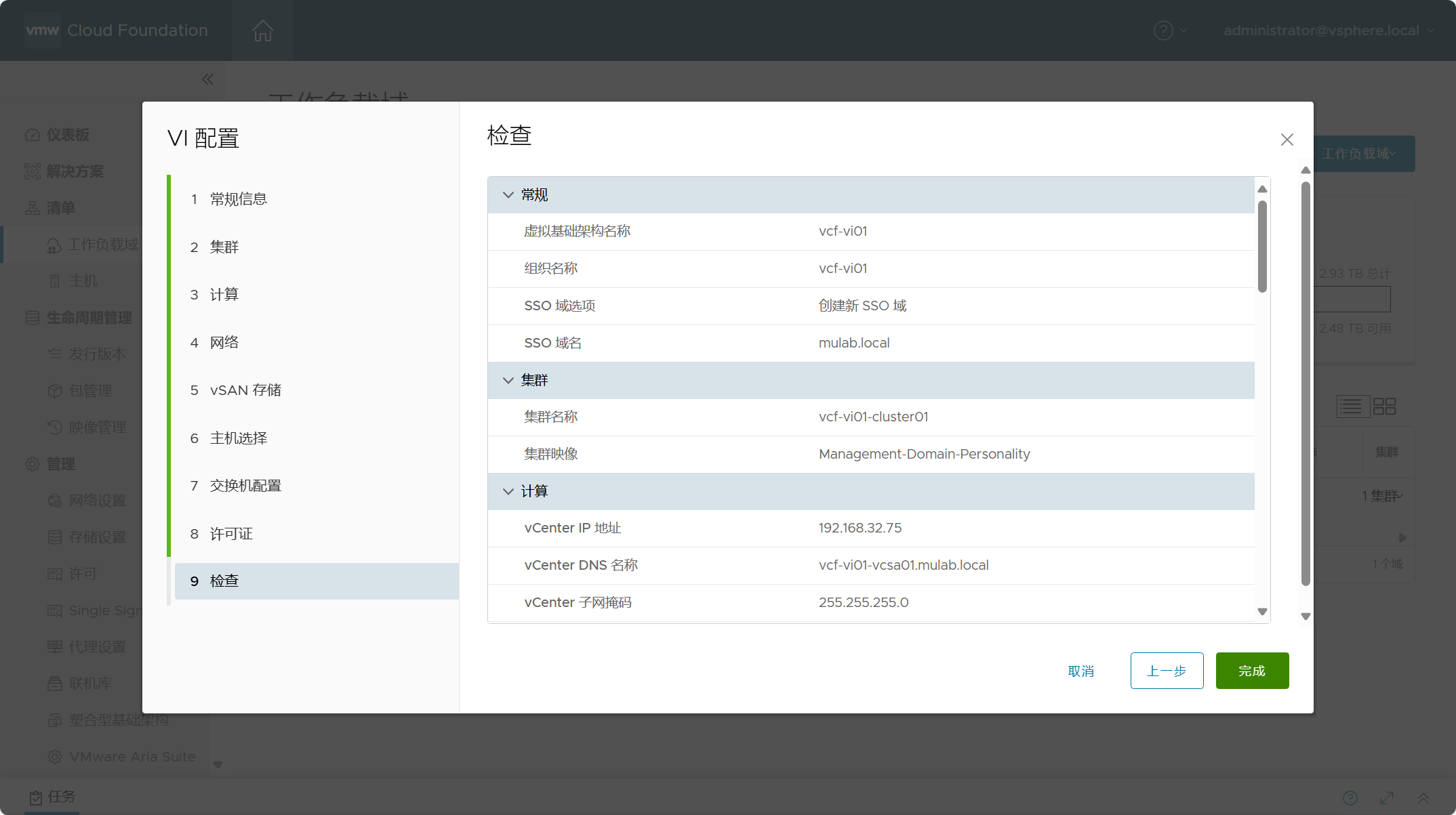

检查所有配置信息,点击完成并开始部署 VI 域。

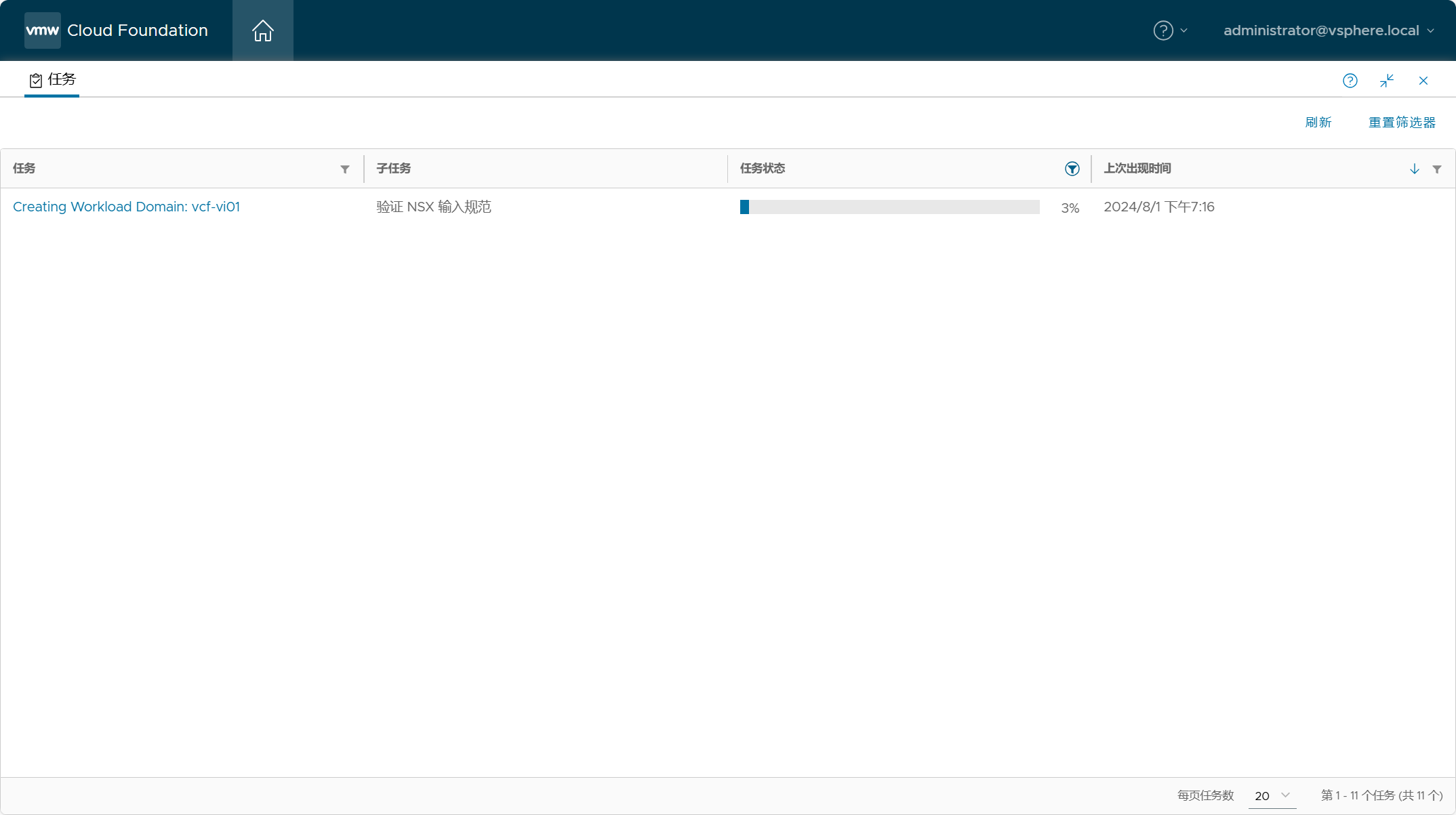

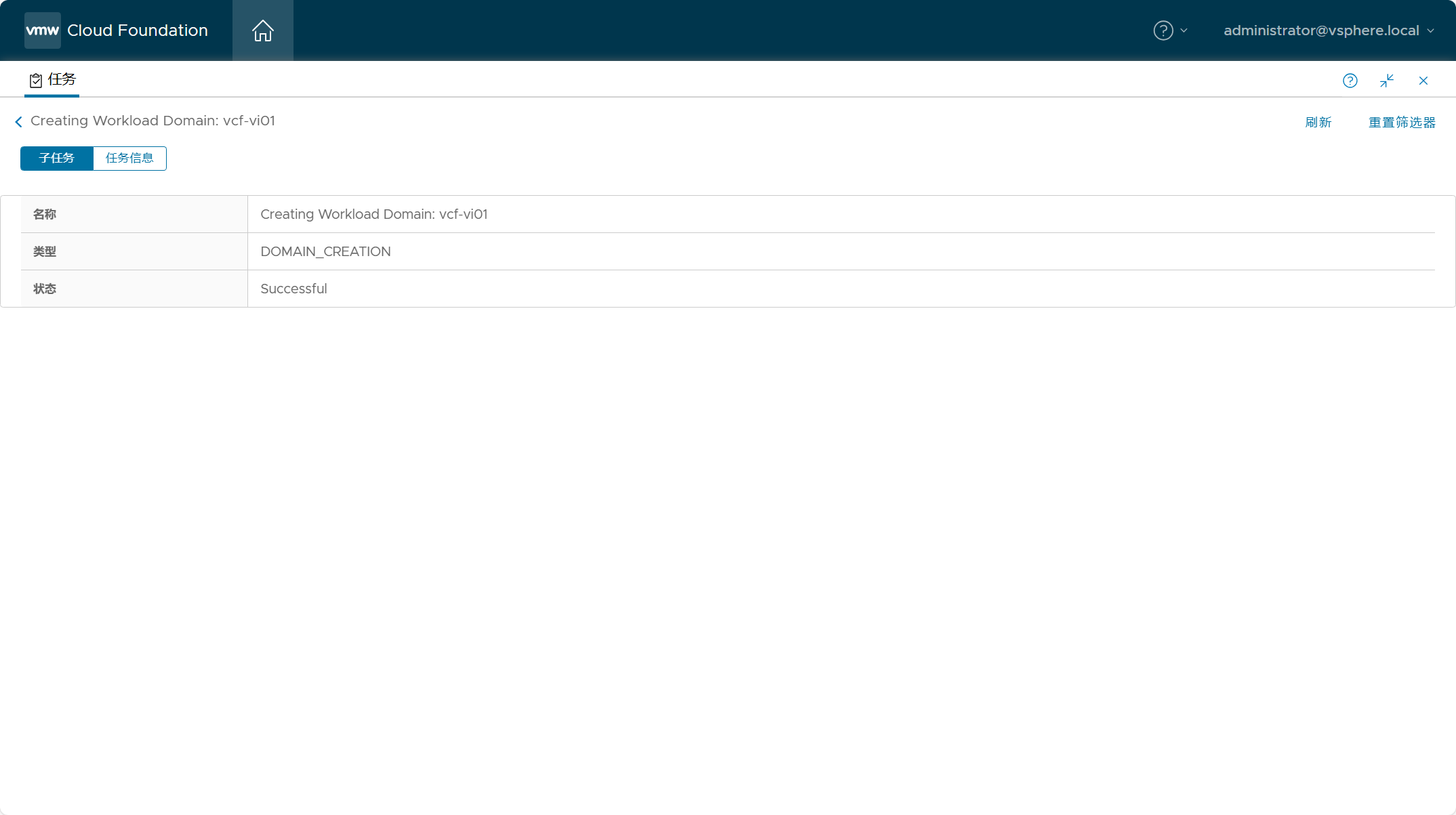

点击底部任务窗口,查看任务状态。

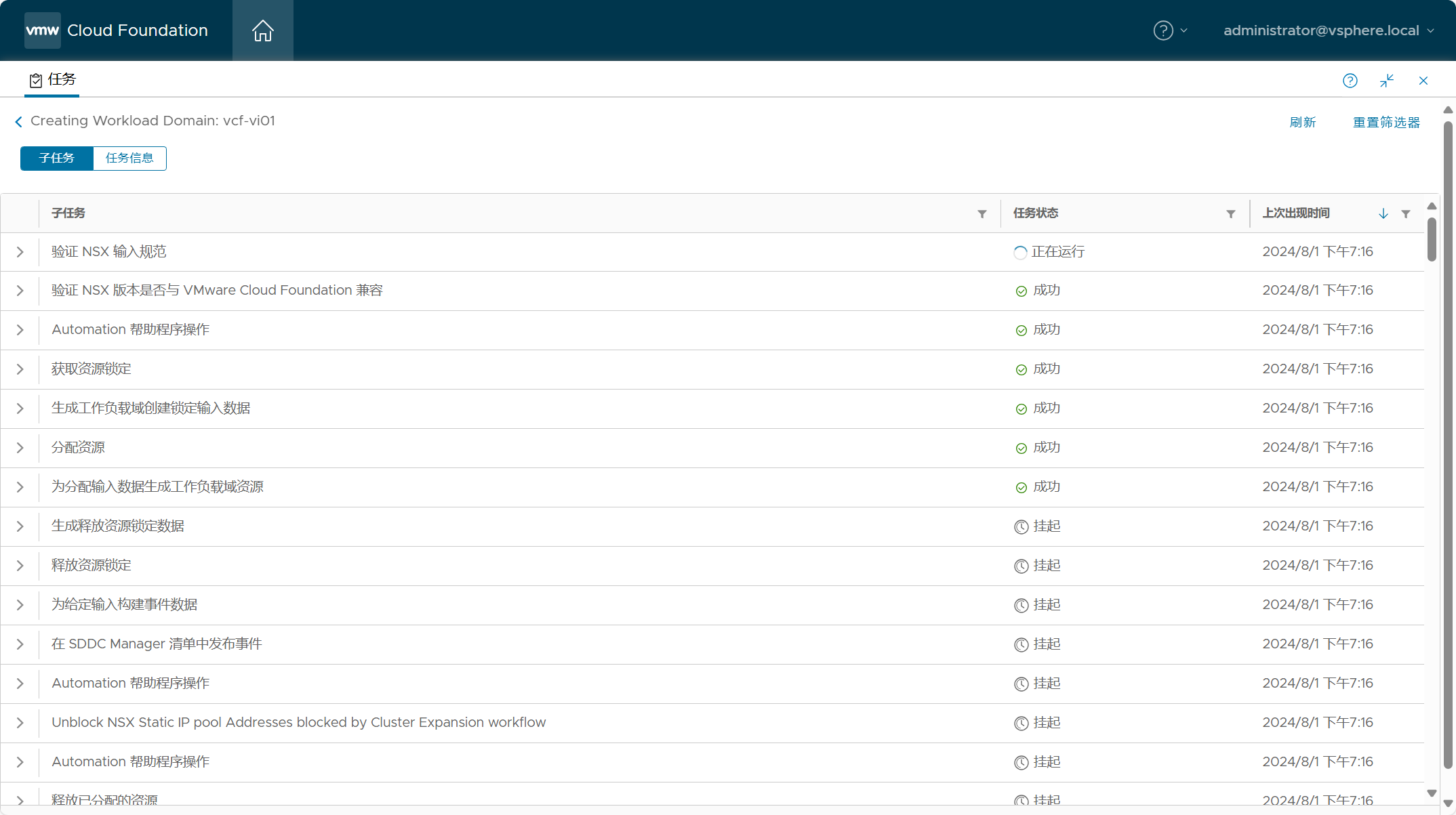

点击该任务,查看子任务执行情况。

整个部署过程花了 2~3 小时。

部署过程的全部任务。

五、VI 域相关信息

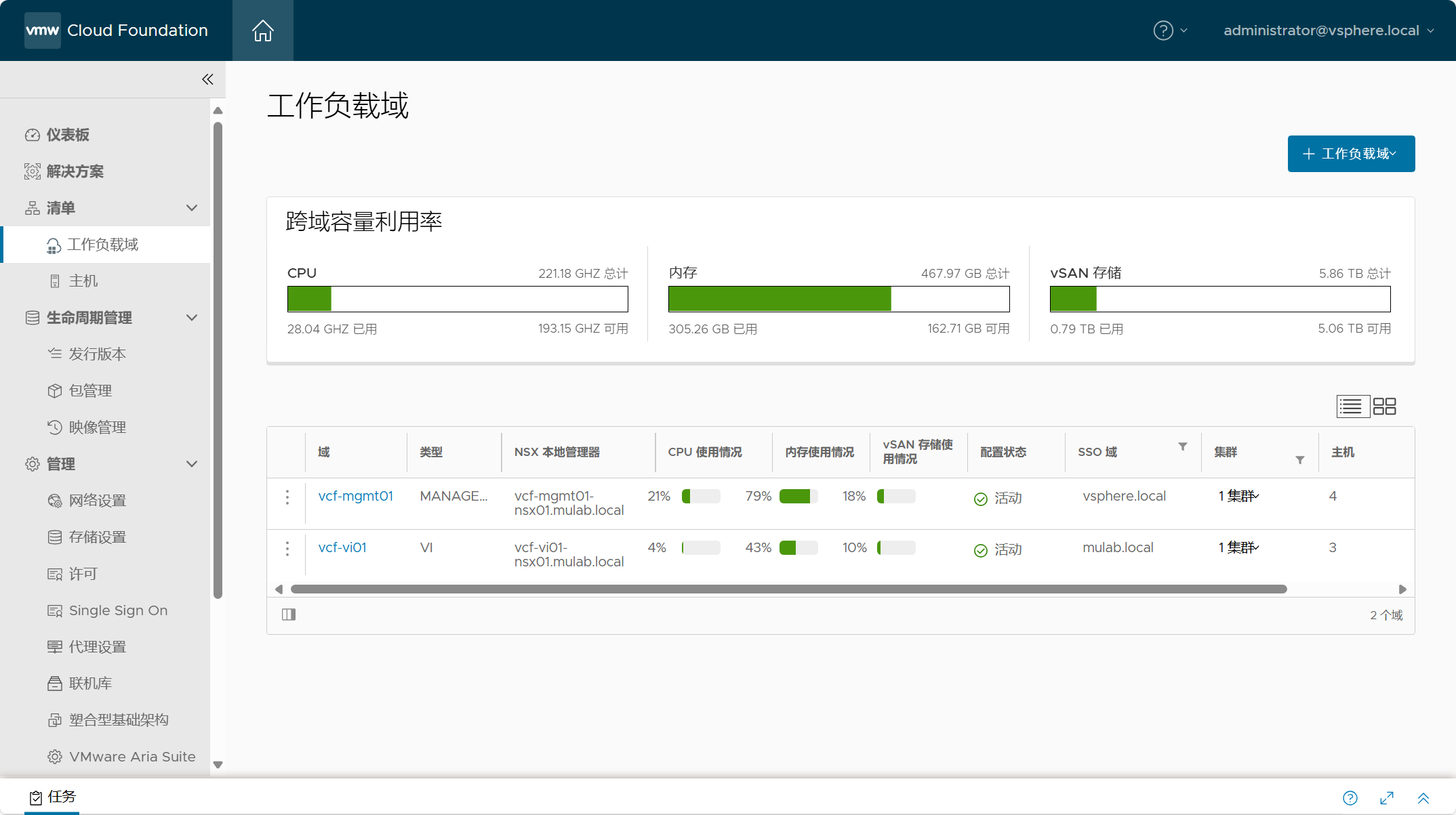

1)SDDC Manager

- SDDC Manager 中的工作负载域

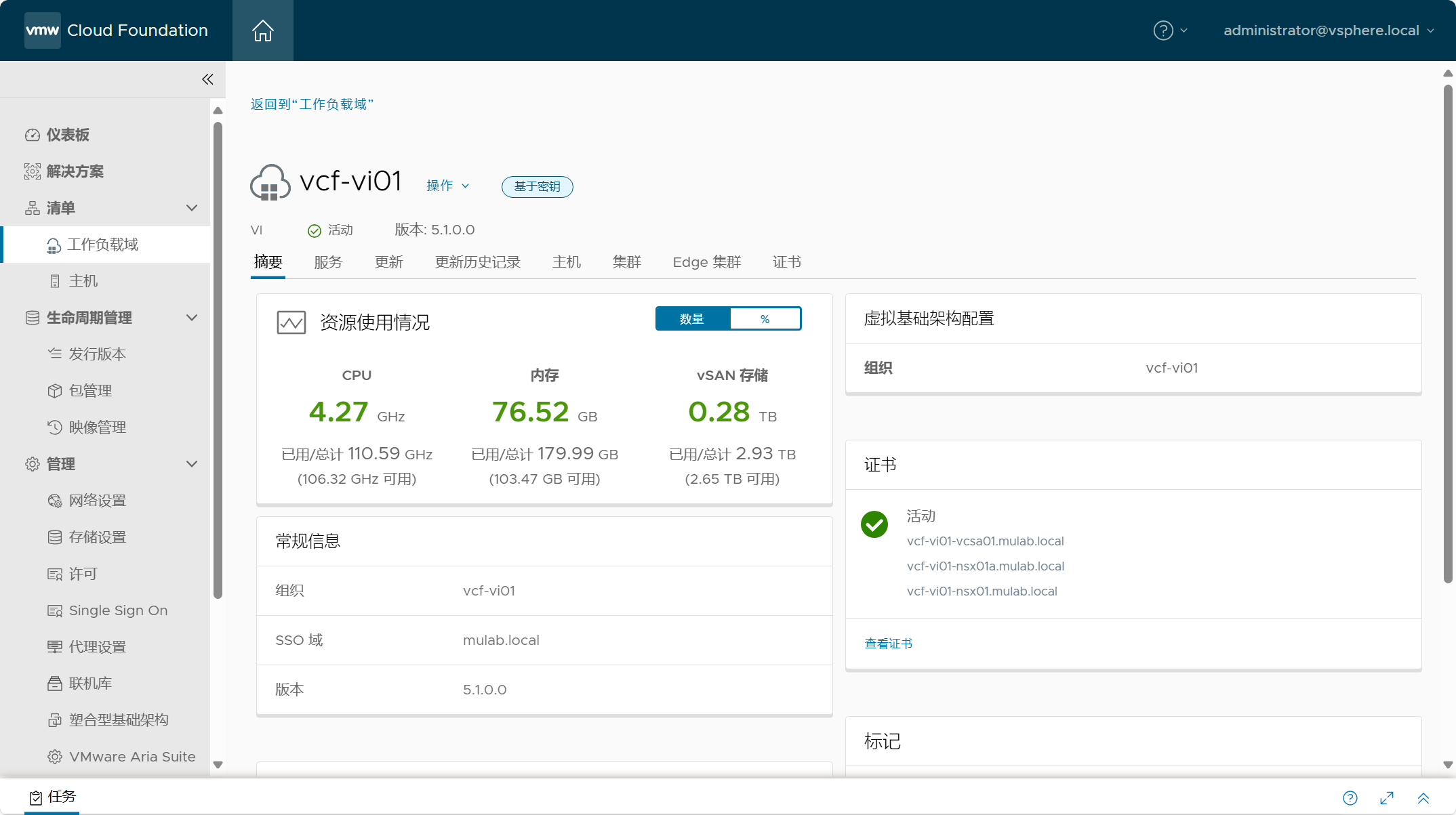

- VI 域(vcf-vi01)摘要信息

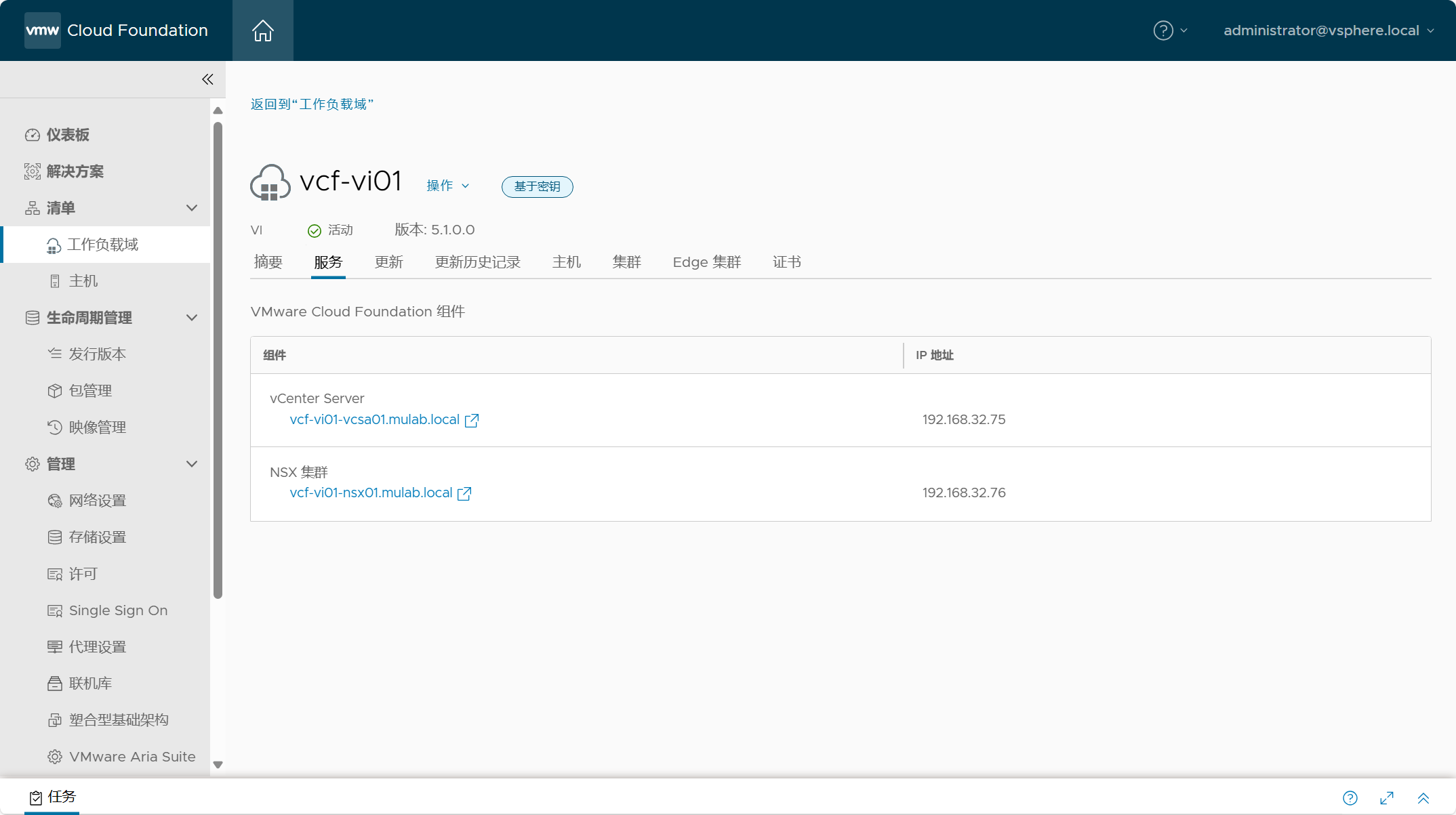

- VI 域(vcf-vi01)服务组件

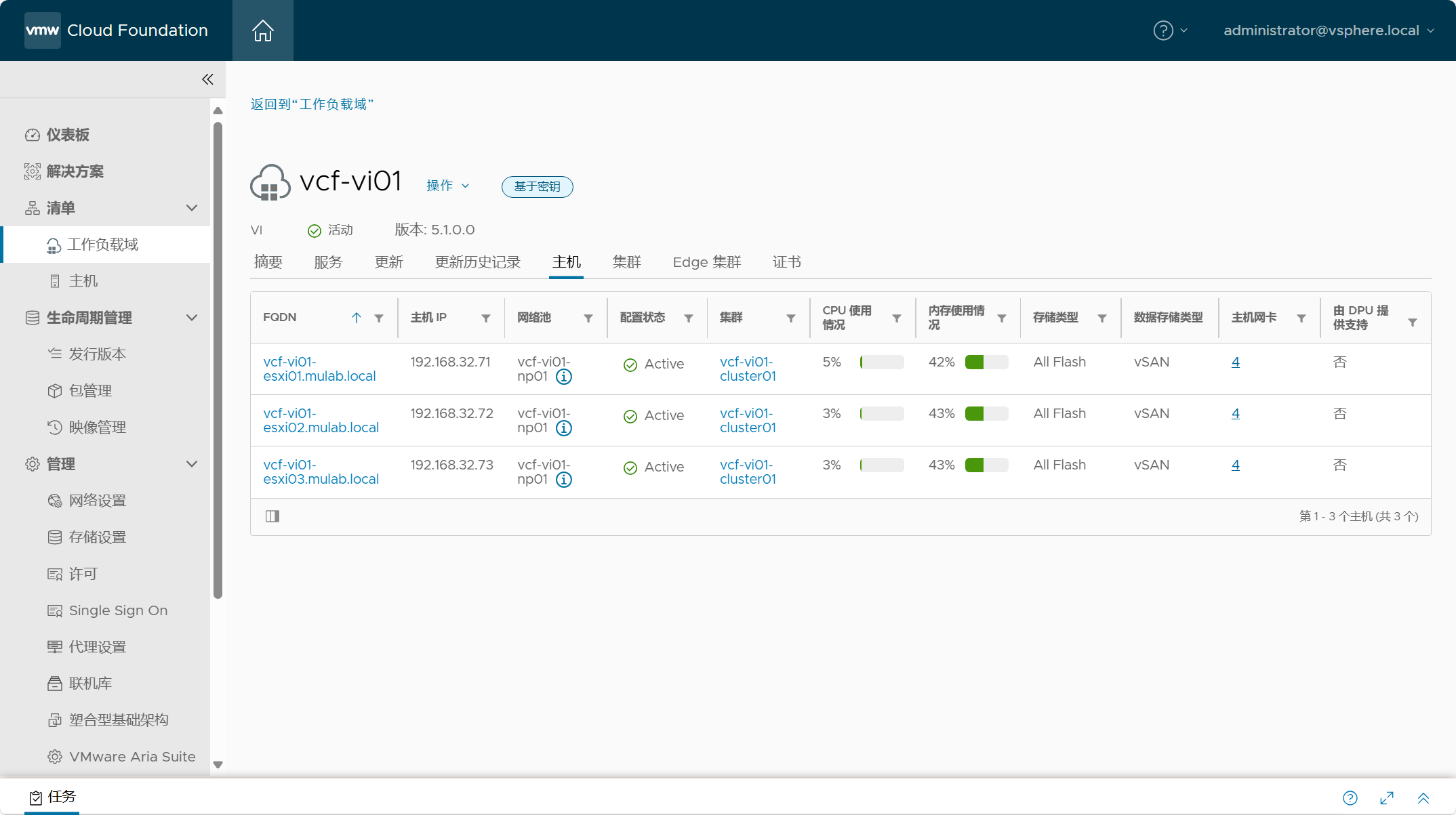

- VI 域(vcf-vi01)服役主机

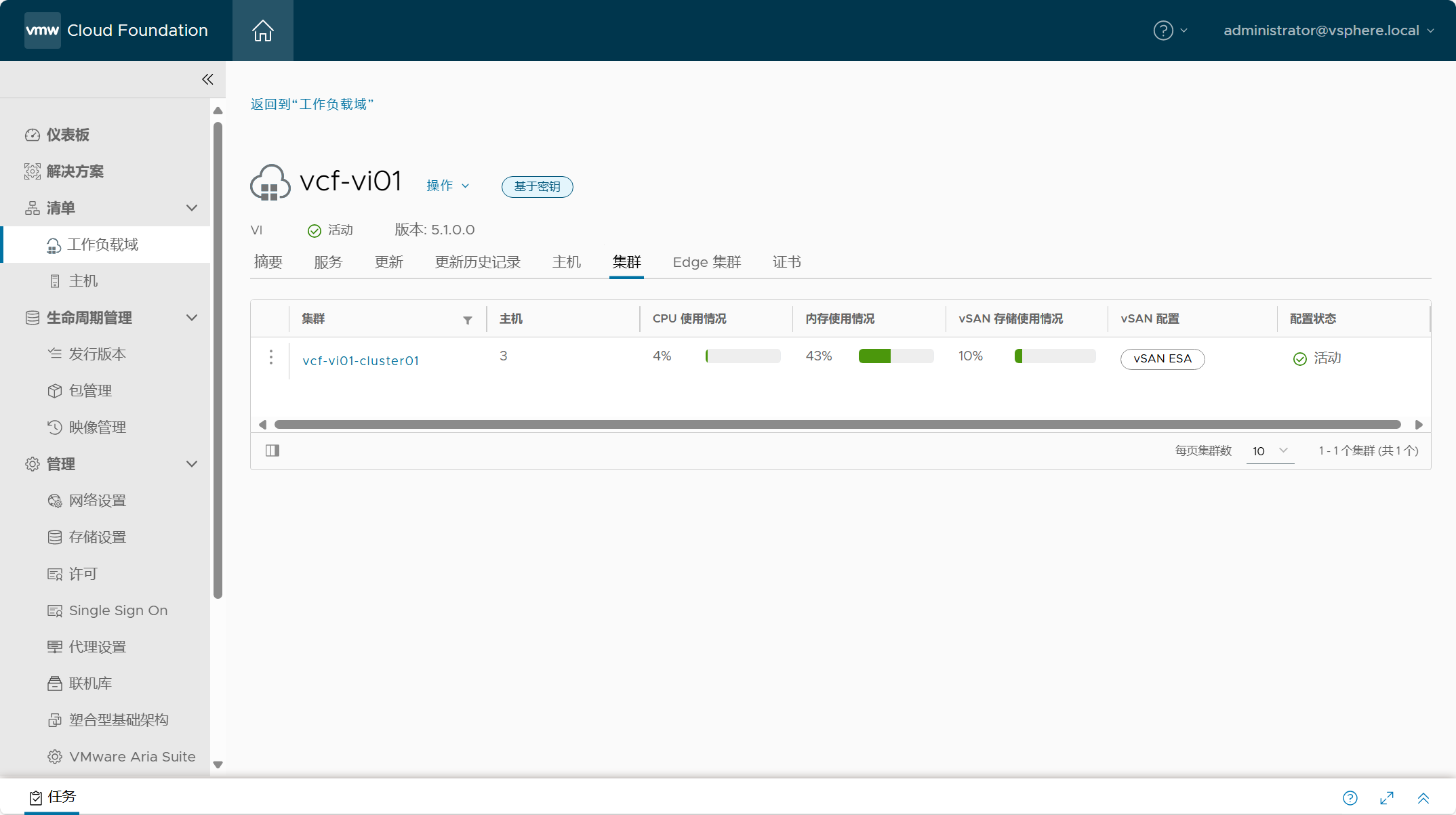

- VI 域(vcf-vi01)默认集群

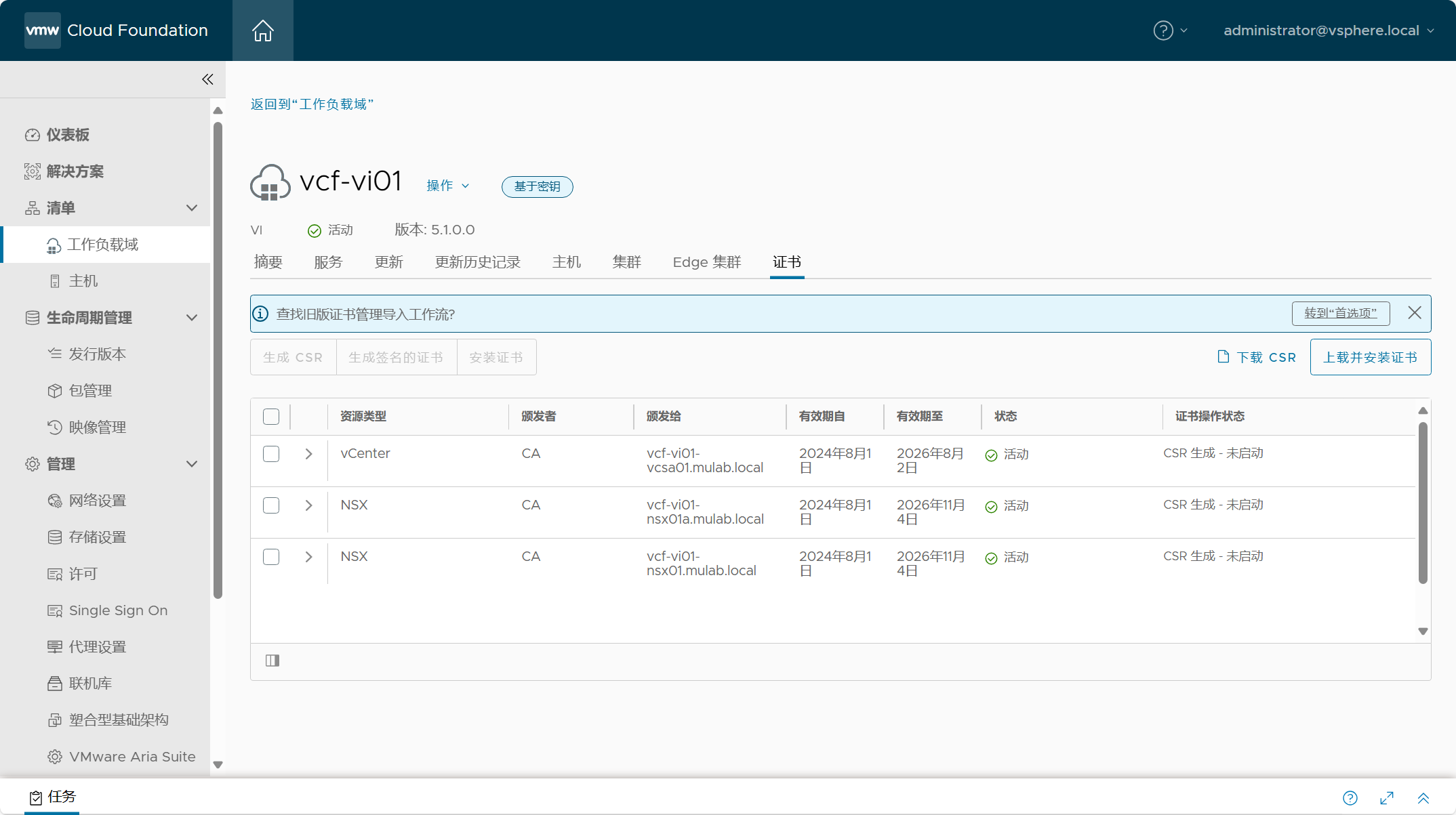

- VI 域(vcf-vi01)组件证书

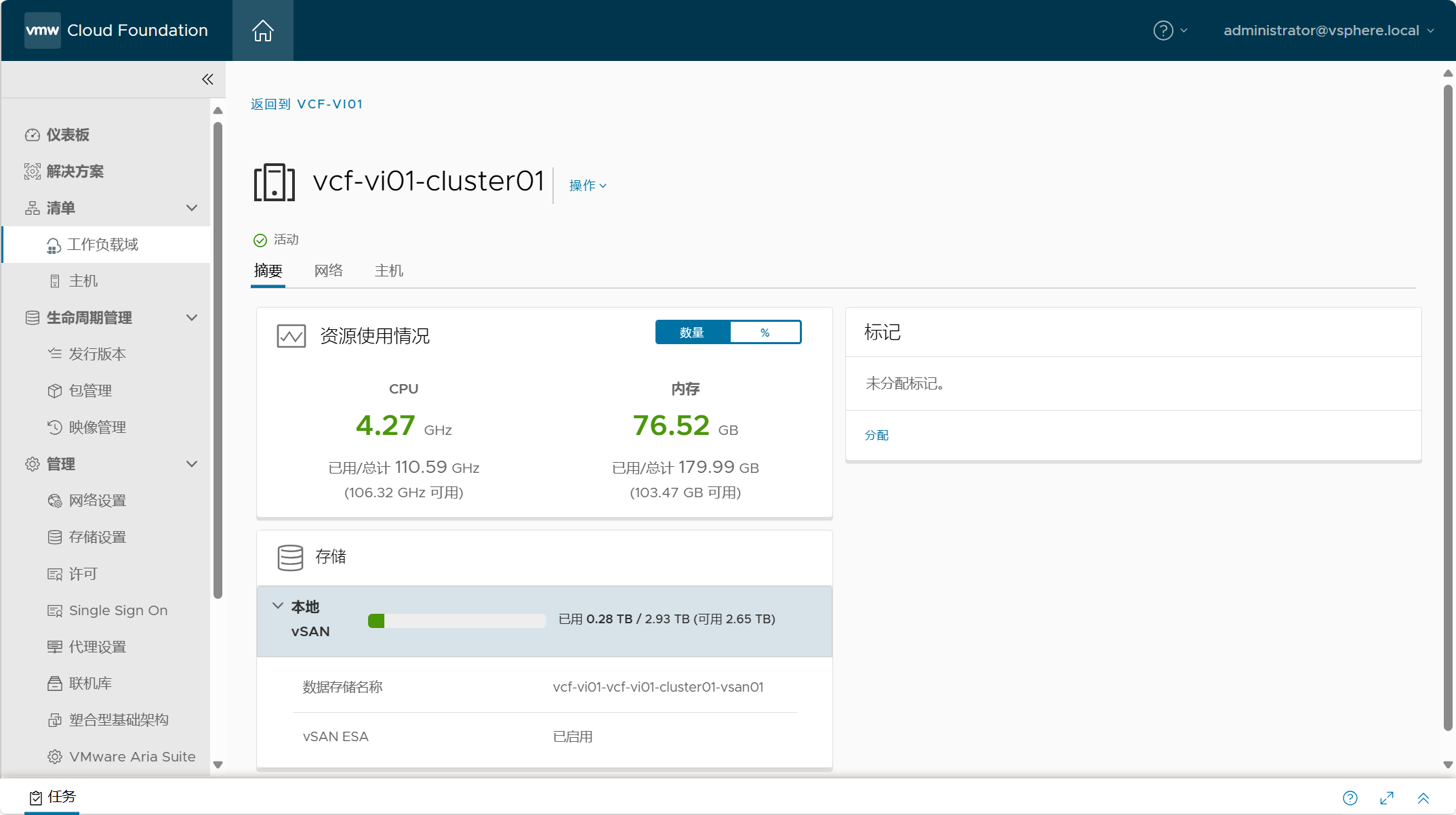

- VI 域(vcf-vi01)集群(vcf-vi01-cluster01)摘要

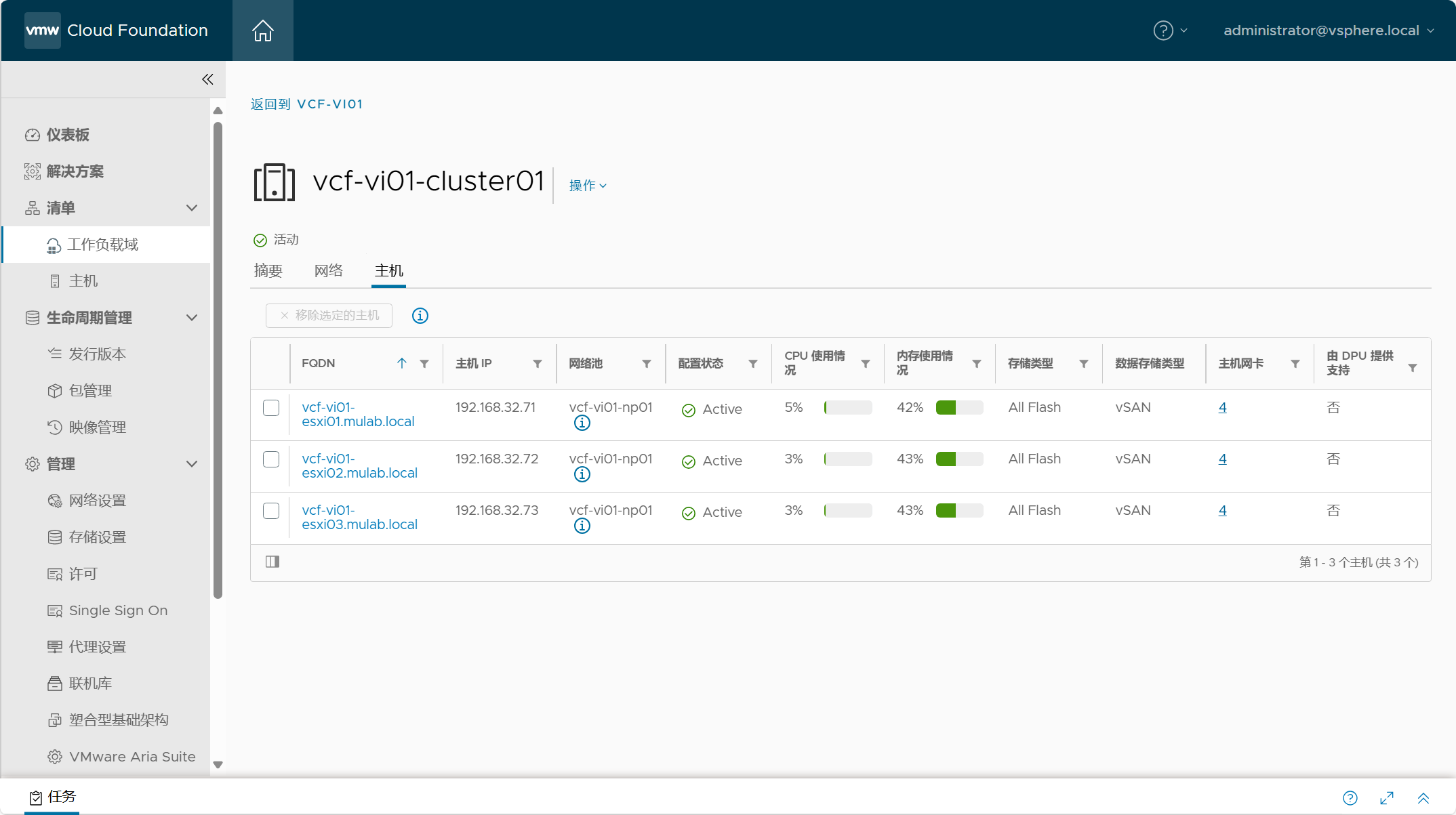

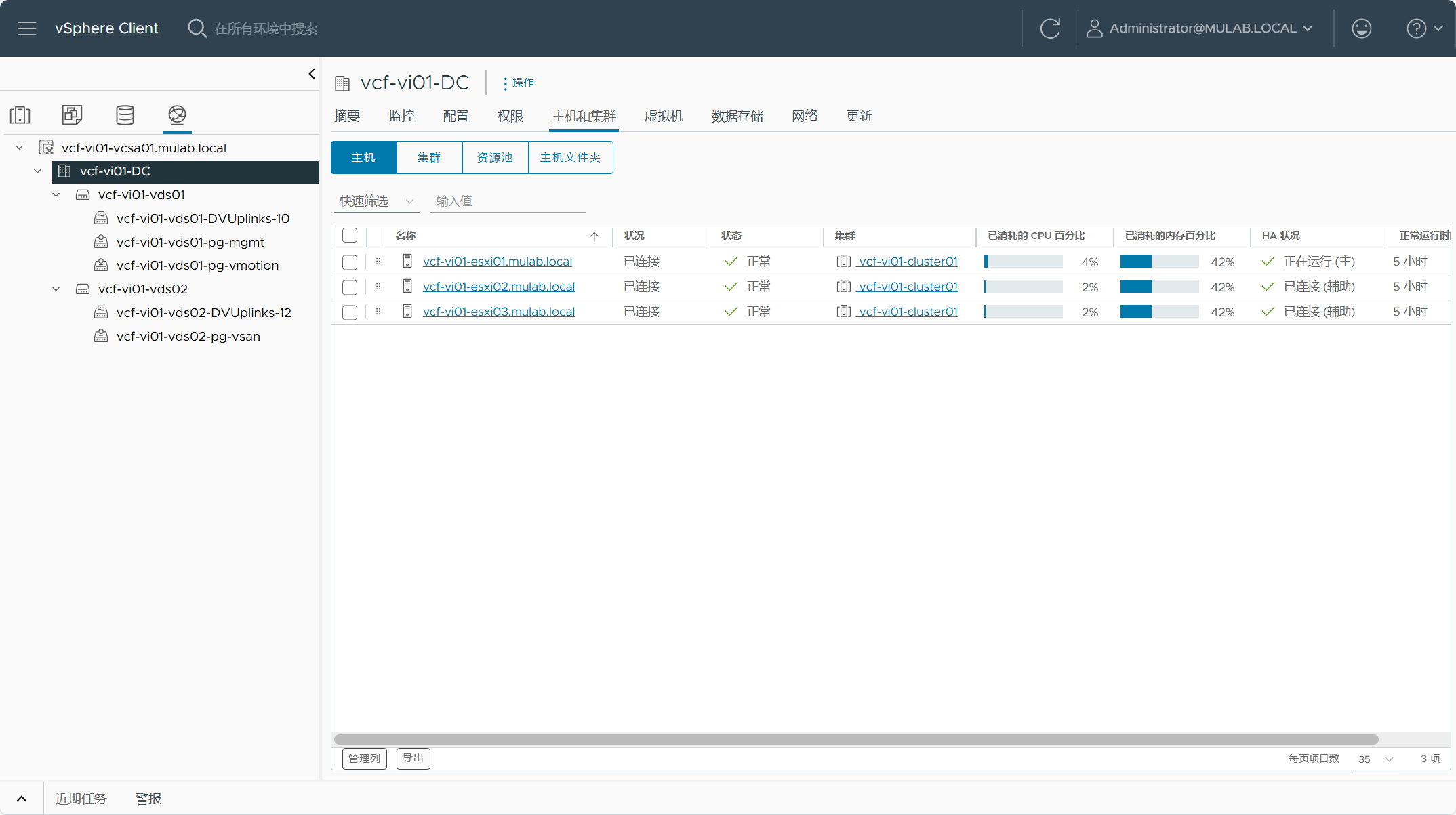

- VI 域(vcf-vi01)集群(vcf-vi01-cluster01)主机

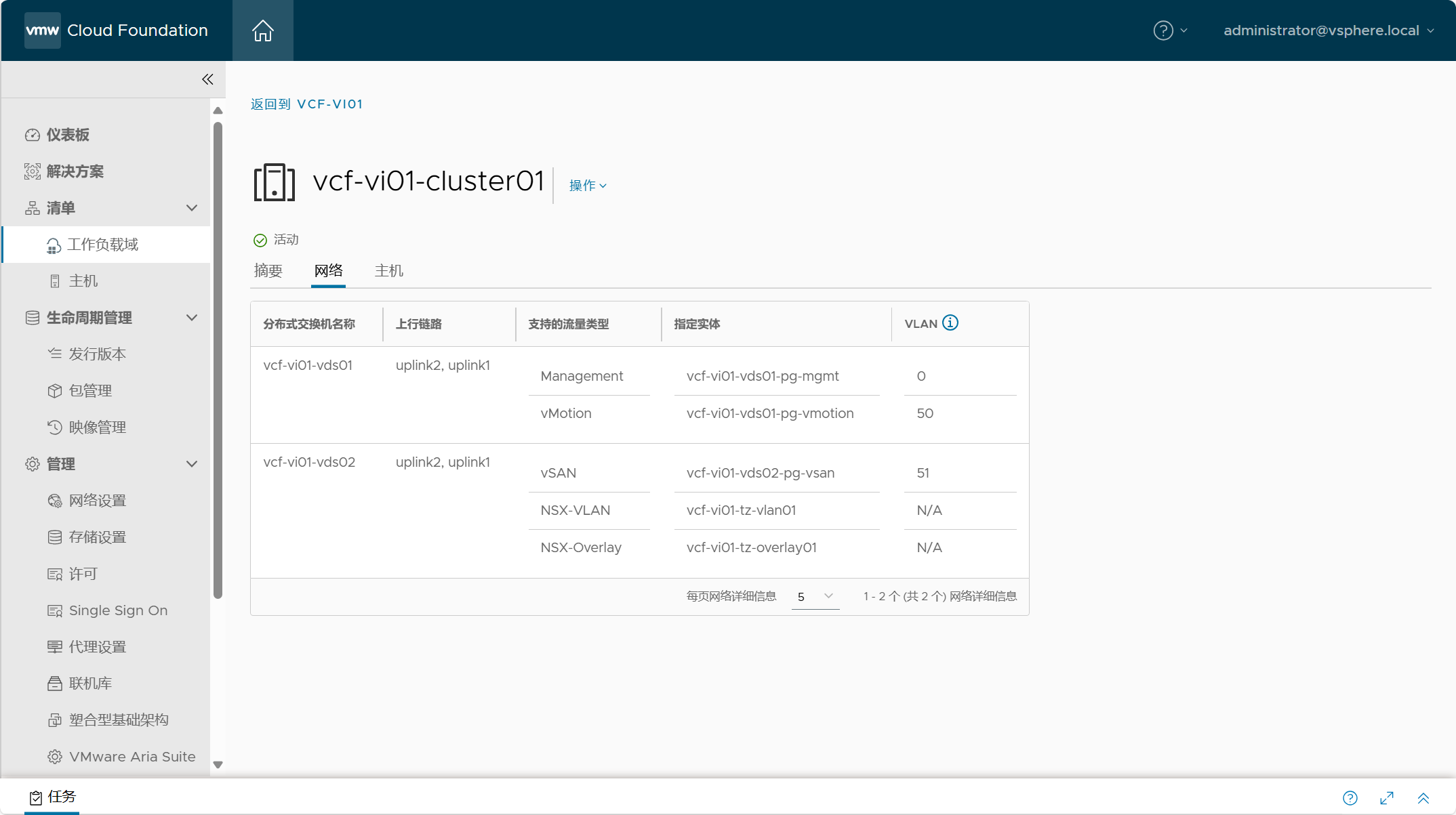

- VI 域(vcf-vi01)集群(vcf-vi01-cluster01)网络

- SDDC Manager 中的网络池

- SDDC Manager 中的所有主机

- SDDC Manager 中的发行版本

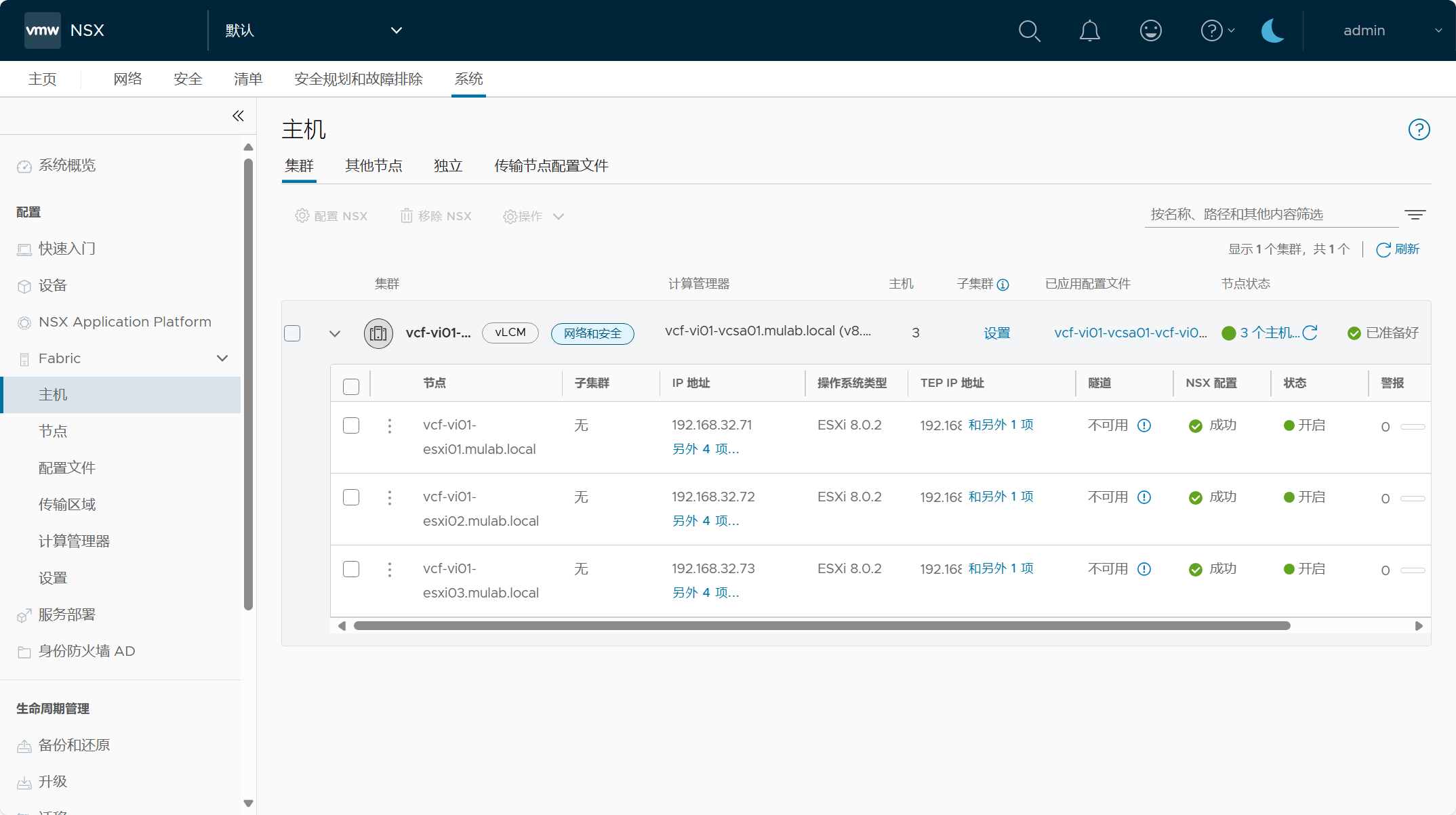

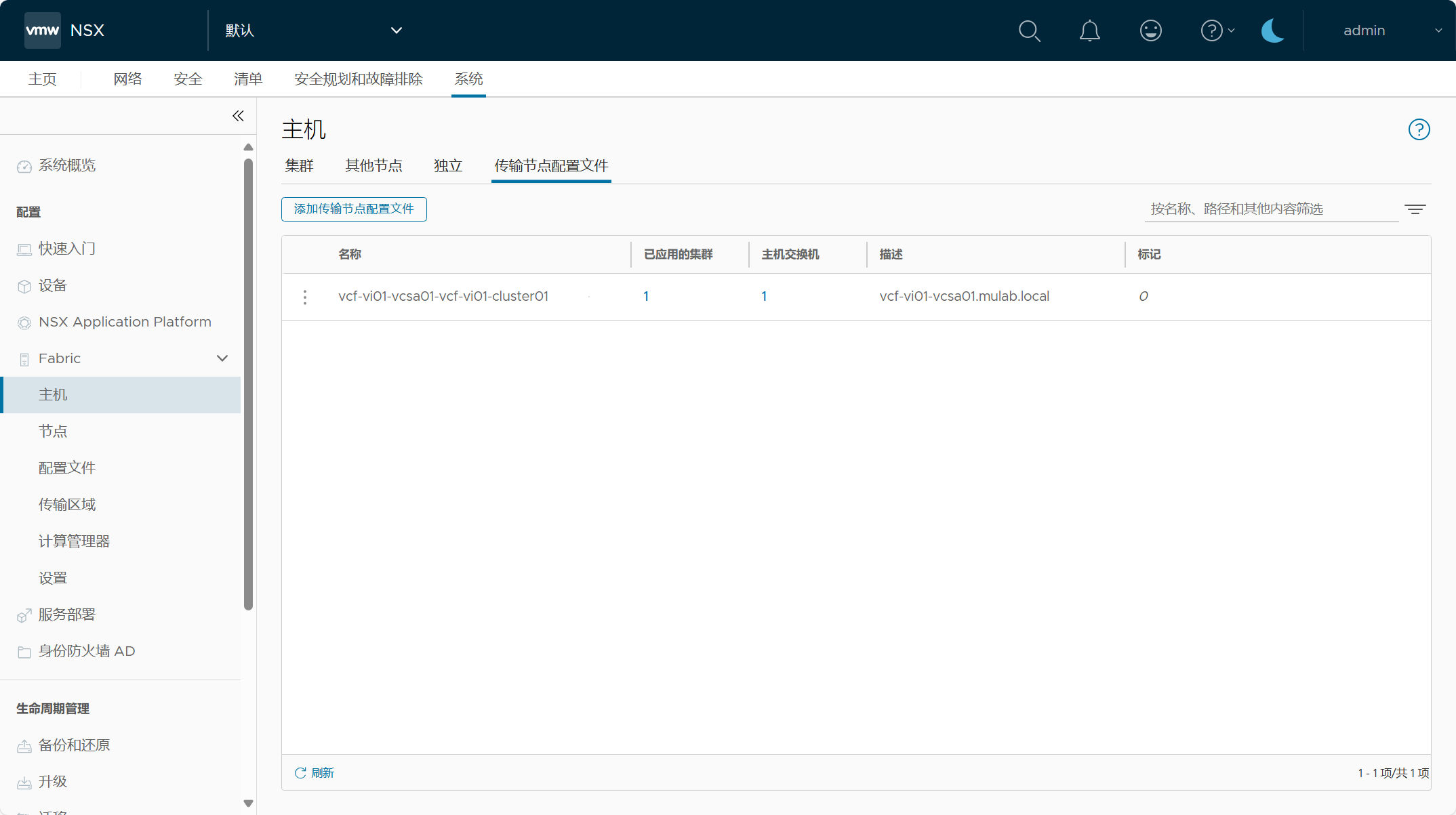

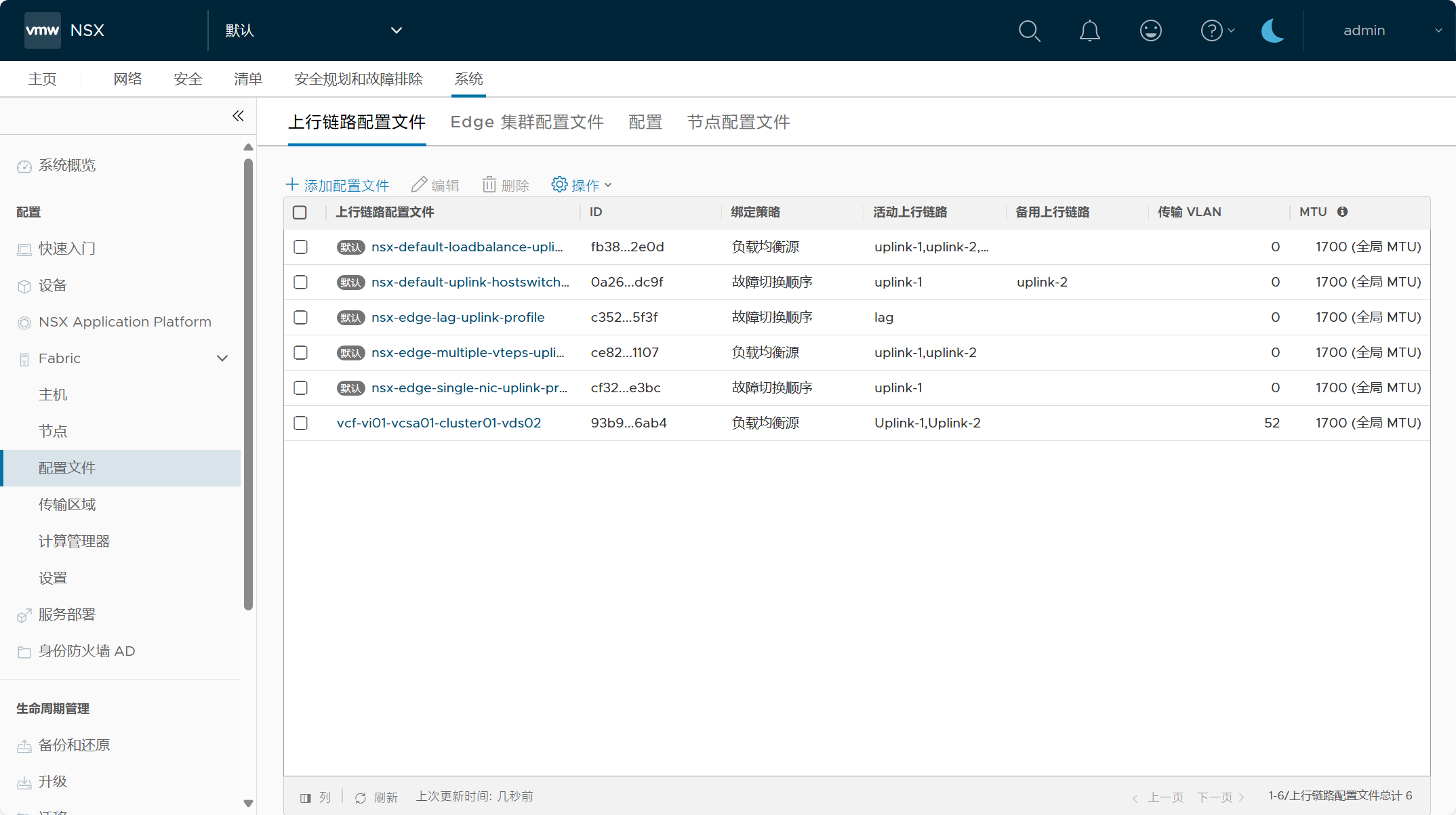

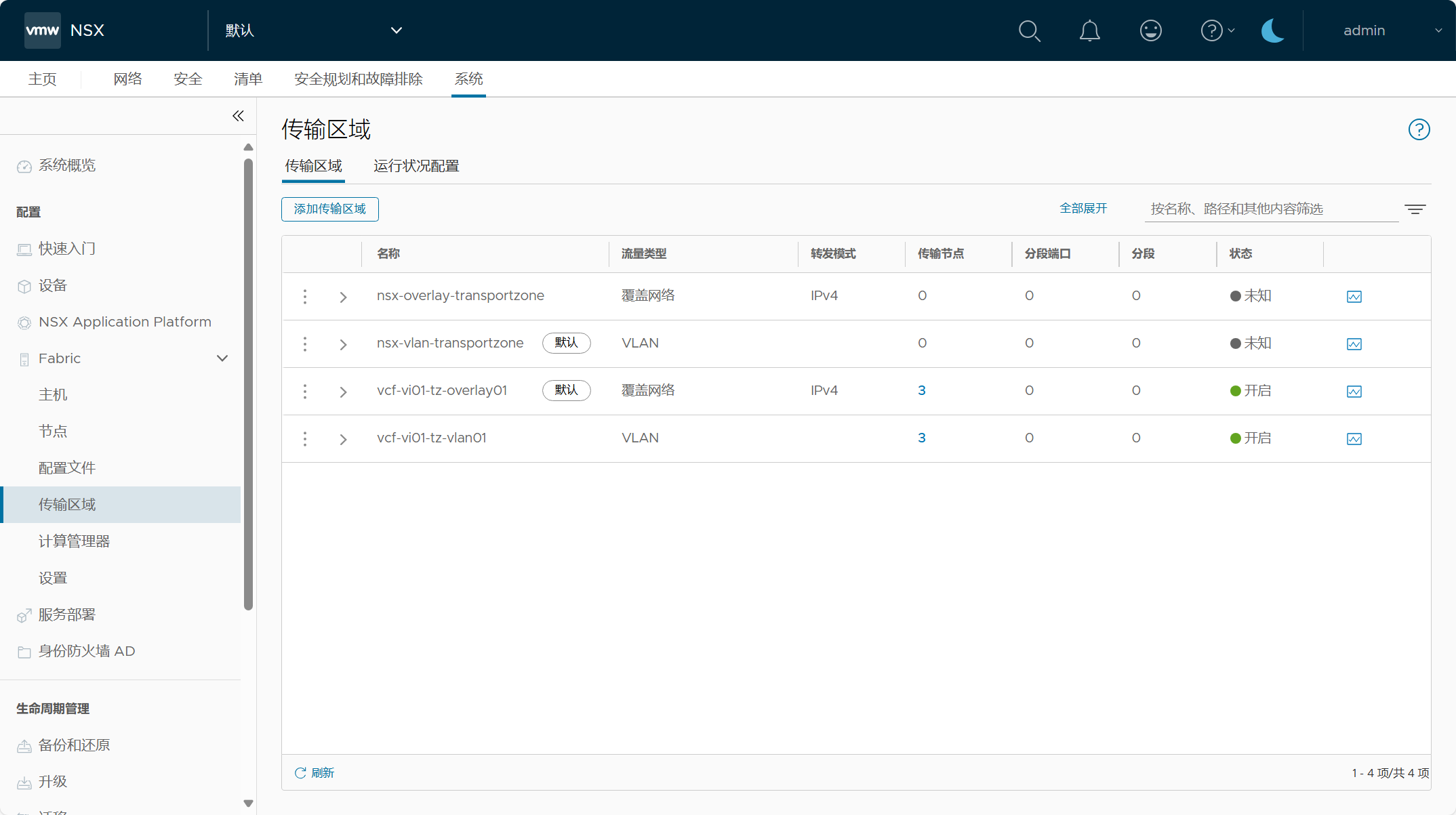

2)NSX Manager

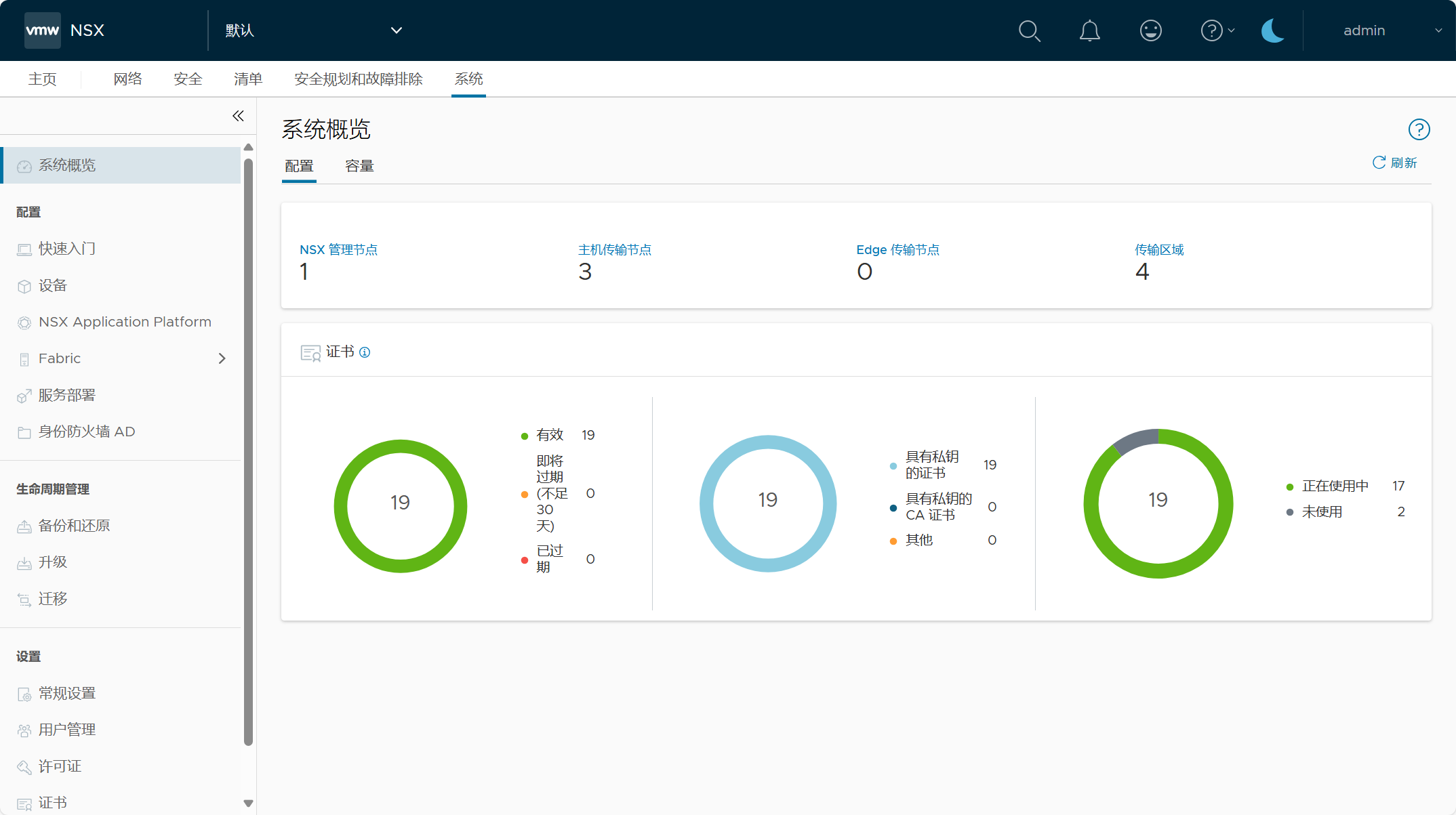

- NSX 系统配置概览

- NSX Manager 设备节点

- NSX 传输主机节点

- NSX 传输主机节点配置文件

- NSX 上行链路配置文件

- NSX 传输区域

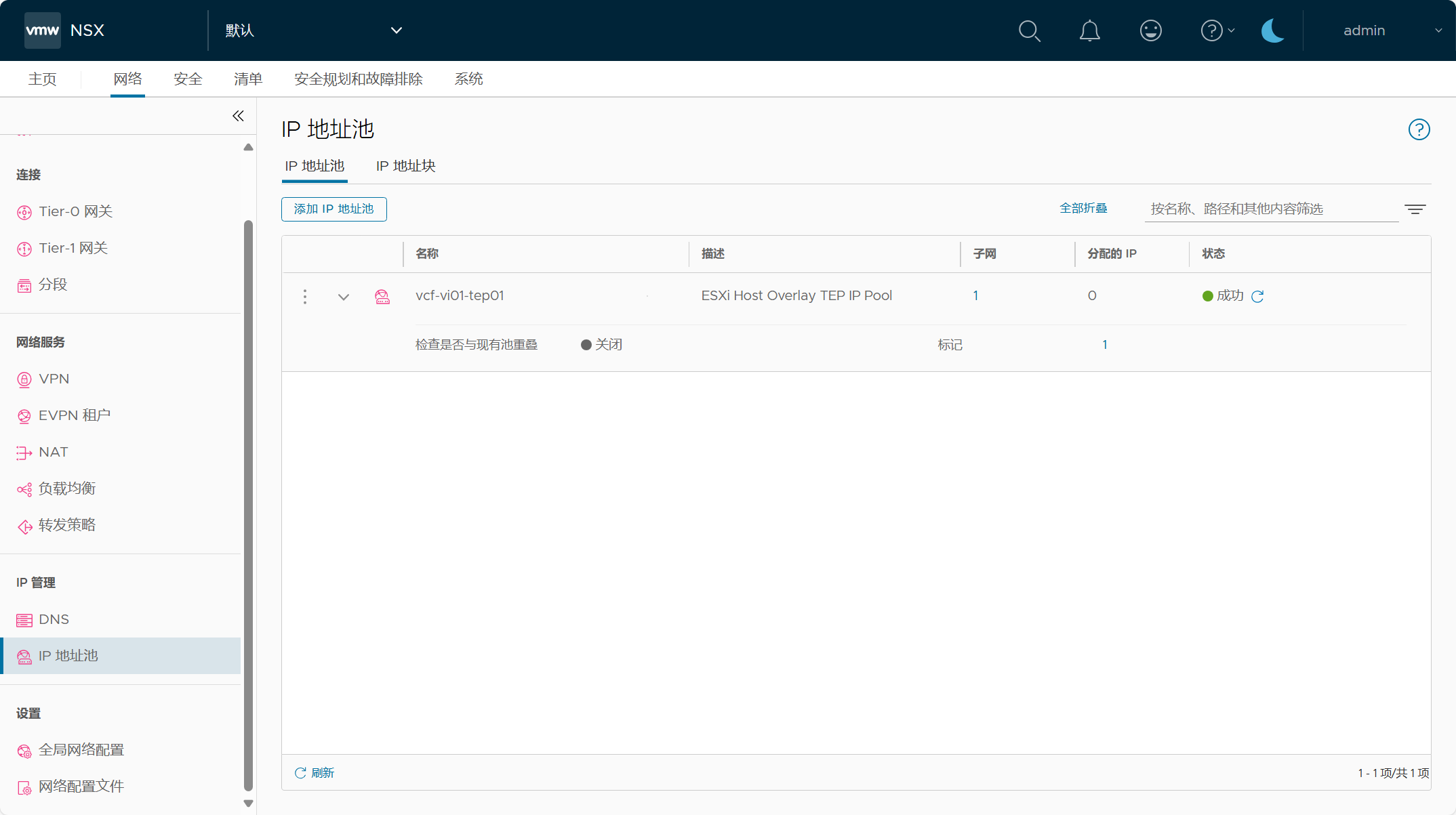

- NSX TEP IP 地址池

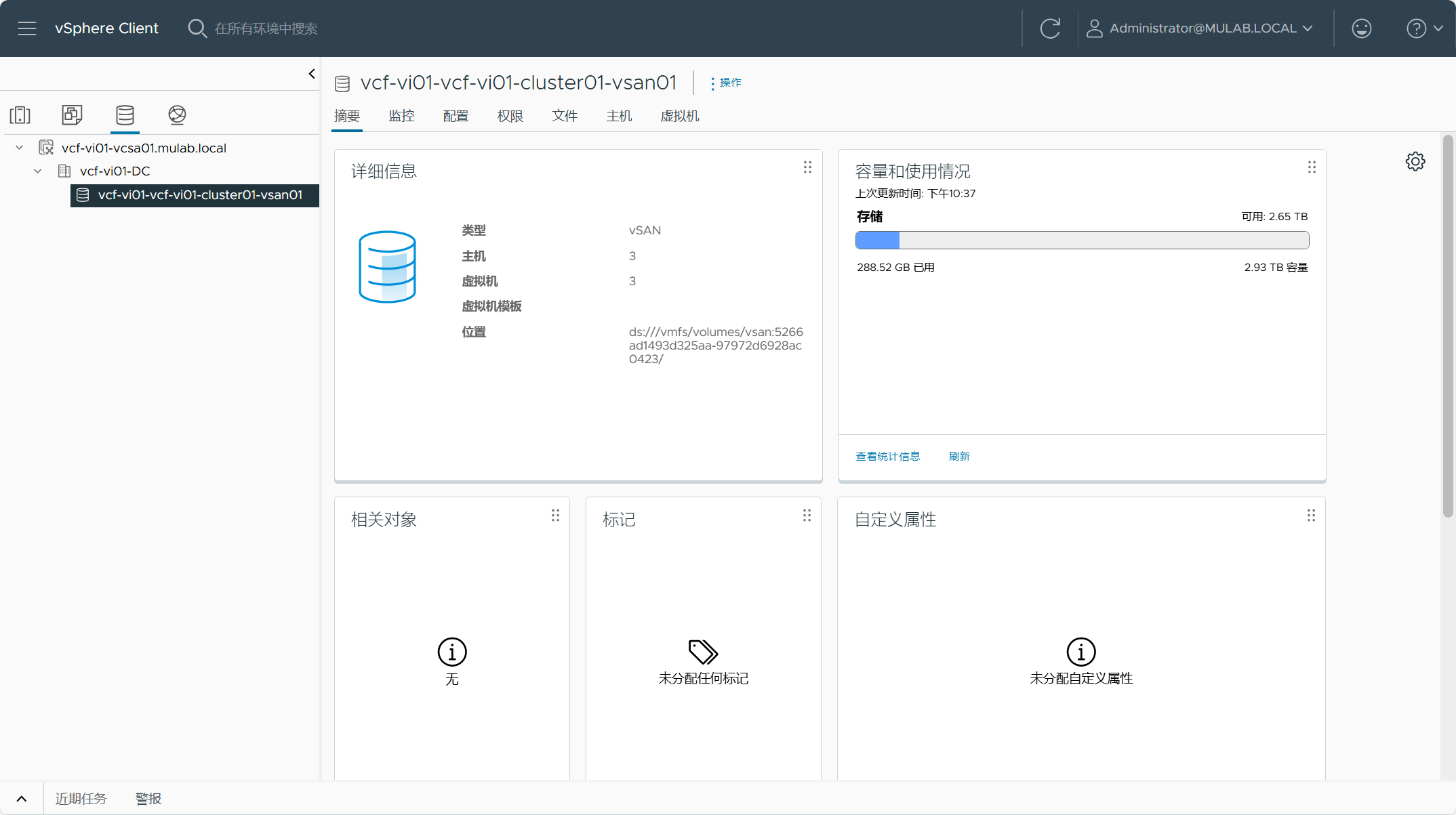

3)vCenter Server

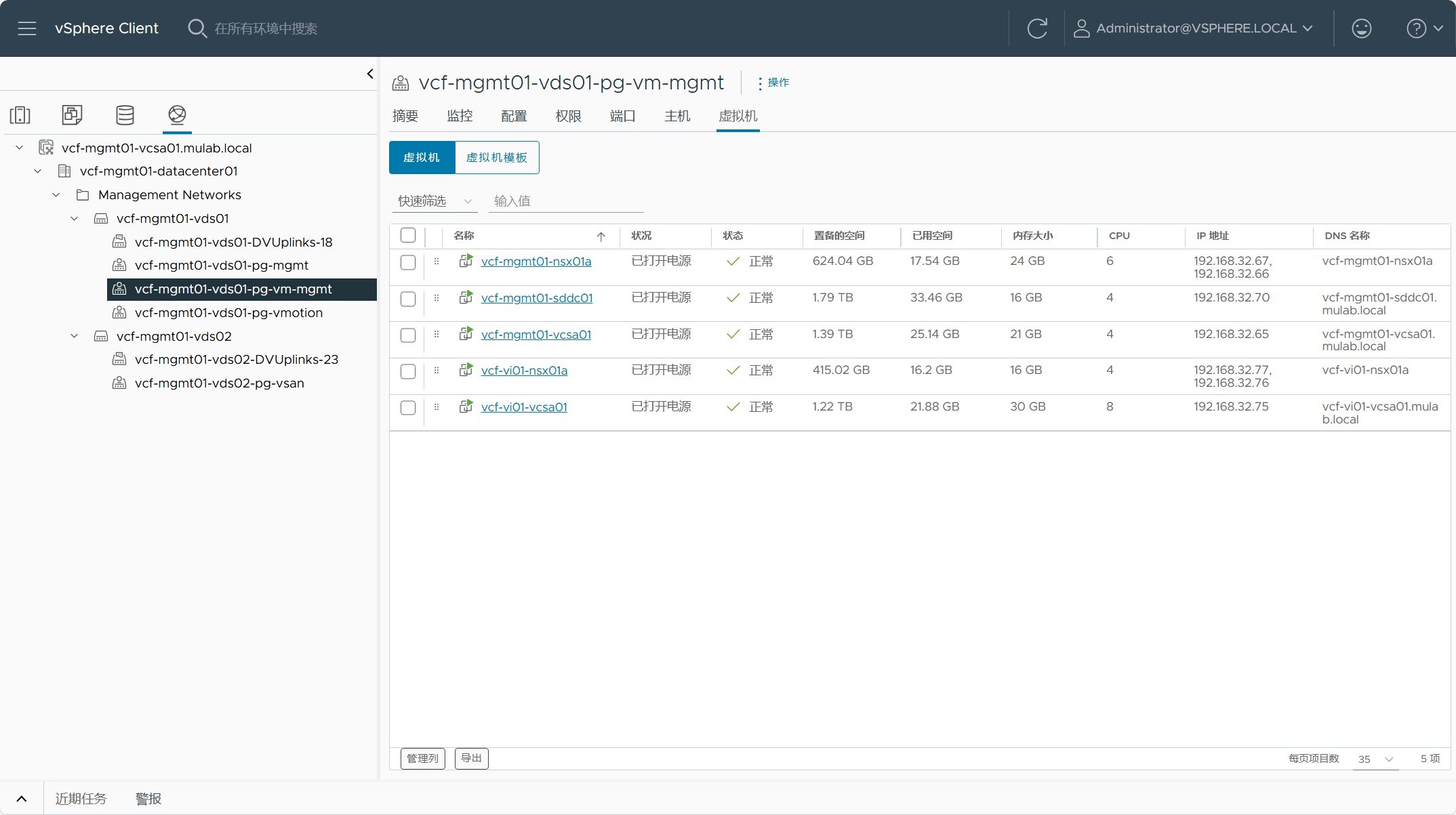

- 管理域 vCenter Server 中 VI 域组件

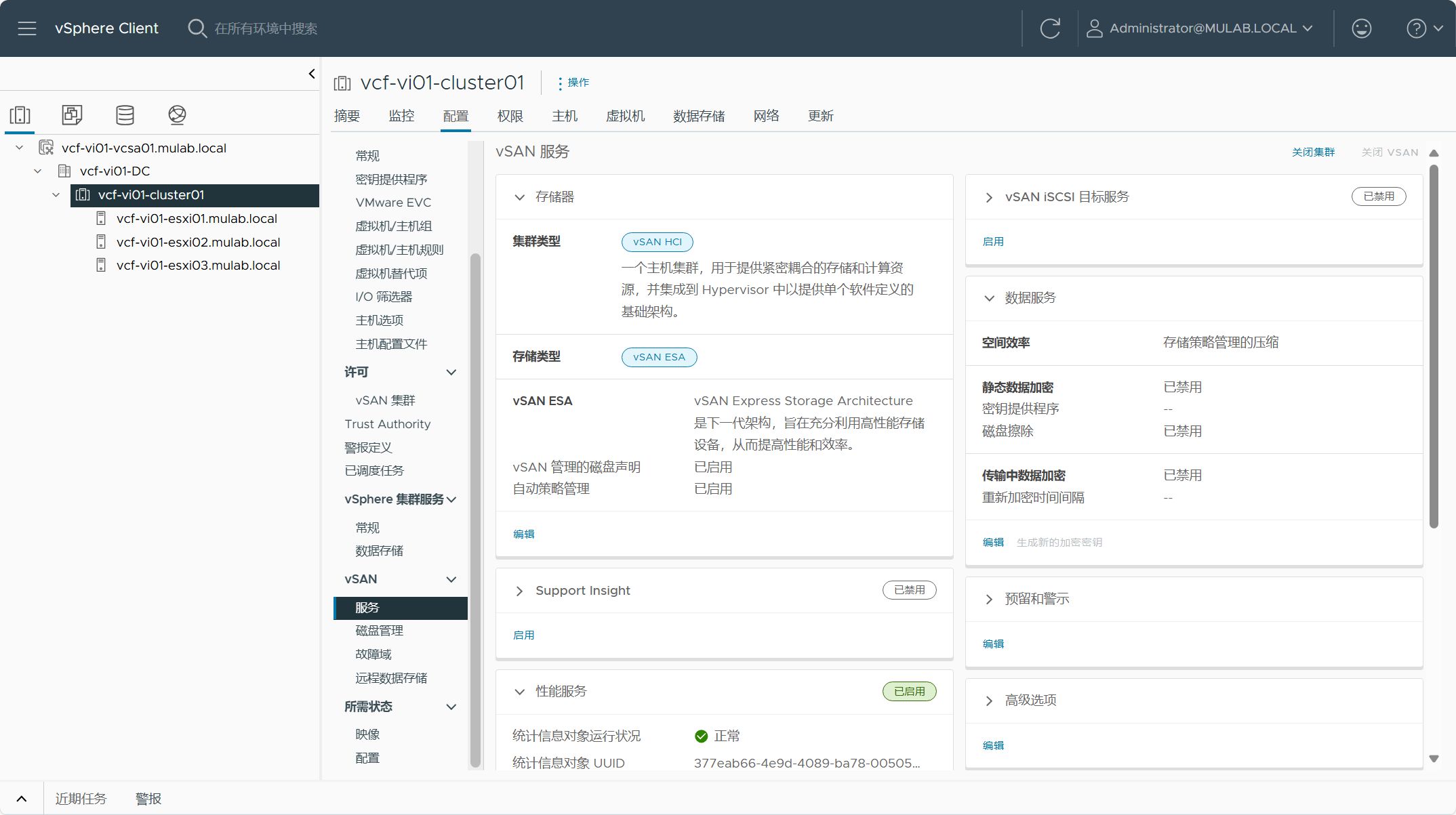

- VI 域 vCenter Server vSAN ESA 集群

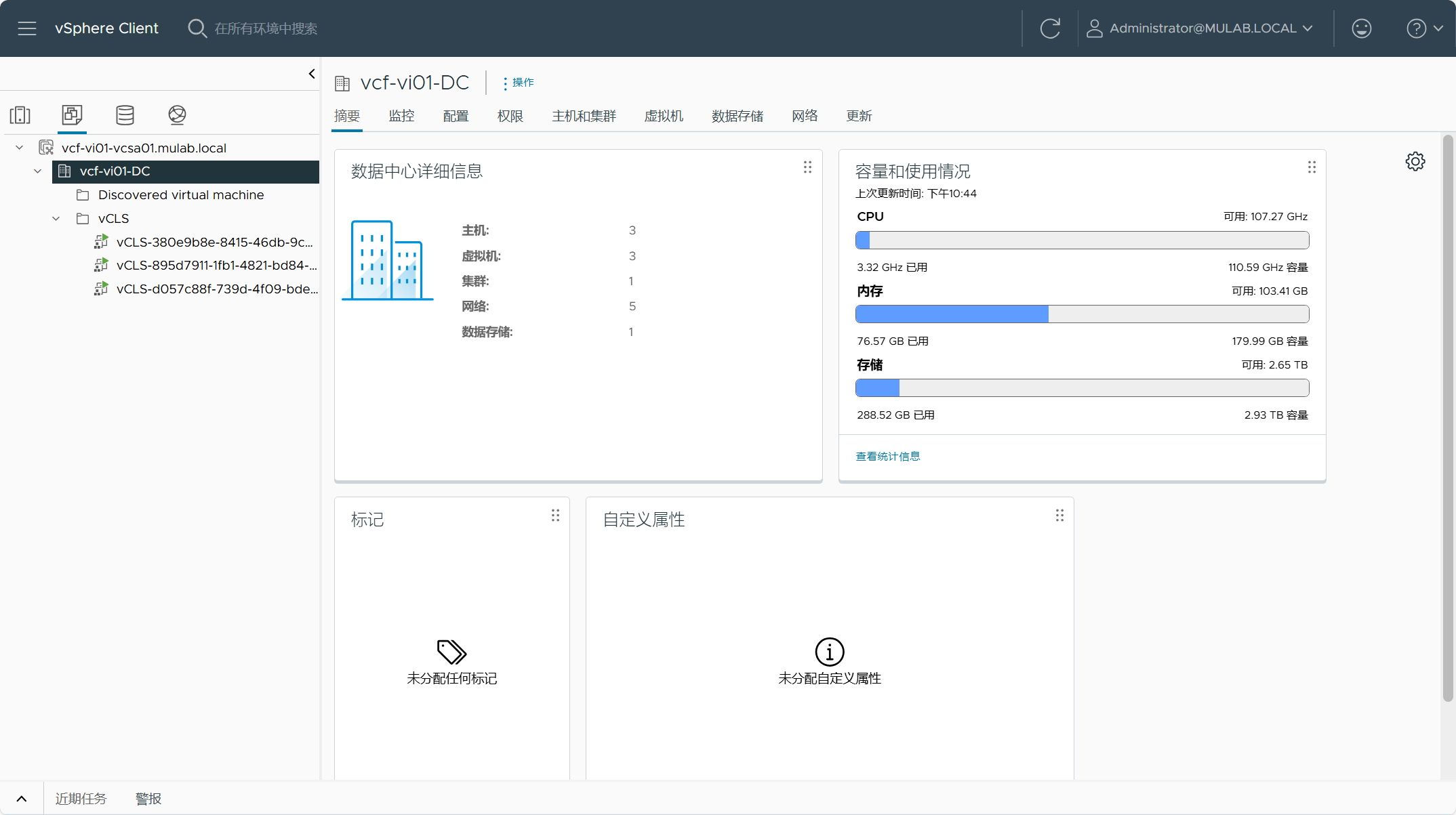

- VI 域 vCenter Server 中的虚拟机

- VI 域 vSAN ESA 存储池

- VI 域 VDS 分布式交换机配置

- VI 域 ESXi 主机交换机配置

【VMware VCF】VMware Cloud Foundation Part 06:部署 VI 工作负载域。的更多相关文章

- VMware Cloud Foundation 4.2 发布 - 领先的混合云平台

VMware Cloud Foundation 4.2 | 09 FEB 2021 | Build 17559673 VMware Cloud Foundation 4.1 | 06 OCT 2020 ...

- vmware vSphere client中,选择文件->部署OVF模板,报错处理方法

在vmware vSphere client中,选择文件->部署OVF模板,选择指定的OVA文件,按步骤进行,则会出现这样的错误:此OVF软件包使用了不受支持的功能.OVF软件包需要不支持的硬件 ...

- 2019-03-26 SpringBoot项目部署遇到跨域问题,记录一下解决历程

近期SpringBoot项目部署遇到跨域问题,记录一下解决历程. 要严格限制,允许哪些域名访问,在application.properties文件里添加配置,配置名可以自己起: cors.allowe ...

- 安装部署VMware vSphere 5.5文档 (6-3) 安装配置AD域控制器

部署VMware vSphere 5.5 实施文档 ########################################################################## ...

- VMware系统运维(十)部署虚拟化桌面 Horizon View 5.2 Connection Server安装

部署桌面虚拟化,首先得安装连接服务器,下面我们开始安装Connection Server. 1.下载并安装以下软件,提示:只能在Win2008R2上安装,Win2012R2无法安装. 2.双击打开程序 ...

- VMware系统运维(十七)部署虚拟化桌面 Horizon View Manager 5.2 配置池授权

1.先在域里面新建一个用户组,添加用户 2.点击"授权....",点击"添加...",设置指定的域用户组,点击"确定" 3.授权完成

- VMware系统运维(十三)部署虚拟化桌面 Horizon View Agent 5.2安装

1.先打开安装程序如下所示 2.点击"下一步" 3.不接受,你能装吗?点击"下一步" 4.选择安装位置,点击"下一步" 5.开启3389和3 ...

- VMware系统运维(十一)部署虚拟化桌面 Horizon View 5.2 HTML ACCESS安装

如果你希望在浏览器上面能够连接到用户桌面,那么HTML ACCESS是必须安装的,下面开始安装. 1.点击红框文件 2.打开安装向导,点击"下一步" 3.接受协议,点击" ...

- <实训|第二天>掌握linux6.7中安装vmware、vmware安装linux发行版本以及遇到的问题最后libreoffice的安装

期待已久的linux运维.oracle"培训班"终于开班了,我从已经开始长期四个半月的linux运维.oracle培训,每天白天我会好好学习,晚上回来我会努力更新教程,包括今天学到 ...

- 【VMware】VMware Workstation中虚拟机网络配置

一直用的vmware的虚拟机以及UVP还有cirtix的虚拟机,然后对vmware workstation却一窍不通,这个怎么了得,下面介绍一下我学习中遇到的问题及解决办法. 一.准备工作: vmwa ...

随机推荐

- 【jetson nano】yolov5环境配置tensorrt部署加速

安装pytorch Nano上预装的Jetpack版本为4.6.1,Python为3.6.9,CUDA环境为10.2.在PyTorch for Jetson中可以下载不同版本的torch,torch& ...

- 🐞vue兄弟组件中方法互相调用

场景:父组件中同时引入两个子组件(A和B),此时B组件点击按钮需要调用A组件里面的方法 方案1:vue的事件总线 方案2:自定义事件($emit) 最终方案:方案2 父组件 具体操作 B组件上添加一个 ...

- 15种pod的状态

15种pod的状态 调度失败 常见错误状态(Unschedulable) pod被创建后进入调度阶段,k8s调度器依据pod声明的资源请求量和调度规则,为pod挑选一个适合运行的节点.当集群节点不满足 ...

- Unity 3D 的NEW (堆内存)

用容器装 在AWEKE NEW 运行时NEW 会导致分配内存时界面卡住, new class 的时候 才刷新程序帧 AWEKE 是程序启动时还没走完第一帧的开头执行 AWEKE 里面的代码 常量也在A ...

- 使用Blazor WebAssembly整合PocketBase的基础项目模板

使用Blazor WebAssembly整合PocketBase的基础项目模板 在这篇博客文章中,我们将探讨如何创建一个集成PocketBase的基础Blazor WebAssembly项目.我们将涵 ...

- Github上优秀的.NET Core开源项目的集合【转】

一般 ASP.NET Core Documentation - 官方ASP.NET核心文档站点. .NET Core Documentation - .NET Core,C#,F#和Visual Ba ...

- 引入feign注入报错 org.springframework.beans.factory.NoSuchBeanDefinitionException解决

引入feign注入报错 org.springframework.beans.factory.NoSuchBeanDefinitionException解决 [172.16.22.215] out: C ...

- email邮件(带附件,模拟文件上传,跨服务器)发送核心代码 Couldn't connect to host, port: smtp.163.com, 25; timeout -1;

邮件(带附件,模拟文件上传,跨服务器)发送核心代码1.测试邮件发送附件接口 /** * 测试邮件发送附件 * @param multipartFile * @return */ @RequestMap ...

- 加速鸿蒙生态共建,蚂蚁mPaaS助力鸿蒙原生应用开发创新

6月21日-23日,2024华为开发者大会(HDC 2024)如期举行.在22日的[鸿蒙生态伙伴SDK]分论坛中,正式发布了[鸿蒙生态伙伴SDK市场],其中蚂蚁数科旗下移动开发平台mPaaS(以下简称 ...

- TensorFLow手写字识别深度学习网络分析详解

Tensorflow和MNIST简介 TensorFlow 是一个采用数据流图,用于数值计算的开源软件库.它是一个不严格的"神经网络"库,可以利用它提供的模块搭建大多数类型的神经网 ...