吴裕雄--天生自然 pythonTensorFlow图形数据处理:输入数据处理框架

import tensorflow as tf # 1. 创建文件列表,通过文件列表创建输入文件队列

files = tf.train.match_filenames_once("F:\\output.tfrecords")

filename_queue = tf.train.string_input_producer(files, shuffle=False)

#解析TFRecord文件里的数据。

# 读取文件。

reader = tf.TFRecordReader()

_,serialized_example = reader.read(filename_queue) # 解析读取的样例。

features = tf.parse_single_example(serialized_example,features={'image_raw':tf.FixedLenFeature([],tf.string),'pixels':tf.FixedLenFeature([],tf.int64),'label':tf.FixedLenFeature([],tf.int64)}) decoded_images = tf.decode_raw(features['image_raw'],tf.uint8)

retyped_images = tf.cast(decoded_images, tf.float32)

labels = tf.cast(features['label'],tf.int32)

#pixels = tf.cast(features['pixels'],tf.int32)

images = tf.reshape(retyped_images, [784])

#将文件以100个为一组打包。

min_after_dequeue = 10000

batch_size = 100

capacity = min_after_dequeue + 3 * batch_size

image_batch, label_batch = tf.train.shuffle_batch([images, labels], batch_size=batch_size,capacity=capacity, min_after_dequeue=min_after_dequeue)

# 训练模型。

def inference(input_tensor, weights1, biases1, weights2, biases2):

layer1 = tf.nn.relu(tf.matmul(input_tensor, weights1) + biases1)

return tf.matmul(layer1, weights2) + biases2

# 模型相关的参数

INPUT_NODE = 784

OUTPUT_NODE = 10

LAYER1_NODE = 500

REGULARAZTION_RATE = 0.0001

TRAINING_STEPS = 5000 weights1 = tf.Variable(tf.truncated_normal([INPUT_NODE, LAYER1_NODE], stddev=0.1))

biases1 = tf.Variable(tf.constant(0.1, shape=[LAYER1_NODE])) weights2 = tf.Variable(tf.truncated_normal([LAYER1_NODE, OUTPUT_NODE], stddev=0.1))

biases2 = tf.Variable(tf.constant(0.1, shape=[OUTPUT_NODE])) y = inference(image_batch, weights1, biases1, weights2, biases2) # 计算交叉熵及其平均值

cross_entropy = tf.nn.sparse_softmax_cross_entropy_with_logits(logits=y, labels=label_batch)

cross_entropy_mean = tf.reduce_mean(cross_entropy) # 损失函数的计算

regularizer = tf.contrib.layers.l2_regularizer(REGULARAZTION_RATE)

regularaztion = regularizer(weights1) + regularizer(weights2)

loss = cross_entropy_mean + regularaztion # 优化损失函数

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(loss) # 初始化会话,并开始训练过程。

with tf.Session() as sess:

# tf.global_variables_initializer().run()

sess.run((tf.global_variables_initializer(),tf.local_variables_initializer()))

coord = tf.train.Coordinator()

threads = tf.train.start_queue_runners(sess=sess, coord=coord)

# 循环的训练神经网络。

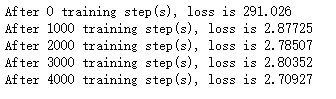

for i in range(TRAINING_STEPS):

if i % 1000 == 0:

print("After %d training step(s), loss is %g " % (i, sess.run(loss)))

sess.run(train_step)

coord.request_stop()

coord.join(threads)

吴裕雄--天生自然 pythonTensorFlow图形数据处理:输入数据处理框架的更多相关文章

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:循环神经网络预测正弦函数

import numpy as np import tensorflow as tf import matplotlib.pyplot as plt # 定义RNN的参数. HIDDEN_SIZE = ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:数据集高层操作

import tempfile import tensorflow as tf # 1. 列举输入文件. # 输入数据生成的训练和测试数据. train_files = tf.train.match_ ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:数据集基本使用方法

import tempfile import tensorflow as tf # 1. 从数组创建数据集. input_data = [1, 2, 3, 5, 8] dataset = tf.dat ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:图像预处理完整样例

import numpy as np import tensorflow as tf import matplotlib.pyplot as plt #随机调整图片的色彩,定义两种顺序. def di ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:TensorFlow图像处理函数

import numpy as np import tensorflow as tf import matplotlib.pyplot as plt #读取图片 image_raw_data = tf ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:windows操作系统删除tensorflow

输入:pip uninstall tensorflow Proceed(y/n):y

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:输入文件队列

import tensorflow as tf # 1. 生成文件存储样例数据. def _int64_feature(value): return tf.train.Feature(int64_li ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:多线程队列操作

import tensorflow as tf #1. 定义队列及其操作. queue = tf.FIFOQueue(100,"float") enqueue_op = queue ...

- 吴裕雄--天生自然 pythonTensorFlow图形数据处理:队列操作

import tensorflow as tf #1. 创建队列,并操作里面的元素. q = tf.FIFOQueue(2, "int32") init = q.enqueue_m ...

随机推荐

- logrotate+crond日志切割、轮询

logrotate 在工作中经常会有需求去查看日志,无论是通过应用或者系统error日志去查找问题或者通过nginx的访问日志统计站点日均PV.UV.所以体现了日志的重要性,但是通常当业务越来越大的时 ...

- Windows系统JDK环境变量配置

一.环境准备 Windows10 jdk1.8.0_144 二.下载并安装JDK 下载 密码: r5ym 三.环境变量配置 首先,打开控制面板>系统和安全>系统,点击高级系统设置进入系统属 ...

- 吴裕雄--天生自然 JAVASCRIPT开发学习:for 循环

<!DOCTYPE html> <html> <head> <meta charset="utf-8"> <title> ...

- SASS - 混合(Mixin)

SASS – 简介 SASS – 环境搭建 SASS – 使用Sass程序 SASS – 语法 SASS – 变量 SASS- 局部文件(Partial) SASS – 混合(Mixin) SASS ...

- Unity 协程运行时的监控和优化

我是快乐的搬运工: http://gulu-dev.com/post/perf_assist/2016-12-20-unity-coroutine-optimizing#toc_0 --------- ...

- Day 3:集合

数组: 存储同一种数据类型的集合容器数组的特点: 1. 只能存储同一种数据类型的数据. 2. 一旦初始化,长度固定. 3. 数组中的元素与元素之间的内存地址是连续的. 注意: Object类型的数组 ...

- EVANYOU尤大个人网站主页CANVAS三角彩带效果分析学习

尤雨溪网站三角彩带效果 效果: 源码 <!DOCTYPE html> <html lang="en"> <head> <meta char ...

- vue/cli创建项目过程

①vue create demo vue版本:3.9.3,node版本:12.8.0 ②Manually select features ③Bab ...

- 桥接 brctl

把eth0和wlan0桥接在一起 作用:测试wlan0网卡的并发性能 两个网卡桥接后把linux主机模拟成一个“无线路由交换机” Vi br0.sh #!/bin/bash ifconfig ...

- BZOJ 2285 [Sdoi2011]保密

题解: 求比值用分数规划,单个求太慢了套整体二分 然后求二分图最小割 // luogu-judger-enable-o2 #include<iostream> #include<cs ...