单向LSTM笔记, LSTM做minist数据集分类

单向LSTM笔记, LSTM做minist数据集分类

先介绍下torch.nn.LSTM()这个API

1.input_size: 每一个时步(time_step)输入到lstm单元的维度.(实际输入的数据size为[batch_size, input_size])

2. hidden_size: 确定了隐含状态hidden_state的维度. 可以简单的看成: 构造了一个权重, 隐含状态

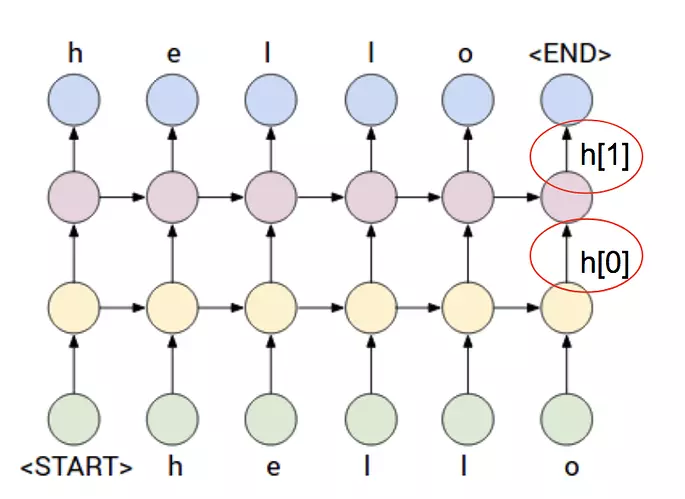

3 . num_layers: 叠加的层数。如图所示num_layers为 3

4. batch_first: 输入数据的size为[batch_size, time_step, input_size]还是[time_step, batch_size, input_size]

使用单向LSTM对MNIST进行分类,我是在pytorch0.4.1坂本上运行的。

########################## pytorch 用LSTM做minist数据分类 ##################

##########################################################################

import torch

import torch.utils.data as Data

import torchvision

import matplotlib.pyplot as plt

import numpy as np BATCH_SIZE = 50 class RNN(torch.nn.Module):

def __init__(self):

super().__init__()

self.rnn = torch.nn.LSTM(

input_size=28,

hidden_size=64,

num_layers=1,

batch_first=True

)

self.out = torch.nn.Linear(in_features=64, out_features=10) def forward(self, x):

# 一下关于shape的注释只针对单向

# output: [batch_size, time_step, hidden_size]

# h_n: [num_layers,batch_size, hidden_size] # 虽然LSTM的batch_first为True,但是h_n/c_n的第一维还是num_layers

# c_n: 同h_n

output, (h_n, c_n) = self.rnn(x)

#print(output.size())

# output_in_last_timestep=output[:,-1,:] # 也是可以的

output_in_last_timestep = h_n[-1, :, :]

# print(output_in_last_timestep.equal(output[:,-1,:])) # ture

x = self.out(output_in_last_timestep)

return x if __name__ == "__main__":

# 1. 加载数据

training_dataset = torchvision.datasets.MNIST("./mnist", train=True,

transform=torchvision.transforms.ToTensor(), download=True)

dataloader = Data.DataLoader(dataset=training_dataset,

batch_size=BATCH_SIZE, shuffle=True, num_workers=2)

# showSample(dataloader)

test_data = torchvision.datasets.MNIST(root="./mnist", train=False,

transform=torchvision.transforms.ToTensor(), download=False)

test_dataloader = Data.DataLoader(

dataset=test_data, batch_size=1000, shuffle=False, num_workers=2)

testdata_iter = iter(test_dataloader)

test_x, test_y = testdata_iter.next()

test_x = test_x.view(-1, 28, 28)

# 2. 网络搭建

net = RNN()

# 3. 训练

# 3. 网络的训练(和之前CNN训练的代码基本一样)

optimizer = torch.optim.Adam(net.parameters(), lr=0.001)

loss_F = torch.nn.CrossEntropyLoss()

for epoch in range(3): # 数据集只迭代一次

for step, input_data in enumerate(dataloader):

x, y = input_data

pred = net(x.view(-1, 28, 28))

loss = loss_F(pred,y) # 计算loss

optimizer.zero_grad()

loss.backward()

optimizer.step()

if step % 50 == 49: # 每50步,计算精度

with torch.no_grad():

test_pred = net(test_x)

prob = torch.nn.functional.softmax(test_pred, dim=1)

pred_cls = torch.argmax(prob, dim=1)

acc = (pred_cls == test_y).sum().numpy() / pred_cls.size()[0]

print(f"{epoch}-{step}: accuracy:{acc}")

由上面代码可以看到输出为:output,(h_n,c_n)=self.rnn(x),解释下代码中的第28行。

output: 如果num_layer为3,则output只记录最后一层 --------- 第三层的输出。

- 对应图中向上的h_t

- 其size根据

batch_first而不同。可能是[batch_size, time_step, hidden_size]或[time_step, batch_size, hidden_size]

h_n: 各个层的最后一个时步的隐含状态

h.- size为

[num_layers,batch_size, hidden_size] - 对应图中向右的h_t. 可以看出对于单层单向的LSTM, 其

h_n最后一层输出h_n[-1,:,:],和output最后一个时步的输出output[:,-1,:]相等。在示例代码中print(h_n[-1,:,:].equal(output[:,-1,:]))会打印True

- size为

c_n: 各个层的最后一个时步的隐含状态

C- c_n可以看成另一个隐含状态,size和

h_n相同

- c_n可以看成另一个隐含状态,size和

我运行了3个epoch效果如下:

0-49: accuracy:0.3

0-99: accuracy:0.596

0-149: accuracy:0.697

0-199: accuracy:0.734

0-249: accuracy:0.769

0-299: accuracy:0.782

0-349: accuracy:0.751

0-399: accuracy:0.843

0-449: accuracy:0.859

0-499: accuracy:0.87

0-549: accuracy:0.857

0-599: accuracy:0.89

0-649: accuracy:0.88

0-699: accuracy:0.883

0-749: accuracy:0.905

0-799: accuracy:0.905

0-849: accuracy:0.902

0-899: accuracy:0.901

0-949: accuracy:0.908

0-999: accuracy:0.921

0-1049: accuracy:0.917

0-1099: accuracy:0.906

0-1149: accuracy:0.941

0-1199: accuracy:0.935

1-49: accuracy:0.935

1-99: accuracy:0.936

1-149: accuracy:0.941

1-199: accuracy:0.923

1-249: accuracy:0.94

1-299: accuracy:0.936

1-349: accuracy:0.941

1-399: accuracy:0.948

1-449: accuracy:0.937

1-499: accuracy:0.939

1-549: accuracy:0.949

1-599: accuracy:0.949

1-649: accuracy:0.953

1-699: accuracy:0.947

1-749: accuracy:0.918

1-799: accuracy:0.944

1-849: accuracy:0.957

1-899: accuracy:0.959

1-949: accuracy:0.947

1-999: accuracy:0.944

1-1049: accuracy:0.961

1-1099: accuracy:0.964

1-1149: accuracy:0.961

1-1199: accuracy:0.952

2-49: accuracy:0.95

2-99: accuracy:0.952

2-149: accuracy:0.957

2-199: accuracy:0.945

2-249: accuracy:0.957

2-299: accuracy:0.953

2-349: accuracy:0.956

2-399: accuracy:0.942

2-449: accuracy:0.946

2-499: accuracy:0.962

2-549: accuracy:0.956

2-599: accuracy:0.957

2-649: accuracy:0.953

2-699: accuracy:0.958

2-749: accuracy:0.963

2-799: accuracy:0.959

2-849: accuracy:0.954

2-899: accuracy:0.961

2-949: accuracy:0.959

2-999: accuracy:0.961

2-1049: accuracy:0.962

2-1099: accuracy:0.958

2-1149: accuracy:0.955

2-1199: accuracy:0.964

主要参考:https://www.jianshu.com/p/043083d114d4

单向LSTM笔记, LSTM做minist数据集分类的更多相关文章

- TensorFlow笔记三:从Minist数据集出发 两种经典训练方法

Minist数据集:MNIST_data 包含四个数据文件 一.方法一:经典方法 tf.matmul(X,w)+b import tensorflow as tf import numpy as np ...

- 做一个logitic分类之鸢尾花数据集的分类

做一个logitic分类之鸢尾花数据集的分类 Iris 鸢尾花数据集是一个经典数据集,在统计学习和机器学习领域都经常被用作示例.数据集内包含 3 类共 150 条记录,每类各 50 个数据,每条记录都 ...

- UFLDL深度学习笔记 (四)用于分类的深度网络

UFLDL深度学习笔记 (四)用于分类的深度网络 1. 主要思路 本文要讨论的"UFLDL 建立分类用深度网络"基本原理基于前2节的softmax回归和 无监督特征学习,区别在于使 ...

- 用CNN及MLP等方法识别minist数据集

用CNN及MLP等方法识别minist数据集 2017年02月13日 21:13:09 hnsywangxin 阅读数:1124更多 个人分类: 深度学习.keras.tensorflow.cnn ...

- Python实现鸢尾花数据集分类问题——基于skearn的NaiveBayes

Python实现鸢尾花数据集分类问题——基于skearn的NaiveBayes 代码如下: # !/usr/bin/env python # encoding: utf-8 __author__ = ...

- Python实现鸢尾花数据集分类问题——基于skearn的LogisticRegression

Python实现鸢尾花数据集分类问题——基于skearn的LogisticRegression 一. 逻辑回归 逻辑回归(Logistic Regression)是用于处理因变量为分类变量的回归问题, ...

- Python实现鸢尾花数据集分类问题——基于skearn的SVM

Python实现鸢尾花数据集分类问题——基于skearn的SVM 代码如下: # !/usr/bin/env python # encoding: utf-8 __author__ = 'Xiaoli ...

- 机器学习与Tensorflow(3)—— 机器学习及MNIST数据集分类优化

一.二次代价函数 1. 形式: 其中,C为代价函数,X表示样本,Y表示实际值,a表示输出值,n为样本总数 2. 利用梯度下降法调整权值参数大小,推导过程如下图所示: 根据结果可得,权重w和偏置b的梯度 ...

- BP算法在minist数据集上的简单实现

BP算法在minist上的简单实现 数据:http://yann.lecun.com/exdb/mnist/ 参考:blog,blog2,blog3,tensorflow 推导:http://www. ...

随机推荐

- linux服务器性能——CPU、内存、流量、磁盘使用率的监控

https://blog.csdn.net/u012859748/article/details/72731080

- [warn] 7#7: *676 a client request body is buffered to a temporary file /var/cache/nginx/client_temp/0000000007

nginx 上传文件遇到的Bug. fastcgi_buffer_size 128k; fastcgi_buffers 8 128k; fastcgi_busy_buffers_size 128k; ...

- MySQL主从备份配置实例

转载自:https://www.cnblogs.com/ahaii/p/6307648.html MySQL主从备份配置实例 场景: 1.主服务器192.168.0.225.从服务器192.168.0 ...

- [转] 浅析JavaScript设计模式——发布-订阅/观察者模式

前一段时间一直在写CSS3的文章 一直都没写设计模式 今天来写写大名鼎鼎观察者模式 先画张图 观察者模式的理解 我觉得还是发布-订阅模式的叫法更容易我们理解 (不过也有的书上认为它们是两种模式……) ...

- 《深入探索Netty原理及源码分析》文集小结

<深入探索Netty原理及源码分析>文集小结 https://www.jianshu.com/p/239a196152de

- 调整LaTeX文档页面的大小

看下面这张图片便一目了然!!! 借助 geometry 包,可以很方便地调整页面大小,常用的参数如图所示,这些参数都可以通过LateX支持的单位(mm, cm, pt, in)去重新设置. ...

- bzoj2683&&bzoj4066

题解: 前一题不是强制在线,后一题是强制在线 树套树空间会炸 说一下cdq分治+树状数组 首先我们利用cdq分治使得查询和操作保证先后关系 然后矩阵查询变成4个矩阵的差 那么我们就可以运用扫描线的方法 ...

- Web Deploy发布网站错误 检查授权和委派设置

web Deploy发布asp.net网站给我们提供方便,开始配置好了可以方便的发布网站,但是过久就出现无法执行此操作.请与服务器管理员联系,检查授权和委派设置.花了好长时间找到问问所在.现在解决方法 ...

- 基于springboot通过自定义注解和AOP实现权限验证

一.移入依赖 <parent> <groupId>org.springframework.boot</groupId> <artifactId>spri ...

- Codeforces 639D Bear and Contribution

Bear and Contribution 对于对于5余数为, 0, 1, 2, 3, 4的分别处理一次, 用优先队列贪心. #include<bits/stdc++.h> #define ...