Ceph块存储介绍

1. 块存储是什么

块存储简称RBD(RADOS Block Device),是一种有序的字节序块,也是在Ceph三大存储类型中最为常用的存储方式 ,Ceph的块存储是基于RADOS的,因此它也借助RADOS的快照、复制和一致性等特性提供了快照、克隆和备份等操作。Ceph的块设备是一种精简置备模式,可以拓展块存储的大小且存储的数据以条带化的方式存储到Ceph集群中的多个OSD中。

2. 访问块存储的方式

访问块存储的方式有两种,分别是KRBD的方式和librbd的方式。

2.1 KRBD方式

KRBD是Kernel RADOS Block Device的简称,它是通过Kernel模块中的RBD模块来实现访问后端存储的,在使用前需要先使用modprobe命令将内核中RBD模块进行加载,同时对内核版本也是有要求的,需要内核的版本不低于3.10,因为比这个版本低的内核还没将RBD模块集成到内核中,因此如果是CentOS6.x的一般需要先升下内核版本。

KRBD访问后端存储的方式一般适用于为物理主机提供的块设备,这种方式是基于内核模块驱动的,可以使用Linux自带的页缓存来提高性能。

以下是通过KRBD模块访问Ceph后端块设备的一些命令操作。

modprobe rbd # 加载RBD内核模块

modinfo rbd # 查看rbd模块信息

rbd create image_name --size 10240 # 创建一个10G大小的名为image_name的块设备

rbd list # 列出存储池中的所有块设备,没有指定存储池,默认使用rbd存储池,可以使用-p选项来指定存储池

rbd info image_name # 显示出image_name块设备的信息

rbd map image_name # 将image_name块设备映射到系统中

rbd showmapped # 查看系统中已经映射的块设备

rbd unmap /dev/xxx # 取消掉块设备的映射

2.2 librbd方式

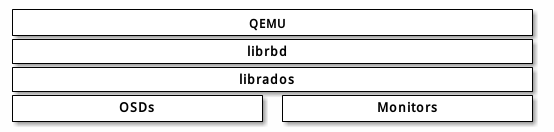

librbd是一个访问rbd块存储的库,它是基于librados库进行的更高一层的封装,所以librbd是通过librados库来与块存储的数据进行交互的。

使用librbd访问块存储的方式适用于为虚拟机提供块设备的方式,可以使用RBD缓存来提高性能,比如在qemu+kvm虚拟框架中提供的虚拟机,qemu可以通过librbd来访问后端存储,以下是访问的模型图:

要通过qemu来将块设备提供给客户机,也就是我们说的虚拟机,需要指定存储池名和映像名

命令格式类似如下:

qemu-img {command} [options] rbd:{pool-name}/{image-name}[@snapshot-name][:option1=value1][:option2=value2...]

举例:

qemu-img {command} [options] rbd:glance-pool/maipo:id=glance:conf=/etc/ceph/ceph.conf

举例:

qemu -m 1024 -drive format=raw,file=rbd:data/squeeze:rbd_cache=true,cache=writeback

3. RBD的一些常用操作和命令

有关存储池的操作:

部署好Ceph集群后,默认都会生成一个名为rbd的存储池

ceph osd lspools # 来查看当前存储的存储池

ceph osd pool create {pool-name} {pg-num} {pgp-num} # 创建存储池

ceph df # 查看存储池统计信息

ceph osd pool set {pool-name} {key} {value} # 调整存储池的选项值

有关image创建和查看的操作:

rbd create pool/image1 --size 1024 --image-format 2 # 在pool存储池中创建1GB大小的image

rbd ls pool-name # 查看pool-name存储池中的image

rbd info pool-name/image1 # 查看image1的详细信息

rbd rm pool-name/image1 # 删除image1

有关快照的操作:

rbd snap create pool-name/image1@image1_snap # 创建image1的快照

rbd snap list pool-name/image1 # 列出image1的所有快照

rbd info pool-name/image1@image1_snap # 查看快照的详细信息

有关克隆的操作:

在克隆前,快照必须处于被保护的状态才能够被克隆。

rbd snap protect pool-name/image1@image1_snap # 将快照置于保护状态

rbd clone pool-name/image1@image1_snap pool-name/image2 # 将快照克隆成一个image2

image2是依赖于image1的快照的,可以称image2是image1_snap的children

rbd children pool-name/image1@image1_snap # 查看该快照的children

要是想要让image2不再依赖于image1_snap,则需要使用如下命令将分层的image2变为扁平的没有层级的image

rbd flatten pool-name/image2

有关备份和恢复的操作:

rbd export pool-name/image1 image1_export # 导出image1

rbd import image1_export pool-name/image3 --image-format 2 # 导入备份的文件保存为image3

4. qemu-kvm如何访问块存储

这里介绍的是通过LIBRBD的方式访问RBD块存储。

(1)检测操作系统的KVM虚拟化是否支持RBD块存储

使用命令:

qemu-img --help |grep rbd

如果输出的内容中出现了rbd关键词,则说明当前qemu-kvm或者qemu-system-x86_64支持RBD块存储。

(2)使用块存储

把/etc/ceph/ceph.conf文件拷贝到目的节点相同的路径位置,这样该节点的qemu-img工具就会使用该文件作为默认配置文件。

如果ceph集群开启了cephx认证,则需要创建客户端访问权限,在我的ceph配置为openstack的后端存储中有说明如何创建这个权限,还有生成秘钥并导入libvirt也有说明:配置Ceph集群为OpenStack后端存储

最后会生成一个xml格式的文件,里面定义了需要访问块存储的各种信息,由libvirt来将其转换为对应的命令行以使得qemu-kvm进程可以访问块存储,从而虚拟机可以访问块存储。

Ceph块存储介绍的更多相关文章

- 二十八. Ceph概述 部署Ceph集群 Ceph块存储

client :192.168.4.10 node1 :192.168.4.11 ndoe2 :192.168.4.12 node3 :192.168.4.13 1.实验环境 准备四台KVM虚 ...

- Ceph 块存储

任何普通的linux主机都可以充当ceph客户机,客户机通过网络与ceph存储集群交互以存储或检索用户数据.Ceph RBD支持已经添加到linux主线内核中,从2.6.34以及以后版本开始. === ...

- ceph块存储场景

1.创建rbd使用的存储池. admin节点需要安装ceph才能使用该命令,如果没有,也可以切换到ceph-node1节点去操作. [cephfsd@ceph-admin ceph]$ ceph os ...

- Ceph 块存储 创建的image 映射成块设备

将创建的volume1映射成块设备 [root@mysql-server ceph]# rbd map rbd_pool/volume1 rbd: sysfs write failed RBD ima ...

- Ceph基本情况介绍

Ceph基本情况的介绍 Ceph是一个分布式存储软件. 它支持用3种方式存储数据,分别是:对象存储.块设备存储.分布式文件系统存储. Ceph最初的目标是做一个分布式文件系统,直到现在这个目标也不能算 ...

- ceph rbd块存储挂载及文件存储建立

一.rbd块存储挂载 1 创建一个OSD pool # ceph osd pool create rbd1 128 查询存储空间使用 # ceph df GLOBAL: SIZE AVAIL RAW ...

- Ceph14.2.5 RBD块存储的实战配置和详细介绍,不看后悔! -- <3>

Ceph RBD介绍与使用 RBD介绍 RBD即RADOS Block Device的简称,RBD块存储是最稳定且最常用的存储类型.RBD块设备类似磁盘可以被挂载. RBD块设备具有快照.多副本.克隆 ...

- [ ceph ] BlueStore 存储引擎介绍

为什么需要 BlueStore 首先,Ceph原本的FileStore需要兼容Linux下的各种文件系统,如EXT4.BtrFS.XFS.理论上每种文件系统都实现了POSIX协议,但事实上,每个文件系 ...

- 我们为什么选择Ceph来建立块存储

我们为什么选择Ceph来建立块存储?国内知名黑客组织东方联盟是这样回答的,卷管理器的大小和增长受到管理程序的驱动器补充的限制,与其他Droplet共享.一旦Droplet被摧毁,储存就会被释放.术语“ ...

随机推荐

- [硬件知识]OP(Over-provisioning)预留空间

SSD上的OP指的是用户不可操作的容量,大小为实际容量减去用户可用容量,OP区域一般被用于优化操作如:WL,GC和坏块映射等. OP一般分三层(见下图).第一层容量固定为SSD标称容量的7.37%,这 ...

- CLR via C# 读书笔记-26.线程基础

前言 这俩个月没怎么写文章做记录分享,一直在忙项目上线的事情,但是学习这件事情,停下来就感觉难受,clr线程这章也是反复看了好多遍,书读百遍其义自见,今天我们来聊下线程基础 1.进程是什么,以及线程起 ...

- 自己写一个java的mvc框架吧(一)

自己写一个mvc框架吧(一) 目录 自己写一个mvc框架吧(一) 自己写一个mvc框架吧(二) 自己写一个mvc框架吧(三) 自己写一个mvc框架吧(四) 写之前的一些废话 废话 1 (总是要先随便说 ...

- python之协程gevent模块

Gevent官网文档地址:http://www.gevent.org/contents.html 进程.线程.协程区分 我们通常所说的协程Coroutine其实是corporate routine的缩 ...

- QT的信号和槽机制简介

信号与槽作为QT的核心机制在QT编程中有着广泛的应用,本文介绍了信号与槽的一些基本概念.元对象工具以及在实际使用过程中应注意的一些问题. QT是一个跨平台的C++ GUI应用构架,它提供了丰富的窗口部 ...

- 备忘:CSS术语词汇表——张鑫旭

一.叨点什么 写文章的时候经常用到一些CSS方面的专业词汇.但是毕竟芳华年少不在,脑袋有点秀逗了,很多名词都记不住,这种感觉比厕所便秘还难受.比如今天居然记不起来公司公认脸蛋最pp的同事的名字,没想到 ...

- CSS关于文本渲染的属性text-rendering

CSS关于文本渲染的属性text-rendering告诉渲染引擎工作时如何优化显示文本. 浏览器会在渲染速度.易读性(清晰度)和几何精度方面做一个权衡. 我们知道,SVG-可缩放矢量图形(Scalab ...

- css3 3d正反面翻转

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- 如何解决css-子div设置margin-top后,父div与子div一起下移的bug?

根据规范,一个盒子如果没有上补白(padding-top)和上边框(border-top),那么这个盒子的上边距会和其内部文档流中的第一个子元素的上边距重叠. 这是规范引起的普遍问题. 只要给父盒子设 ...

- SwipeRefreshLayout的高度测量

感谢此作者的分享 http://www.cnblogs.com/linjzong/p/5221604.html 若SwipeRefreshLayout的子布局为一个线性布局LinearLayout, ...