用MapReduce读HBase写MongoDB样例

1、版本信息:

Hadoop版本:2.7.1

HBase版本:1.2.1

MongDB版本:3.4.14

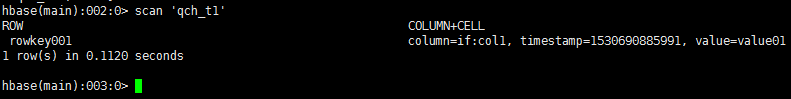

2、HBase表名及数据:

3、Maven依赖:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.1</version>

</dependency>

<dependency>

<groupId>org.mongodb</groupId>

<artifactId>mongo-java-driver</artifactId>

<version>3.4.3</version>

</dependency>

<dependency>

<groupId>org.mongodb.mongo-hadoop</groupId>

<artifactId>mongo-hadoop-core</artifactId>

<version>2.0.2</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-client</artifactId>

<version>1.1.1</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-server</artifactId>

<version>1.1.1</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-common</artifactId>

<version>1.1.1</version>

</dependency>

4、MapReduce程序:

package mapreduce; import com.mongodb.BasicDBObject;

import com.mongodb.hadoop.MongoOutputFormat;

import com.mongodb.hadoop.io.BSONWritable;

import com.mongodb.hadoop.util.MongoConfigUtil;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.mapreduce.TableMapReduceUtil;

import org.apache.hadoop.hbase.mapreduce.TableMapper;

import org.apache.hadoop.hbase.util.Bytes;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job; import java.io.IOException;

import java.util.UUID; public class HBaseToMongo {

public static void main(String[] args) throws Exception {

Long st = System.currentTimeMillis(); Configuration config = new Configuration();

config.set("dfs.socket.timeout", "180000");

config.set("hbase.zookeeper.property.clientPort", "2181");

config.set("hbase.zookeeper.quorum", "10.11.2.4,10.11.2.5,10.11.2.6"); // The format of the URI is:

// mongodb://[username:password@]host1[:port1][,host2[:port2],...[,hostN[:portN]]][/[database][?options]]

String uri = "mongodb://10.11.2.15:27017,10.11.2.16:27017,10.11.2.17:27017/postal.qch_test";

MongoConfigUtil.setOutputURI(config, uri); Job job = Job.getInstance(config);

job.setJobName("HBaseToMongo");

job.setJarByClass(FilterMapper.class);

job.setOutputFormatClass(MongoOutputFormat.class);

job.setNumReduceTasks(0);

TableMapReduceUtil.initTableMapperJob("qch_t1", new Scan(),

FilterMapper.class, ImmutableBytesWritable.class, BSONWritable.class, job); System.exit( job.waitForCompletion( true ) ? 0 : 1 );

System.out.println("HBaseToMongo:" + (System.currentTimeMillis() - st));

} static class FilterMapper extends TableMapper<Text, BSONWritable> {

@Override

protected void map(ImmutableBytesWritable key,

Result value, Context context) throws IOException, InterruptedException {

String col = getStrByByte(value.getValue("if".getBytes(), "col1".getBytes()));

BSONWritable bsonWritable = new BSONWritable();

BasicDBObject doc = new BasicDBObject();

doc.put("_id", UUID.randomUUID().toString());

doc.put("col", col);

bsonWritable.setDoc(doc);

context.write(new Text(key.toString()), bsonWritable);

} private String getStrByByte(byte[] by) {

String str = "";

if (by != null && by.length > 0) {

str = Bytes.toString(by);

}

return str;

}

}

}

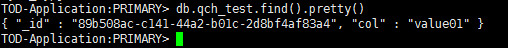

5、运行结果:

6、程序源码:

用MapReduce读HBase写MongoDB样例的更多相关文章

- Spark读HBase写MySQL

1 Spark读HBase Spark读HBase黑名单数据,过滤出当日新增userid,并与mysql黑名单表内userid去重后,写入mysql. def main(args: Array[Str ...

- HBase Filter程序样例及Shell(图)

==过滤器执行流程== reset() : reset the filter state before filtering a new row. filterAllRemaining(): true ...

- hbase java api样例(版本1.3.1,新API)

hbase版本:1.3.1 目的:HBase新API的使用方法. 尝试并验证了如下几种java api的使用方法. 1.创建表 2.创建表(预分区) 3.单条插入 4.批量插入 5.批量插入(客户端缓 ...

- Spring-boot+Spring-batch+hibernate+Quartz简单批量读文件写数据用例

本文程序集成了Spring-boot.Spring-batch.Spring-data-jpa.hibernate.Quartz.H2等.完整代码在Github上共享,地址https://github ...

- Java连接MongoDB样例

package com.moonlit.example; import com.mongodb.BasicDBObject; import com.mongodb.BulkWriteOperation ...

- MapReduce计算每年最大值测试样例生成程序

Demo.java package com.java; import java.io.BufferedWriter; import java.io.File; import java.io.FileW ...

- 使用SALT-API进入集成开发的简单样例

测试的时候,可以CURL -K,但真正作集成的时候,却是不可以的. 必须,不可以让TOKEN满天飞吧. 现在进入这个阶段了.写个样例先: import salt import salt.auth im ...

- hdu1011(树形背包)(提供一个特殊样例)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=1011 Starship Troopers Time Limit: 10000/5000 MS (Jav ...

- hadoop学习;block数据块;mapreduce实现样例;UnsupportedClassVersionError异常;关联项目源代码

对于开源的东东,尤其是刚出来不久,我认为最好的学习方式就是能够看源代码和doc,測试它的样例 为了方便查看源代码,关联导入源代码的项目 先前的项目导入源代码是关联了源代码文件 block数据块,在配置 ...

随机推荐

- windows server 2008 r2 修改远程登入的端口号(3389)

步骤:打开“开始→运行”,输入“regedit”,打开注册表,进入以下路径:[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\Terminal ...

- gcc编译器配置

一.使用交叉编译器编译 1.安装交叉编译工具链 2.导出环境变量 [ubuntu @tmp]$ export PATH=$PATH:/usr/local/oecore-x86_64/sysroots/ ...

- bzoj1037生日聚会

题目:https://www.lydsy.com/JudgeOnline/problem.php?id=1037 任意区间的话,可以从所有后缀区间考虑. 因为每一个区间一定是某一时刻的一个后缀区间,所 ...

- 对类 sizeof

sizeof一个类的时候,都什么会被计算?静态成员会被计算进来么?如果这是一个子类,它的父类成员会被计算么? #include <iostream> using namespace std ...

- 利用WeX5给手机APP增加短信验证码功能

帖子来源:http://bbs.wex5.com/thread-70908-1-1.html 遇到一个手机APP项目客户要求注册到APP上的用户手机号必须是真实的通过X5平台整合短信发送平台接口完成了 ...

- java web Servlet开发(一)

一.Servlet简介 Servlet是sun公司提供的一门用于开发动态web资源的技术. Sun公司在其API中提供了一个servlet接口,用户若想用发一个动态web资源(即开发一个Java程序向 ...

- VBA7种文档遍历法

Sub 在选定文档最后加入一句话() '遍历文件 Dim MyDialog As FileDialog On Error Resume Next Application.ScreenUpdating ...

- 在eclipse中使用mybatis-generator自动创建代码

1.eclipse中安装插件,地址:http://mybatis.googlecode.com/svn/sub-projects/generator/trunk/eclipse/UpdateSite/ ...

- 第九章 自定义mixer adapter

1 install/kubernetes/helm/istio/templates/crds.yaml 序号 名称 用途 分类 归属 virtualservices.networking.istio. ...

- Django学习---Form组件认证

Form组件认证 能够帮助我们做用户认证. 以前写我们自己写用户认证的时候,我们自己写HTML的form表单,点击提交,数据就被发送到后台,后台进行验证.在验证过程中我们就需要自己去写正则表达式去匹配 ...