IDEA 创建HDFS项目 JAVA api

1.创建quickMaven

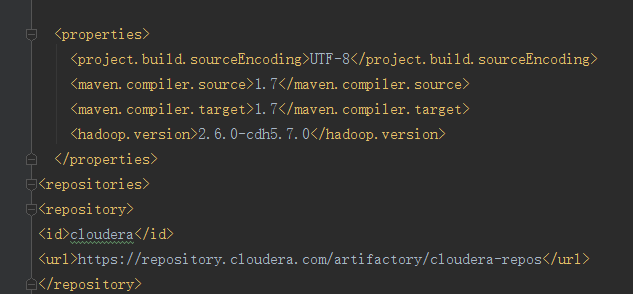

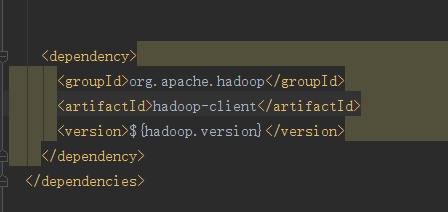

1.在properties中写hadoop 的版本号并且通过EL表达式的方式映射到dependency中

2.写一个repostory将依赖加载到本地仓库中

这是加载完成的页面

这是开发代码

package com.kevin.hadoop; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.util.Progressable;

import org.junit.After;

import org.junit.Before;

import org.junit.Test; import java.io.BufferedInputStream;

import java.io.File;

import java.io.FileInputStream;

import java.io.InputStream;

import java.net.URI; /**

* Created by Administrator on 2018/7/21 0021.

* Hadoop HDFS java API 操作

*/

public class HDFSApp {

public static final String HDFS_PATH = "hdfs://hadoop000:8020";

//文件系统

FileSystem fileSystem = null;

//配置类

Configuration configuration = null; //Before适用于类加载之前

@Test

/**

* 创建HDFS系统

*/

public void mkdir() throws Exception {

fileSystem.mkdirs(new Path("/hdfsapi/test"));

} @Test

public void create() throws Exception {

FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/a.txt"));

output.write("hello hadoop".getBytes());

output.flush();

output.close();

} @Test

/**

* 查看HDFS文件上的内容

*/

public void cat() throws Exception {

FSDataInputStream in = fileSystem.open(new Path("/hdfsapi/test/a.txt"));

IOUtils.copyBytes(in, System.out, 1024);

in.close();

} @Before

public void setUp() throws Exception {

System.out.printf("HDFSapp.setup");

configuration = new Configuration();

//拿到文件系统

fileSystem = FileSystem.get(new URI(HDFS_PATH), configuration, "hadoop");

} //关闭资源用的这个

@After

public void tearDown() throws Exception {

//释放资源

configuration = null;

fileSystem = null;

System.out.printf("HDFSAPP.tearDown");

} /**

* 重命名文件

*/

@Test

public void rename() throws Exception {

Path oldPath = new Path("/hdfsapi/test/a.txt");

Path newPath = new Path("/hdfsapi/test/b.txt");

fileSystem.rename(oldPath, newPath);

} /**

* 上传一个文件

*

* @throws Exception

*/

@Test

public void copyFromLocalFile() throws Exception {

Path localPath = new Path(" //c//hello.txt");

Path hdfsPath = new Path("/hdfsapi/test");

fileSystem.copyFromLocalFile(localPath, hdfsPath);

} /**

* 上传一个大文件

*

* @throws Exception

*/

@Test

public void copyFromLocalBigFile() throws Exception {

InputStream in = new BufferedInputStream(

new FileInputStream(

new File("C:\\mmall-fe\\all.zip"))); FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/all.zip"),

new Progressable() {

public void progress() {

System.out.print("."); //带进度提醒信息

}

}); IOUtils.copyBytes(in, output, 4096);

}

/**

* 下载HDFS文件

*/

@Test

public void copyTOLocalFile() throws Exception{

Path localPath = new Path("C:\\test\\b.txt");

Path hdfsPath = new Path("/hdfsapi/test/hello.txt");

fileSystem.copyToLocalFile(false,hdfsPath,localPath,true);

}

@Test

public void listFiles() throws Exception {

FileStatus[] fileStatuses = fileSystem.listStatus(new Path("/hdfsapi/test")); for (FileStatus fileStatus : fileStatuses) {

String isDir = fileStatus.isDirectory() ? "文件夹" : "文件";

//副本

short replication = fileStatus.getReplication();

//大小

long len = fileStatus.getLen();

//路径

String path = fileStatus.getPath().toString(); System.out.println(isDir + "\t" + replication + "\t" + len + "\t" + path);

}

}

@Test

public void delete() throws Exception{

fileSystem.delete(new Path("hdfsapi/test/"),true);

}

} 注意在查询文件的副本系数时如果是通过hadoop sell put上去的文件副本系数在伪分布式中是1,如果说是通过java api put上去的则副本系数是1,因为我们并没有在本地设置自己的副本系数,所以hadoop采用自己的副本系数

IDEA 创建HDFS项目 JAVA api的更多相关文章

- HDFS中JAVA API的使用

HDFS中JAVA API的使用 HDFS是一个分布式文件系统,既然是文件系统,就可以对其文件进行操作,比如说新建文件.删除文件.读取文件内容等操作.下面记录一下使用JAVA API对HDFS中的 ...

- HDFS的Java API

HDFS Java API 可以用于任何Java程序与HDFS交互,该API使我们能够从其他Java程序中利用到存储在HDFS中的数据,也能够使用其他非Hadoop的计算框架处理该数据 为了以编程方式 ...

- Hadoop之HDFS(三)HDFS的JAVA API操作

HDFS的JAVA API操作 HDFS 在生产应用中主要是客户端的开发,其核心步骤是从 HDFS 提供的 api中构造一个 HDFS 的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS ...

- Hadoop(五):HDFS的JAVA API基本操作

HDFS的JAVA API操作 HDFS在生产应用中主要是客户端的开发,其核心步骤是从HDFS提供的api中构造一个HDFS的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS上的文件. 主 ...

- HDFS的java api操作

hdfs在生产应用中主要是针对客户端的开发,从hdfs提供的api中构造一个HDFS的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS上的文件. 搭建开发环境 方式一(windows环境下 ...

- [转]HDFS中JAVA API的使用

HDFS是一个分布式文件系统,既然是文件系统,就可以对其文件进行操作,比如说新建文件.删除文件.读取文件内容等操作.下面记录一下使用JAVA API对HDFS中的文件进行操作的过程. 对分HDFS中的 ...

- 熟练掌握HDFS的Java API接口访问

HDFS设计的主要目的是对海量数据进行存储,也就是说在其上能够存储很大量文件(可以存储TB级的文件).HDFS将这些文件分割之后,存储在不同的DataNode上, HDFS 提供了两种访问接口:She ...

- 掌握HDFS的Java API接口访问

HDFS设计的主要目的是对海量数据进行存储,也就是说在其上能够存储很大量文件(可以存储TB级的文件).HDFS将这些文件分割之后,存储在不同的DataNode上, HDFS 提供了两种访问接口:She ...

- Sample: Write And Read data from HDFS with java API

HDFS: hadoop distributed file system 它抽象了整个集群的存储资源,可以存放大文件. 文件采用分块存储复制的设计.块的默认大小是64M. 流式数据访问,一次写入(现支 ...

随机推荐

- nginx 代理跨域

跨域 nginx设置http{ add_header Access-Control-Allow-Origin *; add_header Access-Control-Allow-Headers X- ...

- nginx 和 php超时设置

nginx.conf --- http节: keepalive_timeout 600; #客户端浏览器超时时间fastcgi_connect_timeout 600; #php-fpm连接超时时间 ...

- Crontab 删除N天前日志

linux是一个很能自动产生文件的系统,日志.邮件.备份等.虽然现在硬盘廉价,我们可以有很多硬盘空间供这些文件浪费,让系统定时清理一些不需要的文件很有一种爽快的事情.不用你去每天惦记着是否需要清理日志 ...

- hive案例

数据倾斜: 操作• Join on a.id=b.id• Group by• Count Distinct count(groupby)• 原因• key分布不均导致的• 人为的建表疏忽• 业务数据特 ...

- Excel快捷生成想要的xml或text

1.新建一个xml格式的A.xml文本,里面有4条以上的内容,注意哦,里面的元素与Excel里面的标题列数是一直的,不然会少了对应的某列数据.如: 2.打开Excel——>新建一个sheetl— ...

- Struts2中使用HttpServletRequest和HttpServletResponse

一.非Ioc方式 这种方式主要是利用了com.opensymphony.xwork2.ActionContext类以及org.apache.struts2.ServletActionContext类, ...

- ubuntu 安装 oracle sql developer

安装java-jdk 这一部分教程很多,可按照网上教程进行安装 安装sqldeveloper 下载 sqldeveloper Linux RPM http://www.oracle.com/techn ...

- jvm问题

问题: 1. 一台服务器,部署多个服务,请问,这多个服务,对应的是一个jvm,还是多个jvm? 2. 一个线程,从controller 到 service,到DAO,会调用多个方法,请问是 对应一个 ...

- 尚硅谷springboot学习7-yaml配置文件

SpringBoot使用一个全局的配置文件,配置文件名是固定的: application.properties application.yml 配置文件的作用:修改SpringBoot自动配置的默认值 ...

- C语言复习: 二级指针和多级指针

二级指针内存模型建立 void main2() { int i = 0; //指针数组 char * p1[] = { "123", "456 ...